文章目录

- 引言

- [Agent 发展趋势与 MCP 起源](#Agent 发展趋势与 MCP 起源)

-

- [AI Agent 演进路径](#AI Agent 演进路径)

- [MCP 核心优势](#MCP 核心优势)

- [MCP 挑战分析](#MCP 挑战分析)

- [MCP Server 基建设计](#MCP Server 基建设计)

- 工具编排与优化实践

- 技术探索与未来展望

- 结语

引言

Model Context Protocol(MCP)作为 AI Agent 工具交互的标准协议,正深刻改变着智能应用的开发范式。 由 Anthropic 于 2024 年 11 月推出,MCP 通过标准化工具发现、调用和响应流程,解决了 Agent 与外部资源(如 API、数据库)的集成痛点,让开发者能高效构建可扩展的 Agent 系统。 本文深入剖析 MCP Server 的基建设计、编排策略及通用落地经验,面向开发者提供可复现的架构指南,帮助你快速拥抱这一新兴生态。

Agent 发展趋势与 MCP 起源

AI Agent 演进路径

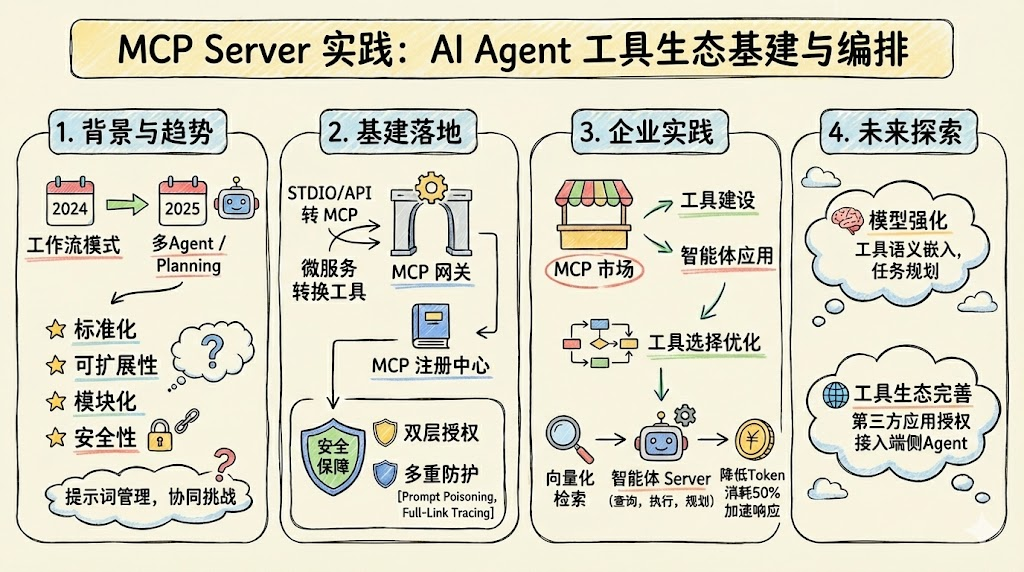

AI Agent 从 2024 年的简单工作流模式,快速演进至 2025 年的多 Agent 协作与高级 Planning 架构。 早期 Agent 依赖硬编码提示词,工具调用碎片化,导致扩展性差。2025 年 3 月,开源社区和云厂商密集推出 MCP 工具,推动企业评估其在生产环境的应用价值。

传统工作流模式遇瓶颈,焦点转向 Agent 的泛化能力和工具使用能力。 MCP 的出现填补工具领域的空白,实现工具复用,避免穷举所有 API 接口的不现实性。

MCP 核心优势

MCP 将外部系统抽象为统一资源,支持 stdio、SSE、HTTP 等传输方式,并内置权限控制机制。 与传统 Function Calling 相比,MCP 强调工具的语义描述(inputSchema、描述)、动态发现和安全执行,避免提示词投毒风险。

其四个主要特点包括标准化、可扩展性、模块化以及安全性。 MCP 重塑 AI 工具生态供给关系:工具生产者与消费者分离,开发者无需自行封装接口。

MCP 挑战分析

MCP 带来系统提示词管理和协同问题。 提示词需清晰管理、安全保障,并有标准可循,以适应多类 Agent(如企业级与端侧)。 大量 MCP Server 会增加 Token 消耗,企业需解决存量服务转化、认证与合规挑战。

MCP Server 基建设计

落地难点

MCP 落地面临安全性(认证授权缺口、多租户挑战)、动态编排(实时调整工具)和稳定性三大难点。 通过网关统一管控,确保能力迭代在基础设施范围内。

核心组件架构

引入 MCP 注册中心和 MCP 网关,形成工具生命周期管理闭环。

- MCP 注册中心(Registry):管理工具 Prompt、元数据和版本,支持配置管理。

- MCP 网关:流量入口,实现协议转换(如 STDIO/HTTP 转 MCP),支持本地进程和 API 封装。

架构分为控制面(注册中心)和数据面(网关实例,集成认证、安全、可观测性)。 网关支持多实例部署,非全局唯一,提供灵活性。

下图展示典型架构(Markdown 简化):

java

[LLM Client] <--> [MCP 网关] <--> [注册中心]

|

[工具 Server] (API/微服务)存量服务转化

开发配置化模板工具,一键将传统微服务转为 MCP Server。 模板覆盖:

- 上下文定义(认证渠道适配)。

- 参数配置(Input Schema)。

- 请求/响应模板(参数化 + 自定义函数)。

- 安全存储(Secrets 密文引用)。

示例 Python 实现(基于开源 MCP SDK):

python

from mcp.server.stdio import stdio_server

from mcp.server.models import Tool, TextContent

async def api_tool(params: dict) -> str:

# 调用后端 API,处理上下文/加密

result = await call_backend_api(params)

return TextContent(text=result)

server = stdio_server(

tools=[Tool(

name="api_query",

description="查询后端服务数据",

inputSchema={"type": "object", "properties": {"query": {"type": "string"}}},

call=api_tool

)]

)此方案高效适配非标准 API,提升大模型响应解析能力。

安全保障机制

双层防护:Agent 到网关认证 + 网关到工具授权。 工具可见性优化:仅返回已授权工具,避免信息泄露。

多重措施:

- 数据外流防控。

- 提示词投毒扫描。

- 代码安全检查(开源组件)。

- 全链路追踪(OpenTelemetry)。

工具编排与优化实践

MCP 市场构建

构建 MCP 市场,支持工具发布、评测和订阅。 概念映射:应用(Agent)- MCP Server(1:N)- 工具(1:1),引入工具描述覆盖优化。

影响因素与评测

工具效果受模型能力、描述质量、上下文长度、任务复杂度影响。 建立评测体系,使用领域数据集评估模型-工具组合。

自动化描述优化原则:简洁、明确、一致、完整、可扩展(参考 EasyTool 论文)。

工具选择优化

两阶段方案:

- 向量化检索:工具描述嵌入 FAISS,匹配 Top-K,降低 Token 消耗。

- Koda Server:内置查询/执行/规划工具,支持分层向量化 + 迭代搜索。

效果对比:

| 维度 | 未优化 | 接入 Koda |

|---|---|---|

| 首 Token 延迟 | ~2s | ~800ms |

| Token 消耗 | ~5万 | ~2万 |

Code

java

import org.springframework.ai.chat.client.ChatClient;

import org.springframework.ai.chat.model.ChatModel;

import org.springframework.ai.chat.model.ChatResponse;

import org.springframework.ai.openai.OpenAiChatModel;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.stereotype.Service;

import reactor.core.publisher.Mono;

import java.util.List;

import java.util.Map;

import java.util.concurrent.CompletableFuture;

import mcp.client.stdio.StdioClient;

import mcp.client.models.Tool;

import mcp.client.ClientSession;

@Service

public class McpSpringAiService {

private final ChatModel chatModel;

private final StdioClient mcpClient;

public McpSpringAiService(

@Value("${spring.ai.openai.api-key}") String apiKey,

StdioClient mcpClient) {

this.chatModel = new OpenAiChatModel(

new OpenAiApi(apiKey, "https://api.deepseek.com/v1"));

this.mcpClient = mcpClient;

}

public Mono<String> queryWithMcpTools(String userQuery) {

return initializeMcpTools()

.flatMap(tools -> callLlmWithTools(userQuery, tools))

.flatMap(this::executeToolCalls)

.map(response -> response.getResult().getOutput().getContent());

}

private Mono<List<Tool>> initializeMcpTools() {

return Mono.fromFuture(CompletableFuture.supplyAsync(() -> {

try (ClientSession session = mcpClient.connect()) {

session.initialize();

return session.listTools().getTools();

} catch (Exception e) {

throw new RuntimeException("MCP初始化失败", e);

}

}));

}

private Mono<ChatResponse> callLlmWithTools(String query, List<Tool> tools) {

return Mono.from(() -> {

List<Map<String, Object>> openaiTools = tools.stream()

.map(Tool::toOpenAiTool)

.collect(Collectors.toList());

return chatModel.call(ChatRequest.builder()

.messages(List.of(new UserMessage(query)))

.options(options -> options

.withModel("deepseek-chat")

.withTools(openaiTools))

.build());

});

}

private Mono<ChatResponse> executeToolCalls(ChatResponse response) {

return Mono.fromFuture(CompletableFuture.supplyAsync(() -> {

if (response.getResult().getOutput().hasToolCalls()) {

List<ToolCall> toolCalls = response.getResult().getOutput().getToolCalls();

for (ToolCall toolCall : toolCalls) {

try (ClientSession session = mcpClient.connect()) {

ToolResult result = session.callTool(

toolCall.getName(),

toolCall.getArgumentsAsMap()

);

// 将工具结果追加到消息历史

response.getResult().getOutput().addMessage(

new ToolMessage(result.getContent().get(0).getText(),

toolCall.getId()));

}

}

// 重新调用LLM处理工具结果

return chatModel.call(response.getRequest());

}

return response;

}));

}

}Spring Boot 配置示例

yaml

# application.yml

spring:

ai:

openai:

api-key: ${DEEPSEEK_API_KEY}

chat:

options:

model: deepseek-chat

mcp:

server:

command: uv

args:

- run

- tool-server.pyController 使用示例

java

@RestController

public class AgentController {

private final McpSpringAiService mcpService;

@PostMapping("/chat")

public Mono<ResponseEntity<String>> chat(@RequestBody String query) {

return mcpService.queryWithMcpTools(query)

.map(result -> ResponseEntity.ok(result))

.defaultIfEmpty(ResponseEntity.ok("无响应"));

}

}技术探索与未来展望

提升执行准确度

- 模型强化:工具语义嵌入 + 微调,构建 Tool Graph,支持强化学习。

- 任务规划:挖掘历史案例,生成最佳实践引导。

工具生态完善

端侧 Agent 连接第三方应用:授权托管 MCP 工具(如云服务、社交平台),扩展生态。

协议融合趋势

MCP 与 A2A/ACP 融合,构建完整 Agent 生态。 关注 v1.0 标准化(2025-06 发布)和隐私优化。

开源生态:GitHub Star 前八项目如 NocoBase,支持可视化工作流。

结语

MCP Server 通过标准化基建与智能编排,重塑 AI 应用生态,实践证明其在生产场景的成熟度。 开发者从注册中心起步,构建工具市场,拥抱多 Agent 时代。