做 Android 流媒体开发的同学应该都懂,原生MediaPlayer简直是 "痛点集合体"------ 延迟高到没法忍、协议支持捉襟见肘,第三方播放器要么体积臃肿,要么定制化能力差,想做个低延迟、支持多路播放还能自定义处理帧数据的功能,总得踩一堆坑。

最近基于 FFmpeg 6.1.1 封装了一款轻量级流媒体播放器FFmpegStreamPlayer,解决了项目中遇到的低延迟、多流并发、YUV 帧自定义处理等核心问题,今天跟大家聊聊这款播放器的核心价值、适用场景,以及为什么它能适配大部分安卓流媒体开发需求。

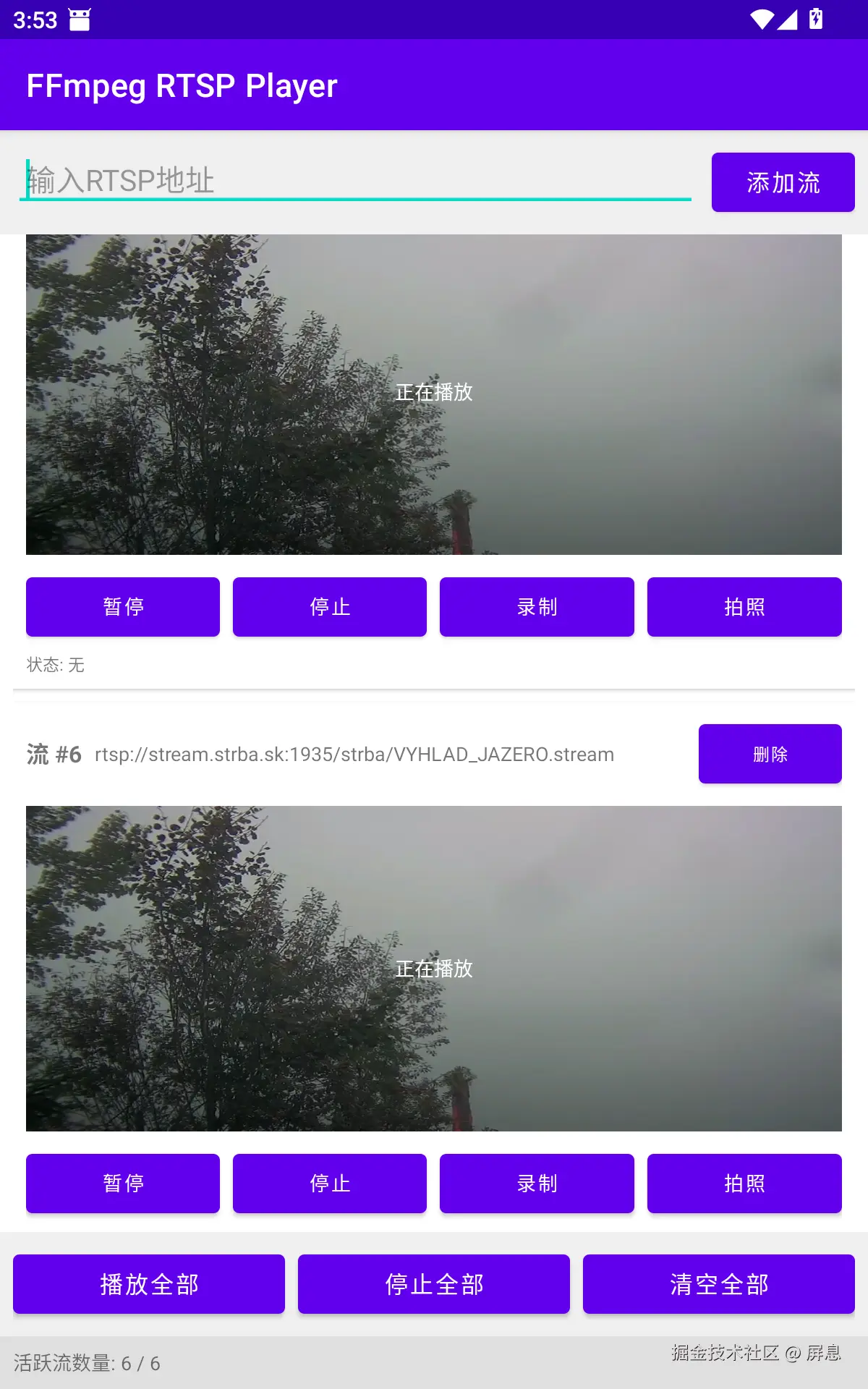

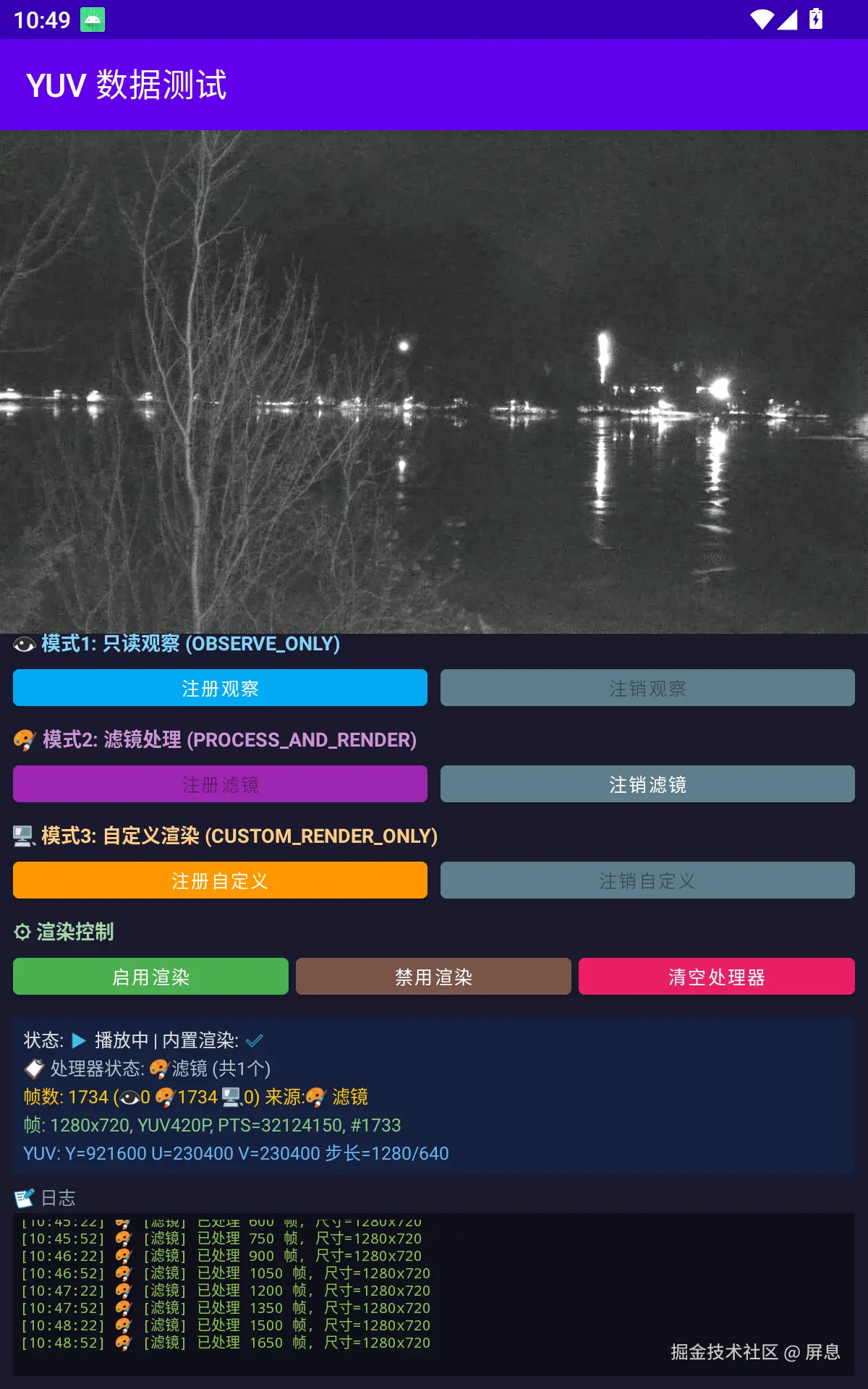

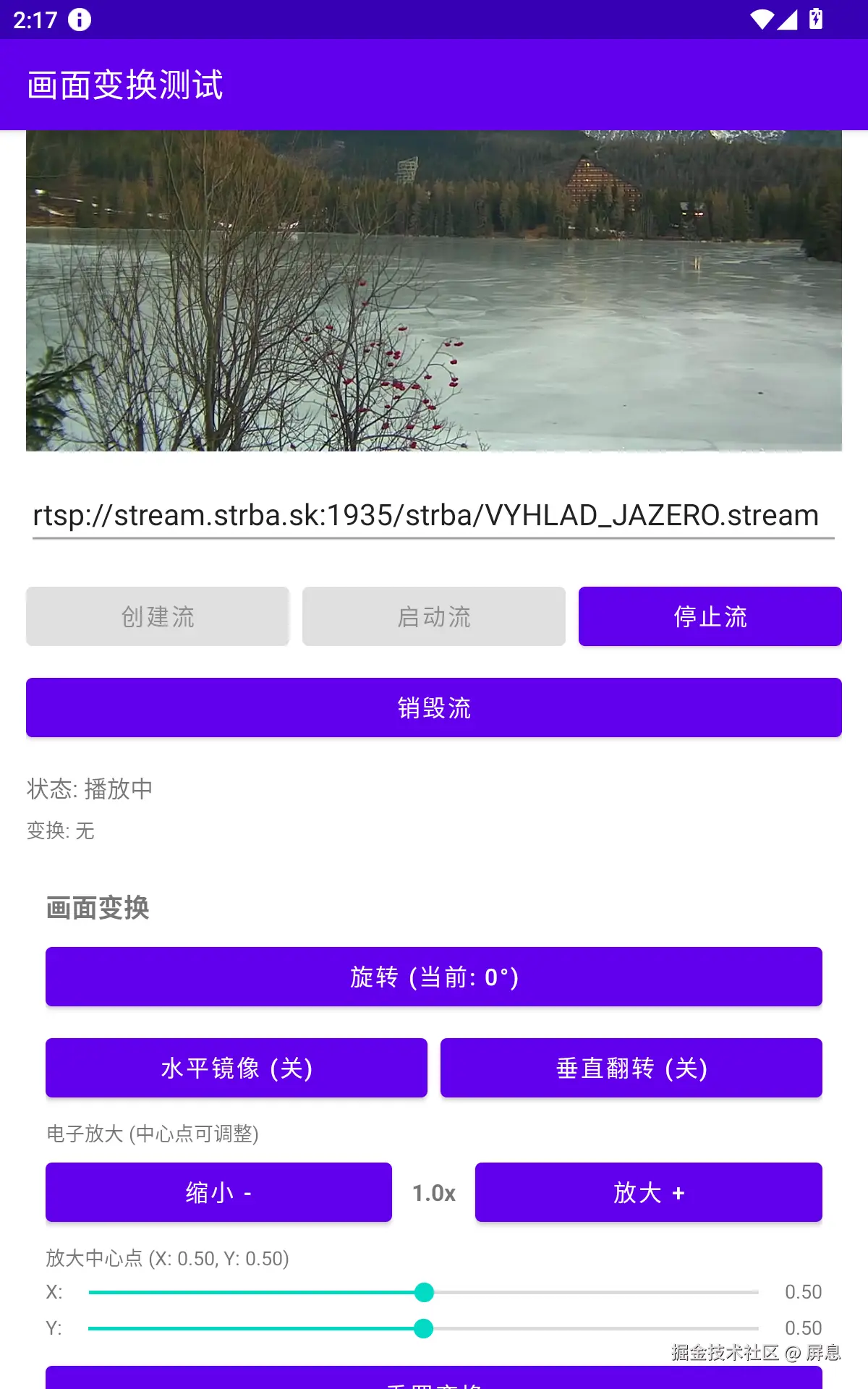

应用截图:

为什么需要这款播放器?

先说说我们日常开发中遇到的真实痛点:

- 原生播放器完全不够用 :原生

MediaPlayer的延迟能到 300-800ms,做安防监控、实时直播这类对延迟敏感的场景,用户体验直接拉胯;而且对 RTSP、HTTP-FLV 这类协议的适配性极差,经常出现播放卡顿、断流的情况。 - 第三方播放器的 "隐形门槛" :市面上不少播放器要么只支持单一协议(比如只做 RTMP),要么硬件解码适配差,部分机型直接闪退;还有的不开源,想自定义处理 YUV 帧、加个 AI 分析功能都无从下手。

- 项目的核心诉求没被满足:我们做安防项目时,需要同时播放 16 路监控流、实时录制、获取 YUV 帧做人脸检测,还要适配 16kb 的特殊屏幕 ------ 这些需求,现成的播放器要么做不到,要么需要大量二次开发。

基于这些痛点,才封装了这款FFmpegStreamPlayer,核心就是 "解决实际问题",而不是做一个 "能用但不好用" 的玩具。

这款播放器的核心使用场景

1. 安防监控场景

这是最核心的场景:支持 RTSP 协议(安防摄像头主流协议),最高 16 路流同时播放(具体路数看设备性能),硬件解码延迟 80-120ms,能实时看到监控画面;还支持边播边录,录制的视频质量无损,满足取证、回放的需求。

2. 直播互动场景

不管是 RTMP 还是 HTTP-FLV 协议的直播,都能做到超低延迟播放 ------ 硬件解码 100ms 级的延迟,比原生播放器快 3 倍以上,适合直播带货、在线教育这类需要实时互动的场景。

3. 智能分析 / 自定义处理场景

软件解码模式下能获取 YUV 原始帧,支持三种处理模式:

- 只读分析(比如人脸检测、行为分析),不影响正常播放;

- 处理后渲染(比如加美颜、滤镜);

- 完全接管渲染(自己用 OpenGL 画)。做 AI 推理、自定义渲染的同学,不用再自己封装 FFmpeg 的解码逻辑,直接用现成的接口就行。

4. 车载 / 工控设备场景

专门做了 16kb 页面适配,能兼容车载、工控这类特殊屏幕;而且完善的生命周期适配逻辑,能处理应用前后台切换、Surface 销毁 / 创建的情况,避免设备长时间运行出现崩溃、内存泄漏。

5. 通用流媒体播放场景

支持 RTSP/RTMP/HLS/HTTP-FLV/RTP/UDP/TCP 等几乎所有主流协议,一套代码就能适配不同的播放需求,不用为不同协议集成不同的播放器。

使用这款播放器的核心好处

1. 极致低延迟,体验拉满

硬件解码延迟 80-120ms,软件解码 120-200ms,亲测比原生MediaPlayer快 3-5 倍;而且用了零拷贝渲染(直接内存映射),减少内存拷贝的开销,播放更流畅。

2. 灵活的解码 & 定制化能力

- 硬件 / 软件解码可选:硬件解码追求低延迟,软件解码支持 YUV 帧自定义处理;

- YUV 帧零拷贝处理:直接拿到

DirectByteBuffer,不用拷贝数据,性能损耗几乎可以忽略; - 自定义渲染:完全接管渲染逻辑,想怎么画就怎么画,适配各种个性化需求。

3. 多流并发 + 协议全覆盖

最多 16 路流同时播放,满足多路监控、矩阵屏等场景;RTSP/RTMP/HLS 等主流协议全覆盖,不用再为不同协议做兼容开发。

4. 稳定的生命周期适配

专门处理了Surface的创建 / 销毁、应用前后台切换、流的销毁等逻辑,只要按文档做好生命周期适配,几乎不会出现崩溃、黑屏、音视频不同步的问题。

5. 轻量化集成

基于 aar 封装,只包含 arm64-v8a/armeabi-v7a/x86_64 三种主流架构,体积可控;集成方式也简单,几行代码就能引入,不用配置复杂的 NDK 环境。

快速上手(核心代码示例)

1. 引入库 + 添加权限

kotlin

less

dependencies {

implementation(fileTree(mapOf("dir" to "libs", "include" to listOf("*.aar"))))

}xml

ini

<uses-permission android:name="android.permission.INTERNET" />

<uses-permission android:name="android.permission.WRITE_EXTERNAL_STORAGE" />2. 基本播放逻辑

java

运行

scss

// 创建流(硬件解码)

int streamId = FFmpegRTSPLibrary.createStream("rtsp://your-server/stream");

// 绑定Surface

FFmpegRTSPLibrary.setSurface(streamId, surfaceView.getHolder().getSurface());

// 异步播放

FFmpegRTSPLibrary.startPlayAsync(streamId, callback);

// 停止+销毁

FFmpegRTSPLibrary.stopPlayAsync(streamId, callback);

FFmpegRTSPLibrary.destroyStream(streamId);3. YUV 帧处理(AI 分析场景)

java

运行

typescript

// 注册YUV处理器(只读分析模式)

FFmpegRTSPLibrary.registerYUVProcessor(streamId, new IYUVFrameProcessor() {

@Override

public YUVProcessMode getProcessMode() {

return YUVProcessMode.OBSERVE_ONLY;

}

@Override

public YUVProcessResult onProcessFrame(YUVFrameInfo frame) {

// 拿到YUV原始数据做AI推理(比如人脸检测)

// frame.yBuffer/uBuffer/vBuffer是零拷贝DirectByteBuffer

return YUVProcessResult.passthrough();

}

});4. 必做的生命周期适配

java

运行

typescript

@Override

public void surfaceDestroyed(SurfaceHolder holder) {

if (currentStreamId >= 0) {

FFmpegRTSPLibrary.onSurfaceDestroyed(currentStreamId);

}

}

@Override

protected void onDestroy() {

super.onDestroy();

FFmpegRTSPLibrary.destroyAllAsync();

}注意事项

- YUV 回调在解码线程执行,耗时操作(比如 AI 推理)一定要异步处理,避免阻塞解码;

- YUV 的 Buffer 仅在回调期间有效,不要缓存复用,否则会出现数据错乱;

- 多流播放时要根据设备性能调整路数,中低端机型建议适当减少并发路数;

最后

这款播放器是从实际项目中沉淀出来的,没有花里胡哨的功能,核心就是解决 "低延迟、多协议、可定制" 这三个核心痛点。目前项目长期维护,有定制化需求(比如裁剪特定架构、新增功能)可以联系作者,也可以加 QQ 群 647718711 交流问题。

项目地址:https://github.com/anwz0611/android-ffmpeg-stream-player

如果你的项目也有安卓流媒体播放的需求,尤其是低延迟、多流并发、自定义帧处理的场景,这款播放器应该能帮你少走不少弯路