在这个AI大模型快速迭代的年代,新模型发布频繁。但MiniMax M2.1的出现带来了不一样的惊喜------一个只用10B激活参数,却在多语言编程任务上能与Claude Sonnet 4.5和GPT-5.2相抗衡的轻量级模型。

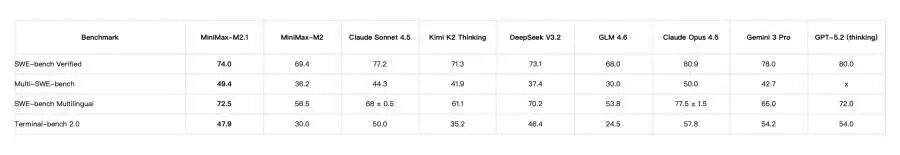

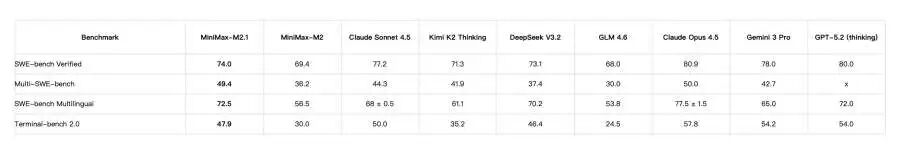

前不久,MiniMax官方发布了M2.1。这次的成绩单确实吸睛:在衡量多语言软件工程能力的Multi-SWE-Bench基准上,M2.1拿下了49.4%的成绩,位列该榜单前列。

更值得注意的是,这次的突破不是靠堆参数,而是对工程上下文的深度理解。过去的模型经常"偏科"------写Python脚本和Web前端没问题,但一旦涉及Java后端、Rust系统编程或Android原生开发,表现就会明显下滑。M2.1的改进就在于对这些领域的理解更深入了。

10B参数的多语言突破

在正式讨论M2.1的能力前,先看看它的硬核成绩。

Multi-SWE-Bench是业界衡量多语言编程能力最权威的基准,涵盖不同语言和复杂场景。M2.1的49.4%打破了开源模型的历史纪录,甚至接近某些闭源商业模型的水平。

更关键的突破在于------M2.1对后端代码有了更深的理解。之前的模型在后端问题上常常捉襟见肘,根本原因在于对工程规范的理解不足。它们可以快速生成前端组件和脚本,因为这类任务容错率高、bug容易暴露。但涉及后端架构、并发控制、内存管理时,模型就力不从心了。

M2.1通过大规模、高质量的工程实践数据训练,让模型不仅能生成代码,还能理解代码背后的设计逻辑。现在它对Go语言的并发模型、C++的内存管理、Java的设计规范都有较深的认知。

Agent协作与推理能力的升级

M2.1在Agent工作流上也做了关键升级。首先,它引入了交错思维(Interleaved Thinking),允许模型在工具调用之间保留推理块。对复杂任务来说这很重要------模型可以在每一步保留思维痕迹,避免长上下文中的信息丧失。这对需要多轮调整的开发任务特别有帮助。

其次,M2.1强化了对编程工具链的适配。它不仅能在Cursor、Claude Code等IDE中流畅协作,还能深度理解这些工具的工作方式。在"修复已有代码"和"重构"这类真实场景中表现出色。换句话说,它成了那种能读懂项目历史、理解既有架构、精准改进的同事。

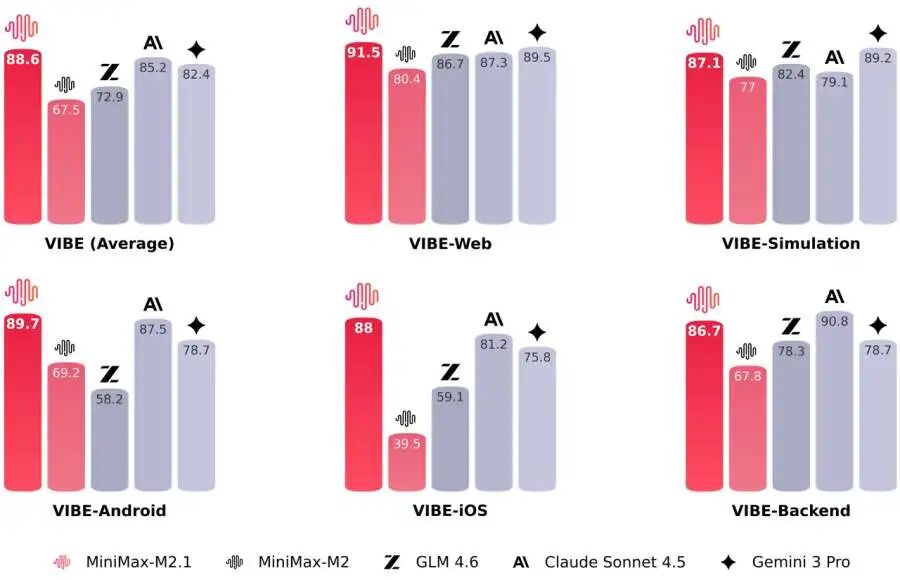

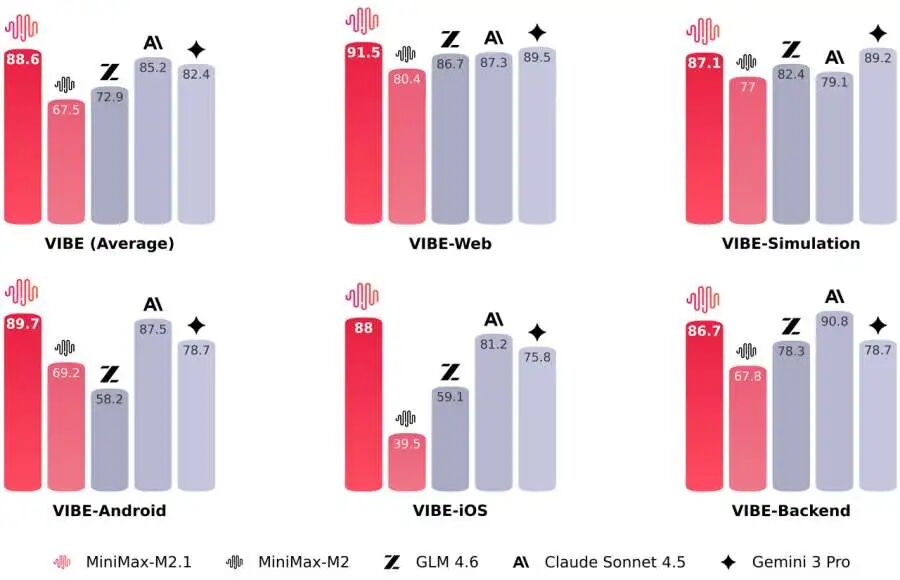

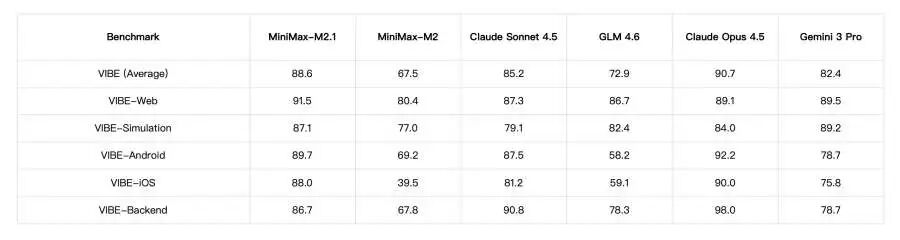

VIBE是MiniMax设计的全栈基准。与纯文本基准不同,它把评测从代码生成扩展到实际应用运行结果。M2.1在此基准的平均得分是88.6,接近Claude Opus 4.5,特别在Web开发(91.5)和Android开发(89.7)上表现突出。

重点是这反映的不是"纸面成绩",而是真实环境表现。能生成代码是一回事,能生成能跑、符合规范、真正解决问题的代码是另一回事。Alt text: MiniMax M2.1在多维度的综合表现对比

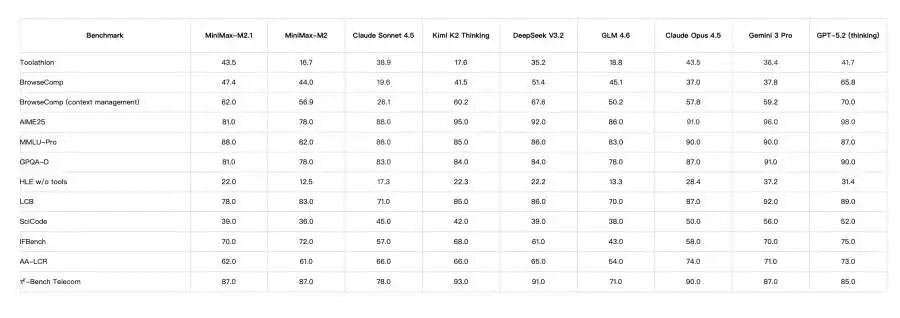

M2.1在工具调用、代码生成、推理等多个维度都有表现。它不仅擅长编程任务,在浏览、检索、知识整合等方面也比较均衡。这意味着它可以胜任从理解需求、调用API到验证结果的完整链路。

从"会写代码"到"懂工程"

数据再硬也不如实践有说服力。看两个具体场景。

Web开发中的多轮迭代

M2.1的优势在于对开发工具链的理解。在Cursor或VS Code中,它不仅能读取当前文件,还能理解整个项目上下文。在一个既有的大型项目里,让M2.1执行"添加新功能"或"修复模块"时,它会充分考虑已有代码的设计、依赖和性能。这种"整体观"正是之前模型所欠缺的。

后端开发中的架构设计

这是M2.1最亮眼的进步。它能够根据需求生成系统设计方案、理解企业级开发规范、对不同语言有深入认知。开发者用几句提示和设计文档,M2.1就能生成逻辑清晰的1000+行后端项目,这在过去需要经验丰富的工程师花多天才能完成。Alt text: MiniMax M2.1与Claude的VIBE全栈基准对比

这个对标图很有说服力。在Web开发、移动开发这些领域,M2.1与Claude旗舰模型的表现已经相当接近。

成本与速度的优势

M2.1虽然只激活10B参数,但推理速度依然有竞争力,官方标注吞吐量在60-100 tokens/sec。定价、1.20/M output tokens,约为Claude Sonnet的1/8。

这对需要高频调用AI做代码生成和修复的团队很有吸引力,特别是对初创公司和中小研发团队而言,可能直接改变AI辅助开发的成本模式。

MiniMax最近刚通过港交所聆讯。在这样的节点发布M2.1,向市场传达了一个清晰信号:MiniMax不仅掌握了多模态交互,在文本模型的Agent和编程能力上也很有竞争力。

更值得关注的是研发效率。招股书显示,MiniMax成立至今仅消耗约5亿美元,却建立了全模态能力。关键是公司内部超过80%的代码已由AI完成。M2.1本质上就是这位"AI实习生"能力的外溢。185人的团队,所有迭代都依赖AI辅助,M2.1在推向市场前已在真实环境中经历过无数次考验。

M2.1代表了AI编程能力的进一步演进。从这个模型开始,开发者不再需要在成本、速度和能力间做取舍。开发者也不再是在"使用一个AI写代码的工具",而是和AI像真实同事一样协作。

这意味着编程工作流有了新的可能性。

社区地址

OpenCSG社区:https://opencsg.com/models/AIWizards/MiniMax-M2.1

hf社区:https://huggingface.co/MiniMaxAI/MiniMax-M2.1

关于 OpenCSG

OpenCSG 是全球领先的开源大模型社区平台,致力于打造开放、协同、可持续生态,AgenticOps是人工智能领域的一种AI原生方法论, 由OpenCSG(开放传神)提出。AgenticOps是Agentic AI的最佳落地实践也是方法论。核心产品 CSGHub 提供模型、数据集、代码与 AI 应用的 一站式托管、协作与共享服务,具备业界领先的模型资产管理能力,支持多角色协同和高效复用。