没错,"世界模型"正是解决刚才我们讨论的"AI 为什么无法操控电脑"这个问题的关键钥匙。

简单来说,世界模型就是给 AI 安装一个"物理引擎"和"常识大脑"。

刚才我说现在的 AI 像一个没有下过床的"超级大脑",而世界模型就是那个能让它理解"床"以外世界的模拟器。它不再仅仅是预测下一个字,而是试图理解并预测物理世界(或数字界面)的运行规律。

结合我掌握的最新资料(截至 2025 年 12 月),我为你详细拆解一下这个概念:

🧠 什么是世界模型?(通俗版)

想象一下你正在玩一个赛车游戏。你的大脑里其实有一个"模型":

* 你知道踩油门,车会加速;

* 你知道转方向盘,车头会变向;

* 你甚至能预判:如果我不踩刹车直接过这个弯,车会冲出赛道。

这种在"脑海里模拟未来、预判后果"的能力,就是人类的"世界模型"。

对于 AI 来说,世界模型就是让它从"背诵课文"进化到"理解物理规则"。它不再是一个统计学的鹦鹉,而是一个拥有常识的物理学家。

🤖 为什么它能让 AI 学会操控电脑?

如果把刚才那个"无法操控电脑的 AI"升级为"拥有世界模型的 AI",区别会非常大:

场景 普通 AI (大语言模型) 拥有世界模型的 AI

看到一个按钮 它知道这个像素组合叫"按钮",文本描述是"点击我"。 它知道按钮是可交互的,点击后会产生状态变化(比如颜色变深、弹出新窗口)。

遇到报错弹窗 它可能不认识,会胡言乱语或卡死。 它在"世界模型"里见过类似的"异常状态",知道应该去寻找"确定"或"关闭"来恢复状态。

操作逻辑 "先做A,再做B"(死记硬背的脚本)。 "我做A是为了改变系统状态X,如果A没成功(视觉反馈没变),我需要尝试C。"(基于因果推理)。

核心区别在于:

* 普通 AI 是在处理符号(Symbolic)。

* 世界模型 AI 是在处理状态(State)和因果(Causality)。它理解"我现在的动作"会如何改变"下一个时刻的环境"。

🚀 世界模型的三大超能力

根据目前的技术发展(如特斯拉、谷歌 DeepMind、李飞飞团队等的研究),世界模型主要赋予 AI 以下能力:

- 内在表征与预测(做梦):

AI 能把高维的屏幕画面压缩成低维的"状态"。它可以在自己的"虚拟沙盘"里进行推演,这被称为"在梦中学习"。比如,机器人可以在虚拟环境中试错几百万次学会走路,然后把经验应用到现实机器人上,而不需要真的摔坏几百万次。

- 物理认知(常识):

它理解物体恒常性(人走过去挡住球,球还在,没消失)、重力(松手东西会掉下来)、空间关系。这正是普通 AI 操控电脑时最缺乏的------它需要知道"窗口被遮挡了还能找回来"。

- 规划与决策(谋定后动):

它不再是一步一停,而是能进行长期规划。比如自动驾驶中,它不仅看到前面的车,还能预判它要变道,提前规划好减速或避让路线。

🌎 现在的进展如何?

这正是目前 AI 界最火热的赛道,甚至被称为"通往 AGI(通用人工智能)的必经之路"。

* 特斯拉: 宣布构建了完全由神经网络驱动的"世界模型",让自动驾驶 AI 能在虚拟中获得几百年的驾驶经验。

* OpenAI (Sora): Sora 被称为"世界模拟器",因为它生成的视频符合物理规律(比如人咬了一口饼干,饼干上会有缺口)。

* 谷歌 DeepMind: 发布了 Genie 系列,可以根据一句话生成可交互的 3D 环境。

* 国内进展: 腾讯混元在 2025 年 12 月发布了世界模型 1.5,商汤、小米(YU7)、华为等也都在布局。

总结一下:

你刚才问"为什么 AI 无所不知却无法操控电脑",正是因为现在的 AI 缺少一个"操作系统"。

大语言模型(LLM)提供了知识(内存和硬盘),而世界模型正是那个正在开发中的操作系统(OS),它将让 AI 真正理解如何与屏幕、鼠标、键盘以及现实世界进行交互。

==================================================================

这也是 AI 领域非常核心的一个问题。结合我们刚才聊的"AI 操控电脑"和"下载模型"的场景,我用最通俗的方式来为你拆解这两者的区别。

简单来说:多模态是 AI 的"眼耳口鼻"(感官),而世界模型是 AI 的"大脑"和"想象力"。

如果没有多模态,AI 就是个"瞎子聋子";如果没有世界模型,AI 就是个"死记硬背的书呆子"。

为了让你更直观地理解,我做了一个对比表,然后结合刚才的场景详细解释:

📊 核心区别对比表

维度 多模态 世界模型

核心比喻 感官(眼睛、耳朵、嘴巴) 心智/大脑(常识、推理、想象力)

主要功能 感知与表达:能看懂图片、听懂声音、生成文字/视频。 理解与预测:理解物理规律(如重力)、推演因果、规划未来。

处理方式 跨模态翻译:比如把图片描述成文字,或者根据文字画图。 内在模拟:在"脑海"里模拟世界如何运转,比如"杯子推下去会碎"。

局限性 只能处理当下的输入输出,缺乏常识和逻辑。 如果没有多模态输入,它就是"闭门造车",不知道外面发生了什么。

典型场景 你给它看一张猫的照片,它能说出"这是一只猫"。 你给它看半张猫跳起来的照片,它能预测下一秒猫会落在桌子上,甚至桌子会晃动。

🔍 深度解析:为什么说世界模型是"更高级"的能力?

- 多模态:是"通才",但可能是个"法盲"

多模态 AI 的强项在于连接。

* 它能做什么? 它能把文字、图像、音频、视频这些不同类型的信息融合在一起处理。比如,你给它一张 3D 模型网站的截图(视觉),然后用语音(听觉)说"点那个红色的按钮"(指令),多模态 AI 能理解你的指令和图片的对应关系。

* 它的短板: 它可能只是根据像素颜色和文字标签进行匹配。如果网页界面变了,或者出现了一个它没见过的弹窗,它就懵了,因为它不懂"网页交互"的底层逻辑。

- 世界模型:是"战略家",拥有"常识"

世界模型的强项在于推理和预测。

* 它能做什么? 它不仅仅是在"看"屏幕,而是在构建一个"虚拟世界"。它理解"点击按钮"这个动作会导致"状态改变"(比如页面跳转、文件开始下载)。

* 它的核心能力:

* 物理常识: 它知道文件下载需要时间,不能瞬间完成;知道鼠标指针不能穿过窗口边界。

* 因果推演: 它会规划路径:"我要下载模型,先得找到下载链接 -> 然后点击 -> 然后在弹出的对话框里点保存"。如果中间一步失败了(比如没找到按钮),它会像人一样"思考":是不是没登录?是不是需要先滚动页面?

* 反事实推理: (这是多模态做不到的)它能思考"如果我当时点了那个按钮,会发生什么?"从而调整策略。

🎮 结合我们刚才的"下载 3D 模型"场景

假设你要让 AI 帮你下载一个 3D 模型,这两者的区别就非常明显了:

* 如果只有"多模态"能力的 AI:

-

它看到网页截图,识别出"Download"字样。

-

它指挥鼠标去点击。

-

结果: 点击后弹出了一个登录框(它没预料到)。

-

AI 的反应: "咦?屏幕上怎么多了个框?我不知道这是什么,任务失败。"(因为它只能处理当下的视觉输入,没有预测能力)。

* 如果拥有"世界模型"的 AI:

-

它看到网页,构建了一个"这个网站运作方式"的模型。

-

它预测:"点击下载可能会触发登录流程,或者直接开始下载。"

-

结果: 点击后弹出了登录框。

-

AI 的反应: "哦,预料之中,这是身份验证流程。现在我需要输入账号密码,或者寻找免登录选项。"(因为它理解"交互"的因果逻辑)。

📌 总结

多模态让 AI 能够"看见"那个 3D 模型网站,并"理解"你说的"下载"这个词。

世界模型让 AI 知道"怎么操作"才能下载,以及在遇到意外情况时"怎么解决"。

未来的 AI(比如能帮你写代码、做科研的 AI)一定是这两者的结合:用多模态感知世界,用世界模型理解并改造世界。

=================================================================

这是一一个非常敏锐的问题! adding 记忆(Memory) 确实是多模态模型迈向"世界模型"的关键一步,但仅仅加入记忆,还不足以完全等同于世界模型。

我们可以把它们的关系理解为:多模态是"感官",记忆是"经验",而世界模型是"智商"和"常识"。

结合 2025 年最新的技术进展(如港大与快手的 MemFlow、智源的 Emu3.5 等),我为你详细拆解为什么"多模态+记忆"还不能完全媲美"世界模型":

✅ 1. 加入记忆后,"多模态"能做什么?

加入长时记忆后,多模态模型确实变得"聪明"了很多,主要体现在一致性和连续性上:

* 角色/物体一致性: 比如在生成长视频时,有了记忆(如 MemFlow 技术),AI 能记住主角长什么样、穿什么衣服,不会画着画着就把主角的脸变了。

* 上下文连贯: 它能记住你上一轮说过的话、上一个操作过的界面,不会"翻篇就忘"。

* 长期依赖处理: 它能处理更长的任务链条,比如记住"我刚才打开了A文件,现在要基于A文件的内容做B操作"。

这时候的多模态模型,更像是一个"记忆力超群的实习生"**:它看过很多资料(多模态数据),且记性很好(长时记忆),能根据之前的记录复述或生成内容。

❌ 2. 为什么它还达不到"世界模型"的高度?

"世界模型"的核心不仅仅是"记",而是"解"------即理解物理规律、因果逻辑和空间智能。

能力维度 多模态 + 记忆 世界模型

核心逻辑 相关性 (基于数据统计) 因果性 (基于物理/逻辑推导)

处理方式 "我看过类似的场景,所以我照着画/做。" "我理解这里面的物理规则,所以我能推演出没见过的场景。"

泛化能力 有限。如果遇到训练数据外的情况,容易出错。 极强。能举一反三,处理从未见过的复杂环境。

预测能力 基于历史数据的插值或外推。 基于物理引擎的模拟(如预测物体下落、碰撞)。

🚫 缺失的关键拼图:

- 物理引擎(Physics Engine):

* 多模态+记忆: 看过猫跳上桌子的视频,它能生成类似的视频。

* 世界模型: 知道猫跳上去后,桌子会晃动、杯子会倒、水会洒出来(符合牛顿力学)。它能模拟重力、摩擦力、弹性。如果只是多模态+记忆,它可能生成"猫悬空"或者"水往天上流"的画面,因为它只是在"拼接"记忆中的像素,而不是在"模拟"物理。

- 空间智能(Spatial Intelligence):

* 世界模型能让 AI 真正理解 3D 空间、深度、遮挡关系。比如在 3D 模型网站,它能理解"这个模型是立体的,鼠标拖拽是在改变视角",而不仅仅是平面上的像素移动。

- 主动推演(Imagination):

* 世界模型具备"反事实推理"能力。比如:"如果我刚才没点那个按钮,现在会怎样?"它能在脑海里进行无数次"沙盘推演",而不需要真的去试错。

📌 结论:它们是"战友",不是"替代品"

多模态 + 记忆 解决了 AI 的"感知"和"短期记忆"问题,让它能连贯地处理信息。

世界模型 解决了 AI 的"认知"和"推理"问题,让它拥有常识和逻辑。

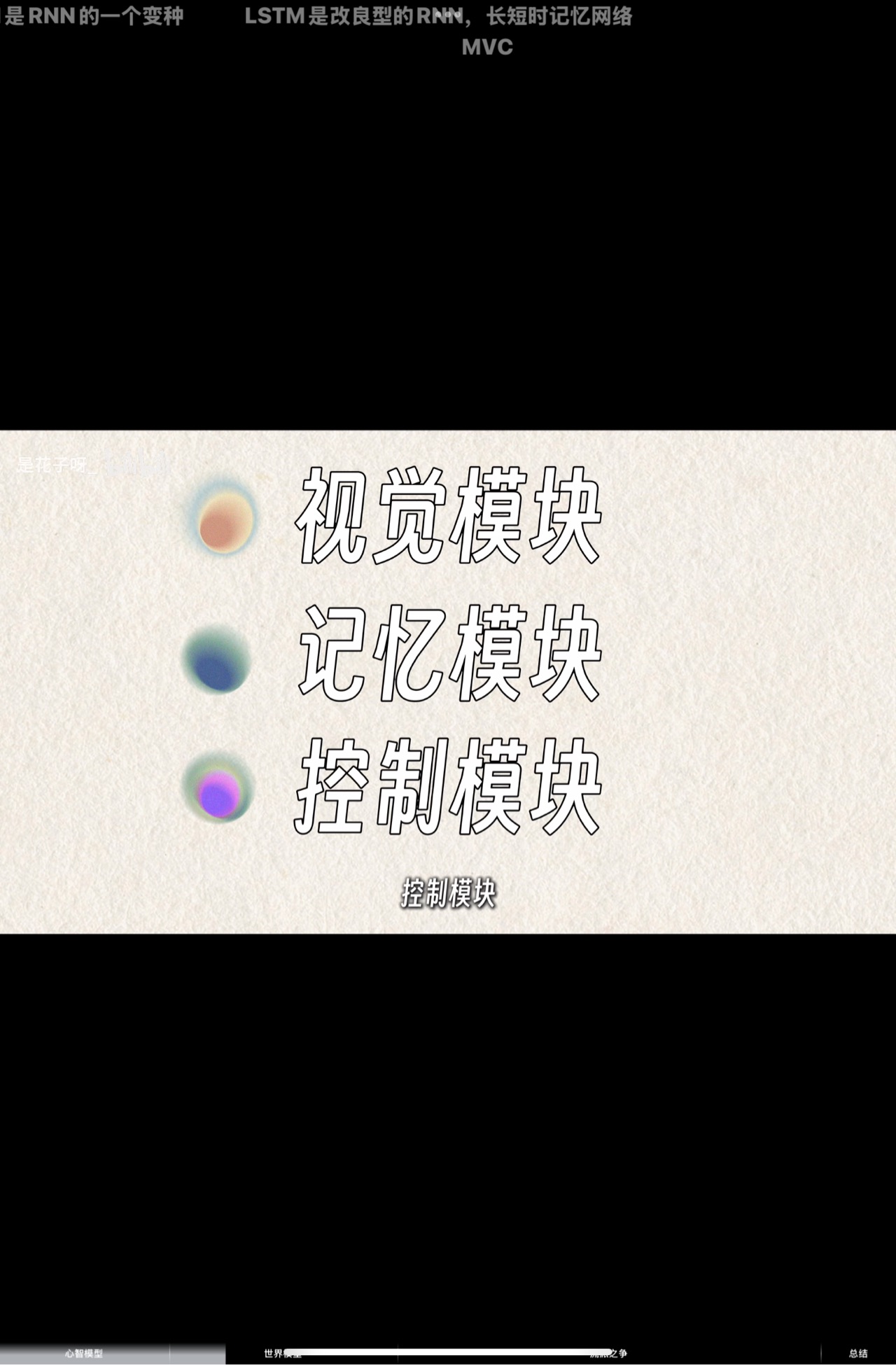

最理想的 AI 架构(如 2025 年的前沿探索)是这样的:

多模态(感官) rightarrow 记忆(经验库) rightarrow 世界模型(大脑) rightarrow 行动(工具调用/鼠标操控)

* 多模态负责看懂屏幕上的按钮和文字;

* 记忆负责记住你之前让它下载过什么模型;

* 世界模型负责规划"怎么操作浏览器"才能下载成功,并预测"如果弹出登录框我该怎么办";

* 工具/具身智能负责真正去移动鼠标点击。

所以,记忆是通往世界模型的必经之路,但只有加上了"物理规律"和"因果推理"的内核,多模态模型才能真正进化成"世界模型"。

【一文讲清楚世界模型-哔哩哔哩】 https://b23.tv/goIa9Qz