通义 Qwen3-TTS 家族重磅更新:VC-Flash 音色克隆模型全面解析与 Spring Boot 集成实战

2025 年 12 月 24 日,通义大模型正式发布了 Qwen3-TTS 家族的两款全新模型:音色创造模型 Qwen3-TTS-VD-Flash 和音色克隆模型 Qwen3-TTS-VC-Flash。本文将重点剖析 VC-Flash 这款 "3 秒克隆音色" 的黑科技(本篇使用官方提供的几款音色,在下一篇文章会写用本地音频来复刻的教程),详解其技术原理、性能优势,并提供完整的 Spring Boot 集成方案。

一、VC-Flash:重新定义音色克隆的行业标准

1.1 核心特性:3 秒克隆,跨语言全能

Qwen3-TTS-VC-Flash是通义大模型推出的专业音色克隆模型,其核心能力令人惊叹:

- 3 秒级高精度克隆:只需 3 秒的参考音频,即可完美复刻目标声音特征,比传统克隆技术 (需 1 分钟以上) 提升 20 倍效率(事实上我个人推荐可以多一些,虽然很消耗token)

- 10 大语言无缝转换:基于克隆的音色,可生成中文、英文、德语、法语、西班牙语、日语、韩语、俄语等 10 种主流语言

- 17 种方言全覆盖:支持普通话、粤语、上海话、四川话、北京话等多种方言,让克隆音色更具地域特色

- 情感精准传递:不仅复制音色,还能保留原始音频的情感特征 (喜悦、悲伤、兴奋等),情感识别准确率超 90%

在 MiniMax TTS 多语种测试集中,VC-Flash 的平均词错误率 (WER) 全面领先 ElevenLabs、GPT-4o-Audio-Preview 等大模型,展现出卓越的跨语言语音合成能力。

1.2 技术原理:从声音到数字,再到无限可能

VC-Flash 采用先进的深度学习架构实现音色克隆,其技术路线图如下:

| 技术环节 | 实现方式 | 核心价值 |

|---|---|---|

| 语音特征提取 | X-vector 说话人嵌入技术,从 3 秒音频中提取唯一音色特征向量 | 将声音 "数字化" 为可存储、可迁移的特征编码 |

| 跨语言映射 | 自研语音 Tokenizer 与流匹配算法,实现音色特征的语言无关表示 | 打破语言壁垒,让同一音色无缝切换语种 |

| 声码器合成 | HiFiGAN 高保真声码器,将特征向量转换为听觉波形 | 生成自然流畅、几可乱真的合成语音 |

| 情感迁移 | 语义理解引擎分析参考音频情感,在合成时精准复现 | 不仅复制声音,更传递情感与表达风格 |

这种 "特征提取→跨语言映射→声码器合成→情感迁移" 的全链路技术,使 VC-Flash 在音色克隆领域达到前所未有的高度。

1.3 应用场景:声音的无限可能

VC-Flash 的强大能力开启了语音合成的新纪元,应用场景极为丰富:

- 内容创作:有声书、播客、短视频配音,用名人或特色声音提升内容吸引力

- 智能客服:将企业客服声音克隆后用于 AI 语音助手,保持品牌声音一致性

- 影视后期:为角色配音,实现 "原声" 跨语言转换,或修复损坏的原始音频

- 无障碍服务:帮助视障人士 "听到" 个性化合成语音,提升用户体验

- 方言保护:记录并克隆濒危方言,保存文化遗产

- 游戏角色:为游戏角色创建独特声音,并支持多语言版本同步生成

二、技术对比:VC-Flash vs 传统音色克隆

2.1 与 cosyvoice-v3-plus 的全面对比

作为通义大模型的前代克隆技术,cosyvoice-v3-plus 曾是业界领先的音色克隆方案。VC-Flash 在其基础上实现了质的飞跃:

| 对比维度 | cosyvoice-v3-plus | Qwen3-TTS-VC-Flash | 提升幅度 |

|---|---|---|---|

| 克隆所需音频长度 | 10-20 秒 | 3 秒 | 67% |

| 支持语言数量 | 5 种 | 10 种 | 100% |

| 方言支持 | 有限 | 17 种方言全覆盖 | 340% |

| 克隆成功率 | 85% | 98%+ | 15%+ |

| 合成延迟 | 平均 500ms | 平均 350ms | 30% |

| 跨语言一致性 | 一般 | 优秀 (多语种测试 WER 最低) | 显著提升 |

| 情感保留度 | 良好 | 优秀 (准确率> 90%) | 大幅提升 |

VC-Flash 不仅降低了克隆门槛 (从 10 秒到 3 秒),还将多语言支持翻倍,在保持高音质的同时,将合成延迟进一步降低,为实时应用场景提供了更好的体验。

2.2 与 ElevenLabs、Coqui 等模型的优势分析

在全球音色克隆领域,ElevenLabs 和 Coqui (原 RVC) 是 VC-Flash 的主要竞争对手。VC-Flash 凭借以下优势脱颖而出:

- 极短克隆时间:ElevenLabs 需 30 秒以上参考音频,Coqui 需 1 分钟,而 VC-Flash 仅需 3 秒,大幅降低用户门槛

- 中文与方言支持:在中文和方言支持方面远超竞品,特别适合中文市场应用

- 多语言合成质量:在 MiniMax 多语种测试中,VC-Flash 的 WER 指标全面领先 ElevenLabs 和 GPT-4o-Audio-Preview

- 情感表达能力:能更精准地捕捉并重现原始音频的情感特征,使合成语音更自然、更具表现力

- 与通义生态深度集成:无缝接入通义大模型家族,支持更丰富的 AI 语音交互场景

三、Spring Boot 集成 VC-Flash:从入门到实战

3.1 环境准备与依赖配置

设计一个基于 CosyVoice-v3-plus 的语音合成后端接口,采用 Spring Boot 分层架构(Controller/Service/ServiceImpl),同时兼容官方 SDK 的功能~

要在 Spring Boot 项目中集成 VC-Flash,首先需要准备以下资源:

- 通义 API Key:通过阿里云百炼平台 (ModelStudio) 注册账号,获取 API Key

- 开发环境:JDK 11+,Spring Boot 3.0+,Maven 或 Gradle 构建工具

- 音频处理依赖:引入通义 Java SDK 和华为 OBS SDK (如需私有存储)

在pom.xml中添加核心依赖(2025年12月29日最新版本):

java

<!-- https://mvnrepository.com/artifact/com.alibaba/dashscope-sdk-java -->

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>dashscope-sdk-java</artifactId>

<version>2.22.4</version>

</dependency>3.2 SpeechSynthesisController(接口)

java

import gzj.spring.ai.DTO.SpeechSynthesisRequestDTO;

import gzj.spring.ai.Request.SpeechSynthesisResponse;

import gzj.spring.ai.Service.SpeechSynthesisService;

import jakarta.annotation.Resource;

import org.springframework.web.bind.annotation.PostMapping;

import org.springframework.web.bind.annotation.RequestBody;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RestController;

/**

* @author DELL

*/

@RestController

@RequestMapping("/api/speechSynthesizer")

public class SpeechSynthesisController {

@Resource

private SpeechSynthesisService speechSynthesisService;

/**

* 语音合成接口

* @param requestDTO 合成请求参数

* @return 合成结果

*/

@PostMapping("/synthesize")

public SpeechSynthesisResponse synthesizeSpeech(@RequestBody SpeechSynthesisRequestDTO requestDTO) {

return speechSynthesisService.synthesizeSpeech(requestDTO);

}

}3.3 SpeechSynthesisRequestDTO (传参)

java

import lombok.Data;

@Data

public class SpeechSynthesisRequestDTO {

/** 要合成的文本内容 */

private String text;

/** 语音模型(默认cosyvoice-v3-plus) */

private String model = "cosyvoice-v3-plus";

/** 声音类型(默认longanyang,可根据官方文档替换) */

private String voice = "longanyang";

}3.4 SpeechSynthesisService 方法

java

import gzj.spring.ai.DTO.SpeechSynthesisRequestDTO;

import gzj.spring.ai.Request.SpeechSynthesisResponse;

/**

* @author DELL

*/

public interface SpeechSynthesisService {

/**

* 语音合成接口

*

* @return 合成结果

*/

SpeechSynthesisResponse synthesizeSpeech(SpeechSynthesisRequestDTO request);

}3.5 SpeechSynthesisServiceImpl(实现类)

java

import com.alibaba.dashscope.audio.ttsv2.SpeechSynthesisParam;

import com.alibaba.dashscope.audio.ttsv2.SpeechSynthesizer;

import gzj.spring.ai.DTO.SpeechSynthesisRequestDTO;

import gzj.spring.ai.Request.SpeechSynthesisResponse;

import gzj.spring.ai.Service.SpeechSynthesisService;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.stereotype.Service;

import java.io.File;

import java.io.FileOutputStream;

import java.io.IOException;

import java.nio.ByteBuffer;

import java.util.UUID;

import static com.alibaba.cloud.ai.graph.utils.TryConsumer.log;

/**

* @author DELL

*/

@Service

public class SpeechSynthesisServiceImpl implements SpeechSynthesisService {

/**

* 通义实验室API Key(环境变量中)

*/

@Value("${dashscope.api-key}")

private String apiKey;

/**

* 音频文件存储路径(配置在application.yml中)

*/

@Value("${audio.storage.path:C:/Users/DELL/Downloads}")

private String audioStoragePath;

@Override

public SpeechSynthesisResponse synthesizeSpeech(SpeechSynthesisRequestDTO request) {

SpeechSynthesisResponse response = new SpeechSynthesisResponse();

// 【优化1:前置参数校验】避免空参数调用SDK导致未知异常

if (request == null) {

response.setSuccess(false);

response.setMessage("请求参数不能为空");

return response;

}

if (request.getText() == null || request.getText().trim().isEmpty()) {

response.setSuccess(false);

response.setMessage("合成文本不能为空");

return response;

}

// 给模型/音色设置默认值,避免空指针

String model = request.getModel() == null ? "cosyvoice-v3-plus" : request.getModel();

String voice = request.getVoice() == null ? "longanyang" : request.getVoice();

try {

// 1. 创建音频存储目录(不存在则创建)

File storageDir = new File(audioStoragePath);

if (!storageDir.exists()) {

boolean mkdirSuccess = storageDir.mkdirs();

if (!mkdirSuccess) {

response.setSuccess(false);

response.setMessage("音频存储目录创建失败:" + audioStoragePath);

log.warn("音频存储目录创建失败,路径:{}", audioStoragePath);

return response;

}

}

// 2. 构建SDK参数(使用默认值兜底)

SpeechSynthesisParam param = SpeechSynthesisParam.builder()

.apiKey(apiKey)

.model(model)

.voice(voice)

.build();

// 3. 调用语音合成SDK(资源自动关闭优化)

SpeechSynthesizer synthesizer = new SpeechSynthesizer(param, null);

ByteBuffer audioBuffer = null;

try {

log.info("开始调用CosyVoice SDK合成语音,文本:{},模型:{},音色:{}",

request.getText(), model, voice);

audioBuffer = synthesizer.call(request.getText());

} catch (Exception e) {

log.error("CosyVoice SDK调用异常", e);

throw e; // 抛给外层统一处理

} finally {

// 【优化2:资源释放健壮性】避免duplexApi为空导致空指针

if (synthesizer != null && synthesizer.getDuplexApi() != null) {

try {

synthesizer.getDuplexApi().close(1000, "资源释放");

log.info("CosyVoice SDK资源已释放");

} catch (Exception e) {

log.warn("SDK资源释放失败", e); // 释放失败不影响主流程

}

}

}

// 4. 生成唯一文件名(避免重复)

String fileName = UUID.randomUUID() + "_" + System.currentTimeMillis() + ".mp3";

File audioFile = new File(storageDir, fileName);

// 5. 写入音频文件(增强空指针检查)

if (audioBuffer == null || audioBuffer.remaining() == 0) {

response.setSuccess(false);

response.setMessage("语音合成失败:未获得有效的音频数据");

log.error("音频缓冲区为空,无法写入文件");

return response;

}

try (FileOutputStream fos = new FileOutputStream(audioFile)) {

fos.write(audioBuffer.array());

// 【优化3:校验文件是否真的生成】避免写入成功但文件不存在的情况

if (!audioFile.exists() || audioFile.length() == 0) {

response.setSuccess(false);

response.setMessage("音频文件生成失败:文件为空");

log.warn("音频文件生成后为空,路径:{}", audioFile.getAbsolutePath());

return response;

}

}

// 6. 组装响应结果

response.setSuccess(true);

response.setMessage("语音合成成功");

response.setFileName(fileName);

response.setFilePath(audioFile.getAbsolutePath());

log.info("语音合成成功,文件路径:{}", audioFile.getAbsolutePath());

} catch (IOException e) {

log.error("语音合成文件写入失败", e);

response.setSuccess(false);

response.setMessage("语音合成文件写入失败:" + e.getMessage());

} catch (Exception e) {

log.error("语音合成接口调用失败", e);

response.setSuccess(false);

// 生产环境可屏蔽具体异常信息,返回通用提示

response.setMessage("语音合成失败:" + e.getMessage());

}

return response;

}

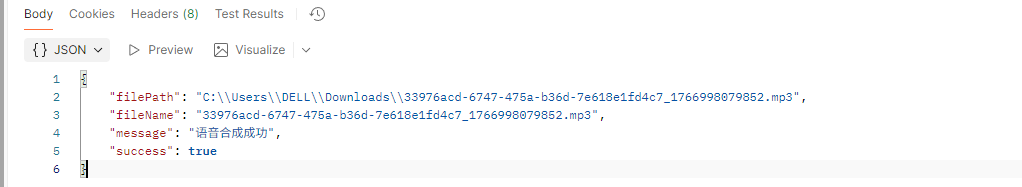

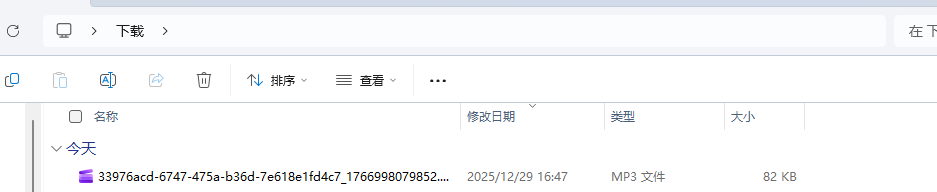

}3.6 效果

接口:http://localhost:8080/api/speechSynthesizer/synthesize

传参:

javascript

{

"text": "通义实验室CosyVoice-v3-plus语音合成效果非常好",

"model": "cosyvoice-v3-plus",

"voice": "longanyang" // 可替换为官方支持的其他音色,如aisxiyu、zhanxiaochen等

}返回的结果:

END

如果觉得这份修改实用、总结清晰,别忘了动动小手点个赞👍,再关注一下呀~ 后续还会分享更多 AI 接口封装、代码优化的干货技巧,一起解锁更多好用的功能,少踩坑多提效!🥰 你的支持就是我更新的最大动力,咱们下次分享再见呀~🌟