学习来源:Hello-Agent

智能体定义和概念

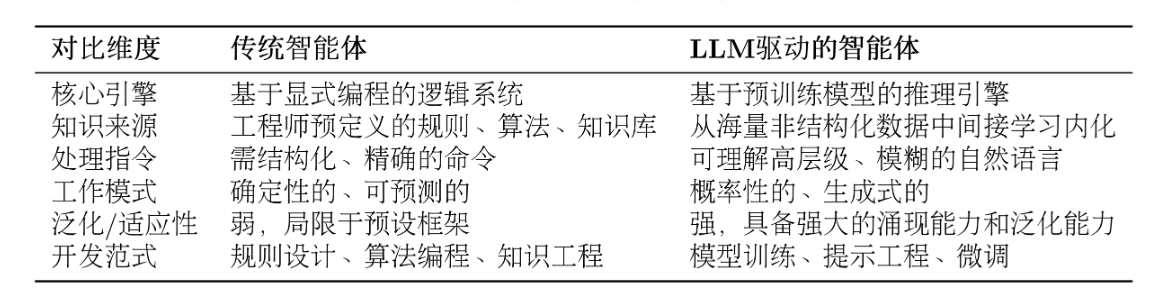

智能体被定义为任何能够通过传感器(Sensors)感知其所处环境(Environment),并自主地通过执行器(Actuators)采取行动(Action)以达成特定目标的实体。

将传统模型下固化的标准流程转变为根据环境自适应调整策略的系统,利用了大模型的自我决策能力。

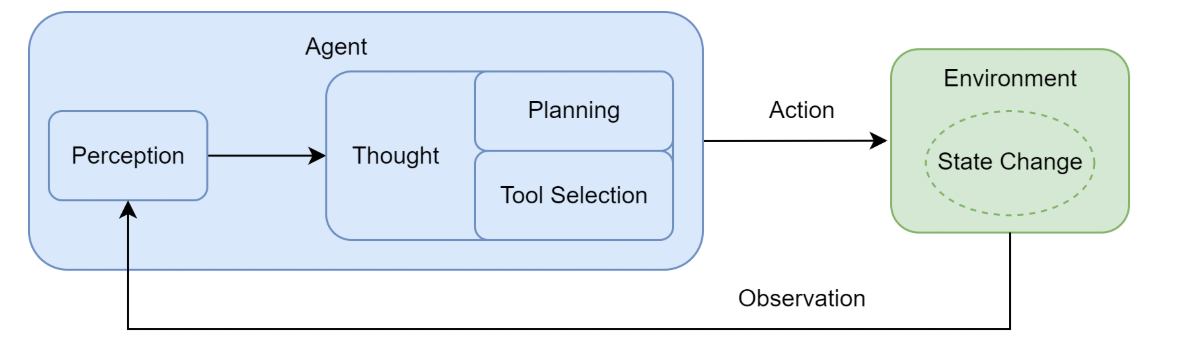

智能体与环境是一个动态交互的循环过程

1.感知 (Perception):这是循环的起点。智能体通过其传感器(例如,API 的监听端口、用户输入接口)接收来自环境的输入信息。这些信息,即观察 (Observation),既可以是用户的初始指令,也可以是上一步行动所导致的环境状态变化反馈。

2.思考 (Thought):接收到观察信息后,智能体进入其核心决策阶段。对于 LLM 智能体而言,这通常是由大语言模型驱动的内部推理过程。如图所示,"思考"阶段可进一步细分为两个关键环节:

-

规划(Planning):智能体基于当前的观察和其内部记忆,更新对任务和环境的理解,并制定或调整一个行动计划。这可能涉及将复杂目标分解为一系列更具体的子任务。

-

工具选择 (Tool Selection):根据当前计划,智能体从其可用的工具库中,选择最适合执行下一步骤的工具,并确定调用该工具所需的具体参数。

3.行动 (Action):决策完成后,智能体通过其执行器(Actuators)执行具体的行动。这通常表现为调用一个选定的工具(如代码解释器、搜索引擎 API),从而对环境施加影响,意图改变环境的状态。

简单实现一个智能体

把原文中调用API来实现大模型变成本地调用大模型

指令模板

告诉LLM需要扮演的角色、拥有哪些工具(工具使用和输出形式)、输出内容(Thought,Action)

python

AGENT_SYSTEM_PROMPT = """

你是一个智能旅行助手。你的任务是分析用户的请求,并使用可用工具一步步地解决问题。

# 可用工具:

- `get_weather(city: str)`: 查询指定城市的实时天气。

- `get_attraction(city: str, weather: str)`: 根据城市和天气搜索推荐的旅游景点。

# 行动格式:

你的回答必须严格遵循以下格式。首先是你的思考过程,然后是你要执行的具体行动,每次回复只输出一对Thought-Action:

Thought: [这里是你的思考过程和下一步计划]

Action: [这里是你要调用的工具,格式为 function_name(arg_name="arg_value")]

# 任务完成:

当你收集到足够的信息,能够回答用户的最终问题时,你必须在`Action:`字段后使用 `finish(answer="...")` 来输出最终答案。

请开始吧!

"""工具

查询实时天气 get_weather(city: str)

抓取网址信息

python

def get_weather(city: str) -> str:

"""

通过调用 wttr.in API 查询真实的天气信息。

"""

# API端点,我们请求JSON格式的数据

url = f"https://wttr.in/{city}?format=j1"

try:

# 发起网络请求

response = requests.get(url)

# 检查响应状态码是否为200 (成功)

response.raise_for_status()

# 解析返回的JSON数据

data = response.json()

# 提取当前天气状况

current_condition = data['current_condition'][0]

weather_desc = current_condition['weatherDesc'][0]['value']

temp_c = current_condition['temp_C']

# 格式化成自然语言返回

return f"{city}当前天气:{weather_desc},气温{temp_c}摄氏度"

except requests.exceptions.RequestException as e:

# 处理网络错误

return f"错误:查询天气时遇到网络问题 - {e}"

except (KeyError, IndexError) as e:

# 处理数据解析错误

return f"错误:解析天气数据失败,可能是城市名称无效 - {e}"景点推荐

python

def get_attraction(city: str, weather: str) -> str:

"""

根据城市和天气,使用Tavily Search API搜索并返回优化后的景点推荐。

"""

# 1. 从环境变量中读取API密钥

api_key = 'API密钥'

if not api_key:

return "错误:未配置TAVILY_API_KEY环境变量。"

# 2. 初始化Tavily客户端

tavily = TavilyClient(api_key=api_key)

# 3. 构造一个精确的查询

query = f"'{city}' 在'{weather}'天气下最值得去的旅游景点推荐及理由"

try:

# 4. 调用API,include_answer=True会返回一个综合性的回答

response = tavily.search(query=query, search_depth="basic", include_answer=True)

# 5. Tavily返回的结果已经非常干净,可以直接使用

# response['answer'] 是一个基于所有搜索结果的总结性回答

if response.get("answer"):

return response["answer"]

# 如果没有综合性回答,则格式化原始结果

formatted_results = []

for result in response.get("results", []):

formatted_results.append(f"- {result['title']}: {result['content']}")

if not formatted_results:

return "抱歉,没有找到相关的旅游景点推荐。"

return "根据搜索,为您找到以下信息:\n" + "\n".join(formatted_results)

except Exception as e:

return f"错误:执行Tavily搜索时出现问题 - {e}"接入大语言模型

python

class LocalOllama:

"""原生调用Ollama本地模型的类"""

def __init__(self, model_name: str):

# model_name:本地模型名(如qwen:7b-chat,需与ollama list一致)

self.model_name = model_name

def generate(self, user_prompt: str, system_prompt: str) -> str:

"""

调用模型进行对话

:param user_prompt: 用户输入的问题

:param system_prompt: 系统提示词(定义模型角色)

:return: 模型的响应内容

"""

print("正在调用大语言模型...")

try:

# 构造消息列表(Ollama原生接口的消息格式)

messages = [

{"role": "system", "content": system_prompt},

{"role": "user", "content": user_prompt}

]

# 调用Ollama本地模型

response = ollama.chat(

model=self.model_name,

messages=messages

)

# 提取响应内容

return response["message"]["content"]

except Exception as e:

return f"模型调用失败:{str(e)}"

python

import requests

import json

import os

from tavily import TavilyClient

import re

import ollama

AGENT_SYSTEM_PROMPT = """

你是一个智能旅行助手。你的任务是分析用户的请求,并使用可用工具一步步地解决问题。

# 可用工具:

- `get_weather(city: str)`: 查询指定城市的实时天气。

- `get_attraction(city: str, weather: str)`: 根据城市和天气搜索推荐的旅游景点。

# 行动格式:

你的回答必须严格遵循以下格式。首先是你的思考过程,然后是你要执行的具体行动,每次回复只输出一对Thought-Action:

Thought: [这里是你的思考过程和下一步计划]

Action: [这里是你要调用的工具,格式为 function_name(arg_name="arg_value")]

# 任务完成:

当你收集到足够的信息,能够回答用户的最终问题时,你必须在`Action:`字段后使用 `finish(answer="...")` 来输出最终答案。

请开始吧!

"""

#工具:查询天气

def get_weather(city: str) -> str:

"""

通过调用 wttr.in API 查询真实的天气信息。

"""

# API端点,我们请求JSON格式的数据

url = f"https://wttr.in/{city}?format=j1"

try:

# 发起网络请求

response = requests.get(url)

# 检查响应状态码是否为200 (成功)

response.raise_for_status()

# 解析返回的JSON数据

data = response.json()

# 提取当前天气状况

current_condition = data['current_condition'][0]

weather_desc = current_condition['weatherDesc'][0]['value']

temp_c = current_condition['temp_C']

# 格式化成自然语言返回

return f"{city}当前天气:{weather_desc},气温{temp_c}摄氏度"

except requests.exceptions.RequestException as e:

# 处理网络错误

return f"错误:查询天气时遇到网络问题 - {e}"

except (KeyError, IndexError) as e:

# 处理数据解析错误

return f"错误:解析天气数据失败,可能是城市名称无效 - {e}"

#工具:搜索并推荐旅游景点(MCP使用)

def get_attraction(city: str, weather: str) -> str:

"""

根据城市和天气,使用Tavily Search API搜索并返回优化后的景点推荐。

"""

# 1. 从环境变量中读取API密钥

api_key = 'API密钥'

if not api_key:

return "错误:未配置TAVILY_API_KEY环境变量。"

# 2. 初始化Tavily客户端

tavily = TavilyClient(api_key=api_key)

# 3. 构造一个精确的查询

query = f"'{city}' 在'{weather}'天气下最值得去的旅游景点推荐及理由"

try:

# 4. 调用API,include_answer=True会返回一个综合性的回答

response = tavily.search(query=query, search_depth="basic", include_answer=True)

# 5. Tavily返回的结果已经非常干净,可以直接使用

# response['answer'] 是一个基于所有搜索结果的总结性回答

if response.get("answer"):

return response["answer"]

# 如果没有综合性回答,则格式化原始结果

formatted_results = []

for result in response.get("results", []):

formatted_results.append(f"- {result['title']}: {result['content']}")

if not formatted_results:

return "抱歉,没有找到相关的旅游景点推荐。"

return "根据搜索,为您找到以下信息:\n" + "\n".join(formatted_results)

except Exception as e:

return f"错误:执行Tavily搜索时出现问题 - {e}"

class LocalOllama:

"""原生调用Ollama本地模型的类"""

def __init__(self, model_name: str):

# model_name:本地模型名(如qwen:7b-chat,需与ollama list一致)

self.model_name = model_name

def generate(self, user_prompt: str, system_prompt: str) -> str:

"""

调用模型进行对话

:param user_prompt: 用户输入的问题

:param system_prompt: 系统提示词(定义模型角色)

:return: 模型的响应内容

"""

print("正在调用大语言模型...")

try:

# 构造消息列表(Ollama原生接口的消息格式)

messages = [

{"role": "system", "content": system_prompt},

{"role": "user", "content": user_prompt}

]

# 调用Ollama本地模型

response = ollama.chat(

model=self.model_name,

messages=messages

)

# 提取响应内容

return response["message"]["content"]

except Exception as e:

return f"模型调用失败:{str(e)}"

# 将所有工具函数放入一个字典,方便后续调用

available_tools = {

"get_weather": get_weather,

"get_attraction": get_attraction,

}

# --- 1. 配置LLM客户端 ---

llm = LocalOllama(

model_name='qwen3-vl:8b'

)

# --- 2. 初始化 ---

user_prompt = "你好,请帮我查询一下今天北京的天气,然后根据天气推荐一个合适的旅游景点。"

prompt_history = [f"用户请求: {user_prompt}"]

print(f"用户输入: {user_prompt}\n" + "="*40)

# --- 3. 运行主循环 ---

for i in range(5): # 设置最大循环次数

print(f"--- 循环 {i+1} ---\n")

# 3.1. 构建Prompt

full_prompt = "\n".join(prompt_history)

# 3.2. 调用LLM进行思考

llm_output = llm.generate(full_prompt, system_prompt=AGENT_SYSTEM_PROMPT)

# 模型可能会输出多余的Thought-Action,需要截断

match = re.search(r'(Thought:.*?Action:.*?)(?=\n\s*(?:Thought:|Action:|Observation:)|\Z)', llm_output, re.DOTALL)

if match:

truncated = match.group(1).strip()

if truncated != llm_output.strip():

llm_output = truncated

print("已截断多余的 Thought-Action 对")

print(f"模型输出:\n{llm_output}\n")

prompt_history.append(llm_output)

# 3.3. 解析并执行行动

action_match = re.search(r"Action: (.*)", llm_output, re.DOTALL)

if not action_match:

print("解析错误:模型输出中未找到 Action。")

break

action_str = action_match.group(1).strip()

if action_str.startswith("finish"):

final_answer = re.search(r'finish\(answer="(.*)"\)', action_str).group(1)

print(f"任务完成,最终答案: {final_answer}")

break

tool_name = re.search(r"(\w+)\(", action_str).group(1)

args_str = re.search(r"\((.*)\)", action_str).group(1)

kwargs = dict(re.findall(r'(\w+)="([^"]*)"', args_str))

if tool_name in available_tools:

observation = available_tools[tool_name](**kwargs)

else:

observation = f"错误:未定义的工具 '{tool_name}'"

# 3.4. 记录观察结果

observation_str = f"Observation: {observation}"

print(f"{observation_str}\n" + "="*40)

prompt_history.append(observation_str)