说实话,我们已经听腻了"AI智能体"这个词。但在大多数时候,所谓的智能体还是像个只会答题的书呆子------你让它写首诗行,但让它帮你用手机订张从北京到上海的高铁票,再顺手发给秘书?它大概率会卡在第一步,或者胡乱点击一通。

为什么?因为它们不懂手机屏幕,也不懂人。

不过,阿里巴巴通义实验室最近扔出的这张王炸------MAI-UI,可能真的要改变这个局面了。这不仅仅是一个新的多模态模型,更像是一个给手机装上的"自动驾驶系统"。

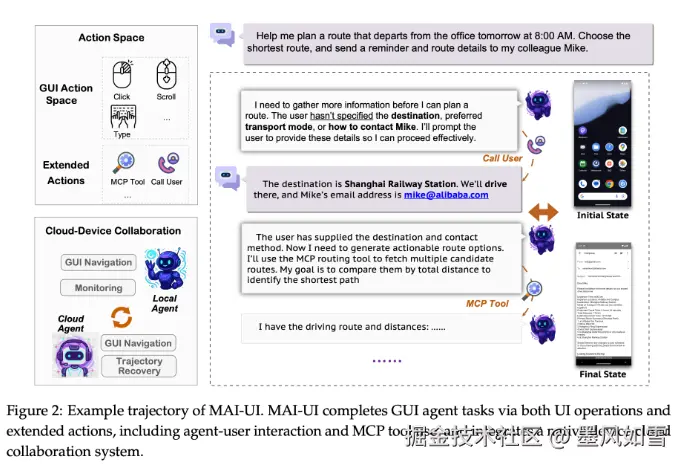

终于学会了"张嘴问人"

现在的GUI Agent(图形界面智能体)有个通病:死脑筋。

举个例子,你跟它说:"把我的简历发给HR。" 传统的AI会直接愣住,或者开始在他的训练数据里瞎猜,甚至可能把你的购物清单发出去。

MAI-UI最大的不同在于,它拥有了原生的人机交互能力。面对模糊指令,它不会盲目操作,而是会暂停下来问你:"老板,你要发哪一份简历?HR的邮箱是哪个?"

这听起来很简单,但在技术上却是巨大的飞跃。阿里团队在训练中引入了"拒绝采样"和专门的交互动作,治好了AI喜欢"不懂装懂"的毛病。这让它不仅仅是一个执行脚本,更像是一个懂得和你确认需求的真实助理。

抄近道:不只是傻傻点屏幕

以前的屏幕智能体完全依赖视觉识别------找图标、模拟点击、滑动。这在复杂APP里很容易出错,效率也低。

MAI-UI引入了一个很极客的功能:MCP工具调用。

简单说,它是个"双面手"。对于简单的界面,它像人一样去点击;但对于复杂的任务,比如"查询GitHub某仓库的最近提交"或者"计算两地驾车距离",它会直接跳过繁琐的UI操作,在后台调用API接口(MCP)直接拿数据。

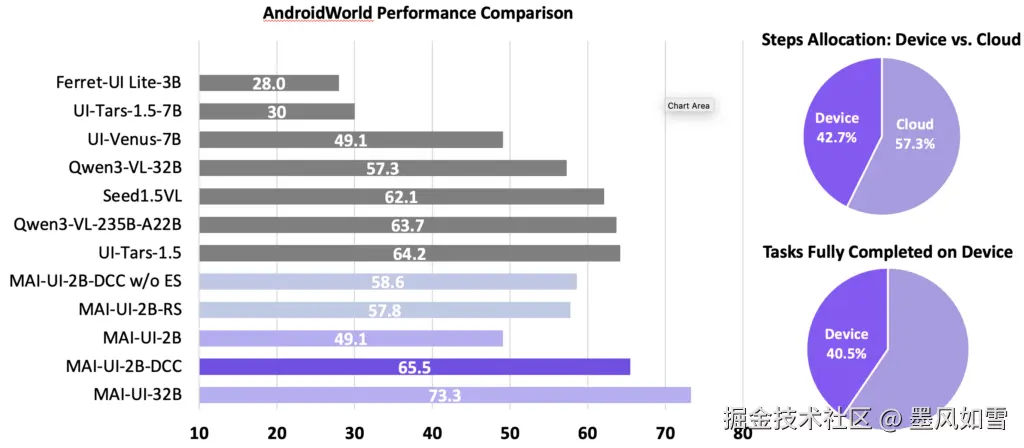

这一招"抄近道",把原本需要几十次点击、容易出错的流程,压缩成了几次精准的代码调用。在MobileWorld的测试中,这让它的成功率直接甩开了最好的竞争对手30多个百分点。

大小脑配合,隐私也没落下

把所有操作都交给云端大模型,不仅慢,还让人担心隐私------谁愿意把银行卡密码传到云端去识别?

MAI-UI搞了一套端云协同的架构。

- 端侧小模型(2B版本): 住在你的手机里,反应快,负责处理日常琐事,盯着屏幕状态,绝不泄露隐私。

- 云端大模型(235B版本): 遇到复杂的逻辑推理难题时,端侧搞不定了,才会请云端的大脑介入。

这种动态调度,让端侧任务成功率提升了33%,同时还可以减少40%的云端调用。既省了流量和算力,又保住了你的隐私。

战绩如何?数据说话

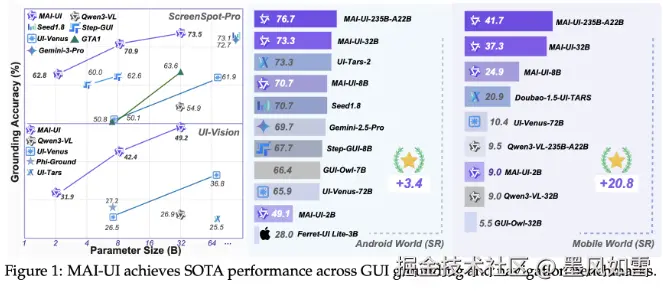

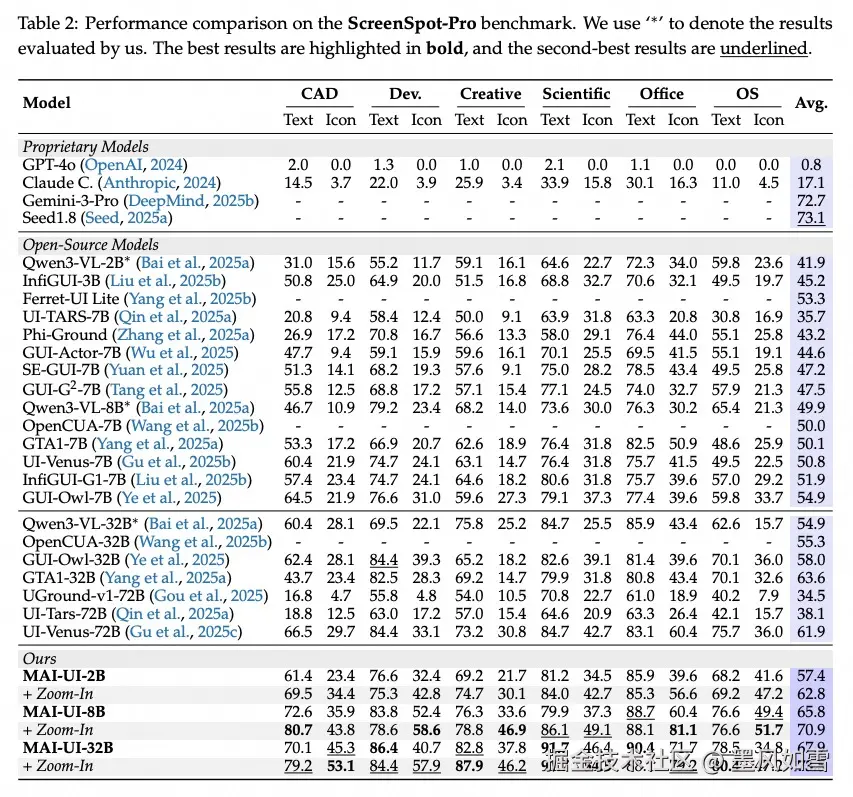

别光听概念,看看硬指标。在目前的GUI智能体竞技场上,MAI-UI的表现可以用"霸榜"来形容。

在著名的AndroidWorld 基准测试中,MAI-UI拿下了76.7%的成功率。 这个成绩意味着什么?它直接超越了Google的Gemini-2.5-Pro ,也击败了之前的开源强者UI-Tars-2。即便是只有2B参数的端侧小模型,其表现也比同级别的Ferret-UI Lite高出了整整21个百分点。

这背后,是阿里在一个拥有500多个并行环境的"虚拟手机农场"里,通过大规模在线强化学习(Online RL)反复操练的结果。它见识过各种弹窗广告、UI漂移和突发状况,所以比温室里长大的模型更抗造。

写在最后

好消息是,通义实验室并没有把这个好东西藏着掖着。目前,MAI-UI的2B和8B模型权重、代码已经在GitHub开源,连同那个高难度的评测基准MobileWorld也一并放了出来。

对于开发者来说,这意味着我们离"动动嘴,手机自动帮我搞定一切"的科幻场景,又近了一大步。或许不久的将来,你的手机操作系统里,就住着这样一个不仅看得懂屏幕,还懂得这什么时候该问你、什么时候该自己动手的"真·智能助理"。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站