摘要

超高动态范围(UHDR)场景在明亮区域和黑暗区域之间表现出显著的曝光差异。这种情况在有光源的夜间场景中很常见。即使使用标准曝光设置,也常常会出现具有边界峰值的双峰强度分布,这使得同时保留高光和阴影细节变得困难。基于RGB的包围曝光方法可以通过长短曝光对捕捉两端的细节,但容易出现错位和重影伪影。我们发现,短曝光图像已经保留了足够的高光细节。超高动态范围(UHDR)重建的主要挑战在于降噪和恢复暗部区域的信息。与RGB图像相比,RAW图像由于其更高的位深度和更可预测的噪声特性,在应对这一挑战方面具有更大的潜力。这就引出了一个关键问题:我们能否仅通过一张短曝光的RAW图像,就学会看清超高动态范围(UHDR)场景中的所有事物?在本研究中,我们仅依赖单张短曝光帧,这从本质上避免了重影和运动模糊,使其在动态场景中尤为稳健。为实现这一目标,我们提出了UltraLED------一种两阶段框架,该框架首先通过比率图进行曝光校正以平衡动态范围,然后借助亮度感知的RAW降噪器增强暗部区域的细节恢复。为了支持这一设置,我们设计了一个9档曝光pipline来合成逼真的超高动态范围(UHDR)图像,并基于多样化的场景构建了相应的数据集,该数据集仅使用最短曝光作为重建输入。大量实验表明,UltraLED 显著优于现有的单帧方法。

UHDR是什么?

UHDR是场景本身的亮度动态范围极其巨大的一类真实世界视觉场景,其最亮与最暗区域的亮度比远远超过传统成像系统(相机、显示器)或普通 HDR 所能完整覆盖的范围。

常见的UHDR场景包括:

- 夜晚城市

- 隧道出口

- 星空

曝光是什么?

曝光 = 相机在拍照时,让光照射到传感器上的总量

短曝光:曝光时间很短,亮部细节保留得好,暗部容易看不清。

长曝光:曝光时间长,暗部细节清楚,高光区域容易饱和。

引言

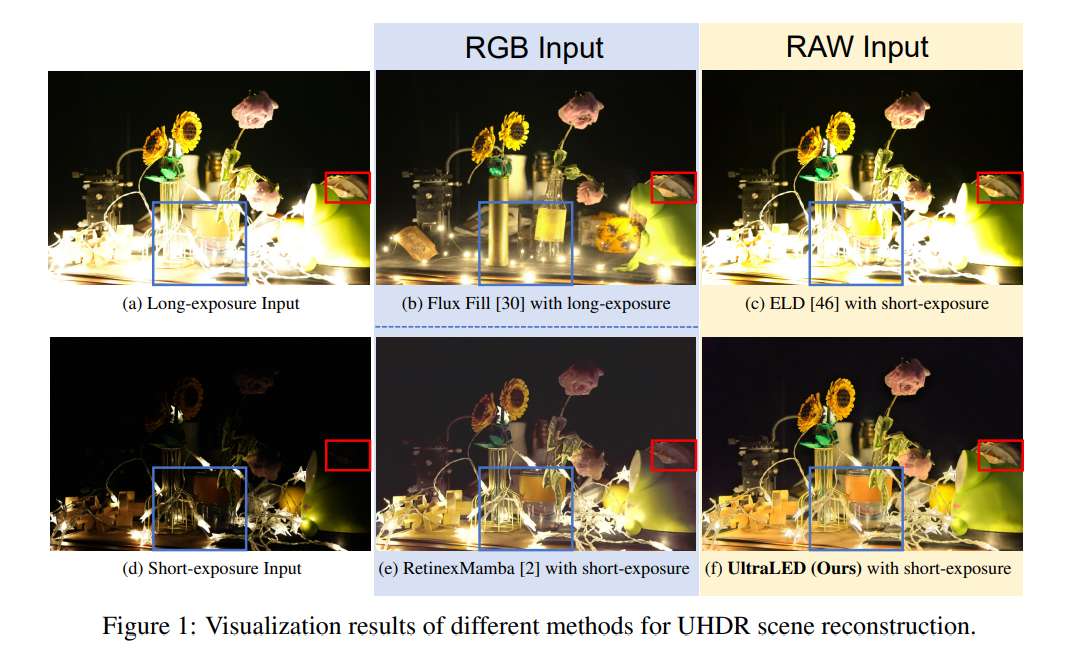

超高动态范围(UHDR)场景在日常生活中很常见,例如被车头灯和路灯照亮的夜晚街道,或者有明亮的窗户光线和昏暗内部环境的室内场所。这些场景中的极端对比度超出了传统相机单次曝光的能力范围,常常导致双峰强度分布,其中高光区域和阴影区域形成各自独立的峰值,而中间调很少。这种现象使得相机难以在整个亮度范围内保留细节,常常导致视觉信息丢失和图像保真度下降。最近的方法通常使用包围法[17, 14, 54, 7, 36]来捕捉从短到长的一系列曝光。然而,这种方法本身受到帧间运动的影响,会导致错位和重影伪影,从而降低重建质量。一些生成式方法[30]会从单一长曝光输入中(Fig1.a)虚构缺失的高光部分,但是难以恢复饱和区域的真实细节,如图Fig1.b。此外,一些方法[15, 2]采用短曝光输入(即图1(d))来避免高光溢出。此外,一些方法[15, 2]采用短曝光输入(即图1(d))来避免高光裁剪。然而,由于8位RGB图像的动态范围有限,阴影区域可能仅用4位来表示,这会导致严重的量化伪影和噪声,如图1(e)所示。图1中的观察结果得出两个关键结论:1)在没有短曝光参考的情况下,基于长曝光的方法从根本上无法恢复高光区域;2)基于短曝光的方法主要受限于位深约束和暗部区域的噪声。幸运的是,由于RAW图像具有更高的位深度和更简单的噪声分布,它们能够为此类任务提供显著优势。如图1(c)的红框所示,右侧处于黑暗中的地球已被修复,呈现出类似于长时间曝光的效果。结果表明,即使在极端弱光条件下,RAW格式图像也能保留更完整、更真实的细节。因此,对于短曝光的RAW图像,我们只需要进行曝光校正,因为它们已经包含了未被截断的高光部分和从低光区域恢复的细节。

然而,两个核心挑战仍然存在:

极端的曝光差异,再加上低光区域的严重噪点,导致了一个极不适定的重建问题。同时优化曝光校正和去噪会降低学习效率和重建精度。复杂的噪声模型 [46] 在极弱光条件下表现出更优异的效果,而像 PG 噪声模型这类较简单的模型则在较亮区域表现更佳 [28]。这种差异源于这样一个事实:随着图像亮度的变化,噪声分布往往会遵循不同的已知分布。因此,要同时重建超高动态范围(UHDR)场景的亮区和暗区具有一定的挑战性。

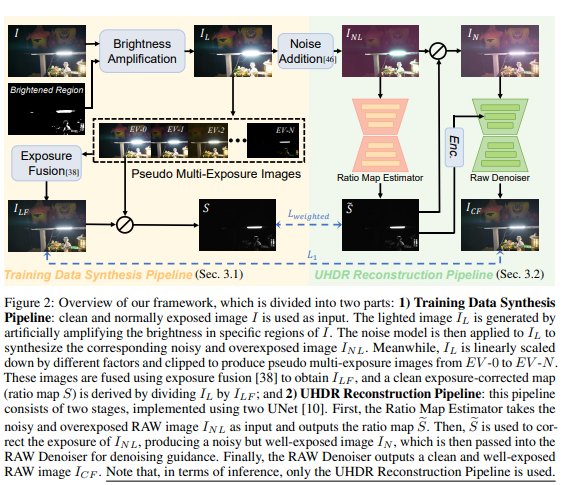

为了应对这些挑战,我们将超高动态范围(UHDR)重建过程拆分为两个不同的阶段。

首先,利用RAW图像的高位深特性,我们训练一个网络来生成一个比率图,该比率图能够动态校正图像各处的局部曝光。其次,考虑到噪声特性会随亮度变化,我们引入了一种亮度感知噪声模型。为了指导去噪网络,我们利用比率图对亮度信息进行编码,从而实现对亮区和暗区的联合重建。

此外,目前没有可公开获取的适用于训练和评估超高动态范围(UHDR)重建方法的数据集。为了填补这一空白,我们开发了一种新颖的流程,该流程利用RAW图像的特性来合成一个9档曝光序列,并从中分别获取无噪声的比率图和相应的融合结果。值得注意的是,所有场景都是在静态条件下拍摄的,这使得多曝光采集能够在没有对齐问题或重影伪影的情况下进行。

方法

合成数据流程

在不受约束的真实世界条件下,拍摄完美对齐、无噪点的多曝光图像仍然极具挑战性。因此,直接从真实场景中构建大规模的成对数据集并非易事,而且往往不切实际。在本研究中,我们利用一个大规模的曝光良好的RAW图像库来克服这一限制,并为整个处理流程合成成对数据。没有高光裁剪的RAW图像在光强度和信号值之间呈现出线性关系,同时具有可预测的噪声分布。我们能够直接获取曝光不足的输入和多曝光序列,从而生成曝光良好的参考图像。由于这些曝光充分的RAW图像没有高光溢出问题,为了完整性,我们还模拟了人为过曝的情况。因此,我们的训练数据合成流程包括:1)亮度增强,2)曝光融合,3)噪声建模。

亮度增强 :

增强局部图像亮度,我们人工合成过曝光效果,遵循先前研究 [16] 的步骤来生成饱和的高光区域。为了进一步模拟超高清动态范围(UHDR)场景中高光的随机分布,我们注入了额外的随机高光块。被提亮的区域是随机选择的,通过随机增益因子增强(真实 UHDR 场景中:高光位置是随机、不规则的),用双边滤波器进行平滑处理,最后用高斯核在边界处进行羽化,以模拟光的扩散。给定保留高光细节的图像,我们通过逐步降低全局光照来构建伪多曝光图像,具体实现方式为对RAW数据进行线性缩放,然后进行值裁剪。

对于正常图像,使用以下公式合成EV-i:

EV−i=clip(IL2i,0,1) EV-i = clip(\frac{I_L}{2^i},0,1) EV−i=clip(2iIL,0,1)

其中,i表示图像曝光值的缩小因子,ILI_LIL表示人工过曝光的RAW输入,clip(x, 0, 1)表示将x的值裁剪到0到1之间,以此模拟过曝光截断现象。由此产生的曝光范围为EV -0至EV -N(其中EV表示曝光值,每一步都会使入射光翻倍或减半),随后会用于HDR融合阶段。

曝光融合

由于伪多重曝光图像是通过调制单张保留高光的RAW帧的亮度合成的,因此帧间错位问题从本质上得到了消除。我们采用曝光融合[38]将这些图像合成为一张曝光良好的合成图。由于曝光融合在RGB域中运行,因此首先使用预定义的图像信号处理(ISP)参数将每个RAW帧渲染到RGB域,之后通过反处理流水线[6]将融合结果转换回RAW域。

该过程会生成一幅无噪声、曝光良好的参考图像ILFI_{LF}ILF,这幅图像经过了光照处理和融合,同时还会生成一幅清晰的比率图S,其定义为

S=ILILF S = \frac{I_L}{I_{LF}} S=ILFIL

曝光融合的目的:把不同曝光下的优势区域拼成一个整体合理曝光的参考图像

曝光比率图S:每个像素"从过曝状态拉回到合理曝光状态所需要的比例"

噪声模型

我们将超高动态范围(UHDR)场景中的噪声分为三部分,包括信号相关噪声、信号无关噪声[46, 52, 21]和亮度感知噪声。我们对信号相关噪声和信号无关噪声的建模与RAW域中现有的方法[46]相同。由于超高动态范围(UHDR)场景不同区域的亮度差异显著,以及后续的曝光校正过程,会引入亮度感知噪声。

对于最终输入的噪声图像INI_NIN

NdeN_{de}Nde为信号相关噪声,NinN_{in}Nin为信号无关噪声,NbaN_{ba}Nba代表亮度感知噪声。SA指的是合成人工过度曝光区域的过程

噪声来源:

- 信号相关噪声NdeN_{de}Nde:光子噪声-来自光本身的随机性,和亮度强相关

- 信号无关噪声NinN_{in}Nin:读出噪声-来自电子电路的不完美,和亮度无关

- 亮度感知噪声NbaN_{ba}Nba:由于亮度/曝光被放大或压缩,原有噪声被"非均匀地重新放大"的结果。

UHDR 重建流程

解耦曝光矫正 :

我们将超高动态范围(UHDR)场景的重建分为两部分:分别学习图像的曝光校正模式和简单的噪声分布。具体来说,该流程包括三个步骤:1) 使用一个简单的UNet(其架构与SID [10]中使用的相同)来预测比例图Sˉ\bar{S}Sˉ

2)预测的比例图Sˉ\bar{S}Sˉ被应用于UHDR输入INLI_{NL}INL来构建一个曝光良好的噪声输入INI_NIN 3)最后,另一个同样的UNet用于对INI_NIN去噪。

比率图编码: 比率图是图像亮度的无噪声表示。我们的目标是引入一个隐性特征,以捕捉亮度和噪声之间的关系。亮度水平相似的区域往往具有相似的理想比例值,并且相应地具有相似的噪声强度水平。由于低维比率值不足以表示不同亮度条件下复杂的噪声分布,我们使用高斯编码来扩展比率图的维度。这是因为随着比率值变得更加接近,高斯分布能够模拟噪声强度的逐渐变化。此外,我们引入了一个与编码前的比率相对应的权重,该权重可调节有效信号强度。对于每一个比例rrr,编码ECrEC_rECr表示如下:

ECr=exp(−(r−y)22σ2)2πσr EC_r = \frac{exp(-\frac{(r-y)^2}{2\sigma^2})}{\sqrt{2\pi}\sigma r} ECr=2π σrexp(−2σ2(r−y)2)

y是在预定义的维度下对比例参数空间进行均匀采样得到的向量表示,比率参数空间应包含该比率可能取的所有值。比率图Sˉi\bar{S}_iSˉi的每个像素对应的rrr计算如下:

r=RSˉ r = \frac{R}{\bar{S}} r=SˉR

这种集成编码方案通过多层感知机和零初始化卷积残差块注入到去噪网络中,从而使比例自适应去噪引导能够在不同比例下更好地恢复细节和纹理。这种配方确保降噪器能根据放大系数动态调整其运行,同时在不同的比率条件下保持噪声抑制的一致性。

我的理解:比率图反映了亮度被放大/压缩了多少,也就是在不同曝光比例下,噪声统计如何变化,但是噪声分布是非线性且连续变化的,而比率图只是一个标量不足以表达噪声状态,因此选择高斯编码。高斯核用来表示当前r对每一个典型曝光状态yiy_iyi的相似度是多少?

Loss function

对于我们的两阶段网络,我们为不同阶段采用了不同的损失函数。在曝光校正阶段,由于我们的比率图数值范围较大,我们使用加权L1损失[39]来确保数值稳定性,而非标准的L1损失:

Lweighted=1N∑i=1N∣Si−S~i∣Si+ϵ \mathcal{L}{\text{weighted}} = \frac{1}{N} \sum{i=1}^{N} \frac{\left| S_i - \tilde{S}_i \right|}{S_i + \epsilon} Lweighted=N1i=1∑NSi+ϵ Si−S~i

去噪阶段是标准的L1损失:

L1=1N∑i=1N∣ILF−ICF∣ \mathcal{L}1 = \frac{1}{N} \sum{i=1}^{N} \left| I_{LF} - I_{CF} \right| L1=N1i=1∑N∣ILF−ICF∣

实验

提出的UHDR数据集

实施细节

训练数据和网络结构:

我们使用基于RawHDR数据集[55]真实值的合成数据来训练我们的网络,选择该数据集是因为它具有高位深度、良好的曝光度和无噪声的特点。我们的比率图估计器采用了简单的U-Net架构[42]来捕捉亮度分布的特征。该模块以一张含噪的RAW图像作为输入,并输出一张无噪的比率图。在我们的实验中,用于构建比率图编码的超参数σ被设置为30。对于去噪网络,可以采用多种架构。然而,由于我们方法的优势主要在于整体流程和数据处理策略,为了与其他方法进行公平比较,我们使用了相同的简单U-Net框架[42]。需要注意的是,采用具有更高计算能力和更多参数的更复杂网络可能会进一步提升性能。相关实验将在补充材料中进行讨论。

优化策略与评估指标。

我们首先训练比率图估计器网络,然后在训练去噪网络之前冻结其参数。对于去噪网络,我们采用了一种在RAW域去噪中广泛使用的训练策略,如ELD[46,28]中所述。比率图估计器需要相对较少的训练迭代次数,使用Adam优化器仅需30,000次迭代,学习率为5×10⁻⁵。为了全面评估定量性能,我们采用PSNR、SSIM和LPIPS作为评估指标。

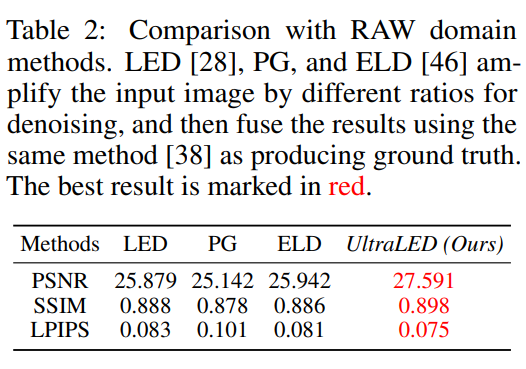

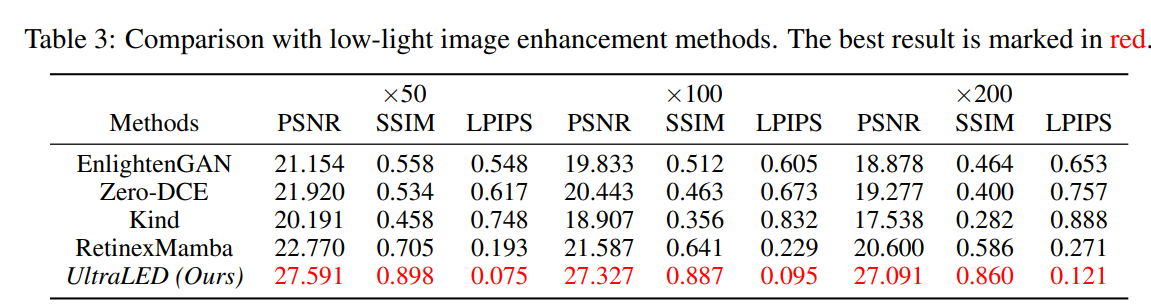

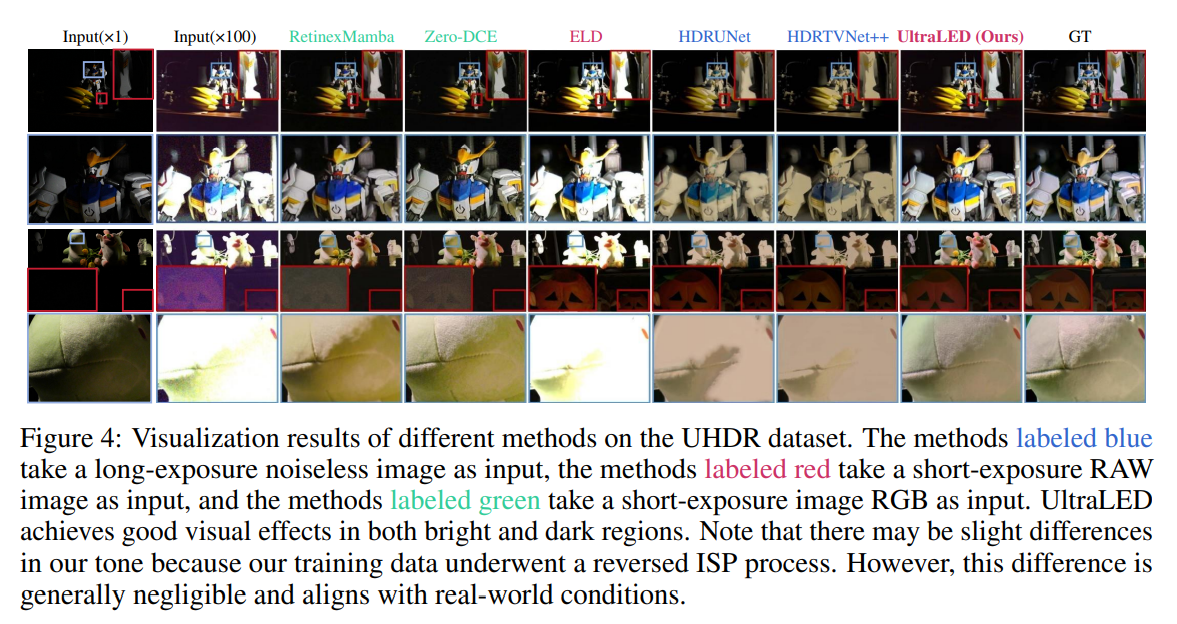

比较实验

UltraLED比HDR类方法高出2个点左右,比RAW域方法高出2个点左右,比低光照增强方法高出5个点。

消融实验

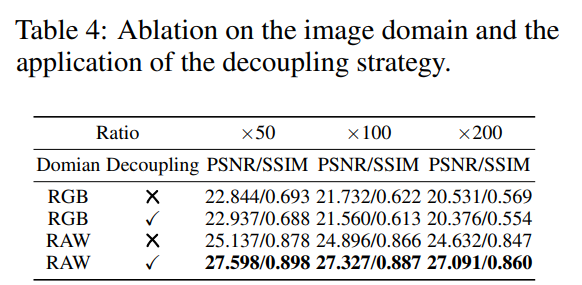

RAW域解耦策略

表4说明解耦策略在RGB域中效果不大,在RAW域中表现较好,RAW域效果要显著优于RGB域

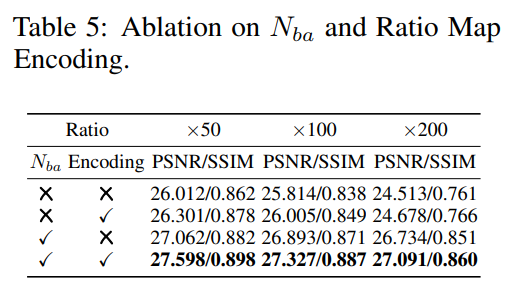

亮度感知噪声与比率图编码。

表5说明了亮度感知噪声和比率图编码的有效性。

可控的局部曝光校正

UltraLED主要将比例应用于图像最暗的区域,对于已经较亮的区域,会自适应地调整局部曝光。仅通过全局亮度调整,图像往往会过度曝光,丢失重要的高光细节,而UltraLED具有可控的局部曝光校正能力。

限制

尽管UltraLED在超高清动态范围(UHDR)场景中的表现显著优于RGB域方法,但它与RAW降噪方法[46, 52, 21]存在一个共同的局限性:噪声模型对相机特定参数有很强的依赖性。为了更直观地说明这一点,我们在使用索尼A7M4相机拍摄的UHDR数据集上,测试了不同相机运用其各自噪声参数时的性能。表6中的结果表明,噪声参数不准确所带来的影响会随着噪声强度的增加而增大。因此,对于不同类型的相机,需要使用针对该类型相机专门校准的噪声参数来重新训练模型。