基于 YOLOv8 的学生课堂行为检测-完整项目源码

一、问题背景:为什么要做"课堂行为识别"

在智慧校园和数字化教学逐步落地的过程中,课堂行为数据正在从"不可量化"走向"可分析、可追溯、可评估"。

在真实教学场景中,教师和管理者往往关注以下问题:

- 学生是否专注听讲?

- 是否存在频繁低头、趴桌、玩手机等行为?

- 课堂互动(举手、回答问题)是否足够积极?

- 不同时间段、不同课程的学习状态差异如何?

传统方式主要依赖人工巡视或事后主观评价,存在明显局限:

| 方式 | 问题 |

|---|---|

| 人工观察 | 成本高、主观性强、难以量化 |

| 问卷反馈 | 滞后、失真、难以持续 |

| 简单视频回放 | 无结构化信息、分析效率低 |

因此,基于计算机视觉的课堂行为识别系统 成为一个极具实际价值的工程方向。

源码下载与效果演示

哔哩哔哩视频下方观看: www.bilibili.com/video/BV1m7...

包含:

📦完整项目源码

📦 预训练模型权重

🗂️ 数据集地址(含标注脚本

二、整体技术路线设计

本项目的目标不是"只跑一个模型 Demo",而是构建一个可直接使用的完整系统。因此在设计之初,整体架构就围绕以下三点展开:

- 模型必须实时可用

- 系统必须非算法人员也能操作

- 工程结构支持后续扩展

2.1 系统总体架构

整体采用典型的三层结构:

数据层 → 模型层 → 应用层- 数据层:YOLO 格式行为数据集(图片 + 标签)

- 模型层:YOLOv8 Detection 模型(PyTorch)

- 应用层:PyQt5 桌面 GUI + 多输入推理模块

markdown

摄像头 / 视频 / 图片

↓

YOLOv8 行为检测

↓

行为类别 + 置信度

↓

GUI 实时展示 / 保存结果

三、为什么选择 YOLOv8 做课堂行为识别

在行为识别领域,常见技术路线包括:

- CNN + 分类(仅判断整张图)

- CNN + 时序模型(LSTM / Transformer)

- 目标检测 + 行为标签

在课堂场景中,我们更关心的是:

"谁"在"做什么行为"

因此,目标检测模型比单纯分类模型更合适。

3.1 YOLOv8 的工程优势

YOLOv8 相比早期 YOLO 版本,具备明显工程优势:

- Anchor-Free 设计 不再依赖复杂 Anchor 调参,对新场景友好

- 端到端训练流程简化

- 推理速度快,适合实时摄像头

- Ultralytics 官方生态成熟

- 原生支持 ONNX / TensorRT 导出

对于"课堂实时监测"这种 FPS 和稳定性同等重要 的任务,YOLOv8 是非常理性的选择。

四、行为数据集构建:比模型更重要的一步

在实际项目中,数据质量往往决定上限。

4.1 行为类别设计原则

本项目中的课堂行为类别遵循三个原则:

- 视觉上可区分

- 教学场景有明确意义

- 避免过细导致标注困难

示例类别包括:

- 举手

- 看书

- 写作业

- 听讲

- 趴桌

- 玩手机

这些行为都可以通过单帧图像 + 空间特征进行判别,而无需复杂时序建模。

4.2 数据集结构(YOLO 标准)

text

dataset/

├── images/

│ ├── train/

│ └── val/

├── labels/

│ ├── train/

│ └── val/标签采用 YOLO 标准格式:

arduino

class_id x_center y_center width height例如:

txt

3 0.51 0.36 0.39 0.32所有坐标均为 相对比例,方便多分辨率训练。

五、模型训练与参数配置经验

5.1 训练策略

在课堂场景中,模型训练重点并不是追求极限精度,而是:

- 稳定收敛

- 类别区分度清晰

- 推理速度可控

示例训练命令:

bash

yolo detect train \

data=dataset/classroom.yaml \

model=yolov8n.pt \

epochs=100 \

batch=16 \

imgsz=6405.2 关键指标解读

训练完成后,重点关注:

- mAP@0.5:是否稳定在 90% 左右

- 混淆矩阵:是否存在行为间严重混淆

- box_loss / cls_loss 收敛情况

课堂行为中,"看书 / 写作业"是最容易混淆的类别,通常需要通过 数据平衡和样本增强 来改善。

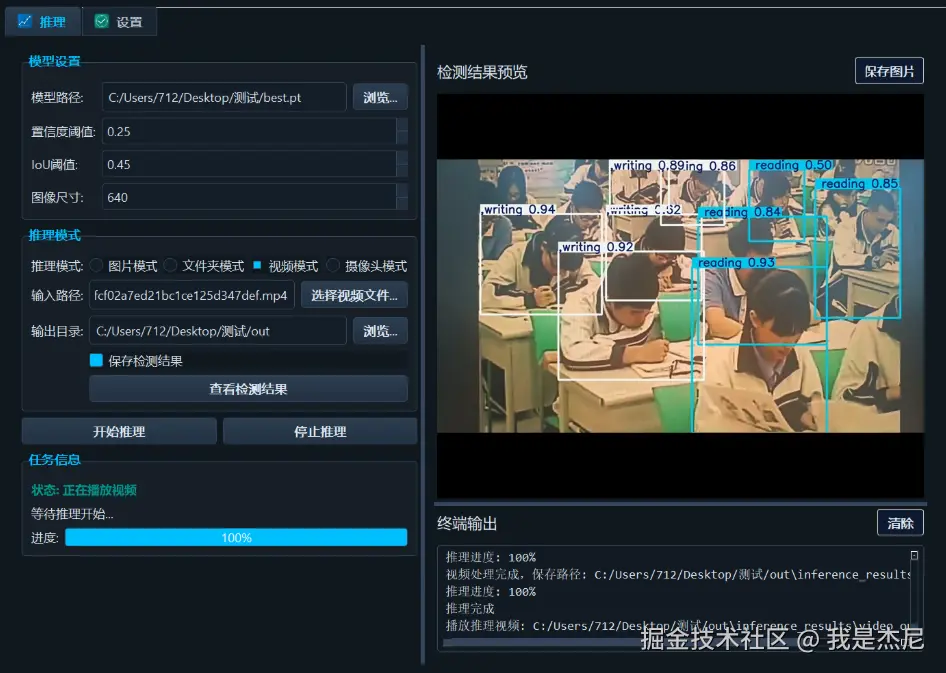

六、推理系统设计:从模型到可用软件

如果说模型是"发动机",那么 GUI 系统就是"驾驶舱"。

6.1 多输入推理设计

系统支持以下输入形式:

- 单张图片检测

- 文件夹批量检测

- 视频文件检测

- 摄像头实时检测

其核心思想是:

统一推理接口,不同输入仅影响数据读取方式

python

results = model(frame, conf=0.25)

6.2 PyQt5 界面设计要点

GUI 设计遵循三个工程原则:

- 功能按钮逻辑清晰

- 推理与界面解耦

- 避免阻塞主线程

常见功能包括:

- 模型加载

- 输入源选择

- 实时结果显示

- 结果保存开关

这种设计使得非算法人员也能直接运行系统。

七、实际应用价值分析

在真实教学场景中,该系统可用于:

- 课堂状态统计分析

- 教学质量评估辅助

- 学生行为数据可视化

- 智慧教室系统模块化集成

相比"单纯监控",该系统更强调:

结构化行为数据的自动生成

八、可扩展方向与进阶思路

该项目并非终点,而是一个可持续扩展的工程起点。

可扩展方向包括:

- 引入姿态估计(Keypoints)

- 多摄像头联动分析

- 行为时间序列建模

- 行为频次 / 趋势统计

- 与教学管理系统对接

未来可从"检测行为"升级为:

理解课堂状态

九、总结

本文从工程视角出发,完整复盘了一个 基于 YOLOv8 的学生课堂行为识别系统 从需求分析、模型选择、数据构建、训练评估到 GUI 应用落地的全过程。

该项目的核心价值不在于"某一个模型指标",而在于:

- 模型可实时运行

- 系统可直接部署

- 工程结构可持续演进

对于希望将 计算机视觉真正落地到教育场景 的开发者而言,这是一个非常具有实践意义的方向。

本文从工程实践角度系统性地梳理了一个基于 YOLOv8 的学生课堂行为识别系统的完整落地过程,涵盖需求背景、模型选型、数据集构建、训练评估以及 PyQt5 图形化应用封装等关键环节。实践表明,目标检测模型在课堂行为分析这一复杂场景中具备良好的实时性与可扩展性,能够有效将"不可量化的课堂状态"转化为结构化、可分析的数据资产。相比单一算法实验,本项目更强调模型与系统的协同设计,使 AI 能够真正服务于教学管理与教学分析。未来,随着姿态估计、多模态数据与行为统计分析的引入,该类系统有望从行为识别进一步升级为课堂状态理解与教学决策支持,为智慧校园建设提供更加可靠的技术基础。