LazyLLM 多 Agent 应用全流程实践:从源码部署到可视化 Web 调试的低代码方案

前言:为什么选择 LazyLLM 构建多 Agent 大模型应用?

LazyLLM 作为低代码构建多 Agent 大模型应用的开发工具,可大幅降低大模型应用的开发与部署门槛。本文聚焦其在豆包模型的落地实践,将从源码部署豆包文本模型的完整配置步骤入手,延伸至官方 WebModule 启动可视化 Web 界面的实操流程,并配套精准性、简洁度等多维度的部署测试说明,为开发者提供可直接对照的实操指南,助力高效完成豆包模型在 LazyLLM 框架下的部署与验证。

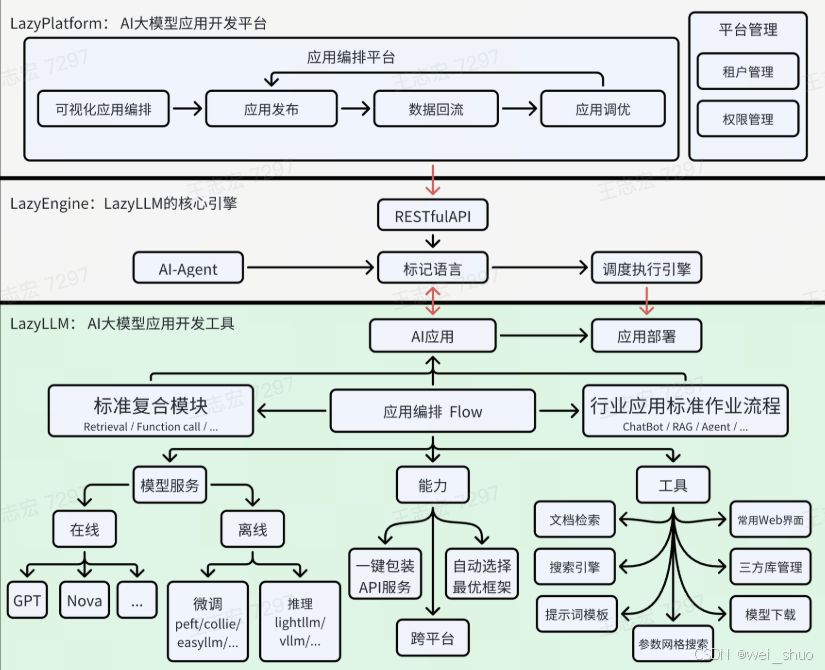

LazyLLM 整体架构解析:三层联动的多 Agent 运行体系

LazyLLM 的架构分为三层级递进结构,各层级分工明确且联动协同,实现从应用开发到落地执行的全流程覆盖:

- 上层(LazyPlatform AI 大模型应用开发平台):核心含应用编排平台以可视化编排、发布、回流、调优的闭环完成应用构建迭代与平台管理模块通过租户、权限管理支撑多用户运维,是开发者的高效开发管理入口

- 中层(LazyEngine LazyLLM 核心引擎):通过 RESTful API 接收上层编排指令,经标记语言解析后,由调度执行引擎协调底层能力,搭配 AI-Agent 作为执行载体,实现指令的高效传递与调度

- 下层(LazyLLM AI 大模型应用开发工具):提供标准复合模块覆盖在线、离线模型服务、应用编排 Flow 衔接 ChatBot 等行业流程、能力工具模块,为多 Agent 大模型应用开发提供全链路支撑,降低开发门槛

源码方式部署豆包文本模型:LazyLLM 多轮对话能力配置全流程

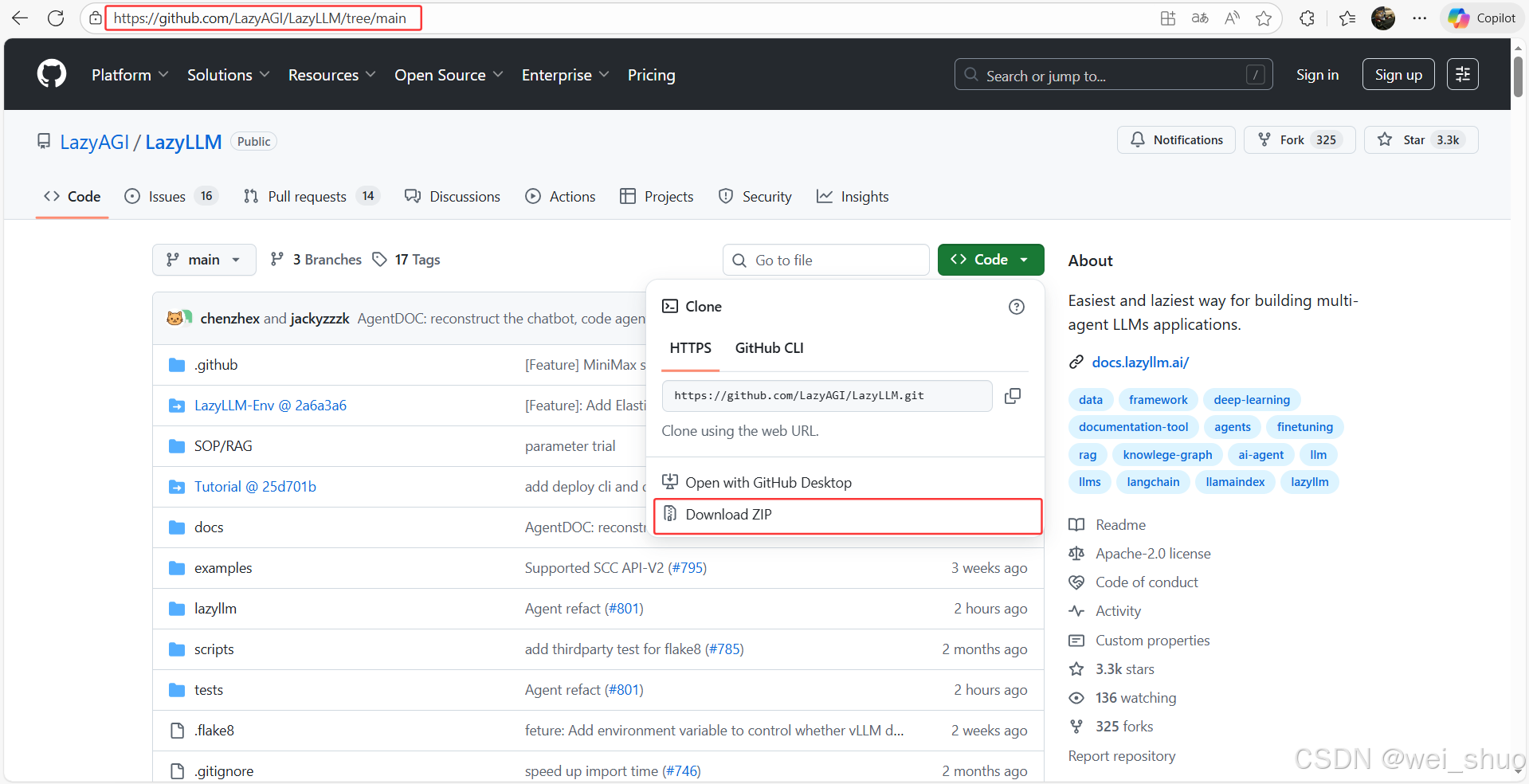

1、GitHub 下载源码

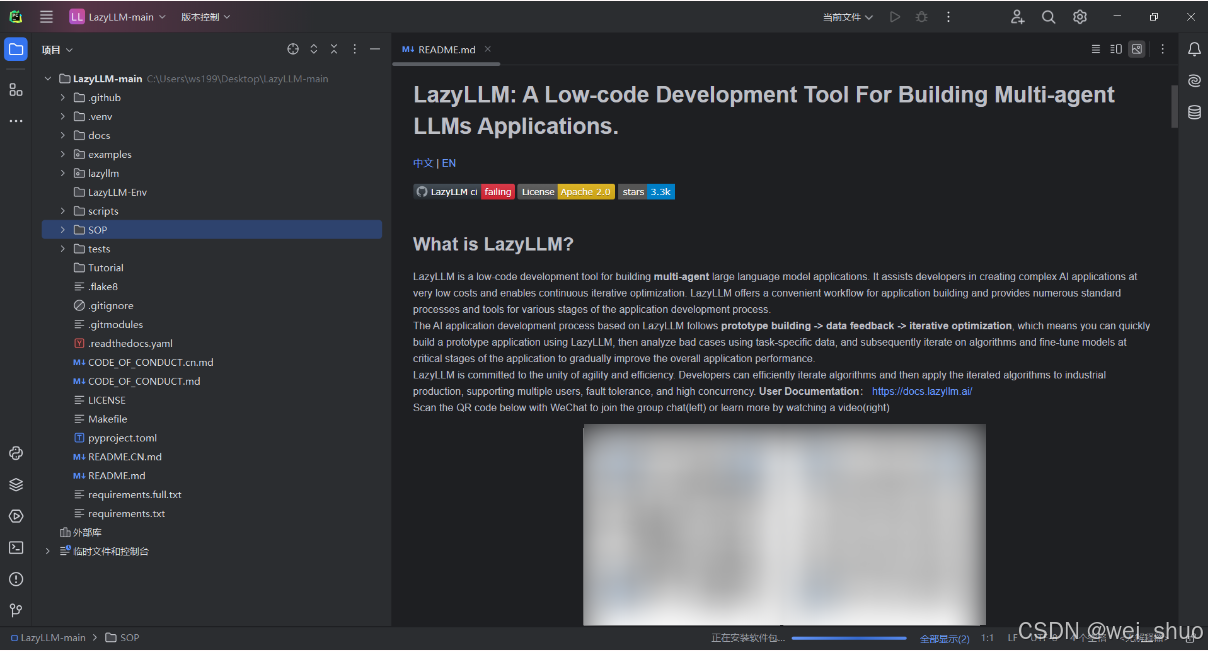

2、PyCharm 打开项目代码

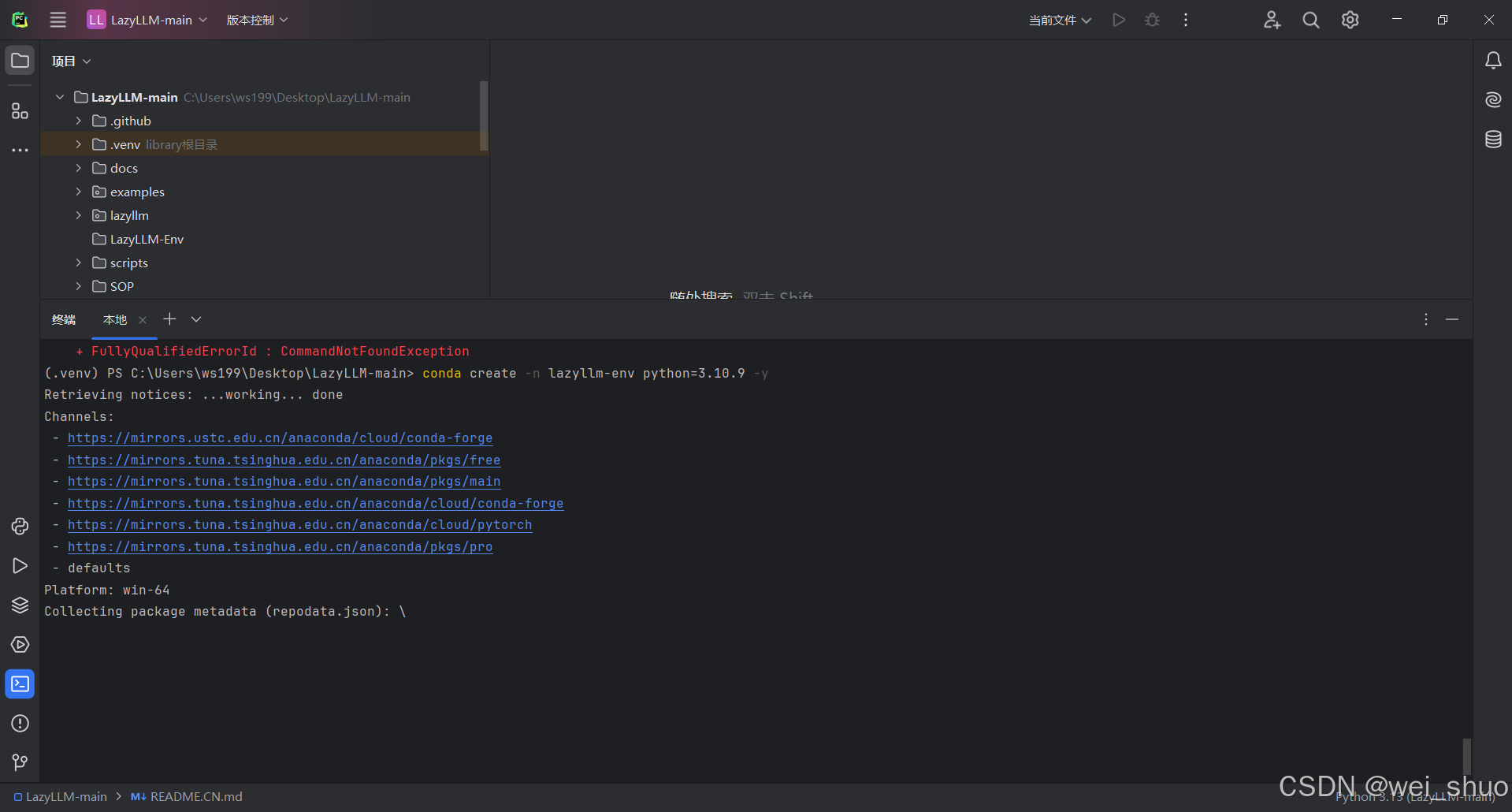

3、创建指定 Python 3.10.9 的环境

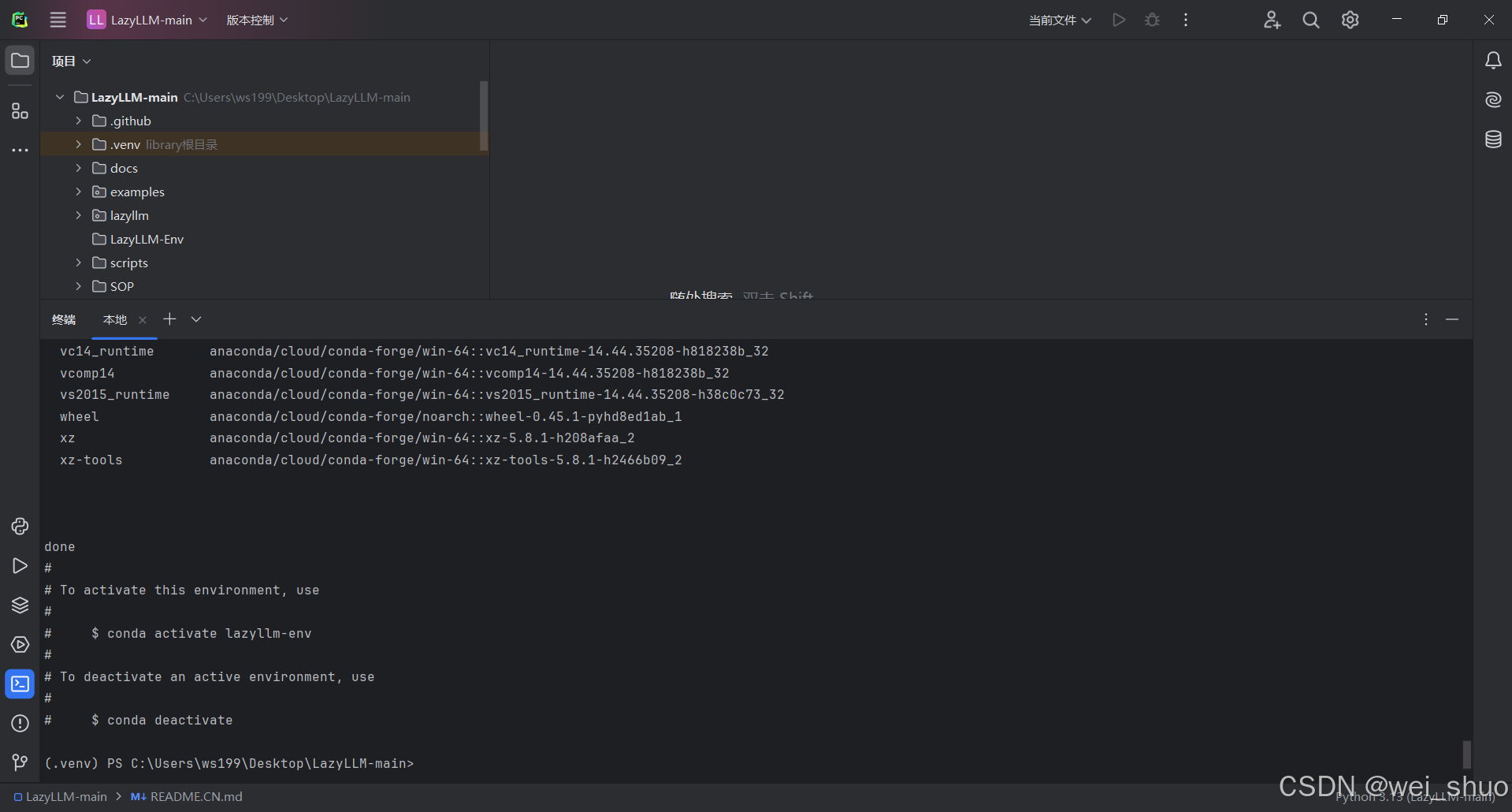

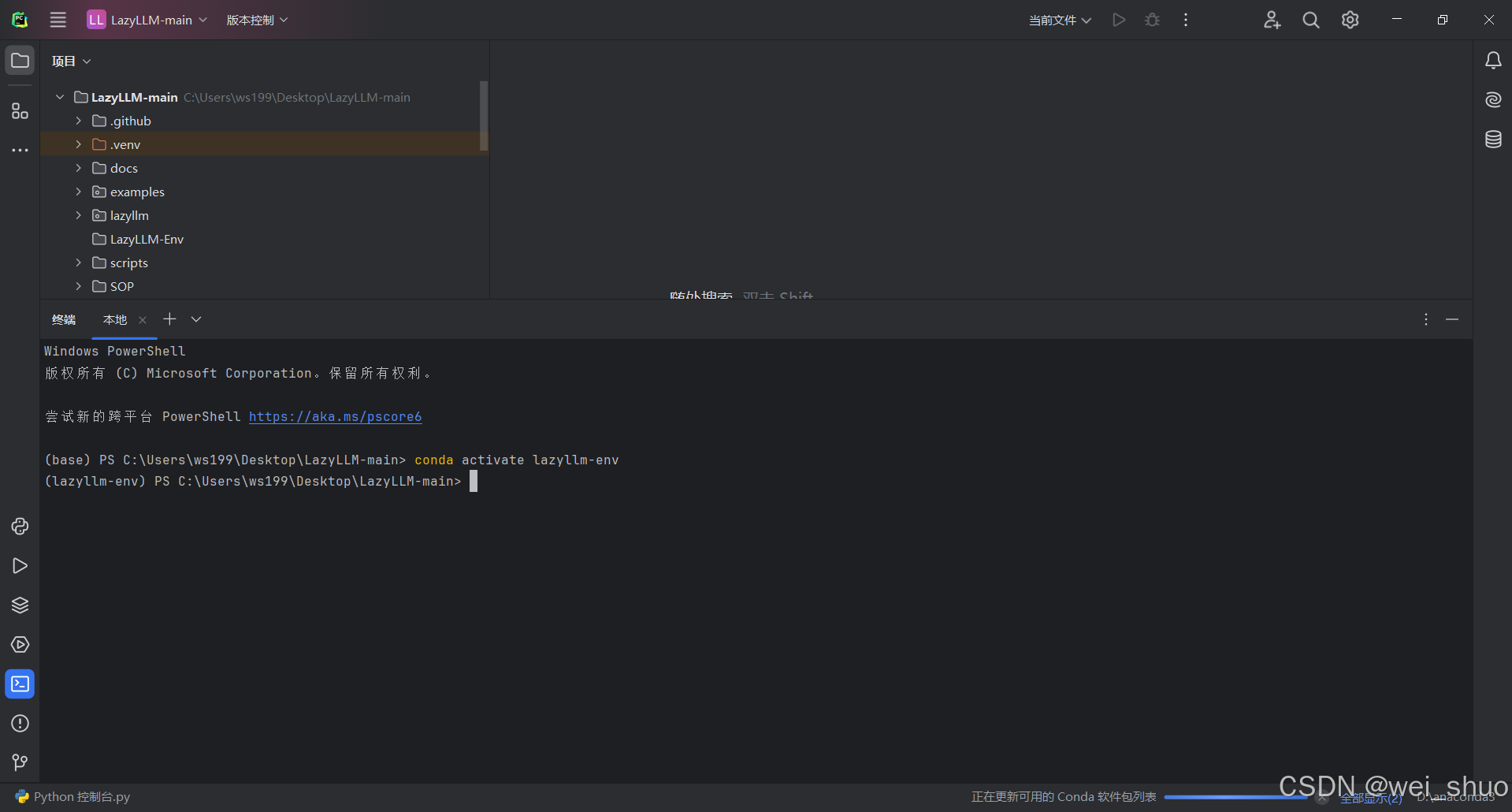

bashconda create -n lazyllm-env python=3.10.9 -y4、PyCharm 激活 lazyllm-env 环境

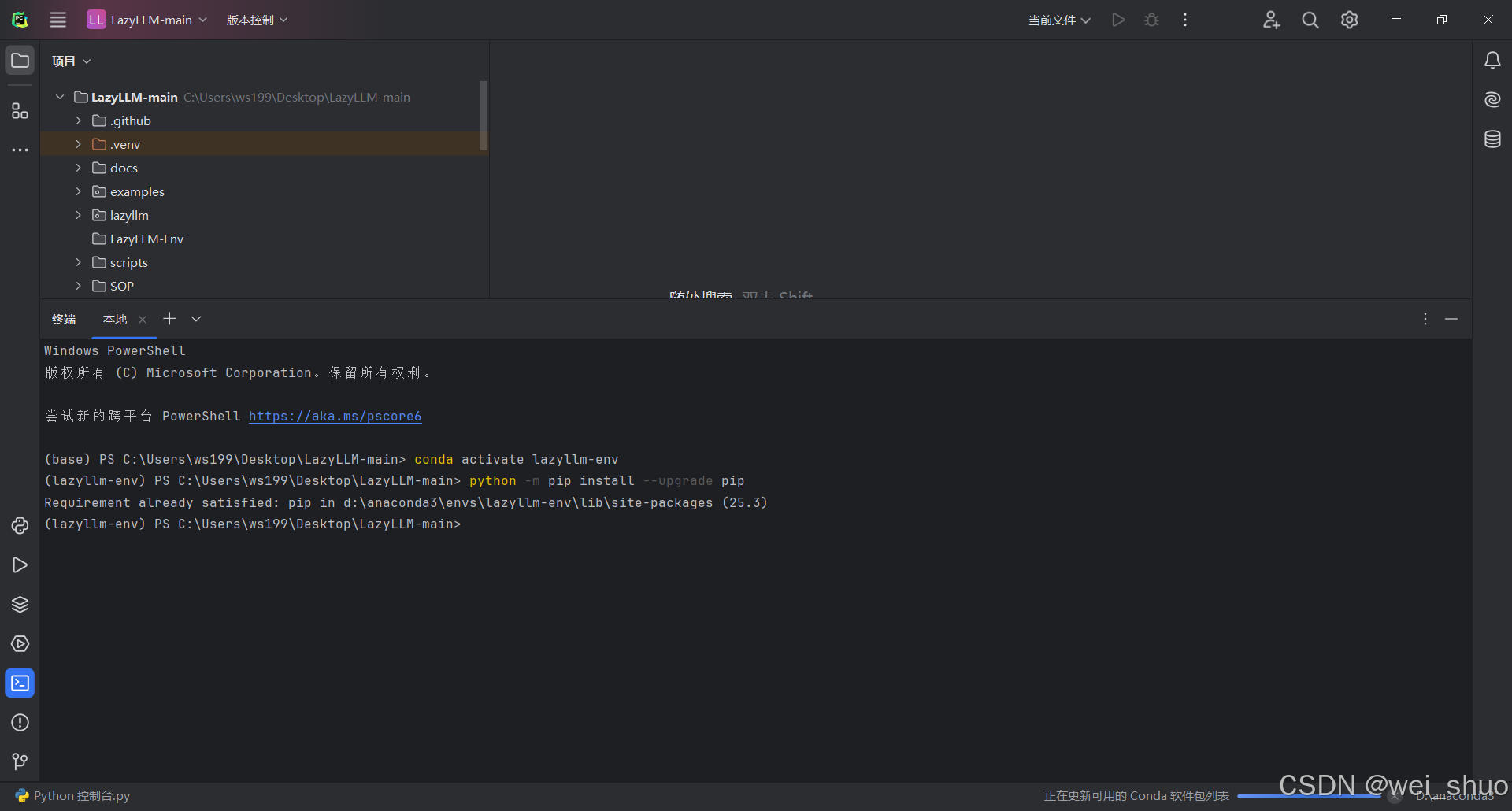

bashconda activate lazyllm-env5、升级 pip(避免旧版本安装失败)

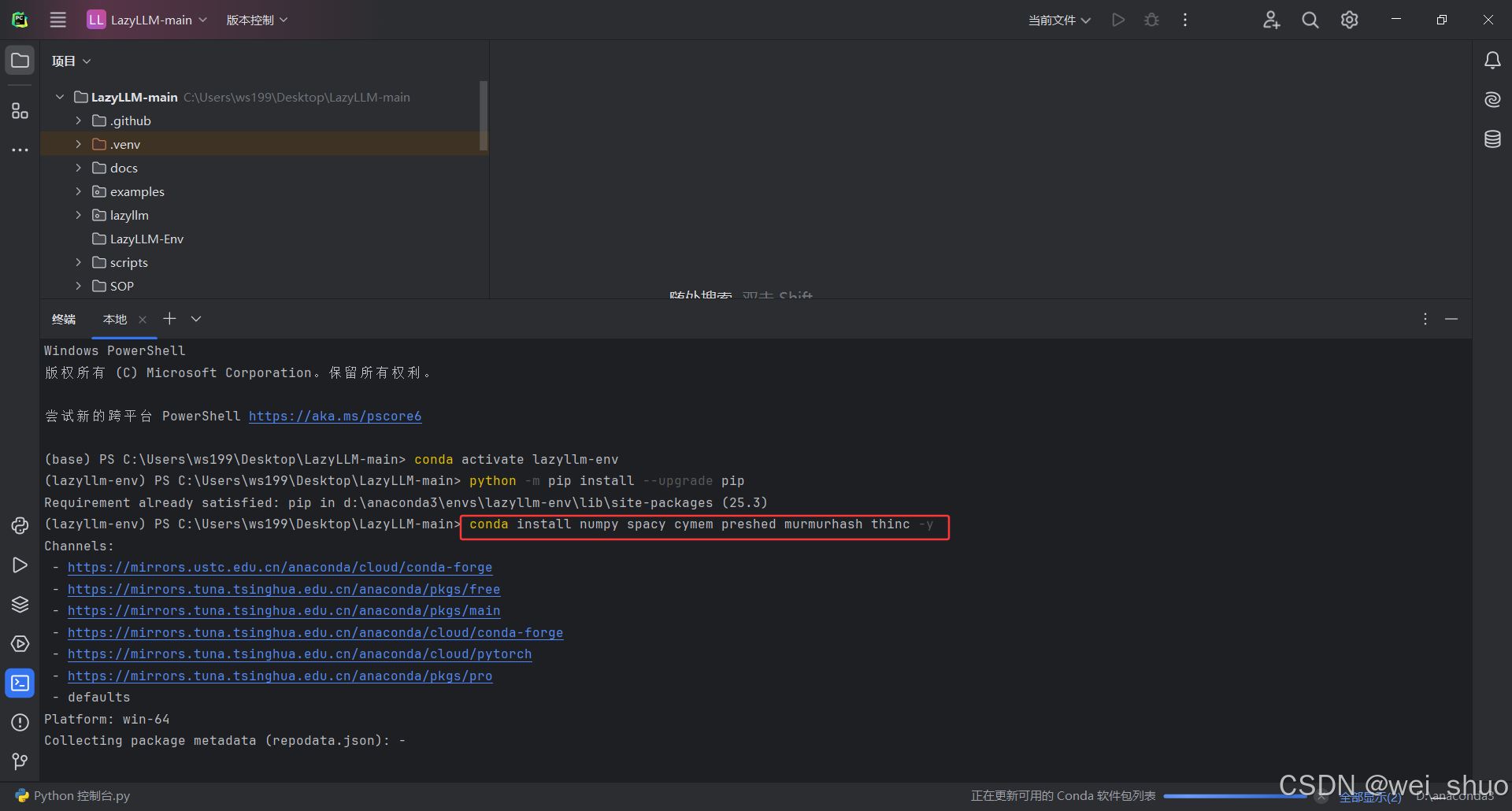

bashpython -m pip install --upgrade pip6、装核心依赖 conda 预编译包,不会有编译报错

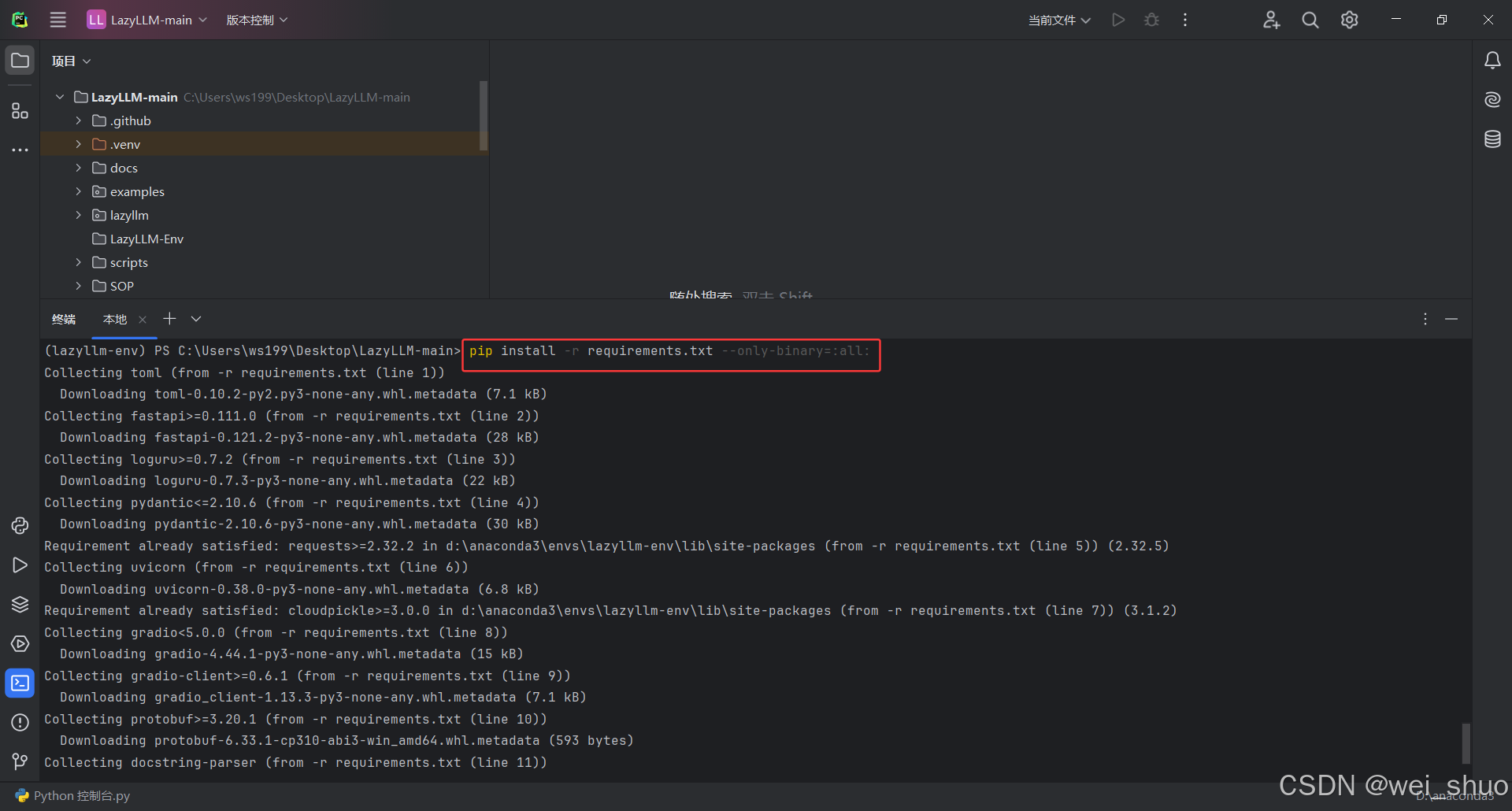

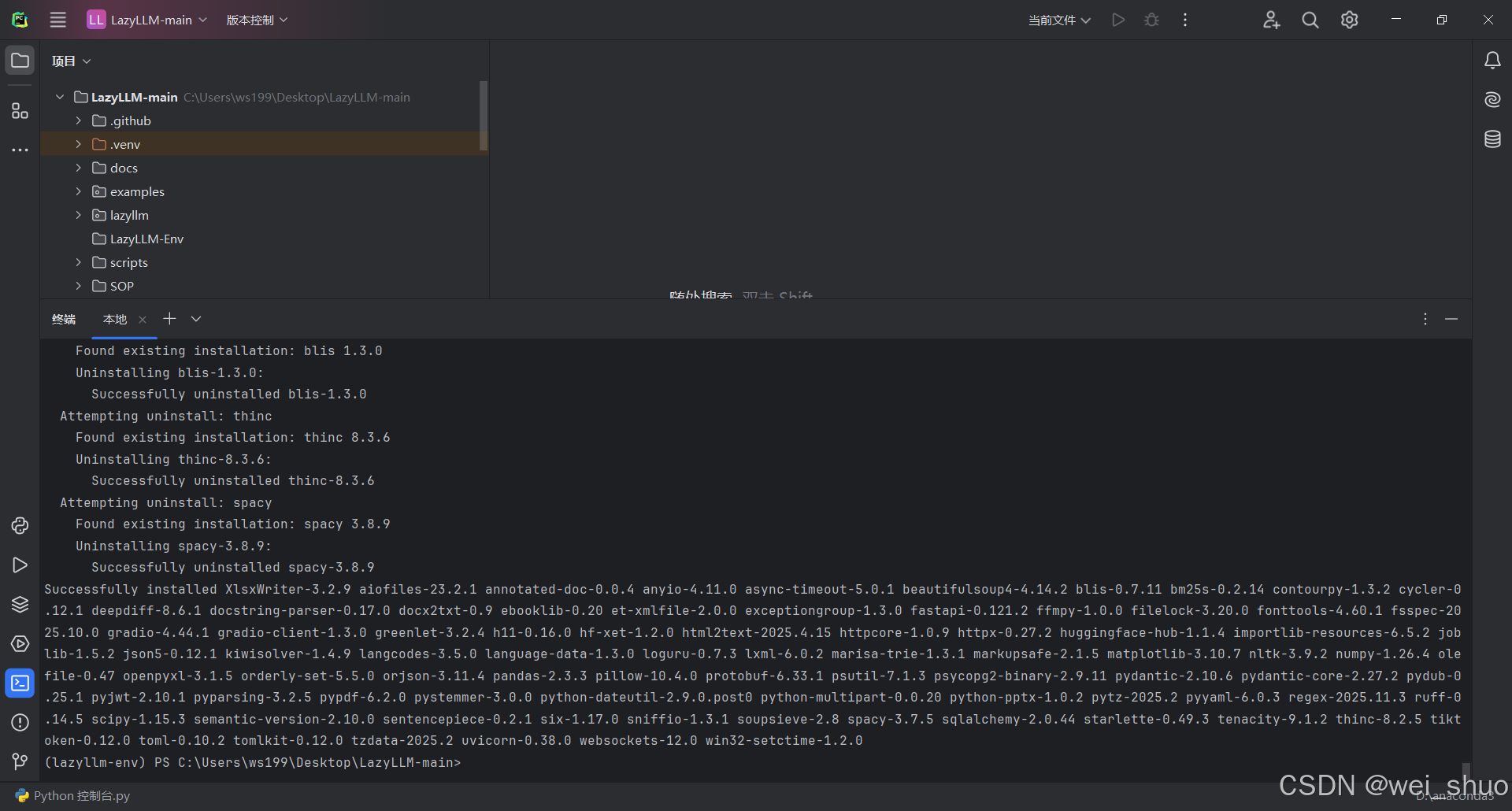

bashconda install numpy spacy cymem preshed murmurhash thinc -y7、装项目所有依赖强制用预编译包,速度快

bashpip install -r requirements.txt --only-binary=:all:8、如果默认 pip 镜像源没找到jieba>=0.42.1的兼容版本,可以手动安装 jieba

bashpip install jieba>=0.42.1 -i https://pypi.tuna.tsinghua.edu.cn/simple9、继续完成剩余依赖安装(重新执行之前的命令,补全所有依赖)

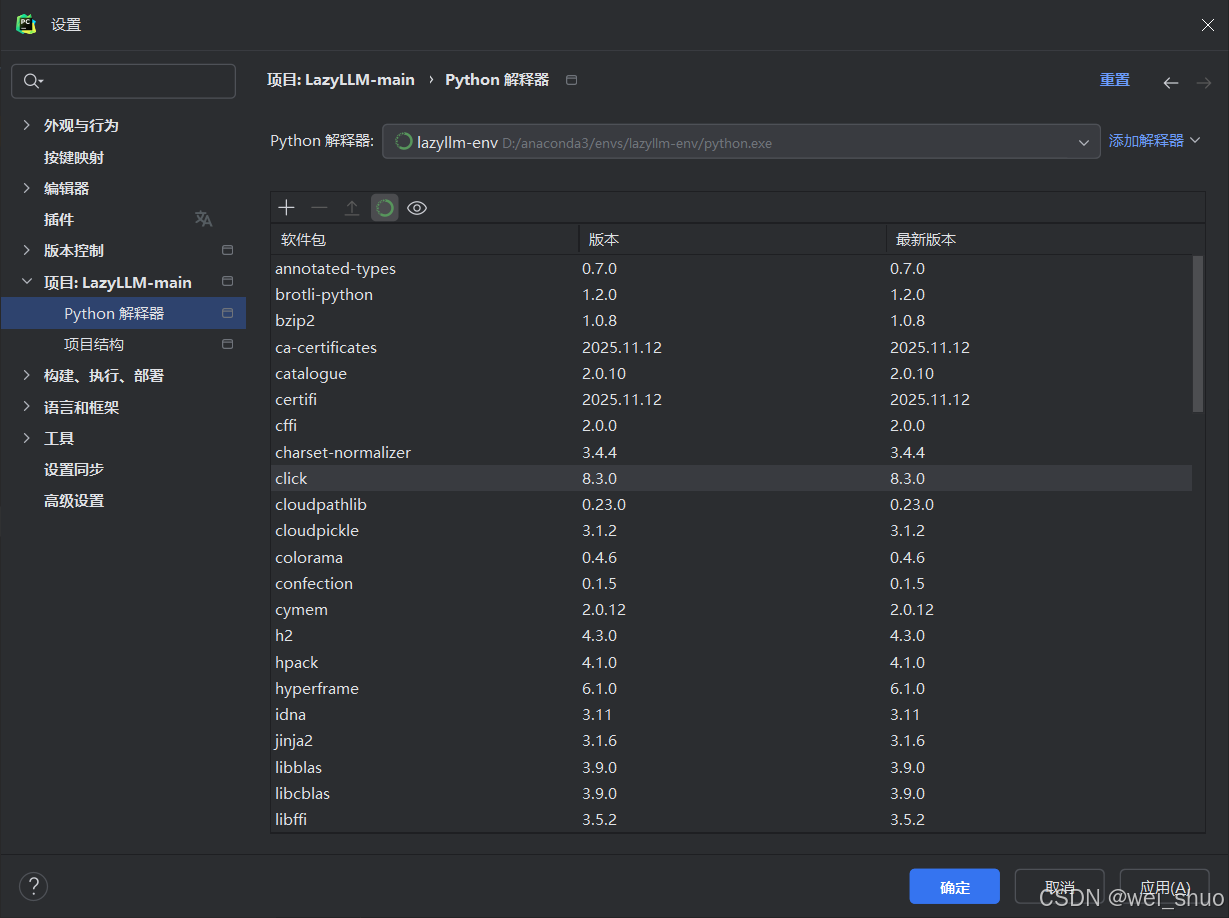

bashpip install -r requirements.txt --only-binary=:all: -i https://pypi.tuna.tsinghua.edu.cn/simple10、Pycharm 切换 lazyllm-env 解释器

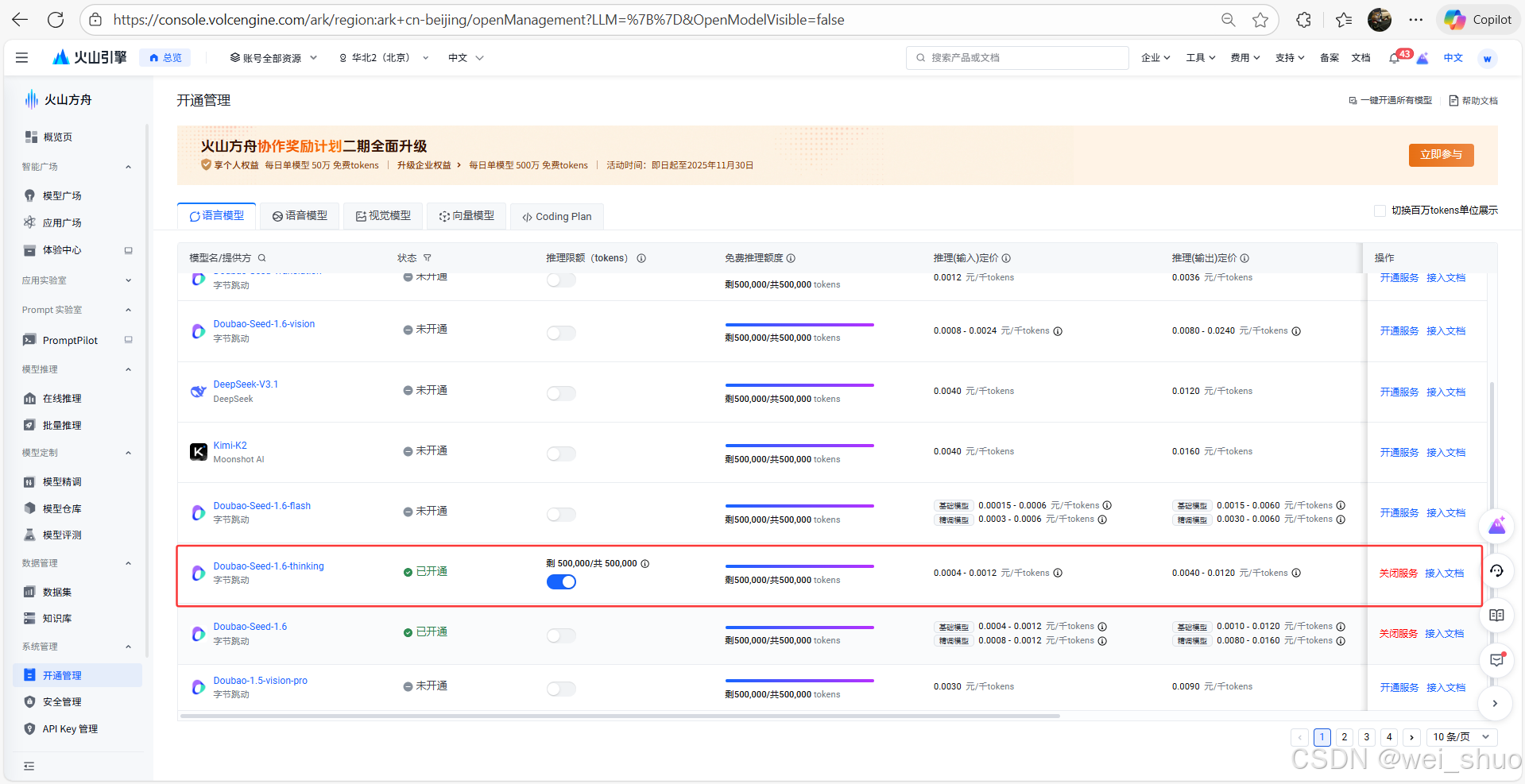

11、豆包文本模型开通

12、豆包 API KEY 获取访问密钥配置

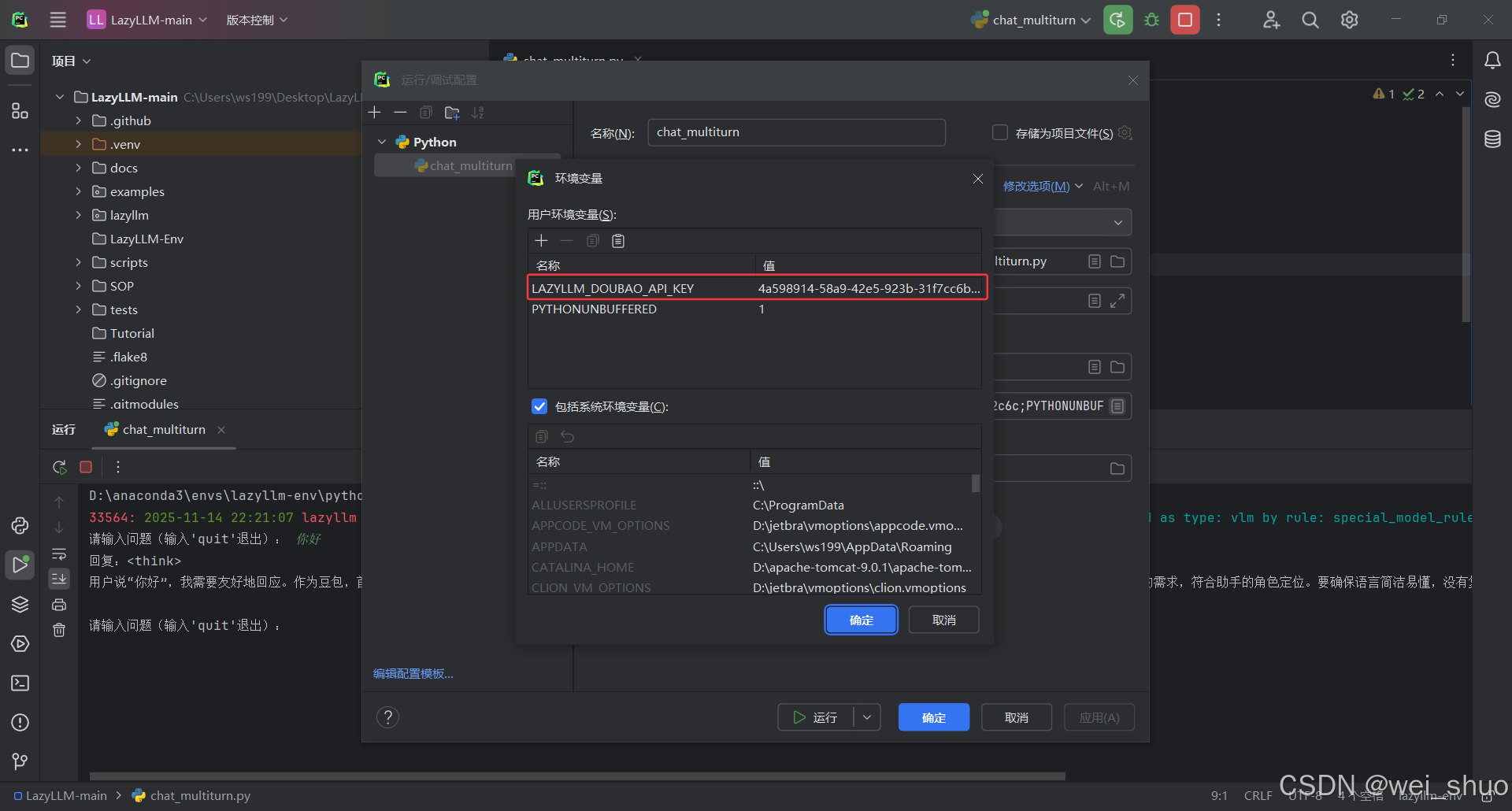

13、 PyCharm 环境变量配置(目前也提供了硅基流动的api支持,大家可以去体验)

名称:LAZYLLM_DOUBAO_API_KEY(对应下方LazyLLM支持的环境变量)

值:填写自己的API KEY

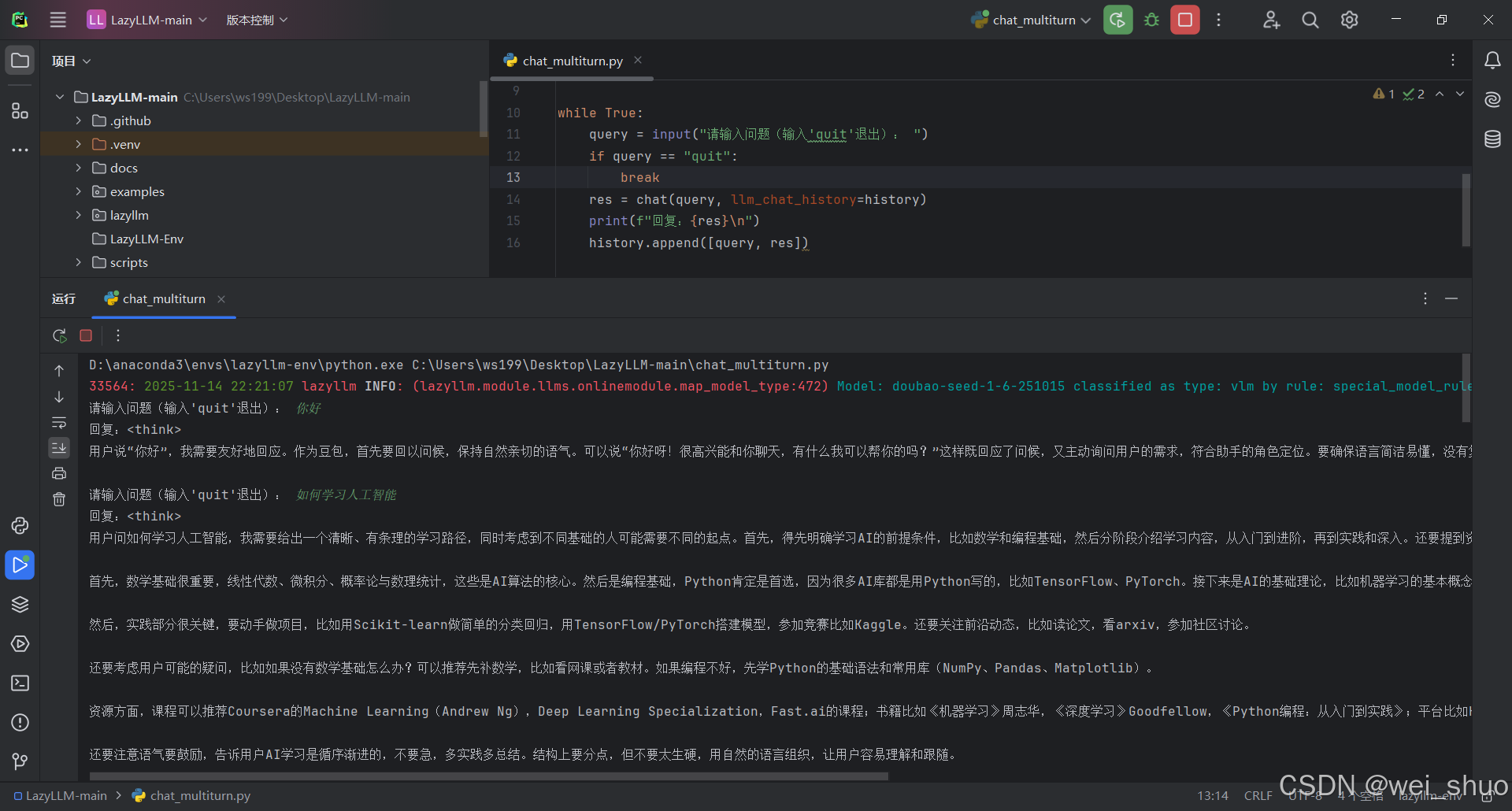

14、多轮对话代码编写,通过导入 LazyLLM 库初始化豆包纯文本对话模块

pythonimport lazyllm chat = lazyllm.OnlineChatModule( # 已开通的模型真实ID model="doubao-seed-1-6-251015", model_type="llm" ) # 存储多轮对话历史,维持上下文关联 history = [] # 多轮对话循环 while True: query = input("请输入问题(输入'quit'退出): ") if query == "quit": break res = chat(query, llm_chat_history=history) print(f"回复:{res}\n") history.append([query, res])

- 成功通过 LazyLLM 调用豆包语言模型

使用 LazyLLM WebModule:快速启动豆包可视化 Web 对话界面

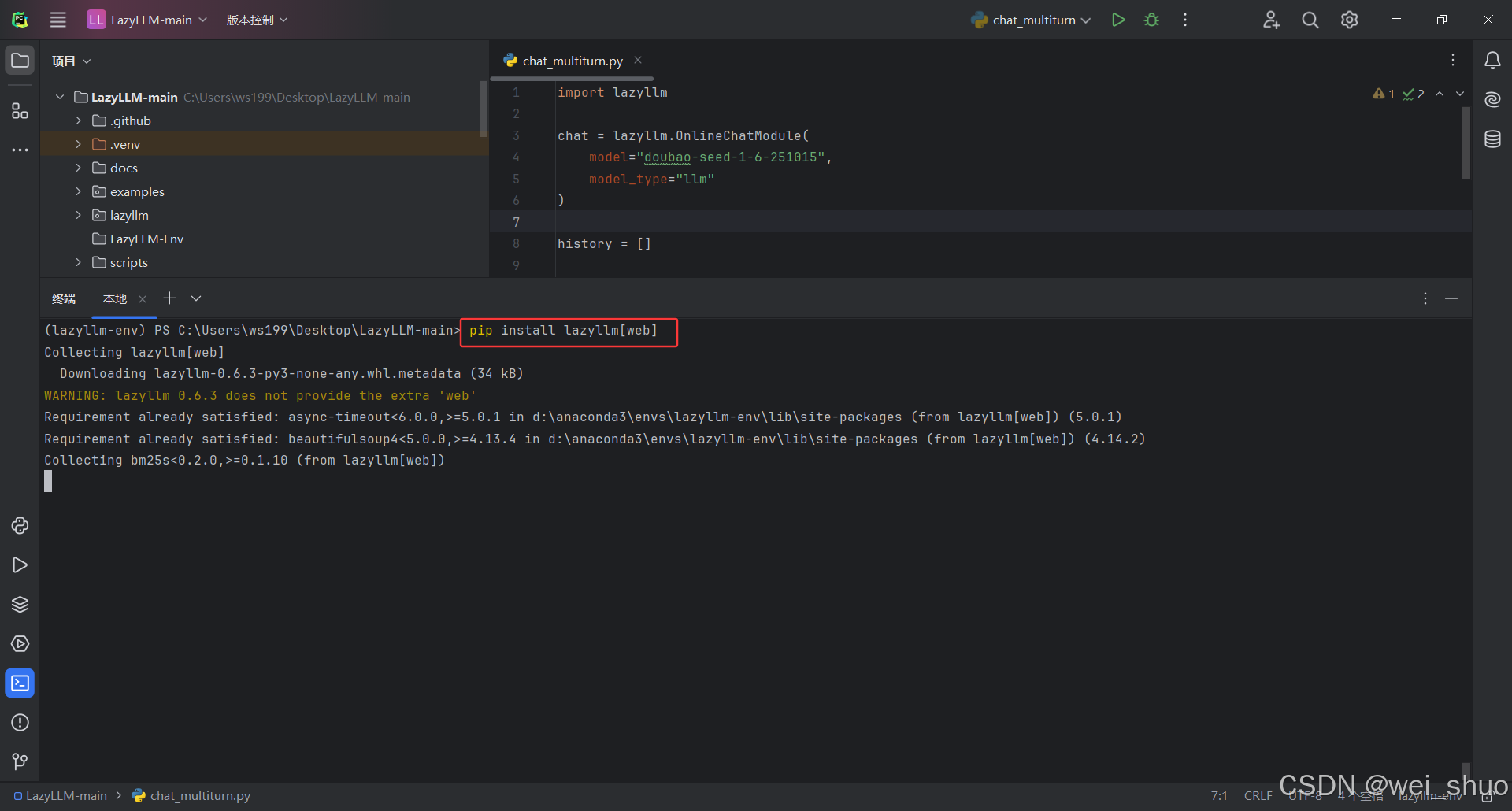

1、安装 LazyLLM Web 模块依赖(WebModule 需要 fastapi、uvicorn 等 web 服务依赖,基础安装未包含)

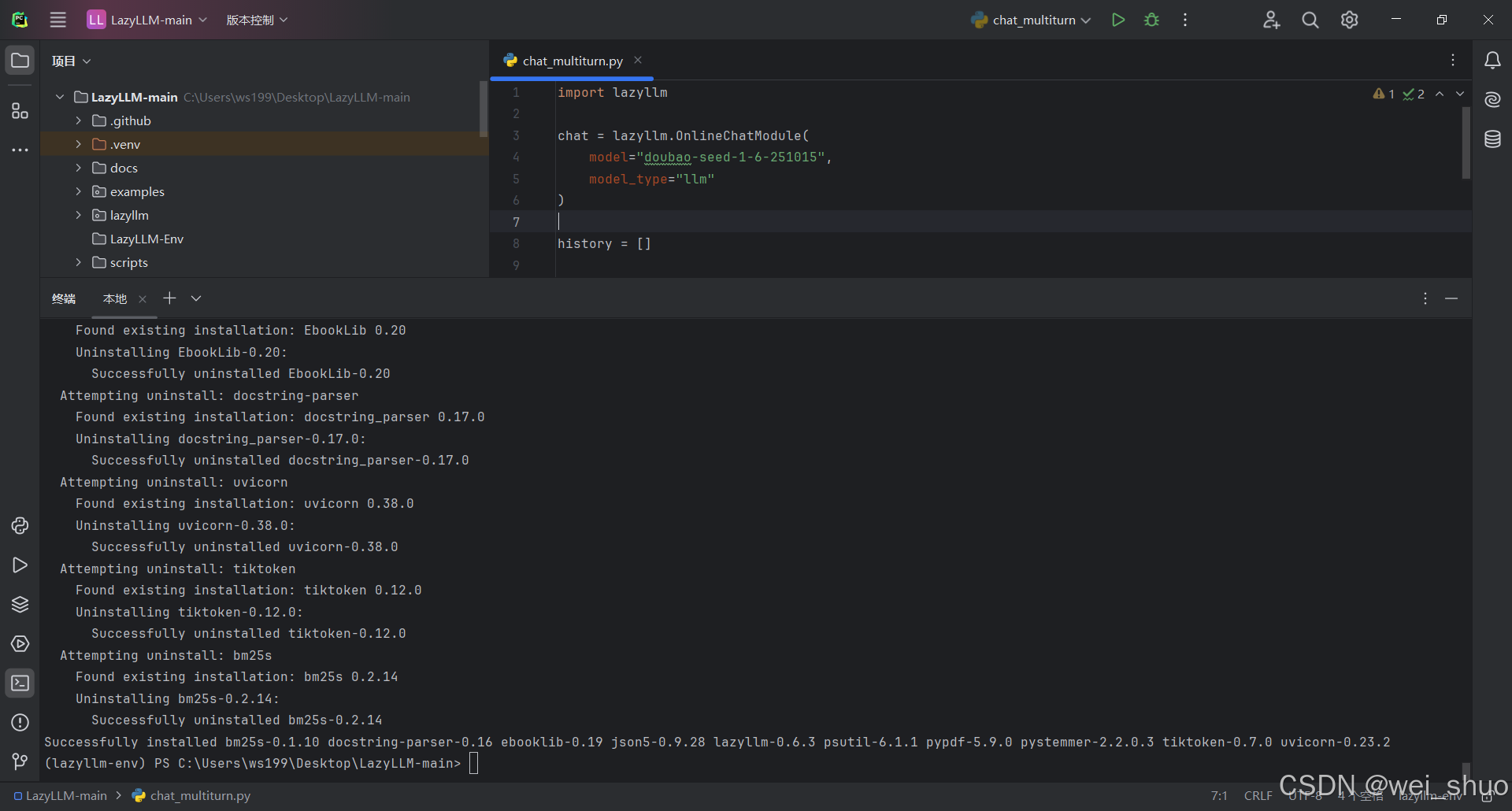

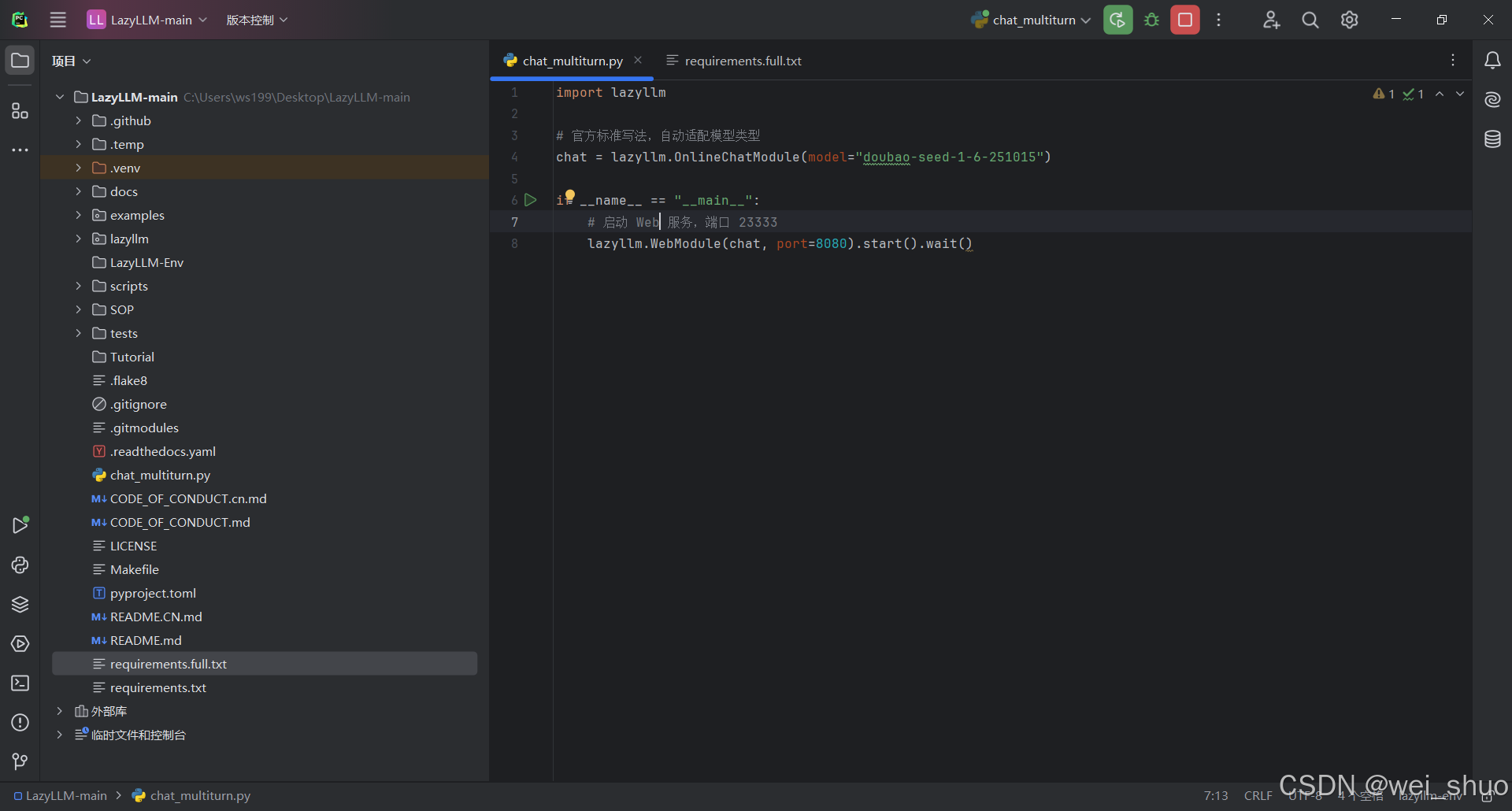

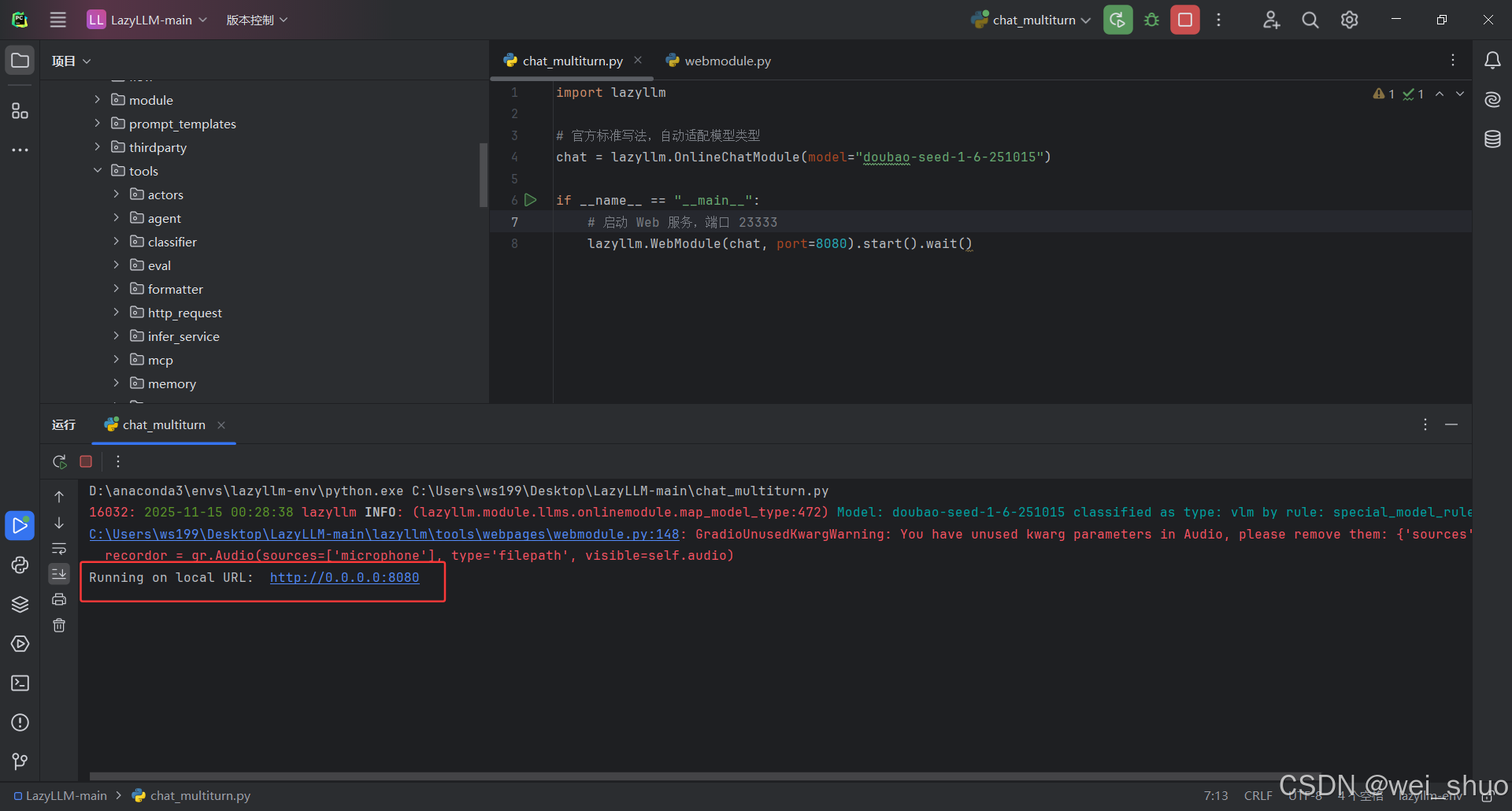

bashpip install lazyllm[web] # 安装web模块所需全部依赖2、编写 Web 界面启动代码(基于之前的模型 ID 和环境变量,补全 WebModule 代码,确保密钥、模型配置正确)

bashimport lazyllm # 官方标准写法,自动适配模型类型 chat = lazyllm.OnlineChatModule(model="doubao-seed-1-6-251015") if __name__ == "__main__": # 启动 Web 服务,端口 23333 lazyllm.WebModule(chat, port=23333).start().wait()3、运行代码启动 Web 服务

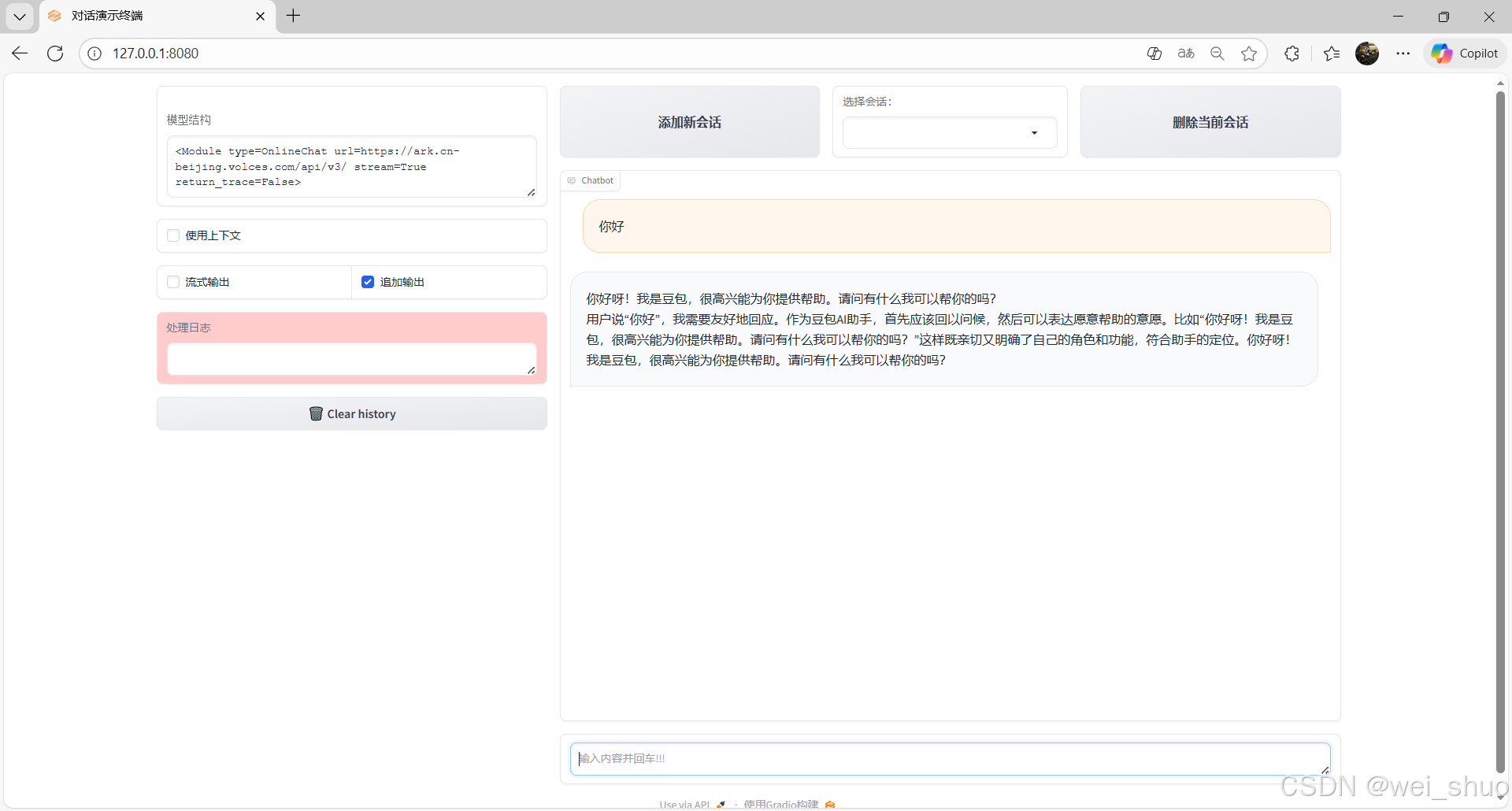

4、浏览器地址:http://127.0.0.1:8080/

- 这样就部署成功了

部署质量验证:LazyLLM 调用豆包模型的多维度测试结果

精准性验证:部署回答的准确度评估

问题:LazyLLM 部署豆包的核心依赖包及最低 Python 版本是什么?

作为常踩部署坑的开发者,这回答算是戳中了本地配豆包的实际痛点,model 路径得指全权重 / 配置文件、backend 选 transformers 还是 vllm 这些,都是调配置时真得盯死的点;像量化配置能救内存、device_map 防溢出这些,还补了实际作用,不是干巴巴列参数

简洁度验证:三句话总结部署关键路径

问题:用 3 句话概括 LazyLLM 本地部署豆包的核心操作。

LazyLLM 本地装豆包的核心链路捏得很准,先把依赖和 Python 环境配好,再搞定模型资源要么拉取要么指定本地路径,最后启动成服务接 API 或 Web 界面,三句话刚好踩中部署的 "准备 - 资源 - 落地" 关键节点,没一句废话,拿来就能对照着走

配置专业度验证:关键参数识别能力评估

问题:LazyLLM 配置文件中,本地部署豆包需配置哪些核心参数(至少 3 个)?

既精准匹配了本地部署豆包需配置的核心参数至少3个的需求,又覆盖了模型路径、运行设备、上下文长度、量化配置等部署关键参数,且每个参数都补充了实际配置要点,比如模型路径需包含完整文件、上下文长度需匹配硬件,信息准确无冗余,同时贴合本地部署的实操场景

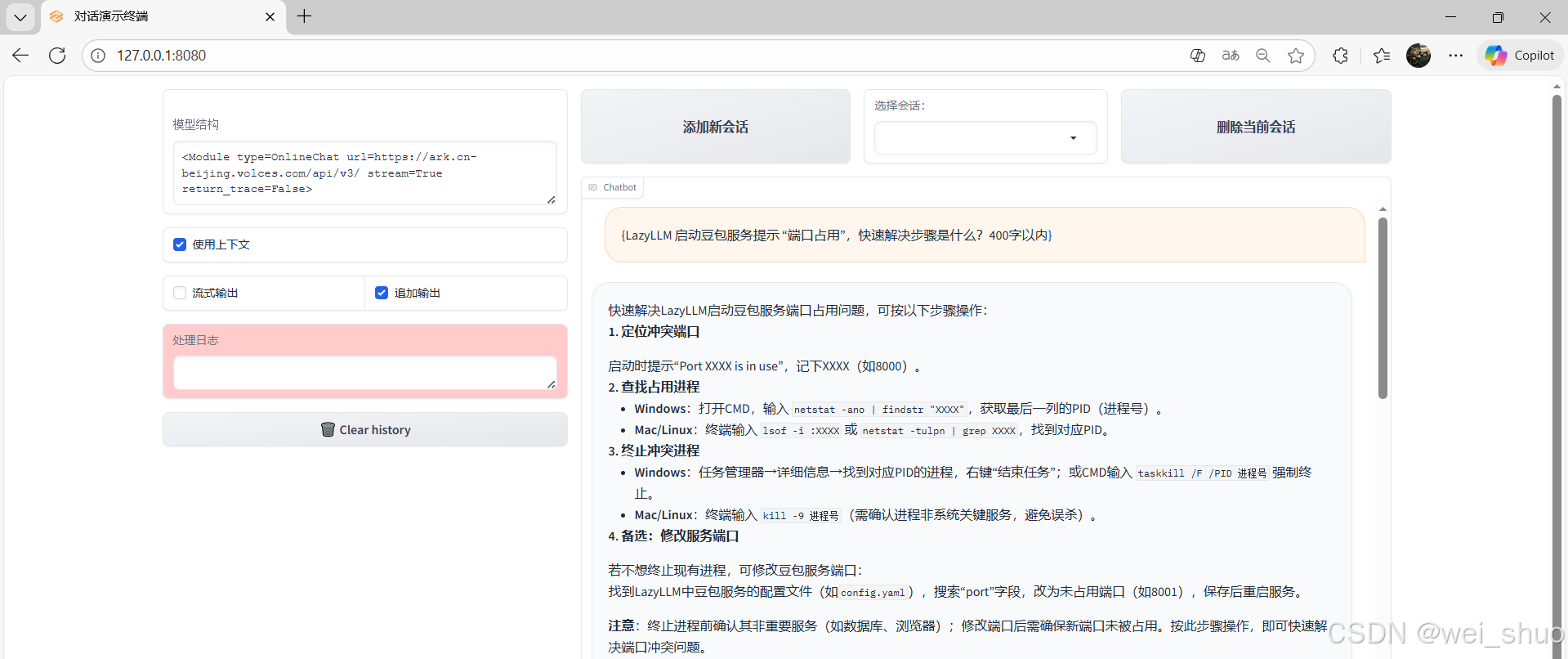

实操性验证:常见部署问题的快速排查能力

问题:LazyLLM 启动豆包服务提示 "端口占用",快速解决步骤是什么?

以定位端口 - 查找进程 - 终止进程 - 备选修改端口的清晰流程展开,同时区分了 Windows、Mac/Linux 不同系统的操作指令,覆盖了开发者常用的系统环境,指令具体可直接执行,贴合实际排查端口占用的实操场景

完整性验证:从准备到验证的全流程覆盖度

问题:本地部署豆包时,从环境准备到服务验证的关键操作有哪些(不展开细节)?

部署的完整链路为逻辑,划分出环境检查、资源获取、模型准备、配置调整、启动服务、服务验证六个核心步骤,既覆盖了从前置条件到收尾验证的全流程,又贴合不展开细节的需求,仅提炼关键操作节点

全文总结:LazyLLM 在多 Agent 大模型应用场景的价值与实践意义

LazyLLM 以其低代码 + 多 Agent + 即插即用模块化的设计理念,大幅降低了大模型应用的开发、部署与调试门槛。本文围绕 LazyLLM 在豆包文本模型场景下的完整落地实践,从环境准备、依赖安装、源码配置、模型接入,到 WebModule 可视化界面启动,再到精准性、简洁度、专业性等维度的模型部署测试,完整展示了从零到可用的全链路操作流程。通过 LazyLLM,开发者不仅能以极低的成本快速构建多轮对话能力,还能直接以 Web 形式完成可视化交互与调试;其模块化 API、灵活的本地/在线模型调用模式,使得 Agent 构建、服务编排、模型调用的开发体验大幅提升。

整体来看,LazyLLM 为多 Agent 大模型应用提供了轻量、清晰、高效、可扩展的开发基础设施,无论是个人开发者快速搭建原型,还是企业验证落地大模型应用,都能显著缩短开发周期、减少踩坑成本,真正让大模型能力以更低门槛、更高效率的方式服务于实际业务应用。