「【新智元导读】当大模型竞争转向后训练,继续为闲置显卡烧钱无异于「慢性自杀」。如今,按 Token 计费的 Serverless 模式,彻底终结了算力租赁的暴利时代,让算法工程师真正拥有了定义物理世界的权利。」

大模型训练,正从「作坊炼丹」进化为「工业微调」!

当 OpenAI 前 CTO Mira Murati 创立的 Thinking Machines Lab 推出 Tinker 时,一切都变了。

通过将训练拆解为 forward、backward 等⼀系列基本原语,算法设计终于不再受限于基础设施。

现在,训练大模型就像「函数调用」一样简单。

「紧跟前沿,潞晨云微调」 「SDK」 「正式发布!」

这是国内首个兼容 Tinker 范式、且全面开放的 Serverless 微调平台。

针对复杂且昂贵的强化学习,给出了更具成本优势的工业级解法:

- 「零门槛」:开发者无需囤积显卡。

- 「全透明」:Rollout → Reward → Update,全流程按 Token 计价。

- 「极高效」:拒绝算力浪费,让每一分钱都花在产生梯度的「刀刃」上。

「拥抱后训练与 RL」

「算法层与底层算力架构的解耦」

随着 OpenAI o1 在推理能力上的突破,业界逐渐形成共识:

大模型的能力突破已不再单纯依赖预训练(Pre-training)阶段的参数堆砌,后训练(Post-Training)特别是强化学习正成为决定模型实用价值的核心战场。

以 DeepSeek‑R1 为例,仅靠强化学习训练,模型在 AIME 数学推理基准上的 pass@1 从 15.6% 提升至 77.9%,充分展示了 RL 在低数据量条件下即可实现大幅能力跃升,迅速成为后训练赛道的新范式。

然而,摆在算法工程师面前的问题依旧严峻。

强化学习涉及到更为复杂的系统设计,训练过程中存在一系列的问题,如多个模型的优化,数据的传递,以及模型权重的传递;一系列工程化的工作,给算法的设计带来了更多的困难,同时也对基础设施提出了更高的要求。

Tinker 的出现,就是为了解决这个问题:「把繁杂训练变成标准易用的」 「API」****。

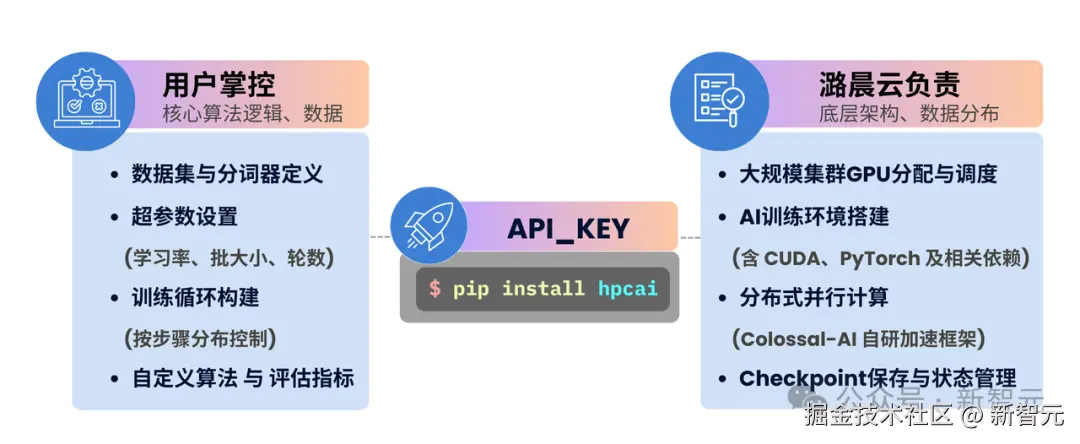

潞晨云把这一范式写进底层假设,「算法****设计与基础设施解耦」------

开发者只负责定义数据与 Loss 函数,底层的异构集群调度、并行策略优化、容错运维等应被封装为基础设施服务,对开发者实现全托管与无感支持。

「致敬创新,更致力于 「「落地」 」。」

潞晨云微调 SDK,直接兼容 Tinker 接口。

它在「零代码」与「裸机手写」之间,找到了最佳平衡点。从此,从算法灵感到模型落地,再无工程壁垒。

如今,开发者可以把研究精力和算力成本从集群运维还原至算法本身,感受「本地写码,云端计算」的**「训练即服务(Training as a Service)」「流畅体验」。**

「颠覆性人效比」

「1 名算法工程师顶替庞大 Infra 团队」

「潞晨云微调」 「SDK」 「的核心思路可以概括为: 「「算法」 」工程师定义算法逻辑,潞晨云搞定 Infra。」

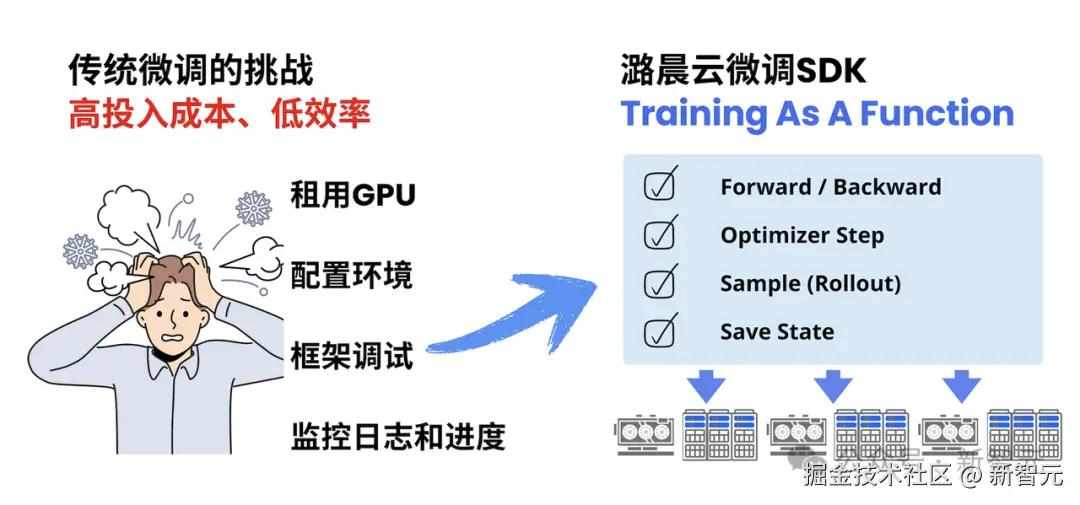

在传统的开发中,用户往往要花大量精力去租赁合适的算力集群、管理环境配置、调训练框架和集群运维。

但潞晨云将大模型训练拆解成了一组标准的函数原语,打通了**「从 SFT 到 RL 的全链路」**:

- **Forward & Backward:**处理前向传播与梯度计算

- **Optimizer Step:**执行权重更新策略

- **Sample (Rollout):**做推理生成和评估,使用户不仅可以完成 SFT,更能轻松构建 PPO、GRPO、DPO 等复杂的强化学习(RLHF/RLAIF)训练流

- **Save State:**管理模型检查点与状态保存

这意味着,用户可以在本地熟悉的 Jupyter Notebook 或 IDE 里,用最标准的 Python 语法像搭积木一样自由组合,掌控训练逻辑的细节。

这种模式带来了颠覆性的「人力效能比」提升------

它将原本需要运维工程师、Infra 工程师、平台工程师和算法工程师紧密配合的庞大团队,简化为了「一个算法工程师」的独立闭环。

用户不再被底层繁杂的基建拖累,不再背负多职能的枷锁,也不再是黑盒填参的被动执行者,而是能够独立驾驭大规模训练流的主动设计师。

无论是监督微调(SFT)还是更复杂的强化学习(RL)Pipeline,都能通过组合这些原子函数来灵活构建。

「为什么这种体验如此丝滑?」

为了实现极致的流畅度,潞晨云基于现有的 GPU 云服务架构实现了一套完整的后端系统。

在具体实现中,潞晨云采⽤控制⾯与计算⾯分离设计,通过统⼀ API Server 管理跨地域的多个 GPU 计算集群,实现多云部署能⼒。

核⼼采⽤基于 Future 模式的异步 API,所有训练操作⽀持⾮阻塞调⽤,⽤⼾⽆需等待 GPU 计算完成即可继续执⾏后续逻辑。

潞晨云微调 SDK 还具备智能队列系统。

即使在资源洪峰期,任务也会自动进入持久化队列(Persistence Queue),一旦底层资源可用,毫秒级启动:

- 队列等待期间 0 计费

- 仅对实际 prefill + sample + train 的 Token 量收费

彻底告别资源闲置浪费,让用户的每一分钱都用在产生梯度的刀刃上。

「模型微调算力零售革命」

「从包机租赁到按 Token 计费」

如果说「易用性」是后训练平台的入场券,那么「成本结构」则是决定谁能走得更远的护城河。

在传统云主机的「包机 / 时租」模式中,用户一直在为「过程」买单------无论是在加载数据、调试代码,还是仅仅在思考 Loss 函数,只要占用了显卡,计费表就在跳动。

这种模式下,「开发过程中有一半以上的预算都浪费在了这些没有实际产出的「垃圾时间」里」。

潞晨云为微调大模型场景引入了 Serverless 架构,推行「按 Token 计费」的商业模式,将微调场景的算力服务切分到了最细的颗粒度:

- 为价值付费

就像使用推理 API 一样,用户只需为 Prefill(输入)、Sample(推理输出)和 Train(训练)产生的**「有效计算 Tokens 量」**付费。

- 其他环节全免费

本地代码调试、环境配置、数据预处理、模型 Checkpoint 保存...... 这些在传统租卡模式下分秒必争的环节,在潞晨云**「全部免费」**。

- 极致性价比

通常,RL 需要同时维护高吞吐的推理集群(vLLM)和训练集群,算力成本极高。

但在潞晨云上,实测基于官方 Cookbook 的 math_rl recipe 跑通包含 Rollout 采样、Reward 评分和 PPO 更新的**「完整 RL 流程」(~300 steps),总算力成本「仅 8.61 元」**。

这意味着,个体开发者也能低成本复现 RLHF/RLAIF 探索。

「技术落地的三个场景」

「SFT 与 RL 同时开箱即用」

这种新模式,也将彻底改变不同领域开发者的工作流:

- 科研场景:告别资源焦虑

学术界,时间与算力往往是最紧缺的资源。研究人员不仅要面对繁琐的集群运维(Slurm/Docker 配置),还要应对昂贵的实验复现成本。

潞晨云微调 SDK 支持「白盒级」的科研探索,全面兼容 Tinker API。

研究人员可以自定义 Evaluation 逻辑、通过 Forward/Backward,Sample 等原语精确控制后训练和强化学习 Pipeline,而无需关心底层的分布式实现,让实验复现成本大幅降低。

- 「创业与独立开发:极速验证」 「MVP」

对于初创团队,「快」是生存根本。利用潞晨云微调 SDK 的 Serverless 特性,开发者无需等待资源排期。

配合极低的 Token 成本,实测从 pip install 到跑通一个包含 1000 条样本的 SFT 或 RL 微调实验,仅需数分钟。

这种极致的边际成本,让创业者敢于在有限预算下快速迭代 Reward 模型,实现真正的「低成本试错」。

- 「工业级 「「落地」 」:复杂架构突围」

在金融、医疗等垂直领域的工业应用中,已有微调 API 往往难以应对复杂的异构架构与 RLHF/RLAIF 需求。

潞晨云微调 SDK 允许工程师通过 train_step 自由定义 Loss 逻辑与强化学习奖励函数。

开发者拥有对模型权重与训练细节的完整控制权**,**实现端到端定制。

「极简实战」

「三步上手」

没有复杂的集群配置,没有冗长的 Docker 构建。

使用潞晨云微调 SDK,训练一个大模型就像写普通 Python 脚本一样简单:

-

Install & Import:

pip install hpcai

-

Initialize Client:

目前已支持 Qwen3 系列(4B - 32B),更多模型即将上线。

- Define Training Loop & Run:

像在本地写 PyTorch 一样,拥有对训练循环的完整控制权。

⽬前,微调 SDK 已覆盖 Qwen3 系列模型(4B、8B、14B、32B),支持监督学习和强化学习训练方式,并将持续扩展更多模型能力与细分落地场景,大家也可以向官方提交需求 push 更新。

「平台还准备了开箱即用的 HPC-AI Cookbook」 ,提供包括 「DeepSeek-R1 GRPO」 「算法」 、「基于 Verifier 的数学推理」、**「自定义 Reward 函数」**等复杂 RL 场景的完整代码实现。

开发者无需从零构建复杂的 PPO/GRPO 流水线,只需复制 Cookbook 中的「配方」,「运行轻量级本地」 「train.py」 **脚本,即可驱动云端复杂的分布式 RL 训练流,**在潞晨云上复现具备复杂逻辑推理能力的 SOTA 模型。

「现在体验」

后训练正从学术支线升级为工程主线,AI 基础设施的终极形态应该是「零认知负荷」------

开发者只需描述数据与算法,其余(租卡、配环境、并行策略、运维调度、故障自愈,乃至 RL 涉及的一系列工程化的工作)全部下沉到用户无感。

当 GPU 闲置成本趋近于 0,环境配置时间趋近于 0,长序列 RLHF 也能按 Token 即时计费,应用创新效率直接逼近算力上限。

潞晨云微调 SDK 今日起全量开放:

- 无需白名单,无需预约

- 前 150 名专属链接注册即得 30 元使用额度(可点击【阅读原文】跳转):cloud.luchentech.com/account/sig...

把资源弹性交给平台,把算法自由度留给自己,每一分钱都用在产生梯度的刀刃上!

立即体验:

cloud.luchentech.com/fine-tuning

使用文档:

cloud.luchentech.com/doc/docs/fi...

Tinker SDK:

DeepSeek-R1: