Dify 介绍

Dify 是一款开源的大语言模型(LLM)应用开发平台,融合了后端即服务(Backend-as-a-Service,BaaS)与 LLMOps 的理念,旨在帮助开发者快速搭建生产级的生成式 AI 应用。

核心定位

Dify 的核心定位体现在以下三大能力:

- 可视化编排引擎:通过拖拽式工作流设计界面,用户可组合 LLM 调用、工具集成、条件分支等节点,构建复杂任务链,无需编写胶水代码。

- 企业级 AI 基础设施:提供模型网关(支持接入 200+ 模型,如 OpenAI、Claude 等)、数据管道(自动化处理文档并构建向量知识库)、安全合规(满足 GDPR/HIPAA 等要求)。

- 持续优化体系:监控模型性能、标注优质回答反馈至 Prompt,形成开发-部署-迭代闭环。

主要功能

- 低代码/无代码开发:提供可视化界面,轻松定义 Prompt、上下文与插件,降低技术门槛。

- 模块化架构:功能模块与接口清晰,可按需组合使用。

- 丰富的功能组件:涵盖 AI 工作流、RAG 管道、Agent、模型管理、可观测性等功能。

- 支持多种大模型:已集成多种模型,包括 OpenAI GPT 系列等,并持续扩展。

- 数据处理与外部知识集成:提供数据清洗、特征工程等功能,支持接入外部 API 与企业知识库

LLM 监测 - Langfuse 介绍

Langfuse 是一个用于 AI 应用的可观测性与数据管理平台,可以帮助开发者记录、分析和优化大模型调用过程。它能自动采集 Prompt、模型输出结果、token 消耗、错误信息、延迟等数据,并通过 Trace 和 Span 展示完整调用链,可用于调试、追踪、评估模型质量以及做 A/B 测试。通过 Langfuse,团队可以像监控后端服务一样监控 AI 应用,从而持续优化 Prompt、降低成本,并提高模型输出质量。

在实际使用 LLM 监测服务中,您可以:

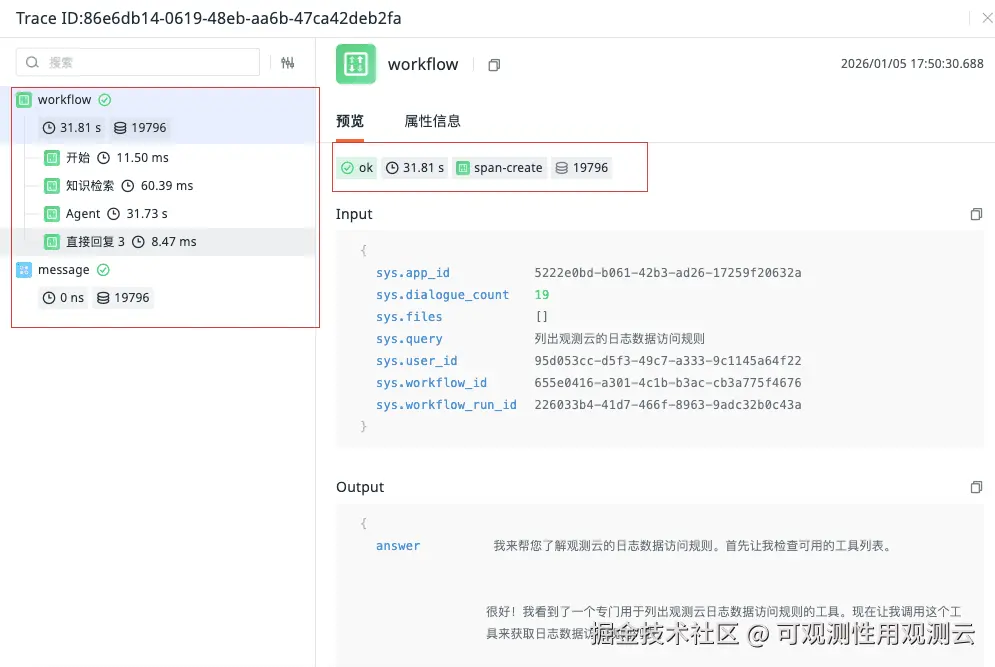

- 查看单次请求的完整链路:清晰查看用户提问从接收、处理(如数据库查询)、到调用 LLM 模型并返回答案的整个过程

- 分析性能瓶颈:精确测量每个环节(如模型调用、数据检索)的耗时,及时发现延迟

- 关联上下游服务:关联 LLM 请求与相关的应用程序、基础设施指标,进行全面根因分析

观测云

观测云是一款专为 IT 工程师打造的全链路可观测产品,它集成了基础设施监控、应用程序性能监控和日志管理,为整个技术栈提供实时可观察性。这款产品能够帮助工程师全面了解端到端的用户体验追踪,了解应用内函数的每一次调用,以及全面监控云时代的基础设施。此外,观测云还具备快速发现系统安全风险的能力,为数字化时代提供安全保障。

LLM 监测

创建 LLM 应用

登录观测云控制台,点击「LLM 监测」 「新建应用」 输入应用名称,应用 ID,点击「创建」。

私有化部署客户,Host 信息默认为空,需配置 forethought-webclient 命名空间下的 llmDatawayUrl 配置项 ,值为 dataway 地址,也可以申请单独的域名指向 dataway 地址。

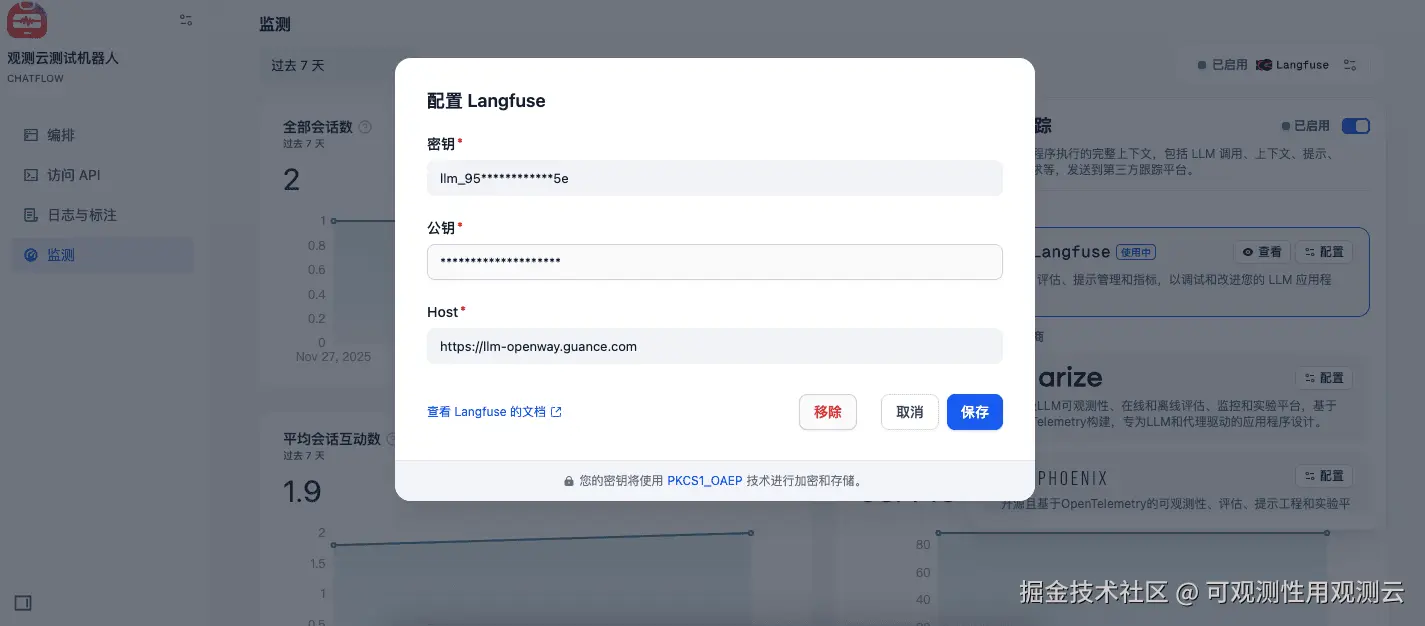

Dify 开启 Langfuse 配置

进入 Dify 后,选择「应用」-「监测」-「追踪应用性能」-「Langfuse」。

配置好后点击「保存并启用」。

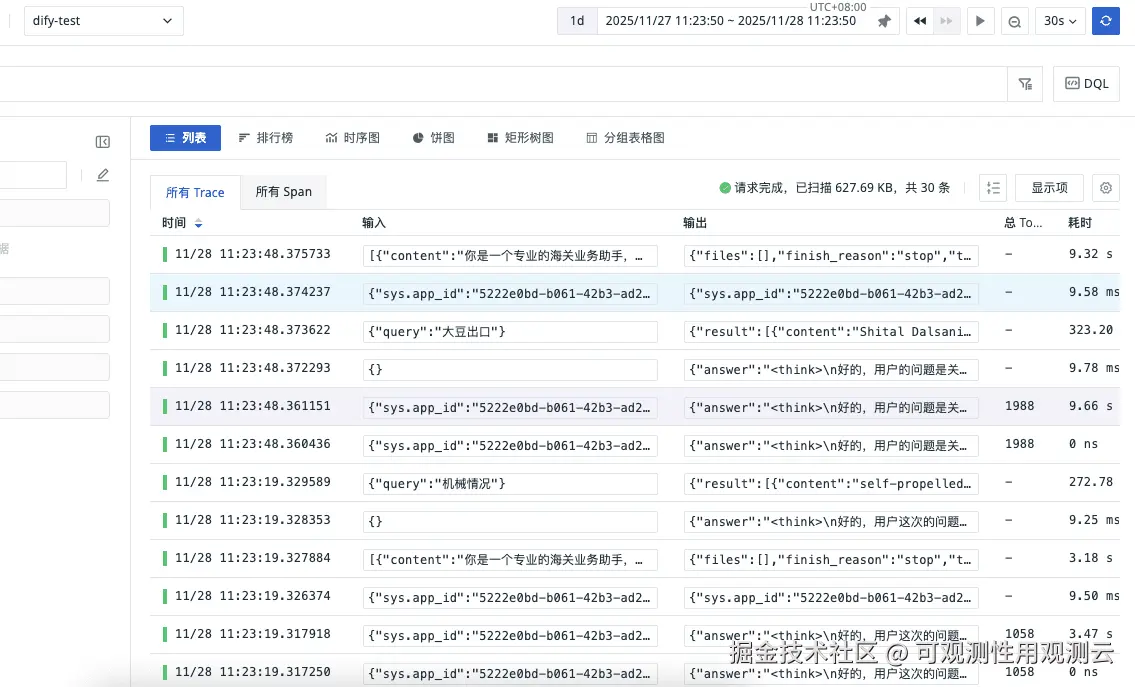

查看 LLM 监测数据

登录观测云控制台,点击「LLM 监测」 -「应用名称」 即可查看数据。

1、LLM 监测 - 应用列表

2、LLM 监测 - 查看器

记录详情 工作流,指标,及Token用量的展示。

在查看器中可以查看每次请求的链路信息,耗时,以及 token 的消耗情况。

3、LLM 监测 - 分析看板

总结

通过观测云 LLM 监测采集 Dify 平台以及各类自定义模型,能够构建全链路可观测体系,全面掌控系统性能与核心调试信息,提前识别并定位潜在问题,持续优化用户交互体验。同时,可实现 Token 消耗的精细化统计,辅助完成提示词优化,最终达成降本增效的核心目标。