Kimi K2 系列大模型:1万亿参数 MoE 架构的技术演进与版本解析

月之暗面(Moonshot AI)发布的 Kimi K2 系列模型,代表了当前国产大模型在混合专家模型(MoE)架构与强化学习推理领域的最新进展。该系列通过 Kimi-k2-instruct 与 Kimi-k2-thinking 两个版本,实现了高效能通用对话与深度逻辑推理的双重覆盖。

一、 核心架构:1万亿参数的混合专家系统

Kimi K2 系列在底层架构上实现了规模化的突破。模型采用 MoE(Mixture-of-Experts)结构,这一设计在维持庞大知识容量的同时,显著优化了推理成本与响应效率。

- 参数规模: 模型总参数量达到 1 万亿 (1 Trillion)。在海量参数的支撑下,模型具备了更强的语境理解能力与复杂的跨领域知识储备。

- 激活参数: 得益于 MoE 架构的路由机制,在每次推理过程中,针对单个 Token 的计算仅激活约 320 亿 (32B) 参数。这种"大总重、轻量化运行"的特性,平衡了模型的智能上限与实际推理的能效比。

- 上下文长度: 全系原生支持 256k tokens 的超长上下文窗口,能够处理长篇文档、超长代码库以及复杂的多轮对话历史。

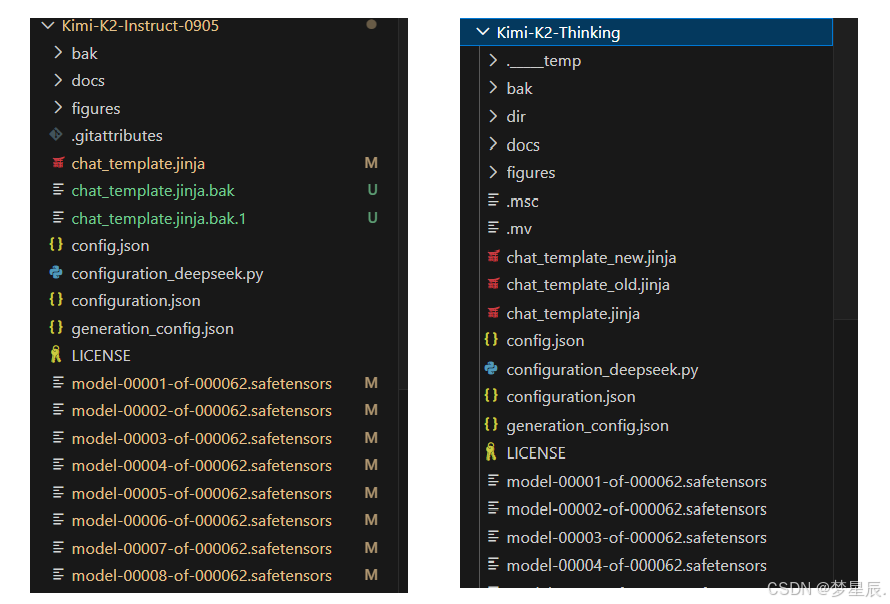

二、 Kimi-k2-instruct:通用指令的高效执行

Kimi-k2-instruct 是针对日常交互与通用任务优化的指令遵循模型。其核心目标是在极短的时间内提供精准的反馈。

- 应用场景: 侧重于文案创作、信息摘要、多语言翻译以及常规的代码辅助。

- 性能表现: 在满足多样化指令遵循的基础上,该版本保持了极高的首字响应速度。它在处理非逻辑密集型任务时,表现出极强的灵活性和语义对齐能力。

- 技术特点: 经过大规模指令微调(SFT),模型能够精准捕捉人类意图,并以符合直觉的方式输出结果,适用于绝大多数高频办公与生活场景。

三、 Kimi-k2-thinking:强化学习驱动的深度推理

Kimi-k2-thinking 是该系列的进阶版本,核心差异在于引入了类似 OpenAI o1 的推理时计算(Test-time Compute)扩展技术。

- 思维链(CoT)机制: 与常规模型直接输出答案不同,Kimi-k2-thinking 在生成最终结论前,会经历一个显性的"思考"过程。模型会自主进行逻辑拆解、自我纠错与路径规划,生成详尽的思维内容(reasoning_content)。

- 强化学习(RL)赋能: 该版本在预训练基础上,通过大规模强化学习进一步增强了逻辑链条的稳定性。在面对奥数级别的数学题、高难度算法竞赛题目(如 Codeforces 级别)以及需要数百步工具调用的复杂 Agent 任务时,其可靠性大幅提升。

- 推理缩放: 模型能够根据问题的复杂度自动调整思考时长。对于简单问题,思考过程较短;对于复杂博弈或科学论证,模型通过消耗更多的推理算力来换取更高的准确率。

四、 部署优化与量化性能

为了解决万亿参数模型带来的显存压力,Kimi K2 在量化技术上进行了深度适配。

官方提供了基于量化感知训练(QAT)的 INT4 量化版本 。在保持模型性能几乎无损的前提下,INT4 版本的权重文件大小约为 594GB 。这一优化使得该万亿规模的模型能够在中大规模的计算集群上实现更经济的部署,显著降低了长上下文推理时的显存占用。