作为全球消费电子领域的"科技灯塔",CES2026刚落幕便引爆了行业对AI硬件的热议------这场集结超3000家国际企业、吸引170余国观众的盛会,成了"具身智能"从概念落地的试验场:微软的多模态服务机器人能精准理解指令,三星的AI智能座舱可通过眼动交互控制车机,中国企业展出的陪伴机器人、工业巡检无人机,更是将"听、说、看、触"的沉浸式体验拉满。

从大模型终端化到AI硬件场景化,这场科技盛宴的底层,其实藏着一个容易被忽略的核心环节:实时音视频(RTC)技术。无论是机器人与人的自然对话、无人机的高清画面回传,还是智能车机的远程交互,都需要低延迟、高稳定的音视频传输作为"神经链路"。而在国内RTC赛道,声网Agora正是支撑这类技术需求的核心玩家之一。

声网RTC:AI硬件落地的"技术底座"

CES2026中AI硬件的核心痛点,恰好是声网技术优势的覆盖范围------多场景、高复杂的实时交互需求,具体可拆解为三大维度:

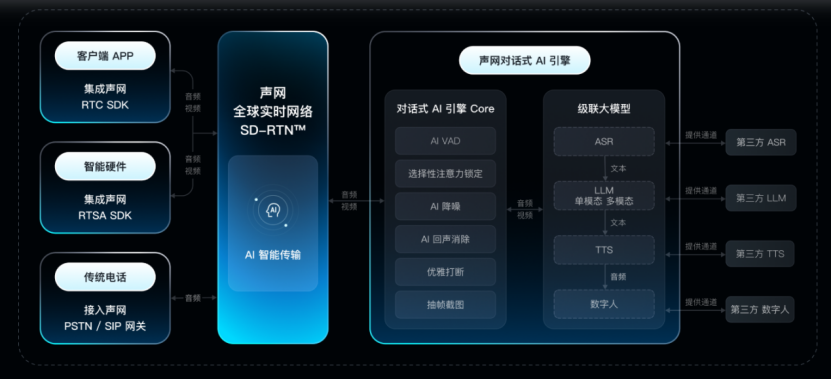

一、让"拟人交互"落地的对话式AI技术

CES展台上,能"像人一样交流"的机器人成了焦点,而这类产品的交互体验,正需要声网对话式AI技术的支撑:

• 硬件原生嵌入:支持直接与硬件设备对接,让机器人、智能车机实现"开口即响应"的自然交互逻辑; • 近真人节奏响应:将对话延迟压缩至650ms、打断响应低至340ms,匹配人类日常交流的速度与节奏; • 强抗干扰识别:可屏蔽95%的环境人声、噪声,即便在展会人流区、工业车间等嘈杂场景,也能精准捕捉对话内容。

这意味着,类似CES展台上的"自然交互型AI硬件",其音视频交互体验的实现,需要声网这类技术提供底层支持。

二、适配多设备的全场景传输能力

CES2026中,无人机、无人车、工业机器人等设备的"多路高清画面回传"需求,正是声网的核心技术优势所在:

• 多路视频并行承载:支持360度多视角的高清视频上行,可满足无人机巡检、无人车全景监控的场景需求; • 多模态交互兼容:覆盖"听、说、看、触"全维度交互形态,适配机器人、无人机、智能座舱等不同硬件的交互逻辑; • 弱网环境韧性:即便在80%丢包率的极端网络下,仍能稳定传输音视频流;对话式AI甚至支持"断网3-5秒后自动恢复响应",适配户外、工业等复杂网络场景。

从CES看趋势:RTC是AI硬件规模化的"必经之路"

CES2026的AI硬件热潮,本质是"大模型+终端设备"的落地浪潮,而声网的技术逻辑,正是通过RTC能力让"数据实时流动"成为可能------无论是机器人的对话、无人机的巡检,还是智能车机的交互,都需要音视频作为"信息载体",连接终端设备与用户、云端。这也意味着,未来类似CES展台上的AI硬件产品,其商业化落地的效率,很大程度上取决于这类RTC技术底座的支撑能力。