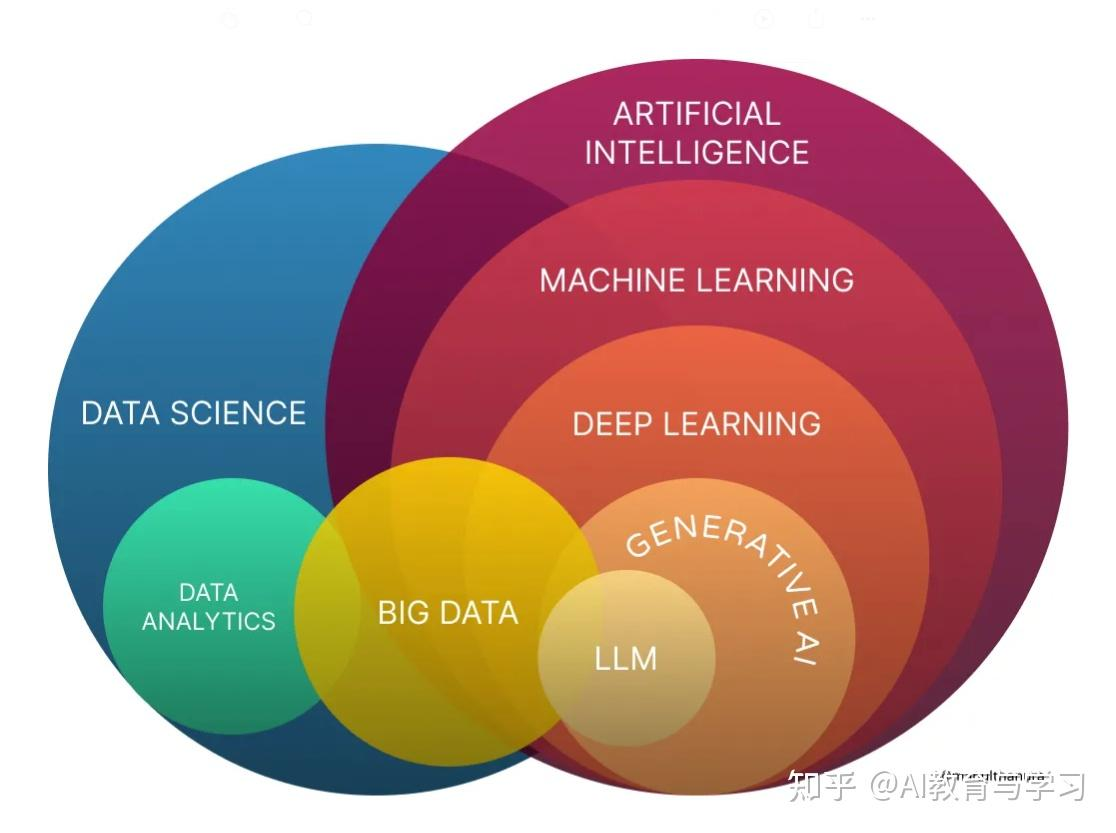

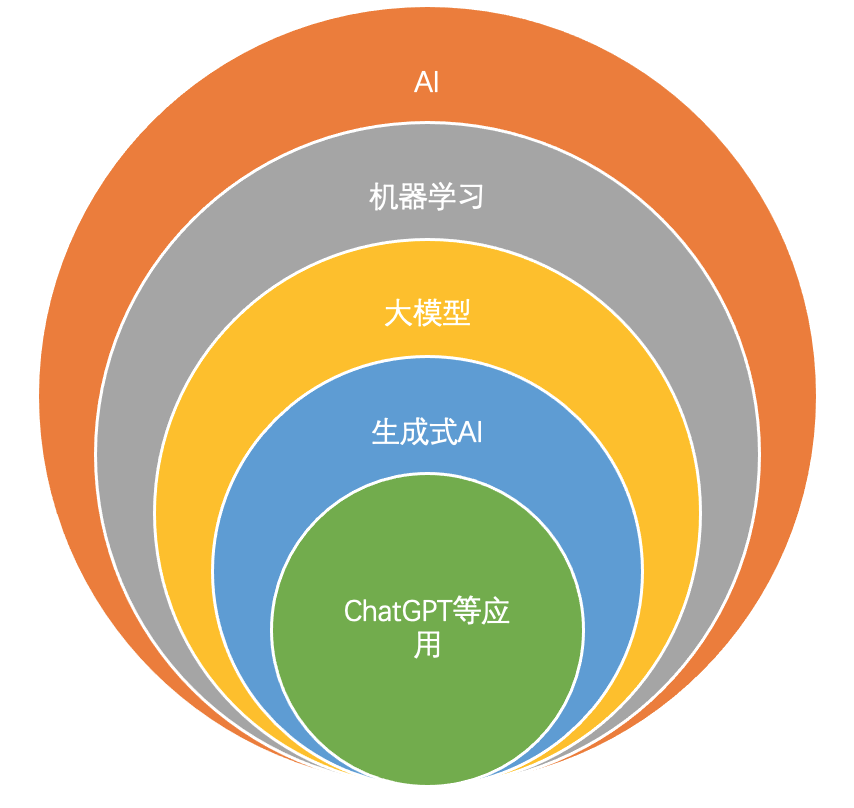

本文系统梳理了人工智能(AI)领域的核心概念与技术体系。首先通过"同心圆图谱"展示AI概念的层级关系:最外层为AI(机器智能),包含机器学习(ML,数据驱动方法),ML又包含深度学习(DL,神经网络方法),最内层是生成式AI(AIGC,内容创作)。随后打破这种教学式分类,提出更贴近现实的"领域-技术栈矩阵"视角:横向基础技术包括表征学习、架构设计和推理对齐;纵向应用领域涵盖生成式创造、具身智能、自动驾驶和科学智能。文章强调当前AI研究呈现多模态融合趋势,专业研究者需跨越传统边界,聚焦解决实际问题而非固守概念分类。

我们用一张清晰的**"同心圆图谱"**来展示它们的关系,并用最直观的语言来拆解每一个概念。

关键概念图谱:AI 的俄罗斯套娃

请看下面这张图,它直观地展示了这四个概念的包含关系:

-

最外层(最大的圆):人工智能(Artificial Intelligence, AI)

-

第二层(包含在AI内):机器学习(Machine Learning, ML)

-

第三层(包含在ML内):深度学习(Deep Learning, DL)

-

最核心(横跨DL和ML的一部分):生成式 AI(Generative AI, AIGC)

注意:生成式AI 是一个应用领域的概念,它主要基于深度学习,但也包含一些传统的机器学习方法,所以它是一个聚焦于"创造"功能的子集。

下面我们一层一层把它拆开来看。

第一层(最外层):人工智能(AI)------ "机器像人一样聪明"的大梦想

-

定义: 人工智能是一个最宽泛的概念,它指的是任何让机器展现出类似人类智能行为的技术。

-

核心目标: 让机器能看(视觉)、能听(语音)、能说(语言)、能思考(推理)、能行动(机器人)。

-

关键点: 它不仅包含我们现在常说的机器学习,还包含早期的"规则引擎"和"专家系统"。

-

通俗比喻:

只要机器做出了让你觉得"哎哟,这机器挺聪明啊"的事情,它就属于 AI 的范畴。

- *例子:*你家里的空调设定为"当温度高于26度时自动开启制冷"。这也叫 AI(虽然是很初级的 AI),因为它在模仿人类"觉得热就开空调"的决策行为。早期下国际象棋的"深蓝"也是 AI,但它主要是靠强大的计算力去硬算每一步棋,而不是靠"学习"。

人工智能研究方向(宏观、跨学科)

它的研究方向极其广泛,包含但不限于机器学习,还包括许多非学习的方法。

-

感知层: 计算机视觉 (CV)、自然语言处理 (NLP)、语音识别与合成。

-

认知层(非ML重点):

-

知识表示与推理: 如何把人类知识形式化(如知识图谱),并基于此进行逻辑演绎。

-

规划与调度 (Planning): 如何在复杂约束下制定达成目标的步骤序列(如物流调度、航天器控制)。

-

多智能体系统 (Multi-Agent Systems): 研究多个 AI 之间如何协作或竞争(如群体机器人、博弈论)。

-

-

行动层: 机器人学 (Robotics),涉及机械控制、传感器融合。

-

基础理论: AI 伦理、可解释 AI (XAI)、通用人工智能 (AGI) 理论框架。

第二层(中间层):机器学习(ML)------ "别给规则,给数据,让它自己学"

-

定义: 机器学习是实现 AI 的一种方法路径 。它的核心思想是废除人类手动编写的规则,而是设计一种算法,让计算机从数据中自动分析出规律,并利用这些规律对未知数据进行预测或决策。

-

核心思想转变: 从"人教机器"变成"机器自学"。

-

关键点: 机器学习包含很多流派,比如统计学习方法(支持向量机 SVM、决策树等)。在深度学习火起来之前,这些是 AI 的主流。

-

通俗比喻:

你不想再一条条写"如果...那么..."的规则了。你直接把一万张猫的照片和一万张狗的照片扔给机器,告诉它答案。机器自己去分析照片里的像素规律,最后总结出怎么区分猫和狗。这就是机器学习。

- 例子: 你的邮箱自动把垃圾邮件过滤掉,它就是通过分析你过去标记为"垃圾"的邮件特征(比如包含某些中奖词汇),学会了自动拦截新邮件。

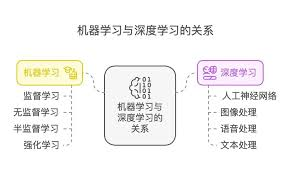

机器学习研究方向(方法论导向)

聚焦于"学习算法"本身的设计和理论分析。

-

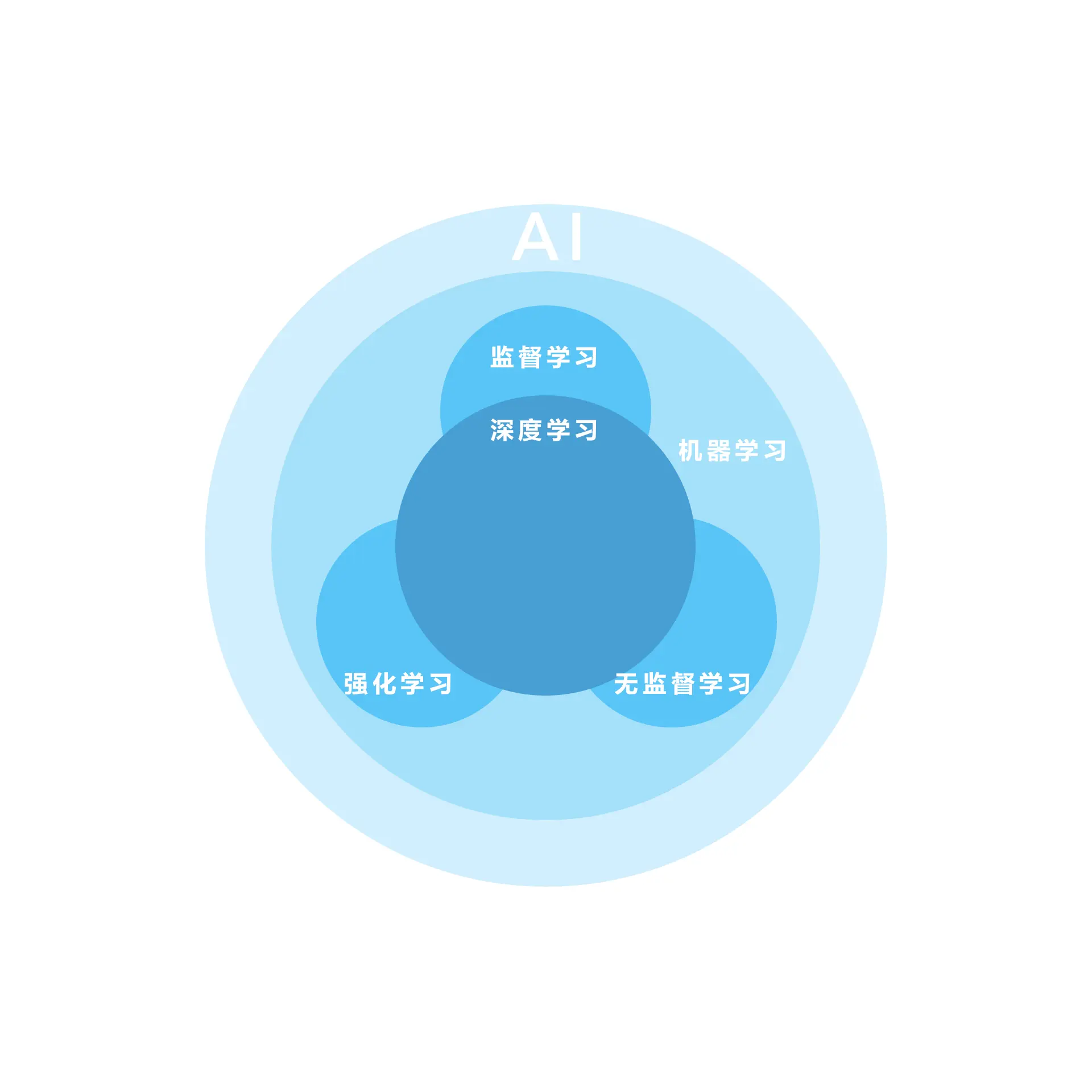

按学习方式划分:

-

监督学习 (Supervised Learning): 研究如何利用带标签数据训练模型(分类、回归)。

-

无监督学习 (Unsupervised Learning): 研究如何在无标签数据中发现结构(聚类、降维、密度估计)。

-

强化学习 (Reinforcement Learning, RL): 研究智能体如何通过与环境交互试错来最大化奖励(策略梯度、Q-learning)。

-

-

按模型类型划分:

-

深度学习 (DL): (见下文)。

-

传统/统计机器学习: 支持向量机 (SVM)、决策树与随机森林、贝叶斯方法、核方法。

-

-

理论研究: 学习理论(Learning Theory,研究学习能力的数学边界)、优化算法(如何更快地训练模型)。

https://cloud.tencent.com/developer/article/2497472

https://aws.amazon.com/cn/compare/the-difference-between-machine-learning-and-deep-learning/

第三层(核心层):深度学习(DL)------ "用模拟人脑的方式来学习"

-

定义: 深度学习是机器学习的一个分支流派,是目前最火、最强大的流派。它特指使用**多层人工神经网络(Artificial Neural Networks)**来解决机器学习问题的方法。

-

核心技术: 它模拟了人脑神经元连接的结构,构建了一个有非常多层(所以叫"深度")的网络结构。这种结构特别擅长处理图像、声音、文本这类非结构化的复杂数据。

-

关键点: "大数据 + 大算力(GPU) + 深层网络结构"是它的三要素。它推动了第三次 AI 浪潮。

-

通俗比喻:

如果传统机器学习是教小学生做题,那深度学习就是建立了一个拥有亿万个"脑细胞"的超级大脑。为了训练这个大脑,你需要喂给它海量的数据教科书,并用超级计算机(GPU)给它加速,让它夜以继日地疯狂刷题,直到它能一眼看穿复杂的奥数题。

- 例子: 手机相册自动识别人脸并分类、Siri 听懂你说的话、特斯拉的自动驾驶视觉系统,背后都是深度学习在支撑。

深度学习研究方向(结构与架构导向)

聚焦于神经网络的结构设计、训练技巧和底层机制。

-

基础模型架构创新:

-

卷积神经网络 (CNN) 及其变体: 专注于图像处理结构的设计 (ResNet, EfficientNet)。

-

循环神经网络 (RNN) 及其变体: 专注于序列数据 (LSTM, GRU)。

-

Transformer 架构: 专注于注意力机制的设计,这是当前最热的方向 (BERT, GPT 系列)。

-

图神经网络 (GNN): 处理图结构数据(如社交网络、分子结构)。

-

-

训练与优化技术:

-

优化器设计: 如何让网络收敛得更快更稳 (Adam, SGD变体)。

-

正则化与归一化: 防止过拟合技术 (Dropout, Batch Normalization)。

-

自监督学习 (Self-Supervised Learning): 如何利用海量无标签数据进行预训练(如对比学习)。

-

-

高效深度学习: 模型压缩、剪枝、量化,让大模型能在手机端运行。

第四层(应用焦点):生成式 AI(AIGC)------ "不再只是判断,而是开始创造"

-

定义: 生成式 AI 指的是一类特定的 AI 技术,它们的目标不再是分析已有数据(比如判断照片里是不是猫),而是创造全新的内容。这些内容可以是文本、图像、音频、视频甚至代码。

-

技术支撑: 它主要依赖于深度学习中的最新技术,特别是大模型(如 Transformer 架构)和扩散模型(Diffusion Models)。

-

关键转变: 从"判别式 AI"(Discriminative AI,比如人脸识别)走向"生成式 AI"(Generative AI,比如 AI 绘画)。

-

通俗比喻:

以前的 AI 像是一个阅卷老师,只负责打钩或打叉(判断对错)。现在的生成式 AI 变成了一个才华横溢的艺术家或作家。你给它一个提示(Prompt):"画一只戴着宇航员头盔在月球上骑自行车的猫",它就能凭空给你创作出一幅从未存在过的画作。

- 例子: ChatGPT 帮你写邮件、Midjourney 帮你画插画、Sora 帮你生成视频,这些都属于生成式 AI。

生成式AI研究方向(应用与生成模型导向)

聚焦于"创造性"任务和特定的生成模型家族。

-

核心生成模型研究:

-

大语言模型 (LLMs): 聚焦于 Transformer Decoder 结构,研究 scaling law(规模法则)、涌现能力、长文本处理能力。

-

扩散模型 (Diffusion Models): 目前图像/视频生成的主流技术,研究噪声调度、采样加速算法 (Stable Diffusion, Sora背后的技术)。

-

生成对抗网络 (GANs): 曾经的王者,现在主要用于特定领域,研究如何稳定训练过程。

-

-

跨模态生成研究:

-

文生图 (Text-to-Image): 研究如何更好地理解文本提示并生成准确图像 (DALL-E 3, Midjourney)。

-

图生文/图生视频: 多模态理解与生成的统一。

-

-

交互与控制研究:

-

提示工程 (Prompt Engineering) 理论: 研究如何设计最优指令来引导模型。

-

可控生成: 如何精确控制生成内容的风格、布局、物体位置(如 ControlNet)。

-

-

评估与安全: 如何评价生成内容的质量?如何防止生成虚假、有害信息(AI 对齐技术)。

总结一张表

| 概念 | 核心逻辑 | 比喻 | 典型代表 | 关系定位 |

|---|---|---|---|---|

| 人工智能 (AI) | 机器展现智能行为 | 只要机器表现得像人一样聪明。 | 自动空调、早期国际象棋程序 | 最外层大框架 |

| 机器学习 (ML) | 从数据中学习规律 | 别写规则,给数据让它自己悟。 | 垃圾邮件过滤、房价预测 | 实现 AI 的主流方法 |

| 深度学习 (DL) | 用多层神经网络学习 | 用模拟人脑结构的超级大脑疯狂刷题。 | 人脸识别、语音助手 | ML 中最强的流派 |

| 生成式 AI (AIGC) | 创造全新的内容 | 从阅卷老师变成了艺术家/作家。 | ChatGPT (写文), Midjourney (作画) | 基于 DL 的前沿应用 |

把这四个层级的研究重点放在一张图里对比:

| 研究层级 | 关键词 | 主要研究对象 (What) | 核心驱动力 (Why) | 典型研究成果例子 |

|---|---|---|---|---|

| 人工智能 | 综合智能 | 智能体、知识、推理、规划、机器人 | 追求机器的全面拟人化能力 | 知识图谱、波士顿动力机器人、AlphaGo 整体系统 |

| 机器学习 | 算法理论 | 学习范式、优化理论、统计模型 | 追求从数据中自动提取规律的高效方法 | 支持向量机(SVM)、随机森林、强化学习理论、贝叶斯网络 |

| 深度学习 | 网络架构 | 神经网络层、激活函数、注意力机制、预训练策略 | 追求对复杂非结构化数据(图像/文本)的强大表征能力 | ResNet, Transformer架构, Adam优化器, BERT预训练模型 |

| 生成式AI | 创造能力 | 大模型、扩散模型、跨模态对齐、提示词 | 追求高质量、高可控性的内容自动化创作 | ChatGPT, Stable Diffusion, Sora, LLaMA |

结论:如何选择你的研究方向?

-

如果你对宏大的哲学问题 感兴趣,想研究如何让机器具备逻辑思维、常识推理,或者想做软硬件结合的机器人,那么你的视野应该放在宽泛的 AI 领域。

-

如果你喜欢数学推导和统计理论 ,想研究学习算法的本质边界,或者想用经典方法解决表格数据问题,那么 ML 是你的阵地。

-

如果你是个架构师 ,喜欢设计精巧的网络结构来提升图像识别或语言理解的准确率,痴迷于调参和炼丹,那么 DL 是你的舞台。

-

如果你是个创作者或产品经理 ,对 AI 画画、写小说、生成视频感到兴奋,想探索 AI 创造力的边界和应用,那么 AIGC 是当前最火热的选择。

到这里请忘记文章开始时的分类图,关注你的研究领域和应用方向,文章开始的分类图只是便于理解的引导,完全相信就陷入了误区。

那个"同心圆"或"俄罗斯套娃"图谱,只是为了让初学者快速建立直觉的教学支架(Scaffolding)。一旦你跨过了入门门槛,如果还死守着那个分类图,就会陷入机械化的理解,无法看清 AI 领域真实、动态、且充满交叉融合的科研与应用现状。

在真实的研究和工业界中,没有人会把自己简单地框定在某个圆圈里。

忘掉那个分类图,现在我们站在一个更专业、更务实的视角,重新审视 AI 的版图。在科研一线和产业前沿,我们更多关注的是**"解决什么领域的问题"以及"运用什么技术栈"**。

我们将 AI 领域重新解构为**"横向基础技术"和"纵向应用领域"**的一个矩阵网络。这才是更接近真相的视角。

真实的 AI 科研与应用视图:领域与技术栈的矩阵

在现实中,一个顶尖的 AI 研究员或工程师,通常不会说"我是研究深度学习的"(这太宽泛了),而是会说"我是做具身智能(Robot Learning)的,主要研究如何利用大模型 来提升机器人的规划能力"。

看到区别了吗?真实的定位是跨越多个维度的。

下面我们用专业的视角,重构 AI 的研究领域和应用方向:

一、 横向:通用基础技术栈 (Foundational Tech Stack)

这是支撑所有上层应用的底层原子能力,是"造轮子"的研究。

1. 表征学习 (Representation Learning)

-

核心问题: 如何把世界上复杂万物(图片、文字、声音、分子结构、社交关系)极其高效地变成计算机能懂的数学向量?

-

前沿方向:

-

多模态对齐: 如何让模型理解一张图片和描述它的文字是同一个东西(如 CLIP 模型)?这是现在文生图、图生文的基础。

-

自监督学习: 如何在没有人类标注的情况下,让机器从未经处理的海量数据中自己学会理解世界(如 BERT, MAE)。

-

2. 基础架构与训练机制 (Architecture & Training Dynamics)

-

核心问题: 设计什么样的网络结构最高效?如何让巨量参数的模型训练得又快又稳?

-

前沿方向:

-

Transformer 及其变体改进: 还能不能设计出比 Transformer 更强、效率更高的架构?(比如最近火热的 Mamba/SSM 架构挑战)。

-

大模型训练优化: 如何在几千张 GPU 上并行训练万亿参数的模型而不崩溃?(涉及分布式系统、显存优化)。

-

高效微调 (PEFT): 如何用极小的代价(如 LoRA)让一个通用大模型适配特定任务?

-

3. 推理与对齐 (Reasoning & Alignment)

-

核心问题: 怎么让模型不仅会"背书",还会"思考"?怎么确保模型听人类的话,不干坏事?

-

前沿方向:

-

思维链 (Chain-of-Thought, CoT): 激发大模型逐步推理解决复杂数学或逻辑问题的能力。

-

人类反馈强化学习 (RLHF): 让模型的输出符合人类的价值观和偏好(ChatGPT 的核心技术)。

-

二、 纵向:核心应用领域与挑战 (Vertical Application Domains)

这是用基础技术去解决的具体世界的问题。在这些领域里,CV、NLP、RL 等技术往往是混杂在一起使用的。

1. 生成式创造 (AIGC & Creative AI)

-

不再是分类的子集,而是全新的范式。

-

核心方向:

-

图像/视频生成: 追求极致的真实感、可控性(如 Sora, Midjourney V6)。研究如何精准控制生成画面里的人物姿态、光影。

-

3D 内容生成: 凭空生成高质量的游戏资产、数字人模型。

-

代码与工具智能体: AI 不仅写代码,还能自己调用搜索、数据库、API 去完成复杂的任务(AI Agent)。

-

2. 具身智能与机器人 (Embodied AI & Robotics)

-

这是 AI 的下一个大战场:让 AI 有个身体,走进物理世界。

-

这不仅仅是机械控制,而是 CV(看懂环境)、NLP(听懂指令)、规划决策(思考怎么动)和控制理论的深度融合。

-

核心方向:

-

端到端机器人控制: 直接从摄像头图像输入,输出机械臂的关节动作,不再依赖繁琐的人工规则。

-

世界模型 (World Models): 让机器人像人一样在脑子里模拟"如果我这么做,世界会发生什么变化",从而预知后果。

-

3. 自动驾驶 (Autonomous Driving)

-

集大成者的应用场景。

-

它需要极端的实时性和安全性,融合了最强的感知技术和决策技术。

-

核心方向:

-

BEV (鸟瞰图) 感知: 把多个摄像头的画面融合成一个上帝视角的 3D 地图。

-

端到端自动驾驶: 像人一样,输入是传感器数据,输出直接是方向盘和油门的操作,不再硬拆分感知、规划模块。

-

4. 科学智能 (AI for Science, AI4S)

-

用 AI 去破解基础科学难题。

-

核心方向:

-

蛋白质结构预测: AlphaFold 已经改变了生物学。现在研究更复杂的蛋白质相互作用。

-

材料发现与药物研发: 用生成式 AI 去设计全新的分子结构,缩短新药研发周期。

-

气象与流体模拟: 用深度学习加速天气预报和复杂的物理模拟。

-

总结:打破边界,解决问题

抛弃了入门的分类图后,你会发现真实的 AI 世界是没有清晰边界的:

-

搞 NLP 的人现在必须懂视觉,因为多模态是趋势。

-

搞图像生成的人必须懂语言模型,因为要理解复杂的 Prompt。

-

搞机器人的人必须懂强化学习和 CV。

现在的 AI 研究主旋律是"融合":不同模态数据的融合,感知与决策的融合,虚拟世界与物理世界的融合。

到这里,你在讲出AI来,就不那么显得是像新手了。