JMM内存模型介绍

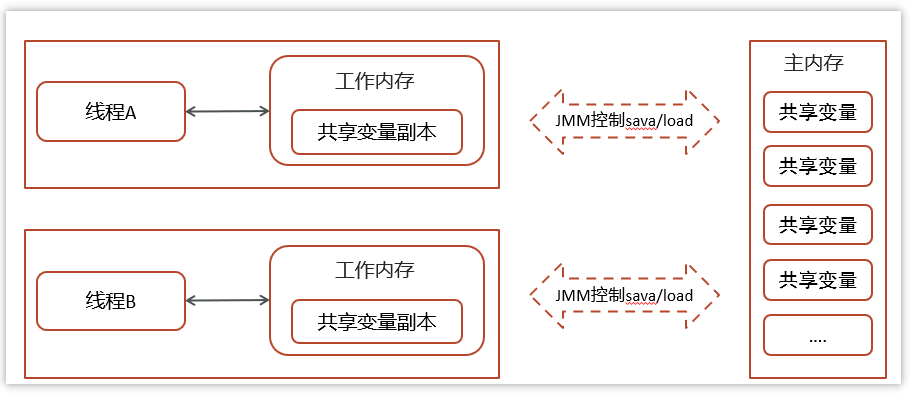

JMM(Java Memory Model)Java内存模型,是java虚拟机规范中所定义的一种内存模型。

Java内存模型(Java Memory Model)描述了Java程序中各种变量(线程共享变量)的访问规则,以及在JVM中将变量存储到内存和从内存中读取变量这样的底层细节。

特点:

-

所有的共享变量都存储于主内存(计算机的RAM)这里所说的变量指的是实例变量和类变量。不包含局部变量,因为局部变量是线程私有的,因此不存在竞争问题。

-

每一个线程还存在自己的工作内存,线程的工作内存,保留了被线程使用的变量的工作副本。

-

线程对变量的所有的操作(读,写)都必须在工作内存中完成,而不能直接读写主内存中的变量,不同线程之间也不能直接访问对方工作内存中的变量,线程间变量的值的传递需要通过主内存完成。

问题1:工作内存存在吗?

问:java的jmm把内存分为共享内存和工作内存,工作内存线程私有的,只能自己访问,那么工作内存这个在计算机物流硬件是实际存在吗?也是RAM吗?

deepseek:

这是一个非常好的问题,触及了Java内存模型的**抽象性**与**硬件实现**之间的区别。

简单直接的答案是:**工作内存并不是一个物理上独立存在的内存区域(不是一块额外的RAM),而是一个涵盖了CPU缓存、寄存器、写缓冲区以及硬件优化的抽象概念。**

下面我们来详细分解:

1. JMM 是一个抽象模型(规范,非实现)

Java内存模型定义了一套规则,旨在解决多线程环境下变量的**可见性**、**有序性**和**原子性**问题。

-

**主内存**: 代表"共享内存",在抽象层面是所有线程共享的变量存储区域。

-

**工作内存**: 代表"线程私有内存",在抽象层面是每个线程独享的,存储了该线程使用到的变量的副本。

**关键点**: JMM描述的"主内存"和"工作内存"是**逻辑划分**,而不是物理划分。它并不规定工作内存必须放在CPU缓存里,主内存必须放在RAM里。这只是一种便于理解的模型。

2. 硬件上的对应关系

当我们把JMM的抽象模型映射到现代多核计算机硬件架构时,对应关系大致如下:

| JMM 概念 | 硬件对应物(可能包括) | 说明 |

| :--- | :--- | :--- |

| **主内存** | **系统主内存(RAM)** | 这是所有数据最终驻留的地方。 |

| **工作内存** | **CPU核心的各级缓存(L1, L2, L3)、寄存器、写缓冲区、甚至编译/运行时优化** | 这是线程私有数据的"工作区域",速度远快于主内存。 |### 3. 一个具体的执行流程(类比)

我们通过一个例子来看抽象模型如何与硬件交互:

java

// 初始状态:共享变量 `counter = 0` 存放在主内存(RAM)

public class Example {

private int counter = 0; // 位于"主内存"

public void increment() {

counter++; // 线程在自己的"工作内存"中操作

}

}假设两个线程(Thread-1, Thread-2)分别在不同CPU核心上执行 `increment()`:

- **读取阶段**:

-

Thread-1 需要读取 `counter`。CPU-1 会先将 `counter` 的值从**主内存(RAM)** 加载到 **CPU-1 的缓存(工作内存)** 中。

-

Thread-2 同样,CPU-2 也会将 `counter` 加载到 **CPU-2 的缓存(工作内存)** 中。

-

此时,物理上存在一个 `counter=0` 在 RAM 中,以及两个副本 `counter=0` 分别在 CPU-1 和 CPU-2 的缓存里。

- **修改阶段**:

-

Thread-1 在自己的工作内存(CPU-1缓存)中将副本值加1,变为 `counter=1`。**此时这个改变对 Thread-2 是不可见的**,因为还在 CPU-1 的私有缓存里。

-

同样,Thread-2 也可能在自己的工作内存(CPU-2缓存)中将副本值加1,变为 `counter=1`。

- **写回与同步问题**:

-

当某个线程(比如Thread-1)需要将修改写回"主内存"时,它会将缓存行写回 RAM。

-

现代CPU使用**缓存一致性协议(如MESI)** 来确保不同核心的缓存数据一致。当 CPU-1 写回时,会**使 CPU-2 中对应的缓存行失效**,强制 CPU-2 下次读取时从 CPU-1 的缓存或 RAM 重新加载。

-

然而,**即使有MESI协议,由于存在延迟、缓冲区等因素,仍可能产生可见性问题**(比如写缓冲区导致其他CPU看不到最新值)。这就需要 JMM 的 `volatile`、`synchronized`、`final` 或 `java.util.concurrent` 包中的工具来提供更强的**内存屏障(Memory Barrier)** 保证,强制刷新或失效缓存,确保可见性。

4. 为什么需要这个抽象模型?

如果工作内存就是物理缓存,那为什么Java不直接叫"缓存"?

-

**平台无关性**: Java要运行在不同架构上(x86, ARM, PowerPC等),它们的缓存模型、内存模型可能不同。JMM提供了一个统一的、更高级的抽象,让Java程序员不用关心底层是强内存模型(如x86)还是弱内存模型(如ARM)。

-

**涵盖范围更广**: "工作内存"不仅包括硬件缓存,还包括编译器/运行时为了性能进行的重排序优化。这些优化可能导致指令执行顺序与代码顺序不一致,也属于JMM要规范的范围。

总结

-

**工作内存不是物理上独立的一块RAM**,它是一个逻辑概念。

-

**它的物理载体主要是CPU核心的私有缓存、寄存器等高速存储部件。**

-

JMM通过定义 `volatile`、`synchronized`、`happens-before` 等规则,在**各种不同的硬件内存模型**之上,为Java程序员提供了一个**一致且可靠**的并发编程保证。程序员只需遵循JMM规则(如正确使用同步),就能写出线程安全的代码,而无需深究底层是x86还是ARM。

所以,你可以把"工作内存"理解为 **"线程所有可能用到的、能快速访问数据的硬件和优化机制的集合体"**,而RAM(主内存)是数据的"终极归宿"。JMM的核心就是规范这两者之间何时、如何进行同步。

问题2:简单介绍cpu三级缓存

好的,简单介绍一下CPU三级缓存。你可以把它想象成一个**"学霸的速记本"体系**,离大脑(CPU核心)越近,速度越快,但容量越小。

核心比喻:图书馆借书

-

**主内存(RAM)**:学校的大图书馆,书很多但走过去要 **100-200 纳秒**。

-

**L3 缓存(三级缓存)**:系里的小资料室,存放常用书,走过去要 **30-40 纳秒**。

-

**L2 缓存(二级缓存)**:你小组的共享书架,更快更小,需要 **10-15 纳秒**。

-

**L1 缓存(一级缓存)**:你桌上的几本正在看的书,伸手就拿,只需 **1-2 纳秒**。

-

**寄存器**:你大脑里正在思考的那几行内容,**瞬间访问**。

三级缓存的具体特征

**L1 缓存(最快,最小)**

-

**位置**:集成在每个CPU核心**内部**

-

**大小**:通常 **32KB - 64KB**(分为指令缓存和数据缓存)

-

**速度**:比寄存器慢一点,但比L2快3-5倍

-

**特点**:每个核心独享,访问几乎无延迟

**L2 缓存(折中)**

-

**位置**:通常也在每个CPU核心内部(现代设计)

-

**大小**:通常 **256KB - 512KB** 每个核心

-

**速度**:比L1慢2-3倍,但比L3快

-

**特点**:核心独享或小范围共享

**L3 缓存(最慢,最大)**

-

**位置**:在CPU芯片上,但**所有核心共享**

-

**大小**:通常 **8MB - 64MB+**(服务器CPU可达数百MB)

-

**速度**:比L2慢2-3倍,但比内存快5-10倍

-

**特点**:**多核同步的关键**!核心间通信主要通过L3

三级缓存如何协同工作

```

CPU核心 <---> L1缓存 <---> L2缓存 <---> L3缓存 <---> 主内存(RAM)

│ (独享) (独享/半共享) (全共享) (全系统共享)

└─ 速度: 1ns级别 3-5ns 10-15ns 100ns+

```

**数据查找流程**(缓存命中):

-

CPU要读取数据,先在 **L1** 找 → 找到就返回(命中)

-

L1没有 → 查 **L2** → 命中返回

-

L2没有 → 查 **L3** → 命中返回

-

L3还没有 → 去 **主内存** 读取(最慢)

**命中率典型值**:

-

L1命中率:~95%

-

L2命中率:大部分剩余访问

-

L3命中率:减少最后去内存的次数

-

总体缓存命中率可达 **98%+**,这就是缓存存在的意义!

为什么需要三层而不是一层?

- **速度与容量的平衡**:

-

L1追求极速,所以必须小

-

L3可以做得比较大,存放更多共享数据

-

没有L3的话,多核CPU会频繁访问慢速的内存

- **多核协作的关键**:

-

当CPU核心1修改了数据,其他核心如何知道?

-

**缓存一致性协议(如MESI)** 通过L3作为"协调中心"

-

核心1修改数据 → 标记L3中该数据状态 → 其他核心从L3同步

- **成本控制**:

-

SRAM(缓存用)比DRAM(内存用)快但贵10倍以上

-

分级缓存用最少的高速SRAM达到最佳效果

实际例子:Intel/AMD现代CPU

**Intel Core i7/i9**:

-

L1:每个核心 32KB数据+32KB指令

-

L2:每个核心 256KB-512KB

-

L3:所有核心共享 8MB-36MB

**AMD Ryzen**:

-

采用"小芯片"设计,L3缓存特别大(32MB-96MB)

-

游戏性能强的原因之一就是大缓存

与Java内存模型的关系

回到你的原始问题,JMM的 **"工作内存"** 主要对应:

-

**L1/L2缓存**:线程的私有工作区域

-

**L3缓存**:线程间共享数据的"中间地带"

-

当线程在不同CPU核心上运行时,它们的"工作内存"实际就是不同核心的L1/L2缓存

**内存屏障**的作用之一,就是确保对一个核心L1缓存的修改,能**立刻反映到L3并通知其他核心**,从而实现JMM要求的可见性。

简单说,**三级缓存是现代CPU为了弥补CPU超快速度和内存相对慢速之间的巨大差距而设计的高速数据中转站**,层级越高,容量越大但速度越慢,是计算机性能优化的关键设计。