07. Hudi Flink 集成分析

主题说明

Hudi 与 Flink 的集成支持流式写入和批式查询,让 Flink 能够实时写入 Hudi 表。理解 Flink 集成有助于理解流式数据湖的实现。

Flink 集成包括:

- DataStream API:流式写入支持

- Table API:SQL 查询支持

- HoodieFlinkWriteClient:Flink 写入客户端

- Checkpoint 机制:保证一致性

细化内容

DataStream API 集成

Hudi 提供 Flink DataStream Sink,支持流式写入。

主要组件:

HoodieFlinkStreamer:流式写入器HoodieFlinkSink:Flink Sink 实现- 配置管理:通过 Flink 配置传递

Table API 集成

Hudi 支持 Flink Table API,可以通过 SQL 查询。

主要功能:

- Catalog 支持:注册 Hudi 表

- SQL 查询:支持标准 SQL

- 时间旅行:支持查询历史版本

HoodieFlinkWriteClient - Flink 写入客户端

HoodieFlinkWriteClient 是 Flink 的写入客户端,支持流式写入。

特点:

- 异步写入:支持异步提交

- Checkpoint 集成:与 Flink Checkpoint 集成

- 状态管理:管理写入状态

Checkpoint 机制

Flink 的 Checkpoint 机制保证写入的一致性:

- Checkpoint 触发:在 Checkpoint 时提交写入

- 状态恢复:从 Checkpoint 恢复写入状态

- Exactly-Once:保证精确一次语义

关键技术

流式写入

Flink 流式写入的特点:

- 增量提交:定期提交写入

- 小文件合并:自动合并小文件

- 背压处理:处理背压情况

状态管理

Flink 状态管理:

- 写入状态:记录写入进度

- Checkpoint 状态:保存 Checkpoint 信息

- 恢复机制:从状态恢复

关键对象说明

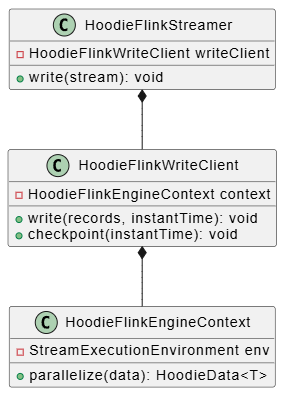

类关系图

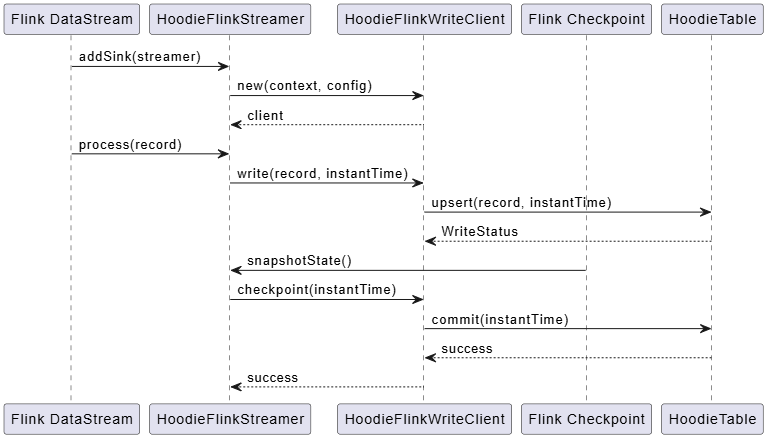

关键操作时序图

代码示例

Flink 流式写入

java

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

DataStream<HoodieRecord> stream = env.addSource(source);

HoodieFlinkStreamer streamer = new HoodieFlinkStreamer(config);

stream.addSink(streamer);总结

Hudi 与 Flink 的集成支持流式写入和批式查询。核心要点:

- DataStream API 支持流式写入

- Table API 支持 SQL 查询

- HoodieFlinkWriteClient 是 Flink 写入客户端

- Checkpoint 机制 保证一致性

- 状态管理 支持恢复

理解 Flink 集成有助于实现流式数据湖。