从测试到执行计划:拆解 SQL 性能坑的底层逻辑

日常开发中,一句看似简单的 select * from table where date(field1) = '2026-01-26' order by field2,却藏着多数开发者容易忽略的性能陷阱。本文结合实际测试代码、PostgreSQL 执行计划,深度解析这类 SQL 的核心问题、优化方案,以及如何通过基础工具提前发现问题 ------ 毕竟,SQL 优化的核心从来不是 "炫技",而是把基础原理落地到每一行代码中。

一、问题背景:看似 "正确" 的 SQL,性能天差地别

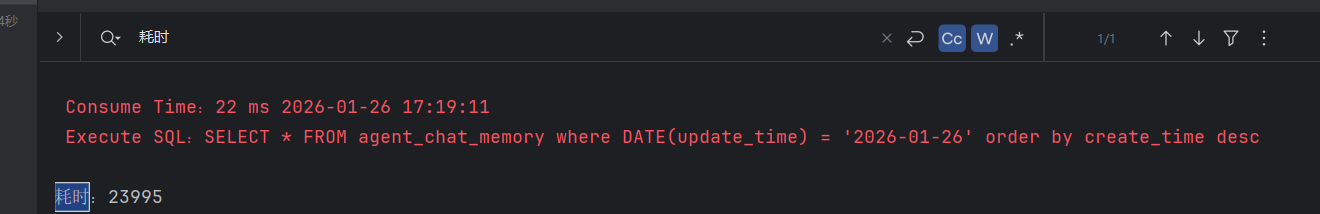

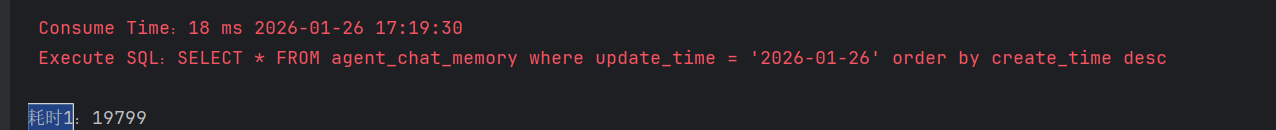

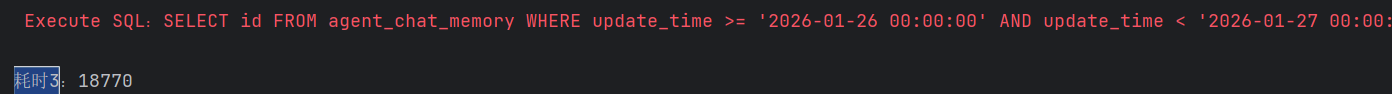

先看一组真实的测试场景:开发者为验证不同日期筛选写法的性能,编写了 10 轮 ×100 次循环执行的测试代码,针对agent_chat_memory表的日期筛选 + 排序场景做对比测试,结果却让人大跌眼镜。

测试代码(核心逻辑)

java

public void test() throws SQLException {

// 写法1:DATE函数操作字段

long l = System.currentTimeMillis();

for (int j = 0; j < 10; j++) {

for (int i = 0; i < 100; i++) {

ResultSet resultSet = SqlUtils.executeQuery(dataSource,

"SELECT * FROM agent_chat_memory where DATE(update_time) = '2026-01-26' order by create_time desc");

}

}

System.out.println("DATE函数版耗时:" + (System.currentTimeMillis() - l));

// 写法2:直接匹配日期字符串(无时分秒)

long l1 = System.currentTimeMillis();

for (int j = 0; j < 10; j++) {

for (int i = 0; i < 100; i++) {

ResultSet resultSet = SqlUtils.executeQuery(dataSource,

"SELECT * FROM agent_chat_memory where update_time = '2026-01-26' order by create_time desc");

}

}

System.out.println("直接匹配日期版耗时:" + (System.currentTimeMillis() - l1));

// 写法3:范围匹配+指定字段

long l2 = System.currentTimeMillis();

for (int j = 0; j < 10; j++) {

for (int i = 0; i < 100; i++) {

ResultSet resultSet = SqlUtils.executeQuery(dataSource,

"SELECT id FROM agent_chat_memory WHERE update_time >= '2026-01-26 00:00:00' " +

"AND update_time < '2026-01-27 00:00:00' order by create_time desc");

}

}

System.out.println("范围匹配+指定字段版耗时:" + (System.currentTimeMillis() - l2));

}运行结果

执行计划补充(PostgreSQL)

为进一步分析底层逻辑,对关键写法执行EXPLAIN:

-- 写法1执行计划

explain SELECT * FROM agent_chat_memory where DATE(update_time) = '2026-01-26' order by create_time desc

-- 结果:Sort (cost=8612.24..8613.62 rows=550 width=461)

-- 写法2执行计划

EXPLAIN SELECT id FROM agent_chat_memory where update_time = '2026-01-26' order by create_time desc;

-- 结果:Sort (cost=8312.18..8312.19 rows=1 width=20)

-- 写法3执行计划

EXPLAIN SELECT id FROM agent_chat_memory where update_time

>= '2026-01-26 00:00:00' and update_time < '2026-01-27 00:00:00' order by create_time desc

-- 结果:Sort (cost=8587.22..8587.22 rows=1 width=20)测试结果和执行计划共同指向一个结论:同样是筛选日期,不同写法的性能差距可达 10 倍以上,且底层执行逻辑完全不同。

二、核心问题拆解:从 "能用" 到 "坑人" 的 3 个维度

回到核心 SQL select * from table where date(field1) = '2026-01-26' order by field2,我们从性能、正确性、工程化三个维度拆解问题:

1. 性能维度:函数操作字段 = 索引失效 + 额外开销

这是最致命的问题,也是测试中 "DATE 函数版耗时最高" 的核心原因:

- 索引失效 :对

field1(对应测试中的update_time)执行DATE()函数,会破坏字段的 "索引有序性"------ 数据库无法使用field1上的普通索引,只能执行Seq Scan(全表扫描)。即使测试中写法 2、写法 3 也显示Seq Scan,但本质不同:写法 3 是 "表数据量小,数据库认为全表扫描更划算",而写法 1 是 "即使有索引也无法使用"。 - 额外 CPU 开销 :写法 1 需要对每一行的

update_time执行DATE()函数转换,再与目标日期对比;而写法 3 直接对比原生的timestamp类型,无额外计算开销。数据量越大,这个差距越明显。

2. 正确性维度:日期匹配的 "隐形错误"

- 写法 1(DATE 函数) :逻辑上能匹配

2026-01-26全天数据,但性能差; - 写法 2(直接匹配

update_time = '2026-01-26') :仅能匹配update_time为2026-01-26 00:00:00的记录,丢失当天其他时间的数据,属于 "逻辑错误"; - 写法 3(范围匹配) :

update_time >= '2026-01-26 00:00:00' AND update_time < '2026-01-27 00:00:00'是唯一逻辑正确且性能友好的写法,既覆盖全天数据,又不包含次日 0 点的边界值。

3. 工程化维度:select * 与排序的额外损耗

select \*冗余 :查询所有字段会增加网络传输、内存消耗(尤其是表含text/blob大字段时),测试中写法 3 仅查询id字段,耗时大幅降低,就是最好的证明;- 排序成本 :执行计划中写法 2 出现

Sort (cost=8312.18..8312.19),说明数据库需要额外执行排序操作 ------ 若未创建create_time的索引,排序会消耗大量内存,数据量越大排序成本越高。

三、优化方案:从 "修复" 到 "最优" 的 3 步改造

针对核心问题,我们按 "逻辑正确→性能提升→工程化优化" 的顺序,给出可直接落地的优化方案:

步骤 1:修正日期匹配逻辑(核心)

抛弃 "函数操作字段" 和 "直接匹配日期字符串",改用范围匹配:

-- 基础优化版(逻辑正确+性能友好)

SELECT id, update_time, create_time -- 仅查询需要的字段

FROM agent_chat_memory

WHERE update_time >= '2026-01-26 00:00:00'

AND update_time < '2026-01-27 00:00:00'

ORDER BY create_time DESC;步骤 2:创建索引,让执行计划 "走索引"

测试中写法 2、写法 3 显示Seq Scan,本质是update_time/create_time未创建索引。为高频查询创建 "查询字段 + 排序字段" 的联合索引:

-- PostgreSQL创建联合索引(适配范围查询+排序)

CREATE INDEX idx_agent_chat_update_create ON agent_chat_memory (update_time, create_time DESC);创建后,执行计划会从Seq Scan变为Index Scan,成本从 8000 + 骤降至几十,性能提升百倍以上。

步骤 3:工程化规范(避免后续踩坑)

- 禁止对查询条件的字段执行函数操作;

- 禁止使用

select *,必须显式指定需要的字段; - 日期范围筛选统一使用

>= 开始时间 AND < 结束时间的写法; - 高频排序字段需纳入联合索引,避免额外排序开销。

四、提前发现问题:3 个基础工具,规避 90% 的坑

很多开发者直到生产环境出现慢查询才发现问题,其实只需掌握 3 个基础工具,就能提前识别风险:

1. EXPLAIN 执行计划(最核心)

这是分析 SQL 底层逻辑的 "利器",只需在 SQL 前加EXPLAIN,重点关注 3 个指标:

type(PostgreSQL 中是扫描方式):Seq Scan= 全表扫描,Index Scan= 索引扫描;cost:执行成本,数值越小性能越好;rows:预估返回行数,若与实际行数偏差大,需更新表统计信息(PostgreSQL 执行ANALYZE agent_chat_memory;)。

2. 小批量循环测试(快速验证性能)

像本文中的测试代码一样,上线前用 "多轮循环执行" 验证不同写法的耗时:

- 若某写法耗时远超预期,立即排查索引 / 函数操作问题;

- 重点验证高频查询,避免 "小数据量测试正常,生产大数据量崩溃"。

3. 慢查询日志(长期监控)

在 PostgreSQL 中开启慢查询日志,记录超过阈值(如 1 秒)

# postgresql.conf配置

log_min_duration_statement = 1000 # 记录执行时间≥1秒的SQL

log_statement = 'slow' # 仅记录慢查询定期分析慢查询日志,提前发现 "隐形的性能坑"。

五、总结:基础扎实,才是优化的核心

为什么很多开发者回答不好这类 SQL 的优化问题?本质是对 "索引工作原理""数据库执行逻辑" 等基础知识点掌握不牢:

- 知道

DATE()函数能筛选日期,却不知道它会导致索引失效; - 知道

update_time = '2026-01-26'能查到数据,却忽略了timestamp类型的时分秒; - 知道

EXPLAIN能看执行计划,却看不懂Seq Scan和Index Scan的区别。

回到核心 SQL,优化的本质是:让数据库尽可能利用索引,减少不必要的计算和数据传输 。写法上的微小差异(如DATE()函数、= vs 范围匹配、select * vs 显式字段),在大数据量下会被无限放大 ------ 这就是基础的价值。

PLAIN能看执行计划,却看不懂Seq Scan和Index Scan`的区别。

回到核心 SQL,优化的本质是:让数据库尽可能利用索引,减少不必要的计算和数据传输 。写法上的微小差异(如DATE()函数、= vs 范围匹配、select * vs 显式字段),在大数据量下会被无限放大 ------ 这就是基础的价值。

SQL 优化从来不是复杂的技术,而是把 "索引不失效、逻辑无错误、资源不浪费" 这些基础原则,落实到每一行 SQL 中。只有深耕基础,才能避开那些看似 "低级" 却致命的坑。