yolov1:开启目标检测的全新纪元

"如果你问一个深度学习新手:'怎么在照片里找猫?'他可能会告诉你:'第一步,先找哪儿可能有猫;第二步,确认那是不是只猫。'但如果你问 YOLOv1,它会翻个白眼告诉你:'看一眼就够了的事,你分两步走,是不是因为家里没装 Titan X?'

作为目标检测界的'暴力拆迁户',YOLOv1 强行把复杂的检测流水线压扁成了一个回归问题。今天我们就拆开那个 7 × 7 × 30 7 \times 7 \times 30 7×7×30 的'黑盒子',看看作者到底往里面塞了多少天才的脑洞。"

Abstract

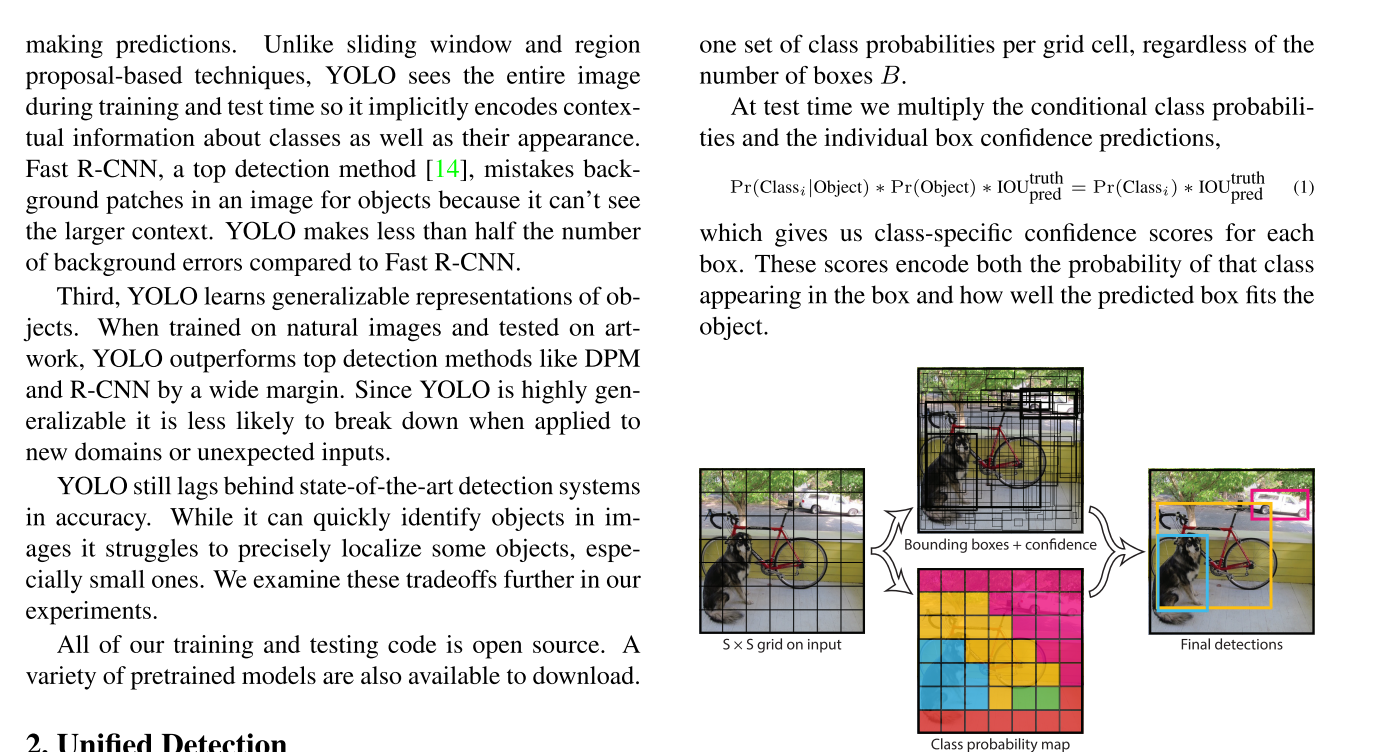

翻译如下:我们提出YOLO,一种全新的目标检测方法。以往的目标检测研究通常将分类器重新用于检测任务;而我们则将目标检测建模为一个回归问题,直接预测空间上相互分离的边界框及其对应的类别概率。单个神经网络仅需一次前向传播,即可从整幅图像中直接输出边界框坐标与类别概率。由于整个检测流程由单一网络构成,因此可直接以检测性能为优化目标,进行端到端训练。

我们的统一架构速度极快。基础版YOLO模型可在实时场景下以每秒45帧的速度处理图像;更轻量的Fast YOLO版本则高达每秒155帧,同时检测精度(mAP)仍为其他实时检测器的两倍。与当前最先进的检测系统相比,YOLO在定位方面误差略多,但在背景区域误报目标的概率更低。最后,YOLO学习到了物体高度通用的表征能力:当从自然图像泛化至艺术画作等其他领域时,其性能明显优于DPM和R-CNN等其他检测方法。

总结一下摘要的核心要点:

-

全新的检测范式:不同于以往将分类器改装为检测器的方法,YOLO 将目标检测重新框架为一个单一的回归问题,直接从图像像素预测边界框位置和类别概率 。

-

端到端优化:由于整个检测流程由一个单一的神经网络完成,因此可以直接针对检测性能进行**端到端(end-to-end)**的优化 。

-

极高的处理速度:标准版 YOLO:能够在 Titan X GPU 上以 45 FPS 的速度实现实时处理 。快速版 (Fast YOLO):处理速度高达 155 FPS,且其 mAP(平均精度)仍是其他实时检测器的两倍 。

-

强大的上下文理解能力:相比于当时的 SOTA 系统(如 Fast R-CNN),YOLO 在背景区域预测假阳性(False Positives)的概率更低,因为它在训练和测试时都能看到整张图片的全局上下文 。

-

卓越的泛化能力:YOLO 学习到了非常通用的目标特征。当从自然图像领域迁移到艺术品等其他领域时,它的表现优于 DPM 和 R-CNN 等传统方法 。

-

存在的局限性:摘要也诚实地指出,相比于当时的顶级检测系统,YOLO 在定位精度上稍弱,尤其是在定位小物体时会面临挑战 。

Introduction

作者首先观察到:人类只需要看一次图像就可以判断出物体在图像中的位置和图像的类别,而当时的SOTA:Fast R-CNN 则是"三部曲":先找可能候选区域(Region Proposals),再运行卷积神经网络分类,最后还要用复杂的后处理来精修框。

结论:这些方法太慢了,且难以优化,因为每个组件都是独立训练的。

总结了之前方法的问题,作者提出了自己的框架:YOLO

YOLO 的全新理念 (The Unified Approach)

作者提出将检测任务看作一个单一的、整体的流程:

-

全局处理:不像 R-CNN 只看候选区域,YOLO 在训练和推理时都是"看整张图"。这让它能利用物体的上下文信息(Contextual Information)。

-

一气呵成:将坐标回归和类别预测集成在一个网络中。这种"统一(Unified)"的设计是 YOLO 速度飞快的根本原因。

YOLO 的三大优势 (Key Advantages)

引言详细列举了 YOLO 的独特长处:

-

快得惊人:因为它不需要复杂的 Pipeline,只要像分类一样跑一遍前向传播就行,非常适合实时视频流。

-

全局推理(Global Reasoning):作者强调,YOLO 的背景识别错误率(背景被误认为物体)比 Fast R-CNN 低了一半以上。因为它知道物体的周围是什么,不会轻易把背景纹理误判成物体。

-

极强的通用性:如果你在自然场景训练它,拿它去检测艺术画(Artworks)中的物体,YOLO 的表现远好于 R-CNN。这说明它抓住了物体的本质特征,而不是记住了特定的像素分布。

权衡与代价 (Trade-offs)

作者也非常客观地承认:虽然 YOLO 很快且全局观强,但在**精确度(Accuracy)**上略逊于当时的顶级系统。

它主要的短板在于定位误差(Localization Errors),尤其是在处理成群出现的微小目标(比如一群鸟)时,网格系统的限制会导致表现不佳。

总结来说: 引言部分确立了 YOLO 的地位------它不是要在精度上完全取代 R-CNN,而是开辟了一条**"实时性"和"全局观"**的新赛道。

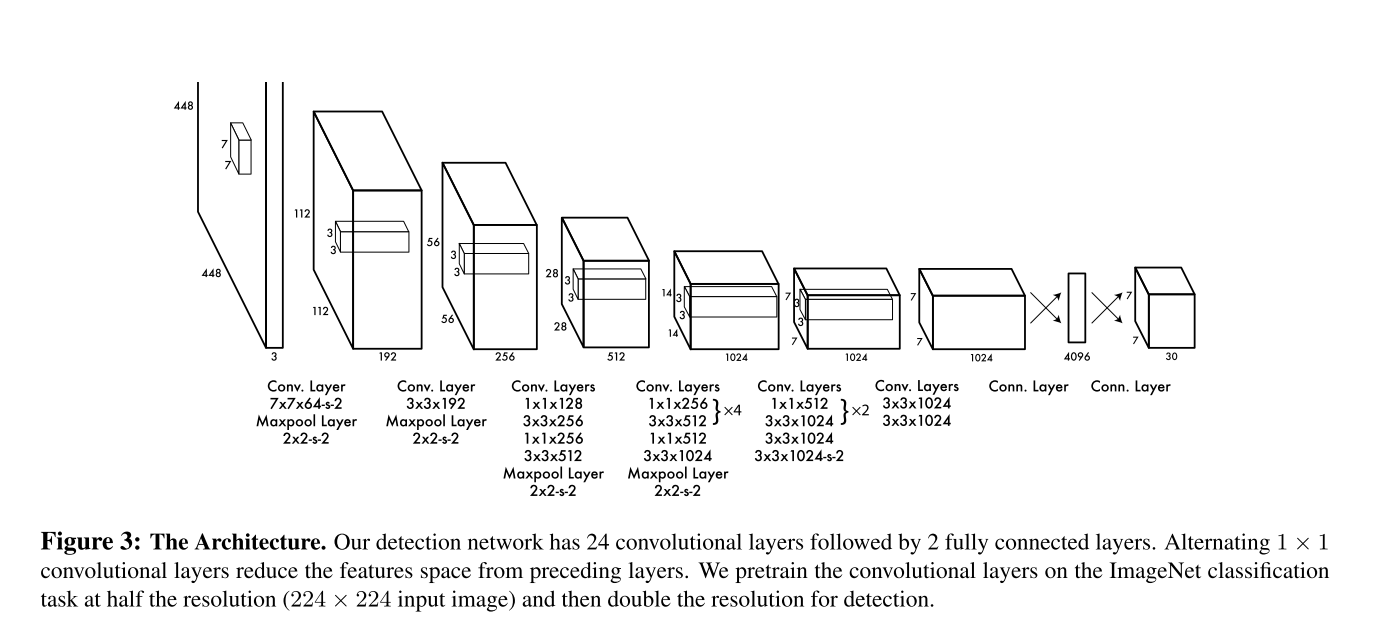

Network Architecture

YOLOv1 的特征提取过程是一个将高分辨率图像逐渐"压缩"并"抽象"为低分辨率、高通道特征图的过程 。这个过程主要由 24 层卷积层完成,其结构灵感来源于 GoogLeNet 。

- 输入阶段:高分辨率感知输入尺寸:网络接收 448 × 448 × 3 448 \times 448 \times 3 448×448×3 的彩色图像 。设计用意:相比传统的分类网络(通常用 224 × 224 224 \times 224 224×224),YOLO 使用更高的分辨率是为了保留更多的细粒度视觉信息,这对于精确预测物体的边界框位置至关重要 。

- 特征提取的核心:卷积与池化特征提取通过一系列重复的模块进行,主要包含以下三种操作:快速降采样(初期):第一层卷积使用了 7 × 7 7 \times 7 7×7 的大卷积核,步长为 2 。配合后续的多个最大池化层(Maxpool Layer,通常为 2 × 2 , s = 2 2 \times 2, s=2 2×2,s=2),图像尺寸从 448 迅速下降到 224, 112, 56, 28, 14,最终变为 7 。 1 × 1 1 \times 1 1×1 卷积的妙用(瓶颈层):网络中大量交替使用了 1 × 1 1 \times 1 1×1 卷积层 。作用:它在不改变特征图尺寸的前提下,压缩通道数(降维),从而减少参数量和计算量,之后再通过 3 × 3 3 \times 3 3×3 卷积提取更高层的空间特征 。这种结构也被称为"串行层"(similar to Lin et al)。深层语义建模:在网络的后半部分( 14 × 14 14 \times 14 14×14 和 7 × 7 7 \times 7 7×7 阶段),网络堆叠了密集的卷积组(如图中的 × 4 \times 4 ×4 和 × 2 \times 2 ×2 模块)。作用:随着感受野的扩大,网络此时提取的不再是简单的线条或边缘,而是全局的上下文信息。正如论文所言,这让 YOLO 能够"全局地思考"图像 。

- 输出端的转化:特征图到预测张量最终特征图:卷积层最后的输出是一个 7 × 7 × 1024 7 \times 7 \times 1024 7×7×1024 的特征图 。展平与全连接:这个高维特征图被输入到两层全连接层(Connected Layer)中 。第一层全连接层将特征转化为 4096 维 。第二层全连接层则完成最后的"回归",将 4096 维向量重新映射为 7 × 7 × 30 7 \times 7 \times 30 7×7×30 的张量 。

Loss Function

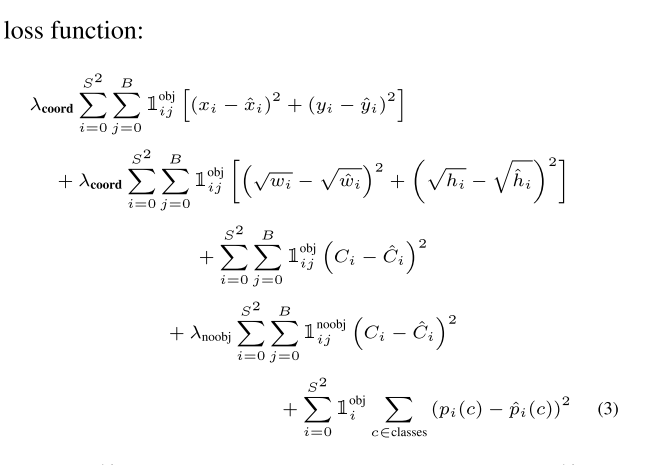

让我们拆解论文第 4 页那个复杂的公式 :

- 坐标预测损失 (Localization Loss)这部分负责让边界框(Bounding Box)更精准 :中心点权重 ( λ c o o r d = 5 \lambda_{coord}=5 λcoord=5):作者发现位置误差比分类误差更严重,因此给坐标预测增加了权重 。宽高的"平方根"处理:公式中预测的是 w \sqrt{w} w 和 h \sqrt{h} h 。这是因为对于大盒子和小盒子,同样的像素偏差影响是不同的。根号的作用是让小框对位置偏差更敏感,从而缓解大框和小框权重一致的问题 。

- 置信度损失 (Confidence Loss)这部分决定了模型认为该区域"有没有物体"以及"预测得准不准" :有物体的网格:预测值与真实 IOU 的差值平方 。无物体的网格 ( λ n o o b j = 0.5 \lambda_{noobj}=0.5 λnoobj=0.5):在图片中,大部分网格是不包含物体的。如果权重一样,不包含物体的梯度会"淹没"包含物体的梯度,导致模型不稳定 。因此,作者调低了无物体背景的损失权重 。

- 分类损失 (Classification Loss)条件概率预测:只有当网格中确实存在物体时(由 1 i o b j \mathbb{1}_{i}^{obj} 1iobj 控制),才会计算分类损失 它计算的是每个类别的概率与真实标签的误差平方和 。

我们可以从以下几个维度来深度拆解这个"类回归"设计的逻辑: - 为什么作者选择了 SSE 而不是更复杂的损失函数?易于优化:作者指出选择 SSE 是因为它易于优化 。在深度学习初期,回归任务使用平方误差是非常自然的选择,其导数计算简单,能让模型快速收敛 。全回归架构:YOLO 的核心理念是"将目标检测重新框架为一个单一的回归问题" 。既然整个网络是一个回归模型,那么损失函数采用回归问题中最经典的平方误差形式,逻辑上是非常自洽的。

- 回归任务中的"权重分配"在线性回归中,我们有时会给不同的特征加权重。YOLO 的损失函数公式 (3) 实际上就是一个加权的 SSE:坐标权重 ( λ c o o r d = 5 \lambda_{coord} = 5 λcoord=5):用来调高坐标预测的重要性 。背景权重 ( λ n o o b j = 0.5 \lambda_{noobj} = 0.5 λnoobj=0.5):用来降低那些不含物体网格的置信度误差贡献 。如果不加这些权重(即所有权重都为 1),模型就会退化成最原始的线性回归组合,从而导致我们之前讨论的"背景噪声淹没目标梯度"的问题 。

- 为了"回归化"而做的参数处理为了让检测任务更像一个 0 0 0 到 1 1 1 之间的回归问题,作者对数据进行了归一化处理:坐标归一化:边界框的 x , y x, y x,y 被参数化为特定网格单元位置的偏移量,范围在 0 0 0 到 1 1 1 之间 。尺寸归一化:边界框的宽度 w w w 和高度 h h h 通过图像的宽和高进行归一化,也落在 0 0 0 到 1 1 1 之间 。平方根技巧:在公式 (3) 中,作者对 w w w 和 h h h 预测的是其平方根 。这是为了弥补 SSE 的一个缺陷------它对大框和小框的微小偏移产生的惩罚是一样的 。通过取平方根,小框的偏差在损失函数中会产生更大的梯度,这使得模型对小物体的定位更加敏感 。

- 论文中提到的局限性尽管作者选择了这种简洁的 SSE 形式,但他们也非常坦诚地提到了它的弊端:目标不完全一致:SSE 虽然好算,但它并不完美契合我们最终追求的 mAP(平均精度) 。分类 vs 定位:它将定位误差和分类误差同等看待,这在实际检测中并不理想 。这也是为什么在后来的 YOLOv2、v3 以及更现代的算法中,损失函数演变得越来越复杂(例如引入了交叉熵处理分类,使用 IoU Loss 处理坐标)。

NMS算法

- 准备工作:置信度筛选在运行 NMS 之前,我们通常会先设定一个置信度阈值 。剔除掉所有置信度得分低于该阈值的预测框,因为它们被认为是噪声 。将剩下的预测框按照置信度分数从高到低进行排序。

- 迭代优选:核心循环假设我们现在有一堆重叠的预测框:选中最强的框:从排序后的列表中取出置信度最高的框(我们称之为 A A A),将其放入"最终保留列表"中。对比与剔除:将 A A A 与列表中剩下的所有其他预测框(设为 B B B)一一计算 IoU(交并比)。判断重叠度:如果 A A A 与 B B B 的 I o U IoU IoU 超过了预设的 NMS 阈值(通常设为 0.5),则认为 B B B 预测的是同一个物体,且表现不如 A A A。此时,将 B B B 从列表中彻底删除。重复循环:对剩下的框继续重复上述过程,直到待处理列表为空。

- 在 YOLOv1 中的特殊性论文在第 4 页提到了一些关于 NMS 的有趣观点:空间多样性:YOLO 的网格设计本身就强制了预测框的空间多样性,通常一个物体只会落入一个网格,因此很多时候网络只会预测出一个框 。多网格响应:但有些大物体或靠近网格边界的物体,可能会被多个网格同时高分预测 。性能提升:虽然 NMS 对 YOLO 来说不像对 R-CNN 那样生死攸关,但使用 NMS 仍能为 YOLO 带来 2-3% 的 mAP 提升 。

- 总结NMS 就是一个"霸道总裁"算法:它只允许在特定区域内存在一个最强的声音,把周围所有和它长得像(IoU 大)但没它强(得分低)的竞争者全部"噤声"。

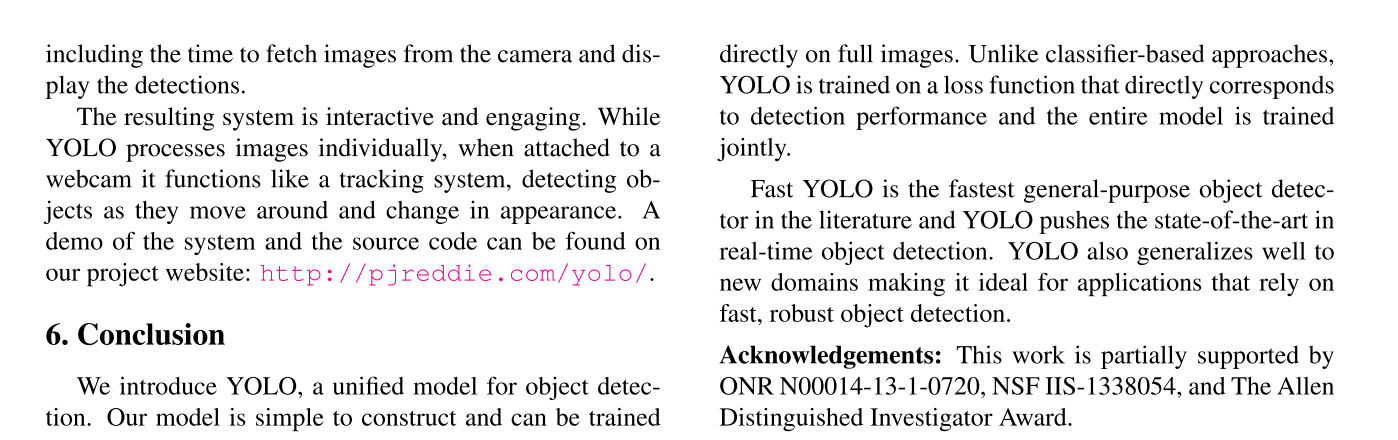

Conclution

提出YOLO:一种端到端的统一目标检测模型

模型结构简洁,可直接在整张图像上训练

采用面向检测性能的联合损失函数,全网络联合训练(区别于分类器级联方法)

Fast YOLO是当时文献中最快的通用目标检测器

YOLO刷新了实时目标检测的性能上限

泛化能力强,适用于新领域

适合对速度与鲁棒性要求高的实际应用