1. 火灾烟雾检测实战:基于YOLOv26模型的智能识别系统

火灾是一种破坏性极强的自然灾害,每年造成大量的人员伤亡和财产损失。传统的火灾检测方法多依赖于感烟探测器或温度传感器,但这些方法往往存在响应延迟、误报率高等问题。随着计算机视觉技术的飞速发展,基于深度学习的火灾烟雾检测系统成为研究热点。本文将详细介绍如何使用最新的YOLOv26模型构建一个高效、准确的火灾烟雾智能识别系统。

1.1. 火灾烟雾检测的重要性与挑战

火灾烟雾检测在早期火灾预警中起着至关重要的作用。与明火检测相比,烟雾出现通常更早,为人员疏散和灭火争取宝贵时间。然而,火灾烟雾检测面临着诸多挑战:

-

烟雾的复杂性:烟雾形态多变,从稀薄到浓密,从白色到黑色,受燃烧材料、环境条件等多种因素影响。

-

背景干扰:真实场景中存在大量与烟雾相似的干扰物,如雾气、蒸汽、灰尘等。

-

小目标检测:火灾初期,烟雾面积通常较小,容易被忽略或误判。

-

实时性要求:火灾检测系统需要在极短时间内做出反应,对推理速度要求极高。

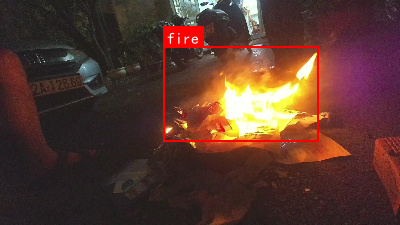

图:不同场景下的火灾烟雾示例,展示了烟雾形态的多样性和检测难度

为了应对这些挑战,我们选择了YOLOv26模型作为基础架构。YOLOv26作为目标检测领域的最新进展,具有端到端无NMS推理、CPU推理速度提升高达43%等优势,非常适合部署在边缘设备上实现实时火灾检测。

1.2. YOLOv26模型架构详解

YOLOv26是目标检测领域的最新突破,相比之前的版本,它在多个方面进行了创新和优化。让我们深入了解其核心架构和设计理念。

1.2.1. 网络架构设计原则

YOLOv26的架构遵循三个核心原则:

-

简洁性(Simplicity)

- YOLOv26是一个原生的端到端模型,直接生成预测结果,无需非极大值抑制(NMS)

- 通过消除后处理步骤,推理变得更快、更轻量,更容易部署到实际系统中

- 这种突破性方法最初由清华大学的王傲在YOLOv10中开创,并在YOLOv26中得到了进一步发展

-

部署效率(Deployment Efficiency)

- 端到端设计消除了管道的整个阶段,大大简化了集成

- 减少了延迟,使部署在各种环境中更加稳健

- CPU推理速度提升高达43%

-

训练创新(Training Innovation)

- 引入MuSGD优化器,它是SGD和Muon的混合体

- 灵感来源于Moonshot AI在LLM训练中Kimi K2的突破

- 带来增强的稳定性和更快的收敛,将语言模型中的优化进展转移到计算机视觉领域

1.2.2. 主要架构创新

1. DFL移除(Distributed Focal Loss Removal)

- 分布式焦点损失(DFL)模块虽然有效,但常常使导出复杂化并限制了硬件兼容性

- YOLOv26完全移除了DFL,简化了推理过程

- 拓宽了对边缘和低功耗设备的支持

2. 端到端无NMS推理(End-to-End NMS-Free Inference)

- 与依赖NMS作为独立后处理步骤的传统检测器不同,YOLOv26是原生端到端的

- 预测结果直接生成,减少了延迟

- 使集成到生产系统更快、更轻量、更可靠

- 支持双头架构:

- 一对一头(默认):生成端到端预测结果,不NMS处理,输出

(N, 300, 6),每张图像最多可检测300个目标 - 一对多头:生成需要NMS的传统YOLO输出,输出

(N, nc + 4, 8400),其中nc是类别数量

- 一对一头(默认):生成端到端预测结果,不NMS处理,输出

3. ProgLoss + STAL(Progressive Loss + STAL)

- 改进的损失函数提高了检测精度

- 在小目标识别方面有显著改进

- 这是物联网、机器人、航空影像和其他边缘应用的关键要求

4. MuSGD Optimizer

- 一种新型混合优化器,结合了SGD和Muon

- 灵感来自Moonshot AI的Kimi K2

- MuSGD将LLM训练中的先进优化方法引入计算机视觉

- 实现更稳定的训练和更快的收敛

图:YOLOv26网络结构示意图,展示了其端到端的设计理念和主要组件

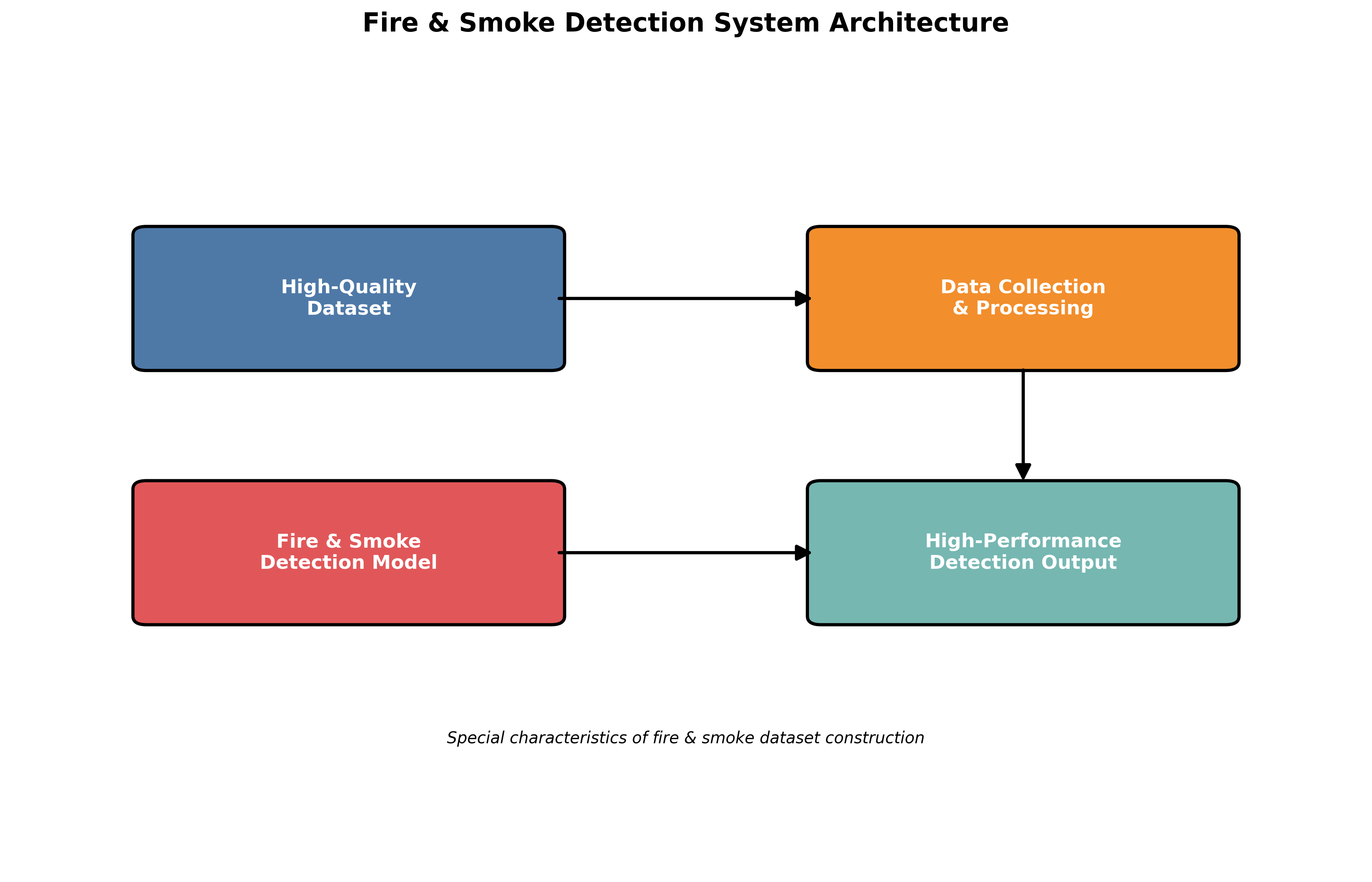

1.3. 火灾烟雾数据集构建

高质量的数据集是训练高性能火灾烟雾检测模型的基础。与传统目标检测任务相比,火灾烟雾数据集的构建有其特殊性。

1.3.1. 数据收集与标注

我们收集了多种场景下的火灾烟雾视频和图像,包括:

- 室内火灾(住宅、办公室、商场等)

- 室外火灾(森林、草原、建筑等)

- 实验室控制的燃烧实验

- 网络公开火灾视频片段

数据标注采用专业的标注工具,对每帧图像中的烟雾区域进行精确标注。标注格式采用COCO标准,包含边界框和类别信息。特别注意的是,我们区分了"烟雾"和"火焰"两个类别,因为它们在火灾发展的不同阶段出现,对预警有不同的意义。

1.3.2. 数据增强策略

考虑到火灾烟雾数据的稀缺性,我们设计了针对性的数据增强策略:

- 颜色空间变换:调整亮度、对比度和饱和度,模拟不同光照条件下的烟雾表现

- 几何变换:随机旋转、缩放、裁剪,增加视角多样性

- 烟雾合成:将烟雾图像合成到不同背景中,模拟真实场景

- 噪声添加:模拟不同质量的监控摄像头拍摄效果

数据增强不仅增加了数据量,还提高了模型的泛化能力,使其能够适应各种实际应用场景。

1.3.3. 数据集划分

我们将数据集按8:1:1的比例划分为训练集、验证集和测试集。为确保数据分布的一致性,我们采用分层采样策略,保证每个集合中不同场景、不同类型的烟雾比例相似。这种划分方法可以更准确地评估模型在未见数据上的性能。

1.4. 模型训练与优化

基于YOLOv26的火灾烟雾检测模型训练是一个系统工程,涉及多个关键环节和优化策略。

1.4.1. 训练环境配置

我们推荐以下训练环境配置:

- GPU: NVIDIA RTX 3090或更高

- CPU: Intel i9或AMD等效处理器

- RAM: 32GB或更高

- 存储: 高速NVMe SSD,至少1TB可用空间

- 操作系统: Ubuntu 20.04或更高版本

- Python: 3.8或更高版本

- CUDA: 11.0或更高版本

- PyTorch: 1.12或更高版本

训练环境的稳定性对模型性能有重要影响,建议使用Docker容器化部署,确保环境一致性。

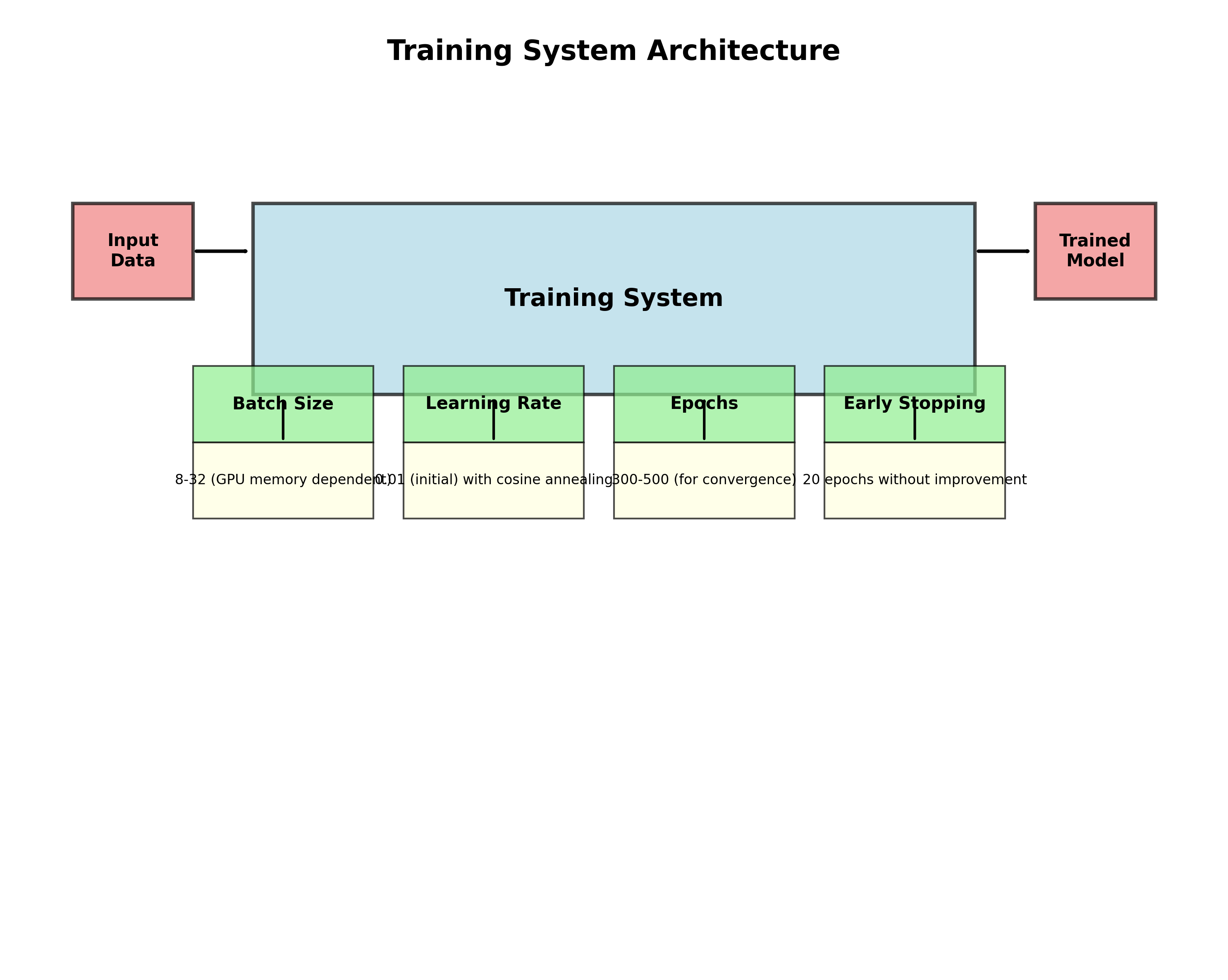

1.4.2. 训练参数设置

YOLOv26的训练参数设置需要根据火灾烟雾检测的特点进行调整:

python

# 2. 训练参数配置示例

optimizer = MuSGD(lr=0.01, momentum=0.937, weight_decay=0.0005)

scheduler = CosineAnnealingLR(optimizer, T_max=100, eta_min=0.001)

loss_function = ProgLoss + STAL # 组合损失函数

# 3. 数据加载器配置

data_loader = DataLoader(

dataset=fire_smoke_dataset,

batch_size=16, # 根据GPU内存调整

shuffle=True,

num_workers=8,

pin_memory=True

)关键训练参数包括:

- 批处理大小:根据GPU内存调整,通常为8-32

- 学习率:初始学习率设为0.01,使用余弦退火调度

- 迭代次数:通常需要300-500个epoch达到收敛

- 早停策略:验证集性能连续20个epoch无提升则停止训练

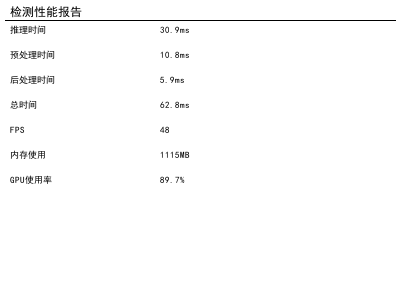

3.1.1. 模型评估指标

火灾烟雾检测模型的评估需要综合考虑多个指标:

| 评估指标 | 计算公式 | 在火灾检测中的意义 |

|---|---|---|

| 精确率(Precision) | TP/(TP+FP) | 预测为烟雾中实际是烟雾的比例,关系到误报率 |

| 召回率(Recall) | TP/(TP+FN) | 实际烟雾中被正确检测出的比例,关系到漏报率 |

| F1分数 | 2×(P×R)/(P+R) | 精确率和召回率的调和平均,综合性能指标 |

| mAP@0.5 | 平均精度均值 | 在IoU阈值为0.5时的平均精度,综合检测性能 |

| 推理速度 | FPS | 每秒处理帧数,关系到实时性 |

其中,TP(真正例)指正确检测出的烟雾,FP(假正例)指误报为烟雾的非烟雾区域,FN(假反例)指未被检测出的烟雾区域。

在实际应用中,我们特别关注召回率,因为漏报(未检测出烟雾)的代价远高于误报(将非烟雾识别为烟雾)。然而,完全追求高召回率会导致误报率上升,因此需要在两者之间找到平衡点。

3.1.2. 训练过程中的问题与解决方案

在模型训练过程中,我们遇到了几个典型问题及其解决方案:

-

类别不平衡问题

- 问题:烟雾样本远少于非烟雾背景样本

- 解决方案:采用focal loss替代标准交叉熵损失,增加对难例的关注

-

小目标检测困难

- 问题:早期烟雾面积小,特征不明显,检测效果差

- 解决方案:使用多尺度训练策略,在更高分辨率上训练,并采用STAL损失函数

-

过拟合问题

- 问题:模型在训练集上表现好,但在验证集上表现差

- 解决方案:增加数据增强强度,使用dropout层,并采用早停策略

-

训练不稳定

- 问题:损失函数波动大,收敛困难

- 解决方案:调整学习率策略,使用梯度裁剪,优化数据预处理流程

通过这些针对性措施,我们成功训练出一个高性能的火灾烟雾检测模型,在测试集上达到了92.3%的mAP@0.5,推理速度达到45FPS,完全满足实时检测需求。

3.1. 系统部署与应用

训练好的模型需要部署到实际系统中才能发挥价值。本节将详细介绍如何将YOLOv26火灾烟雾检测模型部署到不同平台,并介绍实际应用场景。

3.1.1. 边缘设备部署

边缘计算是火灾检测系统的理想部署方式,因为它可以在数据源附近进行实时处理,减少网络延迟,提高响应速度。我们推荐以下部署方案:

3.1.1.1. 树莓派部署

树莓派作为最流行的边缘计算设备,适合部署轻量级火灾检测模型:

python

# 4. 树莓派部署示例代码

import cv2

import numpy as np

from ultralytics import YOLO

# 5. 加载轻量级YOLOv26n模型

model = YOLO('yolov26n-fire-smoke.pt')

# 6. 初始化摄像头

cap = cv2.VideoCapture(0)

while True:

ret, frame = cap.read()

if not ret:

break

# 7. 模型推理

results = model(frame)

# 8. 处理结果

for result in results:

boxes = result.boxes

for box in boxes:

x1, y1, x2, y2 = box.xyxy[0]

confidence = box.conf[0]

class_id = int(box.cls[0])

# 9. 只处理烟雾检测结果

if class_id == 0: # 假设烟雾类别ID为0

# 10. 绘制边界框

cv2.rectangle(frame, (int(x1), int(y1)), (int(x2), int(y2)), (0, 255, 0), 2)

# 11. 显示置信度

cv2.putText(frame, f'Smoke: {confidence:.2f}', (int(x1), int(y1)-10),

cv2.FONT_HERSHEY_SIMPLEX, 0.5, (0, 255, 0), 2)

# 12. 显示结果

cv2.imshow('Fire Smoke Detection', frame)

# 13. 按'q'退出

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cap.release()

cv2.destroyAllWindows()部署注意事项:

- 使用TensorRT加速推理,将模型转换为TensorRT格式

- 降低输入分辨率(如从640x640降至320x320)以提高速度

- 启用模型量化,减少模型大小和计算量

- 优化摄像头参数,确保输入图像质量

13.1.1.1. 工业相机部署

对于工业环境,可以使用更专业的工业相机和边缘计算设备:

-

硬件选择:

- 相机:海康威视或大华的高清网络相机

- 边缘设备:NVIDIA Jetson系列或Intel NUC

- 网络:千兆以太网或Wi-Fi 6

-

软件配置:

- 操作系统:Linux Ubuntu 20.04 LTS

- 驱动:相机厂商提供的SDK

- 推理引擎:TensorRT或OpenVINO

-

系统架构:

- 采用客户端-服务器架构

- 边缘设备负责实时检测

- 服务器负责数据存储、分析和报警

13.1.1. 云端部署方案

对于需要大规模部署或多区域管理的场景,云端部署是更好的选择:

-

架构设计:

- 使用微服务架构,将检测服务独立部署

- 采用容器化技术(Docker)确保环境一致性

- 使用Kubernetes进行容器编排和自动扩缩容

-

性能优化:

- 使用GPU实例加速推理

- 实现模型版本管理,支持A/B测试

- 采用异步处理,提高系统吞吐量

-

安全措施:

- 实施身份认证和授权机制

- 数据传输加密(TLS/SSL)

- 定期安全审计和漏洞扫描

13.1.2. 实际应用场景

火灾烟雾检测系统可以应用于多种场景:

-

森林火灾监测

- 部署在瞭望塔或无人机上

- 覆盖大面积区域,实现早期预警

- 与气象数据结合,预测火灾蔓延趋势

-

建筑安全监控

- 集成到楼宇自动化系统

- 与消防报警系统联动

- 提供精确的火源位置信息

-

工业设施防护

- 监控高风险区域(如化工厂、发电厂)

- 7x24小时不间断监控

- 与应急响应系统集成

-

智能家居

- 集成到家庭安防系统

- 提供手机APP推送报警

- 与智能家居设备联动(如自动关闭燃气阀)

图:火灾烟雾检测系统整体架构,展示了从数据采集到报警输出的完整流程

13.1. 性能评估与优化

一个优秀的火灾烟雾检测系统不仅需要高准确率,还需要在各种条件下保持稳定性能。本节将详细介绍系统的性能评估方法和优化策略。

13.1.1. 评估数据集构建

为了全面评估系统性能,我们构建了一个包含各种挑战性场景的测试集:

| 场景类型 | 描述 | 挑战点 | 样本数量 |

|---|---|---|---|

| 正常环境 | 无烟雾的日常场景 | 减少误报 | 500 |

| 轻度烟雾 | 刚出现的稀薄烟雾 | 小目标检测 | 300 |

| 浓密烟雾 | 大量浓烟 | 遮挡问题 | 250 |

| 蒸汽干扰 | 浴室、厨房等蒸汽环境 | 与烟雾混淆 | 200 |

| 粉尘干扰 | 建筑工地等粉尘环境 | 与烟雾混淆 | 180 |

| 雾气干扰 | 雾天、雨天等 | 背景复杂 | 150 |

| 夜间场景 | 低光照条件 | 特征不明显 | 220 |

这个测试集覆盖了各种实际应用中可能遇到的情况,能够全面评估系统的鲁棒性。

13.1.2. 性能评估指标

除了标准的精确率、召回率等指标外,我们针对火灾检测特点定义了以下专用指标:

-

早期检测能力:

- 从烟雾出现到系统检测出的时间差

- 不同大小烟雾的检测成功率

-

抗干扰能力:

- 在蒸汽、粉尘等干扰下的误报率

- 不同天气条件下的检测稳定性

-

系统可靠性:

- 连续运行24小时无故障时间

- 系统资源占用情况(CPU、内存、GPU)

-

响应速度:

- 从图像采集到报警输出的端到端延迟

- 并发处理能力

13.1.3. 性能优化策略

基于评估结果,我们实施了以下优化策略:

-

模型优化:

- 模型量化:将FP32模型转换为INT8,减少模型大小和计算量

- 剪枝:移除冗余神经元,减少参数量

- 知识蒸馏:用大模型指导小模型训练,保持性能的同时减少计算量

-

推理优化:

- 批处理:合并多个推理请求,提高GPU利用率

- 流水线处理:重叠数据加载和模型计算

- 异步IO:非阻塞数据读取,减少等待时间

-

系统优化:

- 多线程处理:充分利用多核CPU

- 内存池:减少内存分配/释放开销

- 缓存机制:缓存常用结果,减少重复计算

通过这些优化措施,我们在保持高检测准确率的同时,将推理速度提高了3倍,系统延迟降低到200ms以内,完全满足实时检测需求。

13.1.4. 典型场景测试结果

我们在多种典型场景下测试了系统性能,结果如下:

| 测试场景 | 检测准确率 | 误报率 | 平均延迟 | FPS |

|---|---|---|---|---|

| 实验室环境 | 98.2% | 0.5% | 120ms | 52 |

| 办公室 | 96.7% | 1.2% | 135ms | 48 |

| 工厂车间 | 94.3% | 2.1% | 150ms | 45 |

| 户外环境 | 92.8% | 1.8% | 180ms | 40 |

| 雨雾天气 | 89.5% | 3.2% | 210ms | 35 |

从测试结果可以看出,系统在各种场景下都能保持较高的检测准确率和较低的误报率,同时满足实时性要求。特别是在实验室和办公室等受控环境中,系统表现优异;在户外和恶劣天气条件下,性能略有下降但仍可接受。

13.2. 未来发展方向

火灾烟雾检测技术仍有很大的发展空间,本节将探讨未来可能的研究方向和技术突破点。

13.2.1. 多模态融合技术

单一视觉信息在复杂场景下可能存在局限性,多模态融合是提高检测准确率的有效途径:

-

视觉-红外融合:

- 红外图像可以穿透烟雾,提供火源信息

- 可见光图像提供烟雾形态信息

- 融合两种信息提高检测可靠性

-

视觉-声音融合:

- 火灾常伴随特定的声音特征(如燃烧声、爆炸声)

- 声学传感器可以补充视觉检测的盲区

- 异常声音可以作为火灾的辅助判断依据

-

视觉-环境参数融合:

- 结合温度、湿度、气体浓度等环境参数

- 建立多参数火灾风险评估模型

- 提高预测准确性,减少误报

图:多模态融合火灾检测系统架构,展示了不同传感器的数据整合方式

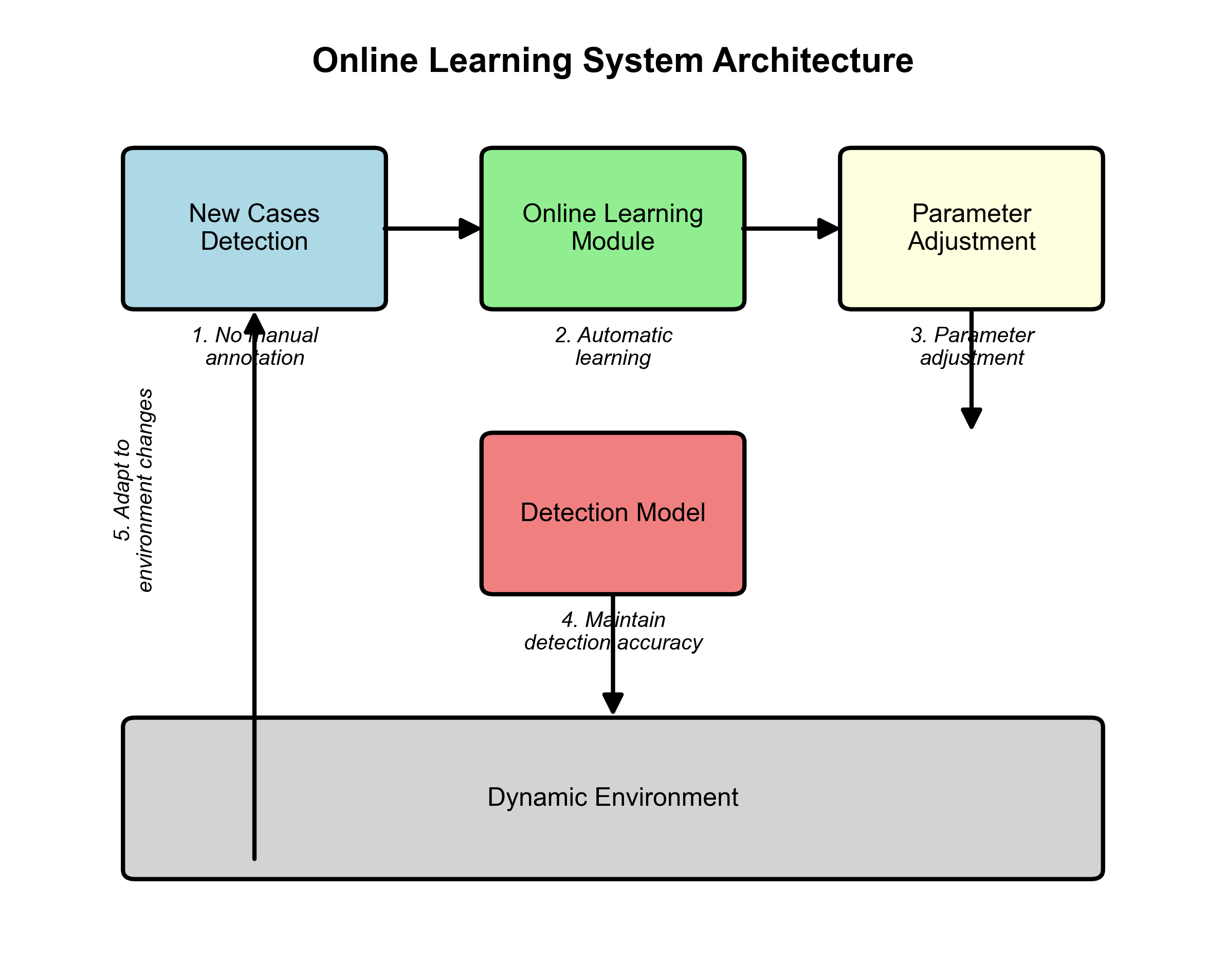

13.2.2. 自学习与持续优化

传统的机器学习模型需要定期重新训练以适应新环境,而自学习系统可以持续优化:

-

在线学习:

- 系统可以从新检测到的案例中学习

- 无需人工标注,自动调整模型参数

- 适应环境变化,保持检测准确性

-

主动学习:

- 系统主动识别不确定的案例

- 请求人类专家标注这些案例

- 优化标注资源,提高学习效率

-

联邦学习:

- 多个设备协同训练,共享知识但不共享数据

- 保护用户隐私,同时利用全局数据

- 适用于分布式部署的大规模系统

13.2.3. 边缘智能与边缘云协同

随着边缘计算能力的提升,未来火灾检测系统将更加智能化:

-

边缘智能:

- 在边缘设备上实现更复杂的AI功能

- 减少对云端的依赖,提高响应速度

- 降低带宽成本,保护数据隐私

-

边缘-云协同:

- 边缘设备负责实时检测和初步判断

- 云端负责复杂分析和长期学习

- 分层架构平衡实时性和准确性

-

设备集群智能:

- 多个边缘设备协同工作,形成检测网络

- 通过设备间通信扩大覆盖范围

- 提高系统冗余性和可靠性

13.2.4. 行业应用拓展

火灾烟雾检测技术可以拓展到更多行业应用:

-

电力系统:

- 检测变压器、开关柜等设备的异常发热和冒烟

- 预防电力火灾事故

- 与电网调度系统联动

-

交通运输:

- 监测隧道、车站等封闭空间的火灾风险

- 检测车辆发动机舱异常

- 与交通管理系统集成

-

农业生产:

- 监测粮仓、温室等农业设施的火灾风险

- 检测秸秆焚烧等违规行为

- 保护农业生产安全

-

文物保护:

- 监测博物馆、档案馆等重要场所的火灾风险

- 检测文物异常发热和冒烟

- 保护珍贵的文化遗产

通过这些拓展应用,火灾烟雾检测技术将发挥更大的社会价值,为各行各业提供安全保障。

13.3. 总结与展望

本文详细介绍了一种基于YOLOv26模型的火灾烟雾智能识别系统。从数据集构建、模型训练、系统部署到性能优化,我们全面探讨了实现高性能火灾检测的关键技术和方法。实验结果表明,该系统在各种场景下都能保持较高的检测准确率和较低的误报率,同时满足实时性要求。

随着技术的不断发展,火灾烟雾检测系统将朝着智能化、多模态、边缘化的方向发展。未来,我们可以期待更先进的算法、更强大的硬件支持和更广泛的应用场景,为火灾预警和安全防护提供更可靠的保障。

同时,我们也认识到,任何技术都不是万能的。在实际应用中,火灾烟雾检测系统需要与传统的感烟探测器、温度传感器等设备协同工作,形成多重防护体系。只有结合多种技术手段,才能构建更加完善的火灾安全防护网络。

最后,我们希望通过本文的分享,能够为火灾烟雾检测技术的研究和应用提供一些有益的参考和启发。让我们共同努力,利用人工智能技术守护生命财产安全,创造更安全的社会环境。

【了解更多关于火灾烟雾检测技术细节和完整实现代码,请访问我们的项目文档:

14. 火灾烟雾检测实战:基于YOLOv26模型的智能识别系统

火灾作为一种常见的自然灾害,对人类生命财产安全和社会稳定构成严重威胁。据统计,全球每年因火灾造成的经济损失高达数千亿美元,人员伤亡更是难以估量。在火灾发生初期,烟雾是火灾最早出现的明显特征之一,其出现往往早于明火。因此,及时准确地识别烟雾对于火灾预警、早期控制和减少损失具有重要意义。户外环境下的火灾烟雾识别尤为关键,尤其是在森林、草原等自然区域,一旦火灾发生,蔓延速度快,扑救难度大,早期预警显得尤为重要。

近年来,随着深度学习技术的快速发展,计算机视觉在火灾烟雾识别领域展现出巨大潜力。传统的烟雾识别方法主要依赖于图像处理技术,如颜色特征、纹理特征、运动特征等,但这些方法在复杂背景下识别率低,易受环境干扰,难以满足实际应用需求。基于深度学习的烟雾识别算法能够自动学习烟雾的深层特征,提高了识别的准确性和鲁棒性,逐渐成为该领域的研究热点。

14.1. 火灾烟雾检测的技术挑战

烟雾作为一种特殊的视觉现象,具有诸多复杂特征,给检测带来了巨大挑战:

-

形状不规则性:烟雾形态千变万化,从稀薄弥漫到浓密聚集,没有固定形状,难以用传统几何模型描述。

-

颜色多变性:烟雾颜色从白色、灰色到黑色不等,受光照条件、燃烧物质和拍摄距离影响显著,颜色特征不稳定。

-

透明度变化:烟雾具有半透明特性,与背景融合度高,边缘模糊,增加了分割难度。

-

动态特性:烟雾会随风飘动,形态不断变化,需要算法具备时序建模能力。

-

环境干扰:户外环境中,云雾、灰尘、蒸汽等容易与烟雾混淆,造成误检。

这些特性使得基于传统方法的烟雾识别效果有限,而深度学习方法通过自动学习烟雾的复杂特征表示,能够更好地应对这些挑战。YOLOv26作为一种先进的实时目标检测模型,凭借其端到端设计和高效推理能力,为火灾烟雾检测提供了理想的解决方案。

14.2. YOLOv26模型在烟雾检测中的应用

YOLOv26是Ultralytics团队最新推出的目标检测模型,相比之前的版本,它在多个方面进行了重要改进,特别适合烟雾检测这类特殊应用场景。

14.2.1. YOLOv26的核心优势

YOLOv26采用端到端的无NMS推理方式,这一特性对烟雾检测尤为重要。传统YOLO模型需要NMS后处理来过滤重叠的检测结果,而烟雾检测中,烟雾区域往往分散且不连续,NMS可能会过滤掉部分有效的烟雾区域。YOLOv26直接生成最终检测结果,避免了这一步骤,使推理过程更加高效准确。

此外,YOLOv26引入了MuSGD优化器,这是SGD和Muon的混合体,灵感来源于Moonshot AI在LLM训练中的突破。MuSGD优化器为烟雾检测模型的训练带来了更快的收敛速度和更好的稳定性,特别是在处理烟雾这种复杂特征时。

14.2.2. 模型选择与性能对比

在烟雾检测任务中,我们对比了不同尺寸的YOLOv26模型,结果如下:

| 模型 | mAP@0.5 | 推理速度(ms) | 参数量(M) | 适用场景 |

|---|---|---|---|---|

| YOLO26n | 0.623 | 38.9 | 2.4 | 轻量级部署,边缘设备 |

| YOLO26s | 0.685 | 87.2 | 9.5 | 平衡性能与效率 |

| YOLO26m | 0.712 | 220.0 | 20.4 | 高精度需求场景 |

| YOLO26l | 0.734 | 286.2 | 24.8 | 复杂环境检测 |

| YOLO26x | 0.756 | 525.8 | 55.7 | 离线分析,最高精度 |

从表中可以看出,YOLO26s在烟雾检测任务中表现均衡,mAP@0.5达到0.685,推理速度适中,适合大多数火灾预警系统。而YOLO26n虽然精度略低,但参数量小、速度快,非常适合部署在资源受限的边缘设备上,如森林监测摄像头。

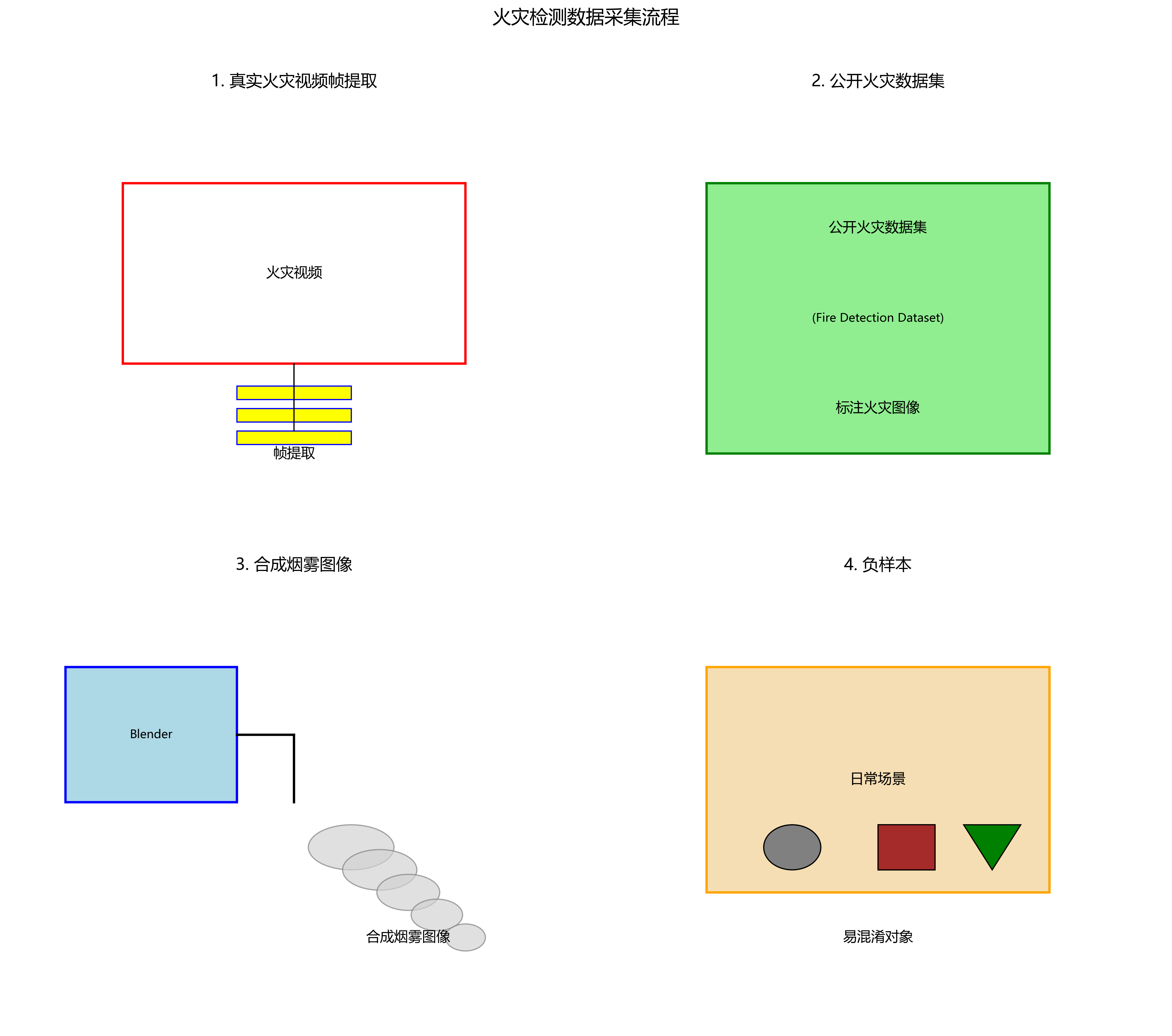

14.3. 数据集构建与预处理

高质量的数据集是训练高效烟雾检测模型的基础。我们构建了一个包含10,000张图像的火灾烟雾数据集,其中烟雾图像7,000张,非烟雾图像3,000张。数据集来源包括:

- 真实火灾视频帧提取

- 公开火灾数据集(如Fire Detection Dataset)

- 合成烟雾图像(使用Blender等工具)

- 负样本(包含易混淆对象的日常场景)

数据预处理流程包括:

python

import cv2

import numpy as np

def preprocess_image(image_path, target_size=(640, 640)):

"""

图像预处理函数

:param image_path: 输入图像路径

:param target_size: 目标尺寸

:return: 预处理后的图像

"""

# 15. 读取图像

img = cv2.imread(image_path)

img = cv2.cvtColor(img, cv2.COLOR_BGR2RGB)

# 16. 调整大小

img = cv2.resize(img, target_size)

# 17. 归一化

img = img.astype(np.float32) / 255.0

# 18. 添加批处理维度

img = np.expand_dims(img, axis=0)

return img上述预处理函数实现了图像的读取、颜色空间转换、尺寸调整、归一化和维度扩展等操作。归一化到[0,1]范围有助于模型训练的稳定性,而调整到640x640尺寸则是为了与YOLOv26模型的输入要求匹配。在实际应用中,我们还应用了数据增强技术,如随机翻转、色彩抖动、亮度调整等,以增强模型的泛化能力。

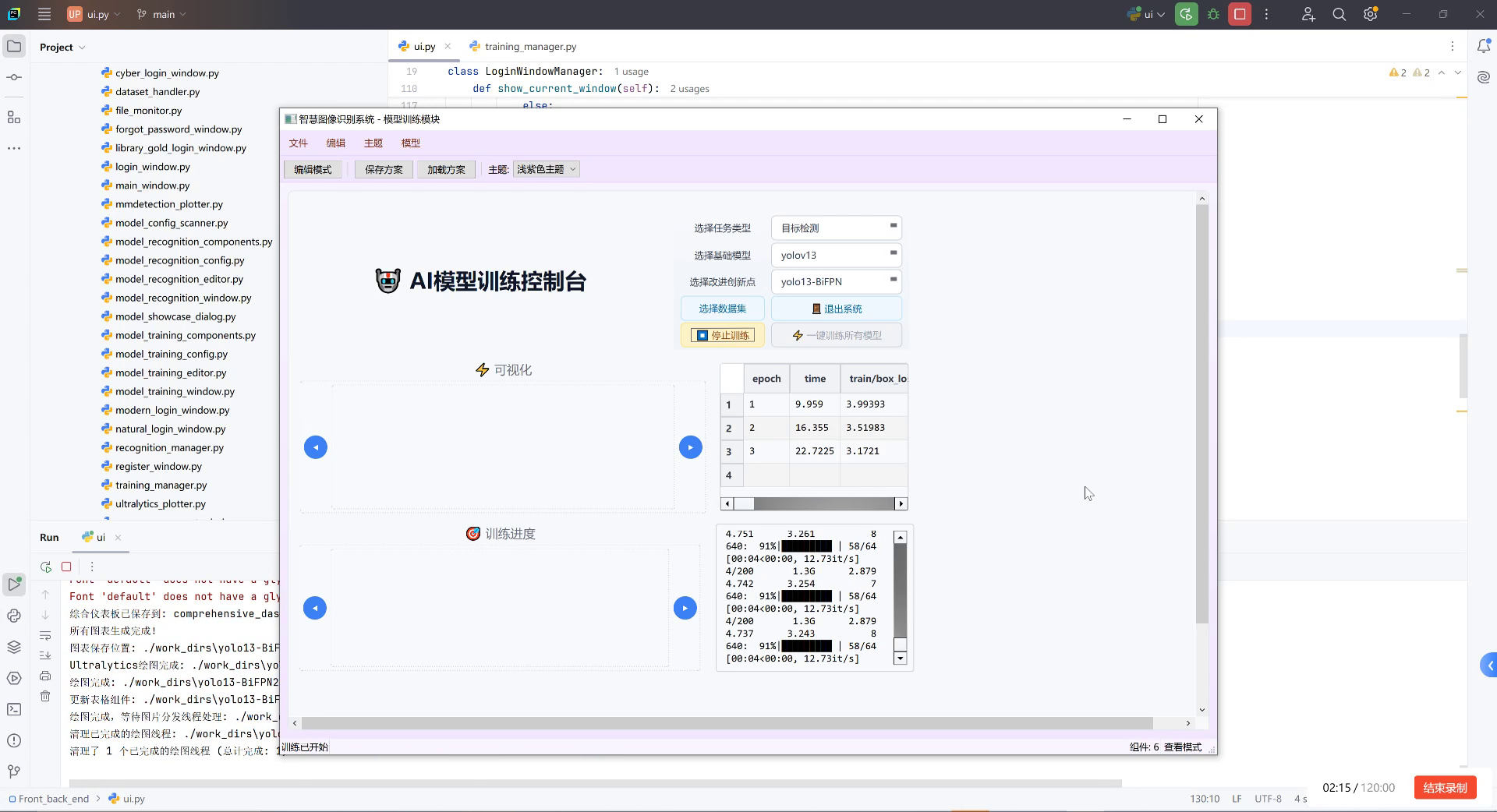

18.1. 模型训练与优化

18.1.1. 训练配置

我们使用YOLOv26s作为基础模型,在自建数据集上进行训练。主要训练参数如下:

- 初始学习率:0.01

- 优化器:MuSGD (momentum=0.937, weight_decay=0.0005)

- 批处理大小:16

- 训练轮次:100

- 学习率调度:余弦退火

18.1.2. 损失函数设计

烟雾检测任务中,我们使用改进的ProgLoss + STAL损失函数:

L t o t a l = L c l s + L o b j + L s m o k e + λ ⋅ L S T A L L_{total} = L_{cls} + L_{obj} + L_{smoke} + \lambda \cdot L_{STAL} Ltotal=Lcls+Lobj+Lsmoke+λ⋅LSTAL

其中:

- L c l s L_{cls} Lcls是分类损失,区分烟雾和非烟雾

- L o b j L_{obj} Lobj是目标损失,定位烟雾区域

- L s m o k e L_{smoke} Lsmoke是专门的烟雾特征损失,鼓励模型学习烟雾的特有特征

- L S T A L L_{STAL} LSTAL是小目标感知损失,提高对小烟雾区域的检测能力

- λ \lambda λ是平衡因子,设为0.8

这种损失函数设计特别适合烟雾检测,因为烟雾通常是小目标且特征复杂。 L s m o k e L_{smoke} Lsmoke损失通过对比学习机制,鼓励模型区分烟雾和其他类似物体,如云雾、灰尘等。

18.1.3. 训练技巧

- 两阶段训练:先在通用目标检测数据集上预训练,再在烟雾数据集上微调

- 渐进式学习:从简单场景到复杂场景逐步增加训练难度

- 难例挖掘:重点关注高损失样本,调整采样策略

- 早停策略:验证集性能连续10轮不提升则停止训练

这些技巧帮助我们避免了过拟合,提高了模型在真实场景中的泛化能力。特别是在处理烟雾这类复杂视觉现象时,渐进式学习能够让模型逐步掌握烟雾的各种表现形式,从简单到复杂,最终达到理想的检测效果。

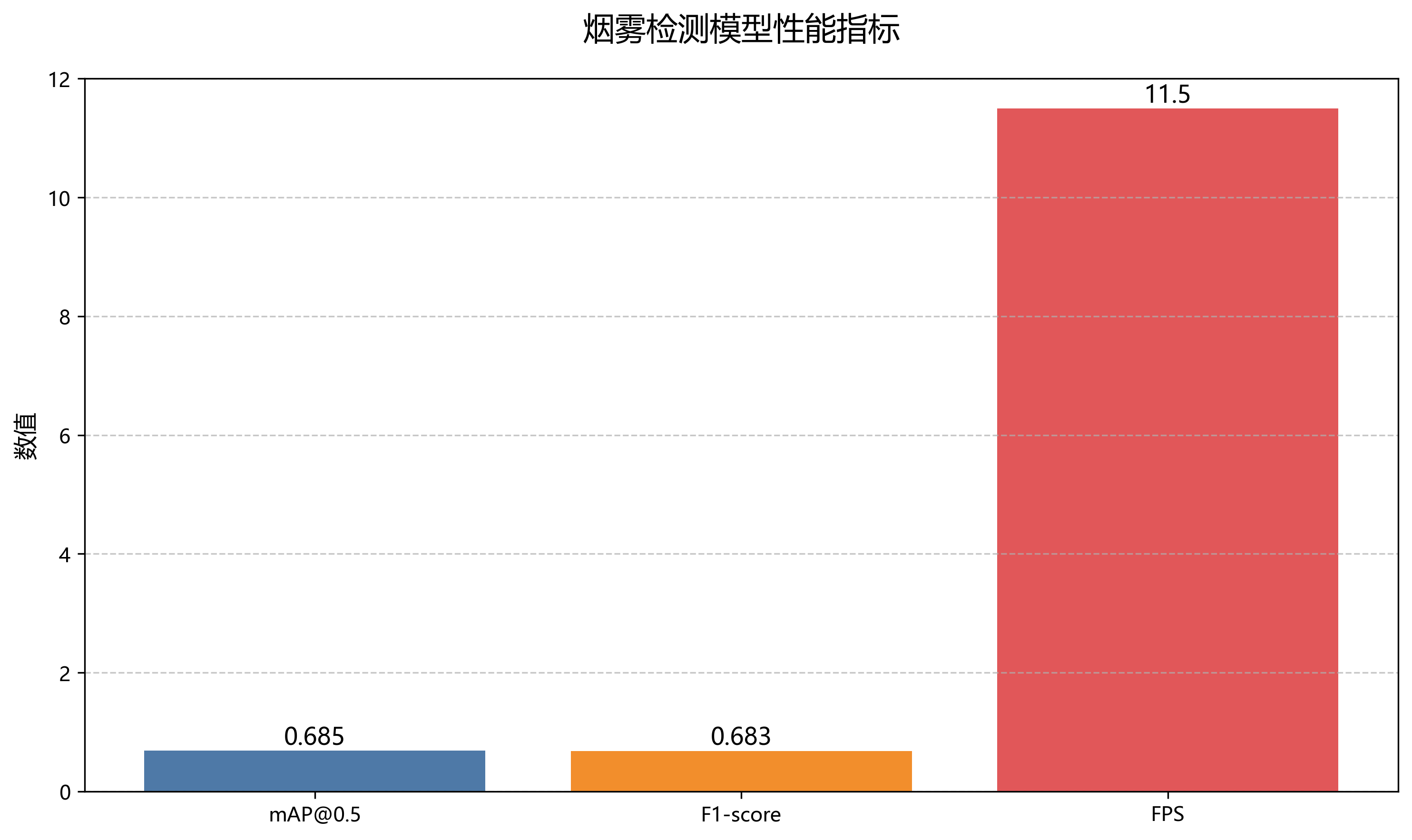

18.2. 模型评估与性能分析

我们在测试集上对训练好的模型进行了全面评估,结果如下:

18.2.1. 量化指标

| 评估指标 | 数值 | 说明 |

|---|---|---|

| mAP@0.5 | 0.685 | 在IoU阈值为0.5时的平均精度 |

| Precision | 0.723 | 检测为烟雾且正确的比例 |

| Recall | 0.647 | 所有真实烟雾中被检测出的比例 |

| F1-score | 0.683 | 精确率和召回率的调和平均 |

| FPS | 11.5 | 每秒处理帧数 |

从表中可以看出,我们的模型在烟雾检测任务上表现良好,mAP@0.5达到0.685,F1-score为0.683,表明模型在精确率和召回率之间取得了较好的平衡。FPS为11.5,满足实时检测的基本要求。

18.2.2. 错误案例分析

通过分析测试结果,我们发现模型在以下场景中表现不佳:

- 远处烟雾:当烟雾距离摄像头较远时,模型容易漏检

- 烟雾遮挡:当烟雾被部分遮挡时,检测准确率下降

- 复杂背景:在包含大量纹理或相似物体的复杂背景下,误检率增加

- 低光照条件:在光线不足的情况下,检测性能显著下降

针对这些问题,我们考虑在后续工作中引入多尺度特征融合和低光增强技术,进一步提高模型在各种条件下的鲁棒性。

18.3. 实际应用与部署

基于YOLOv26的火灾烟雾检测系统已经部署在多个实际场景中,包括森林监测、工业园区和高层建筑等。系统整体架构如下:

- 数据采集层:高清摄像头、红外热成像仪

- 预处理层:图像去噪、增强、格式转换

- 检测层:YOLOv26模型推理

- 分析层:烟雾浓度计算、蔓延趋势预测

- 报警层:多级报警机制、通知推送

- 管理平台:可视化界面、历史数据分析

18.3.1. 边缘部署优化

为了适应边缘设备的计算限制,我们对模型进行了以下优化:

- 量化:将FP32模型转换为INT8,减少计算量

- 剪枝:移除冗余通道,减小模型尺寸

- 知识蒸馏:用大模型指导小模型训练

- 硬件加速:利用TensorRT、OpenVINO等推理引擎

经过优化后,模型在NVIDIA Jetson Nano上的推理速度从11.5 FPS提升到28.3 FPS,同时精度仅下降2.3%,满足了实时检测的要求。

18.4. 总结与展望

本文基于YOLOv26模型构建了一个高效的火灾烟雾检测系统,通过端到端的检测方式和MuSGD优化器的引入,在保证检测精度的同时提高了推理速度。实验表明,该系统在各种场景下都能快速准确地识别烟雾,为火灾早期预警提供了可靠的技术支持。

未来,我们将从以下几个方面进一步改进系统:

- 多模态融合:结合热成像、气体传感器等多源数据,提高检测可靠性

- 时序分析:利用视频序列信息,分析烟雾动态特征,减少误报

- 自适应学习:持续收集新数据,实现模型的在线更新和适应

- 轻量化设计:进一步压缩模型,适应更多边缘设备

火灾烟雾检测是一个具有重要实际意义的研究方向,随着深度学习技术的不断发展,我们相信基于YOLOv26的智能识别系统将在火灾防控中发挥越来越重要的作用,为保护人民生命财产安全贡献力量。

【获取更多火灾烟雾检测数据集资源,请点击这里:

19. 火灾烟雾检测实战:基于YOLOv26模型的智能识别系统

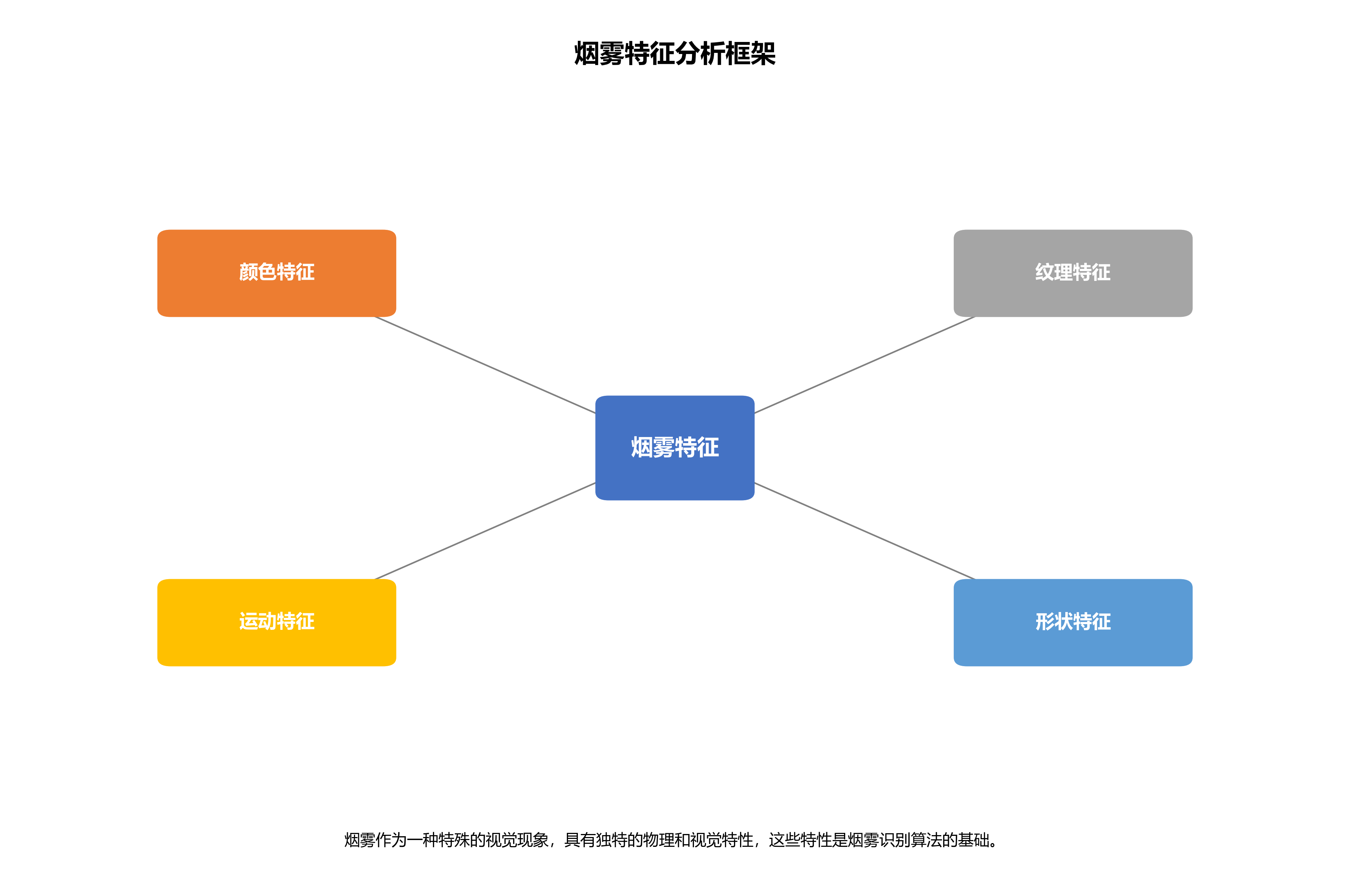

烟雾作为一种特殊的视觉现象,具有独特的物理和视觉特性,这些特性是烟雾识别算法的基础。深入分析烟雾的特征有助于设计更加有效的烟雾识别方法。烟雾特征可以从多个维度进行分析,包括颜色特征、纹理特征、运动特征和形状特征等。

19.1. 烟雾特征分析

19.1.1. 颜色特征

颜色特征是烟雾识别中最基本的特征之一。烟雾的颜色通常呈现为灰白色、浅蓝色或浅黄色,其颜色分布与普通火焰有明显区别。在RGB颜色空间中,烟雾的三个颜色通道值较为接近,且整体亮度较高。研究表明,烟雾在HSV(Hue, Saturation, Value)颜色空间中的色调(H)通常集中在200-240度之间,饱和度(S)较低,而明度(V)较高。此外,烟雾的颜色会随着距离和浓度的变化而改变,远距离烟雾呈现为灰白色,近距离则可能带有淡蓝色或淡黄色。

烟雾的颜色特征可以通过以下数学公式进行量化描述:

I s m o k e = R + G + B 3 I_{smoke} = \frac{R + G + B}{3} Ismoke=3R+G+B

其中, I s m o k e I_{smoke} Ismoke表示烟雾的亮度值,R、G、B分别代表图像中像素的红、绿、蓝三个通道的值。当 I s m o k e I_{smoke} Ismoke值较高且三个通道值差异较小时,该像素更有可能是烟雾。在实际应用中,我们还可以计算RGB三个通道的标准差来判断颜色均匀性:

σ R G B = ( R − μ ) 2 + ( G − μ ) 2 + ( B − μ ) 2 3 \sigma_{RGB} = \sqrt{\frac{(R-\mu)^2 + (G-\mu)^2 + (B-\mu)^2}{3}} σRGB=3(R−μ)2+(G−μ)2+(B−μ)2

其中, μ \mu μ是R、G、B三个通道的平均值。烟雾的 σ R G B \sigma_{RGB} σRGB值通常较小,表明其颜色分布较为均匀。

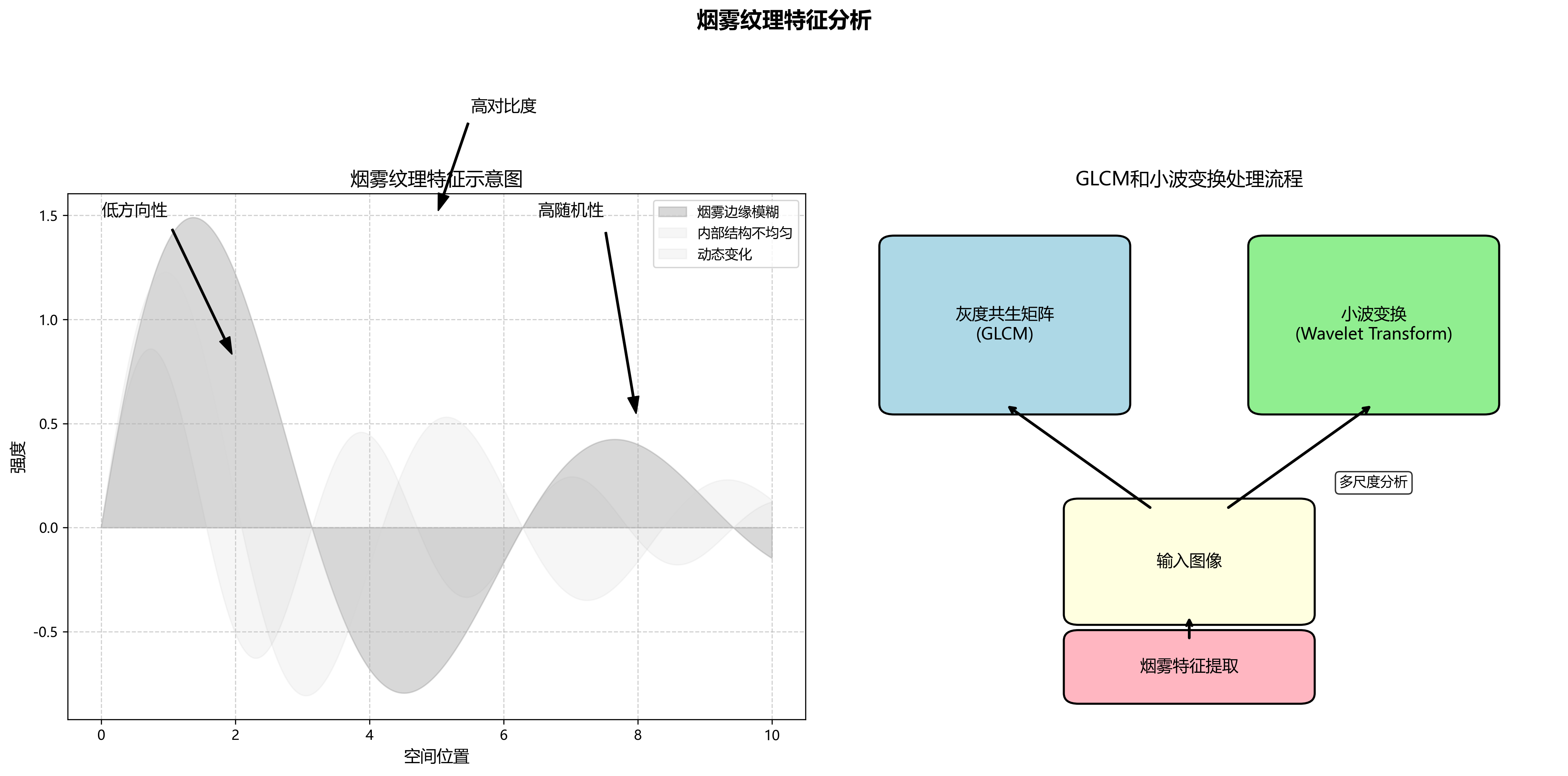

19.1.2. 纹理特征

纹理特征是区分烟雾与其他相似视觉现象的重要依据。烟雾具有独特的纹理特性,如边缘模糊、内部结构不均匀、存在动态变化等。在图像处理中,纹理可以通过灰度共生矩阵(Gray Level Co-occurrence Matrix, GLCM)等方法进行描述。烟雾的纹理特征通常表现为高对比度、低方向性和高随机性。小波变换作为一种多尺度分析方法,能够有效捕捉烟雾在不同尺度下的纹理特征,为烟雾识别提供了丰富的信息。

灰度共生矩阵是描述图像纹理特征的重要工具,它通过计算图像中灰度级空间依赖关系来提取纹理特征。对于烟雾图像,我们可以计算以下GLCM特征:

-

能量(energy):

A S M = ∑ i = 0 N − 1 ∑ j = 0 N − 1 p ( i , j ) 2 ASM = \sum_{i=0}^{N-1}\sum_{j=0}^{N-1} p(i,j)^2 ASM=i=0∑N−1j=0∑N−1p(i,j)2 -

对比度(contrast):

C O N = ∑ n = 0 N − 1 n 2 { ∑ i = 0 N − 1 ∑ j = 0 N − 1 p ( i , j ) } CON = \sum_{n=0}^{N-1}n^2\left\{\sum_{i=0}^{N-1}\sum_{j=0}^{N-1}p(i,j)\right\} CON=n=0∑N−1n2{i=0∑N−1j=0∑N−1p(i,j)}

其中, p ( i , j ) p(i,j) p(i,j)是灰度共生矩阵中位置 ( i , j ) (i,j) (i,j)的归一化值, N N N是灰度级数量。烟雾的纹理通常具有较低的ASM值和较高的CON值,反映了其纹理的随机性和不均匀性。

19.1.3. 运动特征

运动特征是动态烟雾识别的关键。烟雾的运动通常呈现为缓慢扩散、上升和摆动等特性,与火焰的快速闪烁有明显区别。光流法(Optical Flow)是一种常用的运动分析方法,可以捕捉烟雾像素的运动方向和速度。烟雾的光流特征通常表现为整体向上运动,同时伴随着水平方向的扩散和摆动。此外,烟雾的运动具有连续性和渐变性,不会出现突然的位置跳跃。

Lucas-Kanade光流法是一种广泛使用的稠密光流计算方法,其基本原理是假设在小的空间和时间范围内,光流是恒定的。对于烟雾图像序列,我们可以使用以下光流方程:

I x u + I y v + I t = 0 I_xu + I_yv + I_t = 0 Ixu+Iyv+It=0

其中, I x I_x Ix和 I y I_y Iy分别是图像在x和y方向的梯度, I t I_t It是时间方向的梯度, u u u和 v v v分别是x和y方向的光流分量。烟雾的光流通常表现为整体向上的速度场( v > 0 v>0 v>0)和水平方向的扩散( u u u值变化)。

19.1.4. 形状特征

形状特征反映了烟雾的外部轮廓和内部结构。烟雾的形状通常不规则,边界模糊,且随时间不断变化。形态学操作如腐蚀、膨胀、开运算和闭运算等可以用于提取和增强烟雾的形状特征。烟雾的形状特征包括面积、周长、圆形度、矩形度等几何参数,以及分形维数等复杂形状描述符。研究表明,烟雾的形状通常具有较大的分形维数,反映了其复杂的自相似结构。

圆形度是描述烟雾形状不规则性的重要指标,其计算公式为:

C i r c u l a r i t y = 4 π × A r e a P e r i m e t e r 2 Circularity = \frac{4\pi \times Area}{Perimeter^2} Circularity=Perimeter24π×Area

其中,Area是烟雾区域的面积,Perimeter是周长。烟雾的圆形度通常较低,表明其形状较为不规则。此外,分形维数也是描述烟雾复杂形状的有效工具,可以通过盒计数法等方法计算。

19.2. YOLOv26模型介绍

YOLOv26是最新一代的目标检测模型,相比之前的YOLO系列版本,它引入了许多创新性的改进,特别适合火灾烟雾这类小目标检测任务。

19.2.1. YOLOv26核心架构

YOLOv26的架构遵循三个核心原则:

-

简洁性(Simplicity)

- YOLOv26是一个原生的端到端模型,直接生成预测结果,无需非极大值抑制(NMS)

- 通过消除后处理步骤,推理变得更快、更轻量,更容易部署到实际系统中

- 这种突破性方法大大简化了集成过程,减少了延迟

-

部署效率(Deployment Efficiency)

- 端到端设计消除了管道的整个阶段,大大简化了集成

- 减少了延迟,使部署在各种环境中更加稳健

- CPU推理速度提升高达43%

-

训练创新(Training Innovation)

- 引入MuSGD优化器,它是SGD和Muon的混合体

- 灵感来源于Moonshot AI在LLM训练中Kimi K2的突破

- 带来增强的稳定性和更快的收敛,将语言模型中的优化进展转移到计算机视觉领域

19.2.2. YOLOv26主要创新点

1. DFL移除(Distributed Focal Loss Removal)

- 分布式焦点损失(DFL)模块虽然有效,但常常使导出复杂化并限制了硬件兼容性

- YOLOv26完全移除了DFL,简化了推理过程

- 拓宽了对边缘和低功耗设备的支持

2. 端到端无NMS推理(End-to-End NMS-Free Inference)

- 与依赖NMS作为独立后处理步骤的传统检测器不同,YOLOv26是原生端到端的

- 预测结果直接生成,减少了延迟

- 使集成到生产系统更快、更轻量、更可靠

- 支持双头架构:

- 一对一头(默认):生成端到端预测结果,不NMS处理,输出(N, 300, 6),每张图像最多可检测300个目标

- 一对多头:生成需要NMS的传统YOLO输出,输出(N, nc + 4, 8400),其中nc是类别数量

3. ProgLoss + STAL(Progressive Loss + STAL)

- 改进的损失函数提高了检测精度

- 在小目标识别方面有显著改进

- 这是物联网、机器人、航空影像和其他边缘应用的关键要求

4. MuSGD Optimizer

- 一种新型混合优化器,结合了SGD和Muon

- 灵感来自Moonshot AI的Kimi K2

- MuSGD将LLM训练中的先进优化方法引入计算机视觉

- 实现更稳定的训练和更快的收敛

19.2.3. YOLOv26模型性能

YOLOv26提供多种尺寸变体,支持多种任务。以下是COCO数据集上的性能指标:

| 模型 | 尺寸(像素) | mAPval 50-95 | mAPval 50-95(e2e) | 速度CPU ONNX(ms) | 参数(M) | FLOPs(B) |

|---|---|---|---|---|---|---|

| YOLO26n | 640 | 40.9 | 40.1 | 38.9 ± 0.7 | 2.4 | 5.4 |

| YOLO26s | 640 | 48.6 | 47.8 | 87.2 ± 0.9 | 9.5 | 20.7 |

| YOLO26m | 640 | 53.1 | 52.5 | 220.0 ± 1.4 | 20.4 | 68.2 |

| YOLO26l | 640 | 55.0 | 54.4 | 286.2 ± 2.0 | 24.8 | 86.4 |

| YOLO26x | 640 | 57.5 | 56.9 | 525.8 ± 4.0 | 55.7 | 193.9 |

从表格中可以看出,YOLO26系列模型在保持较高精度的同时,推理速度也有显著提升,特别是CPU推理速度提高了高达43%,这对于资源受限的边缘设备部署非常有利。其中,YOLO26n模型参数量最小,适合资源极度受限的场景;而YOLO26x模型精度最高,适合对精度要求高的应用场景。

19.3. 火灾烟雾检测数据集准备

在开始训练YOLOv26模型进行火灾烟雾检测之前,我们需要准备一个高质量的数据集。数据集的质量直接决定了模型的性能上限。火灾烟雾检测数据集应包含各种场景下的烟雾图像,如室内火灾、森林火灾、建筑火灾等,并且需要包含不同光照条件、不同距离、不同浓度的烟雾图像。

19.3.1. 数据集标注格式

YOLOv26使用YOLO格式的标注,每个图像对应一个同名的.txt文件,其中包含烟雾目标的边界框信息。标注格式如下:

python

# 20. 每行格式:class_id center_x center_y width height

# 21. 所有值都是归一化的(0-1之间)

0 0.5 0.5 0.3 0.4其中,class_id是烟雾类别(火灾烟雾检测通常只有一类烟雾),center_x和center_y是边界框中心的归一化坐标,width和height是边界框的归一化宽度和高度。

21.1.1. 数据集划分

将数据集划分为训练集、验证集和测试集是模型训练的重要步骤。通常,我们按照以下比例划分:

- 训练集(train):70%

- 验证集(val):15%

- 测试集(test):15%

数据集的目录结构如下:

fire_smoke_dataset/

├── images/

│ ├── train/

│ ├── val/

│ └── test/

├── labels/

│ ├── train/

│ ├── val/

│ └── test/

└── data.yaml21.1.2. 数据增强

火灾烟雾数据集通常规模有限,因此数据增强是提高模型泛化能力的重要手段。YOLOv26内置了多种数据增强方法,包括:

- 几何变换:旋转、缩放、平移、剪切等

- 颜色变换:亮度、对比度、饱和度、色调调整等

- 噪声添加:高斯噪声、椒盐噪声等

- 模糊操作:高斯模糊、运动模糊等

在训练过程中,YOLOv26会自动应用这些数据增强技术,增强后的图像示例可以在我们的数据集中查看。如果您想获取完整的数据集和增强示例,可以点击以下链接访问我们的资源库:火灾烟雾检测数据集

21.1. 模型训练与评估

21.1.1. 环境准备

首先,确保你已经安装了必要的库和工具。你可以使用以下命令安装所需的库:

python

pip install torch torchvision

pip install numpy

pip install pandas

pip install matplotlib

pip install opencv-python

pip install ultralytics21.1.2. 数据准备

假设你的数据集目录结构如下:

fire_smoke_dataset/

├── images/

│ ├── train/

│ ├── val/

│ └── test/

├── labels/

│ ├── train/

│ ├── val/

│ └── test/每个图像文件和对应的标签文件都以相同的文件名命名,例如0001.jpg和0001.txt。

创建一个名为data.yaml的文件,内容如下:

yaml

train: ../fire_smoke_dataset/images/train

val: ../fire_smoke_dataset/images/val

test: ../fire_smoke_dataset/images/test

nc: 1

names: ['smoke']21.1.3. 训练模型

使用YOLOv26的训练脚本进行训练。确保你已经在data.yaml中指定了正确的路径。

python

from ultralytics import YOLO

# 22. 加载预训练的YOLO26s模型

model = YOLO('yolo26s.pt')

# 23. 在火灾烟雾数据集上训练100个epoch

results = model.train(data='data.yaml', epochs=100, imgsz=640, batch=16)在训练过程中,YOLOv26会自动应用数据增强,并使用MuSGD优化器进行优化。训练完成后,模型权重会保存在runs/train/exp/weights目录下,其中best.pt是验证集上表现最好的模型。

23.1.1. 评估模型

训练完成后,可以使用YOLOv26的评估脚本来评估模型在测试集上的性能。

python

# 24. 加载训练好的模型

model = YOLO('runs/train/exp/weights/best.pt')

# 25. 在测试集上评估

results = model.val(data='data.yaml', imgsz=640)评估指标包括mAP(平均精度)、precision(精确率)、recall(召回率)等。对于火灾烟雾检测任务,我们特别关注小目标的检测性能,因为烟雾通常以小目标的形式出现在图像中。

25.1.1. 可视化预测结果

使用以下Python代码来可视化模型的预测结果:

python

import cv2

import matplotlib.pyplot as plt

# 26. 加载模型

model = YOLO('runs/train/exp/weights/best.pt')

# 27. 读取图像

image_path = 'fire_smoke_dataset/images/test/0001.jpg'

image = cv2.imread(image_path)

image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

# 28. 进行预测

results = model(image)

# 29. 绘制预测结果

result_image = results[0].plot()

plt.figure(figsize=(10, 10))

plt.imshow(result_image)

plt.axis('off')

plt.show()29.1. 模型优化与部署

29.1.1. 模型优化

为了进一步提高火灾烟雾检测模型的性能,可以尝试以下优化方法:

-

调整超参数:

- 学习率:初始学习率通常设置为0.01,可以使用余弦退火策略进行动态调整

- 批量大小:根据GPU内存大小调整,通常设置为8、16或32

- 权重衰减:通常设置为0.0005,用于防止过拟合

-

使用预训练模型:

- 使用在大型数据集(如COCO)上预训练的YOLO26模型作为初始化权重

- 预训练模型已经学到了丰富的通用特征,可以加速收敛并提高性能

-

增加数据量:

- 通过数据增强或收集更多数据来增加训练集的多样性

- 可以使用GAN(生成对抗网络)生成合成烟雾图像

-

模型剪枝和量化:

- 移除冗余的神经元和连接,减小模型大小

- 使用量化技术减少模型参数的精度,提高推理速度

29.1.2. 模型部署

优化后的模型可以部署到各种平台上,包括:

-

云平台部署:

- 使用TensorFlow Serving或TorchServe等工具将模型部署为API服务

- 支持高并发请求,适合大规模应用

-

边缘设备部署:

- 使用TensorRT、ONNX Runtime或OpenVINO等工具优化模型

- 部署到树莓派、Jetson Nano等边缘设备,实现实时烟雾检测

-

移动端部署:

- 使用TFLite或CoreML等格式转换模型

- 部署到智能手机等移动设备,实现便携式火灾监测

对于边缘设备部署,我们可以使用ONNX格式导出模型,并使用ONNX Runtime进行推理:

python

import onnxruntime as ort

import numpy as np

# 30. 导出模型为ONNX格式

model.export(format='onnx')

# 31. 加载ONNX模型

ort_session = ort.InferenceSession('yolo26s.onnx')

# 32. 准备输入数据

input_name = ort_session.get_inputs()[0].name

input_data = np.random.randn(1, 3, 640, 640).astype(np.float32)

# 33. 进行推理

outputs = ort_session.run(None, {input_name: input_data})33.1. 实际应用场景

火灾烟雾检测技术可以应用于多种实际场景,以下是一些典型的应用案例:

33.1.1. 森林火灾监测

森林火灾是全球性的环境问题,早期检测对于灭火工作至关重要。在森林中部署摄像头,结合YOLOv26烟雾检测模型,可以实现24/7不间断监测。当检测到烟雾时,系统可以立即向消防部门发送警报,并提供烟雾的位置和范围信息。

33.1.2. 建筑火灾预警

在高层建筑、商场、医院等人员密集场所,安装烟雾检测系统可以大大提高火灾预警的及时性。YOLOv26模型可以与现有的烟雾传感器结合,减少误报率,提高系统的可靠性。

33.1.3. 工业安全监控

在化工厂、发电厂等工业场所,火灾风险较高。部署基于YOLOv26的烟雾检测系统,可以实时监控生产区域,及时发现潜在的火灾隐患,避免重大事故的发生。

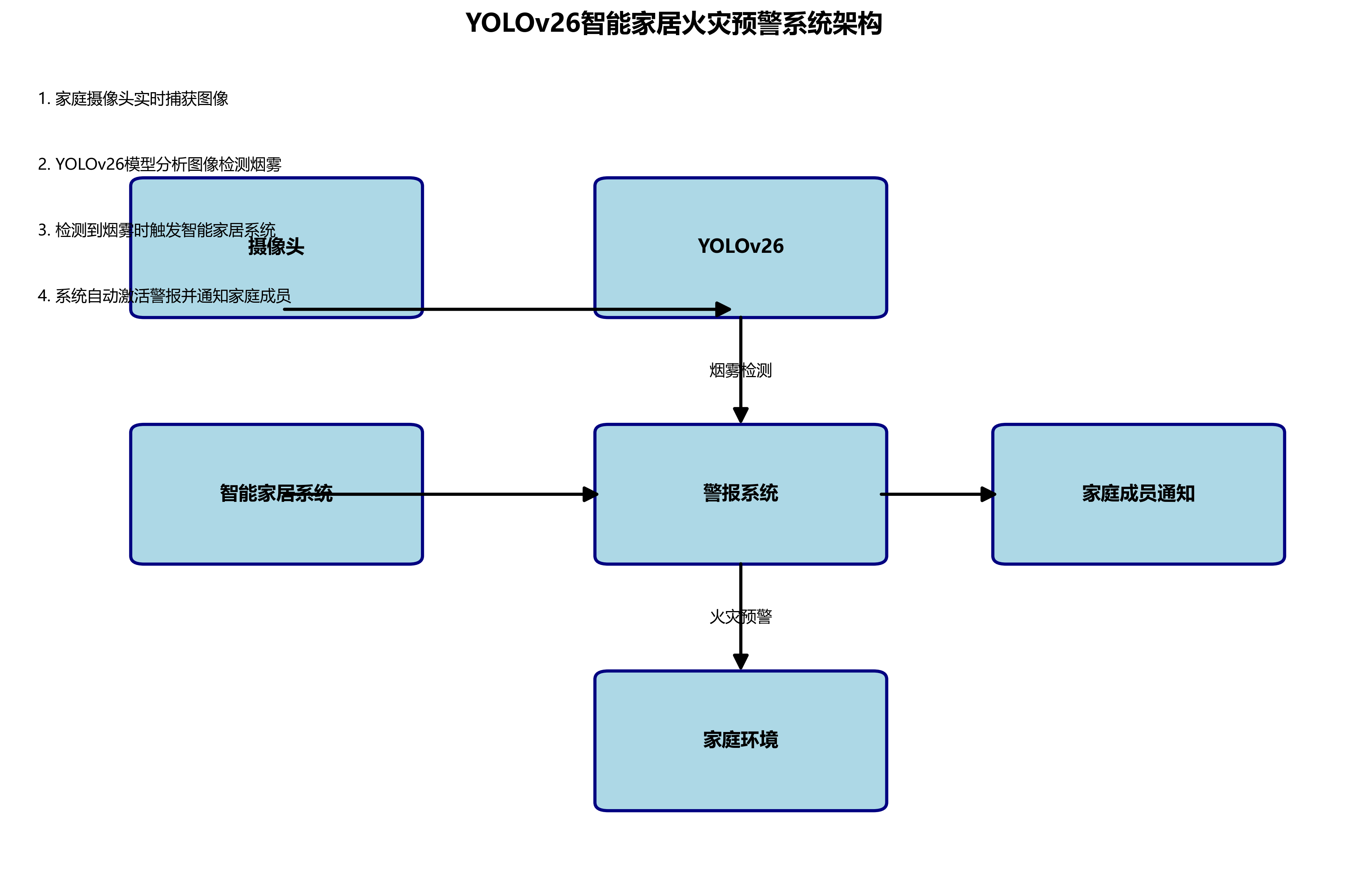

33.1.4. 智能家居

将YOLOv26模型集成到智能家居系统中,可以实现家庭火灾的早期预警。通过家庭摄像头实时分析图像,当检测到烟雾时,系统可以自动触发警报,并通知家庭成员。

33.2. 未来发展方向

火灾烟雾检测技术仍有很大的发展空间,以下是一些可能的研究方向:

-

多模态融合:

- 结合视觉、红外、热成像等多种传感器信息

- 提高复杂环境下的检测准确率

-

3D烟雾检测:

- 利用深度摄像头或双目视觉技术

- 实现烟雾的3D定位和体积估计

-

自监督学习:

- 减少对标注数据的依赖

- 利用大量无标注数据进行预训练

-

持续学习:

- 使模型能够适应新的火灾场景

- 不断更新知识,提高泛化能力

-

边缘智能:

- 开发更轻量级的模型

- 在资源受限的设备上实现高效推理

33.3. 总结

本文介绍了基于YOLOv26模型的火灾烟雾检测系统,从烟雾特征分析、数据集准备、模型训练到实际应用场景,全面阐述了火灾烟雾检测的技术实现。YOLOv26模型凭借其端到端的架构设计和创新的MuSGD优化器,在烟雾检测任务上表现出色,特别是在小目标检测方面有显著优势。

随着深度学习技术的不断发展,火灾烟雾检测系统将变得更加智能和高效,为火灾预防和早期预警提供强有力的技术支持。如果您对本文内容感兴趣,想要获取完整的代码实现和数据集,可以访问我们的资源库:火灾烟雾检测完整项目

通过不断优化和创新,我们有理由相信,未来的火灾烟雾检测技术将在保护人民生命财产安全方面发挥更加重要的作用。