24 年 7 月读完暗涌那篇《揭秘 DeepSeek:一个更极致的中国技术理想主义故事》后,在flomo上记下了其中非共识的对话,也忽然意识到,或许梁文锋就是在践行段永平口中所谓"做对的事情,把事情作对",一切信念都基于对真正价值的尊重和判断。

1、写在前面

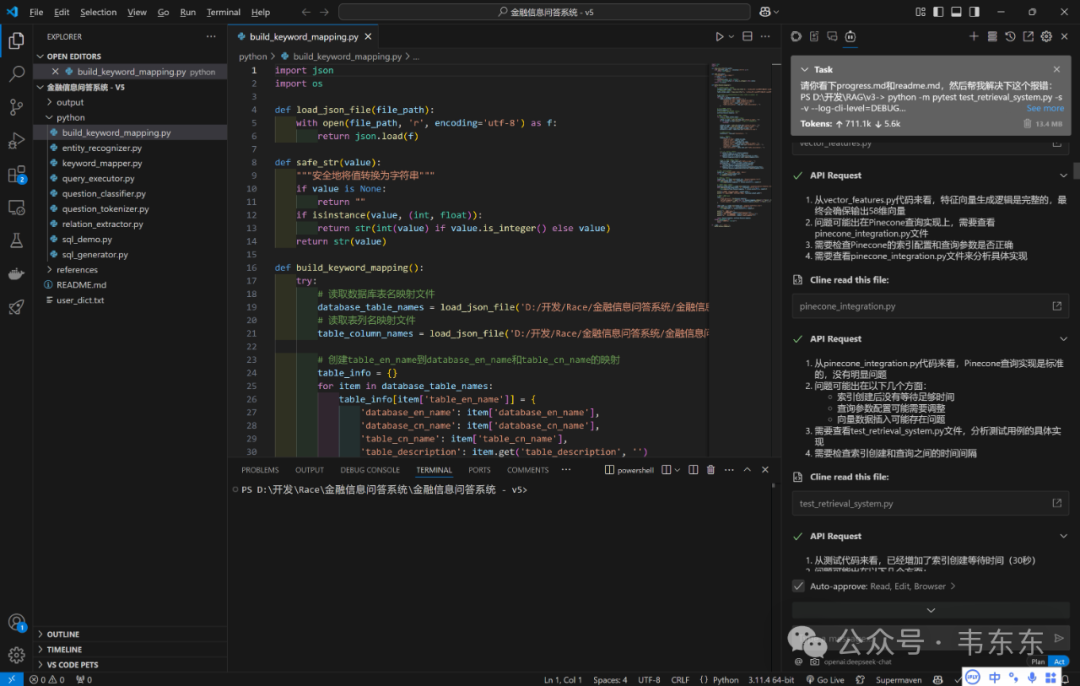

我在日常 AI 编程里,除高频使用Cursor和Windsurf 外,Cline+DeepSeek V3 也会间歇使用,体验丝滑,价格感人。1/20 初步体验了下 DeepSeek R1 后第一反应是,在 Cursor 里使用 gpt o1 3块一次的请求,真是冤大头。。

Anyway,这篇和各位介绍下如何在电脑本地通过 Ollama+Docker+Open WebUI 部署 DeepSeek R1,目的是为了上手体验下在 DeepSeek 这种 RL 方法下,小模型的蒸馏效果究竟如何。最后设想了三种身边最近的使用场景,等待后续继续测试。

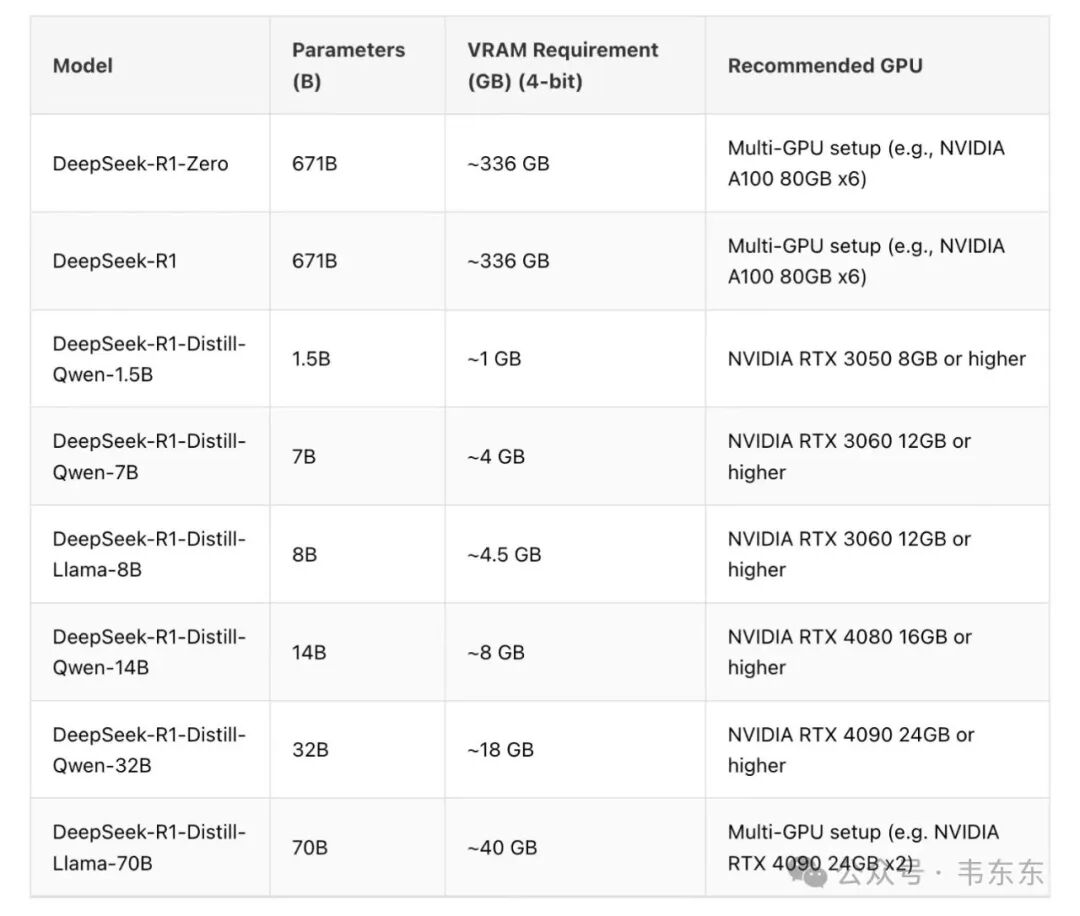

先说结论,DeepSeek-R1-Distill-Qwen-7B 的测试效果很惊艳,CoT 过程可圈可点,25 年应该值得探索更多端侧的硬件机会。

2、部署过程

2.1、 下载 Ollama

访问 Ollama 的官方网站 https://ollama.com/library/deepseek-r1, 根据系统提示下载适合自己电脑的版本。

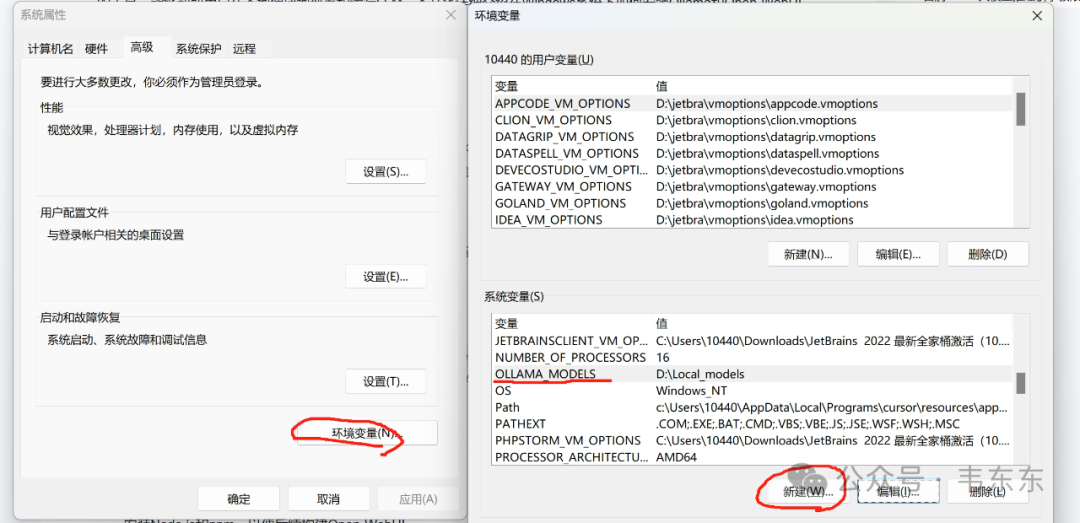

下载完成后,双击安装包进行安装。默认情况下,Ollama 会安装在 C 盘,但为了控制对 C 盘的容量挤压,建议通过在系统变量中添加 OLLAMA_MODELS 环境变量来指定模型文件的存储路径。

2.2、 下载 Docker

直接点击官方 https://www.docker.com/, 下载适合自己电脑的版本。

2.3、 下载模型

以 Distill-Qwen-7B 为例,在电脑终端中输入:ollama run deepseek-r1:7b,7b 的模型大概 4.7G 大小,等待模型下载完成之后即可在终端中输入问题进行测试。下一步会演示如何在 open webui 中使用。

2.4、 部署 open webui

在终端中运行下述命令后,可以自动在 docker 中完成部署,然后在本地浏览器中使用 docker run -d -p 8080:8080 --add-host=host.docker.internal:host-gateway -e OLLAMA_BASE_URL=http://host.docker.internal:11434 ( http://host.docker.internal:11434 ) --name open-webui ghcr.io/open-webui/open-webui:main

Open-WebUI 提供了丰富的功能和界面,如直观的聊天界面、Markdown 和 LaTeX 支持、网页浏览能力、提示预设支持等,极大地提升了用户体验。通过 RLHF 注释功能,用户可以对消息进行评级,以创建强化学习数据集,用于训练或微调模型。

3、应用场景设想示例

3.1、 贷款行业客户经理:移动端本地化风控分析

在手机或电脑本地部署量化后的 DeepSeek 1.5B 模型(约 300MB),支持离线推理。输入客户脱敏数据(如近 6 个月银行流水、近 12 个月发票等),模型输出综合风险评分及关键风险点(如"现金流波动率高于行业均值 30%")。

3.2、 中小微工厂企业主:生产数据智能分析

在工厂办公电脑部署 7B 模型,读取本地 Excel。排产优化:基于历史订单数据预测交付周期,推荐最佳排产序列。设备预警:分析传感器日志,提前 7 天预测设备故障概率(如"冲压机轴承磨损风险 85%")。良品率归因:识别关键工艺参数(如"温度波动>±2℃时良品率下降 20%")。无需云端订阅费,生产数据完全自主控制。

3.3、 贷款风控策略人员:本地化特征探索与策略迭代

在个人电脑部署 7B 模型,支持 Python/Jupyter Notebook 交互式分析。自动特征生成:模型解析客户原始数据,输出衍生特征。重要性排序:输出特征贡献度(SHAP 值),指导策略优化。本地模拟不同风控策略的效果(如"将收入负债比阈值从 50%调整至 55%"),预估坏账率变化。进一步实现敏捷开发:例如把策略迭代周期从 2 周缩短至 1 天。

如火如荼的技术迭代,25年是值得期待的一年,使用新技术解决新老问题会有更多想象空间,learn by doing.