VMware Workstation 17 + Ubuntu 22.04 + MoltBot + Ollama + qwen:1.8b + LlamaIndex(可选)

这份指南将按 真实操作顺序 编写,特别标注 网络、内存、代理、中文输入等关键坑点,适合你在新虚拟机中一键复现。

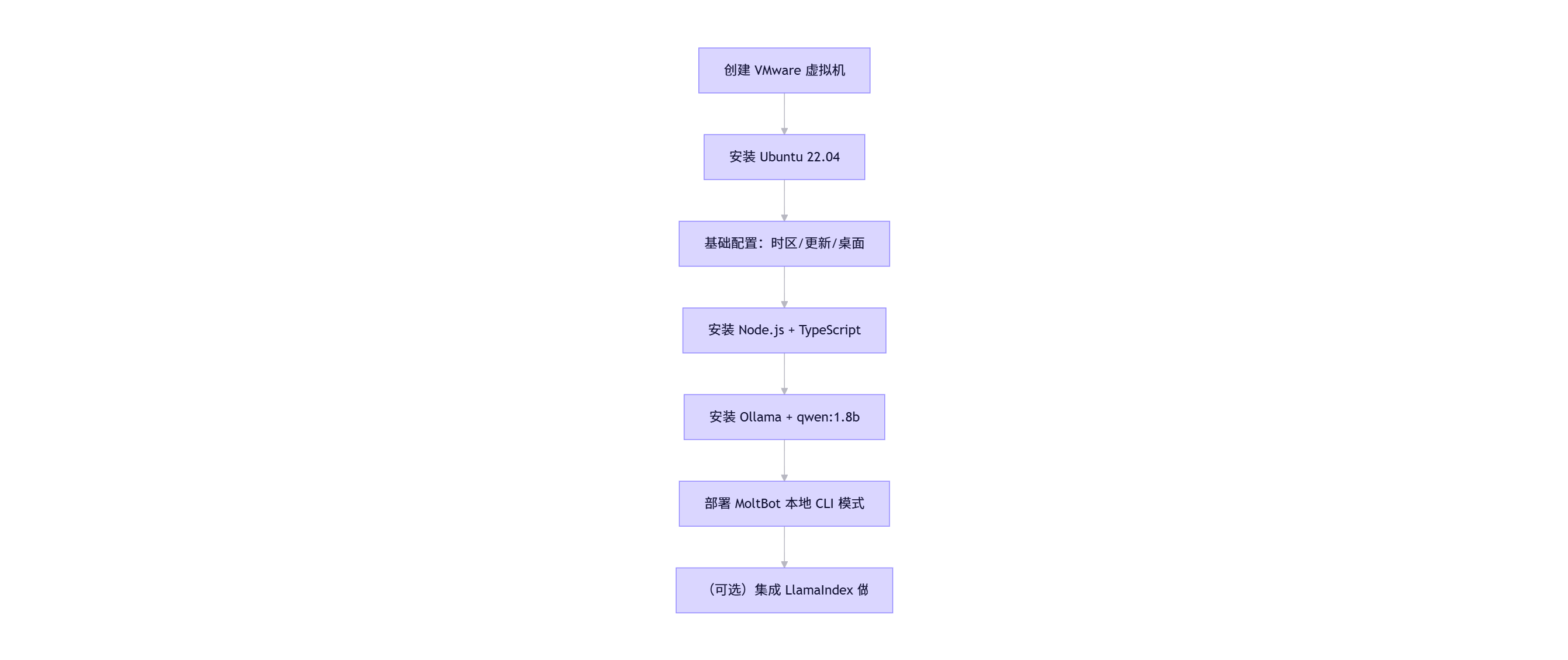

📋 总体流程概览

bash

✅ 第一步:VMware Workstation 17 创建虚拟机

推荐配置

表格

项目 建议值

系统 Ubuntu 22.04 LTS (Desktop)

内存 ≥8 GB(qwen:1.8b 需 ~6GB)

硬盘 ≥50 GB(SSD 更佳)

网络 NAT(确保能上网)

共享文件夹 启用(方便传文件)

⚠️ 注意:不要用"最小安装",需桌面环境(方便终端+浏览器)

bash

✅ 第二步:Ubuntu 22.04 初始设置

bash

编辑

# 1. 更新系统

sudo apt update && sudo apt upgrade -y

# 2. 安装常用工具

sudo apt install -y git curl wget vim net-tools htop

# 3. 设置时区(关键!WhatsApp/Ollama 依赖准确时间)

sudo timedatectl set-timezone Asia/Shanghai

# 4. (可选)安装中文语言包 + 输入法

sudo apt install -y language-pack-zh-hans fcitx fcitx-pinyin

# → 重启后在 Settings > Region & Language 添加 Chinese (Fcitx)

# 5. 禁用 IPv6(避免 WhatsApp 连接卡住)

echo 'net.ipv6.conf.all.disable_ipv6 = 1' | sudo tee -a /etc/sysctl.conf

sudo sysctl -p

⚠️ 重要:

如果在中国大陆,先确认网络能访问 GitHub/Ollama(可用手机热点)

不要提前设 http_proxy,除非代理已运行

bash

✅ 第三步:安装 Node.js 20+ 和 TypeScript

bash

编辑

# 使用官方仓库安装 Node.js 20(推荐)

curl -fsSL https://deb.nodesource.com/setup_20.x | sudo -E bash -

sudo apt install -y nodejs

# 验证

node -v # ≥ v20.0.0

npm -v

# 全局安装 tsx(用于运行 TS 脚本)

npm install -g tsx

⚠️ 不要用 snap 安装 Node.js(权限问题多)

bash

✅ 第四步:安装 Ollama + qwen:1.8b

bash

编辑

# 1. 清除可能存在的错误代理

unset http_proxy https_proxy HTTP_PROXY HTTPS_PROXY

# 2. 修复 DNS(防止 registry.ollama.ai 解析失败)

echo "nameserver 8.8.8.8" | sudo tee /etc/resolv.conf

# 3. 安装 Ollama

curl -fsSL https://ollama.com/install.sh | sh

# 4. 启动服务

sudo systemctl enable ollama

sudo systemctl start ollama

# 5. 下载模型(需联网!建议开热点)

ollama pull qwen:1.8b

# 6. 测试

ollama run qwen:1.8b "你好"

⚠️ 注意事项:

必须保证下载过程网络稳定(中断需重下)

首次运行会解压模型,耐心等待 1~2 分钟

如果内存 < 6GB,改用 qwen:0.5b

bash

✅ 第五步:部署 MoltBot 本地 CLI 模式

bash

编辑

# 1. 克隆项目(假设你已有 moltbot)

cd ~

git clone https://github.com/yourname/moltbot.git

cd moltbot

# 2. 安装依赖

npm install

# 3. 创建安全版 AI 脚本(ai-safe.ts)

# → 内容见前文,使用 spawn('ollama', ['run', 'qwen:1.8b', ...])

# 4. 创建全局启动脚本

cat > ~/moltbot.sh << 'EOF'

#!/bin/bash

cd ~/moltbot && npx tsx ai-safe.ts

EOF

chmod +x ~/moltbot.sh

# 5. 加入 PATH(可选)

echo 'export PATH="$HOME:$PATH"' >> ~/.bashrc

source ~/.bashrc

✅ 现在可直接运行:moltbot.sh

bash

✅ 第六步:(可选)集成 LlamaIndex 做 RAG

适用于:你想让 MoltBot 自动读取 ~/docs/ 中的文件

bash

编辑

# 1. 安装 Python 3.10+

sudo apt install -y python3 python3-pip

# 2. 安装 LlamaIndex

pip3 install llama-index llama-index-llms-ollama llama-index-embeddings-huggingface

# 3. 创建 rag-bot.py(调用 Ollama + 本地文档)

# → 需编写加载 DirectoryReader + Ollama LLM 的脚本

# 4. 在 ai-safe.ts 中调用该 Python 脚本(通过 child_process)

⚠️ 注意:LlamaIndex 需要额外内存(建议 ≥12GB),且首次运行会下载 embedding 模型(~500MB)

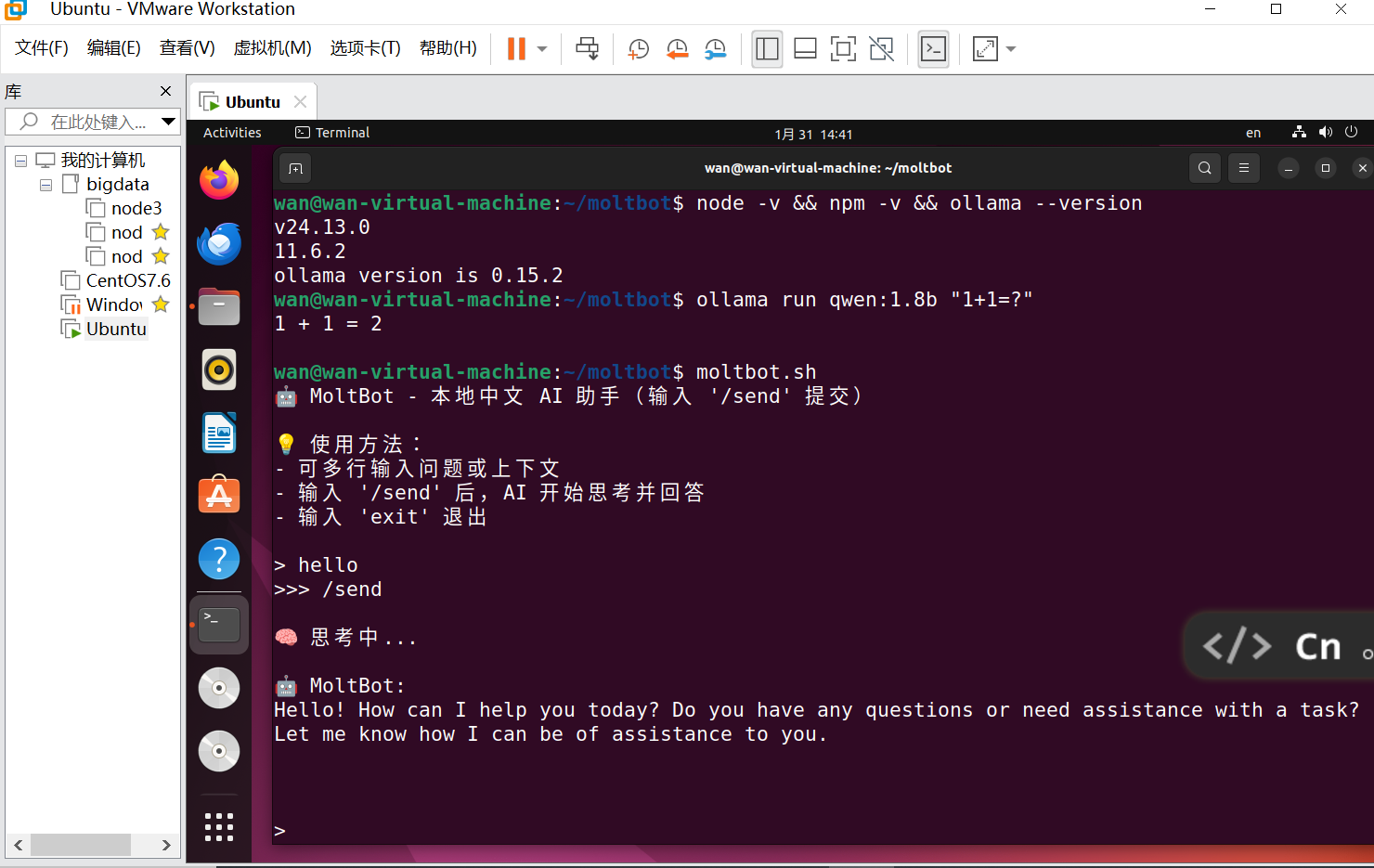

🧪 最终验证命令

bash

wan@wan-virtual-machine:~/moltbot$ node -v && npm -v && ollama --version

v24.13.0

11.6.2

ollama version is 0.15.2

wan@wan-virtual-machine:~/moltbot$ ollama run qwen:1.8b "1+1=?"

1 + 1 = 2

wan@wan-virtual-machine:~/moltbot$ moltbot.sh

🤖 MoltBot - 本地中文 AI 助手(输入 '/send' 提交)

💡 使用方法:

- 可多行输入问题或上下文

- 输入 '/send' 后,AI 开始思考并回答

- 输入 'exit' 退出

> hello

>>> /send

🧠 思考中...

🤖 MoltBot:

Hello! How can I help you today? Do you have any questions or need assistance with a task? Let me know how I can be of assistance to you.

⚠️ 注意:LlamaIndex 需要额外内存(建议 ≥12GB),且首次运行会下载 embedding 模型(~500MB),小编的小心脏,不能玩,就放弃了