🚀 系列导读:本文是AI Agents系列的第八篇,深入探讨单智能体(Single Agent)在实际场景中的应用。我们将从代码助手、研究助手、游戏AI到数据解释器,全面剖析单智能体的任务执行、创新能力与生命周期管理。

📑 目录

- [1. 引言:单智能体的崛起](#1. 引言:单智能体的崛起)

- [2. 单智能体核心概念](#2. 单智能体核心概念)

- [2.1 什么是单智能体](#2.1 什么是单智能体)

- [2.2 单智能体 vs 多智能体](#2.2 单智能体 vs 多智能体)

- [2.3 核心架构解析](#2.3 核心架构解析)

- [3. 任务执行:从感知到行动](#3. 任务执行:从感知到行动)

- [3.1 任务分解与规划](#3.1 任务分解与规划)

- [3.2 工具调用与执行](#3.2 工具调用与执行)

- [3.3 反馈循环与自我修正](#3.3 反馈循环与自我修正)

- [4. 代码助手:编程的智能伙伴](#4. 代码助手:编程的智能伙伴)

- [4.1 GitHub Copilot:开创者的征程](#4.1 GitHub Copilot:开创者的征程)

- [4.2 Cursor:AI-First的IDE革命](#4.2 Cursor:AI-First的IDE革命)

- [4.3 代码助手的技术原理](#4.3 代码助手的技术原理)

- [4.4 实战:构建简易代码助手](#4.4 实战:构建简易代码助手)

- [5. 研究助手:知识的导航员](#5. 研究助手:知识的导航员)

- [5.1 研究助手的核心能力](#5.1 研究助手的核心能力)

- [5.2 典型应用场景](#5.2 典型应用场景)

- [5.3 实战:构建文献研究助手](#5.3 实战:构建文献研究助手)

- [6. 游戏AI:Voyager的探索之旅](#6. 游戏AI:Voyager的探索之旅)

- [6.1 Voyager项目概述](#6.1 Voyager项目概述)

- [6.2 核心创新点](#6.2 核心创新点)

- [6.3 技术架构深度解析](#6.3 技术架构深度解析)

- [6.4 实验结果与启示](#6.4 实验结果与启示)

- [7. Data Interpreter:数据的解读者](#7. Data Interpreter:数据的解读者)

- [7.1 Data Interpreter的设计理念](#7.1 Data Interpreter的设计理念)

- [7.2 核心功能模块](#7.2 核心功能模块)

- [7.3 动态规划与代码生成](#7.3 动态规划与代码生成)

- [7.4 实战案例分析](#7.4 实战案例分析)

- [8. 单智能体的生命周期](#8. 单智能体的生命周期)

- [8.1 初始化阶段](#8.1 初始化阶段)

- [8.2 运行阶段](#8.2 运行阶段)

- [8.3 学习与进化](#8.3 学习与进化)

- [8.4 终止与资源回收](#8.4 终止与资源回收)

- [9. 单智能体的创新能力](#9. 单智能体的创新能力)

- [9.1 探索与利用的平衡](#9.1 探索与利用的平衡)

- [9.2 知识的积累与迁移](#9.2 知识的积累与迁移)

- [9.3 自我改进机制](#9.3 自我改进机制)

- [10. 挑战与未来展望](#10. 挑战与未来展望)

- [10.1 当前面临的挑战](#10.1 当前面临的挑战)

- [10.2 未来发展方向](#10.2 未来发展方向)

- [11. 总结](#11. 总结)

- 参考文献

1. 引言:单智能体的崛起

在人工智能发展的长河中,2023-2024年无疑是一个里程碑式的时期。大型语言模型(LLM)的突破性进展,为智能体(Agent)技术的实用化铺平了道路。如果说LLM是"大脑",那么Agent就是赋予这个大脑"手脚"和"感官"的完整系统------它能够感知环境、制定计划、调用工具、执行任务,并从反馈中学习进步。

┌─────────────────────────────────────────────────────────────────┐

│ AI 发展的关键里程碑 │

├─────────────────────────────────────────────────────────────────┤

│ │

│ 2020 2022 2023 2024 2025 │

│ │ │ │ │ │ │

│ ▼ ▼ ▼ ▼ ▼ │

│ GPT-3 ChatGPT GPT-4/Claude Agent框架 Agent普及 │

│ │ │ │ 成熟化 │ │

│ │ │ │ │ │ │

│ [语言理解] [对话能力] [推理增强] [工具使用] [自主决策] │

│ │

│ ════════════════════════════════════════════════════════════ │

│ 从"会说话"到"会做事"的进化之路 │

└─────────────────────────────────────────────────────────────────┘单智能体(Single Agent) 是这场革命的基础单元。与复杂的多智能体系统不同,单智能体专注于独立完成特定领域的任务,具有架构简洁、部署灵活、调试方便等优势。在实际应用中,从GitHub Copilot到Cursor,从研究助手到游戏AI Voyager,单智能体正在各个领域展现出惊人的能力。

💡 思考:为什么在多智能体系统备受关注的今天,我们仍然需要深入理解单智能体?

🤔 解答:

- 基础决定上层:多智能体系统的每个个体本质上都是单智能体,理解单智能体是理解复杂系统的前提

- 实用性原则:大多数实际场景中,一个设计良好的单智能体就足以解决问题,过度设计反而增加复杂性

- 调试与优化:单智能体的行为更易于追踪、分析和优化,是验证AI能力的最佳载体

- 成本效益:单智能体的资源消耗更可控,适合大规模商业部署

本文将带您深入探索单智能体的世界,从理论基础到实战应用,从经典案例到前沿创新,全面揭示单智能体的任务执行机制、创新能力和生命周期管理。

2. 单智能体核心概念

2.1 什么是单智能体

单智能体(Single Agent) 是一个能够自主感知环境、做出决策并执行行动的智能系统。它通常由以下核心组件构成:

┌─────────────────────────────────────────────────────────────────┐

│ 单智能体核心架构 │

├─────────────────────────────────────────────────────────────────┤

│ │

│ ┌───────────────┐ │

│ │ 用户输入 │ │

│ └───────┬───────┘ │

│ ▼ │

│ ┌───────────────┐ │

│ │ 感知模块 │ ← 理解用户意图、环境状态 │

│ └───────┬───────┘ │

│ ▼ │

│ ┌──────────┐ ┌───────────────┐ ┌──────────┐ │

│ │ │ │ │ │ │ │

│ │ 记忆 │◄────►│ 推理核心 │◄────►│ 知识库 │ │

│ │ Memory │ │ (LLM) │ │Knowledge │ │

│ │ │ │ │ │ │ │

│ └──────────┘ └───────┬───────┘ └──────────┘ │

│ ▼ │

│ ┌───────────────┐ │

│ │ 规划模块 │ ← 分解任务、制定计划 │

│ └───────┬───────┘ │

│ ▼ │

│ ┌───────────────┐ │

│ │ 行动模块 │ ← 调用工具、执行操作 │

│ └───────┬───────┘ │

│ ▼ │

│ ┌───────────────┐ │

│ │ 环境反馈 │ │

│ └───────────────┘ │

│ │

└─────────────────────────────────────────────────────────────────┘核心组件详解:

| 组件 | 功能 | 技术实现 |

|---|---|---|

| 感知模块 | 接收并理解外部输入 | 自然语言处理、多模态理解 |

| 推理核心 | 分析问题、生成方案 | LLM(GPT-4、Claude等) |

| 记忆系统 | 存储上下文和历史信息 | 向量数据库、对话缓存 |

| 知识库 | 提供领域知识支持 | RAG、知识图谱 |

| 规划模块 | 任务分解与执行规划 | Chain-of-Thought、Tree-of-Thought |

| 行动模块 | 工具调用与操作执行 | Function Calling、API调用 |

2.2 单智能体 vs 多智能体

理解单智能体与多智能体的区别,有助于我们在实际项目中做出正确的架构选择:

┌─────────────────────────────────────────────────────────────────┐

│ 单智能体 vs 多智能体 对比 │

├─────────────────────┬───────────────────────────────────────────┤

│ │ │

│ 单智能体架构 │ 多智能体架构 │

│ │ │

│ ┌─────────┐ │ ┌─────┐ ┌─────┐ ┌─────┐ │

│ │ │ │ │Agent│◄─►│Agent│◄─►│Agent│ │

│ │ Agent │ │ │ A │ │ B │ │ C │ │

│ │ │ │ └──┬──┘ └──┬──┘ └──┬──┘ │

│ └────┬────┘ │ │ │ │ │

│ │ │ └────┬────┴────┬────┘ │

│ ┌────┴────┐ │ │ │ │

│ │ Tools │ │ ┌────┴────┐ │ │

│ └─────────┘ │ │Orchestr.│────┘ │

│ │ └─────────┘ │

│ │ │

├─────────────────────┼───────────────────────────────────────────┤

│ ✓ 架构简单 │ ✓ 任务并行处理 │

│ ✓ 部署成本低 │ ✓ 专业分工协作 │

│ ✓ 调试容易 │ ✓ 容错能力强 │

│ ✓ 响应速度快 │ ✓ 可扩展性好 │

│ ✗ 能力边界明确 │ ✗ 协调开销大 │

│ ✗ 难以并行 │ ✗ 调试复杂 │

└─────────────────────┴───────────────────────────────────────────┘💡 思考:什么时候应该选择单智能体,什么时候应该选择多智能体?

🤔 解答:

选择单智能体的场景:

- 任务领域相对单一(如代码补全、文档生成)

- 需要快速响应和低延迟

- 开发资源有限,需要快速迭代

- 任务间依赖性强,难以并行化

选择多智能体的场景:

- 任务涉及多个专业领域

- 需要模拟社会化交互(如辩论、协商)

- 任务可以自然分解为并行子任务

- 系统需要高容错性和可扩展性

2.3 核心架构解析

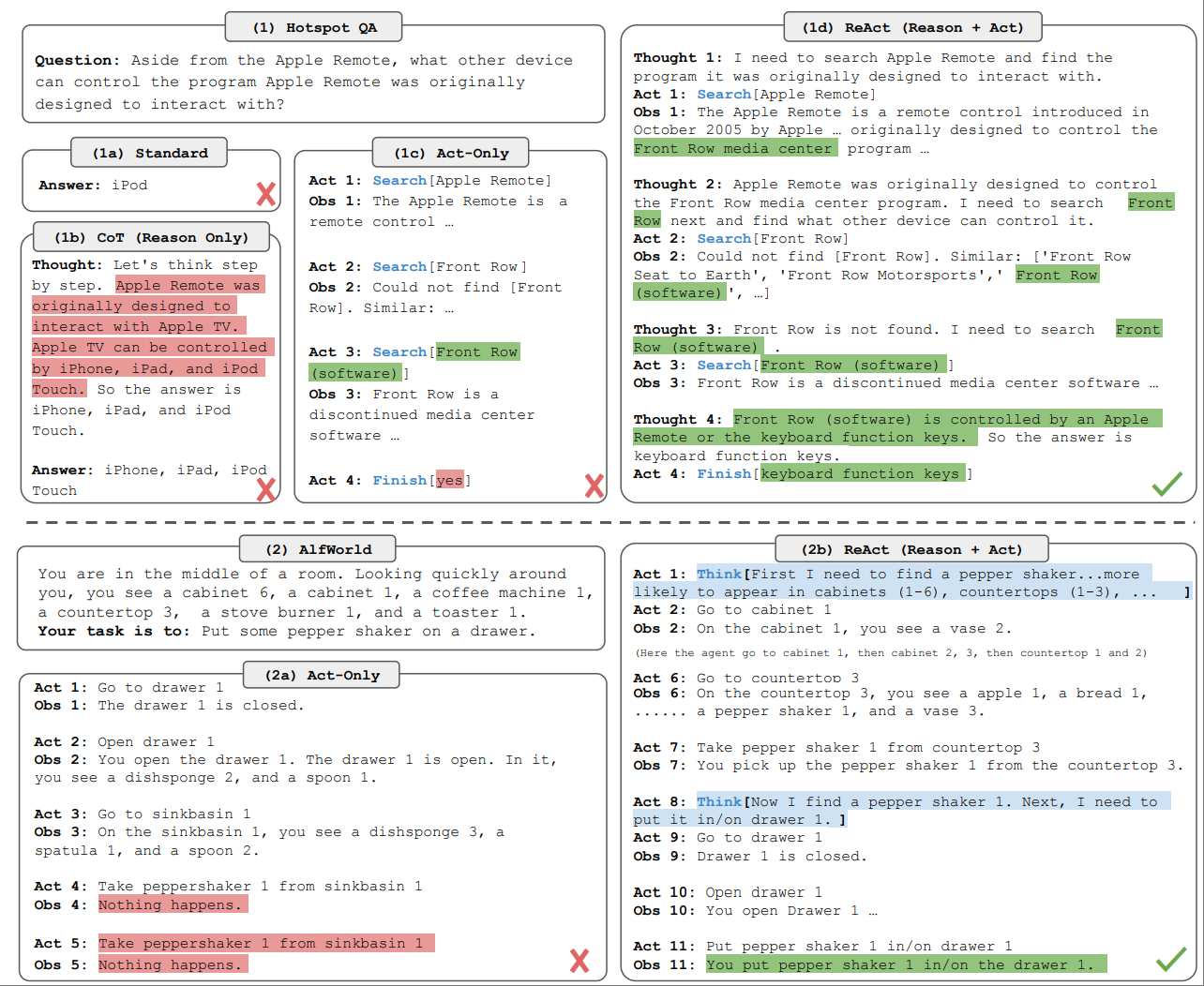

现代单智能体的架构设计通常遵循 ReAct(Reasoning + Acting) 范式,这是一种将推理和行动紧密结合的设计模式:

python

"""

ReAct 架构的核心循环

"""

class SingleAgent:

def __init__(self, llm, tools, memory):

self.llm = llm # 推理核心

self.tools = tools # 可用工具集

self.memory = memory # 记忆系统

def run(self, task: str) -> str:

"""

ReAct 主循环:Thought -> Action -> Observation -> ...

"""

self.memory.add("user", task)

while True:

# 1. Thought: 分析当前状态,决定下一步

thought = self.think()

# 2. 检查是否完成

if thought.is_final_answer:

return thought.answer

# 3. Action: 选择并执行工具

action = self.select_action(thought)

# 4. Observation: 获取执行结果

observation = self.execute(action)

# 5. 更新记忆

self.memory.add("thought", thought)

self.memory.add("action", action)

self.memory.add("observation", observation)

def think(self) -> Thought:

"""基于当前上下文进行推理"""

context = self.memory.get_context()

response = self.llm.generate(

prompt=self._build_think_prompt(context)

)

return self._parse_thought(response)

def select_action(self, thought: Thought) -> Action:

"""根据思考结果选择行动"""

available_tools = self.tools.list()

return self.llm.select_tool(thought, available_tools)

def execute(self, action: Action) -> Observation:

"""执行选定的行动并返回观察结果"""

tool = self.tools.get(action.tool_name)

result = tool.execute(action.parameters)

return Observation(result)这个架构的精妙之处在于:

- 思考与行动交替:模拟人类解决问题的自然过程

- 记忆驱动决策:每一步都基于完整的历史上下文

- 工具扩展能力:通过工具调用扩展Agent的能力边界

- 自我修正机制:观察结果反馈到下一轮思考

3. 任务执行:从感知到行动

3.1 任务分解与规划

任务分解是单智能体处理复杂问题的关键能力。一个好的任务分解策略能够将看似不可能的大任务转化为一系列可执行的小步骤。

┌─────────────────────────────────────────────────────────────────┐

│ 任务分解策略对比 │

├─────────────────────────────────────────────────────────────────┤

│ │

│ 【线性分解】 【层次分解】 【动态分解】 │

│ │

│ Task Task Task │

│ │ │ │ │

│ ▼ ┌────┴────┐ ▼ │

│ Step 1 │ │ ┌───────┐ │

│ │ SubTask A SubTask B │Step 1 │ │

│ ▼ │ │ │ │ └───┬───┘ │

│ Step 2 s1 s2 s3 s4 │ │

│ │ ▼ │

│ ▼ ┌───────┐ │

│ Step 3 │Step 2 │ ← 根据 │

│ │ └───┬───┘ Step1 │

│ ▼ │ 结果 │

│ Result ▼ 动态 │

│ ┌───────┐ 生成 │

│ 适用:简单流程 适用:可并行任务 │Step N │ │

│ └───────┘ │

│ 适用:不确定性任务 │

└─────────────────────────────────────────────────────────────────┘任务分解的实现示例:

python

from typing import List, Optional

from dataclasses import dataclass

from enum import Enum

class DecompositionStrategy(Enum):

LINEAR = "linear" # 线性分解

HIERARCHICAL = "hier" # 层次分解

DYNAMIC = "dynamic" # 动态分解

@dataclass

class SubTask:

id: str

description: str

dependencies: List[str]

status: str = "pending"

result: Optional[str] = None

class TaskPlanner:

def __init__(self, llm, strategy: DecompositionStrategy):

self.llm = llm

self.strategy = strategy

def decompose(self, task: str) -> List[SubTask]:

"""

将复杂任务分解为子任务列表

"""

if self.strategy == DecompositionStrategy.LINEAR:

return self._linear_decompose(task)

elif self.strategy == DecompositionStrategy.HIERARCHICAL:

return self._hierarchical_decompose(task)

else:

return self._dynamic_decompose(task)

def _linear_decompose(self, task: str) -> List[SubTask]:

"""线性分解:生成顺序执行的步骤"""

prompt = f"""

请将以下任务分解为顺序执行的步骤:

任务:{task}

要求:

1. 每个步骤应该是原子性的、可执行的

2. 步骤之间有明确的先后顺序

3. 输出格式:Step 1: xxx\nStep 2: xxx\n...

"""

response = self.llm.generate(prompt)

return self._parse_linear_steps(response)

def _hierarchical_decompose(self, task: str) -> List[SubTask]:

"""层次分解:生成可并行的子任务树"""

prompt = f"""

请将以下任务分解为层次化的子任务结构:

任务:{task}

要求:

1. 识别可以并行执行的独立子任务

2. 标注子任务之间的依赖关系

3. 输出JSON格式的任务树

"""

response = self.llm.generate(prompt)

return self._parse_task_tree(response)

def _dynamic_decompose(self, task: str) -> List[SubTask]:

"""动态分解:根据执行结果逐步生成下一步"""

# 初始只生成第一步

first_step = self._generate_next_step(task, [])

return [first_step]

def generate_next_step(self, task: str,

completed: List[SubTask]) -> Optional[SubTask]:

"""动态生成下一个步骤"""

context = self._build_context(task, completed)

prompt = f"""

任务:{task}

已完成步骤:

{context}

请判断:

1. 任务是否已完成?如果是,回复 "DONE"

2. 如果未完成,生成下一个需要执行的步骤

"""

response = self.llm.generate(prompt)

if "DONE" in response:

return None

return self._parse_single_step(response)💡 思考:为什么动态分解策略在很多场景下优于静态分解?

🤔 解答:

- 适应不确定性:很多任务在执行前无法完全预知所有步骤,动态分解可以根据中间结果调整计划

- 减少浪费:静态分解可能生成很多最终不需要的步骤,动态分解按需生成

- 更好的错误处理:当某一步失败时,动态分解可以灵活地生成替代方案

- 保持上下文相关性:每一步的生成都基于最新的执行状态,决策更加准确

3.2 工具调用与执行

工具调用是单智能体"动手能力"的核心。通过工具,Agent可以突破纯文本交互的限制,与真实世界进行交互。

┌─────────────────────────────────────────────────────────────────┐

│ 工具调用流程 │

├─────────────────────────────────────────────────────────────────┤

│ │

│ 用户请求: "帮我查询北京今天的天气,然后生成一份出行建议" │

│ │

│ │ │

│ ▼ │

│ ┌──────────────────────────┐ │

│ │ LLM 分析与规划 │ │

│ │ 1. 需要查询天气 │ │

│ │ 2. 基于天气生成建议 │ │

│ └────────────┬─────────────┘ │

│ │ │

│ ┌───────────┴───────────┐ │

│ ▼ ▼ │

│ ┌─────────────────┐ ┌─────────────────┐ │

│ │ Tool Selection │ │ 参数构造 │ │

│ │ → weather_api │ │ → city="北京" │ │

│ └────────┬────────┘ └────────┬────────┘ │

│ │ │ │

│ └──────────┬───────────┘ │

│ ▼ │

│ ┌──────────────────────────┐ │

│ │ 工具执行引擎 │ │

│ │ weather_api(city="北京") │ │

│ └────────────┬─────────────┘ │

│ │ │

│ ▼ │

│ ┌──────────────────────────┐ │

│ │ 结果:晴,25°C,微风 │ │

│ └────────────┬─────────────┘ │

│ │ │

│ ▼ │

│ ┌──────────────────────────┐ │

│ │ LLM 整合生成最终回答 │ │

│ │ "北京今天天气晴朗..." │ │

│ └──────────────────────────┘ │

│ │

└─────────────────────────────────────────────────────────────────┘工具系统的实现:

python

from typing import Callable, Dict, Any, List

from dataclasses import dataclass

import json

@dataclass

class Tool:

name: str

description: str

parameters: Dict[str, Any] # JSON Schema

function: Callable

class ToolRegistry:

def __init__(self):

self.tools: Dict[str, Tool] = {}

def register(self, tool: Tool):

"""注册工具"""

self.tools[tool.name] = tool

def get_tools_schema(self) -> List[Dict]:

"""获取所有工具的JSON Schema(用于LLM)"""

return [

{

"type": "function",

"function": {

"name": tool.name,

"description": tool.description,

"parameters": tool.parameters

}

}

for tool in self.tools.values()

]

def execute(self, tool_name: str, **kwargs) -> Any:

"""执行指定工具"""

if tool_name not in self.tools:

raise ValueError(f"Tool {tool_name} not found")

tool = self.tools[tool_name]

return tool.function(**kwargs)

class ToolExecutor:

def __init__(self, llm, registry: ToolRegistry):

self.llm = llm

self.registry = registry

def run_with_tools(self, user_message: str) -> str:

"""带工具调用的对话"""

messages = [{"role": "user", "content": user_message}]

tools_schema = self.registry.get_tools_schema()

while True:

# 调用LLM,可能返回工具调用请求

response = self.llm.chat(

messages=messages,

tools=tools_schema,

tool_choice="auto"

)

# 检查是否有工具调用

if response.tool_calls:

for tool_call in response.tool_calls:

# 执行工具

result = self.registry.execute(

tool_call.function.name,

**json.loads(tool_call.function.arguments)

)

# 将结果加入对话

messages.append({

"role": "tool",

"tool_call_id": tool_call.id,

"content": str(result)

})

else:

# 没有工具调用,返回最终答案

return response.content

# 使用示例

registry = ToolRegistry()

# 注册天气查询工具

registry.register(Tool(

name="get_weather",

description="查询指定城市的天气信息",

parameters={

"type": "object",

"properties": {

"city": {

"type": "string",

"description": "城市名称"

}

},

"required": ["city"]

},

function=lambda city: f"北京今天天气:晴,温度25°C,微风"

))

# 注册搜索工具

registry.register(Tool(

name="web_search",

description="在网络上搜索信息",

parameters={

"type": "object",

"properties": {

"query": {

"type": "string",

"description": "搜索关键词"

}

},

"required": ["query"]

},

function=lambda query: f"搜索结果:关于'{query}'的相关信息..."

))3.3 反馈循环与自我修正

单智能体的一个重要特性是能够从执行结果中学习并自我修正。这种能力使Agent能够处理不确定的环境和意外情况。

┌─────────────────────────────────────────────────────────────────┐

│ 自我修正机制 │

├─────────────────────────────────────────────────────────────────┤

│ │

│ ┌─────────┐ │

│ │ 任务 │ │

│ └────┬────┘ │

│ │ │

│ ┌──────────────┼──────────────┐ │

│ │ ▼ │ │

│ │ ┌─────────────┐ │ │

│ │ │ 执行计划 │ │ │

│ │ └──────┬──────┘ │ │

│ │ │ │ │

│ │ ▼ │ │

│ ┌───────┐ │ ┌─────────────┐ │ ┌───────┐ │

│ │ 成功 │◄──┼──────│ 执行行动 │ │ │ 失败 │ │

│ └───┬───┘ │ └──────┬──────┘ │ └───┬───┘ │

│ │ │ │ │ │ │

│ │ │ ▼ │ │ │

│ │ │ ┌─────────────┐ │ │ │

│ │ │ │ 观察结果 │────────┼───────┤ │

│ │ │ └──────┬──────┘ │ │ │

│ │ │ │ │ │ │

│ │ │ ▼ │ ▼ │

│ │ │ ┌─────────────┐ ┌────────────────┐ │

│ │ │ │ 结果评估 │ │ 错误分析 │ │

│ │ │ └──────┬──────┘ └───────┬────────┘ │

│ │ │ │ │ │

│ │ │ 成功? │ 否 │ │

│ │ │ ▼ ───────────────┘ │

│ │ │ ┌─────────────┐ │

│ │ └──────│ 调整策略 │────────────────┐ │

│ │ └─────────────┘ │ │

│ │ │ │

│ ▼ ▼ │

│ ┌───────────────────────────────────────────────────┐ │

│ │ 完成任务 │ │

│ └───────────────────────────────────────────────────┘ │

│ │

└─────────────────────────────────────────────────────────────────┘自我修正的实现:

python

from dataclasses import dataclass

from typing import Optional, List

from enum import Enum

class ExecutionStatus(Enum):

SUCCESS = "success"

FAILURE = "failure"

PARTIAL = "partial"

@dataclass

class ExecutionResult:

status: ExecutionStatus

output: Any

error: Optional[str] = None

class SelfCorrectingAgent:

def __init__(self, llm, tools, max_retries: int = 3):

self.llm = llm

self.tools = tools

self.max_retries = max_retries

self.execution_history: List[dict] = []

def execute_with_correction(self, task: str) -> str:

"""带自我修正的任务执行"""

for attempt in range(self.max_retries):

# 1. 生成执行计划

plan = self._generate_plan(task, attempt)

# 2. 执行计划

result = self._execute_plan(plan)

# 3. 评估结果

evaluation = self._evaluate_result(task, result)

# 4. 记录历史

self.execution_history.append({

"attempt": attempt,

"plan": plan,

"result": result,

"evaluation": evaluation

})

# 5. 判断是否成功

if evaluation["success"]:

return result.output

# 6. 分析失败原因并调整

if attempt < self.max_retries - 1:

self._analyze_and_adjust(evaluation)

# 达到最大重试次数

return self._generate_best_effort_response(task)

def _generate_plan(self, task: str, attempt: int) -> List[dict]:

"""生成执行计划,考虑历史失败"""

history_context = ""

if attempt > 0:

history_context = self._format_history()

prompt = f"""

任务:{task}

{history_context}

请生成一个执行计划。如果之前有失败的尝试,请避免相同的错误。

"""

response = self.llm.generate(prompt)

return self._parse_plan(response)

def _evaluate_result(self, task: str,

result: ExecutionResult) -> dict:

"""评估执行结果"""

prompt = f"""

任务:{task}

执行结果:{result.output}

错误信息:{result.error}

请评估:

1. 任务是否成功完成?(success: true/false)

2. 如果失败,原因是什么?(failure_reason)

3. 有什么改进建议?(suggestions)

以JSON格式输出。

"""

response = self.llm.generate(prompt)

return json.loads(response)

def _analyze_and_adjust(self, evaluation: dict):

"""分析失败原因并调整策略"""

failure_reason = evaluation.get("failure_reason", "")

suggestions = evaluation.get("suggestions", [])

# 根据失败原因调整

if "tool_error" in failure_reason:

# 工具调用失败,可能需要换一个工具

self._adjust_tool_preference()

elif "timeout" in failure_reason:

# 超时,可能需要简化任务

self._simplify_approach()

elif "invalid_output" in failure_reason:

# 输出格式错误,加强格式约束

self._strengthen_format_constraints()4. 代码助手:编程的智能伙伴

代码助手是单智能体应用中最成功、最广泛使用的类型之一。它们通过理解代码上下文,为开发者提供智能补全、代码生成、错误修复等能力,极大地提升了开发效率。

4.1 GitHub Copilot:开创者的征程

GitHub Copilot 是由 GitHub 和 OpenAI 合作开发的 AI 编程助手,于 2021 年首次发布,被认为是 AI 辅助编程的里程碑式产品。

┌─────────────────────────────────────────────────────────────────┐

│ GitHub Copilot 发展历程 │

├─────────────────────────────────────────────────────────────────┤

│ │

│ 2021.06 2022.06 2023.03 2024 │

│ │ │ │ │ │

│ ▼ ▼ ▼ ▼ │

│ ┌───────┐ ┌───────────┐ ┌──────────┐ ┌──────────┐ │

│ │Preview│ │ GA │ │ Copilot │ │ Copilot │ │

│ │发布 │ │ 正式发布 │ │ Chat │ │Workspace │ │

│ └───────┘ └───────────┘ └──────────┘ └──────────┘ │

│ │

│ • 代码补全 • 商业化 • 对话式交互 • 多文件理解 │

│ • 函数生成 • 企业版 • 代码解释 • 项目级上下文 │

│ • 注释转代码 • 安全过滤 • 错误修复 • Agent能力 │

│ │

└─────────────────────────────────────────────────────────────────┘Copilot 的核心能力:

| 功能 | 描述 | 典型场景 |

|---|---|---|

| 代码补全 | 基于上下文预测下一行代码 | 日常编码 |

| 函数生成 | 根据函数签名生成完整实现 | 快速原型 |

| 注释转代码 | 将自然语言注释转换为代码 | 需求实现 |

| 代码解释 | 用自然语言解释代码逻辑 | 代码审查 |

| Bug修复 | 识别并修复代码问题 | 调试维护 |

| 测试生成 | 自动生成单元测试 | 质量保障 |

Copilot 工作原理示例:

python

# 示例:Copilot 如何理解上下文并生成代码

# 输入:用户输入函数签名和注释

def calculate_fibonacci(n: int) -> int:

"""

计算第n个斐波那契数

使用动态规划优化,避免重复计算

Args:

n: 要计算的斐波那契数的位置(从0开始)

Returns:

第n个斐波那契数

"""

# Copilot 补全 ↓

if n <= 1:

return n

dp = [0] * (n + 1)

dp[1] = 1

for i in range(2, n + 1):

dp[i] = dp[i-1] + dp[i-2]

return dp[n]

# Copilot 还能根据使用场景推断需求

class DataProcessor:

def __init__(self, data: list):

self.data = data

# 输入方法名,Copilot 推断实现

def filter_positive(self): # Copilot 补全 ↓

"""过滤出所有正数"""

return [x for x in self.data if x > 0]

def calculate_average(self): # Copilot 补全 ↓

"""计算平均值"""

if not self.data:

return 0

return sum(self.data) / len(self.data)

def normalize(self): # Copilot 补全 ↓

"""归一化数据到0-1范围"""

min_val = min(self.data)

max_val = max(self.data)

if max_val == min_val:

return [0.5] * len(self.data)

return [(x - min_val) / (max_val - min_val) for x in self.data]4.2 Cursor:AI-First的IDE革命

Cursor 是一款专为 AI 编程设计的代码编辑器,它不是在现有 IDE 上添加 AI 功能,而是从零开始设计,将 AI 能力作为核心特性。

┌─────────────────────────────────────────────────────────────────┐

│ Cursor 核心功能架构 │

├─────────────────────────────────────────────────────────────────┤

│ │

│ ┌─────────────────────────────────────────────────────────┐ │

│ │ Cursor IDE │ │

│ │ ┌──────────────────────────────────────────────────┐ │ │

│ │ │ 用户界面层 │ │ │

│ │ │ ┌────────┐ ┌────────┐ ┌────────┐ ┌────────┐ │ │ │

│ │ │ │代码编辑│ │聊天面板│ │差异视图│ │终端 │ │ │ │

│ │ │ └────────┘ └────────┘ └────────┘ └────────┘ │ │ │

│ │ └──────────────────────────────────────────────────┘ │ │

│ │ │ │ │

│ │ ┌──────────────────────────────────────────────────┐ │ │

│ │ │ AI 能力层 │ │ │

│ │ │ ┌──────────┐ ┌──────────┐ ┌──────────────────┐ │ │ │

│ │ │ │Tab补全 │ │Cmd+K编辑│ │Chat代码库问答 │ │ │ │

│ │ │ │智能预测 │ │自然语言 │ │@引用上下文 │ │ │ │

│ │ │ │多行建议 │ │代码修改 │ │跨文件理解 │ │ │ │

│ │ │ └──────────┘ └──────────┘ └──────────────────┘ │ │ │

│ │ └──────────────────────────────────────────────────┘ │ │

│ │ │ │ │

│ │ ┌──────────────────────────────────────────────────┐ │ │

│ │ │ 上下文引擎 │ │ │

│ │ │ ┌──────────┐ ┌──────────┐ ┌──────────────────┐ │ │ │

│ │ │ │代码索引 │ │符号分析 │ │语义搜索 │ │ │ │

│ │ │ │向量嵌入 │ │依赖图谱 │ │相关性排序 │ │ │ │

│ │ │ └──────────┘ └──────────┘ └──────────────────┘ │ │ │

│ │ └──────────────────────────────────────────────────┘ │ │

│ └─────────────────────────────────────────────────────────┘ │

│ │

└─────────────────────────────────────────────────────────────────┘Cursor 的创新特性:

1. Cmd+K 自然语言编辑

python

# 选中代码后按 Cmd+K,输入自然语言指令

# 原代码:

def process_data(data):

result = []

for item in data:

if item > 0:

result.append(item * 2)

return result

# 输入指令:"添加错误处理和类型注解"

# Cursor 生成:

from typing import List, Union

def process_data(data: List[Union[int, float]]) -> List[Union[int, float]]:

"""

处理数据:过滤正数并翻倍

Args:

data: 输入的数值列表

Returns:

处理后的数值列表

Raises:

TypeError: 如果输入不是列表

ValueError: 如果列表包含非数值元素

"""

if not isinstance(data, list):

raise TypeError("输入必须是列表")

result = []

for item in data:

if not isinstance(item, (int, float)):

raise ValueError(f"列表元素必须是数值类型,得到: {type(item)}")

if item > 0:

result.append(item * 2)

return result2. @符号引用上下文

python

# 在聊天中使用 @ 引用文件、函数、类等

# 用户输入:

# "@models.py 中的 User 类需要添加邮箱验证功能,

# 参考 @utils/validators.py 中的验证器风格"

# Cursor 理解上下文并生成:

# models.py

import re

from utils.validators import BaseValidator

class User:

def __init__(self, name: str, email: str):

self.name = name

self._email = None

self.email = email # 触发验证

@property

def email(self) -> str:

return self._email

@email.setter

def email(self, value: str):

if not EmailValidator.validate(value):

raise ValueError(f"无效的邮箱地址: {value}")

self._email = value

class EmailValidator(BaseValidator):

"""邮箱验证器,遵循 utils/validators.py 的风格"""

EMAIL_PATTERN = re.compile(

r'^[a-zA-Z0-9._%+-]+@[a-zA-Z0-9.-]+\.[a-zA-Z]{2,}$'

)

@classmethod

def validate(cls, value: str) -> bool:

if not value or not isinstance(value, str):

return False

return bool(cls.EMAIL_PATTERN.match(value))

@classmethod

def get_error_message(cls) -> str:

return "请输入有效的邮箱地址"3. Composer 多文件编辑

┌─────────────────────────────────────────────────────────────────┐

│ Cursor Composer 工作流程 │

├─────────────────────────────────────────────────────────────────┤

│ │

│ 用户需求: "创建一个简单的 REST API,包含用户注册和登录功能" │

│ │

│ │ │

│ ▼ │

│ ┌──────────────────────────┐ │

│ │ Composer 分析需求 │ │

│ │ 识别需要创建的文件 │ │

│ └────────────┬─────────────┘ │

│ │ │

│ ┌─────────────────┼─────────────────┐ │

│ │ │ │ │

│ ▼ ▼ ▼ │

│ ┌─────────────┐ ┌─────────────┐ ┌─────────────┐ │

│ │ app.py │ │ models.py │ │ routes/ │ │

│ │ Flask应用 │ │ 用户模型 │ │ auth.py │ │

│ │ 初始化配置 │ │ 数据库定义 │ │ 注册登录 │ │

│ └─────────────┘ └─────────────┘ └─────────────┘ │

│ │

│ 同时生成: requirements.txt, config.py, tests/test_auth.py │

│ │

└─────────────────────────────────────────────────────────────────┘4.3 代码助手的技术原理

代码助手的核心是将代码理解问题转化为语言理解问题。这需要几个关键技术的支撑:

┌─────────────────────────────────────────────────────────────────┐

│ 代码助手技术栈 │

├─────────────────────────────────────────────────────────────────┤

│ │

│ ┌─────────────────────────────────────────────────────────┐ │

│ │ 代码理解层 │ │

│ │ │ │

│ │ ┌──────────────┐ ┌──────────────┐ ┌──────────────┐ │ │

│ │ │ AST │ │ LSP │ │ 语义向量 │ │ │

│ │ │ 抽象语法树 │ │ 语言服务 │ │ Embedding │ │ │

│ │ │ 结构解析 │ │ 符号分析 │ │ 相似搜索 │ │ │

│ │ └──────────────┘ └──────────────┘ └──────────────┘ │ │

│ └─────────────────────────────────────────────────────────┘ │

│ │ │

│ ▼ │

│ ┌─────────────────────────────────────────────────────────┐ │

│ │ 上下文构建层 │ │

│ │ │ │

│ │ ┌──────────────┐ ┌──────────────┐ ┌──────────────┐ │ │

│ │ │ 当前文件 │ │ 相关文件 │ │ 项目结构 │ │ │

│ │ │ 光标位置 │ │ 导入依赖 │ │ 配置信息 │ │ │

│ │ │ 局部上下文 │ │ 类型定义 │ │ 全局约束 │ │ │

│ │ └──────────────┘ └──────────────┘ └──────────────┘ │ │

│ └─────────────────────────────────────────────────────────┘ │

│ │ │

│ ▼ │

│ ┌─────────────────────────────────────────────────────────┐ │

│ │ LLM 推理层 │ │

│ │ │ │

│ │ Prompt = f""" │ │

│ │ # 文件: {filename} │ │

│ │ # 语言: {language} │ │

│ │ # 相关定义: {related_definitions} │ │

│ │ │ │

│ │ {code_context} │ │

│ │ <CURSOR> ← 在此处生成代码 │ │

│ │ """ │ │

│ │ │ │

│ └─────────────────────────────────────────────────────────┘ │

│ │ │

│ ▼ │

│ ┌─────────────────────────────────────────────────────────┐ │

│ │ 后处理层 │ │

│ │ │ │

│ │ ┌──────────────┐ ┌──────────────┐ ┌──────────────┐ │ │

│ │ │ 语法验证 │ │ 格式化 │ │ 排序过滤 │ │ │

│ │ │ 确保可编译 │ │ 代码风格 │ │ 最佳建议 │ │ │

│ │ └──────────────┘ └──────────────┘ └──────────────┘ │ │

│ └─────────────────────────────────────────────────────────┘ │

│ │

└─────────────────────────────────────────────────────────────────┘💡 思考:代码补全看起来"只是"预测下一个token,为什么实际上如此复杂?

🤔 解答:

- 上下文的稀疏性:代码的关键信息可能分散在多个文件中,需要智能地检索和组装

- 语义的精确性:代码必须语法正确、类型匹配,容错空间比自然语言小得多

- 风格的一致性:生成的代码需要与项目现有风格保持一致

- 安全的考量:需要避免生成有安全漏洞的代码

- 实时性要求:开发者期望即时响应,需要在极短时间内完成复杂的上下文分析

4.4 实战:构建简易代码助手

让我们实现一个简化版的代码助手,理解其核心原理:

python

"""

简易代码助手实现

演示代码补全的核心流程

"""

import ast

import re

from dataclasses import dataclass

from typing import List, Optional, Dict, Any

import os

@dataclass

class CodeContext:

"""代码上下文"""

file_path: str

language: str

cursor_line: int

cursor_column: int

prefix: str # 光标前的代码

suffix: str # 光标后的代码

imports: List[str] # 导入语句

definitions: List[str] # 相关定义

@dataclass

class Completion:

"""代码补全建议"""

text: str

score: float

description: str

class CodeAnalyzer:

"""代码分析器:提取上下文信息"""

def __init__(self):

self.language_patterns = {

'python': {

'import': r'^(?:from\s+\S+\s+)?import\s+.+$',

'function': r'^(?:async\s+)?def\s+(\w+)',

'class': r'^class\s+(\w+)',

},

'javascript': {

'import': r'^import\s+.+$|^const\s+.+=\s*require',

'function': r'^(?:async\s+)?function\s+(\w+)|^const\s+(\w+)\s*=',

'class': r'^class\s+(\w+)',

}

}

def analyze_file(self, code: str, language: str) -> Dict[str, Any]:

"""分析代码文件,提取结构信息"""

patterns = self.language_patterns.get(language, {})

imports = []

functions = []

classes = []

for line in code.split('\n'):

line = line.strip()

# 提取导入

if patterns.get('import') and re.match(patterns['import'], line):

imports.append(line)

# 提取函数定义

if patterns.get('function'):

match = re.match(patterns['function'], line)

if match:

func_name = match.group(1) or match.group(2)

if func_name:

functions.append(func_name)

# 提取类定义

if patterns.get('class'):

match = re.match(patterns['class'], line)

if match:

classes.append(match.group(1))

return {

'imports': imports,

'functions': functions,

'classes': classes

}

def get_local_context(self, code: str, cursor_pos: int,

window_size: int = 50) -> tuple:

"""获取光标周围的局部上下文"""

lines = code.split('\n')

# 计算光标所在行

current_line = 0

char_count = 0

for i, line in enumerate(lines):

if char_count + len(line) + 1 > cursor_pos:

current_line = i

break

char_count += len(line) + 1

# 获取前后代码窗口

start_line = max(0, current_line - window_size)

end_line = min(len(lines), current_line + window_size)

prefix = '\n'.join(lines[start_line:current_line + 1])

suffix = '\n'.join(lines[current_line + 1:end_line])

return prefix, suffix, current_line

class SimpleCodeAssistant:

"""简易代码助手"""

def __init__(self, llm_client):

self.llm = llm_client

self.analyzer = CodeAnalyzer()

self.project_index: Dict[str, Dict] = {}

def index_project(self, project_path: str):

"""索引项目文件"""

for root, dirs, files in os.walk(project_path):

# 跳过隐藏目录和常见的忽略目录

dirs[:] = [d for d in dirs if not d.startswith('.')

and d not in ['node_modules', '__pycache__', 'venv']]

for file in files:

if file.endswith(('.py', '.js', '.ts')):

file_path = os.path.join(root, file)

try:

with open(file_path, 'r', encoding='utf-8') as f:

code = f.read()

language = 'python' if file.endswith('.py') else 'javascript'

analysis = self.analyzer.analyze_file(code, language)

self.project_index[file_path] = {

'language': language,

'analysis': analysis,

'content': code

}

except Exception as e:

print(f"索引文件失败 {file_path}: {e}")

def find_relevant_definitions(self, symbol: str) -> List[str]:

"""查找符号的相关定义"""

definitions = []

for file_path, info in self.project_index.items():

analysis = info['analysis']

# 检查函数

if symbol in analysis['functions']:

# 提取函数定义

content = info['content']

# 简化处理:查找函数定义行

for i, line in enumerate(content.split('\n')):

if f'def {symbol}' in line or f'function {symbol}' in line:

# 提取函数签名和docstring

func_lines = content.split('\n')[i:i+10]

definitions.append('\n'.join(func_lines))

break

# 检查类

if symbol in analysis['classes']:

content = info['content']

for i, line in enumerate(content.split('\n')):

if f'class {symbol}' in line:

class_lines = content.split('\n')[i:i+20]

definitions.append('\n'.join(class_lines))

break

return definitions

def build_context(self, file_path: str, code: str,

cursor_pos: int) -> CodeContext:

"""构建代码上下文"""

# 检测语言

if file_path.endswith('.py'):

language = 'python'

elif file_path.endswith(('.js', '.ts')):

language = 'javascript'

else:

language = 'unknown'

# 获取局部上下文

prefix, suffix, cursor_line = self.analyzer.get_local_context(

code, cursor_pos

)

# 分析当前文件

analysis = self.analyzer.analyze_file(code, language)

# 提取可能需要的符号(简化:从prefix中提取标识符)

symbols = set(re.findall(r'\b([A-Z][a-zA-Z0-9_]*)\b', prefix))

# 查找相关定义

definitions = []

for symbol in symbols:

definitions.extend(self.find_relevant_definitions(symbol))

return CodeContext(

file_path=file_path,

language=language,

cursor_line=cursor_line,

cursor_column=0,

prefix=prefix,

suffix=suffix,

imports=analysis['imports'],

definitions=definitions[:5] # 限制数量

)

def generate_completion(self, context: CodeContext) -> List[Completion]:

"""生成代码补全建议"""

# 构建Prompt

prompt = f"""你是一个代码补全助手。请根据上下文生成最可能的代码补全。

## 文件信息

- 文件: {context.file_path}

- 语言: {context.language}

## 相关导入

{chr(10).join(context.imports[:10])}

## 相关定义

{chr(10).join(context.definitions)}

## 代码上下文

```{context.language}

{context.prefix}<CURSOR>

{context.suffix}请在位置生成代码补全。要求:

- 生成的代码应该语法正确

- 与上下文风格一致

- 只输出补全的代码,不要解释

补全代码:"""

# 调用LLM

response = self.llm.generate(prompt, max_tokens=200)

# 解析响应,生成补全建议

completions = self._parse_completions(response)

return completions

def _parse_completions(self, response: str) -> List[Completion]:

"""解析LLM响应为补全建议"""

# 清理响应

code = response.strip()

if code.startswith('```'):

# 移除代码块标记

lines = code.split('\n')

code = '\n'.join(lines[1:-1] if lines[-1] == '```' else lines[1:])

return [Completion(

text=code,

score=1.0,

description="AI生成的代码补全"

)]

def complete(self, file_path: str, code: str, cursor_pos: int) -> List[Completion]:

"""主入口:生成代码补全"""

context = self.build_context(file_path, code, cursor_pos)

return self.generate_completion(context)使用示例

if name == "main ":

模拟LLM客户端

class MockLLM:

def generate(self, prompt, max_tokens=100):

实际应用中这里调用真实的LLM API

return "return sum(self.data) / len(self.data) if self.data else 0"

assistant = SimpleCodeAssistant(MockLLM())

# 测试代码

test_code = '''class DataAnalyzer:

def init (self, data):

self.data = data

def calculate_average(self):

"""计算平均值"""

'''

completions = assistant.complete(

file_path="test.py",

code=test_code,

cursor_pos=len(test_code)

)

for comp in completions:

print(f"补全: {comp.text}")

print(f"得分: {comp.score}")

---

## 5. 研究助手:知识的导航员

研究助手是另一类重要的单智能体应用,它帮助用户在海量信息中导航,提供文献检索、总结分析、知识整合等能力。

### 5.1 研究助手的核心能力┌─────────────────────────────────────────────────────────────────┐

│ 研究助手能力图谱 │

├─────────────────────────────────────────────────────────────────┤

│ │

│ ┌─────────────┐ │

│ │ 研究助手 │ │

│ └──────┬──────┘ │

│ │ │

│ ┌─────────────┬───────┴───────┬─────────────┐ │

│ │ │ │ │ │

│ ▼ ▼ ▼ ▼ │

│ ┌───────────┐ ┌───────────┐ ┌───────────┐ ┌───────────┐ │

│ │ 信息检索 │ │ 内容理解 │ │ 知识整合 │ │ 创作辅助 │ │

│ │ │ │ │ │ │ │ │ │

│ │ • 文献搜索│ │ • 论文阅读│ │ • 知识图谱│ │ • 论文写作│ │

│ │ • 数据查找│ │ • 摘要提取│ │ • 观点对比│ │ • 参考管理│ │

│ │ • 专利检索│ │ • 关键发现│ │ • 时间线 │ │ • 格式规范│ │

│ │ • 网页抓取│ │ • 方法分析│ │ • 趋势分析│ │ • 语言润色│ │

│ └───────────┘ └───────────┘ └───────────┘ └───────────┘ │

│ │

│ ═══════════════════════════════════════════════════════════ │

│ │

│ 【典型工作流程】 │

│ │

│ 研究问题 ──► 文献检索 ──► 筛选阅读 ──► 信息提取 ──► 综述生成 │

│ │ │ │ │

│ └─────────反馈循环────────┴────────────┘ │

│ │

└─────────────────────────────────────────────────────────────────┘

### 5.2 典型应用场景

**场景一:文献综述辅助**用户需求:我正在研究"大语言模型在医疗诊断中的应用",

帮我找出最近两年的重要论文,并总结主要研究方向。

研究助手工作流程:

┌────────────────────────────────────────────────────────────────┐

│ │

│ 1. 【关键词扩展】 │

│ 原始: "大语言模型 医疗诊断" │

│ 扩展: "LLM clinical diagnosis", "GPT medical", │

│ "AI healthcare", "NLP medical imaging"... │

│ │

│ 2. 【多源检索】 │

│ ├── PubMed: 医学文献 (328篇) │

│ ├── arXiv: 预印本 (156篇) │

│ ├── Google Scholar: 综合 (412篇) │

│ └── Semantic Scholar: 引用分析 │

│ │

│ 3. 【智能筛选】 │

│ • 相关性评分 > 0.7 │

│ • 引用数 > 10 或 发表于顶会/顶刊 │

│ • 时间: 2023-2024 │

│ → 筛选后: 45篇核心论文 │

│ │

│ 4. 【深度分析】 │

│ 对每篇论文提取: │

│ • 研究问题 • 方法创新 • 主要结论 • 局限性 │

│ │

│ 5. 【综述生成】 │

│ 按主题聚类,生成结构化综述: │

│ • 诊断辅助 (18篇) │

│ • 病历理解 (12篇) │

│ • 医患对话 (9篇) │

│ • 药物研发 (6篇) │

│ │

└────────────────────────────────────────────────────────────────┘

**场景二:竞品分析研究**用户需求:分析国内外主要的AI编程助手产品,

对比它们的技术路线和商业模式。

研究助手输出:

┌────────────────────────────────────────────────────────────────┐

│ AI编程助手竞品分析报告 │

├────────────────────────────────────────────────────────────────┤

│ │

│ 【产品对比矩阵】 │

│ ┌──────────┬────────────┬──────────┬──────────┬───────────┐ │

│ │ 产品 │ 核心模型 │ 技术特点 │ 定价模式 │ 目标市场 │ │

│ ├──────────┼────────────┼──────────┼──────────┼───────────┤ │

│ │ Copilot │ GPT-4/ │ 行内补全 │ $10-19/月│ 全球开发者│ │

│ │ │ Codex │ 多语言 │ 企业定制 │ │ │

│ ├──────────┼────────────┼──────────┼──────────┼───────────┤ │

│ │ Cursor │ GPT-4/ │ AI原生IDE │ $20/月 │ 专业开发者│ │

│ │ │ Claude │ 多文件 │ 企业版 │ │ │

│ ├──────────┼────────────┼──────────┼──────────┼───────────┤ │

│ │ CodeGeeX │ CodeGeeX2 │ 开源可控 │ 免费/企业│ 国内企业 │ │

│ │ │ (13B) │ 本地部署 │ │ │ │

│ ├──────────┼────────────┼──────────┼──────────┼───────────┤ │

│ │ 通义灵码 │ 通义千问 │ 阿里生态 │ 免费/付费│ 阿里云用户│ │

│ │ │ │ 企业集成 │ │ │ │

│ └──────────┴────────────┴──────────┴──────────┴───────────┘ │

│ │

│ 【技术趋势洞察】 │

│ 1. 从"代码补全"向"代码Agent"演进 │

│ 2. 上下文窗口扩大,支持项目级理解 │

│ 3. 本地模型 + 云端混合部署成为趋势 │

│ 4. IDE深度集成是差异化竞争的关键 │

│ │

└────────────────────────────────────────────────────────────────┘

### 5.3 实战:构建文献研究助手

```python

"""

文献研究助手实现

支持文献检索、摘要提取、知识整合

"""

from dataclasses import dataclass, field

from typing import List, Dict, Optional, Any

from datetime import datetime

import json

import asyncio

@dataclass

class Paper:

"""论文数据结构"""

title: str

authors: List[str]

abstract: str

year: int

venue: str

url: str

citations: int = 0

doi: Optional[str] = None

keywords: List[str] = field(default_factory=list)

# 分析结果

summary: Optional[str] = None

key_findings: List[str] = field(default_factory=list)

methodology: Optional[str] = None

relevance_score: float = 0.0

@dataclass

class ResearchQuery:

"""研究查询"""

topic: str

keywords: List[str]

date_range: tuple # (start_year, end_year)

min_citations: int = 0

sources: List[str] = field(default_factory=lambda: ['arxiv', 'semantic_scholar'])

class LiteratureSearcher:

"""文献检索器"""

def __init__(self):

self.search_apis = {

'arxiv': self._search_arxiv,

'semantic_scholar': self._search_semantic_scholar,

'pubmed': self._search_pubmed

}

async def search(self, query: ResearchQuery) -> List[Paper]:

"""在多个源中并行搜索"""

tasks = []

for source in query.sources:

if source in self.search_apis:

tasks.append(self._search_source(source, query))

results = await asyncio.gather(*tasks, return_exceptions=True)

# 合并去重

all_papers = []

seen_titles = set()

for result in results:

if isinstance(result, list):

for paper in result:

if paper.title.lower() not in seen_titles:

seen_titles.add(paper.title.lower())

all_papers.append(paper)

return all_papers

async def _search_source(self, source: str, query: ResearchQuery) -> List[Paper]:

"""搜索单个源"""

search_func = self.search_apis[source]

return await search_func(query)

async def _search_arxiv(self, query: ResearchQuery) -> List[Paper]:

"""搜索arXiv"""

# 实际实现中调用arXiv API

# 这里返回模拟数据

return [

Paper(

title="Large Language Models for Clinical Decision Support",

authors=["Alice Smith", "Bob Johnson"],

abstract="This paper explores the application of LLMs in clinical settings...",

year=2024,

venue="arXiv",

url="https://arxiv.org/abs/2401.xxxxx",

citations=45,

keywords=["LLM", "clinical", "decision support"]

)

]

async def _search_semantic_scholar(self, query: ResearchQuery) -> List[Paper]:

"""搜索Semantic Scholar"""

# 实际实现中调用Semantic Scholar API

return []

async def _search_pubmed(self, query: ResearchQuery) -> List[Paper]:

"""搜索PubMed"""

# 实际实现中调用PubMed API

return []

class PaperAnalyzer:

"""论文分析器"""

def __init__(self, llm_client):

self.llm = llm_client

async def analyze_paper(self, paper: Paper) -> Paper:

"""分析单篇论文"""

prompt = f"""请分析以下论文摘要,提取关键信息:

标题:{paper.title}

作者:{', '.join(paper.authors)}

摘要:{paper.abstract}

请提供:

1. 一句话总结(50字以内)

2. 主要发现(3-5条)

3. 研究方法概述

4. 与"大语言模型在医疗中的应用"的相关性评分(0-1)

以JSON格式输出:

{{

"summary": "...",

"key_findings": ["...", "..."],

"methodology": "...",

"relevance_score": 0.8

}}

"""

response = await self.llm.agenerate(prompt)

try:

analysis = json.loads(response)

paper.summary = analysis.get('summary')

paper.key_findings = analysis.get('key_findings', [])

paper.methodology = analysis.get('methodology')

paper.relevance_score = analysis.get('relevance_score', 0.0)

except json.JSONDecodeError:

pass

return paper

async def analyze_batch(self, papers: List[Paper],

concurrency: int = 5) -> List[Paper]:

"""批量分析论文"""

semaphore = asyncio.Semaphore(concurrency)

async def analyze_with_limit(paper):

async with semaphore:

return await self.analyze_paper(paper)

tasks = [analyze_with_limit(paper) for paper in papers]

return await asyncio.gather(*tasks)

class KnowledgeSynthesizer:

"""知识综合器"""

def __init__(self, llm_client):

self.llm = llm_client

def cluster_papers(self, papers: List[Paper]) -> Dict[str, List[Paper]]:

"""按主题聚类论文"""

# 简化实现:基于关键词聚类

clusters = {}

for paper in papers:

# 确定主要主题

topic = self._determine_topic(paper)

if topic not in clusters:

clusters[topic] = []

clusters[topic].append(paper)

return clusters

def _determine_topic(self, paper: Paper) -> str:

"""确定论文主题"""

keywords = paper.keywords + paper.title.lower().split()

topic_keywords = {

"诊断辅助": ["diagnosis", "diagnostic", "detection", "screening"],

"病历理解": ["ehr", "medical record", "clinical note", "documentation"],

"医患对话": ["conversation", "dialogue", "chatbot", "communication"],

"药物研发": ["drug", "pharmaceutical", "compound", "discovery"]

}

for topic, kws in topic_keywords.items():

if any(kw in ' '.join(keywords).lower() for kw in kws):

return topic

return "其他"

async def generate_review(self, papers: List[Paper],

topic: str) -> str:

"""生成文献综述"""

clusters = self.cluster_papers(papers)

# 按相关性排序

for topic_name in clusters:

clusters[topic_name].sort(

key=lambda p: p.relevance_score,

reverse=True

)

# 构建综述

review_prompt = f"""请根据以下论文信息,生成一份关于"{topic}"的文献综述。

## 论文列表

"""

for topic_name, topic_papers in clusters.items():

review_prompt += f"\n### {topic_name}({len(topic_papers)}篇)\n"

for paper in topic_papers[:5]: # 每个主题最多5篇

review_prompt += f"""

- **{paper.title}** ({paper.year})

- 摘要:{paper.summary or paper.abstract[:200]}

- 关键发现:{'; '.join(paper.key_findings[:3])}

"""

review_prompt += """

请生成结构化的文献综述,包括:

1. 研究背景与意义

2. 各研究方向的主要进展

3. 研究趋势与未来方向

4. 当前研究的局限性

综述应该学术严谨,引用具体论文支持观点。

"""

return await self.llm.agenerate(review_prompt)

class ResearchAssistant:

"""研究助手主类"""

def __init__(self, llm_client):

self.llm = llm_client

self.searcher = LiteratureSearcher()

self.analyzer = PaperAnalyzer(llm_client)

self.synthesizer = KnowledgeSynthesizer(llm_client)

async def research(self, topic: str,

num_papers: int = 50) -> Dict[str, Any]:

"""执行完整的研究流程"""

# 1. 扩展关键词

keywords = await self._expand_keywords(topic)

print(f"关键词扩展: {keywords}")

# 2. 构建查询

query = ResearchQuery(

topic=topic,

keywords=keywords,

date_range=(2022, 2024),

min_citations=5

)

# 3. 检索文献

papers = await self.searcher.search(query)

print(f"检索到 {len(papers)} 篇论文")

# 4. 分析论文

analyzed_papers = await self.analyzer.analyze_batch(papers[:num_papers])

print(f"分析完成 {len(analyzed_papers)} 篇论文")

# 5. 筛选高相关论文

relevant_papers = [p for p in analyzed_papers if p.relevance_score > 0.6]

print(f"高相关论文 {len(relevant_papers)} 篇")

# 6. 生成综述

review = await self.synthesizer.generate_review(relevant_papers, topic)

return {

"topic": topic,

"keywords": keywords,

"total_papers": len(papers),

"analyzed_papers": len(analyzed_papers),

"relevant_papers": len(relevant_papers),

"paper_list": relevant_papers,

"review": review

}

async def _expand_keywords(self, topic: str) -> List[str]:

"""扩展搜索关键词"""

prompt = f"""请为以下研究主题生成搜索关键词:

主题:{topic}

要求:

1. 生成英文关键词(学术搜索需要)

2. 包含同义词、相关概念

3. 包含缩写和全称

4. 返回JSON数组格式

示例输出:["keyword1", "keyword2", ...]

"""

response = await self.llm.agenerate(prompt)

try:

keywords = json.loads(response)

return keywords if isinstance(keywords, list) else [topic]

except:

return [topic]

# 使用示例

async def main():

# 模拟LLM客户端

class MockLLM:

async def agenerate(self, prompt):

# 实际应用中调用真实的LLM API

return '["LLM healthcare", "large language model medical", "GPT clinical"]'

assistant = ResearchAssistant(MockLLM())

results = await assistant.research(

topic="大语言模型在医疗诊断中的应用",

num_papers=30

)

print("研究完成!")

print(f"主题: {results['topic']}")

print(f"关键词: {results['keywords']}")

print(f"相关论文数: {results['relevant_papers']}")

if __name__ == "__main__":

asyncio.run(main())💡 思考:研究助手与简单的搜索引擎有什么本质区别?

🤔 解答:

- 理解意图 vs 匹配关键词:研究助手理解用户的研究目标,主动扩展和调整搜索策略

- 深度分析 vs 表面索引:不仅检索文档,还深入理解内容、提取关键信息

- 知识整合 vs 结果罗列:能够跨文档综合信息,发现联系,生成新的洞察

- 交互迭代 vs 单次查询:支持持续对话,根据反馈调整研究方向

- 输出创造 vs 信息传递:能够基于收集的信息创造新内容(如综述、报告)

6. 游戏AI:Voyager的探索之旅

Voyager是由NVIDIA研究团队在2023年发布的一个革命性项目,它展示了LLM驱动的智能体如何在Minecraft这个开放世界游戏中自主探索、学习和成长。Voyager被认为是第一个具有"终身学习"能力的LLM驱动游戏智能体。

6.1 Voyager项目概述

┌─────────────────────────────────────────────────────────────────┐

│ Voyager 项目概述 │

├─────────────────────────────────────────────────────────────────┤

│ │

│ 【项目背景】 │

│ • 发布时间: 2023年5月 │

│ • 研究团队: NVIDIA, Caltech, UT Austin, Stanford │

│ • 游戏环境: Minecraft (开放世界沙盒游戏) │

│ • 核心创新: LLM驱动的具身智能体 + 终身学习 │

│ │

│ 【为什么选择Minecraft】 │

│ ┌────────────────────────────────────────────────────────┐ │

│ │ • 开放世界:无固定目标,需要自主探索 │ │

│ │ • 技能体系:从简单到复杂的技能树 │ │

│ │ • 物理规则:模拟真实世界的合成、建造逻辑 │ │

│ │ • 长期规划:需要资源积累和策略规划 │ │

│ │ • 社区活跃:大量先验知识可供学习 │ │

│ └────────────────────────────────────────────────────────┘ │

│ │

│ 【核心目标】 │

│ 在没有人工干预的情况下,让智能体: │

│ 1. 自主探索世界,发现新事物 │

│ 2. 学习新技能,掌握游戏机制 │

│ 3. 积累知识,复用已学技能 │

│ 4. 持续进化,解锁更高级的能力 │

│ │

└─────────────────────────────────────────────────────────────────┘6.2 核心创新点

Voyager的设计包含三个革命性的组件:

┌─────────────────────────────────────────────────────────────────┐

│ Voyager 三大核心组件 │

├─────────────────────────────────────────────────────────────────┤

│ │

│ ┌─────────────────────────────────────────────────────────┐ │

│ │ 1. 自动课程 (Automatic Curriculum) │ │

│ │ │ │

│ │ ┌──────────┐ ┌──────────┐ ┌──────────┐ │ │

│ │ │当前状态 │ ─► │目标生成 │ ─► │难度递进 │ │ │

│ │ │分析 │ │(LLM) │ │探索新奇 │ │ │

│ │ └──────────┘ └──────────┘ └──────────┘ │ │

│ │ │ │

│ │ 特点:不依赖预定义目标,根据当前能力自动生成适合的挑战 │ │

│ └─────────────────────────────────────────────────────────┘ │

│ │

│ ┌─────────────────────────────────────────────────────────┐ │

│ │ 2. 技能库 (Skill Library) │ │

│ │ │ │

│ │ ┌─────────────────────────────────────┐ │ │

│ │ │ 技能库 │ │ │

│ │ │ ┌────────┐ ┌────────┐ ┌────────┐ │ │ │

│ │ │ │采集木头│ │制作工具│ │建造房屋│ │ │ │

│ │ │ │ JS代码 │ │ JS代码 │ │ JS代码 │ │ │ │

│ │ │ └────────┘ └────────┘ └────────┘ │ │ │

│ │ │ ┌────────┐ ┌────────┐ ┌────────┐ │ │ │

│ │ │ │挖矿 │ │战斗 │ │合成 │ │ │ │

│ │ │ │ JS代码 │ │ JS代码 │ │ JS代码 │ │ │ │

│ │ │ └────────┘ └────────┘ └────────┘ │ │ │

│ │ └─────────────────────────────────────┘ │ │

│ │ │ │

│ │ 特点:成功验证的技能被保存为可复用的代码片段 │ │

│ │ 通过向量检索快速找到相关技能 │ │

│ └─────────────────────────────────────────────────────────┘ │

│ │

│ ┌─────────────────────────────────────────────────────────┐ │

│ │ 3. 迭代提示 (Iterative Prompting) │ │

│ │ │ │

│ │ ┌────────┐ ┌────────┐ ┌────────┐ │ │

│ │ │生成代码│ ─► │执行验证│ ─► │反馈修正│ ─┐ │ │

│ │ └────────┘ └────────┘ └────────┘ │ │ │

│ │ ▲ │ │ │

│ │ └───────────────────────────────────────┘ │ │

│ │ │ │

│ │ 特点:代码生成 → 环境执行 → 获取反馈 → 修正代码 │ │

│ │ 多轮迭代直到任务成功 │ │

│ └─────────────────────────────────────────────────────────┘ │

│ │

└─────────────────────────────────────────────────────────────────┘6.3 技术架构深度解析

┌─────────────────────────────────────────────────────────────────┐

│ Voyager 完整架构 │

├─────────────────────────────────────────────────────────────────┤

│ │

│ Minecraft 游戏环境 │

│ ┌─────────────────────────────────────────────────────────┐ │

│ │ │ │

│ │ 🌲 🌲 ⛰️ 🏠 💎 🐄 (开放世界) │ │

│ │ │ │

│ └───────────────────────┬─────────────────────────────────┘ │

│ │ │

│ ┌────────┴────────┐ │

│ │ Mineflayer │ JavaScript API │

│ │ Bot 接口 │ 控制游戏角色 │

│ └────────┬────────┘ │

│ │ │

│ ════════════════════════╪═════════════════════════════════ │

│ │ │

│ ┌────────┴────────┐ │

│ │ Voyager Agent │ │

│ └────────┬────────┘ │

│ │ │

│ ┌──────────────────────┼──────────────────────┐ │

│ │ │ │ │

│ ▼ ▼ ▼ │

│ ┌──────────────┐ ┌──────────────┐ ┌──────────────┐ │

│ │ 课程模块 │ │ 行动模块 │ │ 技能库 │ │

│ │ │ │ │ │ │ │

│ │ • 状态感知 │ │ • 代码生成 │ │ • 技能存储 │ │

│ │ • 目标建议 │ │ • 执行反馈 │ │ • 向量检索 │ │

│ │ • 难度控制 │ │ • 迭代修正 │ │ • 技能复用 │ │

│ └──────┬───────┘ └──────┬───────┘ └──────┬───────┘ │

│ │ │ │ │

│ └─────────────────┼─────────────────┘ │

│ │ │

│ ┌────────┴────────┐ │

│ │ GPT-4 LLM │ │

│ │ 推理与生成 │ │

│ └─────────────────┘ │

│ │

└─────────────────────────────────────────────────────────────────┘核心代码结构示例:

python

"""

Voyager 核心架构实现(简化版)

展示关键组件的交互方式

"""

from dataclasses import dataclass, field

from typing import List, Dict, Optional, Any

import json

import numpy as np

@dataclass

class GameState:

"""游戏状态"""

position: tuple # (x, y, z)

health: int

hunger: int

inventory: Dict[str, int] # 物品: 数量

nearby_blocks: List[str]

nearby_entities: List[str]

time_of_day: str

biome: str

@dataclass

class Skill:

"""技能定义"""

name: str

description: str

code: str # JavaScript 代码

embedding: np.ndarray # 语义向量

prerequisites: List[str] = field(default_factory=list)

success_count: int = 0

class AutomaticCurriculum:

"""自动课程生成器"""

def __init__(self, llm):

self.llm = llm

self.completed_tasks = []

self.failed_tasks = []

def propose_next_task(self, state: GameState,

skills: List[str]) -> str:

"""基于当前状态生成下一个任务"""

prompt = f"""你是Minecraft探险顾问。基于玩家当前状态,建议一个适合的下一步目标。

## 当前状态

- 位置: {state.position}

- 生命值: {state.health}/20

- 饥饿值: {state.hunger}/20

- 背包: {state.inventory}

- 附近方块: {state.nearby_blocks[:10]}

- 时间: {state.time_of_day}

- 生物群系: {state.biome}

## 已掌握技能

{chr(10).join(f'- {s}' for s in skills)}

## 已完成任务

{chr(10).join(f'- {t}' for t in self.completed_tasks[-10:])}

## 任务生成原则

1. 任务应该略高于当前能力,但可实现

2. 优先探索新事物(新方块、新区域、新合成)

3. 考虑生存需求(低生命值时优先找食物)

4. 逐步解锁更高级的游戏内容

请建议一个具体、可执行的任务(一句话描述):"""

response = self.llm.generate(prompt)

return response.strip()

def record_result(self, task: str, success: bool):

"""记录任务结果"""

if success:

self.completed_tasks.append(task)

else:

self.failed_tasks.append(task)

class SkillLibrary:

"""技能库"""

def __init__(self, embedding_model):

self.skills: Dict[str, Skill] = {}

self.embedding_model = embedding_model

def add_skill(self, name: str, description: str, code: str):

"""添加新技能"""

embedding = self.embedding_model.encode(f"{name}: {description}")

skill = Skill(

name=name,

description=description,

code=code,

embedding=embedding

)

self.skills[name] = skill

print(f"技能已添加: {name}")

def search_skills(self, query: str, top_k: int = 5) -> List[Skill]:

"""语义搜索相关技能"""

query_embedding = self.embedding_model.encode(query)

# 计算相似度

similarities = []

for name, skill in self.skills.items():

sim = np.dot(query_embedding, skill.embedding) / (

np.linalg.norm(query_embedding) * np.linalg.norm(skill.embedding)

)

similarities.append((skill, sim))

# 排序返回

similarities.sort(key=lambda x: x[1], reverse=True)

return [s[0] for s in similarities[:top_k]]

def get_skill_code(self, name: str) -> Optional[str]:

"""获取技能代码"""

if name in self.skills:

return self.skills[name].code

return None

class IterativePromptingMechanism:

"""迭代提示机制"""

def __init__(self, llm, max_iterations: int = 5):

self.llm = llm

self.max_iterations = max_iterations

def generate_skill_code(self, task: str, state: GameState,

related_skills: List[Skill]) -> Optional[str]:

"""生成任务代码,支持迭代修正"""

# 构建初始提示

skills_context = "\n".join([

f"// 技能: {s.name}\n{s.code}"

for s in related_skills

])

prompt = self._build_code_prompt(task, state, skills_context)

for iteration in range(self.max_iterations):

# 生成代码

code = self.llm.generate(prompt)

code = self._extract_code(code)

# 验证代码

validation_result = self._validate_code(code)

if validation_result['success']:

print(f"代码在第 {iteration + 1} 次迭代成功")

return code

# 失败时添加错误反馈

error_feedback = f"""

## 执行反馈

代码执行失败。错误信息:

{validation_result['error']}

请修正代码,注意:

1. 检查API调用是否正确

2. 确保所有变量已定义

3. 添加必要的错误处理

修正后的代码:"""

prompt = prompt + code + error_feedback

print("达到最大迭代次数,任务失败")

return None

def _build_code_prompt(self, task: str, state: GameState,

skills_context: str) -> str:

"""构建代码生成提示"""

return f"""你是Minecraft机器人程序员。请为以下任务生成JavaScript代码。

## 任务

{task}

## 当前状态

- 位置: {state.position}

- 背包: {state.inventory}

- 附近: {state.nearby_blocks[:5]}

## 可用API

- bot.chat(message) - 发送聊天消息

- bot.collectBlock.collect(block) - 收集方块

- bot.craft(recipe, count) - 合成物品

- bot.equip(item, destination) - 装备物品

- bot.attack(entity) - 攻击实体

- bot.dig(block) - 挖掘方块

- bot.placeBlock(referenceBlock, faceVector) - 放置方块

## 相关技能代码(可参考)

{skills_context}

## 要求

1. 使用async/await处理异步操作

2. 添加适当的错误处理

3. 在完成时调用bot.chat("任务完成")

请生成代码:

```javascript

"""

def _extract_code(self, response: str) -> str:

"""从响应中提取代码"""

if "```javascript" in response:

code = response.split("```javascript")[1]

code = code.split("```")[0]

return code.strip()

return response.strip()

def _validate_code(self, code: str) -> Dict[str, Any]:

"""验证代码(模拟)"""

# 实际实现中会将代码发送到Minecraft执行

# 这里返回模拟结果

return {'success': True, 'error': None}

class VoyagerAgent:

"""Voyager 智能体主类"""

def __init__(self, llm, embedding_model, game_interface):

self.curriculum = AutomaticCurriculum(llm)

self.skill_library = SkillLibrary(embedding_model)

self.prompting = IterativePromptingMechanism(llm)

self.game = game_interface

# 初始化基础技能

self._init_basic_skills()

def _init_basic_skills(self):

"""初始化基础技能"""

self.skill_library.add_skill(

name="collect_wood",

description="收集附近的木头方块",

code="""

async function collectWood(bot) {

const woodTypes = ['oak_log', 'birch_log', 'spruce_log'];

for (const woodType of woodTypes) {

const woodBlock = bot.findBlock({

matching: block => block.name === woodType,

maxDistance: 32

});

if (woodBlock) {

await bot.collectBlock.collect(woodBlock);

bot.chat("收集了木头");

return true;

}

}

bot.chat("附近没有木头");

return false;

}

"""

)

self.skill_library.add_skill(

name="craft_planks",

description="将原木合成为木板",

code="""

async function craftPlanks(bot) {

const logCount = bot.inventory.count(mcData.itemsByName.oak_log.id);

if (logCount === 0) {

bot.chat("没有原木,无法合成木板");

return false;

}

const plankRecipe = bot.recipesFor(mcData.itemsByName.oak_planks.id)[0];

if (plankRecipe) {

await bot.craft(plankRecipe, 1);

bot.chat("合成了木板");

return true;

}

return false;

}

"""

)

def run_episode(self) -> Dict[str, Any]:

"""运行一个探索回合"""

# 1. 获取当前游戏状态

state = self.game.get_state()

print(f"当前状态: 位置{state.position}, 背包{state.inventory}")

# 2. 获取已掌握技能列表

known_skills = list(self.skill_library.skills.keys())

# 3. 生成下一个任务

task = self.curriculum.propose_next_task(state, known_skills)

print(f"建议任务: {task}")

# 4. 搜索相关技能

related_skills = self.skill_library.search_skills(task, top_k=3)

print(f"相关技能: {[s.name for s in related_skills]}")

# 5. 生成执行代码

code = self.prompting.generate_skill_code(task, state, related_skills)

if code is None:

self.curriculum.record_result(task, success=False)

return {"task": task, "success": False, "reason": "代码生成失败"}

# 6. 执行代码

result = self.game.execute(code)

# 7. 记录结果

success = result.get('success', False)

self.curriculum.record_result(task, success)

# 8. 如果成功,保存为新技能

if success:

skill_name = self._generate_skill_name(task)

self.skill_library.add_skill(

name=skill_name,

description=task,

code=code

)

return {

"task": task,

"success": success,

"code": code,

"skills_count": len(self.skill_library.skills)

}

def _generate_skill_name(self, task: str) -> str:

"""从任务描述生成技能名称"""

# 简化实现

words = task.lower().replace(',', '').replace('.', '').split()[:3]

return '_'.join(words)

def run(self, num_episodes: int = 100):

"""持续运行探索"""

for i in range(num_episodes):

print(f"\n=== Episode {i + 1} ===")

result = self.run_episode()

print(f"结果: {'成功' if result['success'] else '失败'}")

print(f"技能库大小: {result['skills_count']}")

# 使用示例

if __name__ == "__main__":

# 模拟组件

class MockLLM:

def generate(self, prompt):

return "收集10个木头并制作成木板"

class MockEmbedding:

def encode(self, text):

return np.random.rand(384)

class MockGame:

def get_state(self):

return GameState(

position=(100, 64, 200),

health=20,

hunger=18,

inventory={"oak_log": 5},

nearby_blocks=["grass_block", "oak_log", "dirt"],

nearby_entities=["cow", "pig"],

time_of_day="day",

biome="forest"

)

def execute(self, code):

return {"success": True}

agent = VoyagerAgent(MockLLM(), MockEmbedding(), MockGame())

agent.run(num_episodes=3)6.4 实验结果与启示

Voyager在实验中展现出了令人惊叹的能力:

┌─────────────────────────────────────────────────────────────────┐

│ Voyager 实验结果 │

├─────────────────────────────────────────────────────────────────┤

│ │

│ 【物品获取能力对比】 │

│ │

│ 独特物品数量(160小时游戏后): │

│ │

│ Voyager ████████████████████████████████████ 63个 │

│ Auto-GPT ████████████████████ 32个 │

│ ReAct █████████████████ 28个 │

│ Reflexion ██████████████ 24个 │

│ │

│ ───────────────────────────────────────────────────────────── │

│ │

│ 【技能库增长】 │

│ │

│ 技能数 ▲ │

│ 100 │ ╭────────── │

│ 80 │ ╭─────╯ │

│ 60 │ ╭─────╯ │

│ 40 │ ╭─────╯ │

│ 20 │ ╭─────╯ │

│ 0 │────────────╯ │

│ └────────────────────────────────────────────► 时间 │

│ 0h 20h 40h 60h 80h 100h │

│ │

│ ───────────────────────────────────────────────────────────── │

│ │

│ 【关键里程碑】 │

│ │

│ ✓ 2小时内: 掌握木材收集、基础工具制作 │

│ ✓ 10小时内: 学会挖矿、战斗、建造庇护所 │

│ ✓ 50小时内: 掌握附魔、酿造、下界探索 │

│ ✓ 100小时+: 击败末影龙(最终Boss) │

│ │

└─────────────────────────────────────────────────────────────────┘💡 思考:Voyager的成功对通用AI Agent设计有什么启示?

🤔 解答:

-

课程学习的重要性

- 从简单任务逐步过渡到复杂任务

- 让Agent自己决定"下一步学什么"比人工设计课程更有效

-

知识的显式存储

- 将学到的技能显式保存为代码,而不是隐式地存在于模型参数中

- 这使得知识可复用、可检索、可调试

-

迭代反馈的价值

- 一次性生成正确答案很难,通过迭代修正更可靠

- 环境反馈是最有价值的学习信号

-

组合优于单体

- 复杂能力通过组合简单技能实现

- 技能库的增长带来能力的指数级提升

-

探索与利用的平衡

- 课程生成器自动平衡"尝试新事物"和"练习已知技能"

- 这种平衡对持续学习至关重要

7. Data Interpreter:数据的解读者

Data Interpreter是MetaGPT团队在2024年提出的数据分析智能体,它能够接收自然语言描述的数据分析任务,自动生成代码、执行分析并输出结果。

7.1 Data Interpreter的设计理念

┌─────────────────────────────────────────────────────────────────┐

│ Data Interpreter 设计理念 │

├─────────────────────────────────────────────────────────────────┤

│ │

│ 【核心问题】 │

│ 数据分析任务通常需要: │

│ • 理解业务需求 │

│ • 数据探索和清洗 │

│ • 选择合适的分析方法 │

│ • 编写和调试代码 │

│ • 解释和可视化结果 │

│ │

│ 传统方法需要专业数据分析师,门槛高、周期长 │

│ │

│ ───────────────────────────────────────────────────────────── │

│ │

│ 【Data Interpreter 方案】 │

│ │

│ ┌─────────────────────────────────────────────────────────┐ │

│ │ │ │

│ │ 自然语言需求 ──► 动态规划 ──► 代码生成 ──► 执行反馈 │ │

│ │ │ │ │ │ │ │

│ │ │ ┌────┴────┐ ┌────┴────┐ ┌────┴────┐ │ │

│ │ │ │子任务分解│ │迭代优化│ │结果验证│ │ │

│ │ │ └─────────┘ └─────────┘ └─────────┘ │ │

│ │ │ │ │

│ │ └─────► 数据理解 ──► 方法选择 ──► 结果解释 │ │

│ │ │ │

│ └─────────────────────────────────────────────────────────┘ │

│ │

│ 【核心创新】 │

│ 1. 动态规划:根据执行反馈调整计划,而非一次性规划 │

│ 2. 代码验证:自动验证代码执行结果是否符合预期 │

│ 3. 逻辑推理:在代码生成前进行业务逻辑推理 │

│ 4. 可视化集成:自动生成数据可视化 │

│ │

└─────────────────────────────────────────────────────────────────┘7.2 核心功能模块

┌─────────────────────────────────────────────────────────────────┐

│ Data Interpreter 架构 │

├─────────────────────────────────────────────────────────────────┤

│ │

│ ┌──────────────┐ │

│ │ 用户需求 │ │

│ │ "分析销售数据│ │

│ │ 预测下月趋势"│ │

│ └───────┬──────┘ │

│ │ │

│ ▼ │

│ ┌────────────────────────────────────────────────────────┐ │

│ │ 规划模块 (Planner) │ │

│ │ ┌──────────────────────────────────────────────────┐ │ │

│ │ │ │ │ │

│ │ │ Task 1: 数据加载和预览 │ │ │

│ │ │ ↓ │ │ │

│ │ │ Task 2: 数据清洗和预处理 │ │ │

│ │ │ ↓ │ │ │

│ │ │ Task 3: 探索性数据分析 (EDA) │ │ │

│ │ │ ↓ │ │ │

│ │ │ Task 4: 特征工程 │ │ │

│ │ │ ↓ │ │ │

│ │ │ Task 5: 模型训练和评估 ← 动态调整 │ │ │

│ │ │ ↓ │ │ │

│ │ │ Task 6: 预测和结果可视化 │ │ │

│ │ │ │ │ │

│ │ └──────────────────────────────────────────────────┘ │ │

│ └────────────────────────────────────────────────────────┘ │

│ │ │

│ ▼ │

│ ┌────────────────────────────────────────────────────────┐ │

│ │ 代码生成模块 (Coder) │ │

│ │ │ │

│ │ 输入: Task + 上下文 + 执行历史 │ │

│ │ │ │

│ │ ┌──────────────────────────────────────────────┐ │ │

│ │ │ # Task 3: 探索性数据分析 │ │ │

│ │ │ import pandas as pd │ │ │

│ │ │ import matplotlib.pyplot as plt │ │ │

│ │ │ │ │ │

│ │ │ # 统计描述 │ │ │

│ │ │ print(df.describe()) │ │ │

│ │ │ │ │ │

│ │ │ # 销售趋势可视化 │ │ │

│ │ │ plt.figure(figsize=(12, 6)) │ │ │

│ │ │ plt.plot(df['date'], df['sales']) │ │ │

│ │ │ ... │ │ │

│ │ └──────────────────────────────────────────────┘ │ │

│ └────────────────────────────────────────────────────────┘ │

│ │ │

│ ▼ │

│ ┌────────────────────────────────────────────────────────┐ │

│ │ 执行模块 (Executor) │ │

│ │ │ │

│ │ ┌─────────────┐ ┌─────────────┐ ┌──────────┐ │ │

│ │ │ 沙箱环境 │───►│ 代码执行 │───►│ 结果收集 │ │ │

│ │ │ (Docker/ │ │ (Jupyter │ │ • stdout │ │ │

│ │ │ IPython) │ │ kernel) │ │ • 图表 │ │ │

│ │ └─────────────┘ └─────────────┘ │ • 变量 │ │ │

│ │ └──────────┘ │ │

│ └────────────────────────────────────────────────────────┘ │

│ │ │

│ ▼ │

│ ┌────────────────────────────────────────────────────────┐ │

│ │ 反馈循环 │ │

│ │ │ │

│ │ 执行成功? ──┬── 是 ──► 进入下一个Task │ │

│ │ │ │ │

│ │ └── 否 ──► 分析错误 ──► 修正代码 ──► 重试 │ │

│ │ │ │

│ └────────────────────────────────────────────────────────┘ │

│ │

└─────────────────────────────────────────────────────────────────┘7.3 动态规划与代码生成

Data Interpreter的核心创新在于其动态规划机制和高质量的代码生成能力:

python

"""

Data Interpreter 核心实现

展示动态规划和代码生成的关键逻辑

"""

from dataclasses import dataclass, field

from typing import List, Dict, Optional, Any

from enum import Enum

import json

class TaskStatus(Enum):

PENDING = "pending"

RUNNING = "running"

SUCCESS = "success"

FAILED = "failed"

SKIPPED = "skipped"

@dataclass

class Task:

"""任务定义"""

id: str

description: str

code: Optional[str] = None

status: TaskStatus = TaskStatus.PENDING

result: Optional[Any] = None

error: Optional[str] = None

dependencies: List[str] = field(default_factory=list)

@dataclass

class ExecutionContext:

"""执行上下文"""

variables: Dict[str, Any] # 共享变量

code_history: List[str] # 执行过的代码

output_history: List[str] # 输出历史

figures: List[Any] # 生成的图表

class DynamicPlanner:

"""动态规划器"""

def __init__(self, llm):

self.llm = llm

self.task_templates = {

"data_loading": "加载数据文件到DataFrame",

"data_cleaning": "处理缺失值、异常值,进行数据清洗",

"eda": "进行探索性数据分析,生成统计摘要和可视化",

"feature_engineering": "进行特征工程,创建新特征",

"modeling": "训练机器学习模型",

"evaluation": "评估模型性能",

"visualization": "生成结果可视化和报告"

}

def create_initial_plan(self, user_request: str,

data_info: Dict) -> List[Task]:

"""创建初始执行计划"""

prompt = f"""请为以下数据分析需求创建执行计划。

## 用户需求

{user_request}

## 数据信息

- 文件: {data_info.get('filename', 'unknown')}

- 列: {data_info.get('columns', [])}

- 行数: {data_info.get('rows', 'unknown')}

- 数据类型: {data_info.get('dtypes', {})}

## 可用任务类型

{json.dumps(self.task_templates, indent=2, ensure_ascii=False)}

## 输出格式

请输出JSON数组,每个任务包含:

- id: 任务ID (task_1, task_2, ...)

- type: 任务类型

- description: 具体描述

- dependencies: 依赖的任务ID列表

示例:

[

{{"id": "task_1", "type": "data_loading", "description": "加载sales.csv文件", "dependencies": []}},

{{"id": "task_2", "type": "data_cleaning", "description": "处理缺失的销售额数据", "dependencies": ["task_1"]}}

]

"""

response = self.llm.generate(prompt)

try:

task_defs = json.loads(response)

return [

Task(

id=t['id'],

description=t['description'],

dependencies=t.get('dependencies', [])

)

for t in task_defs

]

except json.JSONDecodeError:

# 降级:创建默认计划

return self._create_default_plan()

def _create_default_plan(self) -> List[Task]:

"""创建默认计划"""

return [

Task(id="task_1", description="加载和预览数据"),

Task(id="task_2", description="数据清洗和预处理", dependencies=["task_1"]),

Task(id="task_3", description="探索性数据分析", dependencies=["task_2"]),

Task(id="task_4", description="生成分析报告", dependencies=["task_3"])

]

def replan(self, current_task: Task, error: str,

remaining_tasks: List[Task]) -> List[Task]:

"""根据执行错误动态调整计划"""

prompt = f"""当前任务执行失败,请调整后续计划。

## 失败任务

- ID: {current_task.id}

- 描述: {current_task.description}

- 错误: {error}

## 剩余任务

{json.dumps([{'id': t.id, 'description': t.description} for t in remaining_tasks], ensure_ascii=False)}

## 调整策略

1. 如果是数据问题,可能需要增加数据处理步骤

2. 如果是方法问题,可能需要更换分析方法

3. 如果是依赖问题,可能需要重新排序任务

请输出调整后的任务列表(JSON格式):

"""

response = self.llm.generate(prompt)

try:

adjusted_tasks = json.loads(response)

return [

Task(id=t['id'], description=t['description'],

dependencies=t.get('dependencies', []))

for t in adjusted_tasks

]

except:

return remaining_tasks

class CodeGenerator:

"""代码生成器"""

def __init__(self, llm):

self.llm = llm

self.code_patterns = self._load_code_patterns()

def _load_code_patterns(self) -> Dict[str, str]:

"""加载常用代码模式"""

return {

"load_csv": '''

import pandas as pd

df = pd.read_csv("{filepath}")

print(f"数据形状: {df.shape}")

print(f"列名: {list(df.columns)}")

df.head()

''',

"basic_stats": '''

print("=" * 50)

print("数据统计摘要")

print("=" * 50)

print(df.describe())

print("\\n缺失值统计:")

print(df.isnull().sum())

''',

"time_series_plot": '''

import matplotlib.pyplot as plt

plt.figure(figsize=(12, 6))

plt.plot(df["{date_col}"], df["{value_col}"])

plt.xlabel("{date_col}")

plt.ylabel("{value_col}")

plt.title("{title}")

plt.xticks(rotation=45)

plt.tight_layout()

plt.show()

'''

}

def generate_code(self, task: Task, context: ExecutionContext,

user_request: str) -> str:

"""为任务生成代码"""

# 构建上下文信息

context_info = self._build_context_info(context)

prompt = f"""请为以下数据分析任务生成Python代码。

## 任务

{task.description}

## 用户原始需求

{user_request}

## 当前环境上下文

### 已定义变量

{context_info['variables']}

### 已执行代码(最近5段)

{context_info['recent_code']}

## 代码要求

1. 使用pandas进行数据处理

2. 使用matplotlib/seaborn进行可视化

3. 添加必要的print语句输出关键信息

4. 添加中文注释说明代码逻辑

5. 处理可能的异常情况

6. 确保代码可以独立运行(除了依赖已定义的变量)

## 输出格式

只输出可执行的Python代码,不要添加markdown标记。

代码:

"""

code = self.llm.generate(prompt)

# 清理代码

code = self._clean_code(code)

return code

def _build_context_info(self, context: ExecutionContext) -> Dict:

"""构建上下文信息"""

var_info = []

for name, value in context.variables.items():

if hasattr(value, 'shape'):

var_info.append(f"- {name}: DataFrame, shape={value.shape}")

elif hasattr(value, '__len__'):

var_info.append(f"- {name}: {type(value).__name__}, len={len(value)}")

else:

var_info.append(f"- {name}: {type(value).__name__}")

return {

'variables': '\n'.join(var_info) if var_info else "无",

'recent_code': '\n---\n'.join(context.code_history[-5:]) if context.code_history else "无"

}

def _clean_code(self, code: str) -> str:

"""清理生成的代码"""

# 移除markdown代码块标记

if code.startswith('```python'):

code = code[9:]

if code.startswith('```'):

code = code[3:]

if code.endswith('```'):

code = code[:-3]

return code.strip()

def fix_code(self, code: str, error: str, context: ExecutionContext) -> str:

"""修复有错误的代码"""

prompt = f"""请修复以下有错误的Python代码。

## 原代码

```python

{code}错误信息

{error}

环境变量

{self._build_context_info(context)['variables']}

修复要求

- 保持原有逻辑不变

- 只修复导致错误的问题

- 添加必要的错误处理

修复后的代码:

"""

fixed_code = self.llm.generate(prompt)

return self._clean_code(fixed_code)class CodeExecutor:

"""代码执行器"""

def __init__(self):

self.namespace = {}

self._init_namespace()

def _init_namespace(self):

"""初始化执行命名空间"""

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns

from io import StringIO

import warnings

warnings.filterwarnings('ignore')

self.namespace = {

'pd': pd,

'np': np,

'plt': plt,

'sns': sns,

'StringIO': StringIO

}

def execute(self, code: str) -> Dict[str, Any]:

"""执行代码并返回结果"""

import sys

from io import StringIO

# 捕获标准输出

old_stdout = sys.stdout

sys.stdout = mystdout = StringIO()

result = {

'success': False,

'output': '',

'error': None,

'variables': {},

'figures': []

}

try:

# 执行代码

exec(code, self.namespace)

result['success'] = True

result['output'] = mystdout.getvalue()

# 提取新定义的变量

result['variables'] = {

k: v for k, v in self.namespace.items()

if not k.startswith('_') and k not in ['pd', 'np', 'plt', 'sns', 'StringIO']

}

except Exception as e:

result['error'] = f"{type(e).__name__}: {str(e)}"

finally:

sys.stdout = old_stdout

return resultclass DataInterpreter:

"""Data Interpreter 主类"""

def __init__(self, llm):

self.llm = llm

self.planner = DynamicPlanner(llm)

self.coder = CodeGenerator(llm)

self.executor = CodeExecutor()

self.max_retries = 3

def analyze(self, user_request: str, data_path: str) -> Dict[str, Any]:

"""执行数据分析任务"""

# 1. 获取数据基本信息

data_info = self._get_data_info(data_path)

print(f"数据信息: {data_info}")

# 2. 创建初始计划

tasks = self.planner.create_initial_plan(user_request, data_info)

print(f"初始计划: {[t.description for t in tasks]}")

# 3. 初始化执行上下文

context = ExecutionContext(

variables={},

code_history=[],

output_history=[],

figures=[]

)

# 4. 加载数据

load_code = f"df = pd.read_csv('{data_path}')"

self.executor.execute(load_code)

context.code_history.append(load_code)

context.variables = self.executor.namespace.copy()

# 5. 执行任务计划

results = []

task_index = 0

while task_index < len(tasks):

task = tasks[task_index]

print(f"\n执行任务 {task.id}: {task.description}")

# 生成代码

code = self.coder.generate_code(task, context, user_request)

task.code = code

# 执行代码(带重试)

success = False

for attempt in range(self.max_retries):

exec_result = self.executor.execute(code)

if exec_result['success']:

success = True

task.status = TaskStatus.SUCCESS

task.result = exec_result['output']

# 更新上下文

context.code_history.append(code)

context.output_history.append(exec_result['output'])

context.variables = exec_result['variables']

print(f"✓ 任务成功")

break

else:

print(f"✗ 尝试 {attempt + 1} 失败: {exec_result['error']}")

if attempt < self.max_retries - 1:

# 修复代码

code = self.coder.fix_code(code, exec_result['error'], context)

task.code = code

if not success:

task.status = TaskStatus.FAILED

task.error = exec_result['error']

# 动态重新规划

remaining_tasks = tasks[task_index + 1:]

tasks = tasks[:task_index + 1] + self.planner.replan(

task, exec_result['error'], remaining_tasks

)

print(f"重新规划后的任务: {[t.description for t in tasks[task_index + 1:]]}")

results.append({

'task_id': task.id,

'description': task.description,

'status': task.status.value,

'code': task.code,

'output': task.result,

'error': task.error

})

task_index += 1

# 6. 生成最终报告

final_report = self._generate_report(user_request, results, context)

return {

'request': user_request,

'tasks': results,

'report': final_report,

'code_history': context.code_history

}

def _get_data_info(self, data_path: str) -> Dict:

"""获取数据基本信息"""

import pandas as pd

try:

df = pd.read_csv(data_path, nrows=5)

return {

'filename': data_path,

'columns': list(df.columns),

'dtypes': df.dtypes.astype(str).to_dict(),

'rows': 'unknown (预览5行)'

}

except Exception as e:

return {

'filename': data_path,