从Java到AI:我的转型之路 Ⅱ ------ 手撸一个DeepSeek工具库

实战篇:如何为Java后端打造企业级AI能力

在上一篇文章中,我分享了从Java转型AI的学习路径。本篇将展示我的第一个实战项目------deepseek-util:一个基于Spring Boot的DeepSeek AI工具库,包含Prompt模板管理、A/B测试框架和完整的评论审核系统。

项目地址 :github.com/s1936914629...

一、项目背景与设计目标

在调研了多个Java AI客户端后,我发现现有方案普遍存在三个问题:

- Prompt管理混乱:硬编码在代码中,无法动态调整

- 缺乏效果评估:无法科学对比不同Prompt的效果

- 场景化能力不足:通用客户端难以适配特定业务(如内容审核)

因此,我设计了deepseek-util,核心目标:

| 模块 | 解决痛点 | 技术亮点 |

|---|---|---|

| Prompt模板引擎 | 硬编码Prompt难以维护 | 参数化模板 + 动态加载 |

| A/B测试框架 | 无法量化评估Prompt效果 | 多维度评分 + 响应时间监控 |

| 评论审核系统 | AI能力难以落地业务 | 分层架构 + 规则引擎 + 人工兜底 |

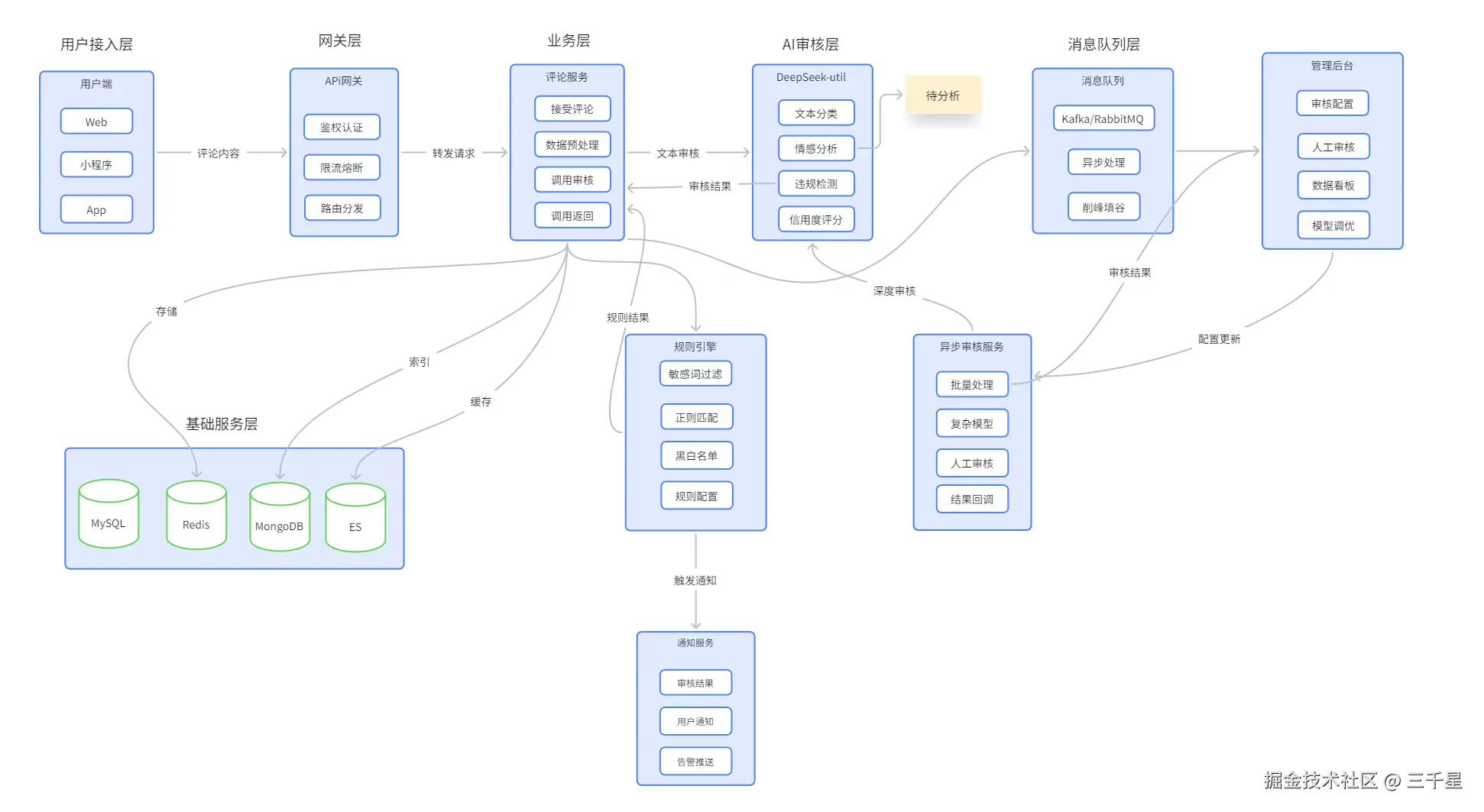

二、审核系统核心架构设计

2.1 整体架构图

2.2 模块详解

模块一:Prompt模板引擎

我设计了10个常用模板,覆盖开发、运营、产品多场景:

swift

// 模板定义示例

public enum TemplateType {

GENERAL_QA("通用问答", "你是一个智能助手...", "{0}"),

CODE_GENERATOR("代码生成", "你是一位资深程序员...", "请用 {0} 语言实现 {1}"),

SUMMARIZER("内容总结", "你是一位内容总结专家...", "请总结以下内容:\n{0}"),

// ... 共10个模板

}核心特性:

- 参数化 :支持多参数注入(如

code_generator模板需要语言+功能描述) - 动态加载:可从数据库/配置中心实时更新Prompt

- 版本管理:支持Prompt版本回溯(为A/B测试提供基础)

模块二:A/B测试框架

这是项目的核心创新点。我设计了一套完整的Prompt效果评估体系:

arduino

public class ABTestReport {

private String template; // 模板名称

private String testCase; // 测试用例ID

private int qualityScore; // 质量评分(1-5)

private long responseTime; // 响应时间(ms)

private boolean relevant; // 是否相关

private String response; // 原始响应

}测试维度设计:

| 维度 | 评估标准 | 数据来源 |

|---|---|---|

| QualityScore | 回答准确性、完整性、结构化程度 | 人工标注 + 自动化检查 |

| ResponseTime | 端到端响应延迟 | 代码埋点统计 |

| Relevant | 是否答非所问 | 语义相似度计算 |

实测数据示例:

从测试报告可以看到有趣的现象:

| 模板 | 用例 | 质量分 | 响应时间 | 相关性 |

|---|---|---|---|---|

general_qa |

什么是AI? | 5 | 11,023ms | ❌ |

summarizer |

什么是AI? | 5 | 2,982ms | ✅ |

关键发现 :summarizer模板在"什么是AI"这个问答场景下,不仅响应速度快3.7倍(2982ms vs 11023ms),而且相关性更好。这说明Prompt的角色设定会显著影响模型表现------让模型扮演"总结专家"比"通用助手"在特定场景下更有效。

模块三:评论审核系统

这是一个完整的生产级内容安全解决方案,采用分层过滤策略:

第一层:规则引擎(毫秒级)

- 敏感词过滤(Trie树实现)

- 正则表达式匹配(手机号、身份证号等)

- 黑白名单(用户ID/IP维度)

第二层:AI审核(百毫秒级) 调用DeepSeek进行多维度分析:

arduino

public class AIReviewResult {

private String textCategory; // 文本分类(政治/广告/正常等)

private double sentimentScore; // 情感评分(-1到1)

private boolean violation; // 是否违规

private double creditScore; // 用户信用度(用于降权/提权)

}第三层:异步深度审核(秒级)

- 复杂模型分析(如上下文关联检测)

- 人工审核队列(Kafka削峰填谷)

- 结果回调通知

三、关键技术实现

3.1 流式响应处理

为了提升用户体验,我实现了SSE(Server-Sent Events)流式输出:

less

@GetMapping(value = "/chat/stream", produces = MediaType.TEXT_EVENT_STREAM_VALUE)

public Flux<ServerSentEvent<String>> streamChat(@RequestParam String message) {

return deepSeekClient.chatStream(message)

.map(content -> ServerSentEvent.builder(content).build());

}3.2 模板热更新

结合Spring Boot的@RefreshScope,实现Prompt不停机更新:

less

@Configuration

@RefreshScope

public class PromptTemplateConfig {

@Value("${prompt.templates.general_qa:}")

private String generalQaTemplate;

// 监听配置变更

@EventListener

public void handleRefresh(RefreshScopeRefreshedEvent event) {

log.info("Prompt模板已刷新");

templateRegistry.reload();

}

}3.3 性能优化策略

| 策略 | 实现方式 | 效果 |

|---|---|---|

| 连接池 | 使用OkHttp连接池复用TCP连接 | 减少握手开销 |

| 缓存 | Caffeine缓存高频Prompt响应 | 降低API调用成本 |

| 异步化 | 审核流程全链路异步 | 提升吞吐量 |

| 削峰填谷 | Kafka队列缓冲突发流量 | 保护下游服务 |

四、项目结构

bash

deepseek-util/

├── src/main/java/com/deepseek/util/

│ ├── client/ # DeepSeek API客户端

│ │ ├── DeepSeekClient.java

│ │ └── DeepSeekProperties.java

│ ├── template/ # Prompt模板引擎

│ │ ├── PromptTemplate.java

│ │ ├── TemplateRegistry.java

│ │ └── TemplateType.java

│ ├── abtest/ # A/B测试框架

│ │ ├── ABTestEngine.java

│ │ ├── TestReport.java

│ │ └── QualityEvaluator.java

│ └── review/ # 评论审核系统

│ ├── CommentReviewService.java

│ ├── RuleEngine.java

│ └── AIReviewClient.java

├── src/main/resources/

│ └── templates/ # 默认Prompt模板

└── docs/

├── 评论审核系统架构图.pdf

└── Prompt模板A_B测试报告.xlsx五、踩坑与反思

5.1 Prompt工程的艺术

在A/B测试中发现,同样的模型,不同的Prompt角色设定,效果天差地别:

- ❌ "你是一个AI助手" → 回答泛泛而谈,经常离题

- ✅ "你是一位资深程序员" → 代码场景回答更专业、结构化

经验 :Prompt中的角色设定(Role)不是装饰,而是隐式的约束条件,能显著激活模型的特定能力。

5.2 响应时间的权衡

从测试数据看,DeepSeek的响应时间在2-12秒之间,这对实时业务是挑战。我的解决方案:

- 异步化:非实时场景(如评论审核)走消息队列

- 流式输出:实时场景(如聊天)使用SSE,让用户感知到"正在思考"

- 缓存预热:高频问题预生成答案

5.3 成本与效果的平衡

AI审核虽然智能,但成本远高于规则引擎。我的分层策略:

- 80% 明显违规 → 规则引擎拦截(成本≈0)

- 15% 疑似违规 → AI审核(成本适中)

- 5% 复杂场景 → 人工审核(成本高但精准)

六、下一步计划

- RAG集成:接入向量数据库,实现基于私有知识的问答

- Function Calling:支持工具调用(如查询数据库、调用API)

- 多模态支持:扩展至图片审核场景

- 可视化后台:搭建Prompt管理后台,支持运营人员自助调整

结语

这个项目让我深刻体会到:AI工程化不仅仅是调用API,而是需要完整的工具链、评估体系和业务适配。从Prompt模板到A/B测试,从规则引擎到分层架构,每个环节都是Java后端工程师可以发挥价值的地方。

如果你也在探索Java与AI的结合,欢迎Star我的项目,一起交流!

GitHub地址 :github.com/s1936914629...

本文是《从Java到AI:我的转型之路》系列第二篇,持续更新中...# 从Java到AI:我的转型之路 Ⅱ ------ 手撸一个DeepSeek工具库

实战篇:如何为Java后端打造企业级AI能力

在上一篇文章中,我分享了从Java转型AI的学习路径。本篇将展示我的第一个实战项目------deepseek-util:一个基于Spring Boot的DeepSeek AI工具库,包含Prompt模板管理、A/B测试框架和完整的评论审核系统。

项目地址 :github.com/s1936914629...

一、项目背景与设计目标

在调研了多个Java AI客户端后,我发现现有方案普遍存在三个问题:

- Prompt管理混乱:硬编码在代码中,无法动态调整

- 缺乏效果评估:无法科学对比不同Prompt的效果

- 场景化能力不足:通用客户端难以适配特定业务(如内容审核)

因此,我设计了deepseek-util,核心目标:

| 模块 | 解决痛点 | 技术亮点 |

|---|---|---|

| Prompt模板引擎 | 硬编码Prompt难以维护 | 参数化模板 + 动态加载 |

| A/B测试框架 | 无法量化评估Prompt效果 | 多维度评分 + 响应时间监控 |

| 评论审核系统 | AI能力难以落地业务 | 分层架构 + 规则引擎 + 人工兜底 |

二、审核系统核心架构设计

2.1 整体架构图

2.2 模块详解

模块一:Prompt模板引擎

我设计了10个常用模板,覆盖开发、运营、产品多场景:

java

// 模板定义示例

public enum TemplateType {

GENERAL_QA("通用问答", "你是一个智能助手...", "{0}"),

CODE_GENERATOR("代码生成", "你是一位资深程序员...", "请用 {0} 语言实现 {1}"),

SUMMARIZER("内容总结", "你是一位内容总结专家...", "请总结以下内容:\n{0}"),

// ... 共10个模板

}核心特性:

- 参数化 :支持多参数注入(如

code_generator模板需要语言+功能描述) - 动态加载:可从数据库/配置中心实时更新Prompt

- 版本管理:支持Prompt版本回溯(为A/B测试提供基础)

模块二:A/B测试框架

这是项目的核心创新点。我设计了一套完整的Prompt效果评估体系:

java

public class ABTestReport {

private String template; // 模板名称

private String testCase; // 测试用例ID

private int qualityScore; // 质量评分(1-5)

private long responseTime; // 响应时间(ms)

private boolean relevant; // 是否相关

private String response; // 原始响应

}测试维度设计:

| 维度 | 评估标准 | 数据来源 |

|---|---|---|

| QualityScore | 回答准确性、完整性、结构化程度 | 人工标注 + 自动化检查 |

| ResponseTime | 端到端响应延迟 | 代码埋点统计 |

| Relevant | 是否答非所问 | 语义相似度计算 |

实测数据示例:

从测试报告可以看到有趣的现象:

| 模板 | 用例 | 质量分 | 响应时间 | 相关性 |

|---|---|---|---|---|

general_qa |

什么是AI? | 5 | 11,023ms | ❌ |

summarizer |

什么是AI? | 5 | 2,982ms | ✅ |

关键发现 :summarizer模板在"什么是AI"这个问答场景下,不仅响应速度快3.7倍(2982ms vs 11023ms),而且相关性更好。这说明Prompt的角色设定会显著影响模型表现------让模型扮演"总结专家"比"通用助手"在特定场景下更有效。

模块三:评论审核系统

这是一个完整的生产级内容安全解决方案,采用分层过滤策略:

第一层:规则引擎(毫秒级)

- 敏感词过滤(Trie树实现)

- 正则表达式匹配(手机号、身份证号等)

- 黑白名单(用户ID/IP维度)

第二层:AI审核(百毫秒级) 调用DeepSeek进行多维度分析:

java

public class AIReviewResult {

private String textCategory; // 文本分类(政治/广告/正常等)

private double sentimentScore; // 情感评分(-1到1)

private boolean violation; // 是否违规

private double creditScore; // 用户信用度(用于降权/提权)

}第三层:异步深度审核(秒级)

- 复杂模型分析(如上下文关联检测)

- 人工审核队列(Kafka削峰填谷)

- 结果回调通知

三、关键技术实现

3.1 流式响应处理

为了提升用户体验,我实现了SSE(Server-Sent Events)流式输出:

java

@GetMapping(value = "/chat/stream", produces = MediaType.TEXT_EVENT_STREAM_VALUE)

public Flux<ServerSentEvent<String>> streamChat(@RequestParam String message) {

return deepSeekClient.chatStream(message)

.map(content -> ServerSentEvent.builder(content).build());

}3.2 模板热更新

结合Spring Boot的@RefreshScope,实现Prompt不停机更新:

java

@Configuration

@RefreshScope

public class PromptTemplateConfig {

@Value("${prompt.templates.general_qa:}")

private String generalQaTemplate;

// 监听配置变更

@EventListener

public void handleRefresh(RefreshScopeRefreshedEvent event) {

log.info("Prompt模板已刷新");

templateRegistry.reload();

}

}3.3 性能优化策略

| 策略 | 实现方式 | 效果 |

|---|---|---|

| 连接池 | 使用OkHttp连接池复用TCP连接 | 减少握手开销 |

| 缓存 | Caffeine缓存高频Prompt响应 | 降低API调用成本 |

| 异步化 | 审核流程全链路异步 | 提升吞吐量 |

| 削峰填谷 | Kafka队列缓冲突发流量 | 保护下游服务 |

四、项目结构

bash

deepseek-util/

├── src/main/java/com/deepseek/util/

│ ├── client/ # DeepSeek API客户端

│ │ ├── DeepSeekClient.java

│ │ └── DeepSeekProperties.java

│ ├── template/ # Prompt模板引擎

│ │ ├── PromptTemplate.java

│ │ ├── TemplateRegistry.java

│ │ └── TemplateType.java

│ ├── abtest/ # A/B测试框架

│ │ ├── ABTestEngine.java

│ │ ├── TestReport.java

│ │ └── QualityEvaluator.java

│ └── review/ # 评论审核系统

│ ├── CommentReviewService.java

│ ├── RuleEngine.java

│ └── AIReviewClient.java

├── src/main/resources/

│ └── templates/ # 默认Prompt模板

└── docs/

├── 评论审核系统架构图.pdf

└── Prompt模板A_B测试报告.xlsx五、踩坑与反思

5.1 Prompt工程的艺术

在A/B测试中发现,同样的模型,不同的Prompt角色设定,效果天差地别:

- ❌ "你是一个AI助手" → 回答泛泛而谈,经常离题

- ✅ "你是一位资深程序员" → 代码场景回答更专业、结构化

经验 :Prompt中的角色设定(Role)不是装饰,而是隐式的约束条件,能显著激活模型的特定能力。

5.2 响应时间的权衡

从测试数据看,DeepSeek的响应时间在2-12秒之间,这对实时业务是挑战。我的解决方案:

- 异步化:非实时场景(如评论审核)走消息队列

- 流式输出:实时场景(如聊天)使用SSE,让用户感知到"正在思考"

- 缓存预热:高频问题预生成答案

5.3 成本与效果的平衡

AI审核虽然智能,但成本远高于规则引擎。我的分层策略:

- 80% 明显违规 → 规则引擎拦截(成本≈0)

- 15% 疑似违规 → AI审核(成本适中)

- 5% 复杂场景 → 人工审核(成本高但精准)

六、下一步计划

- RAG集成:接入向量数据库,实现基于私有知识的问答

- Function Calling:支持工具调用(如查询数据库、调用API)

- 多模态支持:扩展至图片审核场景

- 可视化后台:搭建Prompt管理后台,支持运营人员自助调整

结语

这个项目让我深刻体会到:AI工程化不仅仅是调用API,而是需要完整的工具链、评估体系和业务适配。从Prompt模板到A/B测试,从规则引擎到分层架构,每个环节都是Java后端工程师可以发挥价值的地方。

如果你也在探索Java与AI的结合,欢迎Star我的项目,一起交流!

GitHub地址 :github.com/s1936914629...

本文是《从Java到AI:我的转型之路》系列第二篇,持续更新中...