驱动具身智能进入通用领域最大的问题在哪里?

我们认为,核心问题在于「跨具身(cross-embodiment)迁移」。

当然,具身智能执行通用复杂任务的核心是一个完善的世界模型。但是,大多世界模型其实并没有我们想象的那样具备极强的泛化性和迁移能力。

简单来说,这些用在机器人或是智能汽车上的世界模型,基本都是在某个固定的硬件平台上设计训练的,大多不具备很强的泛化能力,跨具身迁移几乎靠运气。

说白了,大多数机器人今天学到的不是 「世界是如何运作的」,而是 「在这台机器该怎么动」。我们需要能学到一个真正理解物理与因果的世界模型 ------ 知道世界会怎么变、动作会带来什么后果,才能在不同身体、不同环境中迁移与泛化。

在这个问题上,作为算力的王者,深耕各类世界模型的英伟达再一次发力,构建了一个全新是世界模型,一切都是 Zero-Shot 的。

最近,英伟达 GEAR 实验室提出 DreamZero,一种基于预训练视频扩散骨干网络构建的世界动作模型(WAM)。

这是一个拥有 140 亿参数的模型,能够让机器人仅通过简单的文本提示就完成此前从未见过的任务。

实验室负责人 Jim Fan 将其称为机器人领域的「GPT-2 时刻」:研究团队只需输入想法,机器人就能执行相应动作。目前,该模型的代码已在 GitHub 上开源。

-

论文标题:World Action Models are Zero-shot Policies

-

Github 链接:github.com/dreamzero0/...

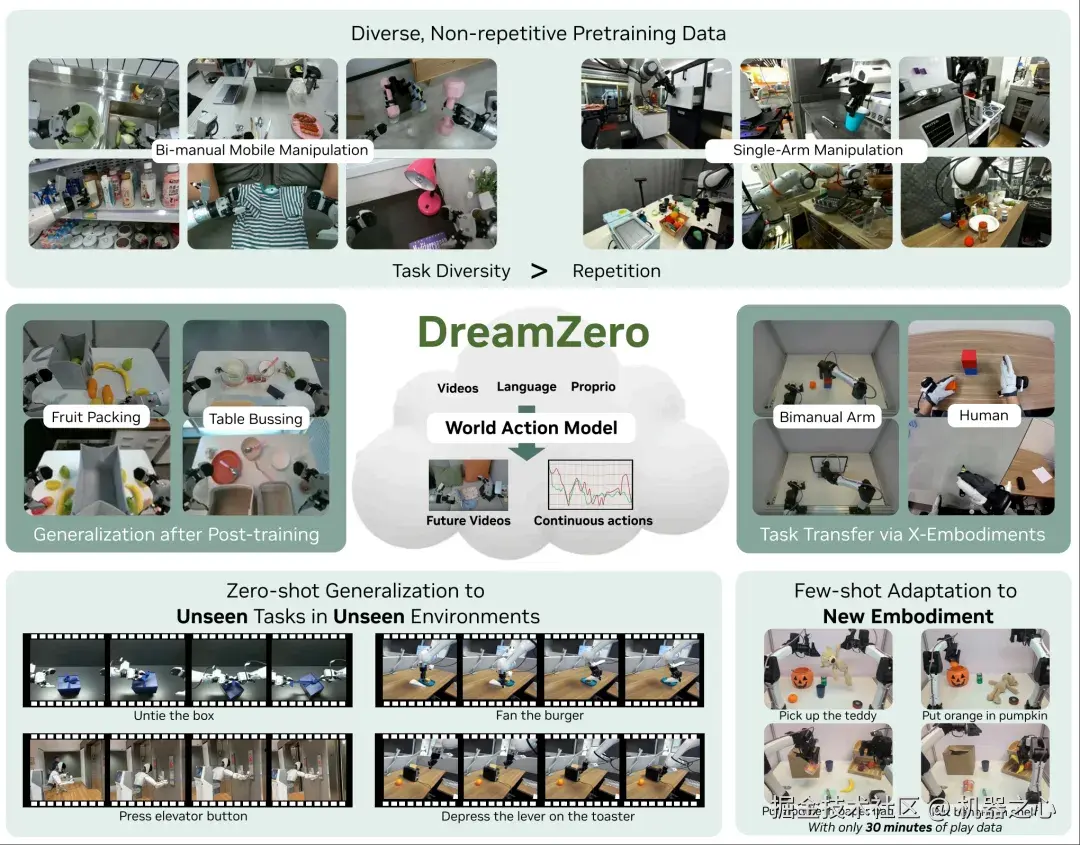

不同于传统的 VLA 模型,WAM 通过联合预测未来世界状态与动作来学习物理动力学,并以视频作为世界演化的稠密表示。通过对视频与动作的联合建模,DreamZero 能够从异构机器人数据中高效学习多样化技能,而不依赖重复示范。在真实机器人实验中,相比最先进的 VLA,DreamZero 在新任务与新环境的泛化上实现了超过 2× 的提升。

至关重要的是,通过模型与系统层面的优化,研究团队让一个 140 亿参数的自回归视频扩散模型实现了 7Hz 的实时闭环控制。此外,研究团队展示了两种跨具身迁移能力:仅使用 10--20 分钟的人类或其他机器人纯视频示范,即可在未见任务上带来 超过 42% 的性能提升。更令人惊讶的是,DreamZero 只需 30 分钟的 「玩耍数据」,就能适配到全新的机器人,同时仍保持零样本泛化能力。

DreamZero 整体概览。

图中展示了 DreamZero 通过联合预测视频与动作,世界动作模型继承了关于世界物理规律的先验,从而实现了:

1)从多样、非重复的数据中高效学习;

2)在开放世界场景中的强泛化能力;

3)仅依赖纯视频数据即可完成跨具身学习;

4)对新机器人的少样本快速适配。

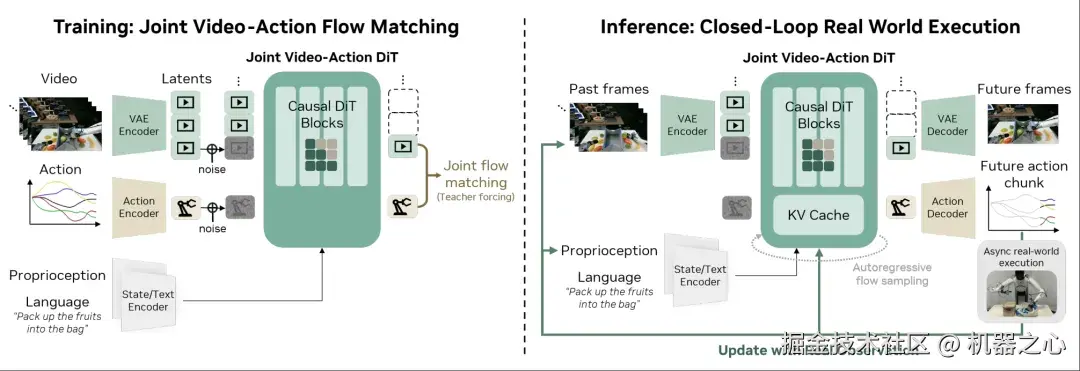

DreamZero 的模型架构。

大多的预训练的视频扩散模型凭借来自网页规模数据的丰富时空先验,成为构建机器人策略的理想骨干网络。然而,将这类模型转化为高效的世界动作模型仍面临关键挑战:

1)视频--动作对齐:联合预测视频与动作要求对视觉未来与电机指令进行紧密耦合,但如果只是简单地将独立的视频头与动作拼接,往往会导致二者对齐失效;

2)架构设计:尚不清楚双向架构还是自回归架构更适合 WAM,这关系到多模态对齐、误差累积以及推理效率等关键问题;

3)实时推理:视频扩散模型需要在高维潜空间中进行多步迭代去噪,使其在闭环控制场景下速度过慢、难以实用。

为此,DreamZero 通过模型设计选择有效应对了上述挑战。

模型接收三类输入:视觉上下文(通过 VAE 编码)、语言指令(通过文本编码器)、以及本体感知状态(通过状态编码器)。这些输入随后被送入一个基于 Flow Matching 的自回归 DiT 主干网络,由其联合预测未来的视频帧与动作,并通过各自独立的解码器输出结果。

在训练阶段,模型以分块(chunk)的方式工作:在给定干净视频上下文作为条件的情况下,对加噪的视频与动作潜变量进行去噪。在推理阶段,模型的预测会以异步方式在真实世界中执行,同时将真实观测结果回灌到 KV cache 中,以防止误差随时间累积。

实验结果

研究团队在 六种设置下展示了 DreamZero 的能力 ------ 其中 五种用于测试泛化,一种用于实时部署。

相关的训练数据以及实验结果的演示可以参考以下链接:

dreamzero0.github.io/evals_galle...

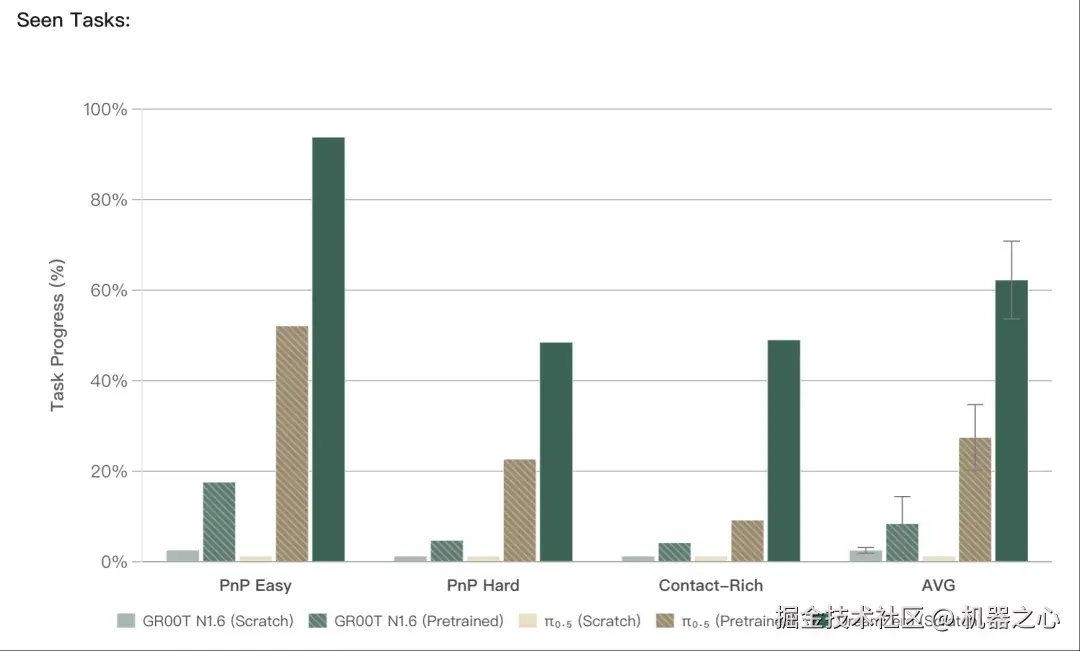

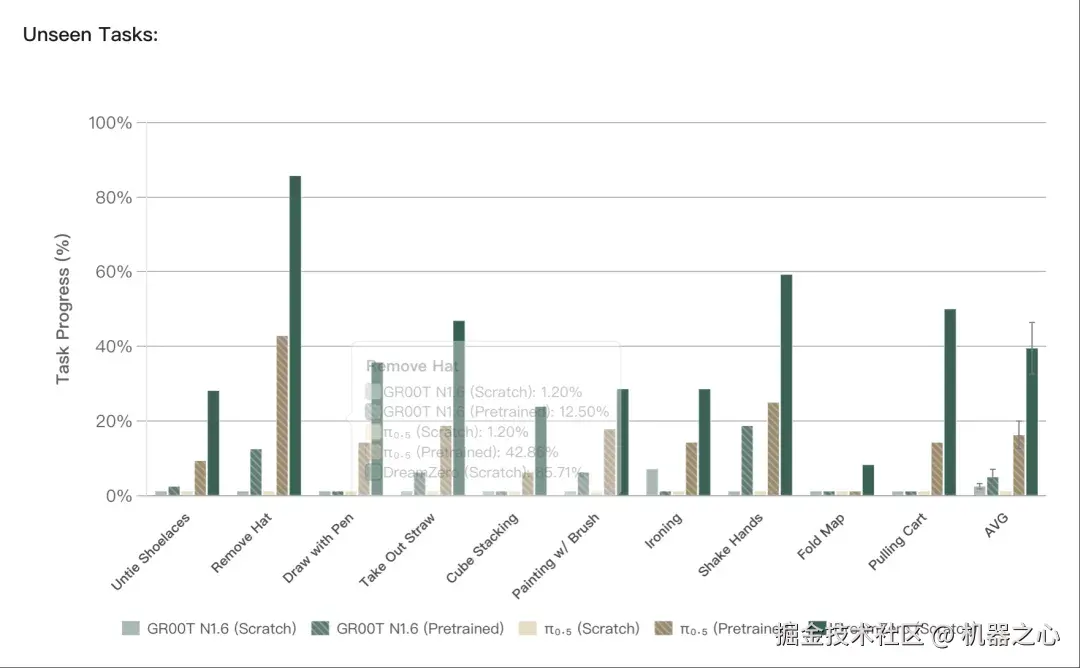

AgiBot 预训练:已见 & 未见任务

研究团队对预训练模型进行开箱即用评测:任务来自预训练分布,但在未见对象的新环境中进行零样本测试。DreamZero(也包含从零训练版本)取得 62.2% 的平均任务进度,相比最佳预训练 VLA 基线(27.4%)提升 超过 2×。从零训练的 VLA 几乎为零;预训练 VLA 有一定进展,但幅度有限。

对于训练中完全未出现的任务(如解鞋带、握手),DreamZero 仍达到 39.5% 的任务进度,而 VLA 再次表现吃力。值得注意的是,预训练 VLA 在未见任务上的有限进展,主要源于其无论指令如何都倾向于执行 「抓取 - 放置」 的默认动作,显示其过拟合于主导训练行为,而非真正理解新任务语义。研究团队在 4 台机器人、不同环境与物体上,对每个检查点进行了 80 次 rollouts。

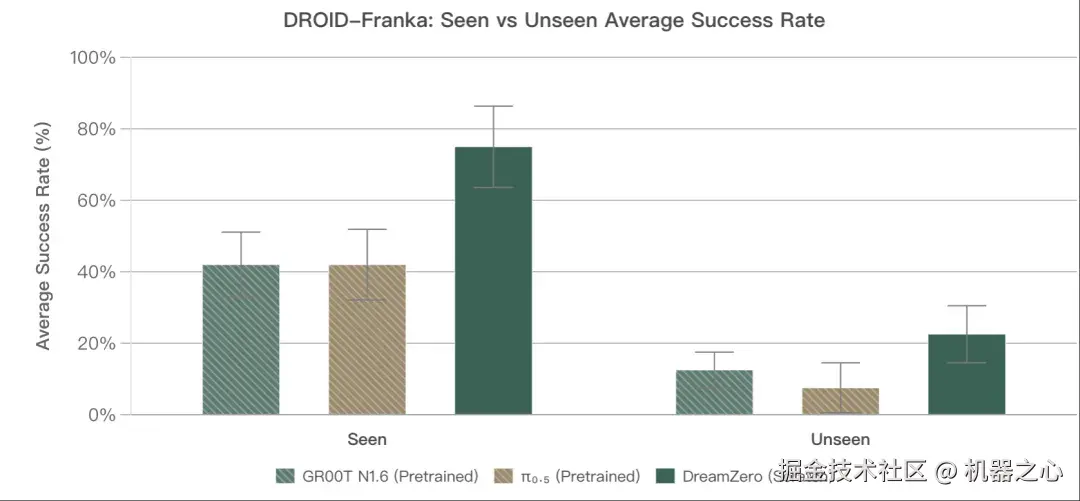

DROID:已见任务 & 未见动作

为验证在公开数据上的效果,研究团队在 DROID(最异构的开源机器人数据集之一)上训练 DreamZero,并评测 20 个已见任务与 20 个未见动词任务(DROID 中未出现的动作)。DreamZero 显著优于预训练基线,在未见动词上取得 49% 的任务进度,而最先进的 VLA 仅为 25--32%。

后训练:分布外泛化

本部分研究 WAM 在任务特定微调后是否仍保留泛化能力。研究团队在 三项下游任务上进行后训练:叠衬衫、装水果、清理餐桌。DreamZero 在三项任务上均表现更强,表明后训练后仍保持环境泛化能力。

跨具身迁移

仅用 30 分钟的玩耍数据(55 条轨迹),DreamZero 即可适配 YAM 机器人,并对南瓜、泰迪熊、纸袋等新物体实现零样本泛化,同时展现出强大的语言指令遵循能力。来自 AgiBot 预训练的知识可直接迁移,无需大规模重训。这是目前效率最高的具身迁移:以往需要数百小时示范的工作,能够在 30 分钟内完成(未使用任何其他 YAM 数据)。

交互式提示

机器人基础模型的 「提示时代」 已经到来。研究团队展示了交互式提示的实战:带着机器人走到不同地方,让人们直接用语言提出新任务。机器人能够完成多种令人惊喜的操作。

实时推理

通过模型、系统与实现层面的优化,DreamZero 实现了 每个动作块 150ms 的实时推理,支持 7Hz 闭环控制。结合异步推理与动作块平滑,执行过程更加流畅、响应迅速。研究团队对比了 16 / 4 / 1 个扩散步数的效果:步数越少延迟越低,而 DreamZero-Flash 即便在单步推理下也能保持性能。研究团队还展示了动作块平滑与异步推理对执行质量的影响。

DreamZero (16 diffusion step) + async & action chunk smoothing

零样本泛化能走多远? 研究团队持续对 DreamZero 进行压力测试:在从未训练过的任务、从未见过的环境中探索能力。从扇汉堡、按电梯按钮,到敲木琴、摇铃鼓,不断涌现出令人惊讶的新能力。

DreamZero 只是开始 ------ 它代表了基于视频世界模型的新一代机器人基础模型浪潮。

更多信息,请参阅原论文。