企业级 Prompt 工程实战指南(上):别让模糊指令浪费你的AI算力

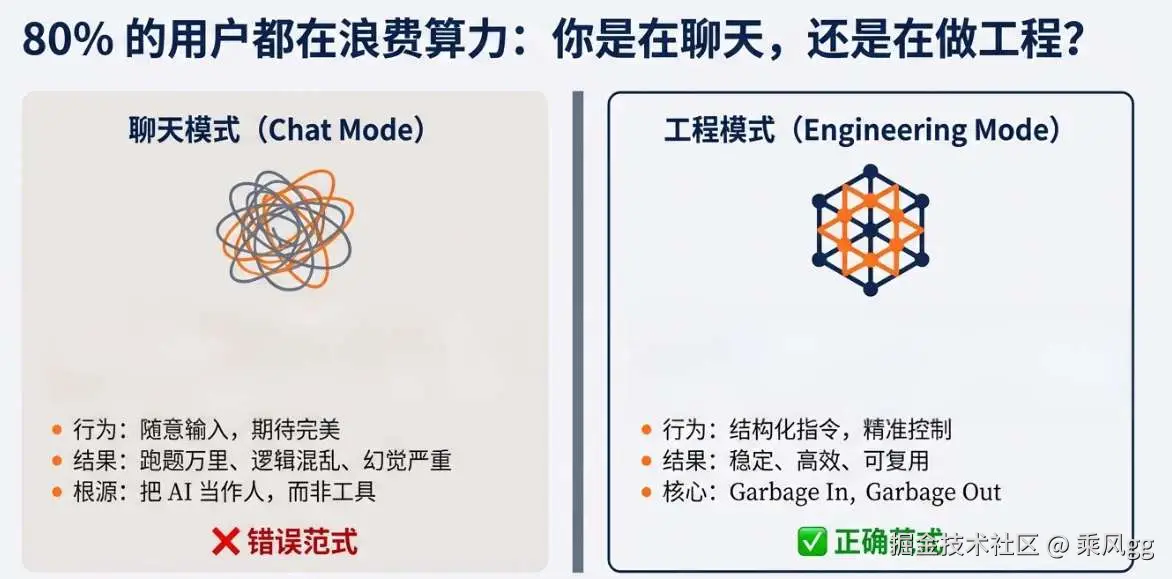

一、引言:80% 的人都踩坑!把 Prompt 当 "聊天"

Prompt(提示词 )技术作为连接人类需求与大语言模型(LLM)能力的关键桥梁,已经是家常便饭了。但在一线实践中,我发现 80% 的使用者和开发者都陷入了一个误区:把 Prompt 简单等同于日常聊天,随意地输入指令,期待模型给出完美答案。结果呢?输出要么跑题万里,要么逻辑混乱,甚至出现重复冗余的废话。这不仅浪费了大量的算力资源,更严重制约了 AI 应用在实际业务中的落地效果。

举个简单例子,一家电商企业希望利用 AI 生成产品推广文案。运营人员直接在对话框输入 "给我写个手机推广文案",得到的却是一篇毫无针对性、平淡无奇的内容,完全无法吸引目标客户。为什么会这样?因为模型没有得到明确的指令、必要的产品信息以及目标受众描述,只能在宽泛的语言空间里 "瞎猜"。

本文将结合我的实战经验,以工程化 的视角深入剖析 Prompt 设计的底层逻辑、核心技巧与落地策略 。希望帮助大家从 "凭感觉写提示词 " 的初级阶段,迈向 "用工程思维构建高效 Prompt 体系" 的新阶段,充分释放大语言模型的潜力。

二、Prompt 的底层逻辑:AI 的 "岗位说明书"+"任务清单"

2.1 核心定义:Prompt 是人类与大模型的 "交互接口"

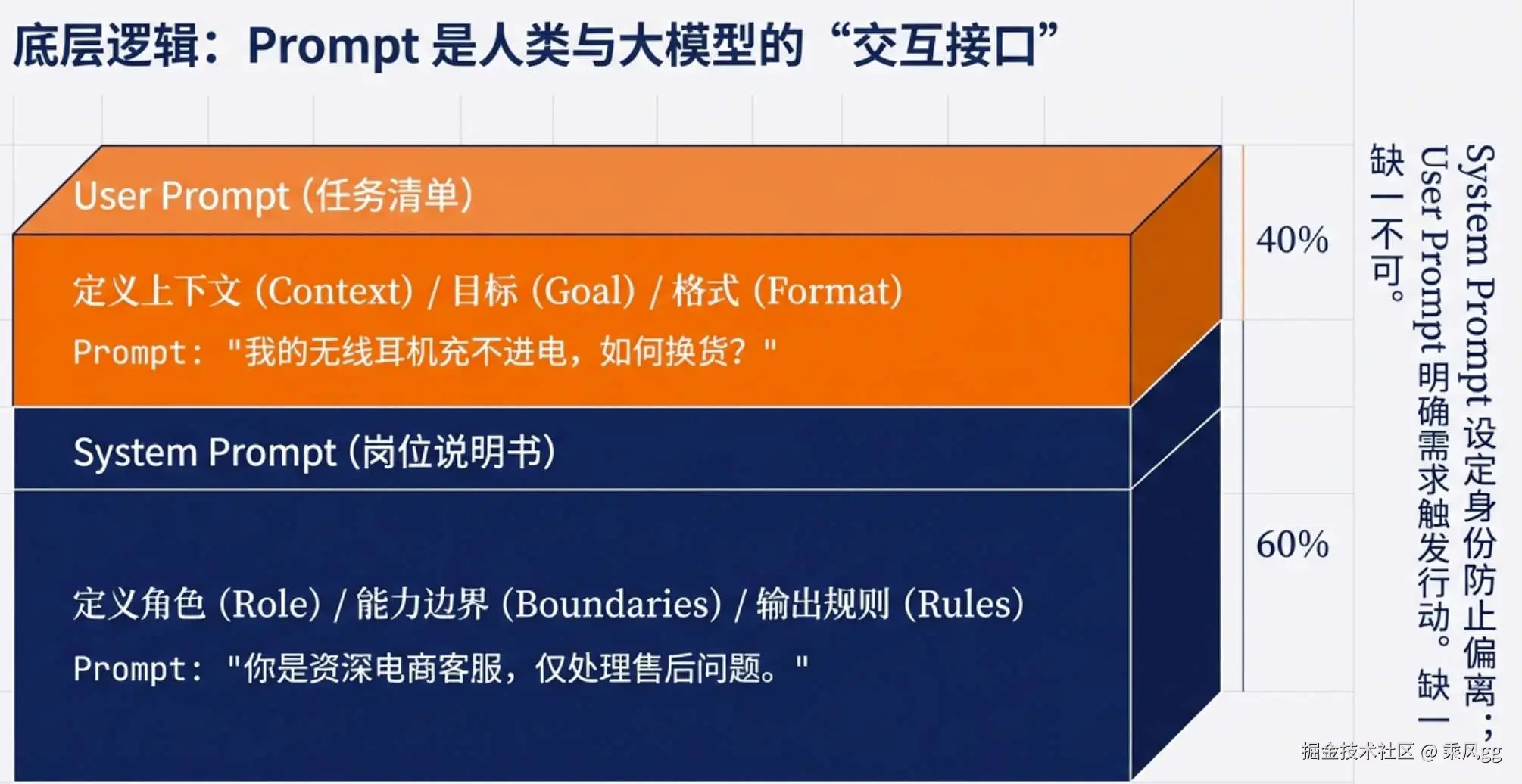

从技术本质看,Prompt 是引导大语言模型输出特定结果的结构化指令,其作用类似于给 AI 下达 "岗位说明书 "(系统 Prompt)和 "具体任务清单"(用户 Prompt)。

大模型作为 "概率机器",其输出质量完全取决于输入指令的清晰度与结构化程度,这也是 Prompt 工程的核心价值所在。如果把大语言模型比作一个能力超强但没有自主意识的 "超级员工",那么 Prompt 就是我们向它传达工作要求的唯一方式。

这个 "员工 " 虽然拥有海量的知识储备和强大的语言 处理能力,但它并不知道我们想要什么,除非我们用清晰、准确的指令告诉它。

2.2 两大核心组件:System Prompt 与 User Prompt

System Prompt 负责定义 AI 的角色、能力边界与输出规则,是全局约束,优先级高于用户输入;User Prompt 则是具体任务需求,包含上下文、目标与格式要求。二者结合构成完整的指令集。以电商客服场景为例

System Prompt 负责定义 AI 的角色、能力边界与输出规则,是全局约束,优先级高于用户输入;User Prompt 则是具体任务需求,包含上下文、目标与格式要求。二者结合构成完整的指令集。以电商客服场景为例

- 系统 Prompt:你是资深电商客服,仅处理售后问题;

- 用户 Prompt:我的无线耳机充不进电,如何换货",

这两个部分缺一不可。系统 Prompt 为 AI 设定了身份和职责范围,确保它不会偏离售后客服的角色去回答其他无关问题;而用户 Prompt 则明确了具体的任务内容,让 AI 能够针对性地提供解决方案。

如果只有用户 Prompt,AI 可能会因为缺乏角色定位而给出不专业或不相关的回答;反之,如果只有系统 Prompt,没有具体的用户需求,AI 就不知道该从何下手。

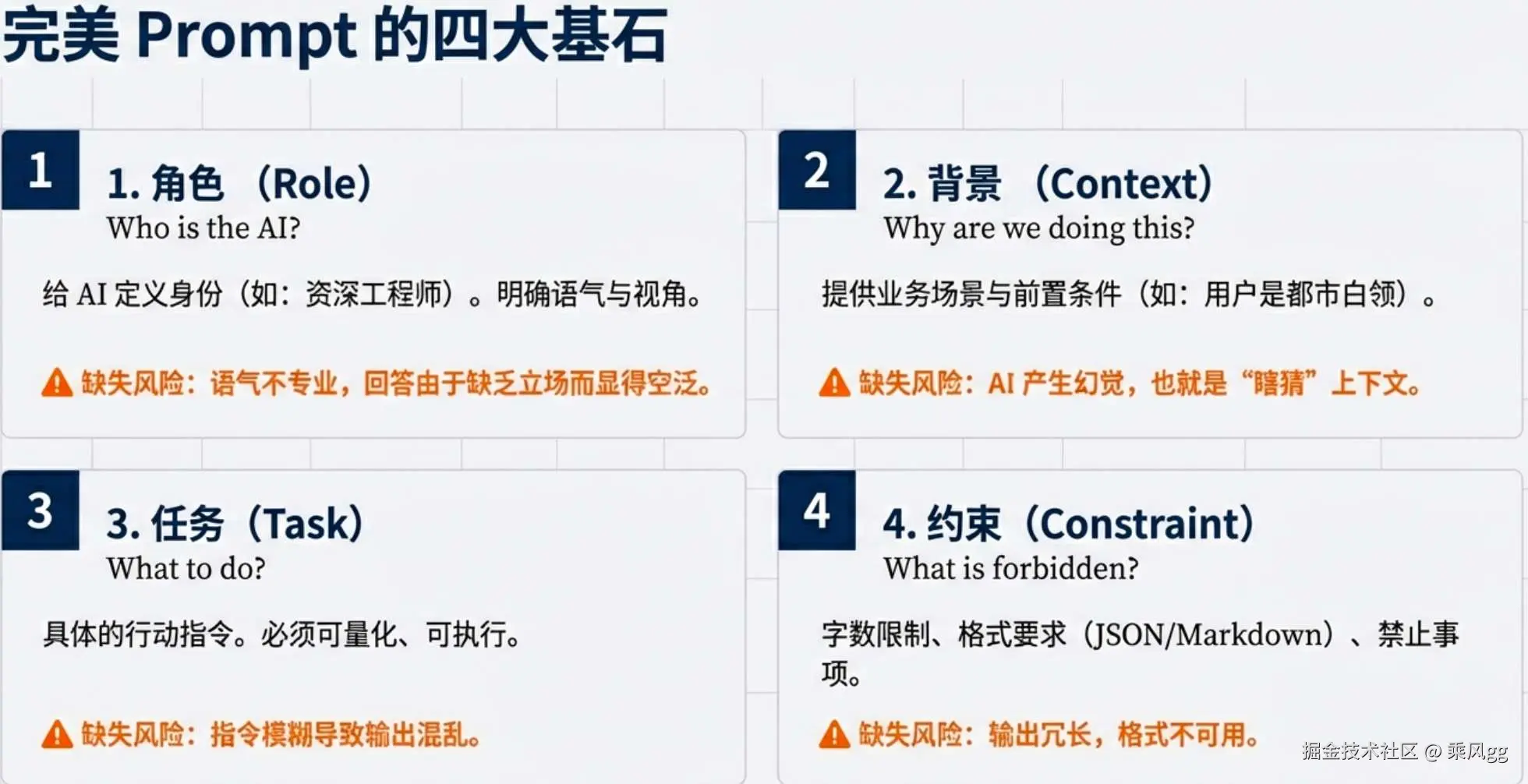

2.3 Prompt 四大核心要素:角色、背景信息、任务、约束

Prompt 工程的核心,本质是把模糊需求转化为模型可精准解读的"结构化指令",而角色、背景信息、任务、约束这四大要素,就是构成指令的"四大基石"------缺少任何一个,都可能导致指令模糊、输出失控。这四大要素并非孤立存在,而是相互支撑,共同定义了"AI 该如何做、做什么、依据什么做、不能做什么 ",是从"凭感觉写提示 "到"工程化设计"的关键转变。

2.3.1 核心一:角色------给 AI 定"身份"

角色是 Prompt 的"灵魂",核心作用是明确 AI 的身份、专业度和语气风格,相当于给"超级员工"定岗位,让它知道自己该以何种视角回应需求。很多开发者忽略角色设定,导致 AI 输出"不接地气""不专业",本质就是角色模糊。

实战案例:同样是"解读产品故障",不同角色的输出天差地别。若不设定角色,Prompt 为"解读耳机充不进电的原因",AI 可能输出晦涩的技术术语;若设定角色为"资深电商售后工程师,面向普通消费者,用通俗语言解读,避免专业术语",AI 会输出"大概率是充电线接触不良或充电口有灰尘,你先换一根充电线试试,再用棉签清理下充电口",更贴合业务需求。

常见误区:角色设定过于宽泛(如"专业人士"),未明确具体领域和沟通对象,导致 AI 输出偏离预期。

2.3.2 核心二:背景信息------给 AI 补"上下文"

背景信息是 AI 决策的"依据",核心是提供任务相关的上下文、前提条件和关键信息。让它知道"为什么做""基于什么做"。缺少背景信息,AI 只能依赖预训练知识猜测,易出现"幻觉"或偏离业务场景。

实战案例:结合前文工单分类场景,若 Prompt 仅设定角色和任务("电商售后工单分类专家,分类工单"),未提供背景信息,AI 可能无法区分"物流延迟"和"产品故障"的边界;若补充背景信息"本电商平台主营3C产品,物流合作快递公司为中通、圆通,售后工单主要涉及物流配送、产品质量、退换货三类场景",AI 分类准确率会大幅提升,避免将"中通快递延迟"误判为"产品故障"。

关键原则:背景信息无需冗余,只需提炼"与任务直接相关"的核心信息,优先补充"业务场景、行业规则、前提条件",避免无关信息占用 token。

2.3.3 核心三:任务------给 AI 下"指令"

任务是 Prompt 的"核心目标",核心是明确 AI 要完成的具体工作,必须清晰、具体、不能模糊。这是四大要素中最基础、也最容易踩坑的部分,前文提到的"随便发挥"误区,本质就是任务设定模糊。

实战对比:模糊任务 Prompt 为"优化产品描述",AI 输出大概率杂乱无章;精准任务 Prompt 为"优化3C产品(无线耳机)的产品描述,突出'续航20小时''降噪深度40dB'两大核心卖点,面向年轻消费者,语言简洁有感染力,控制在150字内",AI 输出会更具针对性。

核心技巧:任务设定需遵循"可量化、可落地",避免使用"更好、更专业、更生动"等模糊表述,明确"做什么、做到什么程度、输出什么形式"。

2.3.4 核心四:约束------给 AI 划"边界"

约束的核心是明确 AI 的输出边界、禁止行为和格式要求,让它知道"不能做什么"。缺少约束,即使角色、背景、任务明确,AI 也可能输出冗余、偏离格式或不符合业务规则的内容。

实战案例:仍以工单分类场景为例,若仅设定任务"生成工单摘要",未加约束,AI 可能生成100字以上的冗余内容,不便于客服快速查看;若补充约束"摘要控制在50字内,仅包含用户核心诉求、涉及产品和关键时间,禁止冗余表述,不添加解决方案",AI 输出会严格符合业务需求,如"用户昨日收到衣服,尺码不符,咨询换货寄回流程"。

常见约束类型:格式约束(如"输出为JSON格式""分点罗列")、内容约束(如"禁止使用专业术语""不添加无关建议")、篇幅约束(如"控制在200字内")、边界约束(如"仅处理售后问题,不回答售前咨询")。

四大要素总结:工作角色、工作背景资料、工作任务目标、工作规矩,四大要素协同作用,才能构成一份高质量的 Prompt。

三、避坑指南:四大典型 Prompt 误区及优化方案

3.1 误区一:"随便发挥"

错误示例:"写点推荐文案"。这种过于宽泛的指令,就像让一个厨师 "做点好吃的",却不告诉他菜系、食材和用餐人数,结果必然是输出失控。由于缺少角色、场景、受众等关键约束,AI 无法准确把握需求,输出的文案可能风格混杂、主题模糊,无法满足任何实际业务需求。

优化方案 :明确 "角色 + 场景 + 目标 + 格式"。以推荐文案为例,优化后的 Prompt 可以是 "你是小红书文案策划,为注重健康的都市白领写 100 字内无糖苏打饮料推荐文案,风格活泼有生活感"。这样详细的指令,从根源上避免了 AI 的 "自由发挥",让它能够聚焦于目标受众和具体需求,生成符合预期的内容。通过清晰的角色设定(小红书文案策划)、场景描述(面向注重健康的都市白领)、目标界定(推荐无糖苏打饮料)和格式要求(100 字内、活泼有生活感),AI 能够更好地理解任务,输出更有针对性和吸引力的文案。

3.2 误区二:多目标并行

错误示例:"写会议纪要 + 行动清单 + 邮件模板"。在这个指令中,单一 Prompt 包含了三个独立且复杂的任务,这对于模型来说就像同时接到三个不同客户的订单,却没有明确的优先级和处理流程,很容易导致输出结构混乱、顾此失彼。模型可能会在不同任务之间来回切换,无法深入处理每个任务,最终生成的会议纪要缺乏重点、行动清单逻辑不清晰、邮件模板格式错误。

优化方案 :拆分任务或结构化指令。一种方法是将任务分步骤进行,先让模型生成会议纪要,再基于纪要生成行动清单,最后根据前两者生成邮件模 板;另一种方法是在 Prompt 中明确要求 "分别输出 3 部分内容:1. 会议纪要;2. 行动清单;3. 全员通知邮件模板",并对每部分的内容和格式进行详细说明。这样可以降低模型的处理复杂度,使其能够专注于每个任务,提高输出的质量和准确性。通过结构化的指令,模型能够更好地组织思路,按照要求依次完成各个任务,生成逻辑连贯、结构清晰的结果。

3.3 误区三:"专业一点"

"更有感觉""更专业""更生动" 等模糊表述是 AI 的 "死敌"。因为这些表述缺乏量化标准,模型无法判断需求边界。例如,当我们要求 "把简介写得更专业" 时,不同的人对 "专业" 的理解可能千差万别,模型也只能在模糊的概念中挣扎,无法确定具体的修改方向和程度。这种模糊指令会导致模型输出的结果要么过于平淡,没有达到预期的专业度;要么过于夸张,偏离了实际需求。

优化方案 :具象化要求。将 "把简介写得更专业" 改为 "将公司简介重写为企业官网版本,语言突出权威性与行业属性,面向制造业客户",这样的指令明确了具体的应用场景(企业官网 )、语言风格(突出权威性与行业属性)和目标受众(制造业客户),让模型能够有针对性地进行创作。通过具象化的描述,模型能够更好地理解用户对 "专业" 的期望,从语言表达、内容组织等方面进行优化,生成更符合专业要求的公司简介。

3.4 误区四:指代不明

错误示例:"把它优化一下"。这个指令中的 "它" 指代不明,模型无法确定优化的对象是一段文字、一个设计还是其他内容。同时,由于缺乏上下文,模型也不知道优化的方向和重点,是要改进语法错误、提升逻辑清晰度还是增强内容的吸引力?这种指代不明和上下文缺失的指令,会让模型陷入困惑,无法准确理解用户的意图,从而生成错误或不相关的结果。

优化方案 :补充完整信息。如果是要优化节能冰箱的产品描述,可以这样表述:"优化以下节能冰箱产品描述,突出其 24 小时耗电 0.5 度的环保优势,适用于环保类公众号,语气亲切真实"。这样的指令明确了优化对象(节能冰箱产品描述)、优化重点(突出 24 小时耗电 0.5 度的环保优势)、应用场景(环保)和语言风格(语气亲切真实),消除了指令中的歧义,让模型能够根据具体要求进行有针对性的优化。通过补充完整的上下文信息,模型能够更好地理解用户的需求,从多个维度对产品描述进行优化,提高其在特定场景下的吸引力和有效性。

下篇预告

掌握了 Prompt 的底层逻辑与避坑技巧,如何在实际业务中落地?下篇将带来完整实战案例(电商工单自动分类与摘要生成 )、三大 Prompt 技术路径对比 、工程化落地策略 ,以及目前趋势展望!

欢迎大家点赞关注,下期更精彩!