近来CNN与LSTM融合 研究的热度一路飙升,顶会顶刊成果不断涌现!其中经过优化的CNN-LSTM混合模型,成功突破时空特征建模的现有局限,在医疗影像分析、电力负荷时序预测、无线通信信号处理等多个场景中刷新SOTA纪录,被TPAMI、NeurIPS等顶会顶刊广泛收录!CNN与LSTM的融合模式,必将成为未来时空序列相关任务的主流趋势。

CNN的核心优势在于精准提取局部空间特征,能够逐层捕捉图像纹理、信号边缘等细节信息,在局部特征挖掘领域表现突出;而LSTM则依靠其独特的门控机制,可高效捕捉长程时间依赖关系,恰好弥补了CNN在动态时序演化规律建模上的不足。两者相辅相成、优势互补,实现了**"局部空间特征提取+全局时序规律建模"**的双重提升,性能表现远优于单一CNN或LSTM模型。

对于打算发论文的小伙伴来说,可重点从这几个方向切入:优化混合架构结构、融入注意力机制、推进模型轻量化部署、适配小样本场景等...... 我已整理好相关顶会论文 及复现代码( 部分 ), 想快速上手的同学工种号 沃的顶会 扫码回复 "CNN+LSTM" 领取。

H-Infinity Filter Enhanced CNN-LSTM for Arrhythmia Detection from Heart Sound Recordings

文章解析

本文针对心音信号中噪声强、数据量小、类别严重不平衡等现实挑战,提出一种新型深度学习架构CNN-H∞-LSTM:将LSTM的遗忘门与细胞状态更新机制替换为受控制理论中H-Infinity滤波器启发的可训练参数,以提升模型在未知噪声下的鲁棒性与泛化能力;结合Stochastic Adaptive Probe Thresholding(SAPT)优化策略与定制化损失函数,在PhysioNet CinC Challenge 2016数据集上实现99.42%测试准确率和98.85% F1分数,显著优于现有基准模型。

创新点

首次将控制理论中的H-Infinity滤波器可训练参数嵌入LSTM单元,替代传统遗忘门与细胞状态更新方程,增强模型对小样本、高噪声心音数据的鲁棒估计能力。

提出Stochastic Adaptive Probe Thresholding(SAPT)训练优化方法,并设计定制化惩罚损失函数,协同缓解PhysioNet CinC数据集中高达87%的正常样本主导导致的严重类别不平衡问题。

研究方法

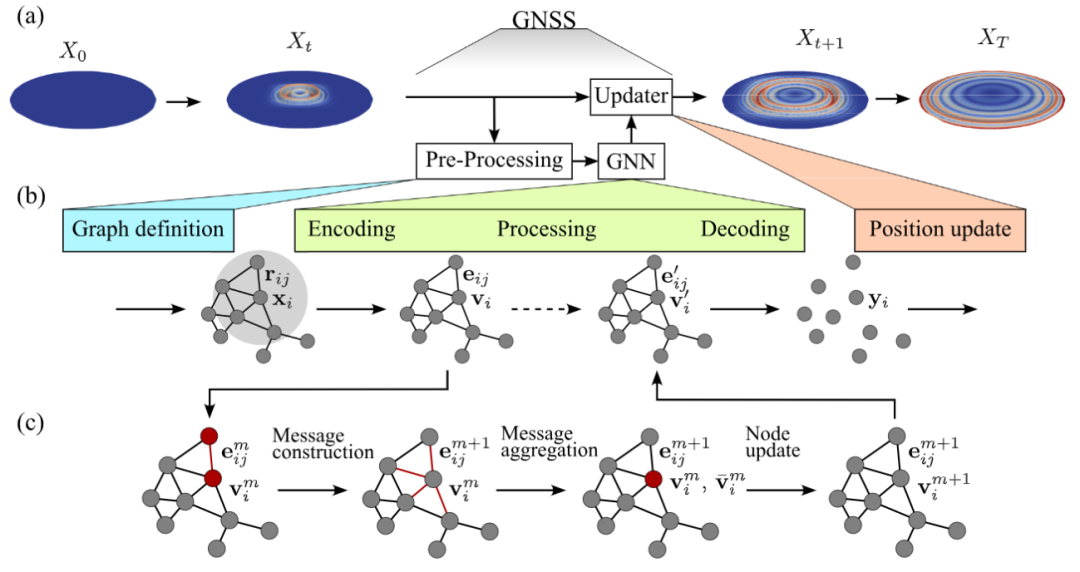

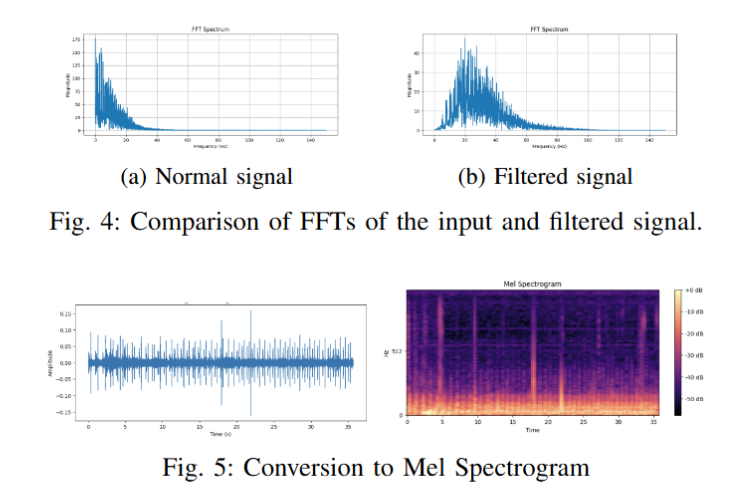

采用双阶段预处理:先用Daubechies 4小波变换(DWT)提取多尺度时频特征,再经5阶Butterworth低通IIR滤波器(截止频率500 Hz)抑制高频噪声。

将原始心音切分为固定长度5秒片段,并转换为Mel spectrogram作为模型输入。

构建CNN-H∞-LSTM混合架构:CNN层提取局部空间特征,H∞-LSTM层(含H∞滤波器启发的可训练状态更新机制)建模长时序动态模式。

使用SAPT策略动态调整分类阈值,并结合加权损失函数优化训练过程,以应对类别极度不平衡。

研究结论

CNN-H∞-LSTM在PhysioNet CinC Challenge 2016数据集(约6000个标注心音样本)上实现稳定收敛,测试准确率达99.42%,F1分数达98.85%,超越现有CNN、CRNN、Capsule Network等基准模型。

H-Infinity滤波器引入的最坏情况误差最小化机制显著提升了模型在真实临床噪声环境下的泛化性能,验证了控制理论工具赋能医学AI建模的有效性。

所提方法尤其适用于资源受限、标注稀缺且信噪比低的生物医学信号分析场景,为端到端心音智能诊断提供了新范式。

Automatic Sign Language Recognition: A Hybrid CNN-LSTM Approach Based on Mediapipe

文章解析

本文提出了一种基于Mediapipe关键点提取与CNN-LSTM混合架构的手语自动识别系统,旨在提升听障人群在医疗、教育等关键领域的服务可及性。系统使用Python、TensorFlow和Streamlit实现端到端实时手势翻译,平均准确率达92%;对视觉差异显著的手势(如"Bonjour"/"Hello"、"Merci"/"Thank you")识别效果优异,但在高度相似手势(如"Appeler"/"Call"与"Yes")间仍存在混淆。

创新点

设计并实现了CNN-LSTM混合架构,协同建模手势的空间特征(CNN)与时间动态(LSTM)。

首次将Mediapipe统一用于手、脸、躯干三域关键点提取,并将其作为鲁棒的多模态手势表征基础。

构建了轻量级、可交互的实时手语翻译系统,通过Streamlit提供直观的用户界面。

研究方法

利用Mediapipe从视频帧中提取21个手部、468个面部、33个躯干关键点(x, y, z坐标),形成时空关键点序列。

对关键点序列进行归一化(以肩/腕为参考)、固定长度截断与数据增强(旋转、缩放、时序偏移)。

采用CNN模块提取单帧内关键点空间关系特征,再经LSTM建模跨帧时序依赖,最终输出手势类别。

基于TensorFlow训练模型,在80%训练集/20%测试集划分下评估性能,使用Streamlit部署实时推理界面。

研究结论

CNN-LSTM混合架构在手语识别任务中展现出高有效性,整体平均准确率达92%,F1-score达90.5%。

Mediapipe提供的高精度关键点是系统鲁棒性的核心支撑,尤其利于捕捉面部表情与身体姿态等手语必要语义线索。

相比Transformer类方法,本方案在保持竞争力精度的同时显著降低推理延迟,更适合边缘设备实时部署。