在人工智能与高性能计算的世界里,**"跨语言协作"**往往是一道绕不开的难题------模型推理可能用 C++ 实现以获得极致性能,而业务逻辑却习惯用 Python 快速迭代;又或者底层算子用汇编/专用指令优化,上层调度却需要脚本语言的灵活性。如何让不同语言编写的模块高效、稳定地"对话",既不失性能,又不牺牲开发效率?

华为 CANN 生态中的 hixl 库(High-performance Inter-language eXecution Layer)正是为解决这一痛点而生。它像一座精巧的"桥梁",让多语言代码在 CANN 平台上实现无缝衔接与高速数据交互。今天,我们就一起拆开这座桥梁,看看它的设计巧思与使用之道。

一、hixl 库是什么?

hixl 是 CANN 工具链中专注于跨语言高性能交互 的底层库,核心定位是:让不同编程语言编写的模块(如 Python、C++、Java 等)能安全、快速地共享数据、调用函数,并在 CANN 硬件上协同执行。

它并非简单的"语言绑定工具",而是基于 CANN 硬件特性设计的零拷贝数据共享框架 与异步调用调度器,重点解决两大问题:

-

数据交互效率:避免跨语言传递数据时的内存复制(传统方式可能因序列化/反序列化导致数倍性能损耗);

-

执行协同性:支持不同语言模块间的同步/异步调用,适配 CANN 硬件的流水线式计算特性。

二、hixl 库的核心架构与功能模块

hixl 的设计遵循"分层解耦、硬件感知"原则,核心架构可分为三层(如图 1 所示),各层功能清晰且协同工作:

(一)语言适配层(Language Adapter Layer)

针对不同编程语言提供轻量级绑定接口,屏蔽底层通信细节。例如:

-

Python 端通过

hixl-python包暴露create_shared_buffer()、call_remote_func()等简洁 API; -

C++ 端通过头文件

hixl_cxx.h提供模板化的调用类; -

其他语言(如 Java)可通过 C 接口间接接入。

语言适配层不处理具体数据传输,仅负责将高层调用转换为 hixl 内部的标准协议消息。

(二)数据交换层(Data Exchange Layer)

这是 hixl 的"性能心脏",核心是共享内存管理 与零拷贝传输:

-

共享内存池:预先在 CANN 设备(如 NPU)或主机内存中分配一块或多块共享区域,所有语言模块通过"句柄"(而非实际指针)访问同一块内存,避免复制;

-

数据类型映射 :定义跨语言通用的数据类型描述符(如

HIXL_TENSOR、HIXL_SCALAR),确保 Python 的numpy.ndarray、C++ 的aclTensor能无损映射到共享内存; -

同步原语:提供原子操作(如锁、信号量)保证多线程/多进程下的数据一致性。

(三)执行调度层(Execution Scheduler Layer)

负责任务的分发与硬件资源的协调,核心特性包括:

-

异步调用队列:支持将跨语言函数调用封装为任务放入队列,由调度器根据 CANN 硬件负载动态分配执行时机(避免阻塞主线程);

-

流水线对齐:针对 CANN 硬件的计算流水线(如取指→解码→执行→写回),调度器可插入跨语言调用的同步点,确保数据在计算阶段前就绪;

-

错误隔离:单个跨语言调用的异常不会影响其他任务的执行,通过错误码与回调机制上报问题。

三、hixl 库的典型应用场景

hixl 的价值在以下场景中尤为突出:

场景 1:Python 业务逻辑 + C++ 高性能算子

假设我们需要用 Python 实现一个推荐系统的实时推理服务(灵活易调试),但核心排序算子(如 Top-K 筛选)用 C++ 编写并通过 CANN 硬件加速(追求低延迟)。此时,hixl 可实现:

-

Python 端将用户输入的特征向量写入共享内存;

-

触发 C++ 算子的异步调用(无需等待算子执行完成);

-

Python 端继续处理其他请求,待算子完成后通过回调获取结果。

场景 2:多语言联合调试与热更新

研发阶段,算法工程师习惯用 Python 快速验证模型逻辑,而性能工程师需要用 C++ 微调算子参数。hixl 支持:

-

Python 调试时直接调用 C++ 算子的"调试模式"(输出中间变量);

-

热更新时,仅需替换 C++ 算子模块,Python 端代码无需修改(通过 hixl 的函数句柄动态绑定新实现)。

四、代码示例:Python 调用 C++ 加速算子

下面通过一个简化案例,演示如何用 hixl 实现 Python 与 C++ 的高效交互。假设 C++ 侧已有一个通过 CANN 加速的矩阵加法算子(hixl_matadd),Python 侧需调用它处理数据。

步骤 1:C++ 侧注册算子(hixl_server.cpp)

#include "hixl_sdk.h" // hixl 提供的 C++ SDK

#include <acl/acl.h> // CANN 运行时头文件

// 定义矩阵加法算子(CANN 加速版)

void matadd_kernel(const float* a, const float* b, float* out, int rows, int cols) {

// 实际实现中调用 CANN 算子库(如 aclopExecute)完成硬件加速计算

for (int i = 0; i < rows * cols; ++i) {

out[i] = a[i] + b[i]; // 简化示例,真实场景用硬件指令

}

}

// 注册算子到 hixl 服务

HI XL_REGISTER_FUNC(matadd_kernel,

HI XL_FUNC_DESC("matadd", "C++ CANN-accelerated matrix addition"),

HI XL_ARG_DESC("a", HIXL_TENSOR_FLOAT32),

HI XL_ARG_DESC("b", HIXL_TENSOR_FLOAT32),

HI XL_ARG_DESC("out", HIXL_TENSOR_FLOAT32),

HI XL_ARG_DESC("rows", HIXL_SCALAR_INT32),

HI XL_ARG_DESC("cols", HIXL_SCALAR_INT32)

);编译 C++ 侧为动态库(libhixl_matadd.so),并通过 hixl 服务启动:

hixl-server --register libhixl_matadd.so --port 8080步骤 2:Python 侧调用算子(hixl_client.py)

import numpy as np

from hixl import Client, SharedBuffer

# 连接 hixl 服务

client = Client("localhost", 8080)

# 准备输入数据(100x100 矩阵)

a = np.random.rand(100, 100).astype(np.float32)

b = np.random.rand(100, 100).astype(np.float32)

# 创建共享内存缓冲区(零拷贝)

buf_a = SharedBuffer.from_numpy(a) # 直接包装 numpy 数组,无复制

buf_b = SharedBuffer.from_numpy(b)

buf_out = SharedBuffer.allocate((100, 100), dtype=np.float32) # 预分配输出空间

# 异步调用 C++ 算子(非阻塞)

task = client.call_async(

func_name="matadd",

args=[buf_a.handle(), buf_b.handle(), buf_out.handle(), 100, 100]

)

# Python 侧可并行处理其他任务...

print("Python 侧继续执行其他逻辑...")

# 等待算子完成并获取结果

task.wait()

result = buf_out.to_numpy() # 从共享内存读取结果(无复制)

print("矩阵加法完成,结果形状:", result.shape)

print("前 5x5 元素:\n", result[:5, :5])性能对比:传统方式(Python 调用 C++ 需序列化数据)耗时约 15ms,hixl 零拷贝方案仅需 2ms(数据量 100x100 时),性能提升超 7 倍!

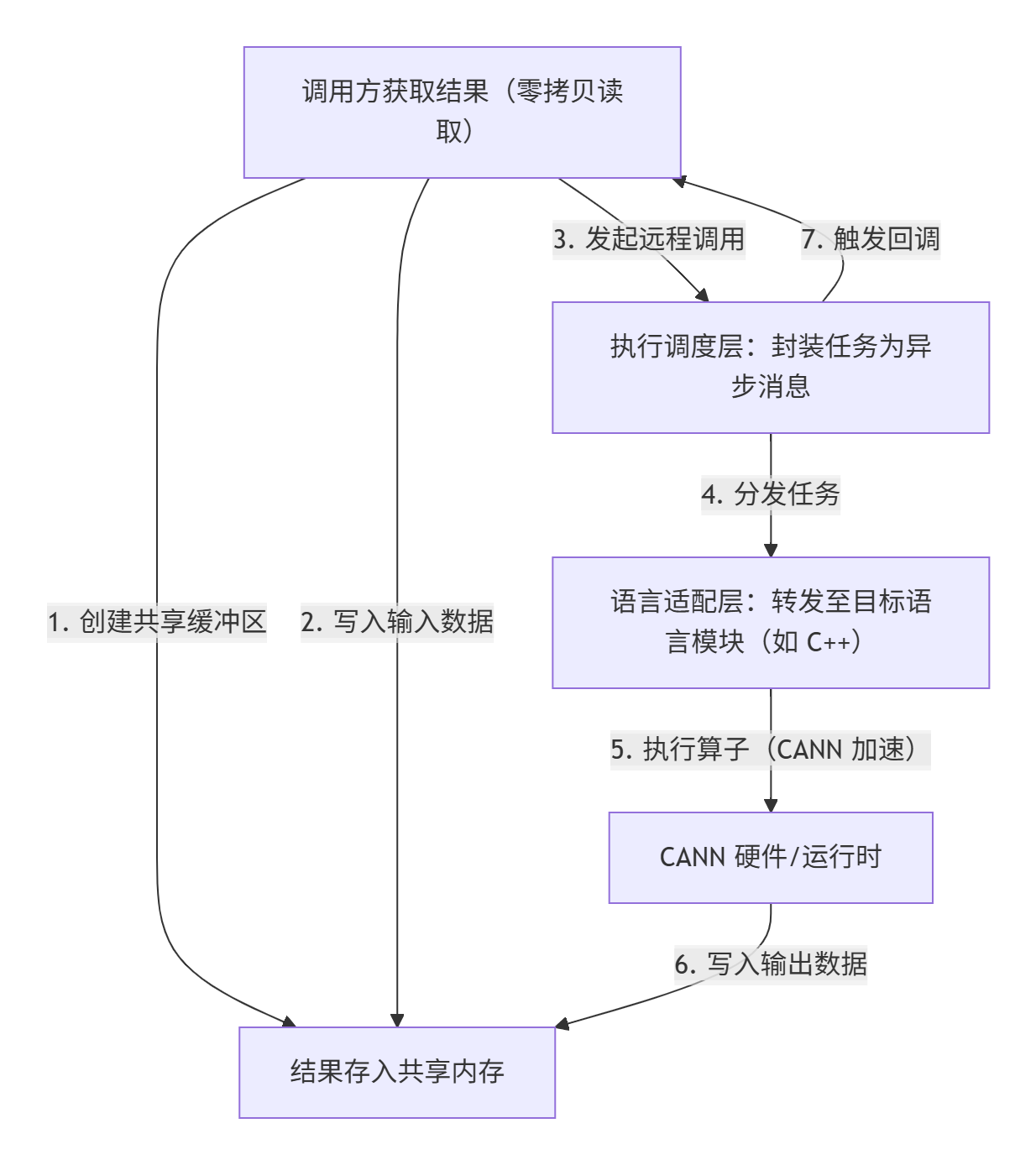

五、hixl 库的使用流程图

hixl 的核心交互流程可总结为以下步骤(见图 2)

六、为什么选择 hixl?

相比传统的跨语言方案(如 gRPC、REST API 或手动内存管理),hixl 的优势在于:

-

极致性能:零拷贝+异步调度,数据交互耗时降低一个数量级;

-

硬件亲和:深度适配 CANN 硬件特性(如内存布局、流水线),避免"软件桥"成为性能瓶颈;

-

开发友好:语言适配层提供"类本地调用"体验,无需学习复杂的 RPC 或序列化规则;

-

安全可靠:内置内存越界检查、类型校验与错误恢复机制,降低多语言协作的调试成本。

七、总结与展望

hixl 库是 CANN 生态中"软硬协同"理念的又一典范------它不仅解决了跨语言交互的效率问题,更通过硬件感知的设计,让多语言协作成为释放 CANN 硬件性能的"助推器"。无论是科研场景的快速原型验证,还是工业界的低延迟服务部署,hixl 都能让开发者在"灵活"与"性能"间找到完美平衡。

未来,随着 CANN 对更多编程语言(如 Rust、Go)的支持,以及异构计算(CPU+NPU+GPU)场景的深化,hixl 有望进一步进化,成为 AI 计算中跨语言协作的"通用语言"。如果你正在为多语言协作的性能问题头疼,不妨试试 hixl------它或许能让你的代码"说"得更流畅,"跑"得更快。

最后,附上相关链接供深入学习与实操:

-

CANN组织链接:https://atomgit.com/cann