一、引言

在当今数字化时代,图像数据如同浩瀚的海洋般源源不断地产生。从日常拍摄的照片到医疗影像、卫星图像等专业领域的数据,如何从这海量的图像数据中提取有价值的信息,成为了众多领域关注的焦点。深度学习中的卷积神经网络(Convolutional Neural Network,简称 CNN)就如同一位技艺高超的渔夫,能够在这图像数据的海洋中精准地 "捕捞" 特征。本文将深入探讨 CNN 是如何实现这一神奇功能的。

二、深度学习与图像数据

(一)深度学习概述

深度学习是一类基于人工神经网络的机器学习技术。它通过构建具有多个层次的神经网络模型,让计算机自动从大量数据中学习特征和模式,从而实现对数据的分类、预测等任务。深度学习模型就像是一个复杂的黑箱,输入数据,经过层层处理,输出我们期望的结果。

打个比方,深度学习模型就像是一个厨师,它能根据不同的食材(数据),按照特定的烹饪方法(模型结构和算法),制作出美味的菜肴(预测结果)。只不过这个厨师不需要我们详细地告诉它每一步该怎么做,它自己就能从大量的烹饪经验(训练数据)中总结出方法。

(二)图像数据的特点

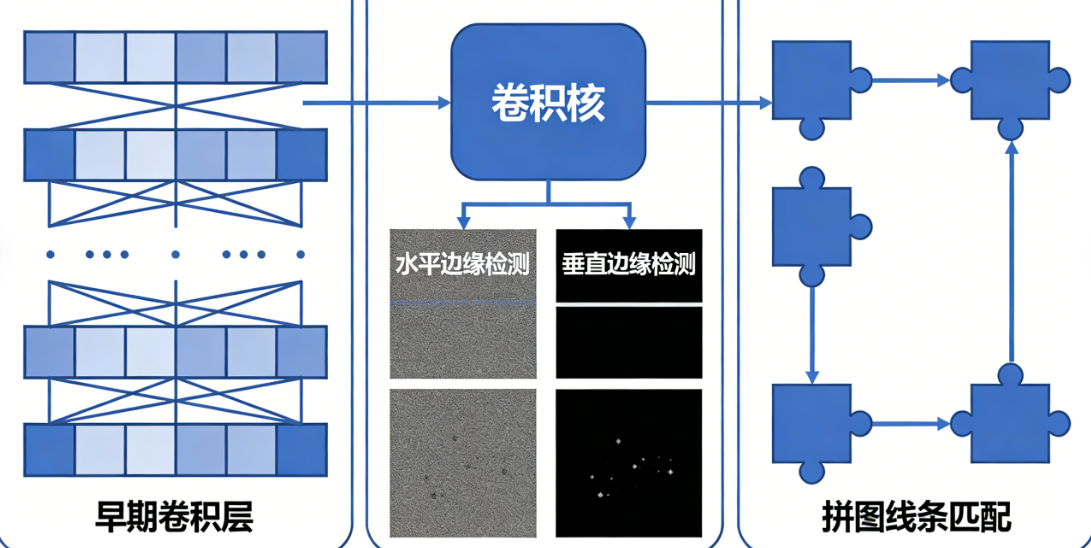

图像数据与传统的结构化数据不同,它具有高度的复杂性和丰富的信息。一张普通的彩色图像由成千上万个像素点组成,每个像素点包含红、绿、蓝三个颜色通道的信息。这些像素点之间相互关联,共同构成了图像中的各种物体、场景等内容。

想象一下,图像就像是一幅巨大的拼图,每个像素点就是拼图的一小块。这些小块以特定的方式组合在一起,形成了我们看到的各种画面。然而,要从这纷繁复杂的拼图中找出关键信息,绝非易事。

三、卷积神经网络(CNN)基础概念

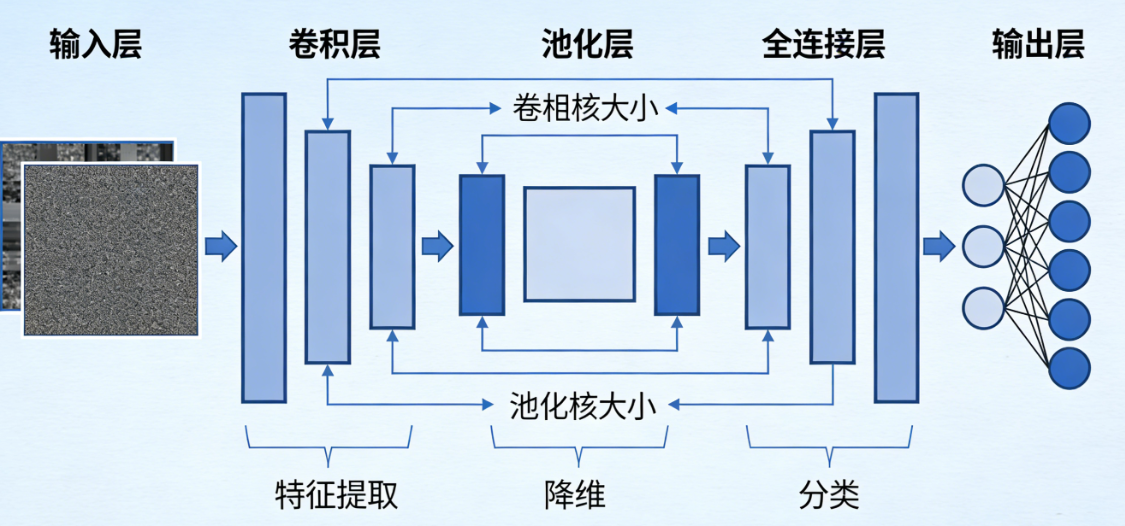

(一)卷积层

-

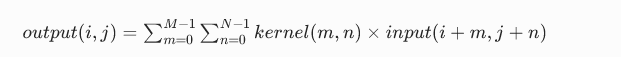

卷积的定义 卷积是 CNN 的核心操作。简单来说,卷积就是通过一个卷积核(也叫滤波器)在图像上滑动,将卷积核与图像上对应位置的像素值进行加权求和,得到新的特征值。数学表达式为:

其中,

output是卷积后的输出,kernel是卷积核,input是输入图像,(i, j)是输出特征图的坐标,(m, n)是卷积核的坐标,M和N是卷积核的大小。 -

通俗比喻: 把卷积想象成用一个特制的 "模板" 在图像上扫描。

这个模板上有不同的权重值,就像一个带有特定图案的印章。当印章在图像上移动时,它会根据自身的图案和权重与图像上对应的区域进行匹配,将匹配的结果记录下来,形成新的特征。比如,我们可以设计一个边缘检测的卷积核,当它在图像上滑动时,就能突出图像中的边缘部分,就好像用这个印章一盖,图像的边缘就被 "印" 出来了。

-

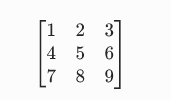

示例

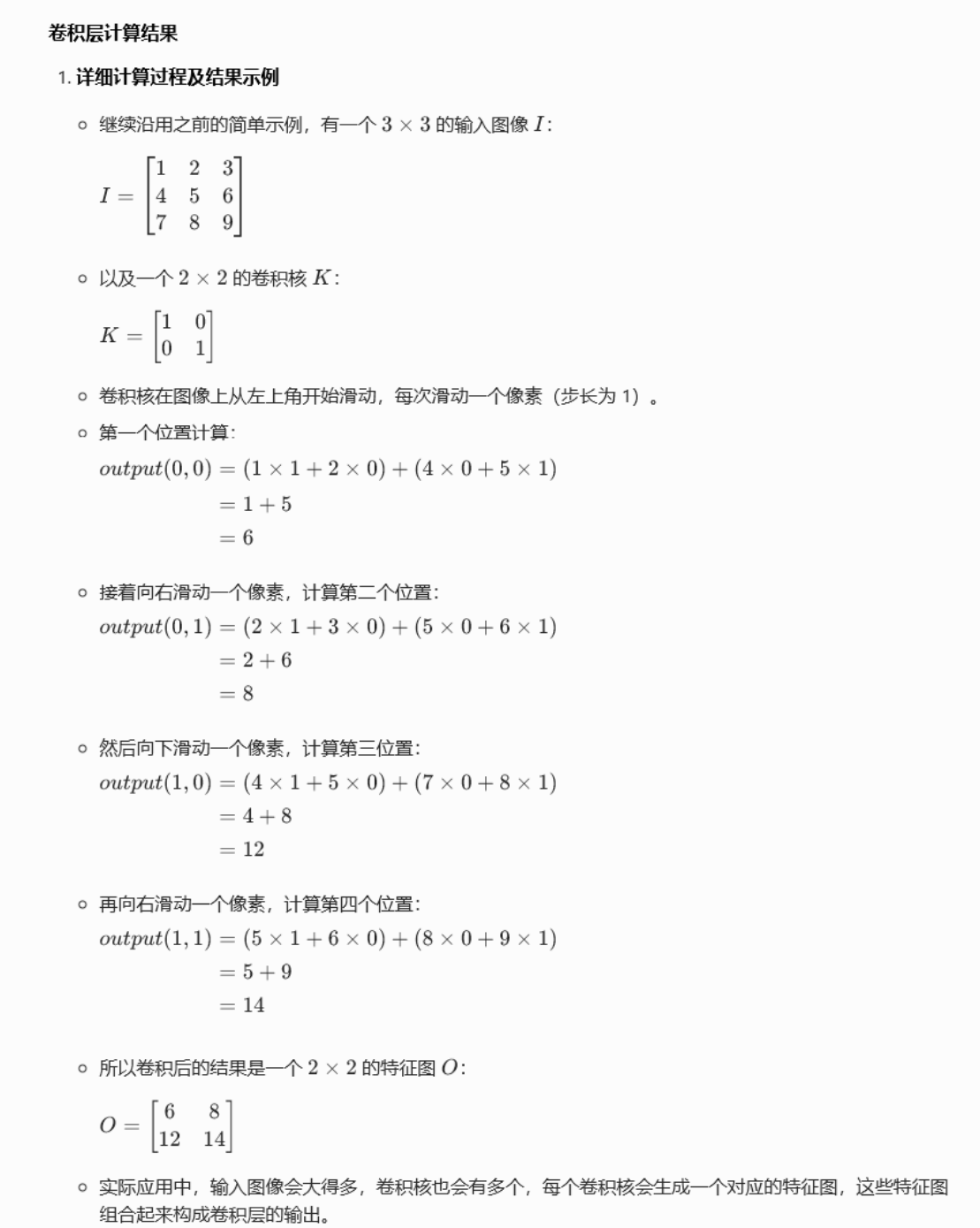

假设我们有一个 3×3 的图像和一个 2×2 的卷积核:

图像:

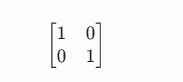

卷积核:

卷积核:

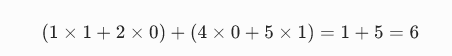

当卷积核在图像左上角开始滑动时,计算过程为:

依次类推,得到卷积后的结果。

计算结果

(二)池化层

-

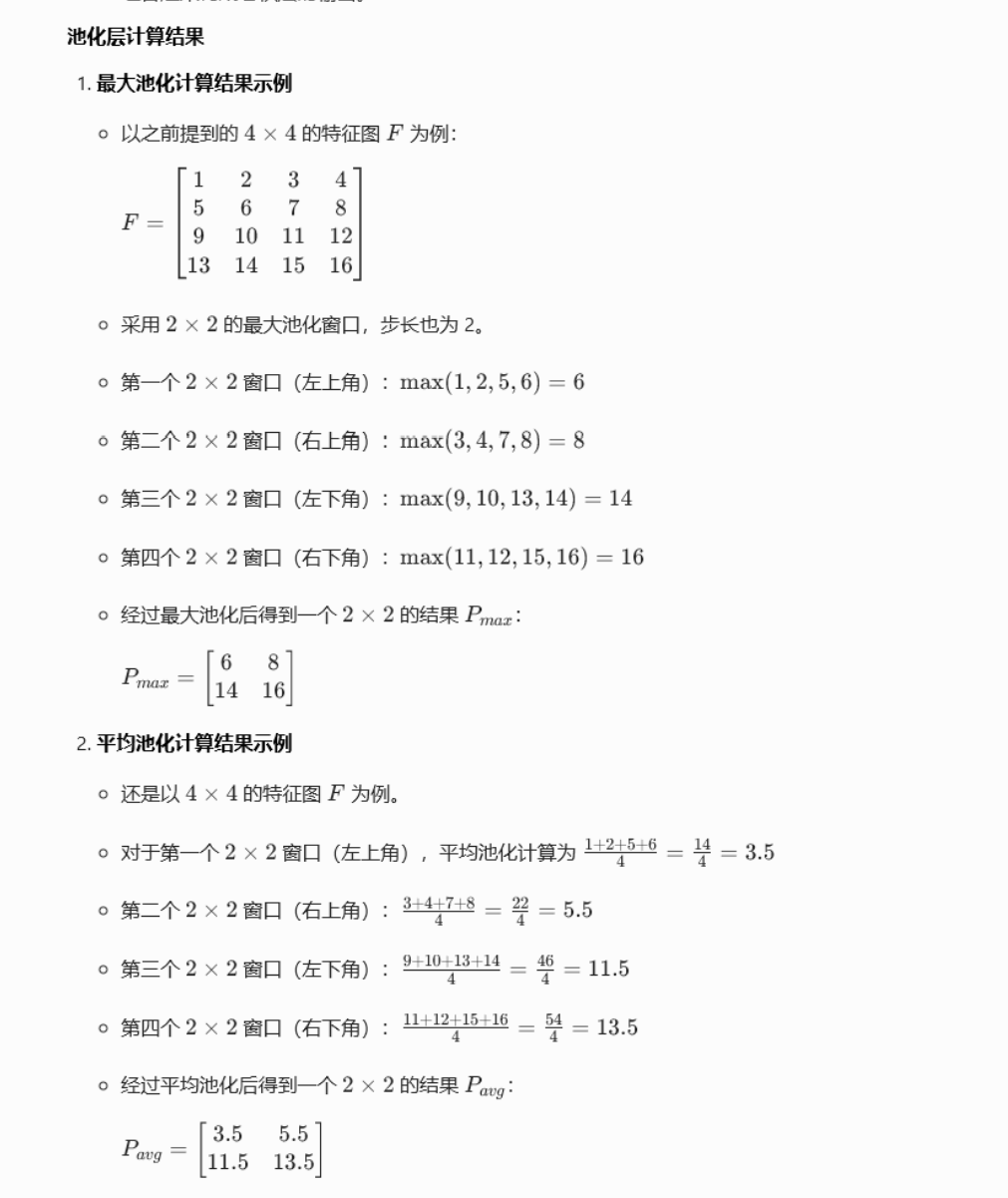

池化的定义池化层的主要作用是对卷积层输出的特征图进行下采样,减少数据量的同时保留主要特征。常见的池化方式有最大池化(Max Pooling)和平均池化(Average Pooling)。最大池化是在一个池化窗口内取最大值作为输出,平均池化则是取窗口内的平均值作为输出。

-

通俗比喻以最大池化为例,想象你有一堆乐高积木(特征图),你想把它们整理得更紧凑,但又不想丢失重要的积木块。最大池化就像是在每一小堆乐高积木中挑选出最大、最显眼的那块留下来,其他的就舍弃。这样既减少了积木的数量,又保留了最突出的特征。

-

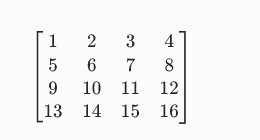

示例 对于一个 4×4 的特征图,采用 2×2 的最大池化窗口:特征图:

第一个 2×2 窗口(左上角):max(1,2,5,6)=6

第二个 2×2 窗口(右上角):max(3,4,7,8)=8

以此类推,得到池化后的结果。

计算过程:

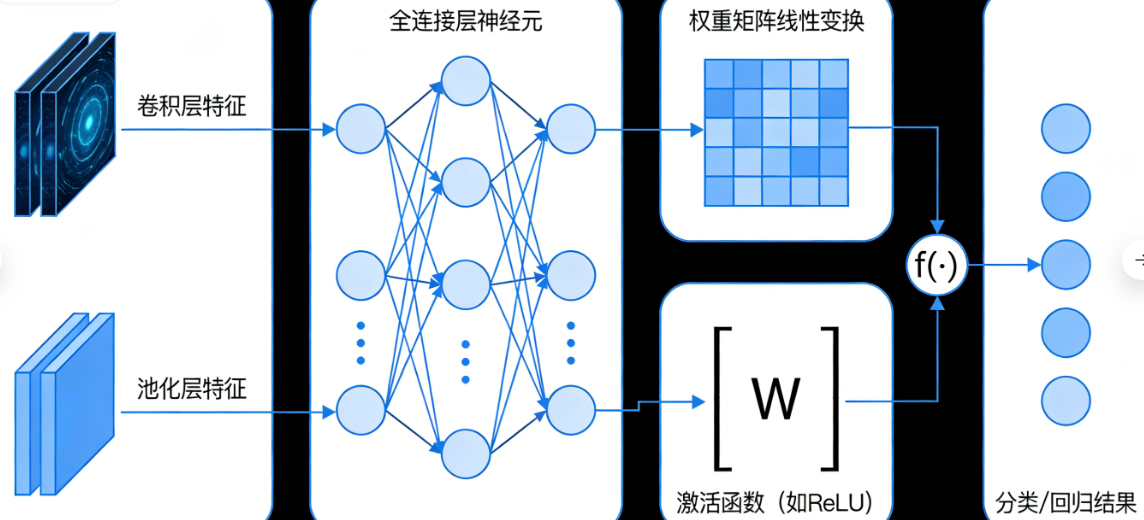

(三)全连接层

-

全连接层的定义

全连接层是将前面卷积层和池化层提取到的特征进行整合,并映射到最终的分类或回归结果。在全连接层中,每个神经元与上一层的所有神经元都有连接,通过权重矩阵对输入特征进行线性变换,再经过激活函数得到输出。

-

通俗比喻

全连接层就像是一个信息汇总中心。前面卷积层和池化层分别对图像的不同方面进行了特征提取,就像是各个部门收集了不同的信息。全连接层把这些信息全部集中起来,综合考虑,做出最终的决策,比如判断这张图像是猫还是狗。

-

示例

假设前面的层输出了一个长度为 n 的特征向量,全连接层有 m 个神经元。那么就会有一个 m×n 的权重矩阵,将特征向量与权重矩阵相乘,再加上偏置项,经过激活函数后得到 m 个输出值,这 m 个值就可以用于最终的分类或回归任务。

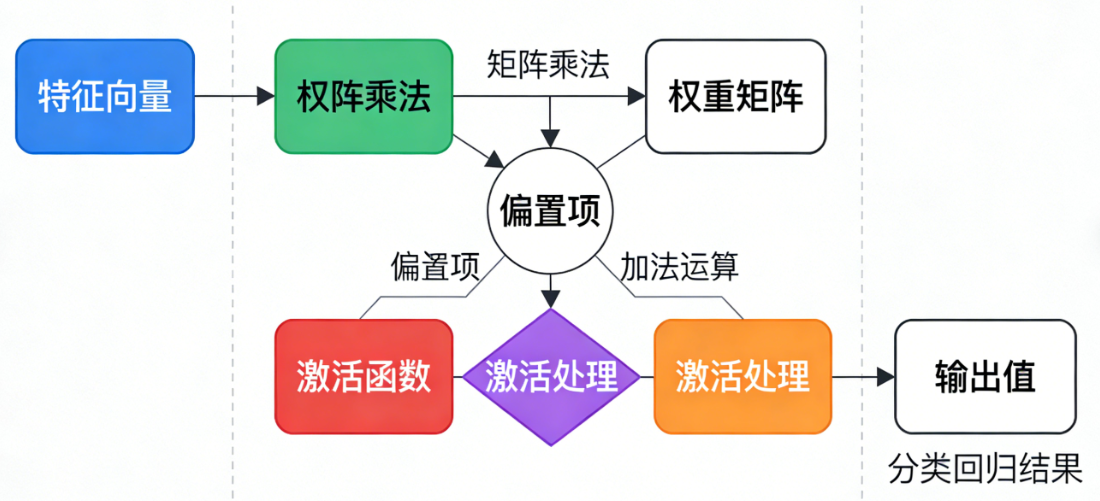

四、CNN 如何在图像中精准 "捕捞" 特征

(一)特征提取过程

-

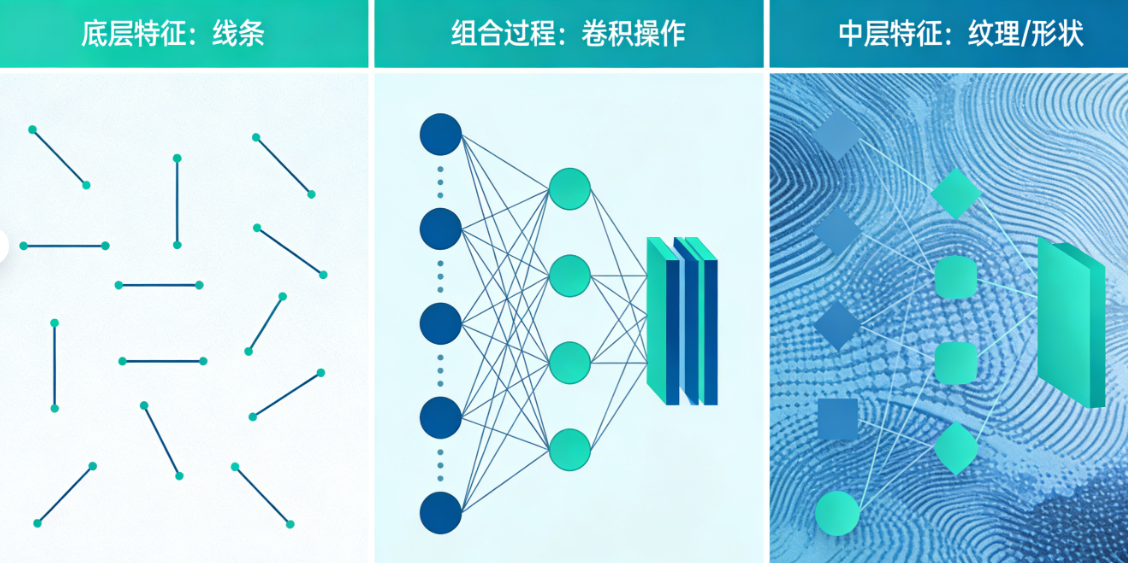

底层特征提取在 CNN 的早期层(通常是前几个卷积层),卷积核主要用于提取一些底层的、局部的特征,如边缘、角点等。这些简单的特征是构建更复杂特征的基础。例如,一个小的卷积核可以检测出图像中的水平或垂直边缘,就像我们在拼图中先找出了一些简单的线条。

-

中层特征组合随着网络层数的增加,卷积层会将底层提取的简单特征进行组合,形成更复杂的中层特征,如纹理、形状的部分等。就好比将一些线条组合成了图形的轮廓。

-

高层特征抽象在网络的深层,CNN 能够将中层特征进一步抽象为更具语义性的高层特征,这些特征可以直接用于图像的分类、识别等任务。比如,高层特征可以表示图像中是一只猫还是一只狗,这时候已经从最初的像素级特征上升到了语义级别的理解。

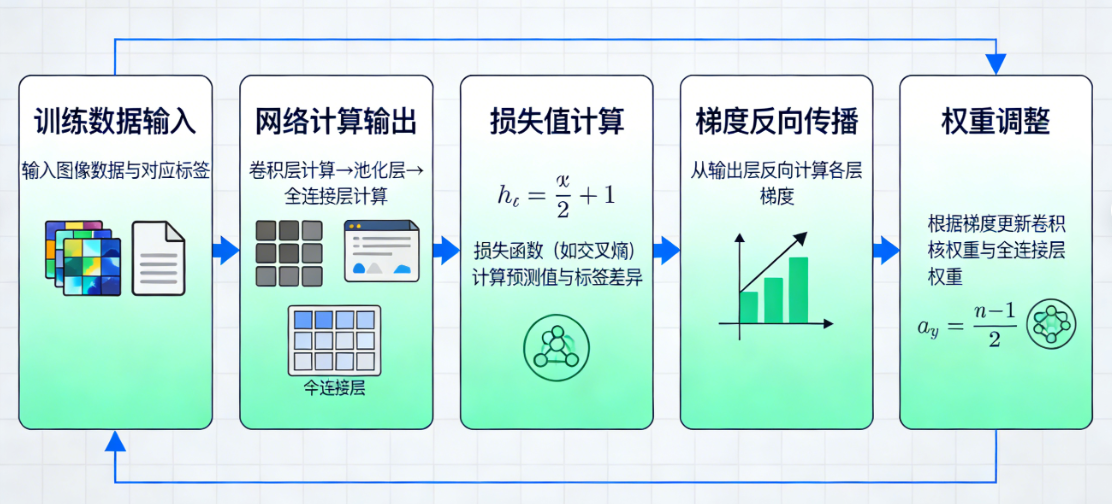

(二)权重学习

CNN 通过反向传播算法来学习卷积核和全连接层的权重。在训练过程中,将大量的图像数据及其对应的标签输入到网络中,网络会根据当前的权重计算输出结果,并与真实标签进行比较,得到损失值。然后,通过反向传播算法,从输出层向输入层反向传播损失值的梯度,根据梯度来调整权重,使得损失值逐渐减小。

这就好比一个学生在学习过程中,通过不断地做练习题(训练数据),发现自己的错误(损失值),然后根据错误的原因(梯度)来调整自己的学习方法(权重),从而不断提高自己的成绩(模型性能)。

五、CNN 的优缺点及适用场景

(一)优点

-

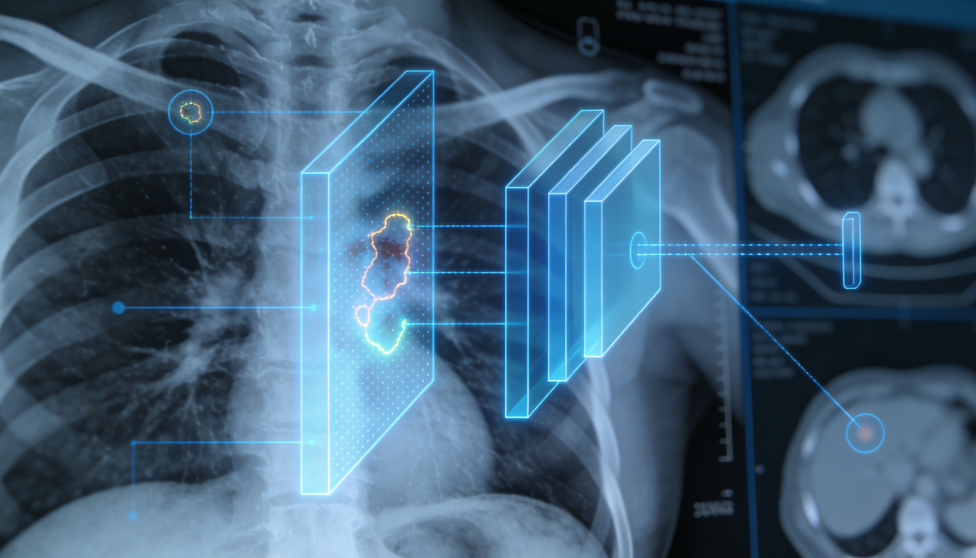

自动特征提取 CNN 能够自动从图像数据中学习特征,无需人工手动设计特征提取方法。这大大减少了特征工程的工作量,并且能够发现一些人类难以察觉的特征。例如,在医学影像诊断中,CNN 可以从复杂的 X 光图像中发现微小的病变特征,而这些特征对于医生来说可能很难直接观察到。

-

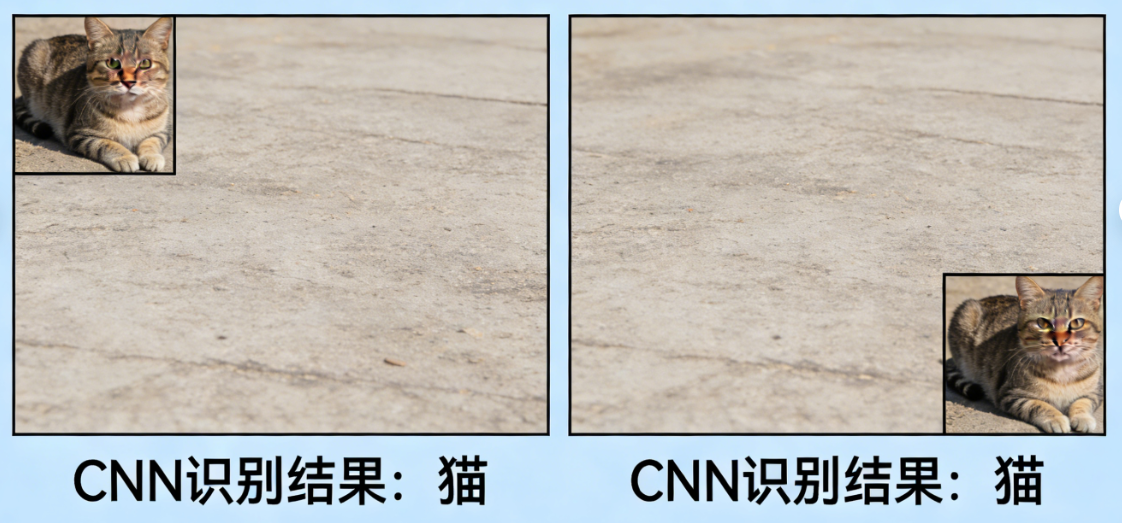

平移不变性 由于卷积操作的特性,CNN 对图像的平移具有不变性。也就是说,无论图像中的物体在哪个位置,CNN 都能有效地提取到相同的特征。比如,无论一只猫在图像的左上角还是右下角,CNN 都能识别出这是一只猫。

-

共享权重 卷积核在图像上滑动时共享权重,这大大减少了模型的参数数量,降低了计算量和过拟合的风险。就像用一个印章在不同地方盖章,不需要为每个位置都重新制作一个印章,节省了资源。

(二)缺点

- 对数据量要求高CNN 需要大量的训练数据才能学习到有效的特征和模式。如果数据量不足,容易出现过拟合现象,导致模型在测试数据上表现不佳。例如,在一些罕见病的医学影像诊断中,由于病例数量有限,CNN 模型的训练效果可能会受到影响。

- 计算资源消耗大CNN 的训练和推理过程通常需要强大的计算资源,尤其是在处理高分辨率图像时。这需要使用高性能的 GPU 等硬件设备,增加了成本。比如,训练一个大型的 CNN 模型用于卫星图像分析,可能需要多块高端 GPU 同时工作。

(三)适用场景

- 图像分类CNN 在图像分类任务中表现出色,如识别动物、植物、物体等类别。例如,在花卉识别应用中,CNN 可以准确地将不同种类的花卉图像分类。

- 目标检测用于检测图像中特定目标的位置和类别。像在自动驾驶中,CNN 可以检测出道路上的车辆、行人、交通标志等目标。

- 语义分割将图像中的每个像素点进行分类,标记出属于不同物体或场景的部分。在医学图像分割中,CNN 可以将肿瘤区域从正常组织中分割出来。

六、类似功能的产品、工具或方法及推荐

(一)传统机器学习方法(如 SVM、决策树等)

-

特点传统机器学习方法需要人工手动提取特征,然后再使用分类器进行分类。例如,在图像分类中,可能需要使用 SIFT、HOG 等特征提取算法提取图像特征,再用 SVM 进行分类。

-

优缺点优点是对数据量要求相对较低,计算资源消耗较小。缺点是特征提取依赖人工设计,对于复杂的图像数据,难以提取到有效的特征,性能通常不如 CNN。

-

适用场景适用于数据量较小、图像特征相对简单、计算资源有限的场景,如一些简单的工业产品缺陷检测。

(二)其他深度学习模型(如 RNN、LSTM 等)

-

特点RNN(循环神经网络)和 LSTM(长短期记忆网络)主要用于处理序列数据,如语音、文本等。虽然它们也可以用于图像数据,但通常是将图像转换为序列形式进行处理。

-

优缺点优点是对序列信息的处理能力强,能够捕捉到数据中的时间依赖关系。缺点是在处理图像数据时,不像 CNN 那样能够直接利用图像的空间结构信息,计算效率相对较低。

-

适用场景适用于与时间序列相关的图像分析任务,如视频中的动作识别等。

七、总结

卷积神经网络作为深度学习在图像领域的重要工具,凭借其强大的特征提取能力,在图像数据的海洋中精准地 "捕捞" 出有价值的特征,为图像分类、目标检测、语义分割等众多任务提供了高效的解决方案。尽管它存在对数据量和计算资源要求较高等缺点,但在当今大数据和高性能计算的时代背景下,其优势依然十分突出。通过不断地研究和改进,CNN 在未来的图像分析及其他领域必将发挥更加重要的作用。

END

如果觉得这份基础知识点总结清晰,别忘了动动小手点个赞👍,再关注一下呀~ 后续还会分享更多有关开发问题的干货技巧,同时一起解锁更多好用的功能,少踩坑多提效!🥰 你的支持就是我更新的最大动力,咱们下次分享再见呀~🌟