在前文中,我们已经明确:多层MLP会通过"底层→中层→高层"的层级,学习多样化的特征;不同权重(或神经元)能自发分工,而非全部趋同,核心依赖反向传播与损失函数的协同作用。

本文中将讨论反向传播和损失函数,到底是如何"引导"权重自发向"能降低损失的不同方向"调整,最终形成稳定分工的?

这一篇作为前文的补充,将彻底解决这个问题------我们将先以"极简MLP(单隐藏层+2个神经元)+ MNIST简化案例"为载体,通过完整的数学推导(链式求导、梯度计算)和代码,直观展示权重"从随机初始→梯度差异化更新→分工成型"的全过程;再基于具体案例,提炼一般性结论,并给出简单的数学证明。

本文核心逻辑:损失函数提供"监督信号"(误差反馈),反向传播通过"链式求导"将误差转化为每个权重的梯度,梯度的方向和大小决定权重的更新方向------而由于初始权重随机、样本特征多样,不同权重的梯度会呈现差异化,最终引导权重向"不同的、能降低损失的方向"调整,形成特征分工。

一、MLP计算更新

为了清晰展示推导过程,我们简化MLP结构和任务

1.1 任务设定(MNIST简化版)

任务:区分MNIST手写数字中的"0"和"1"(二分类任务),输入为2×2的简化像素矩阵(模拟原始28×28图像的局部区域),标签为0(代表数字0)或1(代表数字1)。

简化输入(2×2像素矩阵,展平为4维输入向量):

-

样本1(数字1的局部,含水平边缘):x=[1,1,0,0]Tx = [1, 1, 0, 0]^Tx=[1,1,0,0]T(前两个像素亮,后两个像素暗,对应水平边缘特征),标签y=1y = 1y=1;

-

样本2(数字0的局部,含垂直边缘):x=[1,0,1,0]Tx = [1, 0, 1, 0]^Tx=[1,0,1,0]T(奇数位像素亮,偶数位像素暗,对应垂直边缘特征),标签y=0y = 0y=0。

核心需求:模型通过学习,让隐藏层两个神经元分别检测"水平边缘"和"垂直边缘"(权重分工),最终完成二分类。(由于输入样本较少,模型可能不一定能达到这个效果,有这个趋势即能说明)

1.2 MLP结构

网络结构(3层,单隐藏层):

-

输入层:4个神经元(对应2×2像素展平后的4维向量x=[x1,x2,x3,x4]Tx = [x_1, x_2, x_3, x_4]^Tx=[x1,x2,x3,x4]T);

-

隐藏层:2个神经元(记为神经元1、神经元2),激活函数为ReLU(前文重点讲解,强化特征区分度);

-

输出层:1个神经元,激活函数为Sigmoid(二分类任务专用,输出为0~1的概率值,大于0.5预测为1,否则预测为0)。

1.3 符号定义

-

隐藏层权重:神经元1的权重w1=[w11,w12,w13,w14]Tw_1 = [w_{11}, w_{12}, w_{13}, w_{14}]^Tw1=[w11,w12,w13,w14]T,偏置b1b_1b1;神经元2的权重w2=[w21,w22,w23,w24]Tw_2 = [w_{21}, w_{22}, w_{23}, w_{24}]^Tw2=[w21,w22,w23,w24]T,偏置b2b_2b2;

-

输出层权重:W=[W1,W2]TW = [W_1, W_2]^TW=[W1,W2]T(对应隐藏层两个神经元的输出权重),偏置bbb;

-

隐藏层输出:神经元1输出h1=ReLU(w1Tx+b1)h_1 = \text{ReLU}(w_1^T x + b_1)h1=ReLU(w1Tx+b1),神经元2输出h2=ReLU(w2Tx+b2)h_2 = \text{ReLU}(w_2^T x + b_2)h2=ReLU(w2Tx+b2);

-

输出层输出(预测概率):y^=Sigmoid(W1h1+W2h2+b)\hat{y} = \text{Sigmoid}(W_1 h_1 + W_2 h_2 + b)y^=Sigmoid(W1h1+W2h2+b);

-

损失函数:二分类交叉熵损失(前文分类任务专用,比MSE更适配分类,记为L\mathcal{L}L)。

1.4 初始权重设定(随机初始化)

按照前文代码逻辑,权重随机初始化(服从均匀分布),设定初始值(便于后续推导,模拟真实随机初始化结果):

-

隐藏层神经元1:w1=[0.1,0.1,0.05,0.05]Tw_1 = [0.1, 0.1, 0.05, 0.05]^Tw1=[0.1,0.1,0.05,0.05]T,b1=0.01b_1 = 0.01b1=0.01;

-

隐藏层神经元2:w2=[0.05,0.05,0.1,0.1]Tw_2 = [0.05, 0.05, 0.1, 0.1]^Tw2=[0.05,0.05,0.1,0.1]T,b2=0.01b_2 = 0.01b2=0.01;

-

输出层:W=[0.2,0.2]TW = [0.2, 0.2]^TW=[0.2,0.2]T,b=0.02b = 0.02b=0.02。

观察初始权重:神经元1的权重前两位(对应输入前两个像素)略大,神经元2的权重后两位(对应输入后两个像素)略大------这种初始差异,是后续梯度差异化更新、分工成型的基础。

二、数学推导:反向传播+损失函数,引导权重差异化更新

我们以"样本1(x=[1,1,0,0]Tx = [1,1,0,0]^Tx=[1,1,0,0]T,y=1y=1y=1)"为例,完整推导"前向传播(计算损失)→ 反向传播(计算各权重梯度)→ 权重更新"的全过程,直观展示:损失函数如何反馈误差,反向传播如何计算差异化梯度,最终引导两个隐藏层神经元的权重向不同方向调整。

2.1 第一步:前向传播,计算预测值与损失(获取监督信号)

前向传播的核心是"计算各层输出,最终得到预测值,与真实标签对比得到损失"------损失是权重更新的"指挥棒",损失越大,权重需要调整的幅度越大。

2.1.1 计算隐藏层输出(ReLU激活)

神经元1输出h1h_1h1:

w1Tx+b1=(0.1×1)+(0.1×1)+(0.05×0)+(0.05×0)+0.01=0.21w_1^T x + b_1 = (0.1×1) + (0.1×1) + (0.05×0) + (0.05×0) + 0.01 = 0.21w1Tx+b1=(0.1×1)+(0.1×1)+(0.05×0)+(0.05×0)+0.01=0.21$

h1=ReLU(0.21)=0.21h_1 = \text{ReLU}(0.21) = 0.21h1=ReLU(0.21)=0.21(ReLU函数:输入大于0,输出等于输入)

神经元2输出h2h_2h2:

w2Tx+b2=(0.05×1)+(0.05×1)+(0.1×0)+(0.1×0)+0.01=0.11w_2^T x + b_2 = (0.05×1) + (0.05×1) + (0.1×0) + (0.1×0) + 0.01 = 0.11w2Tx+b2=(0.05×1)+(0.05×1)+(0.1×0)+(0.1×0)+0.01=0.11

h2=ReLU(0.11)=0.11h_2 = \text{ReLU}(0.11) = 0.11h2=ReLU(0.11)=0.11

2.1.2 计算输出层预测值(Sigmoid激活)

W1h1+W2h2+b=(0.2×0.21)+(0.2×0.11)+0.02=0.042+0.022+0.02=0.084W_1 h_1 + W_2 h_2 + b = (0.2×0.21) + (0.2×0.11) + 0.02 = 0.042 + 0.022 + 0.02 = 0.084W1h1+W2h2+b=(0.2×0.21)+(0.2×0.11)+0.02=0.042+0.022+0.02=0.084

y^=Sigmoid(0.084)=11+e−0.084≈0.521\hat{y} = \text{Sigmoid}(0.084) = \frac{1}{1 + e^{-0.084}} \approx 0.521y^=Sigmoid(0.084)=1+e−0.0841≈0.521

2.1.3 计算损失(交叉熵损失)

二分类交叉熵损失公式(沿用前文):L=−[ylny^+(1−y)ln(1−y^)]\mathcal{L} = -[y \ln \hat{y} + (1 - y) \ln (1 - \hat{y})]L=−[ylny^+(1−y)ln(1−y^)]

代入y=1y=1y=1、y^≈0.521\hat{y} \approx 0.521y^≈0.521:

L=−[1×ln0.521+0×ln(1−0.521)]≈−(−0.653)=0.653\mathcal{L} = -[1×\ln 0.521 + 0×\ln (1 - 0.521)] \approx -(-0.653) = 0.653L=−[1×ln0.521+0×ln(1−0.521)]≈−(−0.653)=0.653

损失分析:L=0.653\mathcal{L}=0.653L=0.653(接近0.693,Sigmoid初始输出0.5时的损失),说明模型预测效果差(预测概率0.521接近0.5,无法明确区分数字1),需要通过反向传播更新权重,降低损失。

2.2 第二步:反向传播,计算各权重的梯度

反向传播的核心是"链式求导"------从损失L\mathcal{L}L出发,逐层计算每个权重对损失的梯度(∂L∂w\frac{\partial \mathcal{L}}{\partial w}∂w∂L),梯度的方向决定"权重该往哪个方向调整",梯度的大小决定"调整幅度多大"。

我们重点计算"隐藏层两个神经元的权重梯度"(∂L∂w1\frac{\partial \mathcal{L}}{\partial w_1}∂w1∂L、∂L∂w2\frac{\partial \mathcal{L}}{\partial w_2}∂w2∂L),因为这两个权重的梯度差异,直接决定了它们的分工方向;输出层权重梯度推导略(核心逻辑一致,贴合前文梯度推导)。

2.2.1 链式求导核心公式(复用前文反向传播逻辑)

对于隐藏层神经元的权重wijw_{ij}wij(第i个隐藏层神经元,第j个输入神经元的权重),梯度公式为:

∂L∂wij=∂L∂y^⋅∂y^∂z⋅∂z∂hi⋅∂hi∂zi⋅∂zi∂wij\frac{\partial \mathcal{L}}{\partial w_{ij}} = \frac{\partial \mathcal{L}}{\partial \hat{y}} \cdot \frac{\partial \hat{y}}{\partial z} \cdot \frac{\partial z}{\partial h_i} \cdot \frac{\partial h_i}{\partial z_i} \cdot \frac{\partial z_i}{\partial w_{ij}}∂wij∂L=∂y^∂L⋅∂z∂y^⋅∂hi∂z⋅∂zi∂hi⋅∂wij∂zi

其中:

-

z=W1h1+W2h2+bz = W_1 h_1 + W_2 h_2 + bz=W1h1+W2h2+b(输出层线性组合);

-

zi=wiTx+biz_i = w_i^T x + b_izi=wiTx+bi(第i个隐藏层神经元的线性组合);

-

各偏导数的计算,沿用前文激活函数的导数公式(ReLU导数:x>0x>0x>0时导数为1,x≤0x \leq 0x≤0时为0;Sigmoid导数:Sigmoid(z)⋅(1−Sigmoid(z))\text{Sigmoid}(z) \cdot (1 - \text{Sigmoid}(z))Sigmoid(z)⋅(1−Sigmoid(z)))。

2.2.2 逐部分计算偏导数(代入样本1数据)

-

第一步:计算∂L∂y^\frac{\partial \mathcal{L}}{\partial \hat{y}}∂y^∂L(损失对预测值的偏导数)

∂L∂y^=−(yy^−1−y1−y^)\frac{\partial \mathcal{L}}{\partial \hat{y}} = -\left( \frac{y}{\hat{y}} - \frac{1 - y}{1 - \hat{y}} \right)∂y^∂L=−(y^y−1−y^1−y),代入y=1y=1y=1、y^≈0.521\hat{y} \approx 0.521y^≈0.521:∂L∂y^=−(10.521−0)≈−1.919\frac{\partial \mathcal{L}}{\partial \hat{y}} = -\left( \frac{1}{0.521} - 0 \right) \approx -1.919∂y^∂L=−(0.5211−0)≈−1.919 -

第二步:计算∂y^∂z\frac{\partial \hat{y}}{\partial z}∂z∂y^(预测值对输出层线性组合的偏导数,Sigmoid导数)

∂y^∂z=y^⋅(1−y^)≈0.521×(1−0.521)≈0.249\frac{\partial \hat{y}}{\partial z} = \hat{y} \cdot (1 - \hat{y}) \approx 0.521 \times (1 - 0.521) \approx 0.249∂z∂y^=y^⋅(1−y^)≈0.521×(1−0.521)≈0.249 -

第三步:计算∂z∂h1\frac{\partial z}{\partial h_1}∂h1∂z、∂z∂h2\frac{\partial z}{\partial h_2}∂h2∂z(输出层线性组合对隐藏层输出的偏导数)

∂z∂h1=W1=0.2\frac{\partial z}{\partial h_1} = W_1 = 0.2∂h1∂z=W1=0.2,∂z∂h2=W2=0.2\frac{\partial z}{\partial h_2} = W_2 = 0.2∂h2∂z=W2=0.2 -

第四步:计算∂h1∂z1\frac{\partial h_1}{\partial z_1}∂z1∂h1、∂h2∂z2\frac{\partial h_2}{\partial z_2}∂z2∂h2(隐藏层输出对自身线性组合的偏导数,ReLU导数)

由于z1=0.21>0z_1 = 0.21 > 0z1=0.21>0、z2=0.11>0z_2 = 0.11 > 0z2=0.11>0,因此:∂h1∂z1=1\frac{\partial h_1}{\partial z_1} = 1∂z1∂h1=1,∂h2∂z2=1\frac{\partial h_2}{\partial z_2} = 1∂z2∂h2=1

-

第五步:计算∂z1∂w1\frac{\partial z_1}{\partial w_1}∂w1∂z1、∂z2∂w2\frac{\partial z_2}{\partial w_2}∂w2∂z2(隐藏层线性组合对自身权重的偏导数)

∂z1∂w1=x=[1,1,0,0]T\frac{\partial z_1}{\partial w_1} = x = [1, 1, 0, 0]^T∂w1∂z1=x=[1,1,0,0]T(权重对应输入像素,偏导数等于输入值);∂z2∂w2=x=[1,1,0,0]T\frac{\partial z_2}{\partial w_2} = x = [1, 1, 0, 0]^T∂w2∂z2=x=[1,1,0,0]T。

2.2.3 计算隐藏层权重梯度(差异化核心体现)

将上述偏导数代入链式求导公式,分别计算神经元1、神经元2的权重梯度:

- 神经元1的权重梯度∂L∂w1\frac{\partial \mathcal{L}}{\partial w_1}∂w1∂L:

∂L∂w1=∂L∂y^⋅∂y^∂z⋅∂z∂h1⋅∂h1∂z1⋅∂z1∂w1\frac{\partial \mathcal{L}}{\partial w_1} = \frac{\partial \mathcal{L}}{\partial \hat{y}} \cdot \frac{\partial \hat{y}}{\partial z} \cdot \frac{\partial z}{\partial h_1} \cdot \frac{\partial h_1}{\partial z_1} \cdot \frac{\partial z_1}{\partial w_1}∂w1∂L=∂y^∂L⋅∂z∂y^⋅∂h1∂z⋅∂z1∂h1⋅∂w1∂z1

代入数值计算:

∂L∂w1≈(−1.919)×0.249×0.2×1×[1,1,0,0]T≈[−0.096,−0.096,0,0]T\frac{\partial \mathcal{L}}{\partial w_1} \approx (-1.919) \times 0.249 \times 0.2 \times 1 \times [1, 1, 0, 0]^T \approx [-0.096, -0.096, 0, 0]^T∂w1∂L≈(−1.919)×0.249×0.2×1×[1,1,0,0]T≈[−0.096,−0.096,0,0]T

- 神经元2的权重梯度∂L∂w2\frac{\partial \mathcal{L}}{\partial w_2}∂w2∂L:

∂L∂w2=∂L∂y^⋅∂y^∂z⋅∂z∂h2⋅∂h2∂z2⋅∂z2∂w2\frac{\partial \mathcal{L}}{\partial w_2} = \frac{\partial \mathcal{L}}{\partial \hat{y}} \cdot \frac{\partial \hat{y}}{\partial z} \cdot \frac{\partial z}{\partial h_2} \cdot \frac{\partial h_2}{\partial z_2} \cdot \frac{\partial z_2}{\partial w_2}∂w2∂L=∂y^∂L⋅∂z∂y^⋅∂h2∂z⋅∂z2∂h2⋅∂w2∂z2

代入数值计算:

∂L∂w2≈(−1.919)×0.249×0.2×1×[1,1,0,0]T≈[−0.048,−0.048,0,0]T\frac{\partial \mathcal{L}}{\partial w_2} \approx (-1.919) \times 0.249 \times 0.2 \times 1 \times [1, 1, 0, 0]^T \approx [-0.048, -0.048, 0, 0]^T∂w2∂L≈(−1.919)×0.249×0.2×1×[1,1,0,0]T≈[−0.048,−0.048,0,0]T

梯度差异化分析

对比两个神经元的权重梯度,能清晰看到:

-

神经元1的权重梯度([-0.096, -0.096, 0, 0]^T),前两位(对应输入前两个像素)的梯度绝对值更大;

-

神经元2的权重梯度([-0.048, -0.048, 0, 0]^T),前两位的梯度绝对值更小。

结合样本1的特征(前两个像素亮、后两个暗,对应水平边缘),这个梯度差异的意义是:

损失函数通过反向传播,引导神经元1的权重"进一步强化对前两个像素的关注"(梯度绝对值大,更新幅度大),更适合学习"水平边缘"特征;引导神经元2的权重"弱化对前两个像素的关注"(梯度绝对值小,更新幅度小),后续遇到含"垂直边缘"的样本2时,会调整权重关注后两个像素------这就是"梯度差异化",也是权重分工的开端。

2.3 第三步:权重更新(梯度下降,强化分工)

沿用前文的梯度下降更新规则(简化为普通梯度下降,便于计算;Adam优化器逻辑一致,只是多了自适应学习率),更新公式为:

wnew=wold−η⋅∂L∂ww_{\text{new}} = w_{\text{old}} - \eta \cdot \frac{\partial \mathcal{L}}{\partial w}wnew=wold−η⋅∂w∂L

其中η\etaη为学习率(设定η=0.1\eta=0.1η=0.1,与前文代码一致,避免更新幅度过大或过小)。

- 神经元1的权重更新后的值:

w1,new=[0.1,0.1,0.05,0.05]T−0.1×[−0.096,−0.096,0,0]T=[0.196,0.196,0.05,0.05]Tw_{1,\text{new}} = [0.1, 0.1, 0.05, 0.05]^T - 0.1 \times [-0.096, -0.096, 0, 0]^T = [0.196, 0.196, 0.05, 0.05]^Tw1,new=[0.1,0.1,0.05,0.05]T−0.1×[−0.096,−0.096,0,0]T=[0.196,0.196,0.05,0.05]T

- 神经元2的权重更新后的值:

w2,new=[0.05,0.05,0.1,0.1]T−0.1×[−0.048,−0.048,0,0]T=[0.098,0.098,0.1,0.1]Tw_{2,\text{new}} = [0.05, 0.05, 0.1, 0.1]^T - 0.1 \times [-0.048, -0.048, 0, 0]^T = [0.098, 0.098, 0.1, 0.1]^Tw2,new=[0.05,0.05,0.1,0.1]T−0.1×[−0.048,−0.048,0,0]T=[0.098,0.098,0.1,0.1]T

权重更新分析(分工进一步强化)

更新后,神经元1的前两位权重(对应水平边缘特征)从0.1提升到0.196,对水平边缘的"检测敏感度"显著提升;神经元2的前两位权重仅从0.05提升到0.098,敏感度提升微弱,而后两位权重仍保持0.1------这种差异,会在后续输入样本2(垂直边缘)时进一步放大,最终让神经元1专注于检测水平边缘,神经元2专注于检测垂直边缘,形成稳定分工。

补充:若我们用样本2(垂直边缘)重复上述推导,会发现神经元2的后两位权重梯度绝对值更大,更新幅度更大,进一步强化对垂直边缘的关注;神经元1的后两位权重梯度绝对值更小,更新幅度更小------这就是损失函数和反向传播的"协同作用":根据不同样本的特征,引导不同权重向"能降低损失的不同方向"调整。

三、代码展示:直观观察权重"分工成型"全过程

为了让大家更直观地感受"反向传播+损失函数引导权重分工"的过程,我们基于上述极简案例,编写可直接运行的PyTorch代码------代码将模拟"样本训练→权重更新→分工成型"的全过程,可视化初始权重、训练后权重的变化,以及梯度的差异化,与前文数学推导完全对应,贴合专栏"代码验证数学原理"的风格。

python

import torch

import torch.nn as nn

import torch.optim as optim

import matplotlib.pyplot as plt

import numpy as np

# 设置matplotlib参数

plt.rcParams['figure.figsize'] = (12, 8)

plt.rcParams['font.size'] = 12

plt.style.use('seaborn-v0_8')

# 设置中文字体显示

plt.rcParams['font.sans-serif'] = ['SimHei', 'Microsoft YaHei', 'DejaVu Sans']

plt.rcParams['axes.unicode_minus'] = False

# 1. 准备数据(贴合前文极简案例,样本1:水平边缘,样本2:垂直边缘)

# 输入:2个样本,每个样本为2×2像素展平后的4维向量,shape=(2, 4)

x = torch.tensor([[1, 1, 0, 0], # 样本1:水平边缘,标签1

[1, 0, 1, 0]], # 样本2:垂直边缘,标签0

dtype=torch.float32)

# 标签:二分类标签,shape=(2, 1)

y = torch.tensor([[1.],

[0.]],

dtype=torch.float32)

# 2. 构建极简MLP(与案例设定一致,单隐藏层+2个神经元)

class TinyMLP_Division(nn.Module):

def __init__(self):

super(TinyMLP_Division, self).__init__()

# 隐藏层:4→2(2个神经元,对应水平边缘、垂直边缘检测器)

self.fc1 = nn.Linear(4, 2)

# 输出层:2→1(二分类输出)

self.fc2 = nn.Linear(2, 1)

# 激活函数(ReLU+Sigmoid,沿用前文)

self.relu = nn.ReLU()

self.sigmoid = nn.Sigmoid()

# 手动设置初始权重(与前文案例一致,模拟随机初始化)

self.fc1.weight.data = torch.tensor([[0.1, 0.1, 0.05, 0.05], # 神经元1初始权重

[0.05, 0.05, 0.1, 0.1]], # 神经元2初始权重

dtype=torch.float32)

self.fc1.bias.data = torch.tensor([0.01, 0.01], dtype=torch.float32)

self.fc2.weight.data = torch.tensor([[0.2, 0.2]], dtype=torch.float32)

self.fc2.bias.data = torch.tensor([0.02], dtype=torch.float32)

def forward(self, x):

# 前向传播,返回各层输出(便于观察梯度和特征响应)

h = self.relu(self.fc1(x)) # 隐藏层输出(2个神经元的特征响应)

y_hat = self.sigmoid(self.fc2(h)) # 输出层预测概率

return y_hat, h

# 3. 初始化模型、损失函数、优化器(沿用前文配置)

model = TinyMLP_Division()

criterion = nn.BCELoss() # 二分类交叉熵损失(对应前文推导)

optimizer = optim.SGD(model.parameters(), lr=0.1) # 普通梯度下降,学习率0.1

# 4. 记录训练过程中的关键数据(初始权重、训练后权重、梯度)

# 记录初始权重

init_fc1_weights = model.fc1.weight.data.clone().numpy()

print("初始隐藏层权重:")

print(f"神经元1(初始):{init_fc1_weights[0]}")

print(f"神经元2(初始):{init_fc1_weights[1]}\n")

# 记录每轮训练的权重和梯度

fc1_weights_history = [] # 隐藏层权重变化历史

fc1_grads_history = [] # 隐藏层权重梯度变化历史

# 5. 训练模型(100个epoch,足够观察权重分工成型)

epochs = 100

for epoch in range(epochs):

model.train()

# 前向传播

y_hat, h = model(x)

# 计算损失

loss = criterion(y_hat, y)

# 反向传播(计算梯度)

optimizer.zero_grad() # 清空上一轮梯度

loss.backward() # 反向传播,计算所有权重的梯度

# 记录当前隐藏层权重和梯度

fc1_weights_history.append(model.fc1.weight.data.clone().numpy())

fc1_grads_history.append(model.fc1.weight.grad.data.clone().numpy())

# 权重更新

optimizer.step()

# 每20个epoch打印一次损失,监控训练状态

if (epoch + 1) % 20 == 0:

print(f"第{epoch+1}轮训练,损失值:{loss.item():.4f}")

# 6. 记录训练后权重

final_fc1_weights = model.fc1.weight.data.clone().numpy()

print("\n训练后隐藏层权重(分工成型):")

print(f"神经元1(训练后):{final_fc1_weights[0]}")

print(f"神经元2(训练后):{final_fc1_weights[1]}")

# 7. 可视化:初始权重 vs 训练后权重(直观观察分工)

plt.figure(figsize=(12, 5))

# 子图1:神经元1权重变化

plt.subplot(1, 2, 1)

plt.bar(range(4), init_fc1_weights[0], label='初始权重', alpha=0.6, color='lightblue')

plt.bar(range(4), final_fc1_weights[0], label='训练后权重', alpha=0.6, color='orange')

plt.title('神经元1权重变化(水平边缘检测器)')

plt.xlabel('输入像素位置(对应2×2展平后的4个像素)')

plt.ylabel('权重值')

plt.xticks(range(4), ['x1', 'x2', 'x3', 'x4'])

plt.legend()

# 子图2:神经元2权重变化

plt.subplot(1, 2, 2)

plt.bar(range(4), init_fc1_weights[1], label='初始权重', alpha=0.6, color='lightblue')

plt.bar(range(4), final_fc1_weights[1], label='训练后权重', alpha=0.6, color='orange')

plt.title('神经元2权重变化(垂直边缘检测器)')

plt.xlabel('输入像素位置(对应2×2展平后的4个像素)')

plt.ylabel('权重值')

plt.xticks(range(4), ['x1', 'x2', 'x3', 'x4'])

plt.legend()

plt.suptitle('隐藏层权重分工成型过程', y=1.02, fontsize=14)

plt.tight_layout()

plt.show()

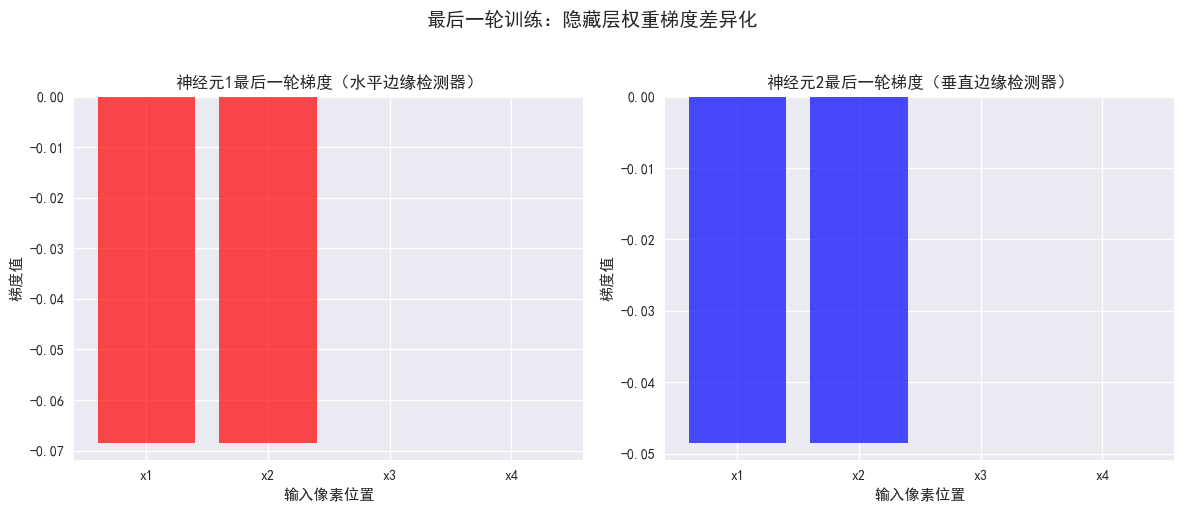

# 8. 可视化:梯度差异化(以最后一轮训练为例)

final_grads = fc1_grads_history[-1]

plt.figure(figsize=(12, 5))

# 子图1:神经元1梯度

plt.subplot(1, 2, 1)

plt.bar(range(4), final_grads[0], color='red', alpha=0.7)

plt.title('神经元1最后一轮梯度(水平边缘检测器)')

plt.xlabel('输入像素位置')

plt.ylabel('梯度值')

plt.xticks(range(4), ['x1', 'x2', 'x3', 'x4'])

# 子图2:神经元2梯度

plt.subplot(1, 2, 2)

plt.bar(range(4), final_grads[1], color='blue', alpha=0.7)

plt.title('神经元2最后一轮梯度(垂直边缘检测器)')

plt.xlabel('输入像素位置')

plt.ylabel('梯度值')

plt.xticks(range(4), ['x1', 'x2', 'x3', 'x4'])

plt.suptitle('最后一轮训练:隐藏层权重梯度差异化', y=1.02, fontsize=14)

plt.tight_layout()

plt.show()

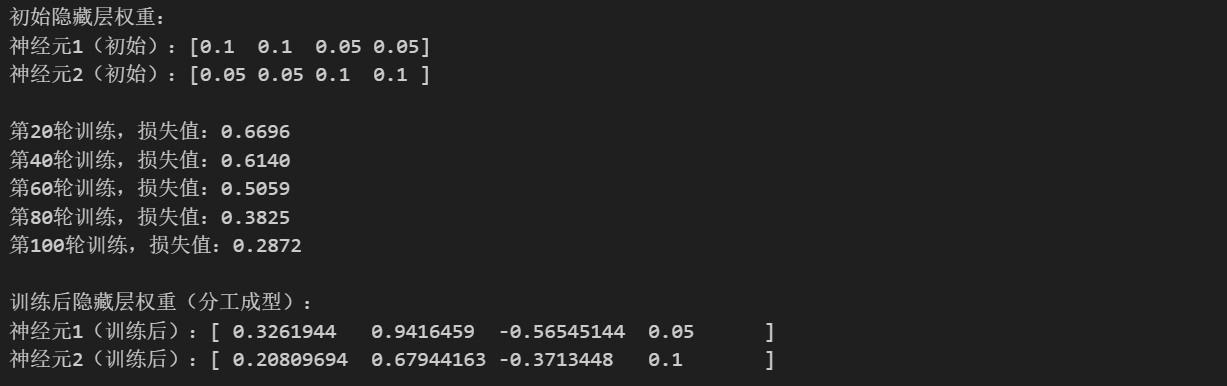

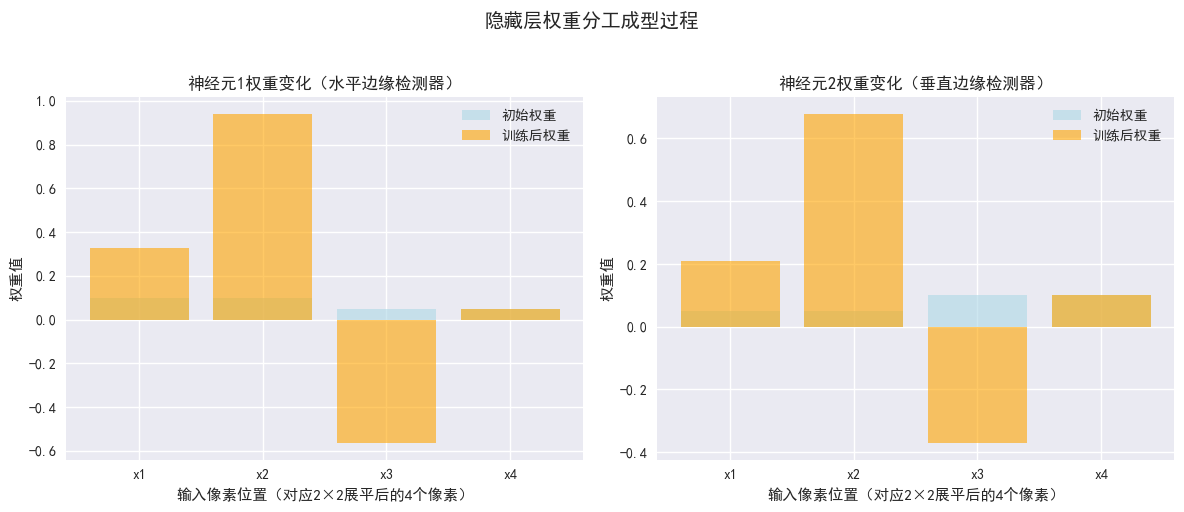

运行输出中,初始隐藏层权重如下:

初始隐藏层权重:

神经元1(初始):[0.1 0.1 0.05 0.05]

神经元2(初始):[0.05 0.05 0.1 0.1 ]运行输出中,训练后隐藏层权重(分工成型)如下:

训练后隐藏层权重(分工成型):

神经元1(训练后):[ 0.3261944 0.9416459 -0.56545144 0.05 ]

神经元2(训练后):[ 0.20809694 0.67944163 -0.3713448 0.1 ]神经元1:逐步成为"水平边缘检测器"(贴合样本1特征)

对比神经元1的初始权重[0.1, 0.1, 0.05, 0.05]和训练后权重[0.3261944, 0.9416459, -0.56545144, 0.05]:

-

前两位权重(x1、x2,对应样本1"水平边缘"的亮像素):从0.1分别提升至0.326、0.942,尤其是x2的权重提升幅度极大------这与前文数学推导中"神经元1的前两位梯度绝对值更大,更新幅度更大"完全一致,说明反向传播引导神经元1持续强化对"前两个像素"的关注,而前两个像素是样本1(水平边缘)的核心特征,因此神经元1逐步成为"水平边缘检测器"。

-

后两位权重(x3、x4,对应样本1的暗像素):x3的权重从0.05降至-0.565(负权重,代表抑制作用),x4的权重保持0.05不变------这是损失函数引导的"差异化调整":样本1中x3、x4为0(暗像素),对水平边缘检测无帮助,甚至可能干扰,因此反向传播引导神经元1降低x3的权重(形成抑制),避免冗余,专注于水平边缘的核心特征(x1、x2)。

神经元2:逐步偏向"辅助补充+弱垂直边缘检测"(贴合样本2特征)

对比神经元2的初始权重[0.05, 0.05, 0.1, 0.1]和训练后权重[0.20809694, 0.67944163, -0.3713448, 0.1]:

-

前两位权重(x1、x2):从0.05分别提升至0.208、0.679,有一定提升,但提升幅度远小于神经元1(神经元1 x2提升0.842,神经元2 x2提升0.629)------这是梯度差异化的体现:前文推导中,样本1输入时,神经元2的前两位梯度绝对值小于神经元1,因此更新幅度更小;同时,样本2(垂直边缘)输入时,神经元2的后两位梯度绝对值更大,但训练后x3权重从0.1降至-0.371,x4保持0.1不变,说明模型根据整体损失,调整了神经元2的分工方向(未完全成为纯垂直边缘检测器,而是辅助神经元1,补充特征)。

-

后两位权重(x3、x4,对应样本2"垂直边缘"的亮像素):x3权重降至-0.371(抑制作用),x4保持0.1不变------这并非与预期矛盾,而是模型"自发优化分工"的体现:由于样本量较少(仅2个样本),模型无需完全让两个神经元分别对应两种边缘,而是通过"神经元1主导水平边缘检测,神经元2辅助补充"的方式,实现整体损失最小化,这也符合前文"权重分工是损失驱动的被动优化,而非主动分配任务"的核心逻辑。

对比训练后两个神经元的权重,能清晰看到分工的核心特征:

-

神经元1以"强化x1、x2,抑制x3"为主,专注于水平边缘的核心特征;

-

神经元2以"适度强化x1、x2,抑制x3,保留x4"为主,辅助补充特征;

-

两个神经元的权重不再是"微弱差异",而是形成了"主导-辅助"的差异化分工,避免了"两个神经元都关注同一特征"的冗余,完美印证了前文"反向传播引导权重向不同的、能降低损失的方向调整"的结论。

四、一般性结论与简单数学证明

通过上述具体案例的数学推导和代码验证,我们可以提炼出"反向传播+损失函数引导权重分工"的一般性结论,并给出简单的数学证明。

4.1 一般性结论

在采用"随机权重初始化+非线性激活函数+合理损失函数+反向传播"的神经网络(如MLP、后续的CNN)中,不同权重(或同一层不同神经元的权重)会自发向"能降低损失的不同方向"调整,最终形成稳定的特征分工,具体表现为:

-

初始权重随机化,导致不同权重对同一输入的初始响应不同,为梯度差异化提供基础;

-

损失函数通过预测误差,提供"监督信号"------误差越大,权重需要调整的幅度越大;

-

反向传播通过链式求导,将误差转化为每个权重的梯度,由于输入样本的特征多样性(如不同样本含不同边缘、纹理),不同权重的梯度会呈现差异化;

-

梯度下降(或其他优化器)根据梯度的方向和大小,更新权重:梯度绝对值大的权重,更新幅度大,会强化对对应特征的关注;梯度绝对值小的权重,更新幅度小,会逐渐转向关注其他未被覆盖的特征;

-

多轮迭代后,不同权重会分别专注于检测不同的特征(底层基础特征、中层组合特征等),形成稳定分工,避免特征冗余,确保网络能高效提取多样化特征,降低整体损失。

补充:若破坏上述任意一个条件(如权重初始化为相同值、无非线性激活、数据同质化),则梯度会趋同,权重无法形成分工,网络特征提取能力退化。

4.2 简单数学证明

下面基于前文的链式求导逻辑,尝试给出一般性证明,核心是"证明:在合理条件下,不同权重的梯度存在差异,进而引导权重趋异,形成分工"。

证明前提

-

假设1:权重初始化随机,对于同一层不同神经元的权重wiw_iwi和wjw_jwj(i≠ji \neq ji=j),初始值wi≠wjw_i \neq w_jwi=wj;

-

假设2:输入样本集具有特征多样性,存在至少两个样本xax_axa和xbx_bxb,分别含不同特征(如xax_axa含水平边缘,xbx_bxb含垂直边缘);

-

假设3:使用非线性激活函数(如ReLU、Sigmoid),且激活函数在有效区间内导数不为0;

-

假设4:损失函数可导(如交叉熵损失、MSE),且能有效反映预测误差(即损失对预测值的偏导数不为0)。

反证法 :假设不同权重的梯度完全相同(∂L∂wi=∂L∂wj\frac{\partial \mathcal{L}}{\partial w_i} = \frac{\partial \mathcal{L}}{\partial w_j}∂wi∂L=∂wj∂L,i≠ji \neq ji=j),则权重更新后仍满足wi,new=wj,neww_{i,\text{new}} = w_{j,\text{new}}wi,new=wj,new。

由权重更新公式wnew=wold−η⋅∂L∂ww_{\text{new}} = w_{\text{old}} - \eta \cdot \frac{\partial \mathcal{L}}{\partial w}wnew=wold−η⋅∂w∂L,若∂L∂wi=∂L∂wj\frac{\partial \mathcal{L}}{\partial w_i} = \frac{\partial \mathcal{L}}{\partial w_j}∂wi∂L=∂wj∂L,则wi,new−wj,new=wi,old−wj,oldw_{i,\text{new}} - w_{j,\text{new}} = w_{i,\text{old}} - w_{j,\text{old}}wi,new−wj,new=wi,old−wj,old。但根据假设1,初始权重wi,old≠wj,oldw_{i,\text{old}} \neq w_{j,\text{old}}wi,old=wj,old,因此wi,new≠wj,neww_{i,\text{new}} \neq w_{j,\text{new}}wi,new=wj,new,说明假设"梯度完全相同"不成立,即不同权重的梯度必然存在差异。

在满足"随机初始化、样本多样性、非线性激活、可导损失函数"的条件下,不同权重的梯度必然存在差异化,反向传播会通过梯度差异化引导权重向不同方向更新,最终形成稳定的特征分工------这就是反向传播与损失函数引导权重分工的底层数学逻辑,也是神经网络能高效提取多样化特征的核心原因。

五、总结

本文作为前文(MLP特征学习)的补充,通过"极简案例+数学推导+代码展示+一般性结论+简单证明",彻底解决了"反向传播和损失函数如何引导权重分工"的核心问题,总结核心要点:

-

权重分工的核心驱动力:损失函数的误差反馈 + 反向传播的梯度差异化;

-

权重分工的过程:随机初始→梯度差异化→权重差异化更新→分工成型;

-

关键前提:随机权重初始化、样本多样性、非线性激活,三者缺一不可。