这里写自定义目录标题

烧录系统

选择一台Linux系统,或者VMware的电脑作为主机,烧录系统和后面安装Jetpack都会用到。

根据供应商的指令烧录的,暂时还没验证官方烧录(后续验证补充)。

安装Jetpack

-

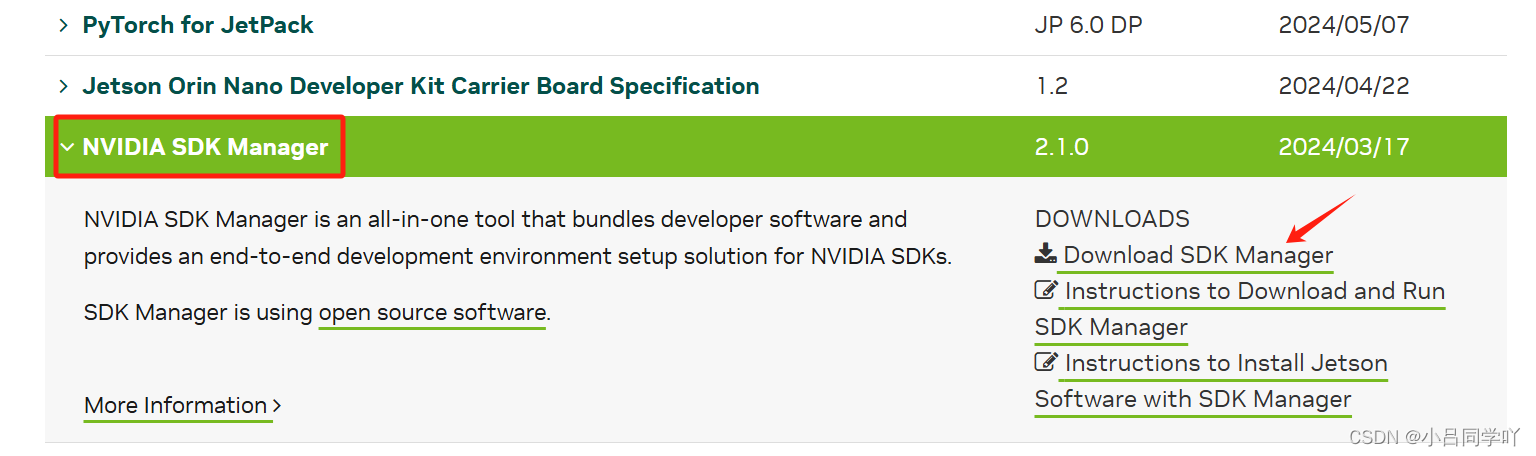

在主机安装SDK Manager,去Jetson Download下载,千万不要下官方给的最新版本(因为他们文档是以前写的,下载他们这个版本登不上)。

-

安装指令

python

sudo apt install ./sdkmanager_[version]-[build]_amd64.deb- 启动

python

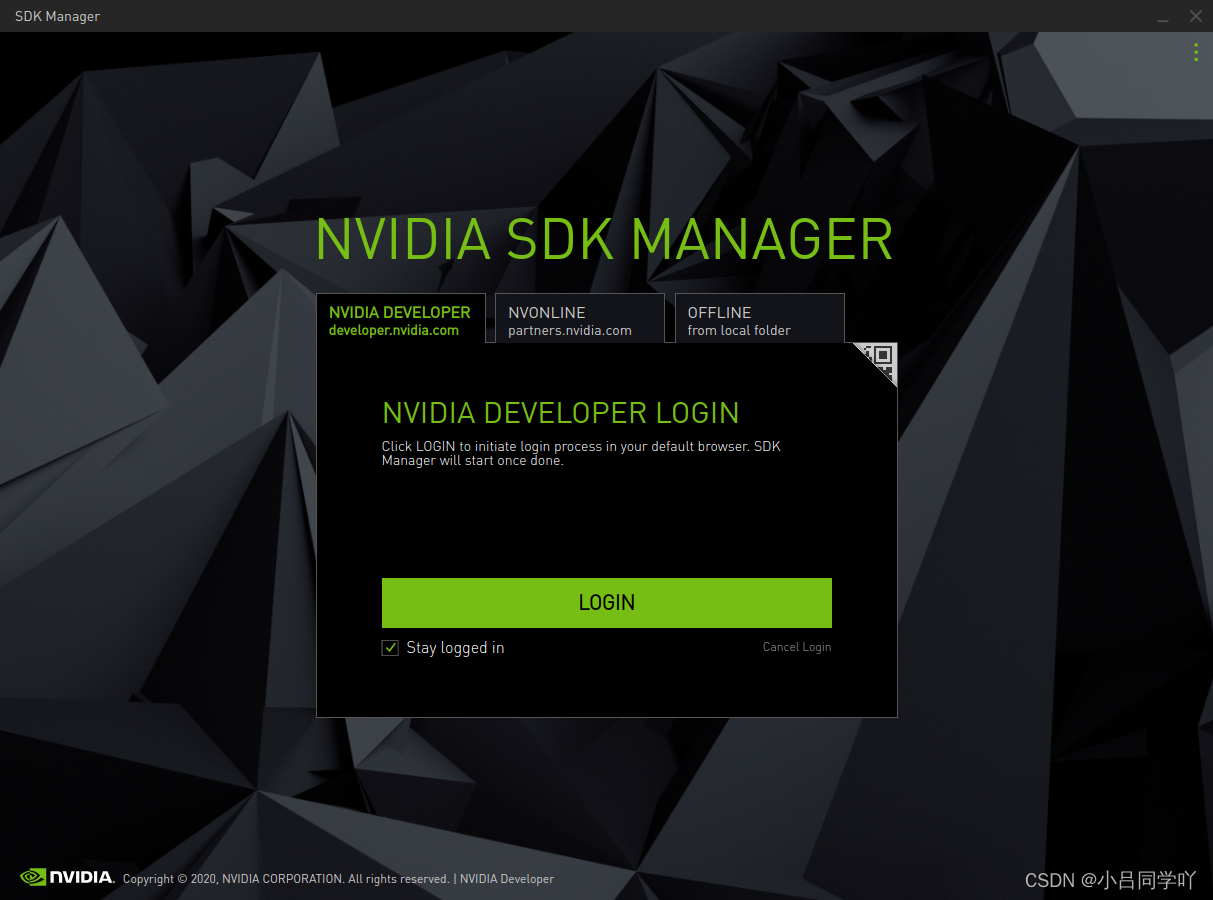

sdkmanager- 登录

输入NVIDIA Developer账户

- 按照以下步骤安装

安装cuda

python

sudo apt install nvidia-jetpack -y检查cuda版本

python

# 不要使用nvidia-smi, 这个不准

nvcc -V如果报错nvcc命令无法识别,需要将nvcc添加到环境变量

一般cuda安装在/usr/local/cuda/bin

python

vim ~/.bashrc

python

# 添加到~/.bashrc里面

export LD_LIBRARY_PATH=/usr/local/cuda/lib

export PATH=$PATH:/usr/local/cuda/bin

python

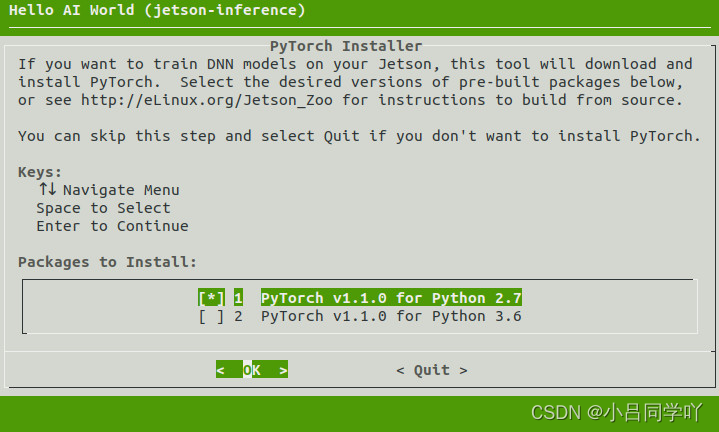

source ~/.bashrc安装Pytorch

python

cd jetson-inference/build

./install-pytorch.sh

安装onnxruntime

为什么安装onnxruntime呢?

为了方便加载模型运行,可以先将torch模型转成onnx模型,再完成模型推理。

下载onnxruntime.whl,然后使用pip3 install onnxruntime_gpu-1.16.0-cp38-cp38-linux_aarch64.whl

GPU运行onnxruntime

python

session = onnxruntime.InferenceSession(onnx_model, provider=['CUDAExecutionProvider'])安装qv4l2

python

# 安装驱动

sudo apt install qv4l2

python

# 加载驱动

cd /etc/realtimes

sudo insmod cam_gmsl.ko