非线性变换的目的

-

非线性变换的目的是为神经网络引入一些非线性特征,使其训练出一些符合各种曲线或各种特征的模型。

-

换句话来说,如果模型都是直线特征的话,它的泛化能力会不够好。

目录

深度学习层列表 - MATLAB & Simulink - MathWorks 中国

- reluLayer 修正线性单元 (ReLU) 层

- sigmoidLayer

- leakyReluLayer泄漏整流线性单元 (ReLU) 层

- 双曲正切 (tanh) 层tanhLayer

- Softmax 层softmaxLayer

reluLayer

修正线性单元 (ReLU) 层

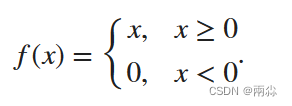

ReLU 层对输入的每个元素执行阈值运算,其中任何小于零的值都设置为零。

此运算等效于

语法

layer = reluLayer 创建一个 ReLU 层。layer = reluLayer('Name',Name) 创建一个 ReLU 层,并使用名称-值对组设置可选的 Name 属性。例如,reluLayer('Name','relu1') 创建一个名为 'relu1' 的 ReLU 层。

机器学习中的数学------激活函数(三): 线性整流函数(ReLU函数)-CSDN博客

sigmoidLayer

Sigmoid 层自 R2020b 起

**说明:**sigmoid 层将 sigmoid 函数应用于输入,例如 输出以区间 (0,1) 为界。

此运算等效于

语法

- layer = sigmoidLayer 创建一个 sigmoid 层。

- layer = sigmoidLayer('Name',Name) 创建一个 sigmoid 层,并使用名称-值对参数设置可选的 Name 属性。例如,创建名称为 的 sigmoid 层。将属性名称括在单引号中。sigmoidLayer('Name','sig1')'sig1'

应用 sigmoid 激活 - MATLAB sigmoid - MathWorks 中国

Sigmoid 层 - MATLAB - MathWorks 中国

机器学习中的数学------激活函数(一):Sigmoid函数-CSDN博客

leakyReluLayer泄漏整流线性单元 (ReLU) 层

在 R2017b 中引入

泄漏的 ReLU 层执行阈值操作,其中任何 小于零的输入值乘以固定标量。

此运算等效于

语法

- layer = leakyReluLayer 返回一个 泄漏的 ReLU 层。

- layer = leakyReluLayer(scale) 返回一个泄漏的 ReLU 层,其标量乘数等于 负输入。scale

- layer = leakyReluLayer(___,'Name',Name)返回泄漏的 ReLU 图层并设置可选的 Name 属性。

机器学习中的数学------激活函数(四):Leaky ReLU函数_leakyrelu函数-CSDN博客

Leaky Rectified Linear Unit (ReLU) layer - MATLAB - MathWorks 中国

双曲正切 (tanh) 层tanhLayer

双曲正切 (tanh) 层tanhLayer在 R2019a 中推出

双曲正切 (tanh) 激活层对层输入应用 tanh 函数。

语法

- layer = tanhLayer 创建一个双曲正切层。

- layer = tanhLayer('Name',Name) 还指定可选的 Name 属性。例如,tanhLayer('Name','tanh1') 创建一个名为 'tanh1' 的 tanh 层。

双曲正切 (tanh) 层 - MATLAB - MathWorks 中国

机器学习中的数学------激活函数(二):双曲正切函数(Tanh函数)_双曲正切激活函数-CSDN博客

Softmax 层softmaxLayer

softmax 层对输入应用 softmax 函数。

softmax 函数

softmax函数又称归一化指数函数,是基于 sigmoid 二分类函数在多分类任务上的推广;在多分类网络中,常用 Softmax 作为最后一层进行分类。

Softmax 的计算公式如下:

语法

- 使用 layer = softmaxLayer 创建一个 softmax 层。

- layer = softmaxLayer('Name',Name) 创建一个 softmax 层,并使用名称-值对组设置可选的 Name 属性。例如,softmaxLayer('Name','sm1') 创建一个名为 'sm1' 的 softmax 层。用单引号将属性名称引起来。