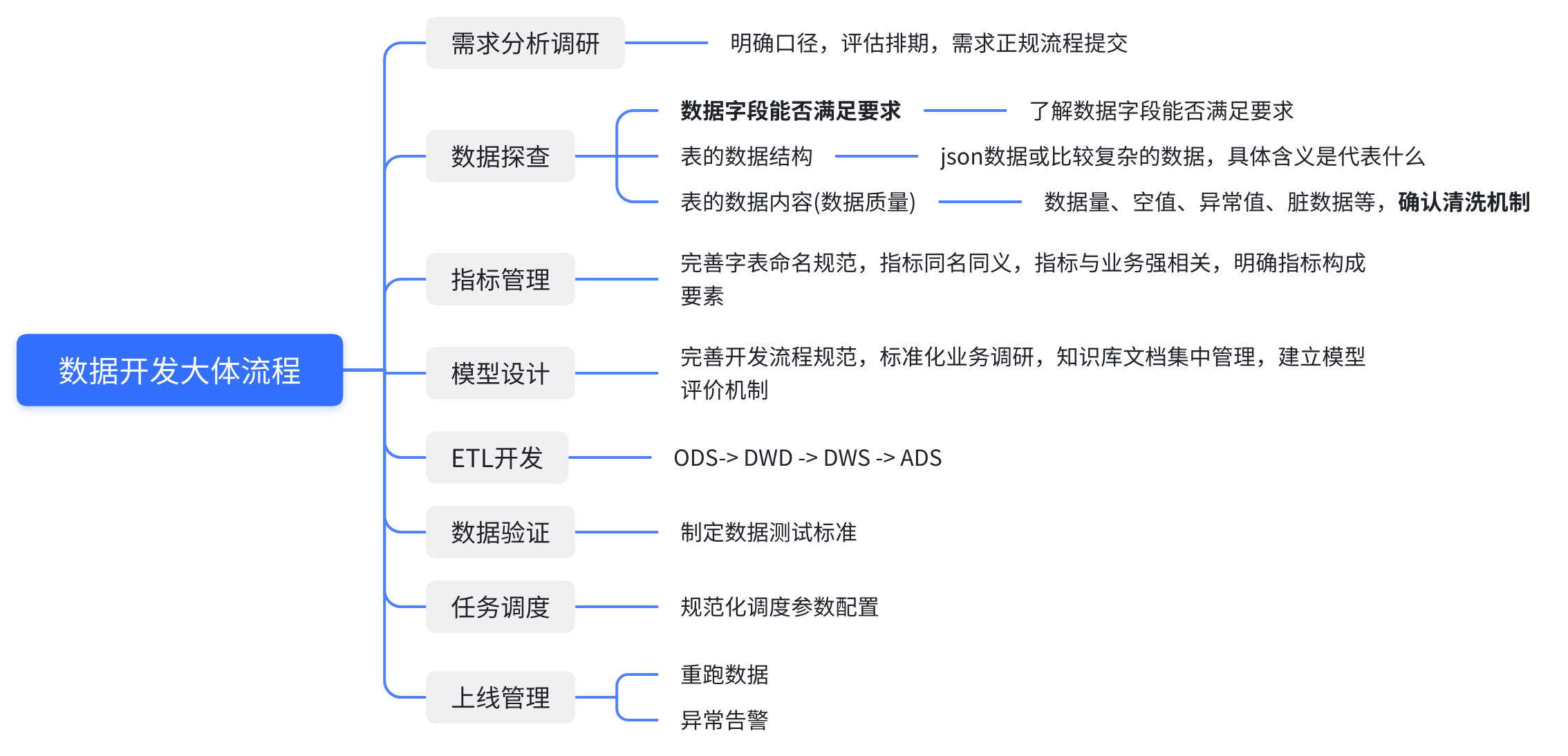

大数据开发是一个复杂且系统的过程,涉及需求分析、数据探查、指标管理、模型设计、ETL开发、数据验证、任务调度以及上线管理等多个阶段。本文将详细介绍每个阶段的内容,并提供相关示例和代码示例,帮助理解和实施大数据开发流程。

本文中的示例只是一个简单的工具,实际中可能用到很复杂的工具,但核心思想不变。

1. 需求分析调研

需求分析是大数据项目开发的第一步,通过明确项目的口径、评估排期和正式需求流程提交,确保所有参与者对项目的目标和范围有一致的理解。

示例:

需求分析文档:**

- 项目名称:用户行为分析平台

- 项目目标:建立一个平台,实时分析用户行为数据,提供行为趋势和预测分析

- 关键指标:用户活跃度、页面停留时间、转化率

- 数据源:用户点击流日志、用户注册信息、交易记录

- 预期交付:原型展示、用户行为报告、预测模型2. 数据探查

在数据探查阶段,我们需要了解数据字段能否满足需求,包括数据结构、数据内容和数据质量等方面。

示例:

python

import pandas as pd

# 读取数据

data = pd.read_csv('user_click_stream.csv')

# 查看数据结构

print(data.info())

# 查看数据内容

print(data.head())

# 检查数据质量

missing_values = data.isnull().sum()

print(f"Missing values in each column:\n{missing_values}")3. 指标管理

指标管理包括完善字段命名规范、确保指标与业务的强相关性,以及明确指标构成。

示例:

sql

-- 建立指标表

CREATE TABLE user_metrics (

user_id INT,

active_days INT,

avg_session_duration FLOAT,

conversion_rate FLOAT

);

-- 插入数据

INSERT INTO user_metrics (user_id, active_days, avg_session_duration, conversion_rate)

VALUES (1, 20, 300.5, 0.05);4. 模型设计

在模型设计阶段,我们需要完善开发流程规范、标准化业务调研和知识库文档集中管理,建立模型。

示例:

python

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

# 加载数据

data = pd.read_csv('user_data.csv')

X = data.drop('target', axis=1)

y = data['target']

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 训练模型

model = RandomForestClassifier(n_estimators=100, random_state=42)

model.fit(X_train, y_train)

# 模型评估

accuracy = model.score(X_test, y_test)

print(f"Model Accuracy: {accuracy}")5. ETL开发

ETL(Extract, Transform, Load)开发包括数据的提取、转换和加载。我们需要从ODS(操作数据存储)到DWD(数据仓库明细层),再到DWS(数据仓库汇总层),最终到ADS(应用数据服务层)。

示例:

python

import pyodbc

# 连接到数据库

conn = pyodbc.connect('DRIVER={SQL Server};SERVER=server_name;DATABASE=db_name;UID=user;PWD=password')

# 提取数据

query = "SELECT * FROM ods_table"

data = pd.read_sql(query, conn)

# 转换数据

data['new_column'] = data['existing_column'].apply(lambda x: transform_function(x))

# 加载数据

data.to_sql('dws_table', conn, if_exists='append', index=False)6. 数据验证

数据验证阶段包括制定数据测试标准,确保数据的准确性和完整性。

示例:

python

# 验证数据质量

def validate_data(data):

if data.isnull().sum().sum() > 0:

raise ValueError("Data contains missing values")

if (data < 0).sum().sum() > 0:

raise ValueError("Data contains negative values")

return True

# 读取数据

data = pd.read_csv('dws_table.csv')

# 执行数据验证

validate_data(data)7. 任务调度

任务调度是为了规范化调度参数配置,确保数据处理任务按计划执行。

示例:

bash

# 使用cron调度任务

0 2 * * * /usr/bin/python3 /path/to/etl_script.py实际中可能使用airflow、dolphinscheduler等工具

8. 上线管理

上线管理包括重跑数据和异常告警,确保系统稳定运行。

示例:

python

import logging

# 设置日志记录

logging.basicConfig(filename='data_pipeline.log', level=logging.INFO)

# 记录重跑数据

def rerun_data():

try:

# 数据处理逻辑

logging.info("Data pipeline rerun successful")

except Exception as e:

logging.error(f"Data pipeline rerun failed: {str(e)}")

# 执行重跑

rerun_data()结论

大数据开发流程涉及多个阶段,每个阶段都有其特定的任务和目标。从需求分析到上线管理,系统地进行规划和执行,可以确保大数据项目的成功实施。