集群启动后,无法正常使用hdfs的任何命令。使用jps查看进程,发现namenode没有启动,然后再进入到Hadoop的相应目录,打开里面的logs文件

打开Hadoop的master的log

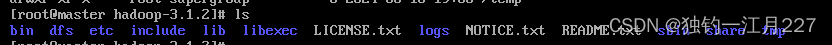

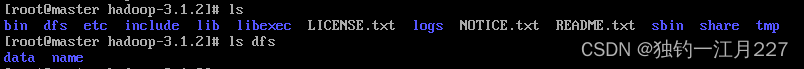

再使用vi编辑器查看(也可以用less或者more命令查看),往上翻到第一个java的报错,发现是img文件坏掉了导致namenode启动不了。然后删除掉hadoop文件下面的tmp文件和dfs文件(子目录也要删干净)。然后重新建dfs和tmp文件,dfs文件下有两个子目录。

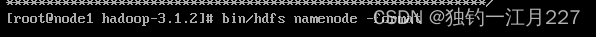

然后重新执行namenode -format指令初始化集群。

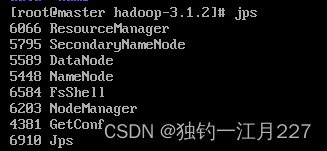

再重新启动,namenode就可以使用了

可能的原因:namenode死掉的原因可能是关虚拟机时没有stop-all.sh,而是直接把虚拟机关了,导致img出了问题。