+10x 工程师可能是神话,但 -10x 工程师确实存在。要成为 -10x 工程师,只需每周浪费 400 小时的工程时间。结合以下策略:

目录

-

- [如何使 10 名工程师的输出无效化](#如何使 10 名工程师的输出无效化)

- [创建 400 小时的繁忙工作](#创建 400 小时的繁忙工作)

- [创建 400 小时的倦怠/离职](#创建 400 小时的倦怠/离职)

- [在技术讨论中扣留 10 名工程师](#在技术讨论中扣留 10 名工程师)

- [增加 400 小时的沟通开销](#增加 400 小时的沟通开销)

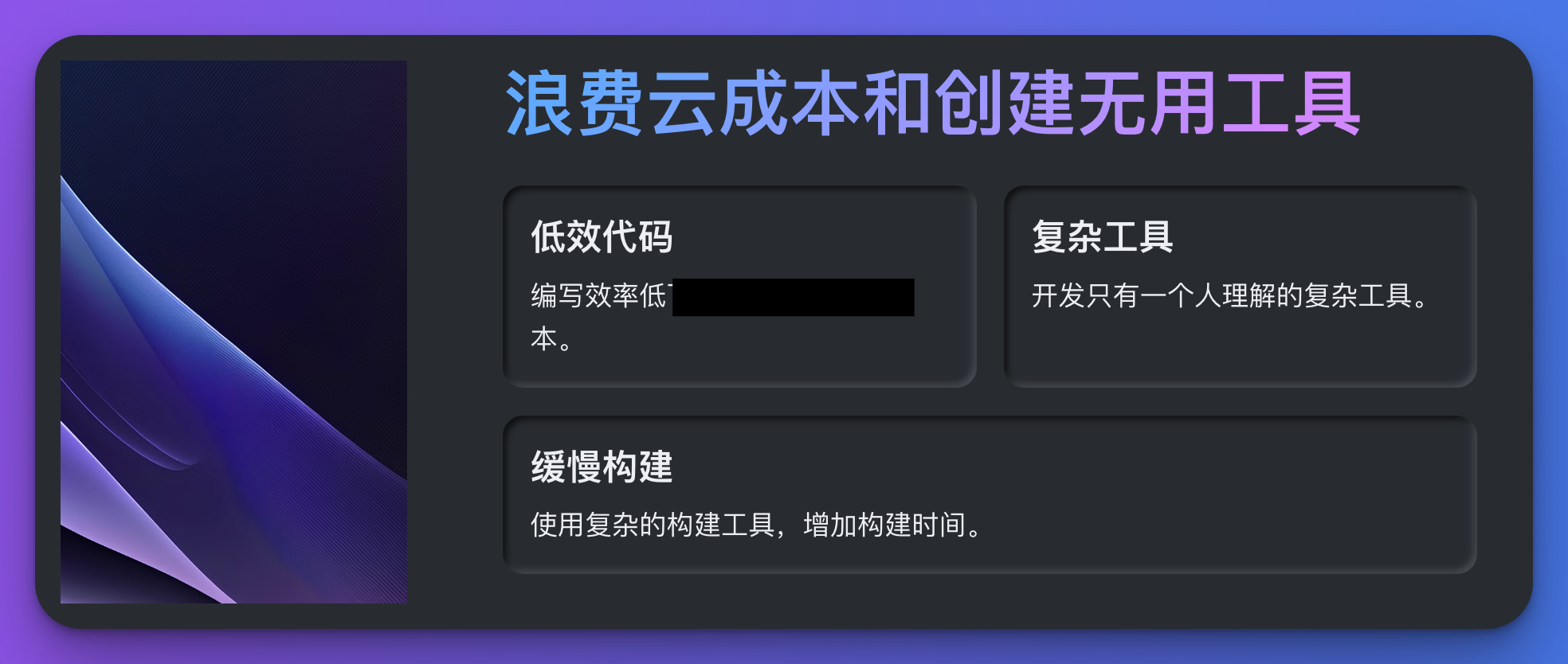

- [将 10 周工资浪费在云成本上](#将 10 周工资浪费在云成本上)

- 创建无用工具

- [增加 400 小时的编译/构建时间](#增加 400 小时的编译/构建时间)

- 编写无意义的测试

- [在糟糕的架构上浪费 400 小时](#在糟糕的架构上浪费 400 小时)

- [浪费 400 小时在部署上](#浪费 400 小时在部署上)

- [将 10 周工资浪费在不满意的客户上](#将 10 周工资浪费在不满意的客户上)

- 编写无用的文档

- [让 10 名工程师陷入徒劳的"特殊项目"](#让 10 名工程师陷入徒劳的“特殊项目”)

- [添加需要 400 小时维护的依赖](#添加需要 400 小时维护的依赖)

- 延迟转向

- [雇佣 10 名 0x 工程师](#雇佣 10 名 0x 工程师)

- [雇佣 5 名 -1x 工程师](#雇佣 5 名 -1x 工程师)

- [防止 10 名 -1x 工程师被解雇](#防止 10 名 -1x 工程师被解雇)

- [花费 400 小时在 bug 归类上](#花费 400 小时在 bug 归类上)

如何使 10 名工程师的输出无效化

改变需求

尽可能在开发后期更改需求。为了避免责备,从一开始就模糊需求。

python

# 确保需求模糊不清

def get_user_input():

return "用户的输入可能是这个,也可能是那个..."

def process_input(input):

# 处理用户输入,可能会有所不同

if input == "这个":

return "处理了这个"

else:

return "处理了那个"

input = get_user_input()

output = process_input(input)

print(output)大数据开发示例

在一个大数据开发项目中,可以不断更改数据处理管道的需求,使团队无法按时完成任务。

python

# 更改数据处理需求

def data_pipeline_v1(data):

return data.upper()

def data_pipeline_v2(data):

return data.lower()

def data_pipeline_v3(data):

return data.title()

# 开发后期不断更改需求

data = "example data"

pipeline = data_pipeline_v3 # 需求从 v1 到 v2 最后到 v3

output = pipeline(data)

print(output)创建 400 小时的繁忙工作

任务示例

要求团队执行类似工作的任务。常见示例包括演示文稿、图表和票务管理。创建无意义的仪式。

python

# 创建无用的工作

def create_presentation():

return "创建了一个无用的演示文稿"

def create_diagram():

return "创建了一个无用的图表"

def manage_tickets():

return "管理了一些无用的票务"

tasks = [create_presentation(), create_diagram(), manage_tickets()]

for task in tasks:

print(task)大数据开发示例

在大数据项目中,可以要求团队不断生成 ETL 流程的流程图和文档,而不关注实际数据处理的效率。

python

# 创建无用的 ETL 流程图

def create_etl_flowchart():

return "创建了一个无用的 ETL 流程图"

# 编写无意义的文档

def write_etl_documentation():

return "编写了一份无人使用的 ETL 文档"

tasks = [create_etl_flowchart(), write_etl_documentation()]

for task in tasks:

print(task)创建 400 小时的倦怠/离职

示例代码

python

# 确保团队感到沮丧

def blame_team_member(member):

return f"责备了团队成员 {member}"

def cause_confusion():

return "制造了混乱"

team_members = ["Alice", "Bob", "Charlie"]

for member in team_members:

print(blame_team_member(member))

print(cause_confusion())大数据开发示例

在大数据团队中,通过不断增加不必要的任务和无效的会议,使团队成员感到沮丧和混乱。

python

# 增加不必要的任务

def add_unnecessary_task(task):

return f"增加了不必要的任务 {task}"

# 安排无效的会议

def schedule_useless_meeting(meeting):

return f"安排了无效的会议 {meeting}"

tasks = ["任务1", "任务2", "任务3"]

meetings = ["会议1", "会议2", "会议3"]

for task in tasks:

print(add_unnecessary_task(task))

for meeting in meetings:

print(schedule_useless_meeting(meeting))在技术讨论中扣留 10 名工程师

示例代码

python

# 扣留工程师在技术讨论中

def discuss_idea(idea):

return f"讨论了想法 {idea},但没有做出任何决定"

ideas = ["想法1", "想法2", "想法3"]

for idea in ideas:

print(discuss_idea(idea))大数据开发示例

在大数据项目中,鼓励团队成员就数据架构进行无休止的讨论,而不采取任何实际行动。

python

# 数据架构无休止讨论

def discuss_data_architecture(architecture):

return f"讨论了数据架构 {architecture},但没有做出任何决定"

architectures = ["架构1", "架构2", "架构3"]

for architecture in architectures:

print(discuss_data_architecture(architecture))增加 400 小时的沟通开销

示例代码

python

# 通过会议浪费时间

def hold_meeting(topic):

return f"召开了关于 {topic} 的会议,浪费了时间"

meetings = ["主题1", "主题2", "主题3"]

for meeting in meetings:

print(hold_meeting(meeting))大数据开发示例

安排大量不必要的会议,讨论大数据处理管道的细节,而不是实际解决问题。

python

# 安排不必要的会议

def schedule_unnecessary_meeting(topic):

return f"安排了不必要的会议讨论 {topic}"

topics = ["大数据处理管道细节1", "大数据处理管道细节2", "大数据处理管道细节3"]

for topic in topics:

print(schedule_unnecessary_meeting(topic))将 10 周工资浪费在云成本上

示例代码

python

# 编写缓慢的程序

def slow_function():

for i in range(10000000):

pass

return "运行了缓慢的函数"

print(slow_function())大数据开发示例

在大数据项目中,编写效率低下的代码,增加云成本,如不使用数据库索引或在大数据集上运行单线程程序。

python

# 编写效率低下的代码

def inefficient_data_processing(data):

# 不使用索引进行查找

result = [item for item in data if item == "目标值"]

return result

data = ["值1", "值2", "目标值", "值3"]

output = inefficient_data_processing(data)

print(output)创建无用工具

示例代码

python

# 创建只有一个人理解的脚本

def obscure_script():

return "创建了一个只有一个人理解的脚本"

print(obscure_script())大数据开发示例

开发一个复杂的 ETL 工具,只有开发者自己能够理解和维护,其他团队成员无法使用或修改。

python

# 创建复杂的 ETL 工具

def complex_etl_tool(data):

# 只有一个人理解的复杂逻辑

result = data[::-1] # 例如,反转数据

return result

data = ["数据1", "数据2", "数据3"]

output = complex_etl_tool(data)

print(output)增加 400 小时的编译/构建时间

示例代码

python

# 确保构建时间缓慢

def slow_build():

import time

time.sleep(20) # 增加编译时间

return "完成了缓慢的构建"

print(slow_build())大数据开发示例

在大数据项目中,使用复杂的构建工具和脚本,增加构建和部署的时间,使开发过程变得缓慢而低效。

python

# 使用复杂的构建工具

def complex_build_tool():

import time

time.sleep(20) # 增加构建时间

return "使用了复杂的构建工具"

print(complex_build_tool())编写无意义的测试

示例代码

python

# 编写无意义的测试

def pointless_test():

import random

result = random.choice([True, False])

return f"测试{'成功' if result else '失败'},但没有意义"

print(pointless_test())大数据开发示例

编写无意义的单元测试,不测试数据处理管道的实际功能,只关注表面的变量变化。

python

# 编写无意义的单元测试

def meaningless_unit_test():

data = ["数据1", "数据2", "数据3"]

# 只测试变量存在与否,而不测试实际功能

assert data is not None, "数据为空"

return "无意义的单元测试通过"

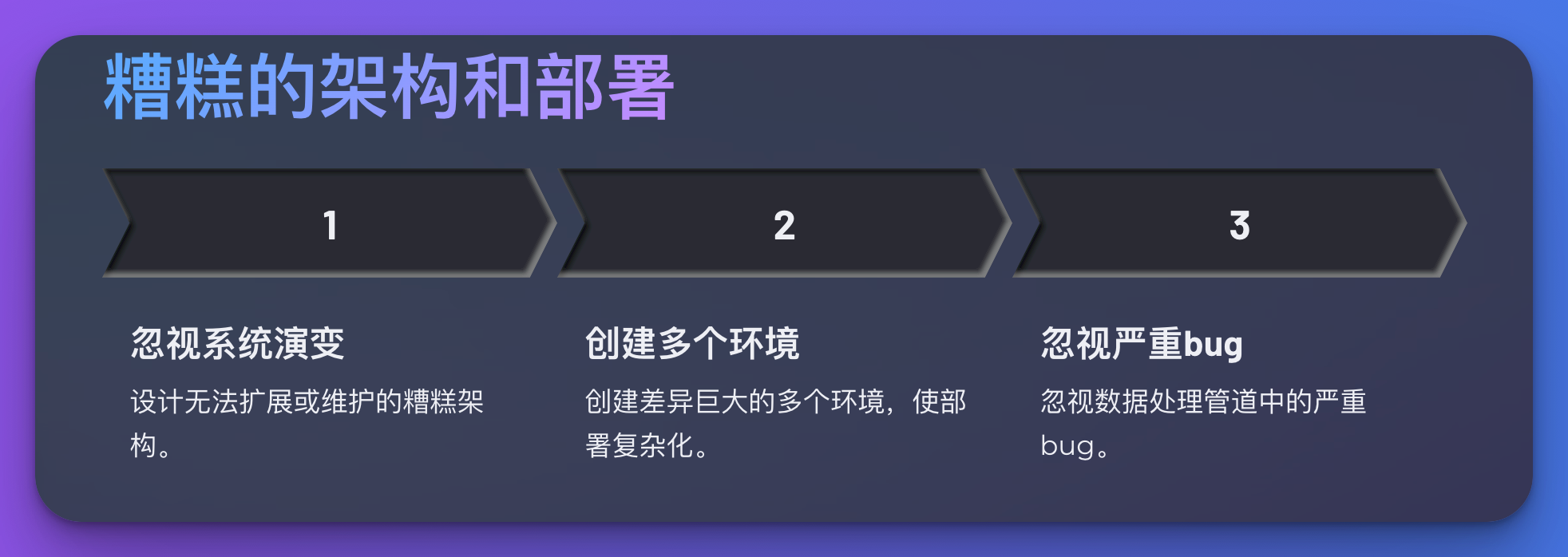

print(meaningless_unit_test())在糟糕的架构上浪费 400 小时

示例代码

python

# 忽视系统设计的演变

def poor_architecture():

return "设计了一个忽视系统演变的糟糕架构"

print(poor_architecture())大数据开发示例

在大数据项目中,设计一个无法扩展或维护的糟糕数据架构,导致未来的开发和维护变得非常困难。

python

# 设计无法扩展的架构

def unscalable_data_architecture(data):

# 使用硬编码方式处理数据

if "特殊值" in data:

return "处理了特殊值"

else:

return "未处理特殊值"

data = ["普通值", "特殊值"]

output = unscalable_data_architecture(data)

print(output)浪费 400 小时在部署上

示例代码

python

# 创建多个环境

def create_environments():

environments = ["生产环境", "预发布环境", "测试环境"]

return f"创建了多个环境:{', '.join(environments)}"

print(create_environments())大数据开发示例

在大数据项目中,创建多个环境,且这些环境之间存在巨大差异,导致部署过程变得复杂且容易出错。

python

# 创建多个差异巨大的环境

def create_varied_environments():

environments = ["生产环境", "预发布环境", "测试环境"]

differences = {

"生产环境": "使用 Oracle 数据库",

"预发布环境": "使用 MySQL 数据库",

"测试环境": "使用 SQLite 数据库"

}

return f"创建了多个差异巨大的环境:{differences}"

print(create_varied_environments())将 10 周工资浪费在不满意的客户上

示例代码

python

# 忽视严重的 bug

def ignore_severe_bugs():

return "忽视了严重的 bug"

print(ignore_severe_bugs())大数据开发示例

在大数据项目中,忽视数据处理管道中的严重 bug,导致客户对系统的不满,进而浪费大量时间和资源来修复和补救。

python

# 忽视数据处理中的严重 bug

def process_data_with_bugs(data):

# 假设存在严重 bug,但忽视它

if "错误值" in data:

return "处理了错误值,但存在严重 bug"

else:

return "数据处理正常"

data = ["数据1", "错误值", "数据3"]

output = process_data_with_bugs(data)

print(output)编写无用的文档

示例代码

python

# 编写无用的文档

def useless_documentation():

return "编写了一份无人使用的 wiki"

print(useless_documentation())大数据开发示例

编写无人使用的大数据处理流程文档,内容冗长且没有实际指导意义,团队成员无法从中获得帮助。

python

# 编写无用的文档

def write_useless_big_data_docs():

return "编写了一份冗长的大数据处理流程文档,没有实际指导意义"

print(write_useless_big_data_docs())让 10 名工程师陷入徒劳的"特殊项目"

示例代码

python

# 吸引优秀工程师但浪费其潜力

def futile_skunkworks_project():

return "吸引了优秀工程师,但浪费了他们的潜力"

print(futile_skunkworks_project())大数据开发示例

在大数据项目中,吸引优秀的工程师参与一个不切实际且毫无实际价值的项目,浪费他们的时间和精力。

python

# 吸引工程师参与无用项目

def attract_engineers_to_futile_project():

engineers = ["优秀工程师1", "优秀工程师2", "优秀工程师3"]

project = "不切实际的大数据项目"

return f"吸引了{', '.join(engineers)}参与{project},浪费了他们的时间和精力"

print(attract_engineers_to_futile_project())添加需要 400 小时维护的依赖

示例代码

python

# 每个库都单独学习

def learn_library(library):

return f"单独学习了库 {library}"

libraries = ["库1", "库2", "库3"]

for library in libraries:

print(learn_library(library))大数据开发示例

在大数据项目中,添加多个复杂且难以维护的依赖库,每个库都需要工程师单独学习和维护,增加了项目的复杂性和维护成本。

python

# 添加复杂依赖库

def add_complex_dependencies():

dependencies = ["复杂库1", "复杂库2", "复杂库3"]

return f"添加了多个复杂且难以维护的依赖库:{', '.join(dependencies)}"

print(add_complex_dependencies())延迟转向

示例代码

python

# 沉没成本

def sunk_cost_fallacy():

return "坚持沉没成本,延迟转向"

print(sunk_cost_fallacy())大数据开发示例

在大数据项目中,明知当前技术栈或架构已经不适合继续发展,但由于沉没成本,仍然坚持不做任何改变,导致项目陷入困境。

python

# 坚持使用不合适的技术栈

def stick_to_unsuitable_tech_stack():

tech_stack = ["不合适的技术1", "不合适的技术2", "不合适的技术3"]

return f"坚持使用不合适的技术栈:{', '.join(tech_stack)},导致项目陷入困境"

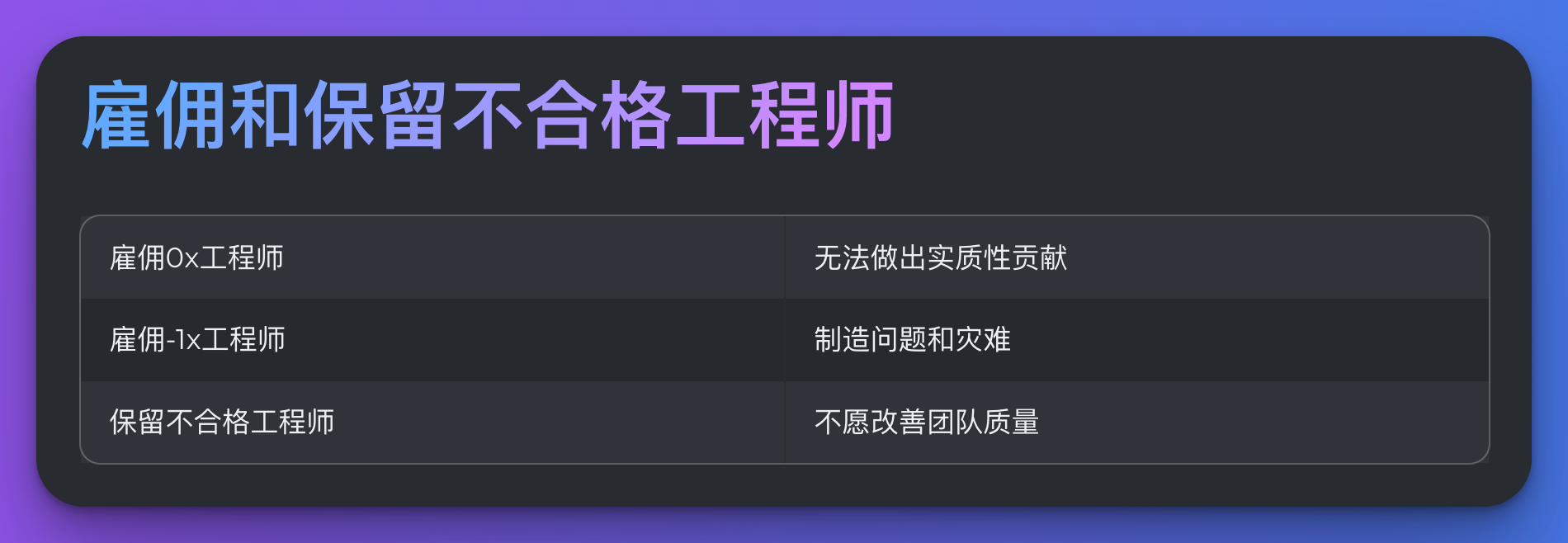

print(stick_to_unsuitable_tech_stack())雇佣 10 名 0x 工程师

示例代码

python

# 雇佣没有贡献的工程师

def hire_0x_engineer(engineer):

return f"雇佣了 0x 工程师 {engineer}"

engineers = ["工程师1", "工程师2", "工程师3"]

for engineer in engineers:

print(hire_0x_engineer(engineer))大数据开发示例

在大数据项目中,雇佣一些无法对项目做出任何实质性贡献的工程师,浪费资源。

python

# 雇佣没有贡献的工程师

def hire_unproductive_big_data_engineers():

engineers = ["工程师A", "工程师B", "工程师C"]

return f"雇佣了一些无法对项目做出实质性贡献的大数据工程师:{', '.join(engineers)}"

print(hire_unproductive_big_data_engineers())雇佣 5 名 -1x 工程师

示例代码

python

# 雇佣造成灾难的工程师

def hire_negative1x_engineer(engineer):

return f"雇佣了 -1x 工程师 {engineer}"

engineers = ["工程师A", "工程师B", "工程师C"]

for engineer in engineers:

print(hire_negative1x_engineer(engineer))大数据开发示例

在大数据项目中,雇佣一些不仅无法贡献,反而会制造问题和灾难的工程师,拖累整个项目的进度和质量。

python

# 雇佣制造问题的工程师

def hire_disastrous_big_data_engineers():

engineers = ["工程师X", "工程师Y", "工程师Z"]

return f"雇佣了一些制造问题和灾难的大数据工程师:{', '.join(engineers)}"

print(hire_disastrous_big_data_engineers())防止 10 名 -1x 工程师被解雇

示例代码

python

# 保住不合格的工程师

def retain_incompetent_engineer(engineer):

return f"保住了不合格的工程师 {engineer}"

engineers = ["不合格工程师1", "不合格工程师2", "不合格工程师3"]

for engineer in engineers:

print(retain_incompetent_engineer(engineer))大数据开发示例

在大数据项目中,保住一些不合格甚至是有害的工程师,不愿采取任何措施来改善团队质量和项目进度。

python

# 保住不合格的大数据工程师

def retain_incompetent_big_data_engineers():

engineers = ["不合格工程师A", "不合格工程师B", "不合格工程师C"]

return f"保住了一些不合格的大数据工程师:{', '.join(engineers)}"

print(retain_incompetent_big_data_engineers())花费 400 小时在 bug 归类上

示例代码

python

# 创建难以调试的程序

def create_undebuggable_program():

return "创建了一个难以调试的程序"

print(create_undebuggable_program())大数据开发示例

在大数据项目中,编写难以调试的复杂代码,层层抽象,使得调试和修复 bug 变得极其困难和耗时。

python

# 编写难以调试的复杂代码

def write_complex_undebuggable_code():

code = """

def process_data(data):

# 层层抽象,难以调试

def inner_process(data_chunk):

# 复杂逻辑,难以跟踪

return data_chunk[::-1]

return [inner_process(chunk) for chunk in data]

data = ["数据1", "数据2", "数据3"]

output = process_data(data)

print(output)

"""

return code

print(write_complex_undebuggable_code())以上示例展示了如何在大数据开发中通过一系列策略成为-10x工程师,浪费时间、资源和精力,使项目陷入困境。希望这些反面教材能帮助大家避免类似的错误。