开源项目,欢迎star哦,https://github.com/data-infra/cube-studio

一款真正意义的 LLMOps 框架

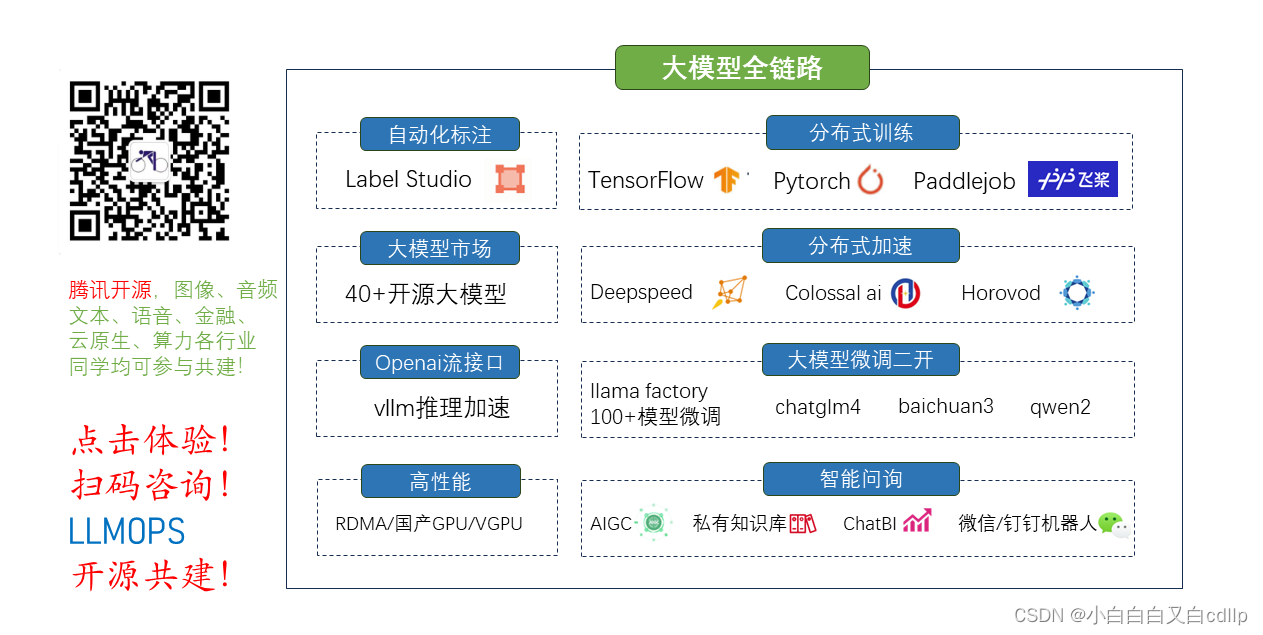

LLMOps(Large Language Model Operations)是一个涵盖了大型语言模型(如GPT系列)开发、部署、维护和优化的一整套实践和流程,而不仅仅是大模型的应用层。

简介

Cube-Studio是由腾讯音乐开源的一款云原生一站式AI中台,覆盖机器学习/深度学习/LLM大模型,开发、训练、推理、应用,全链路。

github地址:https://github.com/data-infra/cube-studio

该项目目前已是国内最火的开源算法全链路中台,上千家企业私有化部署和项目交付,非常适合数据算法架构团队搭建公司级AI中台,以及toB企业算法中台类项目交付。

LLMOps

cube-studio除了支持原有mlops全链路能力外,新版本增加了很多大模型相关的链路能力。

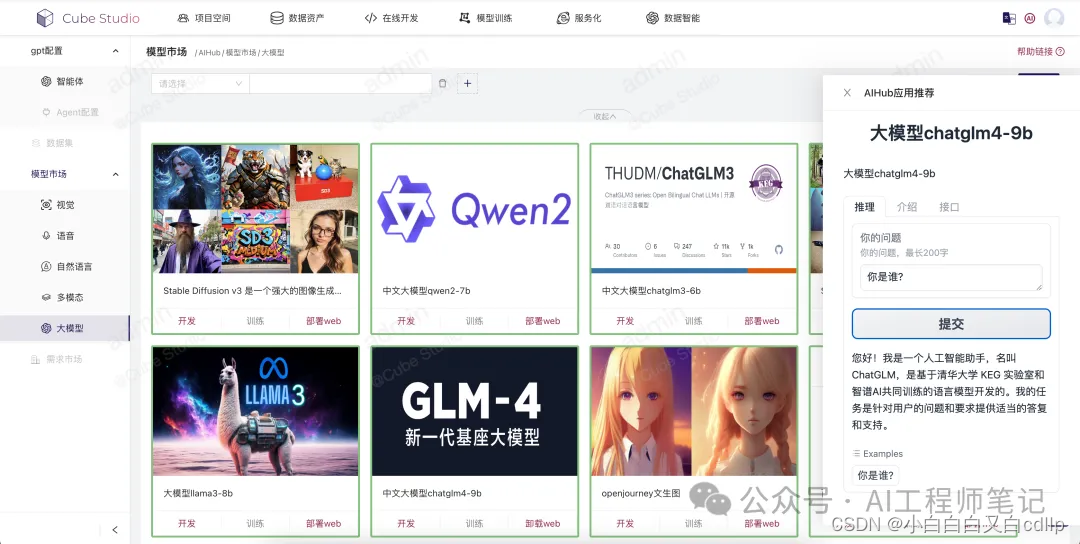

1. 支持AIHub形式部署40+常用开源大模型:

模型市场中已集成了40+常用开源大模型,包括chatglm4、llama3、qwen2、baichuan2、gemma等,还有openjourney、stable diffusion等文生图模型,并且支持开源模型一键部署,一键开发,一键微调,快速直观地感受大模型。

提示:除了大模型,另外还有400+开源图文音常规模型。

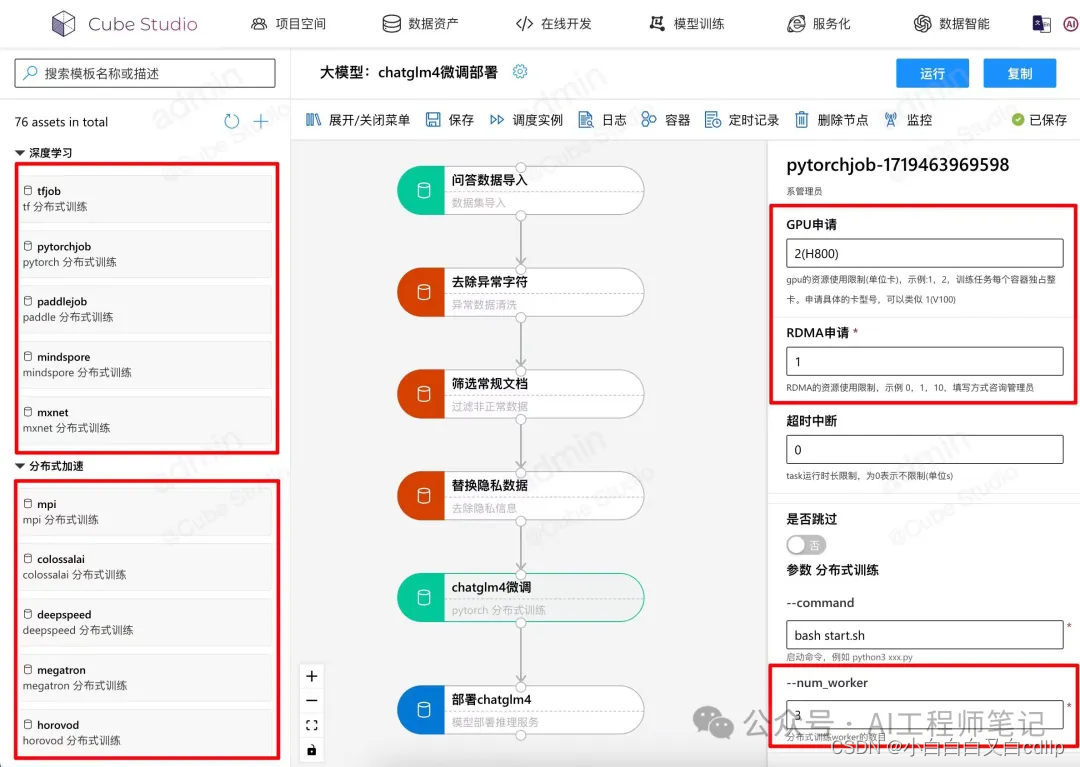

2. 多层次支持大模型训练微调技术栈:

• 支持tensorflow、pytorch、paddlejob、mindspore、mxnet等分布式多机多卡训练框架;

• 支持deepspeed、megatron、colossalai、horovod、mpi等分布式加速框架;

• 同时支持RDMA网络协议,可以使用底层IB交换机或roce网络;

• 硬件适配英伟达,以及海光、华为、寒武纪、天数智芯等国产设备,支持vgpu。

提示:除了多机多卡训练,也包含spark/ray/volcano等分布式计算框以及特征处理,文本处理,模型处理等环节。

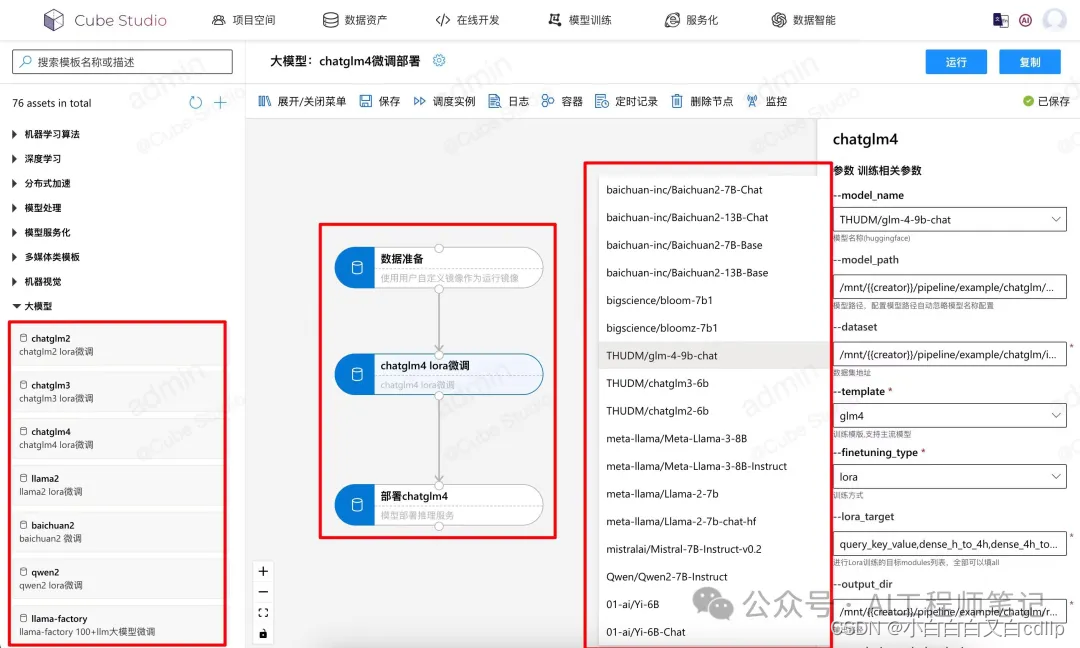

3. 支持自有数据集一键微调部署:

支持chatglm3、chatglm4、qwen2、baichuan2、llama3等一键微调,集成了llama factory 支持100+LLMs的微调方案;并支持自动发布为推理服务,vllm推理加速,形成openai流接口。

pipeline一键训练推理部署,非常适合不太熟悉大模型微调算法的同学,任务流完成后可以直接对接到其他的openai接口使用的产品中。

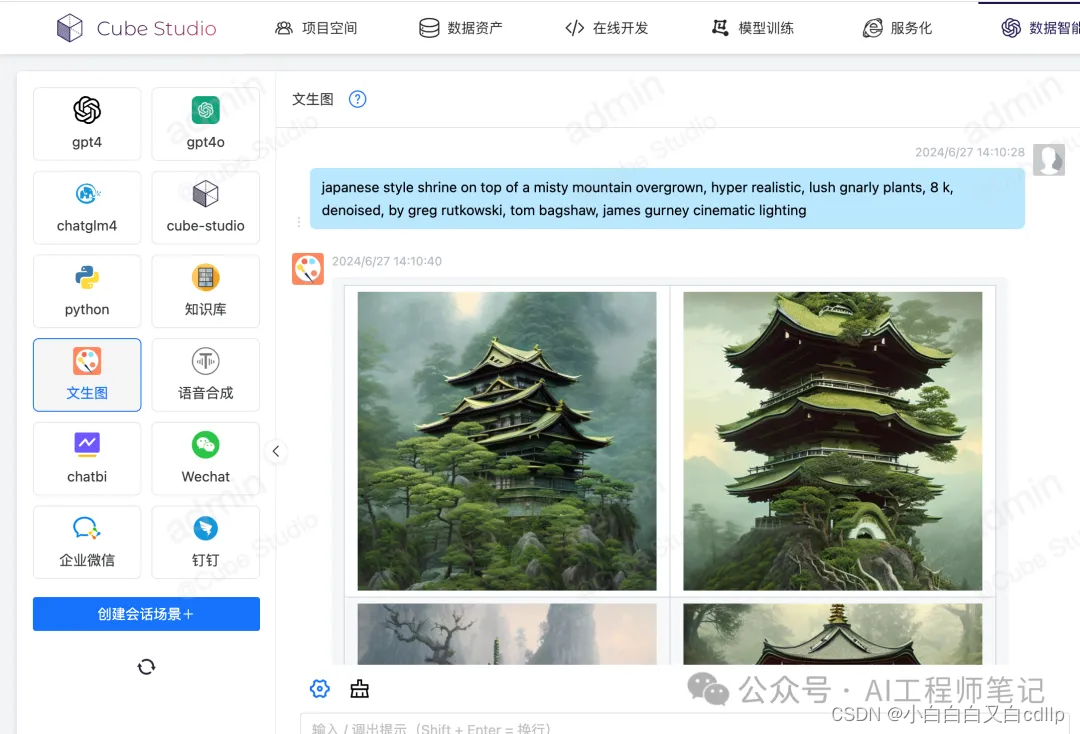

4. 通过智能体构建,构建智能人机交互

• 支持对接外部llm服务厂商接口

• 支持对接内部预训练模型或微调模型llm服务接口

• 支持通过prompt构建领域专家和添加私有知识库

• 支持文生图,语音多模态交互

• 支持支持对接企业oa软件机器人

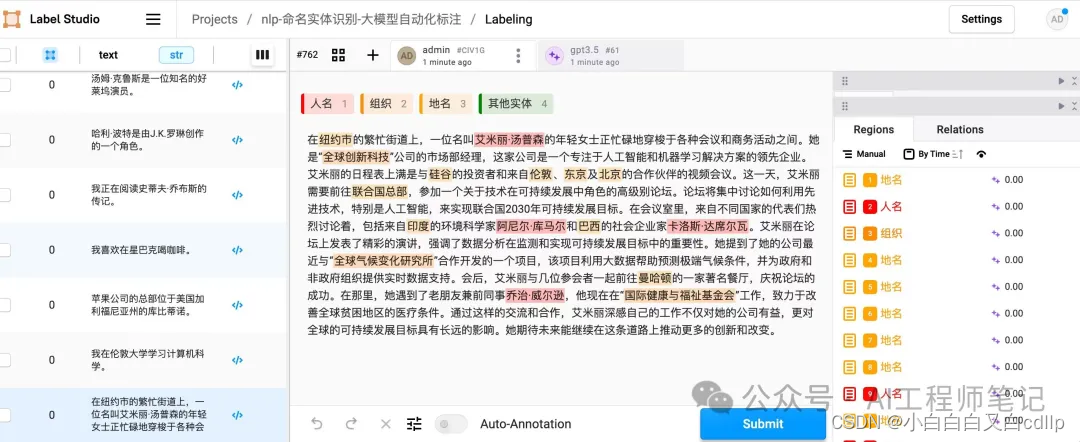

5. 大模型自动化标注

标注是AI中经常出现的任务,cube-studio中集成了开源标注平台label studio,支持图/文/音/多模态/大模型多种类型标注功能,用户管理,工作任务分发,对接数据集,支持标注数据导入;对接pipeline,支持标注结果自动化训练;对接aihub模型市场,支持自动化标注,只需将服务接口配置到label studio中,即可实现通过大模型来自动化标注。

提示:除了支持大模型的自动化标注,也支持普通模型图文音的自动化标注。

详细操作