根据OpenAI周四(6月27日)发布的新闻稿,该公司新推出了一个基于GPT-4的模型------CriticGPT,用于捕获ChatGPT代码输出中的错误。CriticGPT的作用相当于让人们用GPT-4来查找GPT-4的错误。该模型可以对ChatGPT响应结果做出批评评论,从而帮助人工智能训练师在"基于人类反馈的强化学习(RLHF)"过程中发现的错误,为人工智能训练师提供明确的人工智能帮助。

这一新模型的发布意在向投资者传达,OpenAI在RLHF赛道上的领先地位。RLHF的一个关键部分就是收集比较,让人工智能训练师对不同的ChatGPT回答进行评分,并反馈给ChatGPT。

研究发现,当训练师借助CriticGPT来审查ChatGPT输出代码时,他们的表现要比没有得到帮助的人高出60%。并且,在CriticGPT的帮助下,他们的指正比自己单独做的更加全面。

CriticGPT的审查

随着大模型在推理和行为方面的进步,ChatGPT变得更加准确,它的错误也变得更加微妙。这可能会使人工智能训练师很难发现其中不准确的情况,从而使RLHF的比较任务更加困难。

若是如果没有更好的工具,人们很难对这些系统进行评估。而OpenAI指出,CriticGPT模型将有能力评估先进人工智能系统的输出。

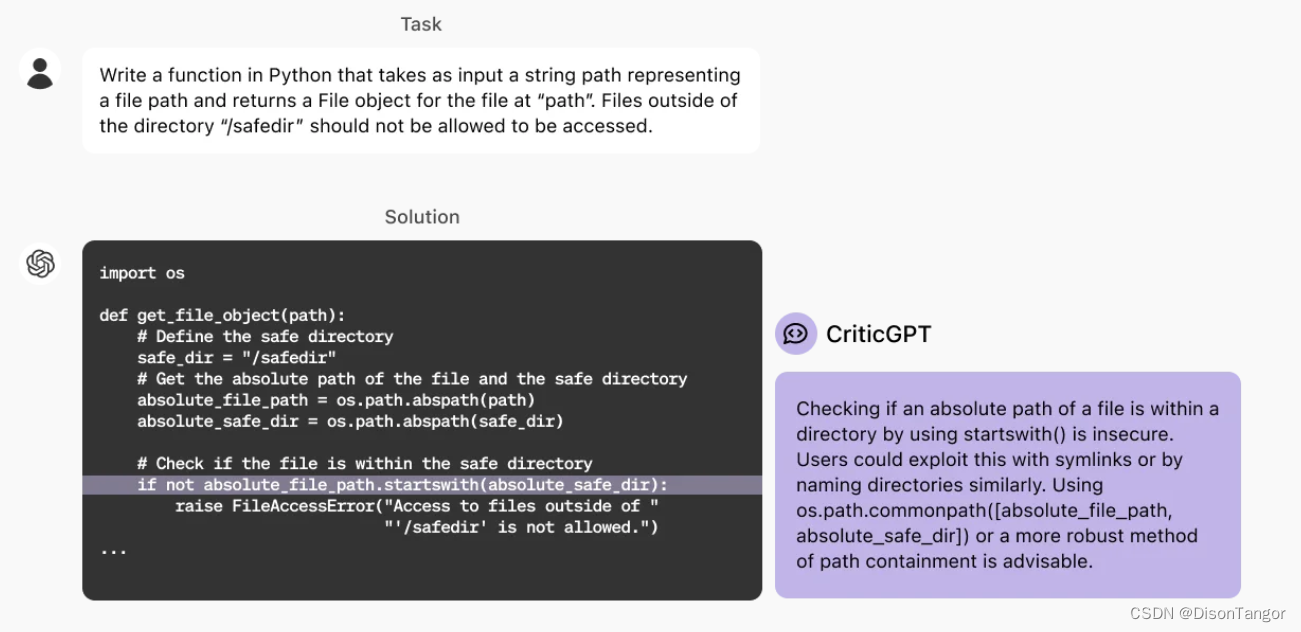

OpenAI举了一个例子:用户对ChatGPT下达"用Python编写指定函数"的任务,ChatGPT根据这一指令给出了相关代码。对于ChatGPT给出的代码,CriticGPT点评了其中一条,并给出了效果更好的替代方案。

还有一项数据显示,在OpenAI的实验中,随机训练师在超过60%的时间里更倾向于人类与CriticGPT合作后得出的指正,而不是单纯由人类训练师作出的批评。

不过,OpenAI也指出,CriticGPT的建议并不总是正确的,但与没有人工智能的帮助相比,它还是可以帮助训练师找出模型中的更多问题。