导读

2024年6月,GAITC 2024全球人工智能技术大会在杭州举办,在视觉大模型关键技术与应用主题论坛上,快手NLP专家林梓佳向参会者汇报了快手「快意」大模型研发过程中的多个关键技术创新,以及应用落地过程中的经验与挑战。

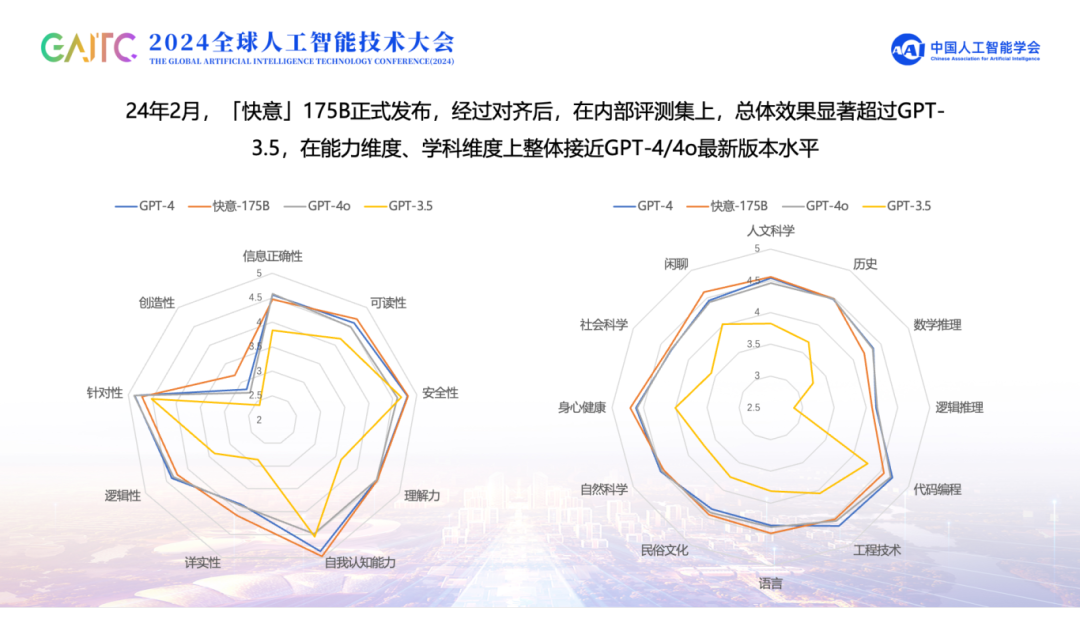

快手作为一家AI技术驱动的公司,紧跟AI时代浪潮,于2023年初启动「快意」大模型研发专项,大力投入研发大语言模型和多模态大模型。2024年2月底,快手发布了「快意」175B模型 。经过对齐后,在内部评测集上,无论是信息正确性、可读性、安全性等能力维度,还是人文科学、数学、逻辑推理等学科维度,都显著超过GPT-3.5,并整体接近GPT-4/4o最新版本水平。

快手「快意」大模型的成功研发,得益于快手在训练/推理框架、数据、算法、评测等环节的大力投入与务实创新。特别是在算法层面上,也有多项关键技术推动快手「快意」大模型不断发展。

「快意」大模型的八项关键技术创新

一、Temporal Scaling Law:直接在大模型上实现低成本的高效超参搜索

众所周知,影响大模型效果的超参非常多,包括数据配比、学习率、dropout等。为了减少超参搜索的成本,通常大模型超参的设定,是在小模型上先进行超参搜索,然后直接应用到大模型上。但已有研究工作表明,部分超参在小模型和大模型上的最优设置是截然不同的。因此,一个很自然的想法便是考虑在大模型上直接进行超参搜索,并通过训练少量的数据,结合loss预测技术,预测最终模型性能,并根据预测的性能选择最优超参。为此,「快意」大模型团队提出了Temporal Scaling Law的概念,研究大模型loss如何随着训练步骤的增加而演变。

经过初步实验,「快意」大模型团队发现,基于常见Scaling Law的幂律关系直接预测loss整体的粗粒度时序建模方式,预测误差偏高,效果不佳。因此,Temporal Scaling Law将预测过程拆分到每个token位置的loss,并通过观察发现,在不同参数规模的模型上,不同token位置的loss,随着位置(i)变化,整体服从动态倒数关系。从期望的角度看,位置越大的token,上文越多,在预测上会更加容易。而这里的"动态"指的是倒数关系中的参数a_0, a_1, a_2均会随着训练步数的增加而改变。

通过分析a_0, a_1, a_2随着训练步数的变化,可以发现其具备很强的可拟合性,并且呈现分段特性。因此,Temporal Scaling Law定义了分段函数的分界点N_{sep},并基于分界点为a_0, a_1, a_2引入了分段函数,用于拟合其随着训练步数N增加的变化。因此,一旦明确训练步数,便可以预测出a_0, a_1, a_2,进而根据动态倒数关系,得到每个位置的token loss,并通过平均,得到最终的整体loss,这便是Temporal Scaling Law的最终表达式。

而在预测阶段,由于只训练少量的数据,往往只能看到分段函数的第一段,为了得到最终的结果,可以通过分界点的定义预测其位置,并在分界点处,通过增加数值平滑的约束条件,推导出第二段函数的参数,进而可以得到完整的分段函数和最终的loss预测结果。经过实验验证,Temporal Scaling Law相比于以幂律关系等方式建模整体loss的方式,在预测loss方面误差显著降低。

而在实际应用方面,Temporal Scaling Law可以**以低成本方式,直接用于在大模型上进行更好的超参搜索。**以数据配比为例,可结合小模型搜索先圈定若干较好的候选,进而用Temporal Scaling Law直接在目标大模型上做进一步的选择,而从实验结果来看,Temporal Scaling Law选择的最优方案比小模型搜索得到的最优方案,在绝大多数benchmark上均表现更佳。此外,Temporal Scaling Law也有助于我们洞察大模型训练的内在机制。通过Temporal Scaling Law的公式,可以推导出,随着模型训练达到一定程度,各个位置的token loss整体下降幅度将趋于相同,从实验的观察来看,不同参数规模的模型也确实呈现出理论推导的结果。这意味着,虽然不同位置的token loss本身在预测难度上存在天然差异,但实际上学习进度相似,无需做额外的加权,这也验证了大模型训练的默认设置(即 不对token位置进行加权)的有效性。

二、MiLe Loss:预训练损失函数优化方案

在预训练阶段,不同token由于出现的频率不同,存在学习难易bias的问题,通常而言,出现频率高的token更易学,而频率低的token则学习难度更高一些。基于这样的观察,「快意」大模型在预训练阶段,改进了传统的交叉熵损失,提出了基于信息熵的加权损失优化方案MiLe Loss,并在多种参数规模的预训练模型上均取得显著效果提升。值得一提的是,MiLe Loss实现非常简单,但却能带来模型性能的全面提升。

三、Scaffold-BPE:词表学习方法改进

在大模型中,Tokenizer通常使用BPE(Byte-Pair-Encoding)算法,BPE通过自下而上逐步合并的方式学习词表,但在合并的过程中,可能出现"伪高频"token的情况,导致最终词表在训练语料上的压缩率偏低。例如,"zona"在大部分情况下只出现在"Arizona"中,所以当中间token "zona"与"Ari"合并成新的token "Arizona"之后,"zona" 作为独立token出现的频率显著降低,变成"伪高频" token。「快意」大模型团队提出的Scaffold-BPE词表学习方法,**通过在BPE的token合并过程中更新token频率,并将"伪高频"token放入优先队列的方式,将其逐步替换为更高频的token,**有效提升了词表压缩率和大模型的训练效果。Scaffold-BPE同样可用于提升机器翻译等传统NLP任务上。

四、引入SFT负反馈机制提升大模型生成优质回复概率

在对齐阶段,SFT(Supervised Fine-tuning)过程,通常仅使用正样本数据训练,但这种方式,难以解决重复生成、身份认知出错等问题。为此,「快意」大模型团队在SFT阶段,引入了负反馈机制,通过构造负样本,并与正样本进行比较的方式,提升了模型区分优劣回复的能力,从而有效减少重复文本等情况,显著提升了大模型生成优质回复的概率。

五、词汇单元并行解码策略:解码速度提升约30%

对齐之后,为了加速推理,「快意」大模型团队提出了词汇单元并行解码策略,在一次推理过程中,同时预测多个token,并自适应地选择其中置信度较低的部分,重新生成。经过实验,该方法可以在对解码效果无损的前提下,大幅提升解码速度约30%,有效扩大了模型服务的吞吐量。

六、Reward Model引入MoE:有效优化了对齐阶段的全流程

在对齐阶段的强化学习中,Reward Model的质量对强化学习的效果有至关重要的影响。为了解决Reward Model在通用场景下判别能力不高、泛化能力较差的问题,「快意」大模型团队在Reward Model上引入了MoE(Mixture-of-Expert)结构,并通过实验验证了该方法能够显著提升Reward Model的判别、泛化和抗遗忘能力。在「快意」大模型中,Reward Model不仅仅用在RLHF(Reinforcement Learning from Human Feedback)中,也应用在了SFT阶段的数据质量筛选等环节,有效优化了对齐阶段的全流程。

七、迭代式RLHF+RLAIF:提升策略探索和学习效率

在强化学习阶段,除了收集来自人类的反馈,「快意」大模型也收集了来自于「快意」175B、GPT-4等大模型的反馈,整合了RLHF和RLAIF,并且采用了RLHF+RLAIF->Reward Model->Policy Learning 的迭代式Pipeline来更新模型。在每一轮迭代中,人工反馈和大模型的反馈数据整合后,用于迭代Reward Model(防止reward hacking),进而用于指导PPO(Proximal Policy Optimization)和DPO(Direct Preference Optimization)的学习过程,提升强化学习策略探索和学习的效率。强化学习对「快意」大模型的安全性等方面带来了显著提升。

八、MoE路由错误自适应检测与Loss优化

「快意」大模型近期也在升级MoE结构,在研发过程中,「快意」大模型团队发现路由错误,会引发单expert内部的知识产生冲突,加大学习难度,导致最终MoE优化效果不理想。为了提升路由模块预测的准确性和解决上述路由错误导致的expert优化不理想问题,「快意」大模型团队提出了基于训练过程中token梯度分布的自适应错误检测策略,并基于检测的结果,提出了新的路由loss优化方案,最终在多个benchmark的实验上,验证了该方法的有效性。

「快意」大模型的落地实践

「快意」大模型自发布之后,迅速在快手的多个站内场景中落地,并取得了一系列的业务收益,包括评论区AI小快、对话式搜索、商业化短视频文案创作、营销智能Bot、B端和C端的内容理解等,充分验证了「快意」大模型的业务价值。以AI小快的落地为例,「快意」大模型在实践过程也遇到了一些挑战,同时提出了相应的解决方案。

AI小快的挑战与破局

AI小快是孵化自「快意」大模型的情感陪伴机器人,主要在快手App的评论区、私信等场景中上线,具备强大的多模态内容理解和人格化互动能力,从2023年底上线至今,6个月时间就积累了超过1千万的粉丝,日活用户超过150万。

着眼于用户,AI小快的技能跟随着用户需求而持续迭代发展,从目前的分析来看,用户与AI小快的互动中,占比较高的需求主要包括:情感陪伴类、视频内容理解类、闲聊类、知识与工具类等。AI小快在发展技能的过程中,遇到了如下几方面挑战,并通过技术攻关,找到了合适的解决方案。

挑战1:多模态内容理解能力要求高

AI小快作为开放领域的服务,而且在视频评论区中落地,用户会很自然地提问AI小快关于视频内容的相关问题,需要AI小快具备突出的多模态内容理解能力。借助于快意多模态大模型所提供的dense video captioning等能力,以及引入ASR(Automatic Speech Recognition)等辅助信息,AI小快捕获并整合了视频内容的关键信息,为有效回答用户关于视频内容的问题打下坚实基础。

挑战2:有趣、有温度的情感陪伴需求大

AI小快的核心定位是情感陪伴机器人,因此需要在人文关怀上表现优秀,要有趣,更要有温度。基于此,「快意」大模型团队,通过收集和构建大量的人物卡片信息,包括外在的年龄性别等特征,以及内在的人格特征等,在「快意」大模型上,**微调出人格化的情感陪伴大模型(KwaiYii-Role),**并基于对齐阶段的迭代式强化,让AI小快具备了显著的类人对话风格和情感表达能力。KwaiYii-Role的能力在权威评测榜单CharacterEval上也得到了充分验证,显著优于同赛道竞品,尤其在沟通技巧、表达多样性和共情能力等方面表现优秀。

挑战3:长轮次对话能力需提升

由于常见的对话训练语料,对话轮次在10次左右,很难直接用于训练AI小快使其具备超长轮次的对话能力。为此,「快意」大模型团队额外引入了**智能提问的用户模拟器(KwaiYii-Parrot),**并基于真实人人、人机对话日志对其进行训练,而后经过用户模拟器与AI小快的多轮交互,累计越来越长的对话日志,并通过数据清洗、增强等方式,同时更新用户模拟器与AI小快,逐步提升其对话轮次。最终,AI小快具备了与用户进行超过200轮对话的能力。

挑战4:多种工具能力需具备

在快手App的场景下,AI小快承载了用户的多种工具类需求,包括短视频推荐、时间查询、画图特效调用、新闻获取、知识问答等。而这些工具或能力,本身并非「快意」大模型所天然具备。因此,为了满足用户需求,「快意」大模型团队在微调「快意」大模型的基础上,研发了函数调用能力和检索增强能力,以便根据用户query调用站内外的工具,或者通过搜索引擎、知识图谱等获取时效性信息、社区信息等,有效延伸了「快意」大模型的能力边界。

得益于快手公司在内容、场景、基建等方面的优势,以及对大模型研发的大力投入,快手「快意」大模型以较短的周期,顺利完成从13B到175B的规模提升和能力升级,同时也在AI小快等多个应用场景中验证了业务价值,打开了大模型落地应用的新局面。未来,「快意」大模型团队,将持续围绕大模型技术创新、应用创新等方面,继续攻关迭代,推动「快意」大模型走向新的高度。

文章来源:快手大模型与多媒体技术部