大家好,我是木易,一个持续关注AI领域的互联网技术产品经理,国内Top2本科,美国Top10 CS研究生,MBA。我坚信AI是普通人变强的"外挂 ",所以专注于分享AI全维度知识,包括但不限于AI科普 ,AI工具测评 ,AI效率提升 ,AI行业洞察。关注我,AI之路不迷路,2024我们一起变强。

开源模型会越来越落后?百度,你再次被狠狠打脸了。

北美时间7月23日,Meta(原Facebook,脸书)公司正式官宣发布了开源模型Llama 3.1。不出意外的话,根据各项AI模型基准测试的结果来看,Llama 3.1将会成为史上最强大的开源LLM模型。Llama 3.1模型具备128K的上下文长度,支持八种语言,并推出了首个开放源码前沿级AI模型Llama 3.1 405B。作为首个开源的前沿级AI模型,Llama 3.1 405B在通用知识、可控性、数学、工具使用和多语言翻译等方面拥有最先进的能力,能与目前市场上最好的闭源模型相媲美,如GPT-4o和Claude 3.5 Sonnet。

Llama 3.1通过扩展上下文长度、增强推理能力和改进工具使用,能够支持高级应用如长文本摘要、多语言对话代理和编程助手。此外,Meta还注重该模型的开放性和可扩展性,鼓励开发者创建自定义代理和新型智能行为,同时配备了如Llama Guard 3和Prompt Guard等安全工具,以支持负责任的开发。

Llama 3.1的三种型号

和大多数AI模型一样,Llama 3.1也包含三种型号:405B、70B和8B,表示模型的参数量依次降低。这三档模型均支持128K上下文长度,增强了长文本处理和对话能力。

-

405B 型号 :这是

Llama 3.1系列的最强模型,具有最广泛的使用案例。它以4050亿参数成为目前参数量最大(参数量越大某种程度上意味着"智商"越高)的开源模型,适用于复杂的数学问题和多语言翻译等任务。 -

70B 型号 :高性能且性价比很高的中端模型,类似于

Claude 3系列中的Claude 3 Sonnet,能适用于多种使用案例。它在性能和成本之间取得了良好的平衡,非常适合需要强大但不及最大模型资源需求的应用。 -

8B 型号:轻量级且超高速,几乎可以在任何设备上运行。它特别适合资源受限的环境,仍能提供强大的语言处理能力。

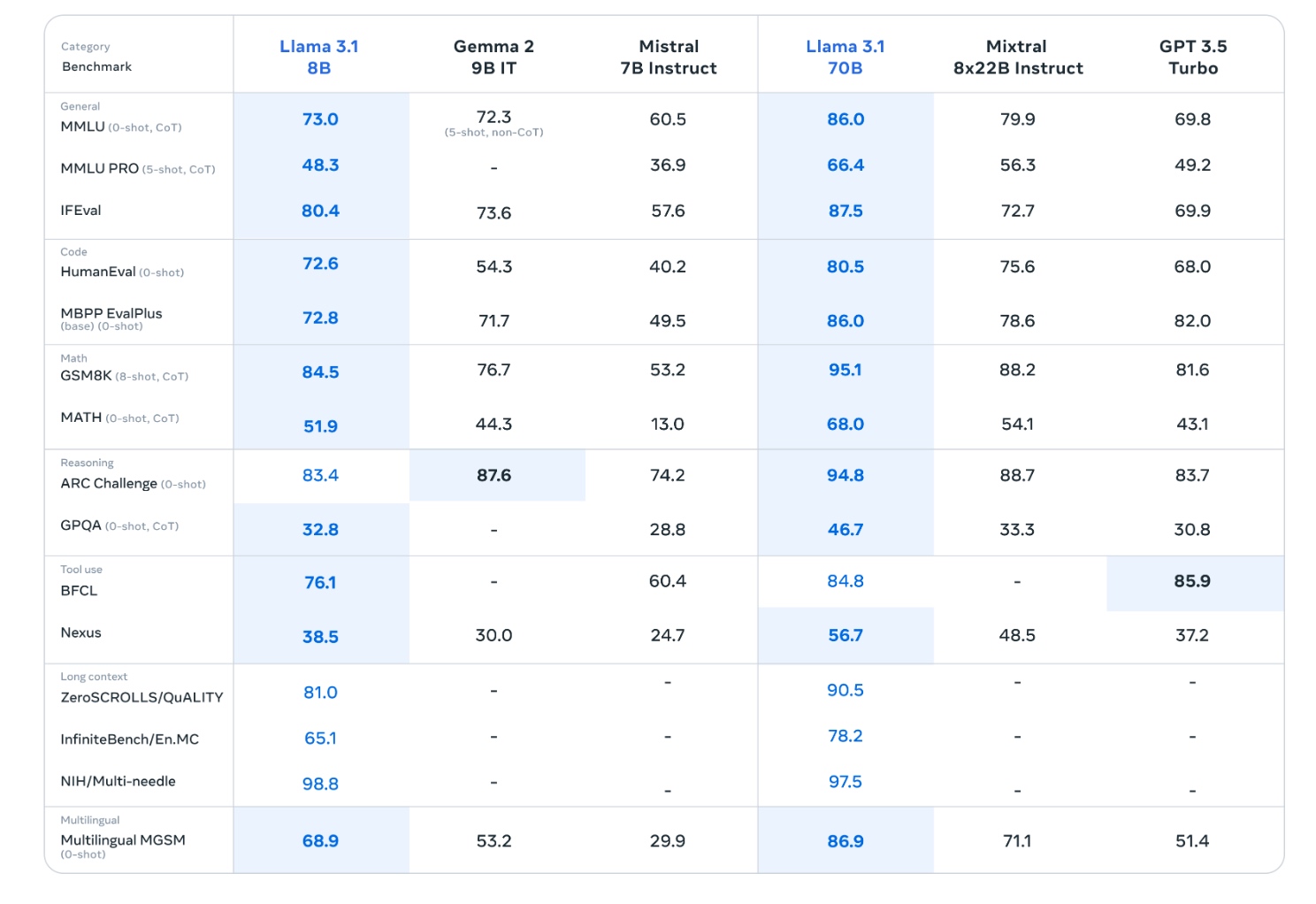

Llama 3.1基准测试结果

Llama 3.1 405B

Llama 3.1 405B模型在多个测试中表现优秀,在某些领域甚至超过了目前AI领域最强模型GPT-4o和Claude 3.5 Sonnet。

- 强项:

-

数学能力:在GSM8K测试中得分96.8,为所有模型中最高。

-

推理能力:ARC Challenge得分96.9,同样是最高分。

-

长文本处理:ZeroSCROLLS/QuALITY测试得分95.2,与

GPT-4持平,优于其他模型。 -

多语言能力:Multilingual MGSM测试得分91.6,与

Claude 3.5 Sonnet并列最高。

- 相对弱项:

-

GPQA测试得分51.1,低于

GPT-4 Omni和Claude 3.5 Sonnet。 -

Nexus测试得分58.7,虽然高于其他已测试模型,但分数相对较低。

- 通用能力:

-

MMLU和MMLU PRO测试中表现良好,分别得到88.6和73.3分。

-

IFEval测试得分88.6,与

Claude 3.5 Sonnet相当,高于其他模型。 -

HumanEval和MBPP EvalPlus测试中也有不错表现,分别得分89.0和88.6。

- 工具使用:

- BFCL测试得分88.5,表现不错但略低于

Claude 3.5 Sonnet。

- 特殊测试:

- NIH/Multi-needle测试得分98.1,虽然低于

GPT-4系列的满分,但仍然非常高。

Llama 3.1 405B模型在多个领域展现了强劲的性能,特别是在数学、推理和长文本处理方面。它在某些测试中甚至超过了其他知名闭源模型,展现出较为全面的能力。

Llama 3.1 8B

-

总体表现: 作为较小的模型,

Llama 3.1 8B在多个测试中表现出色,尤其考虑到其较小的参数规模。 -

强项:

-

数学能力:GSM8K 测试得分 84.5,表现优秀。

-

推理能力:ARC Challenge 得分 83.4,高于某些更大的模型。

-

长文本处理:ZeroSCROLLS/QuALITY 测试得分 81.0,显示出不错的长文本理解能力。

- 相对弱项:

-

GPQA 测试得分 32.8,相对较低。

-

Nexus 测试得分 38.5,虽然超过了一些竞争对手,但仍有提升空间。

- 通用能力:

-

MMLU 和 MMLU PRO 测试中表现尚可,分别得到 73.0 和 48.3 分。

-

IFEval 测试得分 80.4,显示出良好的通用理解能力。

- 特殊测试:

- NIH/Multi-needle 测试得分高达 98.8,表现非常出色。

Llama 3.1 70B

-

总体表现:

Llama 3.1 70B作为更大的模型,在几乎所有测试中都表现优异,经常超越其他模型,包括GPT 3.5 Turbo。 -

强项:

-

数学能力:GSM8K 测试得分 95.1,大幅领先其他模型。

-

推理能力:ARC Challenge 得分 94.8,表现卓越。

-

长文本处理:ZeroSCROLLS/QuALITY 测试得分 90.5,展现出强大的长文本理解能力。

-

多语言能力:Multilingual MGSM 测试得分 86.9,远超其他模型。

- 相对弱项:

-

GPQA 测试得分 46.7,虽然领先于表格中的其他模型,但仍有提升空间。

-

Nexus 测试得分 56.7,虽然高于其他模型,但相对于自身其他测试结果略显逊色。

- 通用能力:

-

MMLU 和 MMLU PRO 测试中表现优秀,分别得到 86.0 和 66.4 分,领先其他模型。

-

IFEval 测试得分 87.5,展现出强大的通用理解能力。

-

HumanEval 和 MBPP EvalPlus 测试中表现出色,分别得分 80.5 和 86.0。

- 特殊测试:

- NIH/Multi-needle 测试得分 97.5,虽略低于 8B 版本,但仍然非常出色。

Llama 3.1 70B 模型在几乎所有测试中都展现出卓越的性能,显著优于其 8B 版本,并在多个领域超越了包括 GPT 3.5 Turbo 在内的其他模型。它展示了强大的全面能力,特别是在数学、推理、长文本处理和多语言任务方面。

如何体验Llama 3.1 405B?

结语

Llama 3.1模型其实早在几天前,就因为消息泄露而引起了很多关注。今天正式发布后,更是以其强大的性能技惊全场。感兴趣的朋友不妨一试。

精选推荐

关于Meta AI的Llama系列的更多文章,请看这里。

都读到这里了,点个赞鼓励一下吧,小手一赞,年薪百万!😊👍👍👍。关注我,AI之路不迷路,原创技术文章第一时间推送🤖。