当代理IP在爬虫中频繁掉线时,我们先要了解出现问题的可能原因,这不仅限于技术性因素,还涉及操作策略和环境因素。只有在找到具体原因后,才能针对问题类型从源头解决IP掉线问题。

一、问题原因:

1. 代理IP质量问题导致的掉线:

- 低质量或免费代理IP:由于自己选择的IP代理商对代理IP维护不足、来源不明或被检测与他人共享IP,导致在爬虫时网络稳定性差,容易掉线。

2. 连接超时导致的掉线:

- 并发请求过多:过多的并发请求会使得IP代理服务器的响应时间延迟,导致连接超时和掉线,或者当目标网站的响应时间过长时,代理IP也会掉线。

3. 代理服务器故障导致的掉线:

- 服务器崩溃或停机:如果代理服务器本身出现故障无法使用,那么代理IP失效即会掉线。

4. 网络信号不稳定导致的掉线:

- 客户端、代理服务器或目标服务器之间的网络信号不稳定:不稳定的网络连接会导致代理IP使用失败,在爬虫前要检查自己的网络信号是否稳定。

5. 代理IP过期导致的掉线:

- 代理IP有效期限到:如果使用代理IP时已经超过有效期限,那便无法继续使用,会导致爬虫中断,记得检查自己是不是该续费了。

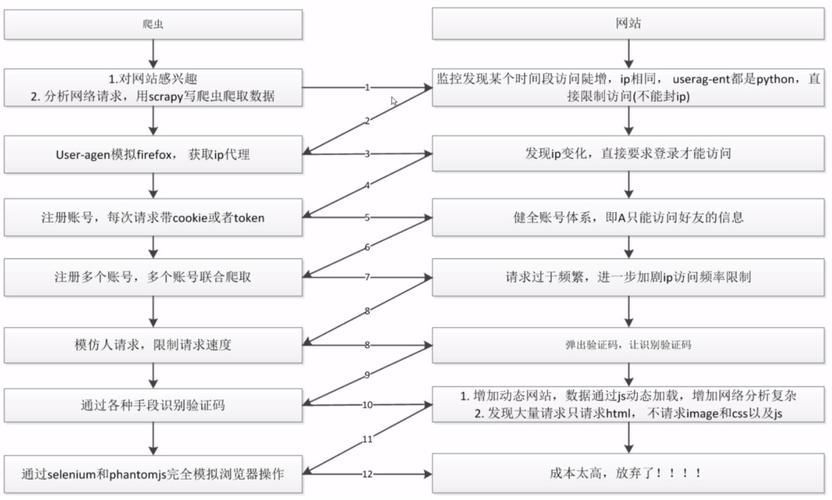

6. 代理IP被反爬虫策略限制导致的掉线:

- 目标网站的反爬虫策略:大部分网站比如TikTok、Google等会设置严格的爬虫检测程序,包括IP封锁、验证码验证等措施,可能会检测到并限制代理IP的访问,导致使用时突然掉线。

二、解决方法

1. 选择高质量的代理IP服务商:

建议选择信誉良好、稳定可靠的代理服务商,避免使用低质量或免费的代理服务,这些服务商通常会定期维护和更新IP池,确保提供稳定且纯净的IP地址。比如我一直在用的IPFoxy,它有大量且独立的动态IP可以挑选,能保证爬虫期间不被检测掉线,还有针对爬虫用户的免费试用额度,算是比较稳定可靠的服务器,

2. 合理控制并发请求数量:

注意对爬虫程序的并发请求进行限制,避免给IP代理服务器和目标服务器造成过大的负载压力,从而提高代理IP的稳定性和可用性。

3. 定期监控代理IP和服务器状态:

监测代理IP的可用性和服务器运行状态,发现问题时及时切换到可用的代理IP或服务器,以确保爬虫程序持续运行。记得定期更新和替换过期的代理IP,确保使用的代理IP在有效期,避免用到一半代理IP过期而导致的爬虫中断,功亏一篑。

4. 确保稳定的网络连接:

使用稳定、高质量的网络运行Python代码,避免在信号不佳或不稳定的网络环境下进行爬取操作,以减少代理IP连接失败的概率。

5. 模拟真实用户行为:

可以使用随机化的User-Agent头部、模拟鼠标点击和随机浏览页面等技术手段,使爬虫行为更接近真实用户,从而降低被反爬虫策略检测到的可能性。

总结

感谢你看到这里,希望你通过这篇文章了解到自己做爬虫时代理IP掉线的原因,并采取以上解决方法,能有效减少代理IP在爬虫过程中频繁掉线的问题,提高爬虫的稳定性和效率。