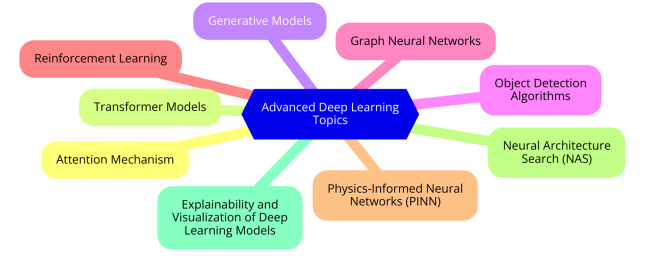

注意力机制、Transformer模型(BERT、GPT-1/2/3/3.5/4、DETR、ViT、Swin Transformer等)、生成式模型(变分自编码器VAE、生成式对抗网络GAN、扩散模型Diffusion Model等)、目标检测算法(R-CNN、Fast R-CNN、Faster R-CNN、YOLO、SDD等)、图神经网络(GCN、GAT、GIN等)、强化学习(Q-Learning、DQN等)、深度学习模型可解释性与可视化方法(CAM、Grad-CAM、LIME、t-SNE等)的基本原理及Python代码实现方法。

|-----------------------------------------------------|--------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| 第一章 注意力(Attention)机制 | **1、注意力机制的背景和动机(**为什么需要注意力机制?注意力机制的起源和发展里程碑)。 **2、注意力机制的基本原理(**什么是注意力机制?注意力机制的数学表达与基本公式、用机器翻译任务带你了解Attention机制、如何计算注意力权重?) **3、注意力机制的主要类型:**键值对注意力机制(Key-Value Attention)、自注意力(Self-Attention)与多头注意力(Multi-Head Attention)、Soft Attention 与 Hard Attention、全局(Global)与局部(Local)注意力 **4、注意力机制的优化与变体:**稀疏注意力(Sparse Attention)、自适应注意力(Adaptive Attention)、动态注意力机制(Dynamic Attention)、跨模态注意力机制(Cross-Modal Attention) 5、注意力机制的可解释性与可视化技术:注意力权重的可视化(权重热图) 6、案例演示 7、实操练习 |

| 第二章 自然语言处理(NLP)领域的Transformer模型 | 1、Transformer模型的提出背景( 从RNN、LSTM到注意力机制的演进、Transformer模型的诞生背景及其在自然语言处理和计算视觉中的重要性) 2、Transformer模型的进化之路(RCTM→RNN Encoder-Decoder→Bahdanau Attention→Luong Attention→Self Attention) 3、Transformer模型拓扑结构(编码器、解码器、多头自注意力机制、前馈神经网络、层归一化和残差连接等) 4、Transformer模型工作原理(输入数据的Embedding、位置编码、层规范化、带掩码的自注意力层、编码器到解码器的多头注意力层、编码器的完整工作流程、解码器的完整工作流程、Transformer模型的损失函数) 5、BERT模型的工作原理(输入表示、多层Transformer编码器、掩码语言模型MLM、下一句预测NSP) 6、GPT系列模型(GPT-1 / GPT-2 / GPT-3 / GPT-3.5 / GPT-4)的工作原理(单向语言模型、预训练、自回归生成、Zero-shot Learning、上下文学习、RLHF人类反馈强化学习、多模态架构) 7、案例演示 8、实操练习 |

| 第三章 计算视觉(CV)领域的Transformer模型 | **1、ViT模型(**提出的背景、基本架构、与传统CNN的比较、输入图像的分块处理、位置编码、Transformer编码器、分类头、ViT模型的训练与优化、ViT模型的Python代码实现) **2、Swin Transformer模型(**提出的背景、基本架构、与ViT模型的比较、分层架构、窗口机制、位置编码、Transformer编码器、模型的训练与优化、模型的Python代码实现) **3、DETR模型(**提出的背景、基本架构、与RCNN、YOLO系列模型的比较、双向匹配损失与匈牙利匹配算法、匹配损失与框架损失、模型的训练与优化、模型的Python代码实现) 4、案例演示 5、实操练习 |

| 第四章 生成式模型 | 1、变分自编码器VAE(自编码器的基本结构与工作原理、降噪自编码器、掩码自编码器、变分推断的基本概念及其与传统贝叶斯推断的区别、VAE的编码器和解码器结构及工作原理)。 **2、生成式对抗网络GAN(**GAN提出的背景和动机、GAN的拓扑结构和工作原理、生成器与判别器的角色、GAN的目标函数、对抗样本的构造方法)。 3、扩散模型Diffusion Model(扩散模型的核心概念?如何使用随机过程模拟数据生成?扩散模型的工作原理)。 4、跨模态图像生成DALL.E(什么是跨模态学习?DALL.E模型的基本架构、模型训练过程)。 5、案例演示 6、实操练习 |

| 第五章 自监督学习模型 | 1、自监督学习的基本概念(自监督学习的发展背景、自监督学习定义、与有监督学习和无监督学习的区别) 2、经典的自监督学习模型的基本原理、模型架构及训练过程(对比学习: SimCLR、MoCo;生成式方法:AutoEncoder、GPT;预文本任务:BERT掩码语言模型) 3、自监督学习模型的Python代码实现 4、案例演示 5、实操练习 |

| 第六章 目标检测算法 | 1、目标检测任务与图像分类识别任务的区别与联系。 **2、两阶段(Two-stage)目标检测算法:**R-CNN、Fast R-CNN、Faster R-CNN(RCNN的工作原理、Fast R-CNN和Faster R-CNN的改进之处 )。 **3、一阶段(One-stage)目标检测算法:**YOLO模型、SDD模型(拓扑结构及工作原理)。 4、案例演示 5、实操练习 |

| 第七章 图神经网络 | 1、图神经网络的背景和基础知识(什么是图神经网络?图神经网络的发展历程?为什么需要图神经网络?) 2、图的基本概念和表示(图的基本组成:节点、边、属性;图的表示方法:邻接矩阵;图的类型:无向图、有向图、加权图)。 3、图神经网络的工作原理(节点嵌入和特征传播、聚合邻居信息的方法、图神经网络的层次结构)。 4、图卷积网络(GCN)的工作原理。 **5、图神经网络的变种和扩展:图注意力网络(GAT)、图同构网络(GIN)、图自编码器、图生成网络。 6、案例演示 7、实操练习 |

| 第八章 强化学习 | 1、强化学习的基本概念和背景(什么是强化学习?强化学习与其他机器学习方法的区别?强化学习的应用领域有哪些? 2、Q-Learning(马尔可夫决策过程、Q-Learning的核心概念、什么是Q函数?Q-Learning的基本更新规则)。 3、深度Q网络(DQN)(为什么传统Q-Learning在高维或连续的状态空间中不再适用?如何使用神经网络代替Q表来估计Q值?目标网络的作用及如何提高DQN的稳定性?) 4、案例演示 5、实操练习 |

| 第九章 物理信息神经网络 (PINN) | 1、物理信息神经网络的背景(物理信息神经网络(PINNs)的概念及其在科学计算中的重要性、传统数值模拟方法与PINNs的比较) 2、PINN工作原理:物理定律与方程的数学表达、如何将物理定律嵌入到神经网络模型中?PINN的架构(输入层、隐含层、输出层的设计)、物理约束的形式化(如何将边界条件等物理知识融入网络?)损失函数的设计(数据驱动与物理驱动的损失项) 3、 案例演示 4、实操练习 |

| 第十章 神经架构搜索(Neural Architecture Search, NAS) | 1、NAS的背景和动机(传统的神经网络设计依赖经验和直觉,既耗时又可能达不到最优效果。通过自动搜索,可以发现传统方法难以设计的创新和高效架构。) 2、 NAS的基本流程:搜索空间定义(确定搜索的网络架构的元素,如层数、类型的层、激活函数等。)、搜索策略(**随机搜索、贝叶斯优化、进化算法、强化学习等)、性能评估 3、 NAS的关键技术:进化算法(通过模拟生物进化过程,如变异、交叉和选择,来迭代改进网络架构)、强化学习(使用策略网络来生成架构,通过奖励信号来优化策略网络)、贝叶斯优化(利用贝叶斯方法对搜索空间进行高效的全局搜索,平衡探索和利用) 4、 案例演示 5、实操练习 |

| 第十一章 深度学习模型可解释性与可视化方法 | 1、什么是模型可解释性?为什么需要对深度学习模型进行解释? 2、可视化方法有哪些(特征图可视化、卷积核可视化、类别激活可视化等)? 3、类激活映射CAM(Class Activation Mapping)、梯度类激活映射GRAD-CAM、局部可解释模型-敏感LIME(Local Interpretable Model-agnostic Explanation)、等方法原理讲解。 4、t-SNE的基本概念及使用t-SNE可视化深度学习模型的高维特征。 5、案例演示 6、实操练习 |

| 第十二章 总结 | 1、相关资料分享与拷贝(图书推荐等) |