**注意力特征融合AFF,**一种在深度学习领域被广泛应用的先进技术,通过结合注意力机制和特征融合,可以显著提升模型的泛化能力和性能。

拿其中关键的多尺度通道注意力模块MS-CAM来说,注意力特征融合利用MS-CAM兼顾global feature和local feature,通过注意力机制对特征进行加权平均,引导模型关注重要的信息,然后再融合,这样就能实现更高精度。

因此这种技术比起传统特征融合更适用于多种CV任务,而且已经成了我们论文涨点的常用方法, 关于AFF的研究只多不少。为了方便大家找灵感写论文,我整理了10个最新的AFF相关方案,全部开源有代码。

论文原文+开源代码需要的同学看文末

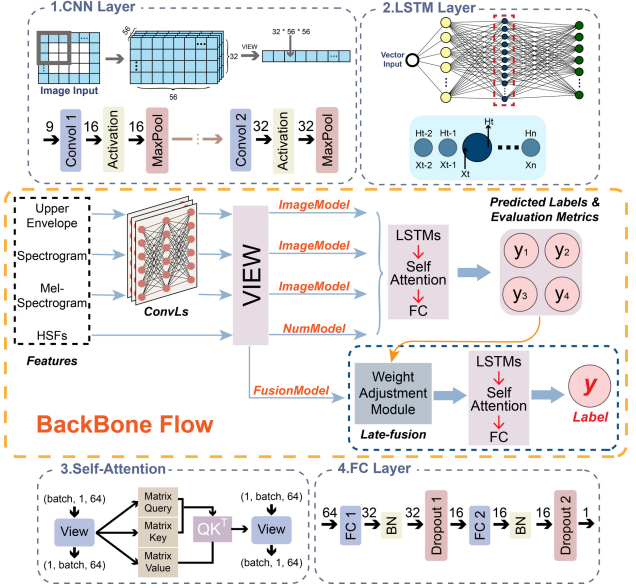

Attention-based acoustic feature fusion network for depression detection

**方法:**论文提出了一种基于注意力机制的声学特征融合网络,用于检测抑郁症。ABAFnet结合了四种不同的声学特征到一个综合的深度学习模型中,有效地整合和融合了多层次的特征。作者还提出了一种新颖的权重调整模块,用于后期融合,通过有效地综合这些特征来提升性能。

创新点:

-

ABAFnet 集成了一个基于注意力的多特征融合机制,这提高了模型在处理序列数据时的性能。

-

ABAFnet 中的权重调整模块(WAM)动态地调整每个特征的权重,优化它们对模型性能的贡献。

-

ABAFnet 利用晚期融合策略,结合并优化多个特征以改进抑郁症检测。

-

ABAFnet 的全面特征提取能力有效地剖析并利用了与抑郁症相关的高维信号中的相关频谱特征。

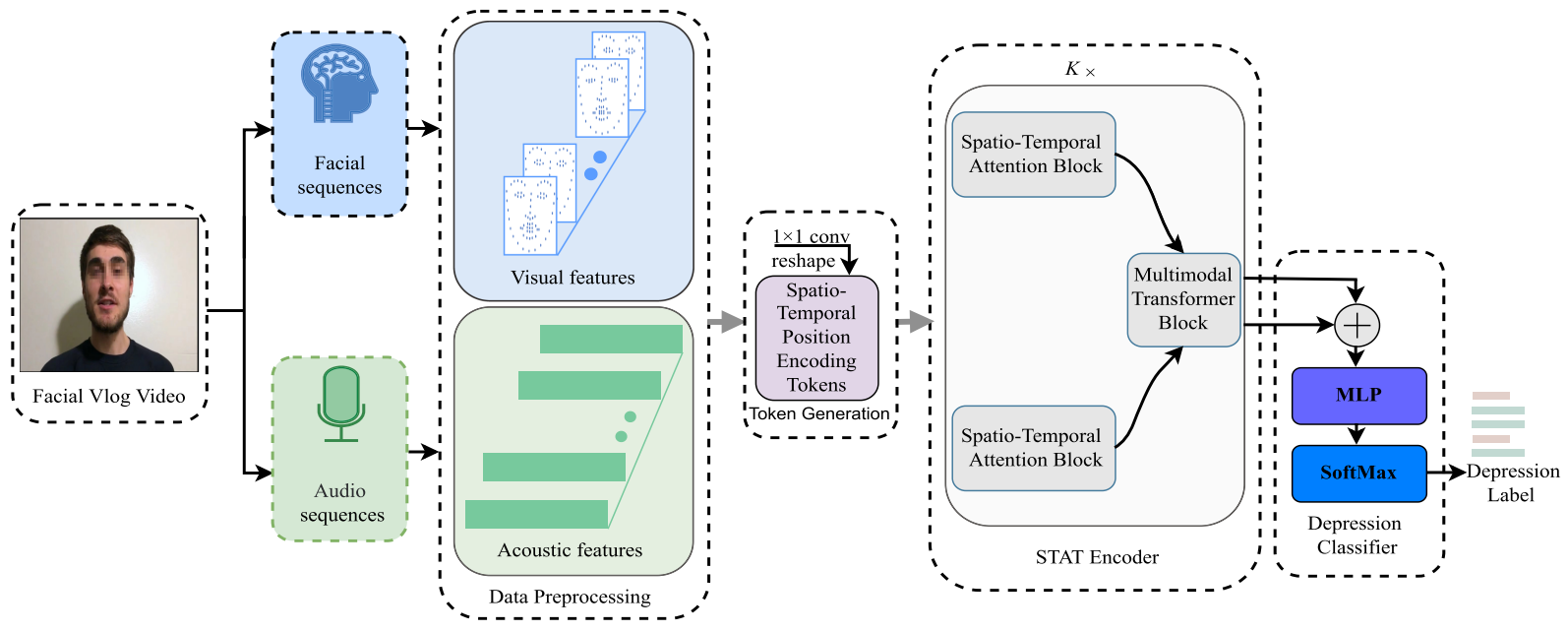

DepMSTAT: Multimodal Spatio-Temporal Attentional Transformer for Depression Detection

**方法:**论文提出了一种基于注意力机制的特征融合技术DepMSTAT。DepMSTAT框架利用了注意力机制来捕捉视频流数据中的时空特征,并通过多模态特征的早期融合策略,提高了抑郁症检测的准确性。

创新点:

-

提出了一种轻量级的多模态时空注意力Transformer方法来检测抑郁症。该方法能够从面部和语音数据中提取和融合时空信息,并通过投票分类器进行抑郁症的检测。

-

基于DepMSTAT模型提出了STAT模块,用于提取面部和语音数据的时空特征。该模块包括空间注意力块(SAB)和时间注意力块(TAB),以及多模态融合Transformer块(MTB)用于融合特征。

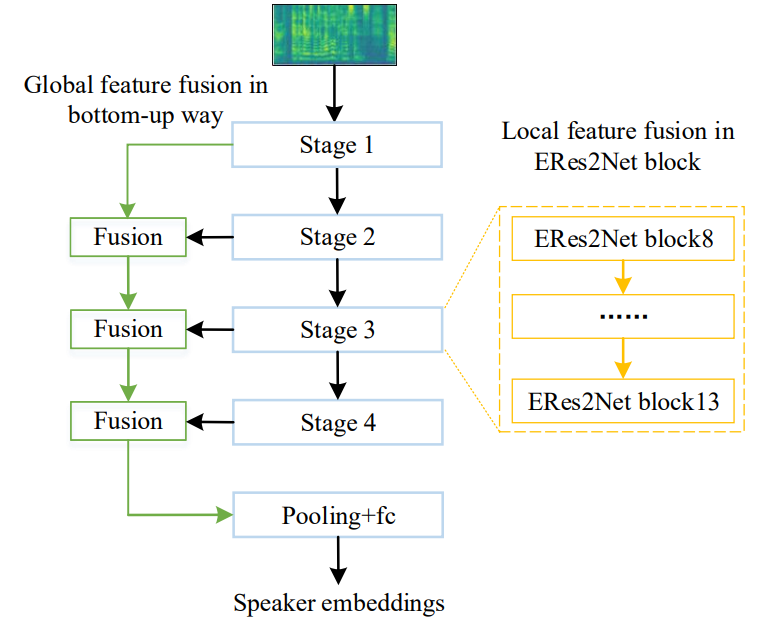

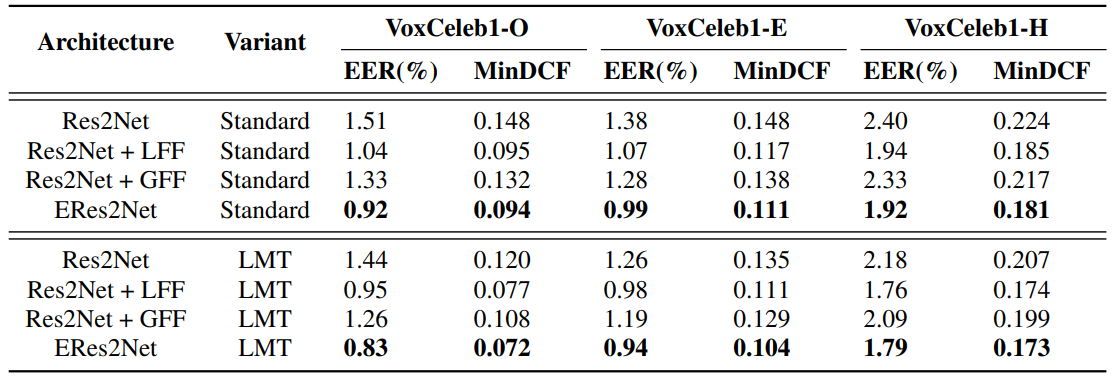

An enhanced res2net with local and global feature fusion for speaker verification

**方法:**论文提出了一种改进的 Res2Net(ERes2Net)架构,它结合了局部特征融合和全局特征融合技术,以及一个注意力机制模块,用于改善说话人验证的性能。实验结果表明,ERes2Net在说话人验证任务中取得了更好的性能,且参数更少。

创新点:

-

提出了一种名为ERes2Net的新型架构,通过局部特征融合和全局特征融合技术,改善了说话人验证的性能。

-

引入了注意力特征融合模块,用于有效地在局部和全局特征融合中进行特征融合,替代了简单的求和或连接操作。

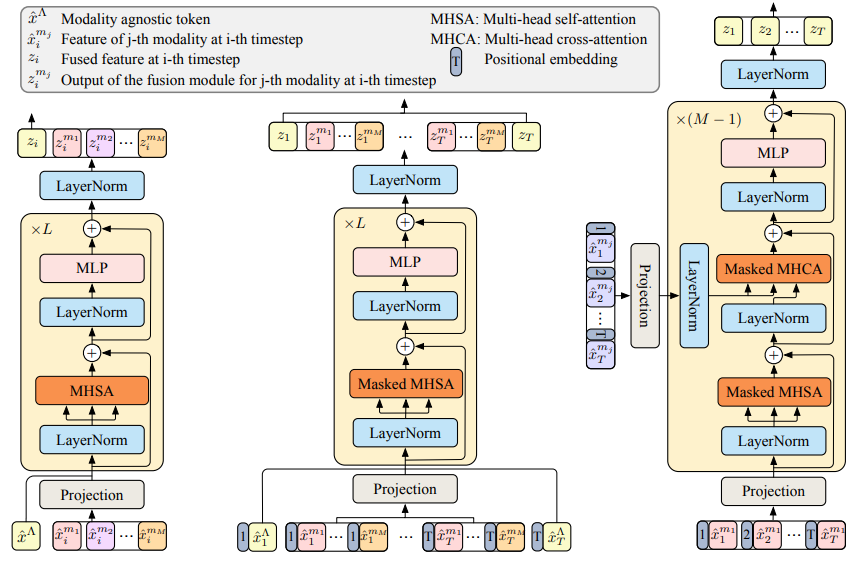

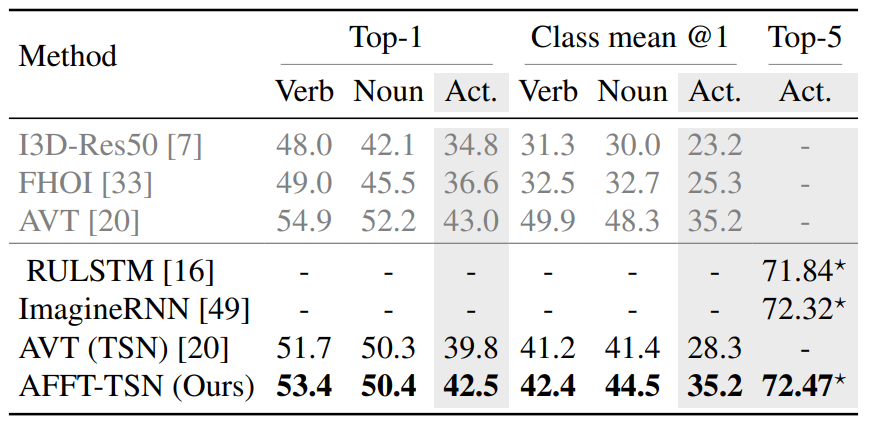

Anticipative Feature Fusion Transformer for Multi-Modal Action Anticipation

**方法:**论文提出了一种基于注意力机制的多模态特征融合技术,称为 Anticipative Feature Fusion Transformer。这项技术用于多模态动作预测任务,旨在通过结合来自不同模态(如视觉、音频等)的数据来提高动作预测的准确性。

创新点:

-

提出了Anticipative Feature Fusion Transformer (AFFT),成功地对提取的特征进行中级融合,明显改进了基于评分融合方法,并在EpicKitchens-100动作预测任务中提供了最先进的性能。

-

引入了音频视觉学习,将音频视为动作预测的补充信息来源,并在动作预测任务中取得了显著的改进。

关注下方《学姐带你玩AI》🚀🚀🚀

回复"AFF新"获取全部论文+开源代码

码字不易,欢迎大家点赞评论收藏