LayTextLLM

Paper : A Bounding Box is Worth One Token Interleaving Layout and Text in a Large Language Model for Document Understanding

Author : Jinghui Lu, Haiyang Yu, Yanjie Wang, Yongjie Ye, Jingqun Tang, Ziwei Yang, Binghong Wu, Qi Liu, Hao Feng, Han Wang, Hao Liu, Can Huang

Affiliation :ByteDance Inc,Fudan University

Code :https://github.com/LayTextLLM/LayTextLLM

将边界框映射到单个嵌入中,并将其与文本交错排列

0 背景

基于现有 LLM 构建文本敏感的多模态大型语言模型 (MLLM) 的努力,特别是增强视觉丰富文档理解 (VRDU) ,已经取得了重大进展 。尽管现有的 MLLM 在文档理解方面显示出良好的效果,但它们经常遇到与图像分辨率相关的挑战。当输入图像的分辨率较低时,图像太模糊,无法有效提取视觉特征。相反,高分辨率图像需要额外的计算资源来捕获详细的文本信息 。

同时,另一项研究使用现成的 OCR 工具来提取文本和空间布局,然后将其与 LLM 相结合以解决 VRDU 任务。这些方法假设文档理解的最有价值的信息可以从文本及其空间布局中获得,将空间布局视为"轻量级视觉信息"。基于这一前提,几项研究探索了将空间布局与文本相结合用于 LLM 的各种方法,取得了与 MLLM 相媲美甚至超越 MLLM 的结果。

0.1 动机

整合布局信息最自然的方法是将空间布局视为 token,这样可以将文本和布局无缝交织成统一的文本序列。 例如,Perot 等人使用"HARRISBURG 78|09"等格式来表示 OCR 文本和相应的布局,其中"HARRISBURG"是 OCR 文本,"78|09"分别表示水平和垂直坐标的平均值。同样,He 等人使用"[x_min, y_min, x_max, y_max]"来表示布局信息。这些方法可以有效地利用 LLM 的自回归特性,被称为"坐标作为 token"方案。相比之下,DocLLM 通过解开的空间注意机制探索与文本交互的空间布局,该机制可以捕获文本和布局模态之间的交叉对齐。

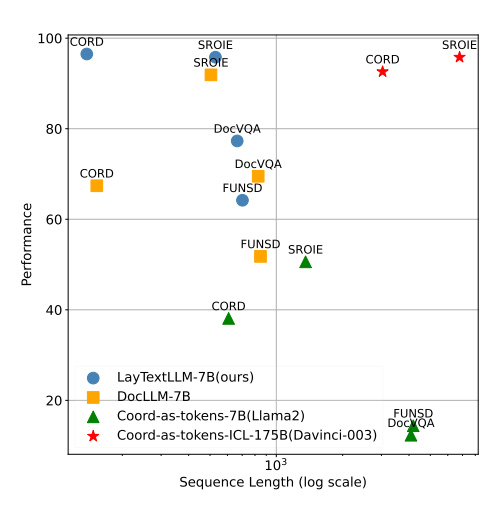

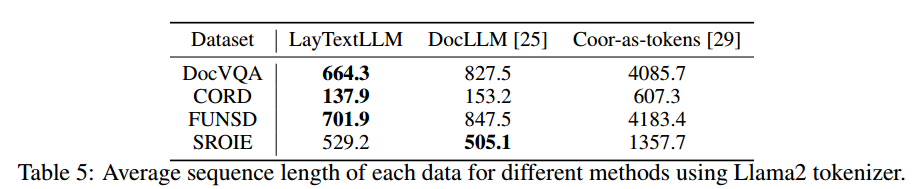

然而,作者认为,上述两种方法都有局限性。如图 1 所示,将坐标作为 token 显著增加了 token 的数量。此外,为了准确理解坐标并增强零样本能力,该方案通常需要少样本上下文演示和大规模语言模型,例如 ChatGPT Davinci003 (175B) ,这加剧了与序列长度和 GPU 资源需求相关的问题。同时,尽管 DocLLM 不会增加序列长度并通过注意力机制整合空间布局,但其通用性有限。作者认为 DocLLM 中的空间交叉注意力机制和掩蔽跨度任务不能充分利用 LLM 的自回归特性。

为了解决这些问题,本文探讨了一种简单而有效的方法来增强空间布局和文本之间的交互------用于文档理解的大型语言模型中的布局和文本交错(LayTextLLM)。遵循将任何模态与文本交错的常见做法 ,作者专门将这一原则应用于空间布局。具体来说,作者将每个边界框映射到单个嵌入,然后将其与其对应的文本交错。然后,作者提出了一个量身定制的预训练任务------布局感知的下一个标记预测------一个完全自监督的任务,它在不使用合成数据的情况下增强了布局和文本模态之间的一致性。 最后,通过提出的 Shuffled-OCR 监督微调,LayTextLLM 显着提高了下游文档相关的 VQA 和 KIE 任务的性能。如图 1 所示,LayTextLLM 的表现明显优于 175B 模型,而与 DocLLM 相比,序列长度仅略有增加甚至减少。作者的贡献可以列举如下:

- 作者提出使用 LayTextLLM 进行文档理解。据作者所知,这是第一项采用统一嵌入方法(第 3.1.1 节)的工作,该方法将空间布局直接与 LLM 中的文本数据交织在一起。通过用一个标记表示每个边界框,LayTextLLM 有效地解决了由坐标作为标记带来的序列长度问题,同时充分利用自回归特征来增强文档理解。

- 作者提出了两个量身定制的训练任务:(1)布局感知下一个标记预测(第 3.2.1 节),这是一项完全自监督的训练任务,用于增强布局和 2 个文本模态之间的一致性;(2)Shuffled-OCR 监督微调任务(第 3.2.2 节),以更好地引出模型在下游任务中的通用性。

- 综合实验结果定量表明,LayTextLLM 在零样本场景中的表现显著优于之前最先进的 (SOTA) 无 OCR MLLM,尤其是在 KIE 任务中,提升了 27.0%。此外,作者说明 LayTextLLM 在零样本和 SFT 场景中都能有效竞争甚至超越之前基于 OCR 的 SOTA 方法。具体来说,它在 VQA 上超过 DocLLM 19.8%,在 KIE 任务上超过 15.5%(第 4 节)。

- 广泛的消融证明了所提出的组件的实用性,分析表明,与当前基于 OCR 的模型相比,LayTextLLM 不仅提高了性能,而且还缩短了输入序列长度。

1 方法

首先,作者引入了一个创新的 Spatial Layout Projector(第 3.1.1 节),它将四维布局坐标转换为单标记嵌入。为了减少参数开销,作者应用了Partial Low-Rank Adaptation(第 3.1.2 节)。而且,引入特定的训练任务:布局感知的下一个标记预测(第 3.2.1 节)用于在预训练期间将布局与文本对齐,以及 Shuffled-OCR 监督微调(第 3.2.2 节)用于增强模型的通用性。

LayTextLLM 建立在 Llama2-7B 基础模型上,该模型最初设计为仅接受文本输入。 为了使模型能够将空间布局与文本交错,作者引入了一种新颖的Spatial Layout Projector。此投影仪将 OCR 派生的坐标转换为边界框标记。 作者还采用了 Partial Low-Rank Adaptation,这是一种微创方法,可在保留 LLM 固有知识的同时整合其他模态。

1.1 Spatial Layout Projector (SLP)

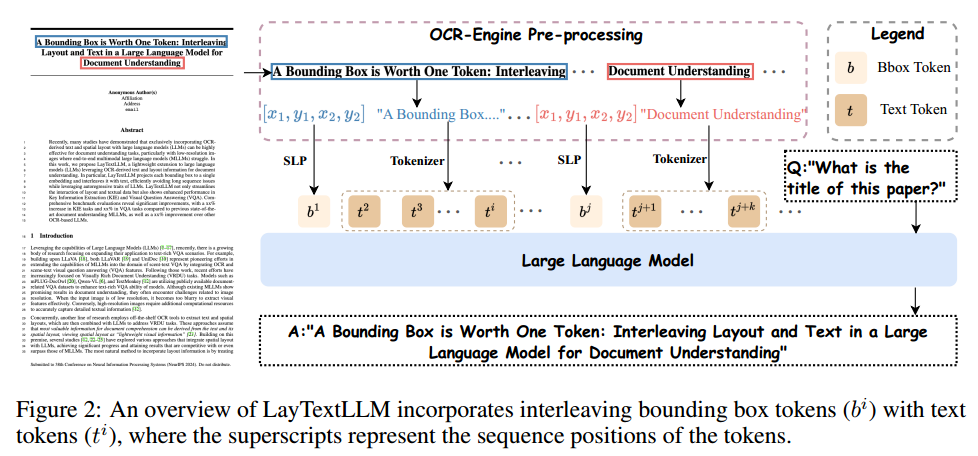

LayTextLLM中的一个关键创新是空间布局投影器(SLP),它将空间布局转换为一个单一的边界框标记。这一改进使得模型能够同时处理空间布局和文本输入。具体来说,每个由OCR导出的空间布局由一个由四维坐标[x1, y1, x2, y2]定义的边界框表示,这些坐标分别表示框的归一化最小和最大水平及垂直范围。SLP将这些坐标映射到一个高维空间,语言模型可以将其作为一个单一标记处理。这个过程可以计算为z = W · c + b,其中c ∈ R^4是边界框坐标的向量,W ∈ R^d×4是一个权重矩阵,d表示嵌入的维度,b ∈ R^d×1是一个偏置向量,z是结果边界框标记,表示为一个d维嵌入。如图2所示,结果边界框标记z将与相应的文本嵌入交错,然后输入到LLMs中。需要注意的是,SLP被所有边界框标记共享,因此引入的参数数量非常有限。

与坐标作为标记方案相比,SLP 使用单个标记来表示每个边界框。这种方法显著减少了输入标记的数量,并遵循将任何模态与文本交错的做法,有效地将布局和文本信息整合成一个统一的序列。这使得模型能够同时且连贯地处理这两种模态,充分利用 LLM 的自回归特性。

1.2 Layout Partial Low-Rank Adaptation

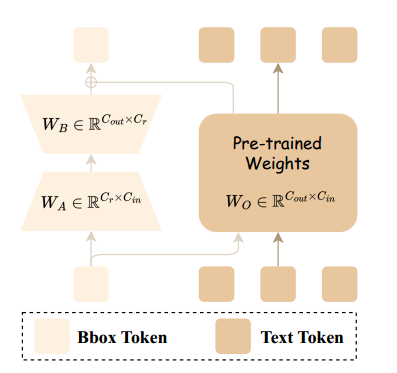

在使用SLP生成边界框标记和使用分词器生成文本标记之后,这两种模态通过LLMs中的布局部分低秩适应(P-LoRA)模块进行通信。P-LoRA,在InternLM-XComposer2 中引入,最初用于使LLMs适应视觉模态。它应用针对视觉标记指定的插件低秩模块,这些模块在添加最少参数的同时保留了LLMs的固有知识。

形式上,如图3所示,对于LLM中的一个线性层,原始权重 W O ∈ R C out × C in W_O \in \mathbb{R}^{C_{\text{out}} \times C_{\text{in}}} WO∈RCout×Cin和偏置 B O ∈ R C out B_O \in \mathbb{R}^{C_{\text{out}}} BO∈RCout 分别针对输入和输出维度 C in a n d C out C_{\text{in}} and C_{\text{out}} CinandCout。P-LoRA通过引入两个额外的矩阵 W A ∈ R C r × C in a n d W B ∈ R C out × C r W_A \in \mathbb{R}^{C_r \times C_{\text{in}}} andW_B \in \mathbb{R}^{C_{\text{out}} \times C_r} WA∈RCr×CinandWB∈RCout×Cr 来修改这一设置。这些矩阵是低秩的,Cr远小于Cin和Cout,并且专门设计用于与新模态标记交互,在作者的例子中是边界框标记。例如,给定一个包含边界框标记(xb)和文本标记(xt)的输入x = [xb, xt]被送入系统,前向过程如下,其中 x ^ t , x ^ b , 而 x ^ \hat{x}_t, \hat{x}_b, 而 \hat{x} x^t,x^b,而x^是输出:

x ^ t = W O x t + B O x ^ b = W O x b + W B W A x b + B O x ^ = [ x ^ b , x ^ t ] \begin{align*} \hat{x}_t &= W_O x_t + B_O \\ \hat{x}_b &= W_O x_b + W_B W_A x_b + B_O \\ \hat{x} &= [\hat{x}_b, \hat{x}_t] \end{align*} x^tx^bx^=WOxt+BO=WOxb+WBWAxb+BO=[x^b,x^t]

1.3 Training Procedure

LayTextLLM 采用创新的布局感知训练程序进行训练,该程序包括两个阶段:布局感知下一个标记预测预训练和 Shuffled-OCR 监督微调。

1.3.1 Layout-aware Next Token Prediction

受到当前 LLM 预训练中常用的下一个标记预测的启发,作者提出了布局感知的下一个标记预测 (LNTP)。图 4 展示了所提出的布局感知的下一个标记预测与传统的下一个标记预测任务的对比。传统的下一个标记预测 (图 4(a)) 仅依赖于文本内容,根据先前的标记序列预测每个后续标记,而不考虑它们的空间布局。然而,布局感知的下一个标记预测 (图 4(b)) 将 SLP 编码的空间信息 (即 bi ) 与文本标记 (即 t i ) 交错在一起。这种整合同时考虑了文档中的内容及其布局,从而可以更丰富、更精确地理解结构和内容。

类似地,LNTP 的主要目标是最大化其对下一个标记的预测可能性。因此,损失函数定义为

L = − 1 T ∑ i = 1 T log P ( t i ∣ t 1 , t 2 , ... , t i − 1 ) L = -\frac{1}{T} \sum_{i=1}^{T} \log P(t_i | t_1, t_2, \ldots, t_{i-1}) L=−T1i=1∑TlogP(ti∣t1,t2,...,ti−1)

其中 P ( t i ∣ t 1 , t 2 , ... , t i − 1 ) P(t_i | t_1, t_2, \ldots, t_{i-1}) P(ti∣t1,t2,...,ti−1)表示给定前一个标记序列 t 1 , t 2 , ... , t i − 1 t_1, t_2, \ldots, t_{i-1} t1,t2,...,ti−1,模型预测第 i 个标记 t i 的概率。请注意作者仅计算文本标记的损失,不包括边界框标记。在预训练期间,作者的目标是增强空间布局和文本模态之间的对齐,同时尽可能保留 LLM 的固有知识。因此,作者冻结了 LLM,只更新了 SLP 和 P-LoRA 的参数。

值得注意的是,作者提出的布局感知下一个标记预测是一种完全自监督的预训练程序,这与之前的研究不同,这些研究需要人工注释文档结构数据或由 GPT-4 等更大的 LLM 生成的合成数据 。因此,LNTP 有助于以最低成本创建大规模、高保真预训练数据集

1.3.2 Shuffled-OCR Supervised Fine-tuning

OCR 引擎通常从上到下、从左到右处理文本。当前基于 OCR 的 LLM 也采用此顺序作为输入顺序 [25, 27]。然而,现代 LLM 往往对输入标记的位置表现出强烈的归纳偏差,这受到旋转位置嵌入 (RoPE) [44] 等设计的影响。具体而言,输入序列中靠得很近的标记可能会获得更高的注意力分数,这对于处理标准文本序列是有利的。这种归纳偏差有利有弊。

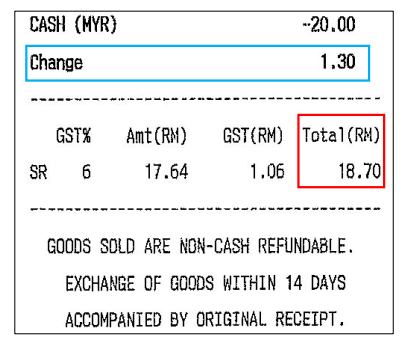

考虑图 5 中所示的示例,其中 OCR 输入文本为:"... Change,1.30,GST%,Amt(RM),GST(RM),Total(RM),SR,6,17.64,1.06,18.70..."。如果提出的问题是"字段 Change 的值是多少?" (以蓝色框突出显示),该模型很容易识别"1.30",因为它在序列中的位置与单词"Change"很接近。但是,对于更具挑战性的查询,例如"字段 Total(RM) 的值是多少?"(以红色框突出显示),由于存在多个靠近"Total(RM)"的后续数字,因此模型很难确定正确答案。 LayTextLLM 将空间布局与文本数据相结合,减少了对输入序列顺序的依赖。 因此,作者假设,打乱 OCR 输入顺序可以增强 LayTextLLM 在辨别相关信息方面的弹性,而不管序列中的标记接近度如何。

具体而言,作者提出了 Shuffled-OCR 监督微调 (SSFT),它可以随机打乱一定比例的示例中 OCR 衍生文本的顺序。可以在表 7 中找到打乱比率的探索范围,并应用 20% 的打乱比率。训练目标相当于预测下一个标记,但在这种情况下,仅使用响应的标记来计算损失。在 SSFT 期间,作者解冻所有参数,包括 LLM 的参数。第 4.6 节中的实验结果表明,利用 SSFT 可以进一步增强模型性能,使其对输入标记顺序的中断更具鲁棒性。

2 实验

2.1 数据集

- 预训练数据

在作者的训练过程中,作者专门使用开源数据来促进复制。作者从两个数据集收集数据进行预训练:(1)IIT-CDIP 测试集 1.0 和(2)DocBank 。IIT-CDIP 测试集 1.0 包含超过 1600 万页文档的庞大存储库。DocBank 包含 50 万份文档,每份文档都有不同的布局,每个文档只有一页。为了提高训练效率,作者选择使用整个 DocBank 数据集,并且仅从 IIT-CDIP 集合 1.0 中抽取 500 万页。

- SFT 数据

对于面向文档的 VQA,作者选择了 Luo 等人 中使用的 Document Dense Description(DDD)和布局感知 SFT 数据,这是 GPT-4 生成的两个合成数据集。DocVQA 、InfoVQA 、ChartQA 、VisualMRC 。对于 KIE 任务, SROIE 、CORD 、FUNSD 、POIE 数据集。

2.2 实施细节

LayTextLLM 的 LLM 组件从广泛使用的骨干网络 Llama2-7B-base 初始化。其他参数(包括 SLP 和 P-LoRA)都是随机初始化的。预训练阶段,LLM 冻结,SLP 和 P-LoRA 模块参数更新。SFT 阶段,所有参数均进行微调。

作者已使用三个版本的 LayTextLLM 配置模型,以便在不同设置下进行并排比较。与 Luo 等人 [27] 一致,第一个版本 LayTextLLMzero 专门使用 DDD 和布局感知 SFT 数据进行训练。在此基础上,并与 Liu 等人 [12] 的设置保持一致,作者将 DocVQA 和 InfoVQA 训练集引入到第二个版本(称为 LayTextLLMvqa)的数据集池中。最后,作者整合了一套全面的 KIE 数据集 - FUNSD、CORD、POIE、SROIE、ChartQA 和 VisualMRC,创建了作者最广泛的版本 LayTextLLMall。请注意,所有版本都基于相同的预训练 LayTextLLM 权重。

2.3 基线

无 OCR 基线

在无 OCR MLLM 类别中,作者选择了以下 SOTA 模型作为作者的强基线,因为它们在面向文档的 VQA 和 KIE 任务中都表现优异。 其中包括 UniDoc 、DocPedia 、Monkey 、InternVL 、InternLMXComposer2 、TextMonkey 和 TextMonkey+ 。

基于 OCR 的基线

对于基于 OCR 的基线模型,作者实现了一种基本方法,仅使用 OCR 派生的文本作为输入。 这是使用两个版本完成的:Llama2-7B-base 和 Llama27B-chat。 作者还为这些模型改编了 He 等人的坐标作为标记方案,从而产生了两个新变体:Llama2-7B-basecoor 和 Llama2-7B-chatcoor。值得注意的是,作者没有在这些模型中使用 ICL 策略,因为这会大大超出它们的最大序列长度限制。此外,作者还纳入了使用 ChatGPT Davinci-003 (175B) 模型 的更强基线的结果,称为 Davinci-003-175Bcoor。作者的分析还考虑了另一种最近的基于 SOTA OCR 的方法 DocLLM 。最后,还包括 LayoutLLM 和 LayoutLLMCoT ,它们集成了视觉提示、文本和布局。

2.4 评估指标

为了确保与无 OCR 方法进行公平比较,作者采用了准确度指标,即如果模型的响应完全捕捉到了基本事实,则该响应被视为正确。为了进一步增强与其他基于 OCR 的方法的可比性,作者使用特定于某些数据集的原始指标进行了额外评估,例如 F1 分数 、ANLS 和 CIDEr 。

2.5 定量结果

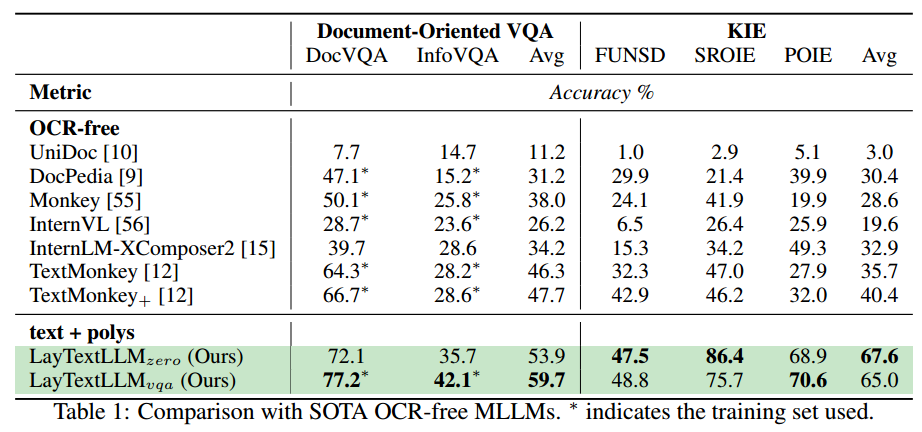

2.5.1 Comparison with SOTA OCR-free Methods

比较表 1 中的实验结果证明了 LayTextLLM 系列在各种任务中的出色表现。请注意,由于担心比较的公平性,ChartQA 的结果在附录 E 中报告,因为数据集不包含 OCR 得出的结果,因此作者使用内部 OCR 工具。首先,LayTextLLMzero 在零样本能力方面明显优于之前的 SOTA 无 OCR 方法,例如 TextMonkey [12],即使这些方法使用数据集的训练集。例如,在 DocVQA 和 InfoVQA 数据集中,LayTextLLMzero 分别实现了 72.1% 和 35.7% 的准确率,明显高于现有的无 OCR 方法,例如 TextMonkey 和 InternLM-XComposer2。当使用相应的数据集进行微调时,LayTextLLM 显示出更大的性能提升,特别是在面向文档的 VQA 数据集中。具体来说,它在 DocVQA 和 InfoVQA 上的准确率分别提高到 77.2% 和 42.1%,证明了该模型利用任务特定数据的强大能力。此外,LayTextLLMzero 在 KIE 数据集上表现出色,尤其是在 SROIE 和 POIE 数据集上,准确率分别达到 86.4% 和 68.9%。这些结果分别显著超过了之前的 SOTA 无 OCR 模型(即 TextMonkey+),幅度分别为 40.5% 和 34.1%。这种显著的性能提升可能是因为这些数据集包含低分辨率图像,这些图像太模糊,当前的 MLLM 无法提取视觉特征,而 LayTextLLM 在这种具有挑战性的场景中表现出了稳健性。

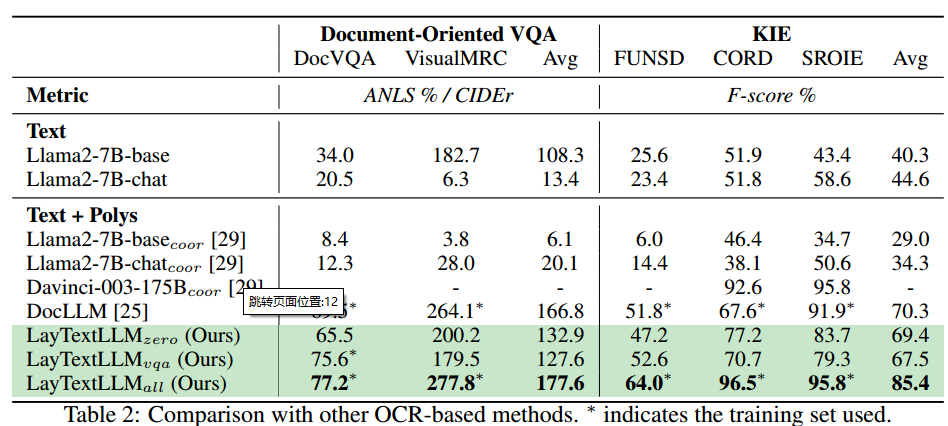

2.5.2 Comparison with SOTA OCR-based Methods

为了进行全面比较,作者还进行了相应的实验以与基于 OCR 的方法保持一致 [25, 27]。表 2 中显示的实验结果展示了与纯基于 OCR 的 SOTA 方法(如 DocLLM [25])相比,LayTextLLM 模型取得了显著的性能提升。具体而言,与 DocLLM 相比,LayTextLLMzero 表现出了显著的优越性,甚至其零样本能力也与监督 SFT 方法相媲美。作者认为 DocLLM 表现不佳可能是由于其使用了交叉注意和掩蔽跨度预训练任务 [59],这未能有效利用 LLM 的自回归特性。同样,与 Llama2-7B 中使用的坐标作为标记相比,LayTextLLMzero 再次表现出色。这种性能差异可以归因于以下三个原因:(1)坐标即标记方法往往会引入过多的标记,通常会超过 Llama2-7B 预定义的最大长度(即 4096)。因此,这会导致关键 OCR 信息缺失,从而产生幻觉和低于标准的性能。(2)在使用 Llama2-7B 重新实现坐标即标记方法时,作者没有引入 ICL 策略,因为它会增加输入序列的长度。(3)坐标即标记方法需要相当大尺寸的 LLM 才能有效理解数值标记。

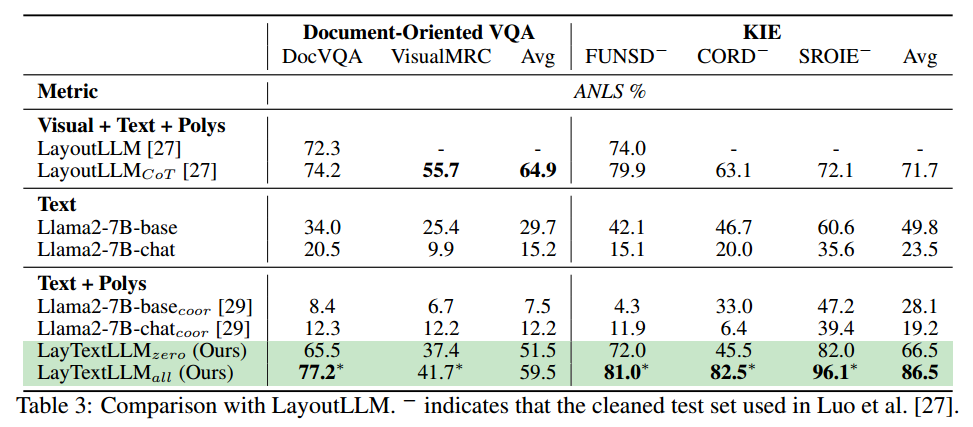

与 LayoutLLM 相比,作者的方法在不同任务中表现出不同的性能,如表 3 所示。在零样本场景中,作者在大多数 KIE 数据集中的表现都优于 LayoutLLM,证明了作者能够有效利用基于 OCR 的结果。然而,作者在面向文档的 VQA 任务上表现不佳,因为回答一些与视觉信息密切相关的问题可能会挑战作者的方法。两个主要原因可以很好地解释这种性能差异:(1)LayoutLLM 中的视觉编码器提供了额外的视觉信息。(2)LayoutLLM 结合了思想链 (CoT) 机制来建模上下文信息,而作者的方法中并未使用该机制。然而,当使用定制数据进行微调时,LayTextLLM 的表现明显优于 LayoutLLM,展示了其利用特定于任务的数据的强大能力。

2.6 分析

- 消融

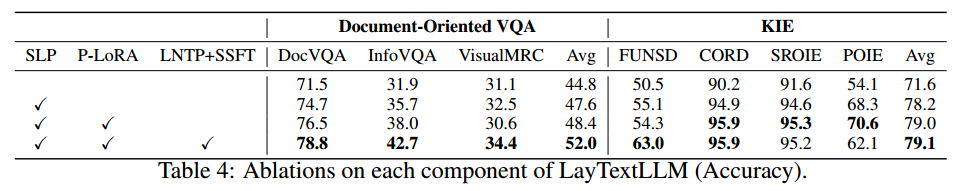

为了更好地评估 LayTextLLM 中每个组件的效用,进行了一项消融研究,其结果如表 4 所示。附录 B 提供了有关所有变体的训练设置的详细信息。结果清楚地表明,结合交错的空间布局和文本可显着提高性能,与普通版本相比,VQA 提高了 2.8%,KIE 提高了 6.6%,这表明 SLP 是一个关键组件。 此外,启用 P-LoRA 可使 VQA 和 KIE 任务的性能均小幅提升 0.8%。最后,启用 LNTP+SSFT 可显着改善 VQA 和 KIE 任务,分别提高 3.6% 和 0.1%。

- 序列长度

表 5 显示了不同数据集中平均输入序列长度的统计数据。有趣的是,尽管交错边界框标记,LayTextLLM 在四个数据集中的三个中始终表现出最短的序列长度,甚至超过了 DocLLM,这是违反直觉的。作者将其归因于标记器机制。例如,使用 tokenizer.encode(),OCR 引擎中的单个单词(如"International")被编码为单个 ID [4623]。相反,当整个 OCR 输出被处理为一个序列时,例如"... CPC,International,Inc...",单词"International"被拆分为两个 ID [17579, 1288],分别对应于"Intern"和"ational"。这种情况经常发生,更多讨论见附录 C。此外,作者发现空间布局可以解码回坐标,并且需要输出边界框坐标的推理可以进一步缓解幻觉问题,更多讨论见附录 F。

3 限制

尽管 LayTextLLM 在文本丰富的 VQA 和 KIE 任务中表现出了显著的能力,但仅凭这一点还不足以满足所有实际应用的需求。在某些情况下,特别是在图表分析中,推理必须完全基于视觉提示(例如大小、颜色)------这一挑战仍未得到解决。诸如"最高和最低绿色条之间的差异是什么?"之类的问题说明了这一差距。附录 E 中详细介绍的 ChartQA 结果也强调了这些局限性。 应对这些挑战凸显了未来迫切需要将视觉提示集成到 LayTextLLM 的功能中。

4 结论

作者针对各种 VRDU 任务提出了 LayTextLLM,其中空间布局和文本数据无缝交错,通过引入创新的空间布局投影仪做出更准确的预测。两个定制的训练任务------布局感知的下一个标记预测和 Shuffled-OCR 监督微调------旨在提高对文档布局的理解。大量实验证实了 LayTextLLM 的有效性。

4 结论

作者针对各种 VRDU 任务提出了 LayTextLLM,其中空间布局和文本数据无缝交错,通过引入创新的空间布局投影仪做出更准确的预测。两个定制的训练任务------布局感知的下一个标记预测和 Shuffled-OCR 监督微调------旨在提高对文档布局的理解。大量实验证实了 LayTextLLM 的有效性。