2024年2月16日,OpenAI 在其官网上面正式宣布推出文本生成视频的大模型 Sora:

Sora的能力

Sora是生成视频为主要能力的模型,能够:

1. 文/图生成视频

openai sora文生视频案例:

Prompt: Historical footage of California during the gold rush.

翻译:加利福尼亚淘金热时期的历史影像。

openai sora图生视频案例:

2. 视频生成视频

openai sora视频转视频案例:

3. 1分钟超长高质量视频生成

openai sora视频时长:60秒

4. 视频裂变多视角生成

openai sora视频裂变多视角生成案例:

5. 准工业级数字孪生游戏/科幻片特效,物理引擎能力

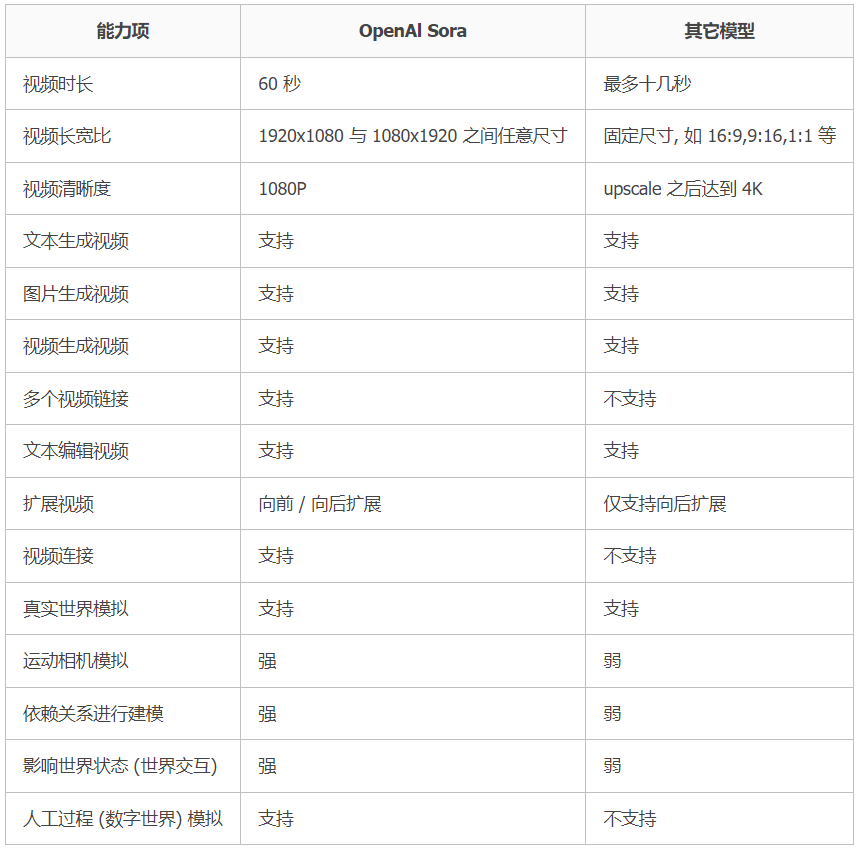

Sora 、Runway Gen2、Pika能力差异

Sora技术

Sora 模型技术报告中,可以看到 Sora 模型的实现建立在 OpenAI 一系列坚实的历史技术工作的沉淀基础上。

包括不限于视觉理解(Clip),Transformers 模型和大模型的涌现(ChatGPT),Video Caption(DALL·E 3)

报告地址:https://openai.com/research/video-generation-models-as-world-simulators

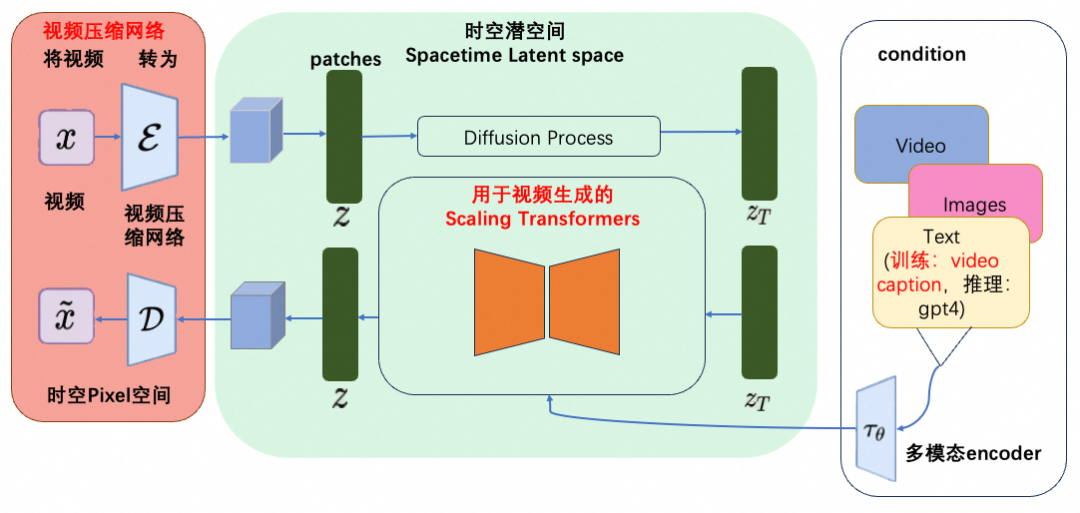

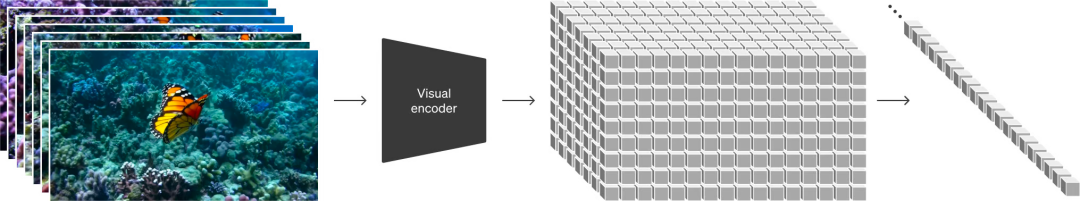

技术1、视觉数据转为 Patches

从"大型语言模型通过在互联网规模的数据上进行训练,获得了出色的通用能力"中,OpenAI汲取了灵感。

LLM 确立新范式,部分得益于创新了 token 使用的方法。研究人员们巧妙地将文本的多种模态 ------ 代码、数学和各种自然语言统一了起来。

这项工作中,OpenAI 考虑了生成视觉数据的模型如何继承这种方法的好处。大型语言模型有文本 token,而 Sora 有视觉 patches。此前的研究已经证明 patches 是视觉数据模型的有效表示。OpenAI 发现 patches 是训练生成各种类型视频和图像的模型的可扩展且有效的表示。

更高层面上,OpenAI 首先将视频压缩到较低维的潜在空间,然后将表示分解为时空 patches,从而将视频转换为 patches。

Sora的一个重大突破是能够生成非常长的视频。制作2秒视频和1分钟视频的区别是巨大的。Sora中,这可能是通过允许自回归采样的联合帧预测来实现的,但一个主要挑战是如何解决误差积累并保持质量/一致性。

技术2、视频压缩网络

Sora实现了将Transformer和扩散模型结合的创新,首先将不同类型的视觉数据转换成统一的视觉数据表示(视觉patch),然后将原始视频压缩到一个低维潜在空间,并将视觉表示分解成时空patch(相当于Transformer token),让Sora在这个潜在空间里进行训练并生成视频。

接着做加噪去噪,输入噪声patch后Sora通过预测原始"干净"patch来生成视频。OpenAI发现训练计算量越大,样本质量就会越高,特别是经过大规模训练后,Sora展现出模拟现实世界某些属性的"涌现"能力。

这也是为啥OpenAI把视频生成模型称作"世界模拟器",并总结说持续扩展视频模型是一条模拟物理和数字世界的希望之路。

训练了一个降低视觉数据维度的网络。该网络将原始视频作为输入,并输出在时间和空间上压缩的潜在表示。Sora 在这个压缩的潜在空间中接受训练,而后生成视频。OpenAI 还训练了相应的解码器模型,将生成的潜在表示映射回像素空间。

- 时空潜在 patches

给定一个压缩的输入视频,OpenAI 提取一系列时空 patches,充当 Transformer 的 tokens。

该方案也适用于图像,因为图像可视为单帧视频。OpenAI 基于 patches 的表示使 Sora 能够对不同分辨率、持续时间和长宽比的视频和图像进行训练。在推理时,OpenAI 可以通过在适当大小的网格中排列随机初始化的 patches 来控制生成视频的大小。

- 用于视频生成的缩放 Transformer

Sora 是个扩散模型;给定输入噪声 patches(以及文本提示等调节信息),训练出的模型来预测原始的「干净」patches。重要的是,Sora 是一个扩散 Transformer。Transformer 在各个领域都表现出了卓越的缩放特性,包括语言建模、计算机视觉、和图像生成。

这项工作中,OpenAI 发现扩散 Transformers 也可以有效地缩放为视频模型。下面,OpenAI 展示了训练过程中具有固定种子和输入的视频样本的比较。随着训练计算的增加,样本质量显着提高。

- 可变的持续时间,分辨率,宽高比

过去的图像和视频生成方法通常需要调整大小、进行裁剪或者是将视频剪切到标准尺寸,例如 4 秒的视频分辨率为 256x256。相反,该研究发现在原始大小的数据上进行训练,可以提供以下好处:

首先是采样的灵活性

Sora 可以采样宽屏视频 1920x1080p,垂直视频 1920x1080p 以及两者之间的视频。这使 Sora 可以直接以其天然纵横比为不同设备创建内容。Sora 还允许在生成全分辨率的内容之前,以较小的尺寸快速创建内容原型 ------ 所有内容都使用相同的模型。

其次是改进帧和内容组成

研究者通过实证发现,使用视频的原始长宽比进行训练可以提升内容组成和帧的质量。将 Sora 在与其他模型的比较中,后者将所有训练视频裁剪成正方形,这是训练生成模型时的常见做法。经过正方形裁剪训练的模型(左侧)生成的视频,其中的视频主题只是部分可见。相比之下,Sora 生成的视频(右侧)具有改进的帧内容。

技术3、语言理解

训练文本到视频生成系统需要大量带有相应文本字幕的视频。研究团队将 DALL ・ E 3 中的重字幕(re-captioning)技术应用于视频。

具体来说,研究团队首先训练一个高度描述性的字幕生成器模型,然后使用它为训练集中所有视频生成文本字幕。研究团队发现,对高度描述性视频字幕进行训练可以提高文本保真度以及视频的整体质量。

与 DALL ・ E 3 类似,研究团队还利用 GPT 将简短的用户 prompt 转换为较长的详细字幕,然后发送到视频模型。这使得 Sora 能够生成准确遵循用户 prompt 的高质量视频。

- 以图像和视频作为提示

我们已经看到了文本到视频的诸多生成示例。实际上,Sora 还可以使用其他输入,如已有的图像或视频。这使 Sora 能够执行各种图像和视频编辑任务 --- 创建完美的循环视频、静态图像动画、向前或向后延长视频时间等。

- 视频内容拓展

Sora 还能够在开头或结尾扩展视频内容。以下是 Sora 从一段生成的视频向后拓展出的三个新视频。新视频的开头各不相同,拥有相同的结尾。

使用这种方法无限延长视频的内容,实现「视频制作永动机」。

- 视频到视频编辑

扩散模型激发了多种根据文本 prompt 编辑图像和视频的方法。OpenAI 的研究团队将其中一种方法 ------SDEdit 应用于 Sora,使得 Sora 能够在零样本(zero-shot)条件下改变输入视频的风格和环境。

连接视频可以使用 Sora 在两个输入视频之间逐渐进行转场,从而在具有完全不同主题和场景构成的视频之间创建无缝过渡。

技术4、图像生成

Sora 还能生成图像。为此,OpenAI 将高斯噪声 patch 排列在空间网格中,时间范围为一帧。该模型可生成不同大小的图像,最高分辨率可达 2048x2048。

OpenAI 发现,视频模型在经过大规模训练后,会表现出许多有趣的新能力。这些能力使 Sora 能够模拟物理世界中的人、动物和环境的某些方面。这些特性的出现没有任何明确的三维、物体等归纳偏差 --- 它们纯粹是规模现象。

Sora 可以生成动态摄像机运动的视频。随着摄像机的移动和旋转,人物和场景元素在三维空间中的移动是一致的。

视频生成系统面临的一个重大挑战是在对长视频进行采样时保持时间一致性。

OpenAI 发现,虽然 Sora 并不总是能有效地模拟短距离和长距离的依赖关系,但它在很多时候仍然能做到这一点。例如,即使人、动物和物体被遮挡或离开画面,Sora 模型也能保持它们的存在。同样,它还能在单个样本中生成同一角色的多个镜头,并在整个视频中保持其外观。

Sora 有时可以模拟以简单方式影响世界状态的动作。例如,画家可以在画布上留下新的笔触,这些笔触会随着时间的推移而持续,或者一个人可以吃汉堡并留下咬痕。

Sora 还能模拟人工进程,视频游戏就是一个例子。Sora 可以通过基本策略同时控制 Minecraft 中的玩家,同时高保真地呈现世界及其动态。只需在 Sora 的提示字幕中提及 「Minecraft」,就能零样本激发这些功能。

这些功能表明,视频模型的持续扩展是开发物理和数字世界以及其中的物体、动物和人的高能力模拟器的一条大有可为的道路。

报告脑图

本报告重要发现概述:

-

Sora 是一个扩散模型,该模型基于 扩散变换器 (DiT)和 潜在扩散进行构建,并在模型和训练数据集的规模上进行了大幅度的扩展。

-

Sora 展示了,像大语言模型(LLM)一样,对视频模型进行规模扩大是有益的,并且这种规模扩大将成为迅速提升模型质量的主要动力。

-

诸如 Runway,Genmo 和 Pika 这样的公司正在努力围绕 Sora 等视频生成模型,构建直观易用的界面和工作流程,这将决定这些模型的广泛应用性和实用性。

-

Sora 的训练需要大量的计算资源,据估计,需要 4200-10500 台 Nvidia H100 GPU 运行一个月。

-

在推断阶段,我们估计 Sora 每小时最多可以在每台 Nvidia H100 GPU 上生成大约 5 分钟的视频。与 LLM 相比,像 Sora 这样的基于扩散的模型的推断成本高出数个数量级。

-

随着类似 Sora 的模型广泛部署,推断计算的需求将超过训练计算的需求。我们估计,当生成视频的总时长达到 1530-3810 万分钟时,将达到"收支平衡点",此后在推断阶段所消耗的计算资源将超过原始训练阶段。相比之下,每天有 1700 万分钟(TikTok)和 4300 万分钟(YouTube)的视频被上传。

-

假设在像 TikTok(占所有视频分钟数的 50%)和 YouTube(占所有视频分钟数的 15%)这样的热门平台上,大量采用 AI 进行视频生成,并考虑到硬件的利用率和使用模式,我们估计推断阶段的峰值需求将达到约 720k 台 Nvidia H100 GPU。

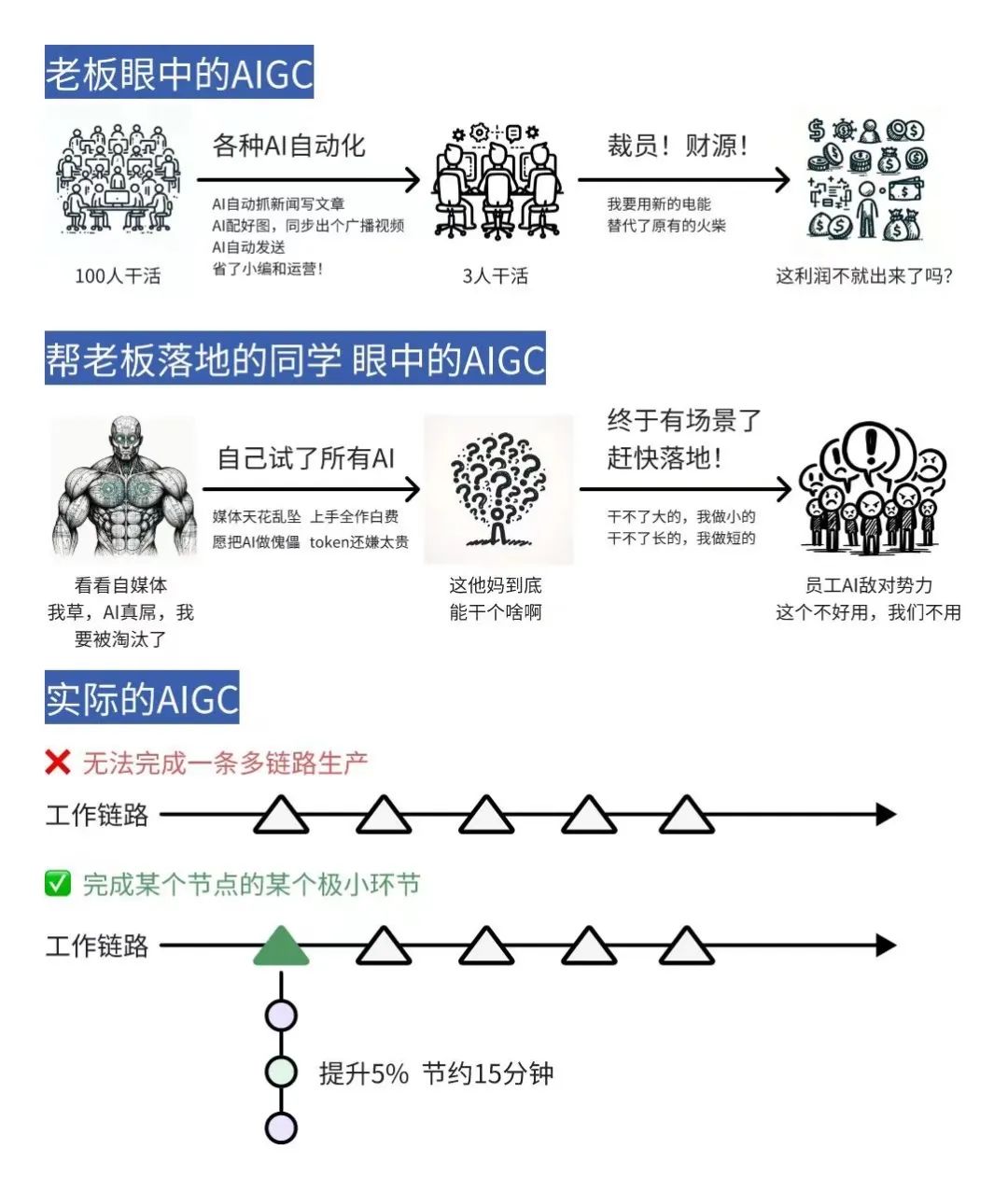

难用的模型

Sora的出现一时间万人欢呼,好象AI时代己经到来,然而,很多人使用时发现,对Sora的期待落空了。

因为如果把Sora类比ChatGPT,对标GPT3更合适。Sora 通过学习海量视频使得AI 开始涌现对物理规律的理解,这和 GPT3 通过学习海量文本使得 AI 开始涌现对语言+知识的理解很像。

然而,GPT3 刚出来时问题多多,是很难用的模型,经过了几次模型和产品的迭代,两年后才有了一个完整的ChatGPT产品问世。Sora一样,真正成熟还需要些时间,耐心等待。