基于gis数据的高敏感高保密性要求,相信gis的小伙伴都有如下的需求:在内网,无外网环境下,部署自己的私有化大模型。

1.环境背景:

没有Linux环境,只是windows

无外网,内网环境

2.安装部署过程:

一、Ollama下载安装

进入官网:github.com

点击Download

选择Windows,点击Download for Windows (Preview)

默认安装。

安装完成以后在win+r,输入cmd,弹出dos命令界面。输入ollama。

右侧状态栏出来小绵羊就算成功了。

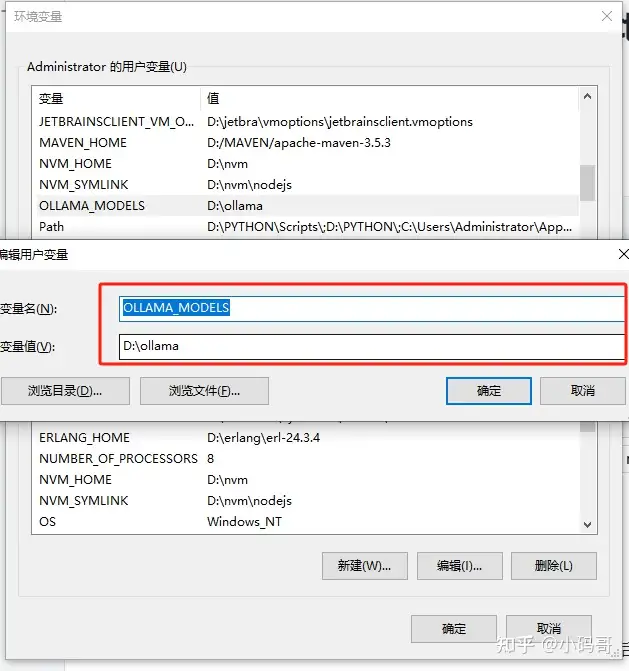

二、创建环境变量

OLLAMA_MODELS,随意指定变量值,如图所示:

|---------------|

| OLLAMA_MODELS |

二、支持的模型

三、下载模型的地址

(1)国内大模型源文件下载地址https://modelscope.cn/models

(2)国外大模型源文件下载地址https://huggingface.co/models

三、大模型下载安装

1.我选择的阿里qwen2,下载Qwen2

我这是离线部署,只能把几个g的模型下载到本地,然后安装,如果不是离线,一个命令就搞定了,别在我这个文章晃了。

进入魔塔社区下载:通义千问2-7B-Instruct-GGUF · 模型库 (modelscope.cn)

Qwen2是刚出来的号称国内最强开源大模型。之前还有1.5的,肯定要选2的吧,选择instruct就是内含训练好的模型。不带的需要自己训练。 GGUF文件就是模型文件。有0.5B,7B,14B......72B,前面的数字是存储权重的位数(精度) 参数越大越费显存, 数字越大性能越强**。**

k是在所有的attention和feed_forward张量上将精度提升2位,m是在一半的attention和feed_forward张量上将精度提升2位。

instruct是训练好的模型,包含从0.5亿到720亿参数的指令调优语言模型,包括一个专家混合模型。具体来说,这里有一个指令调优的7亿参数Qwen2模型。

废话一下:传说又有2.5更牛,通义千问2.5是一个集成了通义大模型全栈能力的全能AI助手。它支持多种文件格式进行处理,包括PDF、Word、Excel等,且在文档处理方面,支持单次处理最长1000万字、100个文档。此外,于2024年,该APP更名为"通义APP",其基模的性能可与GPT-4 Turbo相媲美。

模型可以去ollama gallary里面选择支持哪些模型都可以自己去选。

在下面列表按照自己的机器内存选一个合适自己的,选好以后,在右侧"下载"下载到本地就行,不用注册。怎么选呢?前面tab页有"模型介绍"可以翻过去查一下。

前面可以看模型介绍:

先在最下面点击效率评估,看下各个模型占的显存,选择适合自己的,比如我的显卡内存是8g显存,我选择的模型就是Qwen2-7B-Instruct GPTQ-Int4

2、准备Modelfile文件

(1)Modelfile参数说明

| 命令 | 描述 |

|---|---|

FROM (必需的) |

引入使用的模型或者模型源文件 |

新建一个txt文件,改名成modelfile,去掉扩展名。在里面贴上这么一句

|------------------------------------|

| FROM ./Qwen2-7B-Instruct GPTQ-Int4 |

新建一个文件夹叫qwenmodel,把模型和modelfile都放进去

(2)执行命令

|----------------------------------|

| ollama create qwen2 -f Modelfile |

等待差不多10分钟,出现success表示成功。

3.运行安装qwen2模型

进到cmd命令下面。

输入"cd d:/qwenmodel"

进入这个目录下面,然后在这个目录下,开始运行ollama安装

输入命令"ollama run qwenmodel"

输入ollama list查看大模型列表

输入ollama run 模型名称我这里装了两个,直接运行启动一个就行,ollama run+模型名称就从服务器端,把大模型启动起来了。这里犯了错,搞了好久才明白,如果下次开机还行用模型,直接在cmd命令页面下,使用命令"ollama run 模型名"就可以启动了,跟tomcat启动一个道理。