这一年来,AI 发展的越来越快,大模型使用的门槛也越来越低,每个人都可以在自己的本地运行大模型。之前也给大家介绍过一些可以在本地运行大模型的项目,今天再给大家介绍一个最厉害的开源大模型服务框架------ollama。

项目介绍

Ollama 是一个开源的大语言模型(LLM)服务工具,它允许用户在本地环境快速实验、管理和部署大型语言模型。它支持多种流行的开源大型语言模型,如 Llama 3.1、Phi 3、Mistral、Gemma 2 等,并且可以通过命令行界面轻松下载、运行和管理这些模型。

Ollama 的出现是为了降低使用大型语言模型的门槛,是让大型语言模型更加普及和易于访问。

项目安装

既然说到要降低门槛,Ollama 的安装也自然是非常的方便了。

Ollama 支持 macOS、Windows 和 Linux 操作系统,同时也提供了 Docker 镜像,方便在不同环境中部署。

-

macOS : 可以通过 Homebrew 安装,使用命令

brew install ollama。也可以直接下载安装包运行。 -

Windows: 需要下载安装包并运行。

-

Linux : 可以通过包管理器或使用命令

curl -fsSL ``https://ollama.com/install.sh`` | sh安装。 -

Docker : 可以使用

docker pull ollama/ollama命令拉取镜像,并运行容器。

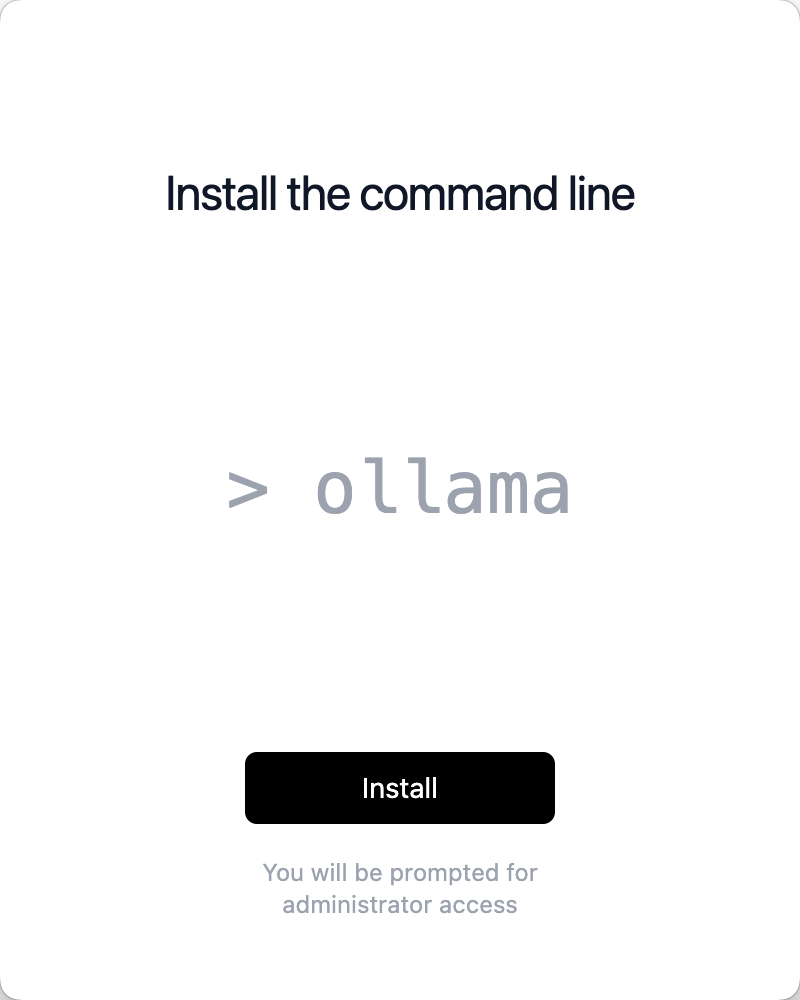

这里以 macOS 为例,下载了 ollama 的安装包后,直接双击运行这个可爱羊驼的应用,程序会提示你将应用移动到 application 文件夹,并且有后续的提示操作,我们按照指引去安装就可以了。

项目使用

安装完成后,我们可以直接执行 ollama 应用启动,也可以在命令行中执行 ollama serve 来启动 Ollama 服务。

当然,现在的我们主要在命令行中去操作 ollama。

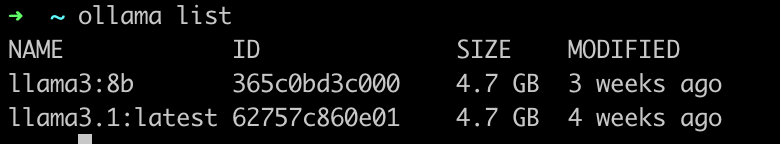

执行 ollama list:可以列出已下载的模型,如图:

执行 ollama pull <model> 可以从远程仓库拉取模型。

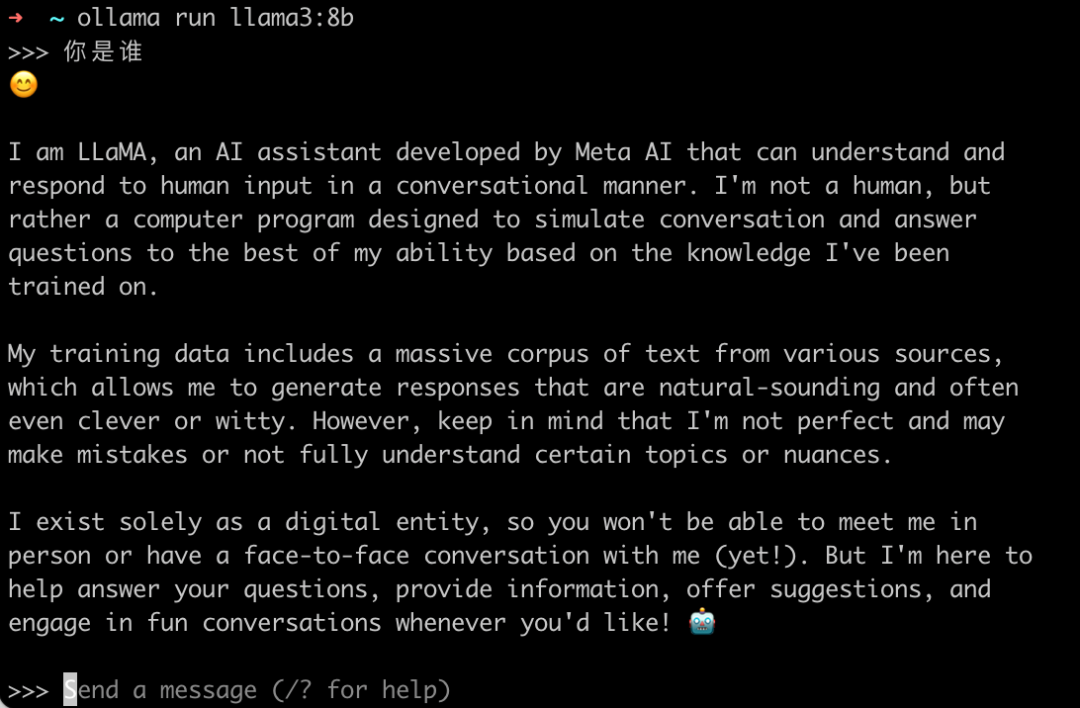

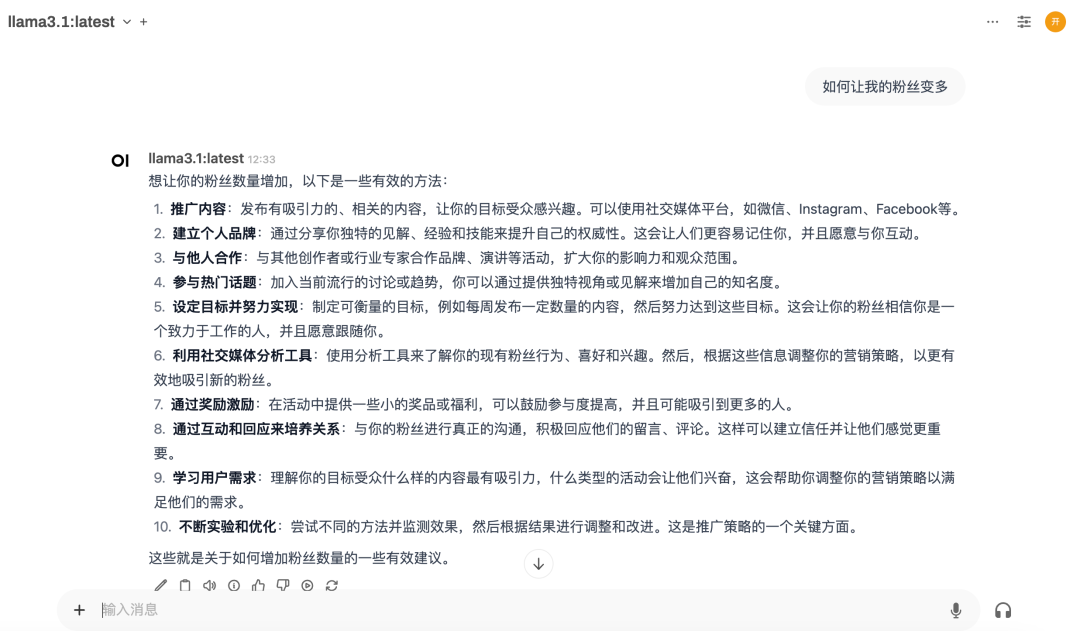

执行 ollama run <model> 可以运行指定的模型,我们使用 ollama run llama3:8b 来运行已经安装的模型,并且开始对话,如图:

web 界面

如果都是用命令行交互,还是挺麻烦的。这里再给大家介绍一个好用的 ollama 的 web 界面:open-webui。

这也是一个开源项目,我们可以使用 docker 来快速部署:

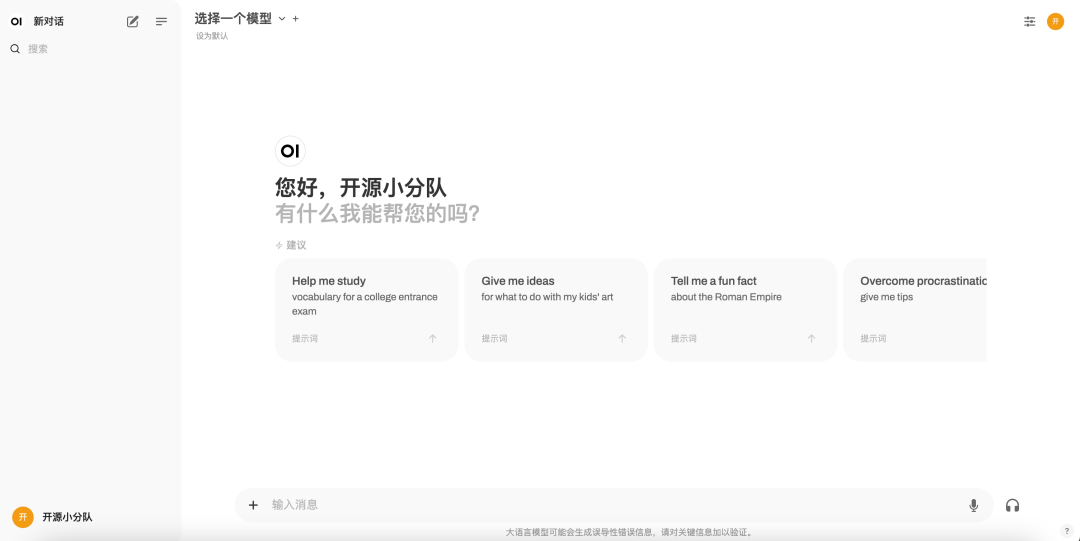

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main之后在浏览器访问 localhost:3000,可以打开一个和 ChatGPT 很像的页面:

点击上方的"选择一个模型",便可以看到 ollama 中已经下载的模型,选中后直接开启聊天就可以啦。

总结

Ollama 是一个功能强大且易于使用的工具,它为本地部署和运行大型语言模型提供了一个简单而有效的方法。无论是研究、开发还是日常使用,Ollama 都能满足用户对大型语言模型的需求。Ollama 拥有庞大的社区用户和相关的开源项目,配合 open-webui,我们可以更好的使用 Ollama,并为朋友们提供一个类似于 ChatGPT 的对话界面。

感兴趣的朋友们,赶紧去试试吧。

项目地址:

https://github.com/ollama/ollama

https://github.com/open-webui/open-webui