首先要说明的是,模型训练,需要显卡持续不间断地一致运行,

快则0.5-1小时左右,慢的话可能需要跑上几小时,甚至是几天,

原因跟显卡的配置和训练设置参数都有关系。

模型训练与显卡配置:

-

训练 LoRA模型:要求6GB显存及以上

-

训练 Checkpoint:要求8GB显存及以上

-

训练 SDXL模型:要求16GB显存及以上

因此,从显卡配置角度来看,更推荐训练 LoRA模型,而且训练 LoRA模型 比其他的要快上很多。

我们利用训练好的 LoRA模型,搭配合适的大模型,也能轻松实现各种定制的风格效果。

素材准备

确定模型主题

确认主题,有利于我们围绕模型的核心特点来准备素材,提供给AI学习。

我们所收集到的图片质量好与坏,直接影响模型的最终效果。

图片数量

这需要匹配模型风格来确定:

- 训练通用性较强的模型:需要提供较多的图片素材,数量可以达到100张以上

- 训练单一风格/指定角色的模型:至少需要提供20张图片素材

素材图片并非越多越好,图片过多,会增加训练时长,以及处理图片的工作量;

相反,图片过少,AI学习信息不足,从而导致生成的画面不拟合,描述词一改就达不到想要的效果了。

图片质量

首先,要确保图片清晰度;

其次,要确保图片的全面性;

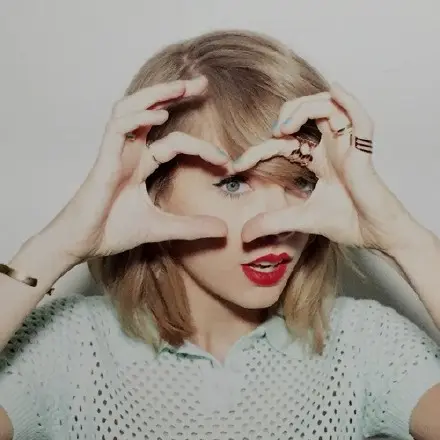

以训练人物模型举例,需要准备以下的图片素材,包括:

- 不同角度,表情

- 不同姿势,光影

- 面部特写照

- 半身照

- 全身照

最后,要注意图片中的细节:

- 不要在素材文件夹中放置一样的图片,会影响AI的学习

- 不要挑选主体被遮挡的图片

- 应尽可能突出主体,不要挑选背景太花太复杂的图片

今天先分享到这里~

开启实践: SD绘画 | 为你所做的学习过滤