服务器变革:存储从HBM到CXL

****

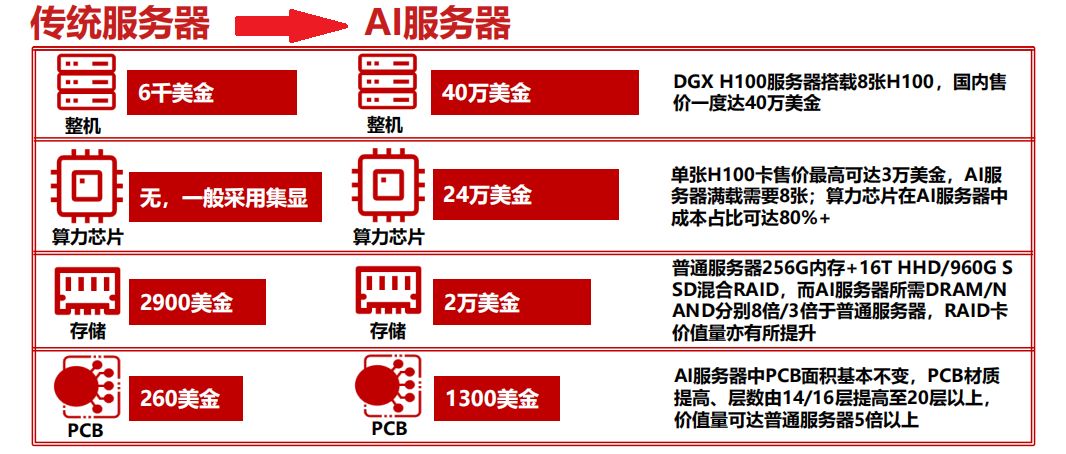

在《从云到端,AI产业的新范式(2024)》中揭示,传统服务器价格低至1万美金,而配备8张H100算力卡的DGX H100AI服务器价值高达40万美金(约300万人民币)。

从供应链角度出发,探讨存储、PCB,以及更上游的封测、制造环节的产业机遇。

AI三要素包括算力、互联和存储,从服务器供应链角度看,存储是AI时代变革重点。

随着处理器性能的飞跃,"内存墙"成为计算机瓶颈。处理器速度依照摩尔定律持续提升,但内存DRAM带宽未同步增长,导致访存延迟高,效率低下,严重限制了处理器性能。在AI和视觉等高带宽需求领域,内存性能的落后将导致算力下降达50%甚至90%,影响巨大。

HBM,突破"内存墙"的关键技术,以其3D堆栈工艺,提供卓越内存带宽与低能耗。HBM3E新品,带宽超1TB/s,I/O速率达8Gb/s,助力HPC、网络交换设备等,解决算力增长瓶颈。

Yole Group数据显示,2023年海力士以55%的营收独占HBM市场鳌头,紧随其后的是三星(41%)和美光(3%)。美光虽曾因HMC技术导致传输速度和延迟问题,但迅速调整策略,于2020年推出HBM2,并直接投入HBM3E研发,2023年7月成功发布24GB 8-HighHBM3E。

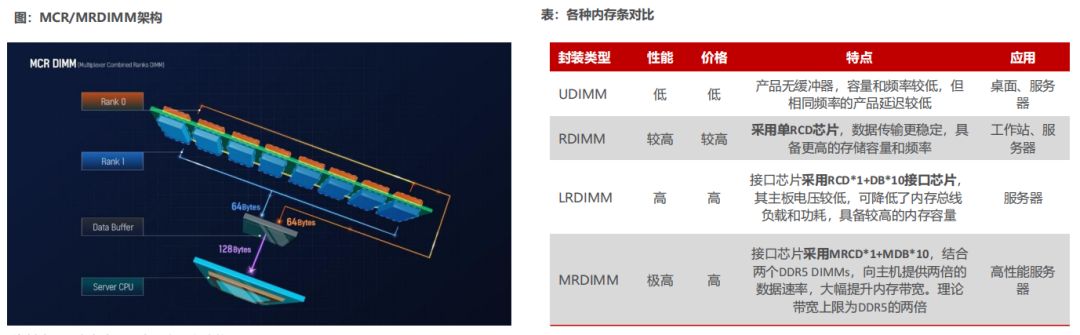

AI服务器需求核心在于更大带宽的存储,带来了存储技术路线变革:

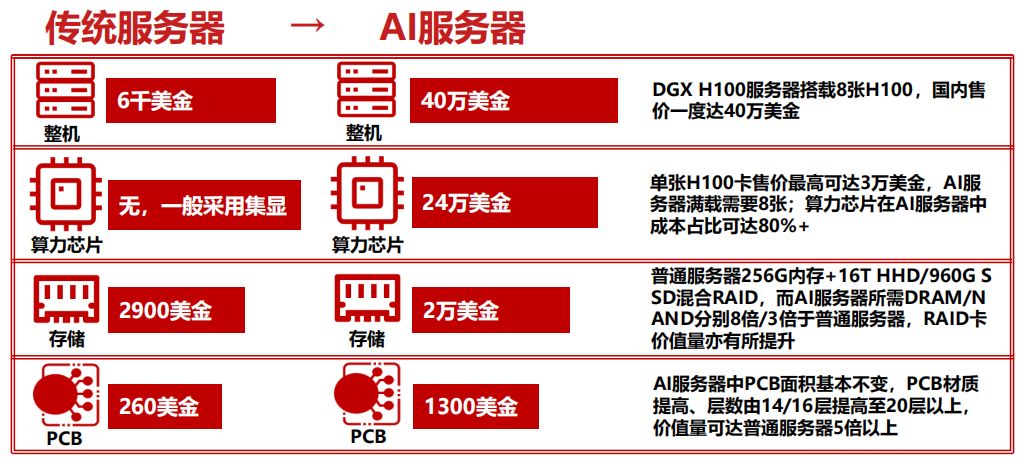

MCR/MDIMM技术大幅提升内存带宽。AMD致力于推动JEDEC MRDIMM开放标准,英特尔联合SK hynix与瑞萨,开发类似MCR的多路合并阵列DIMM,共铸高性能内存未来。

MCR/MRDIMM技术完美契合AI服务器对内存带宽的严苛需求。它通过整合多个DRAM模块,创建伪多内存通道,并配备专用控制器,大幅提升数据传输效率。MCR/MRDIMM内存带宽理论上是DDR5的两倍,助力AI服务器性能飞跃。

澜起科技已于2022年完成MCR控制芯片(MRCD/MDB)研发。

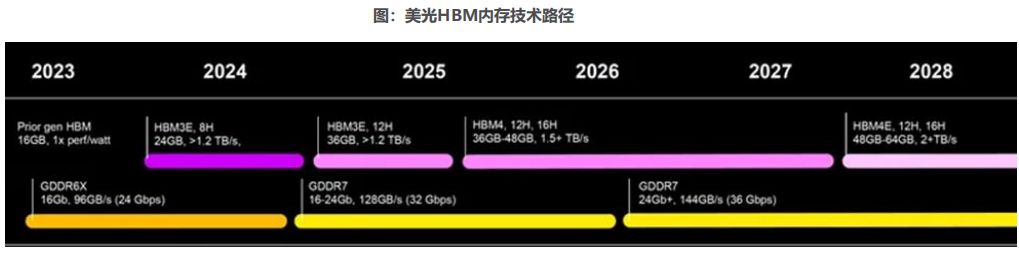

美光虽在HBM市场起步较晚,却于2023年7月以HBM3E反超三星和SK海力士。未来,美光计划于2025年推出36GB 12-High HBM3E,2026年推出带宽超1.5TB/s的36GB 12-High HBM4,引领行业革新。

预计至2027年,美光将升级HBM4至48GB 16-High,2028年推出带宽超2TB/s的HBM4E。2023至2028年,美光年均推出一款HBM新品,彰显其在高速增长市场的坚定决心。

澜起科技引领行业,两大产品线实力非凡:涵盖内存接口、PCIe Retimer等高端互连芯片,及津逮CPU、混合安全内存模组等服务器平台产品。

新品序列2023年全面研发并送样,业绩增长双管齐下:DDR5芯片迭代增值,新品量产拓展成长空间。高性能产品线已推出Retimer、MRCD/MDB,并加速研发DDR5第四代RCD、第二代MRCD/MDB及PCIe 6.0 Retimer芯片。

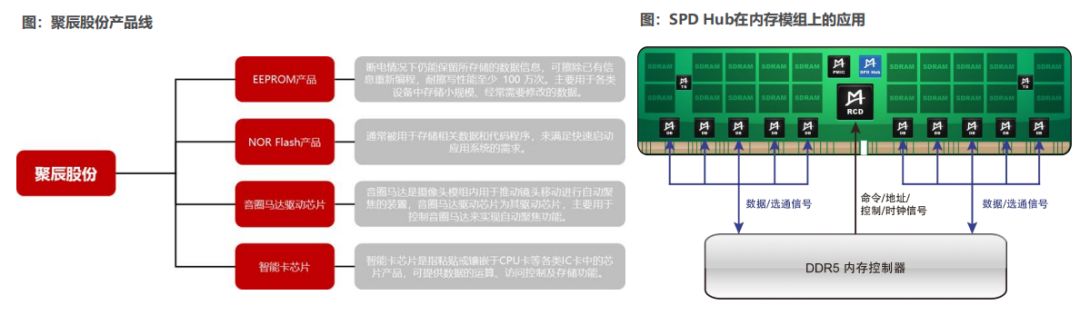

聚辰股份,国产EEPROM领军企业,产品涵盖EEPROM、音圈马达驱动芯片、智能卡芯片及NOR Flash,广泛应用于手机、汽车电子、家电等领域。拓展应用新领域,与澜起科技合作,SPD EEPROM量产于2021年Q4,技术领先。

DDR5时代来临,SPD EEPROM需求激增。作为内存管理系统核心,串行检测集线器(SPD)适配LRDIMM、RDIMM等内存模组。随着DDR5市场渗透率上升,SPD EEPROM市场前景广阔。

-对此,您有什么看法见解?-

-欢迎在评论区留言探讨和分享。-