前言

有用户反馈离线语音识别不灵敏,跟着笔者一起分析原因吧。笔者知识能力有限,难免会误,还请大家批评指正。

1 影响离线语音识别的因素

笔者分析离线语音识别不灵敏的原因有以下几点

1.1 运行硬件的算力限制

由于离线语音识别在本地MCU进行,受限于MCU的计算能力和存储空间,无法像在线识别那样依赖云端的强大计算资源。此外,离线语音识别缺乏实时的数据更新和优化,导致其对新词汇和口音的适应能力较弱。虽然我们的S100D离线语音识别内置高性能 主频160Mhz的RISC-V CPU + NPU + DSP,在同类MCU里是性能很强了,但相较于服务器强大算力的GPU是弱的。离线语音识别IC,训练的模型语料库也没有运行大模型的服务器那么丰富,一般只有精简的标准普通话。

1.2 固定词条、识别率稍低

离线语音识别技术将词条储存于本地设备中,由于本地存储空间有限,设置的词条内容也会受到限制。例如,如果储存的词条只有"关灯"这个命令,那么用户说"把灯关了"则无法执行,因为在数据库中找不到对应的词条命令

1.3 用户使用环境影响

背景噪音、说话人的距离和方位都会影响语音信号的质量,从而降低识别率。在嘈杂的环境中,离线语音识别尤其容易受到干扰,导致识别不准确。

1.4 硬件问题

上面说了一些客观原因,有人会说,笔者在找借口了。下面我们来分析一下主观原因。

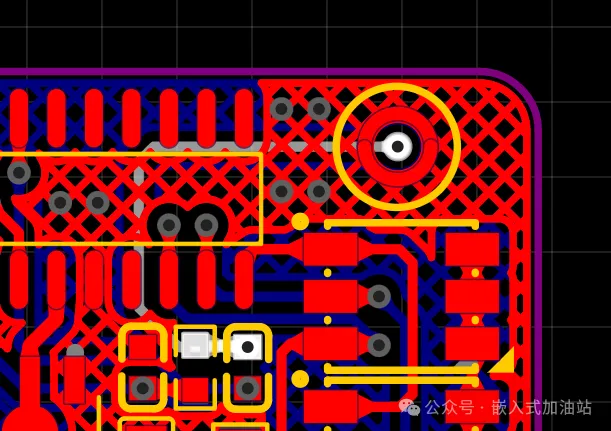

电源纹波,供电电路走线方式、Mic布线走线方式,也会影响识别效果,例如下面电路走线方式,就有点不合理,后面我们如何合理走线。

还有Mic增益和信噪比,也会影响识别率。增益小拾取声音也小,增益大了,声音大的同时,噪声也变大了。

1.5 语速和方言口音影响

语音太快或太慢,和方言口音都会影响语音识别,因为我们的离线语音的模型是基于正常语速的标准普通话训练的。

2 改善语音识别策略

了解影响离线语音识别的因素,下面我们看看如何改善和提升识别率。

2.1 优化声学模型和语言模型

通过深度学习算法,声学模型可以将语音信号转换为音素序列,而语言模型则将音素序列转换为文字。优化这两个模型可以提高识别的准确性和灵敏度。

2.3 使用高性能的语音芯片

高性能的语音芯片可以提供更快的处理速度和更高的识别精度,从而提升离线语音识别的灵敏度。

2.3 采用轻量级NLP技术

例如"离线自然说",通过语义协议和语音识别构图结合,实现对指令的泛化理解,支持多种说法,提高识别的灵活性和准确性。

3 离线语音识别的应用场景和优势

离线语音识别技术在多个领域有广泛应用,如智能家居、智能车载和智能物联设备。其优势包括:

3.1 独立性

不需要网络连接,适用于无网络或网络不稳定的场景3。

3.2 隐私保护

数据不经过云端,更好地保护用户隐私。

3.3 实时性

对需要即时反馈的应用提供更好的用户体验。

4 总结

通过以上方法和技术改进,可以有效提升离线语音识别的灵敏度和准确性,满足更多应用场景的需求。