将一个 720p 的视频放大编码到 4K,这样的视频处理在很多业务场景中都会用到。很多视频社交、短视频、视频点播等应用,都会需要通过服务器来处理大量的视频编辑需求。

本文我们会探讨一下做这样的视频处理,最低的 GPU 指标应该是多少。利用开源的 FFmpeg 放大视频的原理和基本步骤是怎样的。然后,我们通过一个简单的示例教程,一步步带领你利用带有 CUDA 支持的 FFmpeg 将一个视频从 720p 分辨率放大并编码到 4K 分辨率。示例教程会适合希望在GPU 服务器上高效处理视频的视频工程师和开发者,步骤会比较详细,刚接触视频编解码的开发者也可以尝试。

达到什么指标的 GPU 适合视频处理?

视频的处理必然离不开 GPU 的加持。但是什么样的 GPU 规格才能满足,或者说最低限度地满足视频处理的需要呢?

最低指标

以下是基于不同分辨率的基准线:

|-------|-------|----------|-------|-----------|--------|

| 分辨率 | 所需显存 | CUDA 核心数 | 张量核心数 | 内存带宽 | RT 核心数 |

| 1080p | 8GB | 2,000+ | 100+ | 300+ GB/s | 20+ |

| 4K | 16GB | 4,000+ | 200+ | 500+ GB/s | 40+ |

| 8K | 32GB+ | 8,000+ | 400+ | 1+ TB/s | 80+ |

你可以基于这些指标,去寻找合适的 GPU。已知 NVIDIA H100 达到了甚至超过了 4K 和 8K 视频处理的这些基准。

使用 FFmpeg 放大视频的原理

放大视频的方法有很多种,最前沿的方法是 AI 技术,但是这需要训练模型,还要不断调优以达到想要的结果。另外,你还可以使用 FFmpeg,这是最简单直接的方法。

使用 ffmpeg 将视频从 720p 放大到 4K 的原理主要涉及图像处理中的尺度变换(scaling)技术。具体来说,ffmpeg 使用内置的滤镜和编解码器来实现这一过程。下面是详细的原理和步骤:

1. 输入文件读取

首先,ffmpeg 读取输入的 720p 视频文件。这个文件包含一系列低分辨率的帧。

2. 尺度变换滤镜

ffmpeg 使用 -vf 参数指定视频滤镜,其中 scale 滤镜用于改变视频的分辨率。例如,-vf "scale=3840:2160" 表示将视频的宽度调整为 3840 像素,高度调整为 2160 像素,即从 720p (1280x720) 放大到 4K (3840x2160)。

3. 插值算法

在尺度变换过程中,scale 滤镜使用插值算法来估计新的像素值。常见的插值算法包括:

- 最近邻插值(Nearest Neighbor Interpolation):简单地复制最近的像素值。这种方法速度快但结果粗糙,常用于简单的放大操作。

- 双线性插值(Bilinear Interpolation):通过线性插值算法估计缺失像素的值。这种方法比最近邻插值更平滑,但计算量稍大。

- 双三次插值(Bicubic Interpolation):通过三次多项式插值算法估计缺失像素的值。这种方法计算量更大,但结果更平滑,细节更好。

4. 编码和输出

放大后的视频帧需要重新编码以生成新的视频文件。ffmpeg 使用 -c:v 参数指定视频编解码器,例如 libx264 用于 H.264 编码。此外,可以通过 -preset 参数指定编码速度和质量的平衡,例如 fast 表示较快的编码速度,-b:v 参数指定目标视频比特率,例如 10M 表示 10 Mbps。

示例教程

为了方便大家了解实际的视频放大过程,我们给大家一份简单实用的上手操作教程。一步步带领你利用带有 CUDA 支持的 FFmpeg 将一个视频从 720p 分辨率放大并编码到 4K 分辨率。

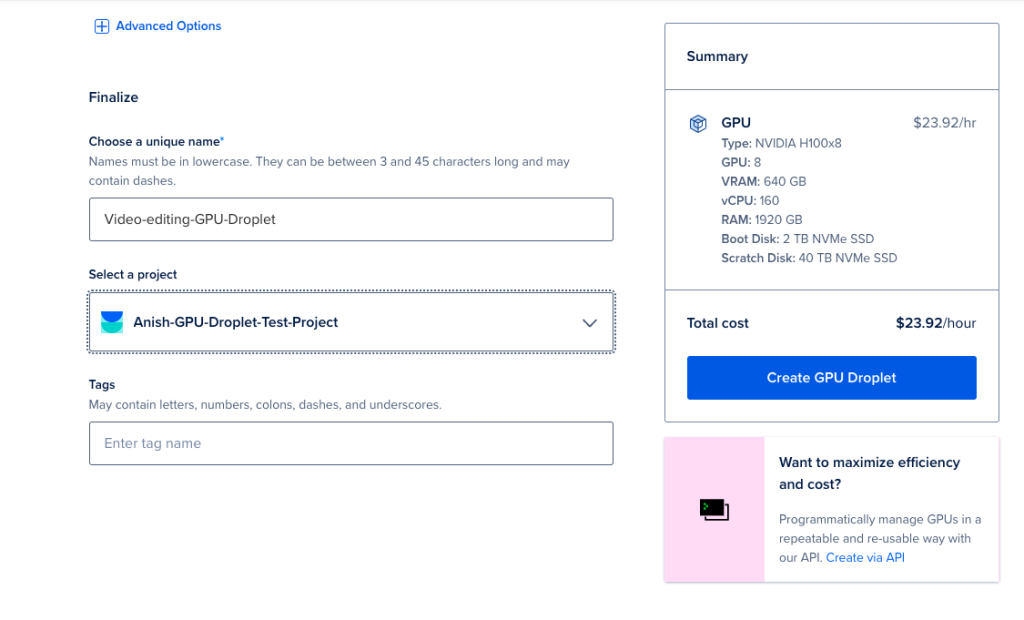

我们在这里选择了 DigitalOcean 的 GPU Droplet 云服务器,注册后有赠送使用额度,可以免费使用。

NVIDIA H100 提供了广泛的 CUDA、张量和 RT 核心,为高分辨率视频处理工作负载提供了必要的资源:

- 显存(VRAM):NVIDIA H100 配备了 80GB HBM2e 显存,可以处理 4K 和 8K 视频。

- CUDA 核心:18,432 个 CUDA 核心用于高速处理和编码。

- 张量核心:640 个张量核心支持增强型任务,例如降噪。

- RT 核心:128 个 RT 核心用于实时处理和视觉效果。

- 内存带宽:最高可达 2 TB/s,允许平滑播放和快速数据传输。

对于视频处理而言,这些规格意味着更快的处理速度、高效的缩放以及实时效果渲染。H100 可以处理最密集的视频任务,同时保持最小的延迟和高速处理能力。

准备工作

在开始之前,请确保你具备以下条件:

- 注册 DigitalOcean 账户,注册后即可有 200$使用额度。

- 部署并运行 GPU Droplet,我们会在下面介绍步骤,你也可以观看官方的视频教程。

- 你需要对 Linux 命令行有所了解。

以上就是你需要准备的。我们也会在后面的步骤中一步步带你做。这次我们要处理的视频会从开源项目中获取,所以你不需要额外准备视频文件。

步骤 1 - 设置 GPU Droplet

1、创建新项目 - 你需要从云端控制面板创建一个新项目,并将其与 GPU Droplet 绑定。

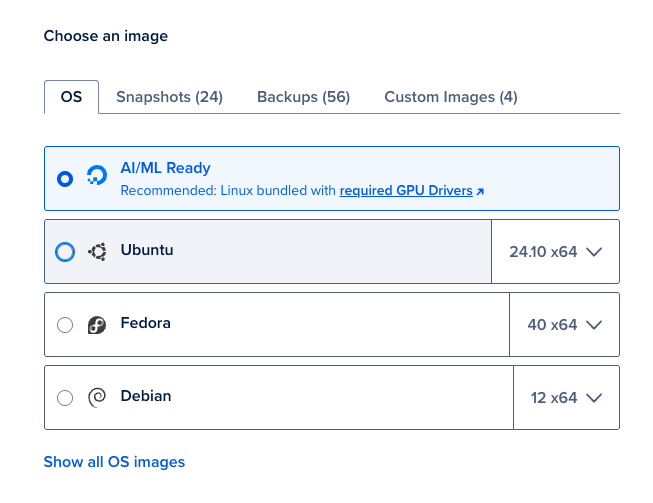

2、创建 GPU Droplet - 登录你的 DigitalOcean 账户,创建一个新的 GPU Droplet,并选择 AI/ML Ready 作为操作系统。该操作系统镜像安装了所有必要的 NVIDIA GPU 驱动程序。

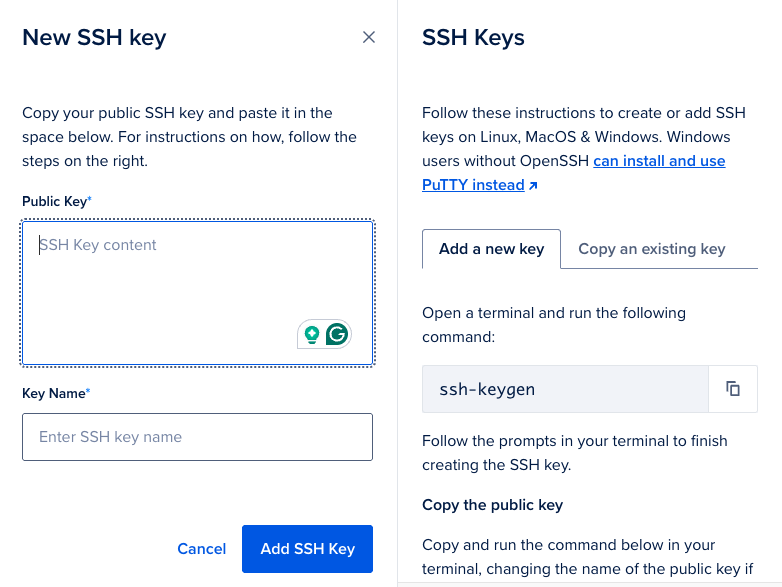

3、添加 SSH 密钥进行身份验证 - 添加 SSH 密钥是为了与 GPU Droplet 进行身份验证,通过添加 SSH 密钥,你可以从终端登录到 GPU Droplet。

4、完成并创建 GPU Droplet - 完成上述所有步骤后,完成并创建新的 GPU Droplet。

步骤 2 - 安装依赖项

GPU Droplet 准备好并已部署后,你可以从终端使用 SSH 登录到 GPU Droplet。

ssh root@<your-droplet-ip>确保你的基于 Ubuntu 的 GPU Droplet 是最新的:

sudo apt update && sudo apt upgrade -y接下来,请使用以下命令重启 GPU Droplet 并等待其上线。在运行 sudo apt update && sudo apt upgrade -y 后重启通常是为了确保任何更新的系统组件,特别是内核和硬件驱动程序,都被完全加载和应用。

注意:在大多数 Linux 系统上,你可以通过运行以下命令来检查是否需要重启:

[ -f /var/run/reboot-required ] && echo "Reboot is required"如果在内核和硬件驱动程序更新后需要重启,你将看到上述命令的输出如下:

Reboot is required现在,让我们使用以下命令验证 NVIDIA 驱动程序和 CUDA 版本:

nvidia-smi此命令应显示 NVIDIA GPU 的详细信息和驱动程序版本。

Output+---------------------------------------------------------------------------------------+

| NVIDIA-SMI 535.183.06 Driver Version: 535.183.06 CUDA Version: 12.2 |

|-----------------------------------------+----------------------+----------------------+

| GPU Name Persistence-M | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+======================+======================|

| 0 NVIDIA H100 80GB HBM3 Off | 00000000:00:09.0 Off | 0 |

| N/A 28C P0 67W / 700W | 0MiB / 81559MiB | 0% Default |

| | | Disabled |

+-----------------------------------------+----------------------+----------------------+

+---------------------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=======================================================================================|

| No running processes found |

+---------------------------------------------------------------------------------------+接下来,验证 CUDA 的安装:

nvcc --version你应该看到有关已安装 CUDA 版本的信息。

nvcc: NVIDIA (R) Cuda compiler driver

Copyright (c) 2005-2023 NVIDIA Corporation

Built on Mon_Apr__3_17:16:06_PDT_2023

Cuda compilation tools, release 12.1, V12.1.105

Build cuda_12.1.r12.1/compiler.32688072_0注意:请从上述输出中确保 nvidia-smi 命令和 nvcc -v 命令的 CUDA 驱动程序版本匹配。如果两个命令的输出之间存在版本不匹配,你必须重新安装两者并再次重启 GPU Droplet。

接下来,你将安装 FFmpeg。FFmpeg 可以利用 GPU 加速视频处理,然后我们就可以缩放视频了。

sudo apt install -y ffmpeg运行以下命令检查 FFmpeg 是否检测到 CUDA 支持。

ffmpeg -hwaccels此命令应列出 cuda、vdpau 和 vappi,表明 GPU 加速可用。

ffmpeg version 4.4.2-0ubuntu0.22.04.1 Copyright (c) 2000-2021 the FFmpeg developers

built with gcc 11 (Ubuntu 11.2.0-19ubuntu1)

configuration: --prefix=/usr --extra-version=0ubuntu0.22.04.1 --toolchain=hardened --libdir=/usr/lib/x86_64-linux-gnu --incdir=/usr/include/x86_64-linux-gnu --arch=amd64 --enable-gpl --disable-stripping --enable-gnutls --enable-ladspa --enable-libaom --enable-libass --enable-libbluray --enable-libbs2b --enable-libcaca --enable-libcdio --enable-libcodec2 --enable-libdav1d --enable-libflite --enable-libfontconfig --enable-libfreetype --enable-libfribidi --enable-libgme --enable-libgsm --enable-libjack --enable-libmp3lame --enable-libmysofa --enable-libopenjpeg --enable-libopenmpt --enable-libopus --enable-libpulse --enable-librabbitmq --enable-librubberband --enable-libshine --enable-libsnappy --enable-libsoxr --enable-libspeex --enable-libsrt --enable-libssh --enable-libtheora --enable-libtwolame --enable-libvidstab --enable-libvorbis --enable-libvpx --enable-libwebp --enable-libx265 --enable-libxml2 --enable-libxvid --enable-libzimg --enable-libzmq --enable-libzvbi --enable-lv2 --enable-omx --enable-openal --enable-opencl --enable-opengl --enable-sdl2 --enable-pocketsphinx --enable-librsvg --enable-libmfx --enable-libdc1394 --enable-libdrm --enable-libiec61883 --enable-chromaprint --enable-frei0r --enable-libx264 --enable-shared

libavutil 56. 70.100 / 56. 70.100

libavcodec 58.134.100 / 58.134.100

libavformat 58. 76.100 / 58. 76.100

libavdevice 58. 13.100 / 58. 13.100

libavfilter 7.110.100 / 7.110.100

libswscale 5. 9.100 / 5. 9.100

libswresample 3. 9.100 / 3. 9.100

libpostproc 55. 9.100 / 55. 9.100

Hardware acceleration methods:

vdpau

cuda

vaapi

qsv

drm

opencl步骤 3 - 下载样本视频数据以测试

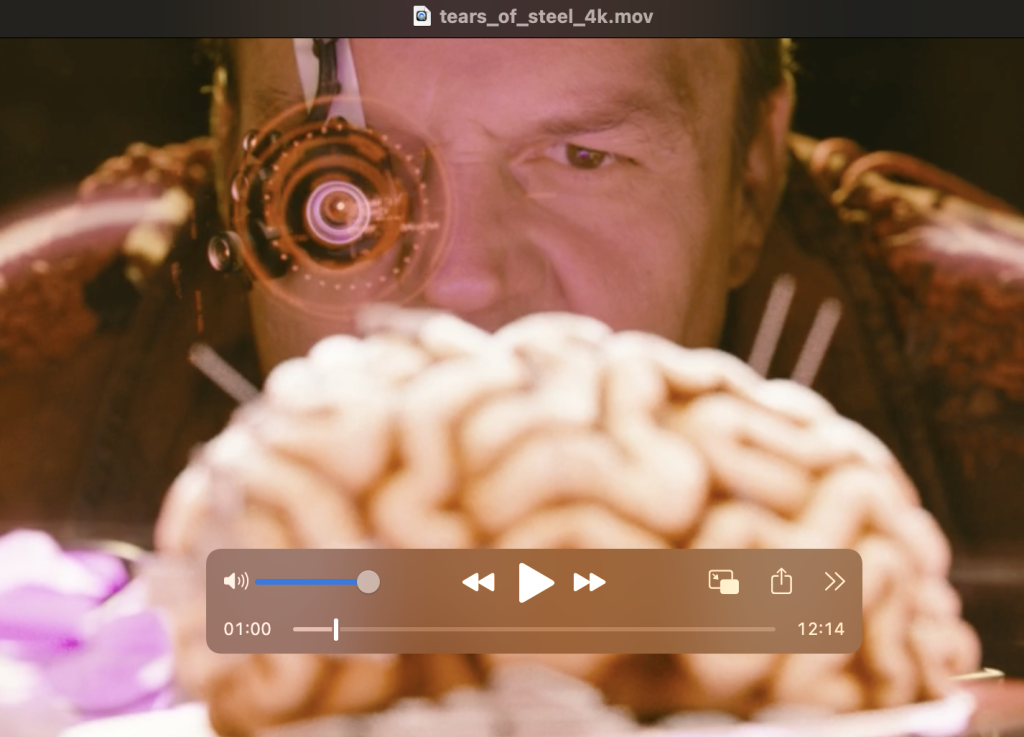

在本教程中,你将使用 Blender 基金会提供的一个样本视频来演示 GPU 加速视频处理。Blender 是一个免费且开源的 3D 创作套件,支持整个 3D 流水线------建模、装配、动画、模拟、渲染等。

使用以下命令下载样本视频:

wget https://download.blender.org/demo/movies/ToS/tears_of_steel_720p.mov步骤 4 - 使用 FFmpeg 将视频放大至 4K

现在你可以使用已安装的FFmpeg和配置好的 GPU 来处理视频了。

ffmpeg 命令的基本语法是:

ffmpeg -i <input_file> -vf "scale=width:height" -c:v <codec_name> -preset <encoding_preset> -b:v <bitrate> <output_file>各参数的含义如下:

input_file:输入视频文件的名称。scale=宽度:高度:缩放滤镜,其中宽度和高度是你希望调整的尺寸。codec_name:用于编码视频的编解码器(例如,libx264表示 H.264)。encoding_preset:编码的速度与压缩效率预设(例如,fast、medium、slow)。bitrate:目标视频比特率(例如,10M表示 10 Mbps)。output_file:输出文件的名称,包括格式和扩展名。

在这个例子中,你将把视频从 720p 放大到 4K 分辨率。

运行以下 FFmpeg 命令将视频放大至 4K(3840x2160 分辨率):

ffmpeg -i tears_of_steel_720p.mov -vf "scale=3840:2160" -c:v libx264 -preset fast -b:v 10M tears_of_steel_4k.mov处理完成后,你应该能看到如下输出:

Output #0, mov, to 'tears_of_steel_4k.mov':

Metadata:

major_brand : qt

minor_version : 512

compatible_brands: qt

encoder : Lavf58.76.100

Stream #0:0(eng): Video: h264 (avc1 / 0x31637661), yuv420p(tv, progressive), 3840x2160 [SAR 120:89 DAR 640:267], q=2-31, 10000 kb/s, 24 fps, 12288 tbn (default)

Metadata:

handler_name : VideoHandler

vendor_id : FFMP

encoder : Lavc58.134.100 libx264

Side data:

cpb: bitrate max/min/avg: 0/0/10000000 buffer size: 0 vbv_delay: N/A

Stream #0:1(eng): Audio: aac (LC) (.mov / 0x6134706D), 44100 Hz, stereo, fltp, 128 kb/s (default)

Metadata:

handler_name : SoundHandler

vendor_id : [0][0][0][0]

encoder : Lavc58.134.100 aac

frame=17620 fps= 69 q=-1.0 Lsize= 949201kB time=00:12:14.07 bitrate=10592.7kbits/s speed=2.88x

video:937125kB audio:11532kB subtitle:0kB other streams:0kB global headers:0kB muxing overhead: 0.057354%

[libx264 @ 0x564504ee7f40] frame I:223 Avg QP:22.07 size:180259

[libx264 @ 0x564504ee7f40] frame P:5973 Avg QP:25.97 size: 92140

[libx264 @ 0x564504ee7f40] frame B:11424 Avg QP:27.21 size: 32306

[libx264 @ 0x564504ee7f40] consecutive B-frames: 8.2% 14.4% 5.4% 72.0%

[libx264 @ 0x564504ee7f40] mb I I16..4: 20.9% 75.8% 3.2%

[libx264 @ 0x564504ee7f40] mb P I16..4: 9.4% 21.2% 1.1% P16..4: 29.5% 4.3% 1.4% 0.0% 0.0% skip:33.0%

[libx264 @ 0x564504ee7f40] mb B I16..4: 0.9% 1.4% 0.1% B16..8: 25.0% 1.3% 0.2% direct: 1.8% skip:69.3% L0:44.6% L1:53.4% BI: 2.0%

[libx264 @ 0x564504ee7f40] final ratefactor: 25.73

[libx264 @ 0x564504ee7f40] 8x8 transform intra:66.4% inter:91.8%

[libx264 @ 0x564504ee7f40] coded y,uvDC,uvAC intra: 30.5% 41.4% 7.3% inter: 6.3% 10.8% 0.3%

[libx264 @ 0x564504ee7f40] i16 v,h,dc,p: 31% 23% 7% 38%

[libx264 @ 0x564504ee7f40] i8 v,h,dc,ddl,ddr,vr,hd,vl,hu: 34% 16% 23% 3% 5% 6% 4% 5% 3%

[libx264 @ 0x564504ee7f40] i4 v,h,dc,ddl,ddr,vr,hd,vl,hu: 37% 17% 10% 4% 8% 9% 6% 6% 4%

[libx264 @ 0x564504ee7f40] i8c dc,h,v,p: 55% 16% 22% 6%

[libx264 @ 0x564504ee7f40] Weighted P-Frames: Y:2.2% UV:1.1%

[libx264 @ 0x564504ee7f40] ref P L0: 62.5% 12.6% 18.5% 6.3% 0.1%

[libx264 @ 0x564504ee7f40] ref B L0: 90.1% 8.2% 1.7%

[libx264 @ 0x564504ee7f40] ref B L1: 96.5% 3.5%

[libx264 @ 0x564504ee7f40] kb/s:10456.65

[aac @ 0x564504f67ec0] Qavg: 259.313这里是对命令的解释:

-i tears_of_steel_720p.mov:指定输入视频文件。-vf "scale=3840:2160":设置缩放滤镜,将视频放大至 4K 分辨率(3840x2160)。-c:v libx264:使用libx264编解码器对视频进行编码。-preset fast:指定编码速度与质量之间的平衡(fast是一个好的平衡点)。-b:v 10M:设置目标视频比特率为 10 Mbps 以保持质量。

若想了解更多关于 FFmpeg 命令的信息,你可以参考FFmpeg官方文档。

步骤 5 - 将处理后的视频下载到本地系统

视频处理完毕后,使用 scp 命令将其从 Droplet 下载到你的本地机器。将 <your_droplet_ip> 替换为你的 Droplet 的 IP 地址。

scp root@<your_droplet_ip>:~/tears_of_steel_4k.mov ~/Downloads/此命令将 4K 放大的视频文件复制到你本地桌面的 Downloads 文件夹中。

小结

由 NVIDIA H100 GPU 驱动的服务器为视频处理提供了一个高性能的环境。通过 FFmpeg 实现的 GPU 加速缩放和编码,你可以大幅缩短处理时间,实现实时的视频调整和快速视频导出。这种配置非常适合处理高分辨率工作负载的视频工程师和开发人员。

最后,DigitalOcean GPU 云服务是专注 AI 模型训练的云 GPU 服务器租用平台,提供了包括 A5000、A6000、H100 等强大的 GPU 和 IPU 实例,以及透明的定价,可以比其他公共云节省高达70%的计算成本。目前,DigitalOcean GPU Droplet H100 与 H100x8 服务器正在限时优惠,如需了解详情,可联系DigitalOcean 中国区独家战略合作伙伴卓普云。(或加飞机号:Dd0CL)